比OpenAI的Whisper快50%,最新開源語音模型

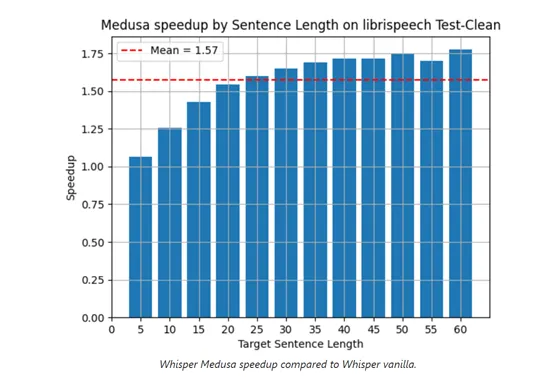

生成式AI初創公司aiOla在官網開源了最新語音模型Whisper-Medusa,推理效率比OpenAI開源的Whisper快50%。

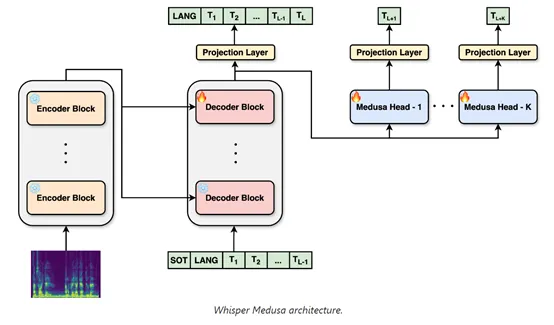

aiOla在Whisper的架構之上進行了修改采用了“多頭注意力”機制的并行計算方法,允許模型在每個推理步驟中預測多個token,同時不會損失性能和識別準確率。

開源地址:https://github.com/aiola-lab/whisper-medusa

huggingface:https://huggingface.co/aiola/whisper-medusa-v1

傳統的Transformer架構在生成序列時,是遵循逐個token的順序預測過程。這意味著在生成新序列時,模型每次只能預測下一個token,然后將這個預測的token加入到序列中,再基于更新后的序列預測下一個token。

這雖然能夠確保生成序列的連貫性和上下文相關性,但也有一個非常明顯的缺陷——極大限制了模型的推理效率。

此外,由于每次只能處理一個 token ,模型難以捕捉到數據中的長程依賴關系,可能會忽略一些重要的全局信息,從而影響模型的整體性能和準確性。

而Whisper-Medusa使用了10頭的多注意力機制, 能各自獨立地計算注意力分布并行地處理輸入,然后將各自的輸出通過拼接的方式組合起來,形成一個多維度的向量。

隨后向量被送入全連接層進行進一步的處理,以生成最終的token預測。這種并行的數據處理方式不僅加快了模型的推理效率,還增加了模型的表達能力,因為每個注意力頭都可以專注于序列的不同子集,捕捉到更豐富的上下文信息。

為了使多頭注意力機制在Whisper-Medusa模型中更高效地運行,aiOla采用了弱監督的方法,在訓練過程中凍結了原Whisper模型的主要組件,使用該模型生成的音頻轉錄作為偽標簽來訓練額外的token預測模塊。

使得模型即便沒有大量手動人工標注數據的情況下,依然能夠學習到有效的語音識別模式。

此外在訓練過程中,Whisper-Medusa的損失函數需要同時考慮預測的準確性和效率。一方面,模型需要確保預測的token序列與實際轉錄盡可能一致;

另一方面,通過多頭注意力機制的并行預測,模型被鼓勵在保證精度的前提下,盡可能地加快預測效率。

aiOla使用了學習率調度、梯度裁剪、正則化等多種方法,確保模型在訓練過程中能夠穩定收斂,同時避免過擬合性。

業務場景方面, Whisper-Medusa能理解100多種語言,用戶可以開發音頻轉錄、識別等多種應用,適用于翻譯、金融、旅游、物流、倉儲等行業。

aiOla表示,未來會將Whisper-Medusa的多注意力機制擴展至20個頭,其推理效率將再次獲得大幅度提升。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區