VideoLLaMB:創(chuàng)新開源框架,引領多模態(tài)長視頻理解

隨著互聯網技術的發(fā)展和智能設備的普及,視頻內容正以前所未有的速度增長。長視頻,尤其是那些包含豐富信息和復雜場景的視頻,對于理解人類行為、環(huán)境變化以及時間序列事件具有重要價值。然而,隨著視頻長度的增加,如何有效地處理和理解這些視頻內容,成為了人工智能領域中的一個挑戰(zhàn)。

- 視頻內容的挑戰(zhàn)

傳統的視頻理解模型通常專注于短視頻片段,這些片段由于時間跨度小,因此容易處理和分析。但對于長視頻,尤其是那些時長可達幾分鐘甚至幾小時的視頻,傳統的模型往往難以捕捉和理解視頻中的長期依賴關系和復雜的語義信息。這導致了在長視頻內容的自動分析和理解方面存在顯著的局限性。

- VideoLLaMB的興起?

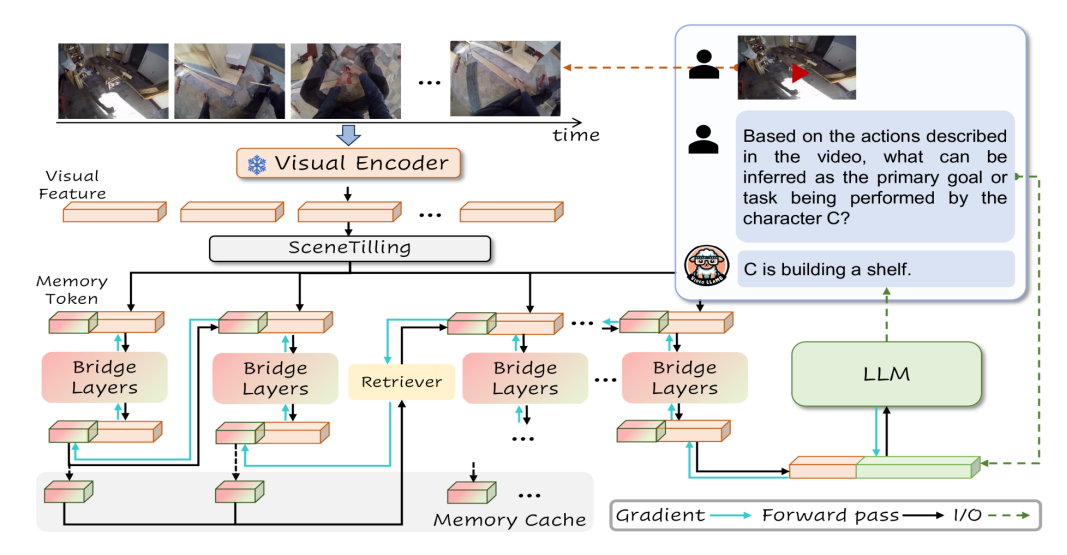

為了克服這些挑戰(zhàn),研究人員一直在探索新的技術和方法。最近,一種名為VideoLLaMB的新型框架引起了廣泛的關注。VideoLLaMB是一種開源的多模態(tài)長視頻理解框架,它通過引入記憶橋接層和遞歸記憶令牌來處理視頻數據,確保在分析時不丟失關鍵視覺信息。這種創(chuàng)新的方法特別設計用于理解長時間視頻內容,保持語義連續(xù)性,并在多種任務中表現出色。

技術特點

VideoLLaMB框架的創(chuàng)新之處在于其對長視頻內容的處理能力,它通過以下幾個關鍵技術特點實現了這一點:

1、長視頻理解

VideoLLaMB專門設計用于處理和理解長時間的視頻內容,包括復雜的場景和活動,而不丟失關鍵的視覺信息 。這對于實時規(guī)劃和詳細交互等任務至關重要。

2、記憶橋接層

框架的核心是記憶橋接層(Memory Bridge Layers),它使用遞歸內存令牌(recurrent memory tokens)來編碼整個視頻序列。這種設計允許模型在不改變視覺編碼器和大型語言模型(LLM)架構的情況下,有效地處理和記憶視頻內容 。

3、遞歸內存令牌

遞歸內存令牌用于存儲和更新視頻的關鍵信息。在處理視頻片段時,模型更新這些令牌,保持長期依賴性的同時,也能反映當前處理的視頻內容 。

4、SceneTilling算法

SceneTilling算法用于視頻分割,通過計算相鄰幀之間的余弦相似度來識別視頻中的關鍵點,將視頻分割成多個語義段。這有助于模型更好地理解和處理視頻中的場景變化 。

5、內存緩存與檢索機制

為了緩解梯度消失問題并保持長期記憶,VideoLLaMB采用了內存緩存和檢索策略。這允許模型在每個時間步存儲先前的記憶令牌,并在需要時檢索和更新記憶,維持對視頻內容的長期理解 。

應用場景

VideoLLaMB框架因其先進的技術特點,在多個領域都有廣泛的應用潛力。以下是一些主要的應用場景:

1、視頻內容分析

VideoLLaMB能夠理解和分析長視頻內容,這對于視頻內容審核、版權檢測、內容推薦系統等場景非常有用。它能夠捕捉視頻中的細微動作和長期記憶,提供詳細的互動和規(guī)劃支持。

2、視頻問答系統

在視頻問答(VideoQA)任務中,用戶提出關于視頻內容的問題,VideoLLaMB能夠提供準確的答案。這適用于教育、娛樂和信息檢索等領域,能夠增強用戶的互動體驗。

3、自我中心規(guī)劃

在需要根據視頻內容進行實時規(guī)劃的場景中,比如規(guī)劃一系列動作來完成某個任務,VideoLLaMB能夠提供有效的決策支持。這對于家庭環(huán)境或個人助理等場景尤其有用。

4、視頻字幕生成

基于其流式字幕生成能力,VideoLLaMB為視頻自動生成實時字幕,這對于聽障人士訪問視頻內容或為外語視頻提供即時翻譯非常有價值。

這些應用場景展示了VideoLLaMB如何幫助不同領域的專業(yè)人員更有效地處理和理解視頻數據,提高決策質量和操作效率。隨著技術的不斷進步和優(yōu)化,VideoLLaMB在未來可能會解鎖更多創(chuàng)新的應用方式。

部署實踐

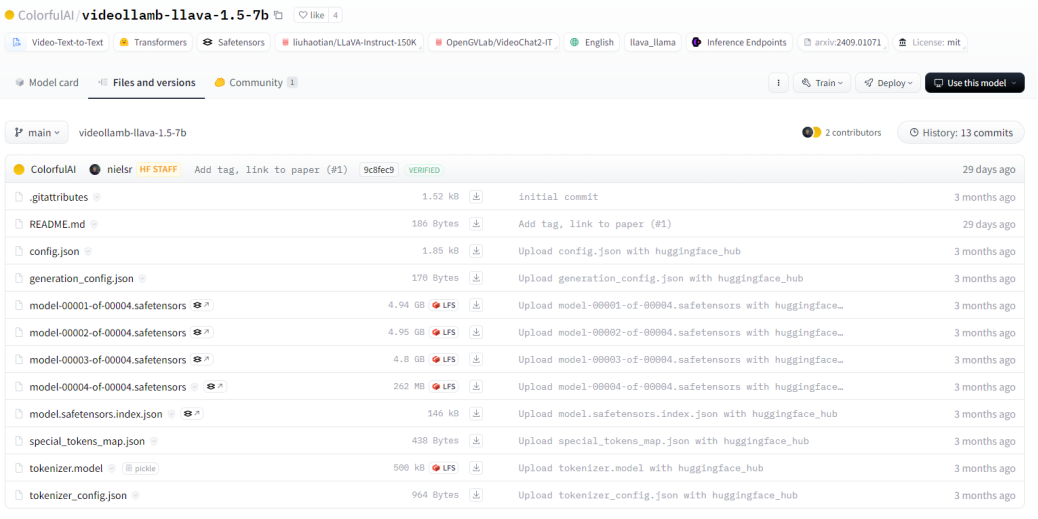

1、下載模型

從huggingface下載相關模型文件

git clone https://huggingface.co/ColorfulAI/videollamb-llava-1.5-7b

2、環(huán)境準備

1)克隆VideoLLaMB倉庫

git clone https://github.com/nlco-bigai/VideoLLaMB.git

cd VideoLLaMB2)創(chuàng)建環(huán)境&安裝包

conda create -n videollamb pythnotallow=3.10 -y

conda activate videollamb

pip install --upgrade pip

pip install -e .

conda install ffmpeg3、使用CLI的快速入門

下載模型文件,將其放置到 checkpoints 目錄,然后運行以下命令:

python -m llava.serve.cli --model-path checkpoints/videollamb-llava-1.5-7b --video-file XXX.mp44、使用CLI流式傳輸視頻字幕

下載模型文件,將其放置到 checkpoints 目錄,然后運行以下命令:

python -m llava.serve.cli_streaming --model_path checkpoints/videollamb-llava-1.5-7b5、Gradio演示

下載檢查點,將其放置到 checkpoints 目錄,然后運行以下命令:

python -m llava.serve.gradio_demo結語

VideoLLaMB 作為一款創(chuàng)新的長視頻理解框架,為人工智能領域在處理長視頻內容方面帶來了新的突破。它的出現不僅解決了傳統模型在長視頻處理上的難題,還為多個領域的應用提供了強大的技術支持。相信在未來,隨著技術的不斷發(fā)展和完善,VideoLLaMB 將在更多領域發(fā)揮重要作用,為我們的生活和工作帶來更多的便利和創(chuàng)新。讓我們共同期待 VideoLLaMB 在人工智能領域創(chuàng)造更加輝煌的成就。

相關資料

1. 項目官網:??https://videollamb.github.io??

2.GitHub倉庫:??https://github.com/bigai-nlco/VideoLLaMB??

3. 技術論文:??https://arxiv.org/pdf/2409.01071??

本文轉載自 ??小兵的AI視界??,作者: 小兵