最新開源Auto-RAG:最低成本解決多跳問題

1.引言

1.1 RAG 的局限與迭代檢索的提出

在知識密集型任務中,大語言模型(LLMs)的檢索增強生成(RAG)雖應用廣泛,能提升輸出質量、減少幻覺,但仍存缺陷。比如,檢索內容常含噪聲,這會致使 RAG 系統性能下滑。復雜查詢時,單次檢索難以獲取充足知識,進而阻礙 RAG 系統的廣泛應用。

為攻克這些難題,迭代檢索應運而生,其持續更新檢索結果,以契合生成進程里動態變化的信息需求。可現有的迭代檢索方法多依賴少樣本提示或手動構建規則。這類方式需大量人力,推理時計算成本頗高。更為關鍵的是,它們忽視了 LLMs 強大的推理與決策能力,未能充分挖掘模型在判定檢索時機與內容上的潛力,造成資源浪費。

1.2 Auto-RAG 的創新點與優勢

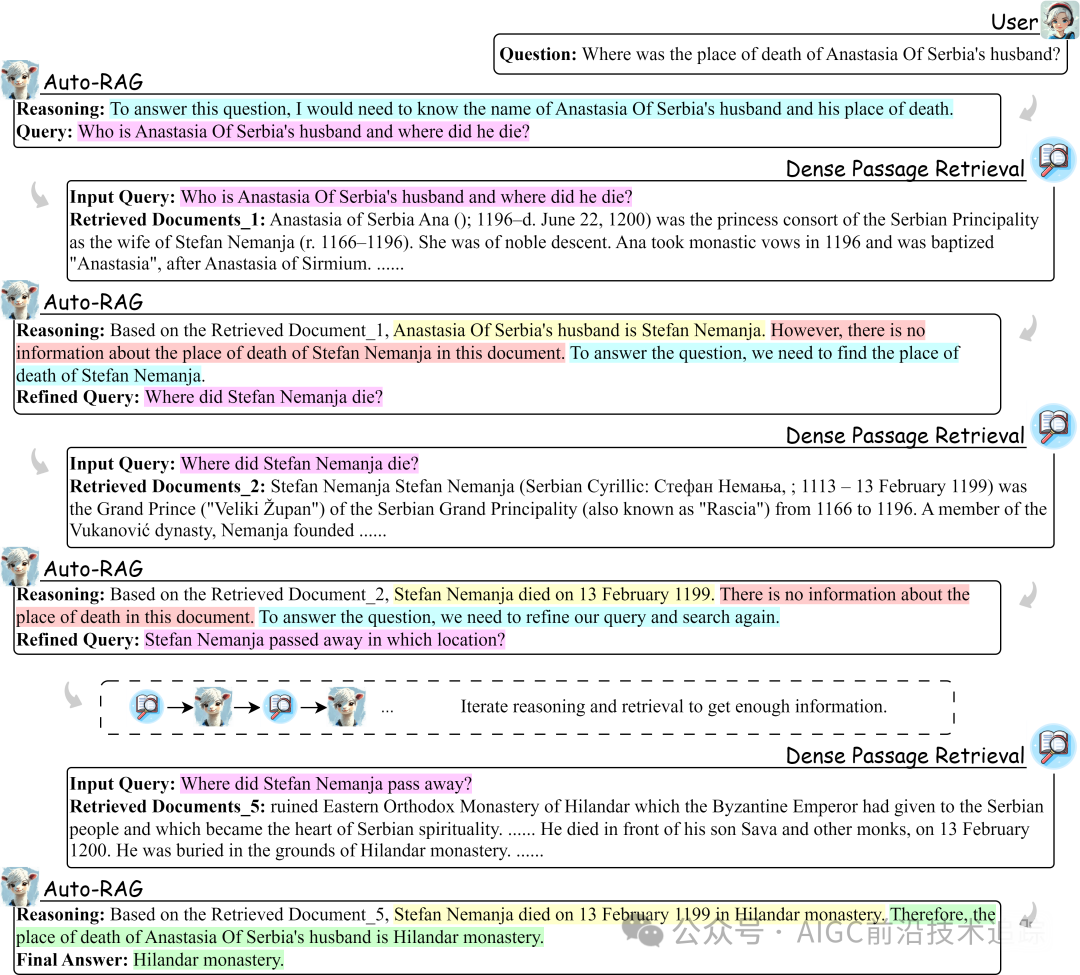

鑒于現有方法的不足,我們設計了 Auto-RAG,這一以 LLMs 強大決策能力為核心的自主迭代檢索模型。它借助多輪對話與檢索器交互,精心規劃檢索流程、優化查詢語句,直至采集到充足外部知識,最終為用戶輸出精準結果。

為賦予 LLMs 迭代檢索中的自主決策本領,我們構建了自動合成基于推理的決策指令框架,并對最新開源 LLMs 進行微調。經在六個具代表性基準測試的驗證,即便訓練數據有限,Auto-RAG 也表現卓越。其能依問題難度與檢索知識的效用,自動調整迭代次數,無需人工干預。而且,它以自然語言呈現迭代檢索過程,提升可解釋性,賦予用戶更直觀體驗。例如在處理復雜多跳問題時,Auto-RAG 可通過迭代推理,從檢索到的眾多文檔中精準提取關鍵知識,逐步逼近正確答案,過程清晰透明,結果準確可靠。

2.相關工作

2.1 檢索增強生成(RAG)

RAG 的誕生,旨在應對模型參數中知識過時以及 LLMs 對長尾知識保留不佳的困境。常見的 RAG 方法遵循檢索-讀取框架,即將檢索文檔與用戶輸入拼接,為 LLMs 補充外部知識。然而,檢索器并非完美無缺,檢索內容的噪聲問題,已被眾多研究證實會損害 RAG 系統性能。

為此,學界展開多方面探索。在查詢表述優化上,通過改進查詢構建方式,提升檢索精準度;檢索器增強方面,采取優化檢索器架構與算法,提高檢索效率與質量;生成器改進方向,著力優化生成模型,增強其基于檢索知識生成高質量文本的能力;檢索文檔后處理優化領域,通過對檢索文檔的篩選、整合與提煉,提升知識可用性。但隨著任務復雜度攀升,單次檢索獲取足量知識愈發困難,這些方法仍未徹底解決問題。

2.2 迭代檢索

迭代檢索是為處理復雜問題求解時動態變化的知識需求而設,關鍵在于精準判定檢索時機與內容。諸如 ITER-RETGEN 將輸入問題與前次迭代生成的輸出拼接成新查詢,雖取得一定成果,但僅反映既有知識,未明確揭示 LLMs 的信息需求。以生成的下一句為查詢,并依檢索結果優化前一句,雖更精準定位信息需求,卻高度依賴精心設計的少樣本提示,需持續檢索與優化,人力成本與推理成本居高不下。Self-RAG 訓練 LLMs 反思檢索與生成內容,但學習過程機械,未有效培育推理能力,限制了模型表現。

與上述方法相較,Auto-RAG 全面釋放 LLMs 在迭代檢索中的推理式自主決策潛能,憑借推理自主抉擇檢索時機與內容,性能更優、效率更高,為迭代檢索開辟新路徑。

3.方法

3.1 基于推理的迭代檢索

我們將迭代檢索視作 LLM 與檢索器的多輪交互流程。用戶查詢觸發交互,持續至獲取充足知識形成最終答案。每次迭代中,Auto-RAG 依當前狀態深度推理,判斷是否需額外檢索及確定所需信息,待知識完備則停止查詢并作答。

3.1.1 基于推理的規劃與查詢優化

為優化迭代效率與連貫性,我們構建契合人類認知的推理范式,涵蓋檢索規劃、信息提取、答案推斷三個核心環節:

檢索規劃:接收用戶問題時,LLM 需精準明確解答所需知識,檢索文檔后評估是否需進一步檢索及明確后續檢索方向。此規劃全程至關重要,如同導航系統,可提升檢索效率、規避迷失方向風險(Wang 等人,2024a)。例如在歷史知識問答中,面對“文藝復興對歐洲科技發展的影響”問題,LLM 應迅速梳理出需檢索文藝復興時期科技成果、代表人物貢獻、社會環境變革等知識要點,并依據首輪檢索結果決定是否深入挖掘特定領域知識或拓展檢索范疇。

信息提取:處理檢索文檔時,LLM 應高效提取關鍵信息,過濾無關內容。這一過程類似專業學者研讀文獻,提煉精華,增強處理外部知識的效率與準確性(Wei 等人,2023;Xu 等人,2024)。以醫學研究文獻檢索為例,面對海量醫學論文,LLM 需精準提取疾病病因、癥狀、治療方案、實驗數據等核心信息,摒棄無關的研究背景、實驗設備介紹等冗余內容,為答案推斷筑牢基礎。

答案推斷:集齊解答問題的全部知識后,LLM 運用推理生成準確答案,降低幻覺風險,確保回應可靠精準(Wei 等人,2023)。如在復雜物理問題求解中,綜合各類物理定律、實驗數據及現象描述后,LLM 經嚴謹推理得出符合物理原理與實際情況的答案,避免無根據的臆測與錯誤結論。

這三種推理共同構成迭代檢索的思維鏈條。我們采用少樣本提示法激發推理過程,依實際情境靈活調整步驟。初始接收問題時可省略后兩步,檢索信息全無關時跳過信息提取,確保模型依據情境精準判斷,而非機械模仿與虛構答案。用于激發推理的提示示例見附錄C.1,同時利用靈活提示策略生成多樣查詢,擺脫少樣本提示的風格局限,提升檢索靈活性與全面性。

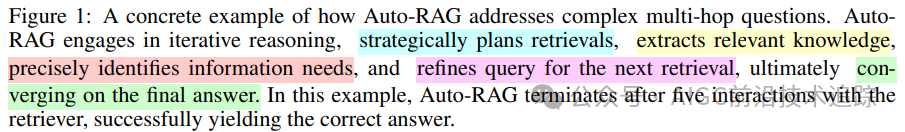

3.1.2 數據過濾與格式化

數據過濾:雖闡明迭代檢索推理與查詢優化方法,但仍可能產生推理瑕疵或不佳查詢。我們通過對生成的推理與查詢篩選。在含子答案的多跳問答數據集里,每次檢索迭代多采樣查詢,保留檢索文檔含子答案的查詢。同時,若最終答案與數據集參考答案吻合,則保留數據,確保迭代檢索質量與答案連貫性。算法 1 清晰勾勒指令合成與過濾框架,從源頭提升數據質量,為模型訓練與性能優化奠定堅實基礎。

數據格式化:將迭代檢索視作多輪交互對話,各輪輸入為用戶問題或檢索文檔,輸出是 LLM 的推理、檢索規劃或最終答案。

3.2 訓練

為賦予任意 LLM 迭代檢索自主決策能力,我們選用標準監督微調策略。依公式 :

計算交叉熵損失,通過反向傳播優化模型參數,使模型學習到精準的決策模式與推理邏輯,提升在迭代檢索任務中的性能表現。

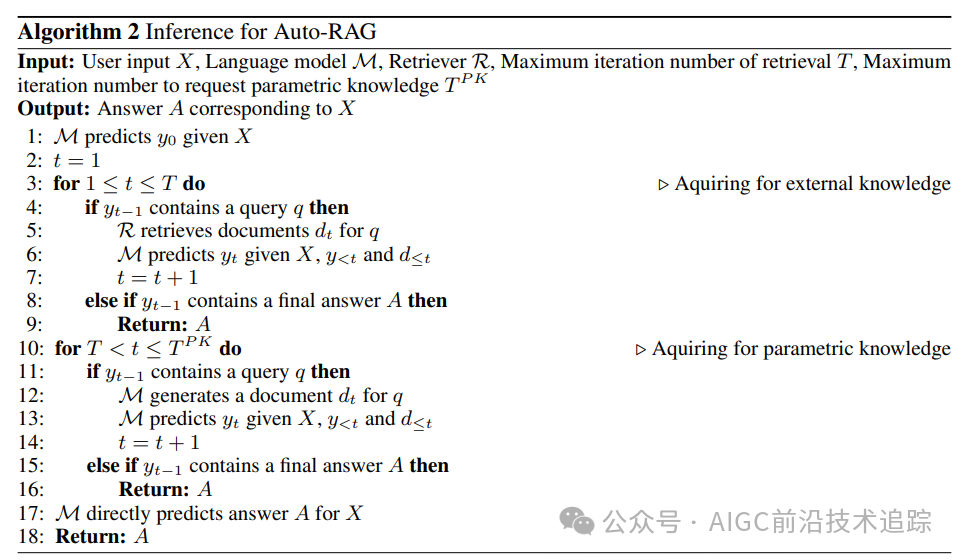

3.3 推理

4.實驗

4.1 實驗設置

本研究聚焦 Auto-RAG 于問答(QA)任務應用,涵蓋開放域 QA與多跳 QA領域。

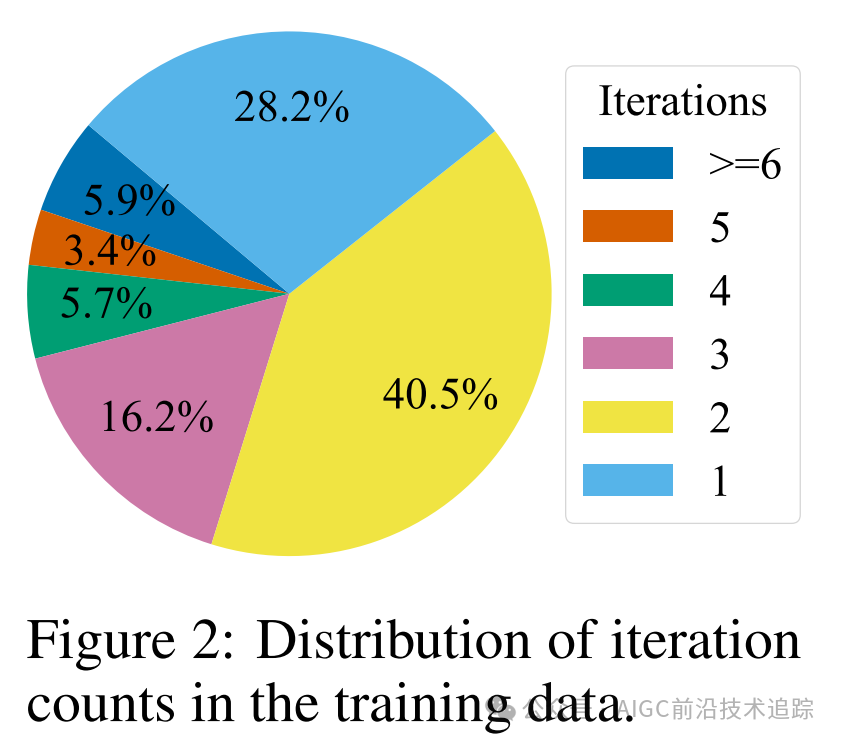

為訓練 Auto-RAG,我們以 Natural Questions(NQ)和 2WikiMultihopQA(2Wiki)兩個代表性數據集為藍本,精心合成 10,000 條基于推理的指令。選用 Llama-3-8B-Instruct 塑造推理過程,Qwen1.5-32B-Chat 構建改寫查詢,隨后用合成指令對 Llama-3-8B-Instruct 微調五輪,強化其迭代檢索自主決策能力。訓練數據迭代次數分布如圖 2 所示,呈現出一定規律,為模型性能評估與優化提供數據洞察。

評估環節,我們橫跨 NQ、2Wiki、TriviaQA(TQA)、PopQA(PQA)、HotpotQA(HQA)和 WebQuestions(WQ)六個數據集展開嚴格測試,采用 E5-base-v2 作檢索器,以 2018 年 12 月 Wikipedia 數據轉儲為檢索語料庫,遵循標準報告結果與指標,NQ、TQA、WQ 用精確匹配(EM),2Wiki、PQA、HQA 用 F1 分數,各數據集超參數詳情于附錄 B 完整呈現,確保實驗設置科學合理、結果可比可靠。

4.2 基線方法

基線設置全面涵蓋無檢索(Naive Gen)、單次檢索與多次檢索(迭代檢索)方法:

無檢索基線(Naive Gen):以 Llama-3-8B-Instruct 零樣本設置評估性能,展現模型自身知識儲備應對問答任務的水平,為對比檢索增強策略效果提供基礎參照。

單次檢索基線:過程優勢,多維度剖析單次檢索性能邊界與提升方向。對比 RECOMP-abstractive 和 Selective-Context 在上下文選擇優化的成果、REPLUG 對生成器性能提升成效,以及 IRCoT閱讀解釋檢索文檔時思維鏈(CoT)

多次檢索基線(迭代檢索):將 Auto-RAG 與 FLARE、Iter-RetGen、Self-RAG 對比。前兩者分別依賴手動定義檢索內容與規則判定檢索時機,Self-RAG 靠預測反思標記決定檢索與評估結果質量,Auto-RAG 則憑借自主推理決策脫穎而出,凸顯智能自主檢索優勢。

4.3 主要結果

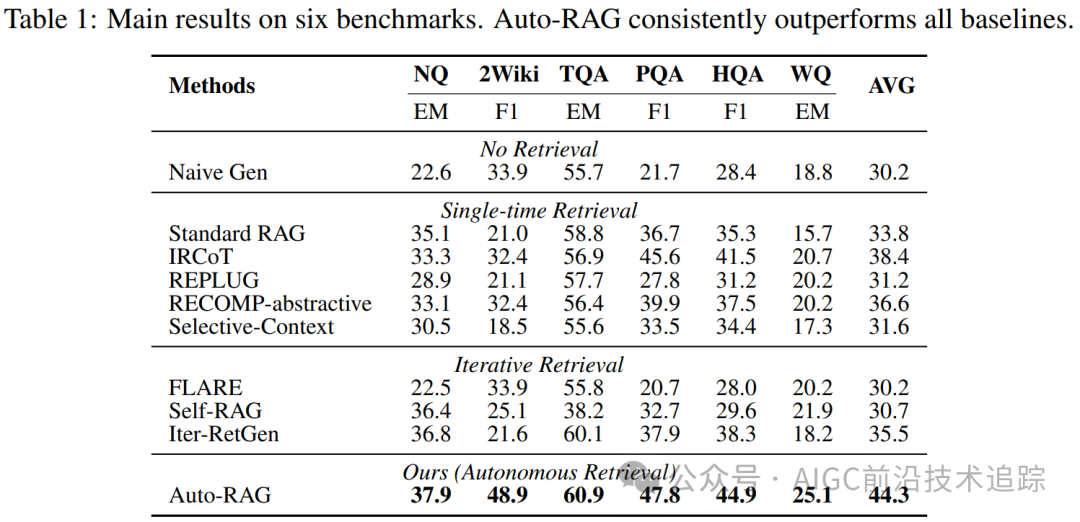

表 1 展示六個基準測試結果,Auto-RAG 在各數據集表現優異,超越其他迭代檢索方法。與 Iter-RetGen 相比,其擺脫手動定義檢索內容與次數依賴;相對 FLARE,突破預定義規則限制,自主決策檢索時機與內容,精準高效;相較于 Self-RAG,融入迭代推理機制,決策更精細合理,優化檢索策略應對復雜任務,在六個基準測試中成績斐然,有力證明其在問答任務中的卓越性能與領先地位,為知識檢索與答案生成樹立新標桿。

5.分析

5.1 對問題和檢索器的強適應性

實際應用中,問題復雜度與檢索文檔長度差異顯著,檢驗 Auto-RAG 適應性至關重要。分析多數據集不同檢索文檔數量下 Auto-RAG 迭代比例與性能:

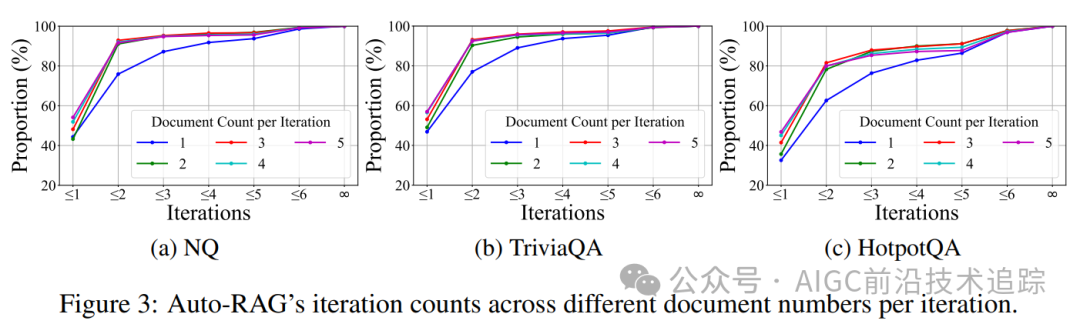

迭代次數自適應調整:如圖 3,單跳 QA 任務 NQ 和 TriviaQA 首輪迭代終止比例高于多跳 QA 任務 HotpotQA,因單跳任務信息需求相對簡單,模型能快速判定檢索充分性。且隨每輪檢索文檔增多,首輪迭代終止比例上升,表明模型依信息充足度靈活調控迭代次數,如信息充裕則速決,不足則持續檢索,智能適配任務需求。

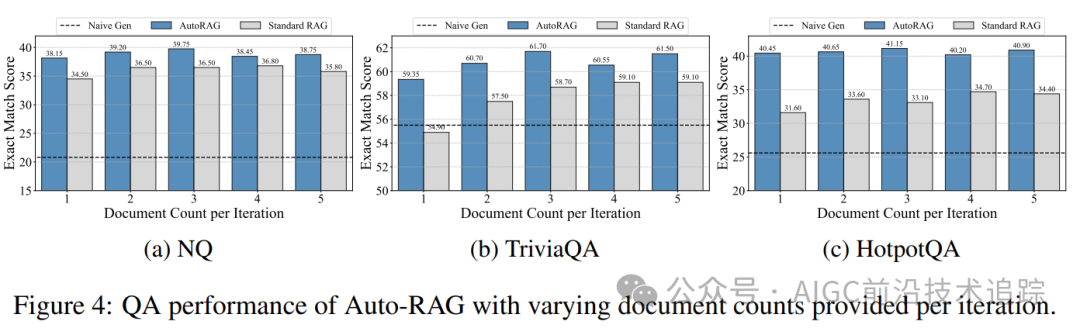

文檔數量影響性能:圖 4 顯示不同文檔數量影響 QA 性能,在三個任務中,每輪提供三篇文檔時效果佳,揭示合適文檔量對模型性能提升關鍵作用,為檢索器設置與檢索策略優化指引方向,確保模型輸入信息質與量平衡。

對比無檢索(Naive Gen)和 Standard RAG,Auto-RAG 性能卓越且波動小,穩健應對檢索器差異,為復雜多變實際應用筑牢可靠性能根基。

5.2 消融研究

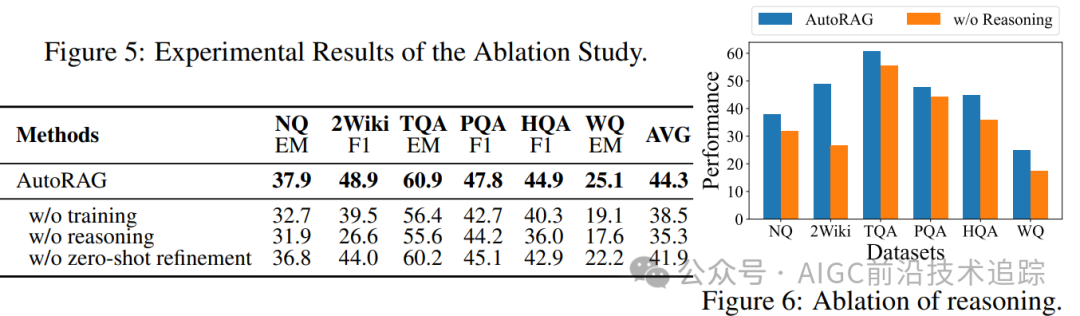

通過消融實驗深度驗證 Auto-RAG 訓練、迭代推理與數據構建環節關鍵作用:

訓練成效顯著:經訓練的 Auto-RAG 相較以少樣本提示合成數據引導的未訓練模型優勢盡顯。未訓練模型在問答任務中常陷入困境,因依賴少樣本提示致使推理過程生硬、缺乏靈活性,額外推理開銷巨大。而訓練后的 Auto-RAG 憑借微調學習,精準捕捉數據深層特征與邏輯關聯,將知識深度內化于模型架構,構建高效檢索決策體系,有力消除少樣本局限,在復雜問答情境下迅速定位關鍵知識,大幅提升答案準確性與完整性,彰顯訓練對模型迭代檢索能力進階的核心驅動價值。

迭代推理賦能:對比直接依檢索文檔生成答案的模型,融入迭代推理的 Auto-RAG 在解決復雜問題時效果提升顯著。缺乏推理環節的模型面對多跳、邏輯嵌套問題時易迷失方向,誤判信息關聯,答案質量參差不齊。Auto-RAG 的迭代推理機制似智慧導航,逐輪剖析問題、精準甄別信息需求、動態優化檢索策略。如在科學知識問答中,面對多因素交織難題,Auto-RAG 層層推理、抽絲剝繭,挖掘知識間微妙聯系,直至構建完整邏輯鏈條解答問題,有力印證推理環節對提升模型復雜任務處理能力的關鍵意義,契合推理提升模型能力的理論預期。

數據構建優勢:在數據合成環節,零樣本查詢改寫方法遠超少樣本查詢精煉。少樣本查詢精煉受樣本數量與分布制約,易陷入局部最優陷阱,生成查詢趨同、覆蓋范圍窄。零樣本方法擺脫樣本束縛,基于語義理解與知識泛化動態生成多元查詢。如歷史事件檢索中,能從不同視角時段構建查詢,大幅提升檢索全面性精準度,為模型挖掘深層知識、優化答案創造豐富信息源,充分展現數據構建策略優化對提升 Auto-RAG 整體性能的深遠影響。

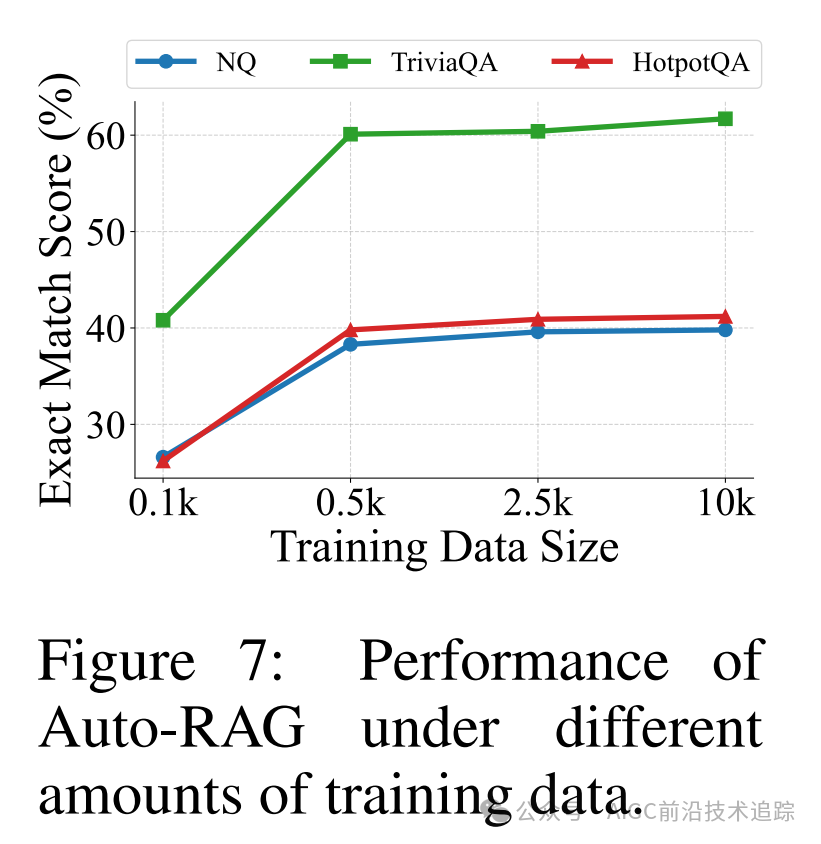

5.3 數據縮放

系統探究 Auto-RAG 在不同指令數量訓練下性能演變規律,將訓練數據量從 0.1k 精細拓展至 10k 并于問答任務評估。實驗數據(圖 7)清晰顯示:約 0.5k 數據量時,模型初獲自主檢索能力萌芽,此階段模型似懵懂學徒,依據有限指令初步構建知識檢索框架,嘗試探索信息海洋,雖檢索決策稍顯稚嫩,但已具備應對簡單問答基礎能力,開啟智能檢索征程第一步。隨數據量穩步攀升,模型性能呈持續上揚態勢。豐富數據為模型注入知識養分,助其深化語義理解、拓展知識視野、強化邏輯推理,精準洞察問答任務復雜模式與微妙語境差異。于海量歷史文獻問答中,大量數據使模型精準解析時代背景、人物關系及事件脈絡,優化檢索路徑、精準篩選關鍵知識片段,大幅提升答案準確性與權威性,為模型性能與數據規模間緊密關聯提供有力量化支撐,指引模型訓練資源高效配置與性能深度優化方向。

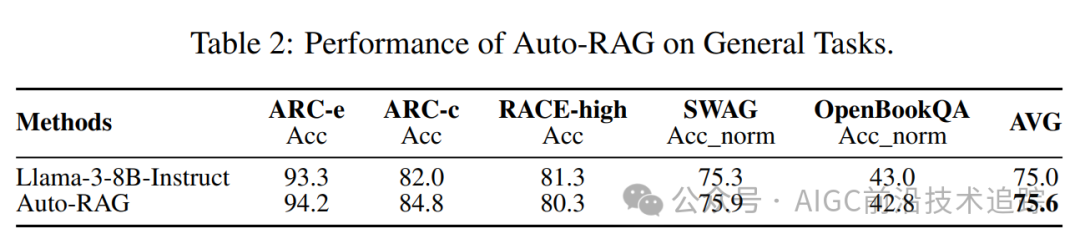

5.4 一般任務性能

為全面度量 Auto-RAG 通用任務處理實力,精心擇取多領域權威基準測試,涵蓋 AI2 推理挑戰、考試閱讀理解數據集、對抗生成場景及開放圖書問答等。實驗結果(表 2)表明,Auto-RAG 在 ARC 與 SWAG 任務中成績耀眼、進步顯著。經合成數據專項訓練,LLMs 推理內核深度強化,賦予 Auto-RAG 應對對抗任務復雜挑戰卓越智慧。于 ARC 任務邏輯迷宮里,面對環環相扣推理難題,Auto-RAG 運用知識檢索銳眼捕捉關鍵線索,憑借嚴密邏輯思維熔爐錘煉答案,精準拆解迷惑陷阱、嚴密推導正確結論,展現強大邏輯推理與知識運用協同能力;在 SWAG 對抗戰場,面對誤導干擾,Auto-RAG 依深厚知識儲備與靈動應變智慧,精準剖析語境語義、敏銳識破陷阱偽裝,生成合理答案,凸顯強大泛化能力與環境適應韌性,為處理跨領域復雜任務筑牢堅實能力根基,拓展人工智能技術應用邊界。

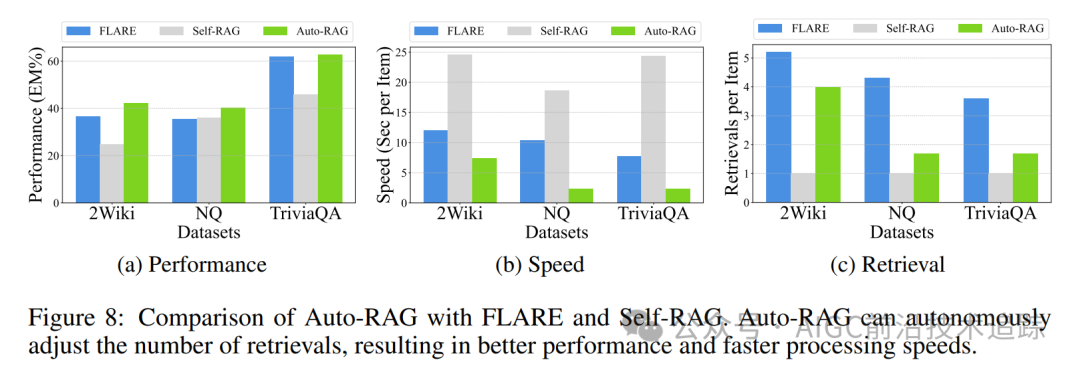

5.5 效率

對比 Auto-RAG 與 FLARE、Self-RAG 效率(圖 8),FLARE 困于手動規則桎梏,檢索修訂流程機械、應變遲緩,檢索低概率成分時資源消耗大、效率低迷;Auto-RAG 以自主智能決策為引擎,動態規劃檢索軌跡,性能卓越、檢索次數精簡、處理速度飆升。Self-RAG 處理短問答時逐個文檔孤立生成答案與反思,忽視文檔關聯協同,檢索次數盲目依賴輸出長度,耗時費力且易陷入局部最優;Auto-RAG 依問題復雜度與知識關聯度智能調配迭代節奏,如敏銳獵手精準捕獲關鍵知識,高效生成優質答案,于各數據集性能與效率指標優勢盡顯(圖 8),于實際問答場景中大幅提升用戶信息獲取時效,重塑智能問答效率典范。

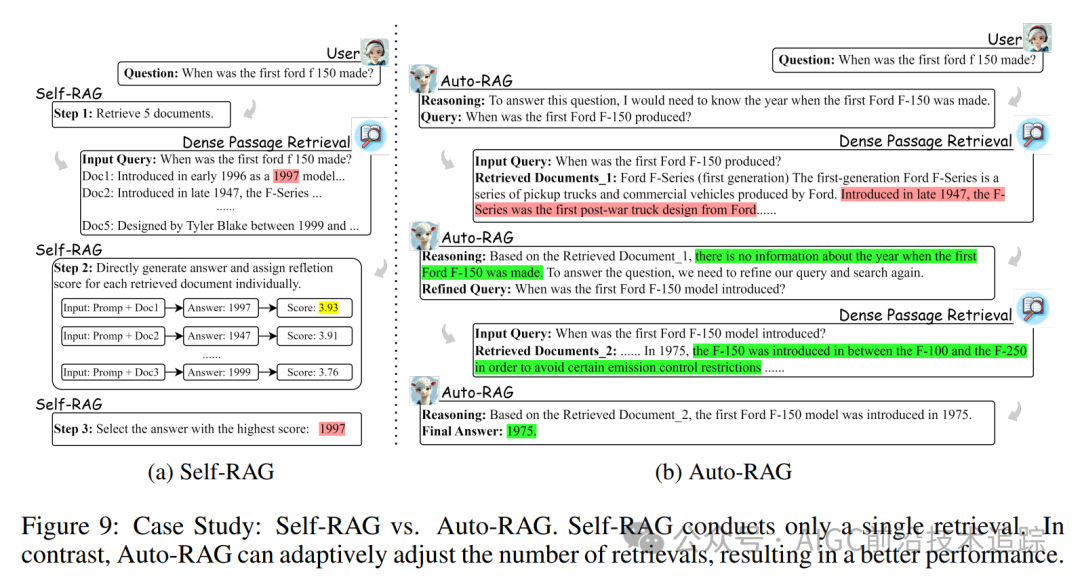

5.6 案例研究

深入對比 Auto-RAG 與 Self-RAG 案例(圖 9),Self-RAG 對檢索文檔獨立處理、孤立評估反思,選最高分答案策略弊端顯著。處理復雜問題時,因未考量文檔內在邏輯關聯,易被無關信息誤導,當文檔皆無關時,無法主動拓展搜索糾錯,致答案可靠性受損;Auto-RAG 以自主決策為智慧中樞,依知識價值動態導航檢索路徑,遇無關文檔冷靜篩選、持續探索,直至掘取關鍵知識點亮答案燈塔。且 Auto-RAG 以自然語言清晰闡釋推理脈絡,Self-RAG 反射令牌式反思晦澀難懂。如剖析文學作品深層寓意問答場景,Auto-RAG 以流暢自然語言引領用戶漫步推理之路,Self-RAG 則令用戶于符號迷宮中迷茫,Auto-RAG 大幅提升交互可解釋性與用戶體驗,開啟智能交互新紀元。

6.結論

在這篇論文中,我們介紹了 Auto-RAG,這是一個以大型語言模型強大的決策能力為核心的自主迭代檢索模型。Auto-RAG 通過多輪對話與檢索器進行交互,系統地規劃檢索并優化查詢以獲取有價值的知識,直到獲得足夠的外部信息,此時將結果呈現給用戶。為此,我們開發了一種在迭代檢索中自主合成基于推理的決策指令的方法,并對最新的開源大型語言模型進行了微調。分析結果表明,Auto-RAG 不僅實現了出色的性能,還保持了高度的可解釋性,為用戶提供了更直觀的體驗。

本文轉載自 ??AIGC前沿技術追蹤??,作者: 喜歡學習的小仙女