大模型訓練的本質是什么?以及大模型訓練的核心要點 原創

?“ 大模型訓練的本質,是一個參數不斷優化的過程 ”

大模型訓練的本質是通過大量的數據和計算資源,優化一個參數化的模型,使其能夠在高緯空間中擬合復雜的輸入和輸出關系;從而學習到數據中的模式和規律,并能對未知數據進行推理和預測。

大模型訓練的本質

要想了解大模型訓練的本質,首先要明白大模型是什么;從表面來看,大模型就是一個具有大量參數的神經網絡模型。

可能上面這句話很多人已經聽了很多遍,但往往復雜的問題總是隱藏在這些簡單的描述中,而大模型為什么需要訓練,這個定義也講的一清二楚。

我們來一步一步的分解上面這句話,大模型首先是一個模型(機器學習模型/神經網絡模型);其次,大模型具有很多參數,所以大模型是一個具有大量參數的神經網絡模型;所以本質上大模型是一個參數化的模型。

既然是參數就說明這些參數是可以調整的,所以大模型訓練的本質就是不斷的優化模型參數的過程。

我們都知道大模型是根據人類的大腦神經仿真的一套神經網絡模型,雖然這套模型被仿真出來了;但它就像人類的小孩子一樣,雖然小孩子的大腦結構雖然和大人沒什么區別;但大人的大腦中存儲了更多更復雜的信息。

所以,孩子需要不斷的學習和經歷,然后不斷的去優化自己的大腦,這也是孩子不斷成長的過程;大模型同樣如此,雖然設計出來的大模型結構已經很完美了,但它的認知參數還不夠完善;因此才需要大量的數據對大模型進行訓練,也就是不斷的優化大模型的參數值,而這個過程也被叫做學習,這就是大模型訓練的本質。

大模型訓練的核心要點

既然大模型訓練的過程就是其參數不斷優化的過程,那到底應該怎么去優化這些參數呢?這就有了以下幾個訓練的要點。

- 目標函數優化

- 數據驅動學習

- 高緯空間的擬合

- 泛化和正則化

- 計算資源和分布式計算

- 最終目標

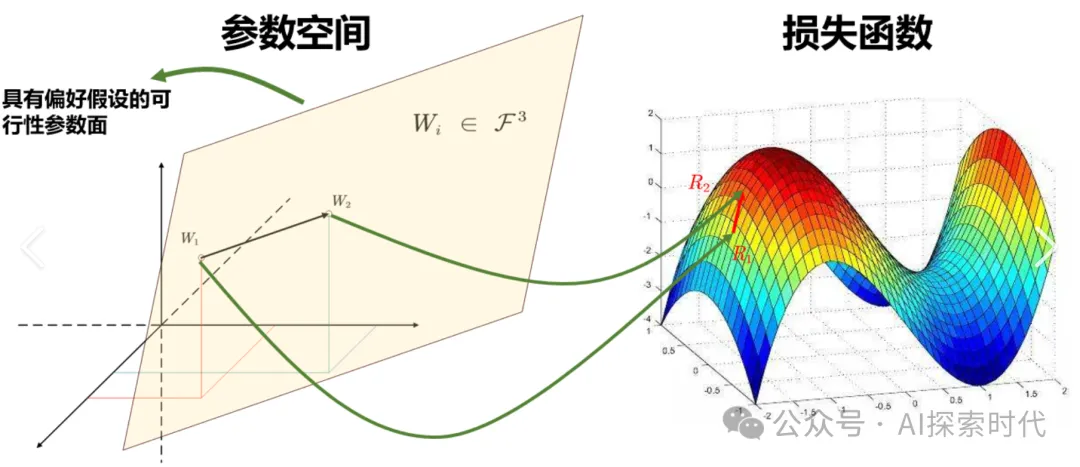

目標函數優化

知道了大模型訓練的本質,那么目標函數優化就很好理解了;大模型訓練的本質既然是一個優化問題,那么就需要一種辦法讓大模型知道自己的不足,以及自動完成優化的過程;而這就需要一個損失計算函數如交叉熵,均方誤差等;以及一個優化函數,如梯度下降,Adam等。

- 梯度計算:

使用反向傳播算法計算損失函數關于模型參數的梯度。

- 參數更新:

- 通過梯度下降或其變種(如Adam、RMSProp)對模型參數進行更新。

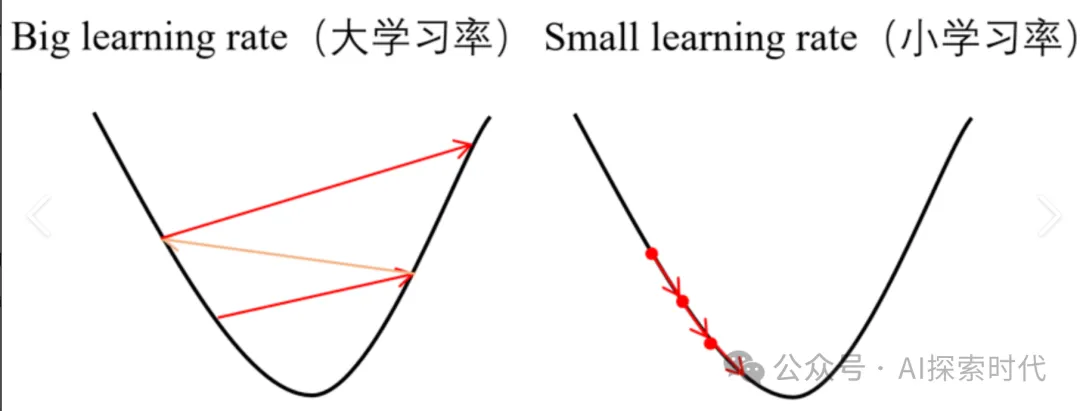

- 學習率:

- 控制參數更新的步長,過大可能導致訓練不穩定,過小會使訓練收斂速度變慢。

數據驅動學習

模型通過海量訓練數據的輸入,通過目標函數不斷的更新權重來學習數據中的權重與特征。

學習方式主要有:

監督學習

無監督學習

強化學習等

高緯空間的擬合

大模型本質上是一個多層嵌套的函數,能夠表示非常復雜的高緯線性關系;通過層層特征變換(如卷積,全連接等),將輸入數據從原始空間映射到一個更容易分離的特征空間。

泛化和正則化

泛化能力:模型在未見過的數據上表現良好的能力

防止過擬合:大模型容易過擬合訓練數據,因此需要采用正則化技術;如:

- 權重衰減(L2正則化)

- Dropout

- 數據增強

- 提前停止訓練

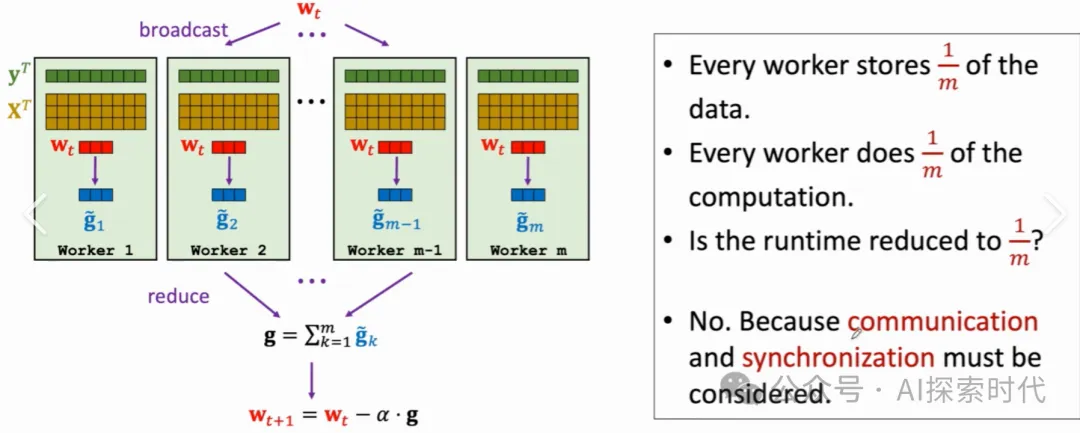

計算資源與分布式訓練

大模型需要龐大算力資源和存儲能力:

GPU/TPU加速矩陣計算

分布式訓練將模型和數據分布到多個節點中并行計算

優化技巧:

- 梯度剪裁防止梯度爆炸。

- 混合精度訓練加速模型收斂并降低顯存占用。

最終目標

不管大模型的設計和實現有多么的牛逼,大模型的唯一目標就是能夠解決現實問題,否則無論采用什么技術都將毫無意義。

因此,大模型訓練的目的就是獲取一個具有強泛化能力的模型,用來解決現實中的問題。

- 圖像分類、目標檢測(如ResNet、YOLO)

- 自然語言處理(如GPT、BERT)

- 生成任務(如Stable Diffusion、GAN)

- 多模態任務(如CLIP、GPT-4)

?

本文轉載自公眾號AI探索時代 作者:DFires