從頻率到細(xì)節(jié):ConsisID實(shí)現(xiàn)無縫身份一致的文本到視頻生成

文章鏈接: https://arxiv.org/abs/2411.17440

項(xiàng)目鏈接: https://pku-yuangroup.github.io/ConsisID/

亮點(diǎn)直擊

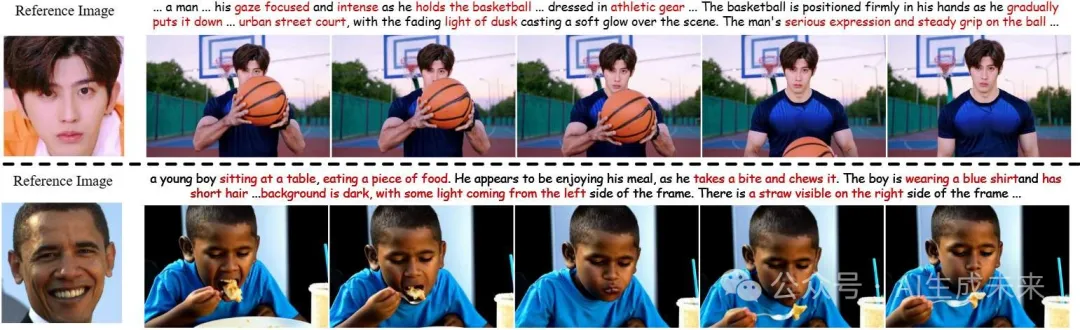

- 提出了ConsisID,一個(gè)基于 DiT 的免調(diào)優(yōu)(tuning-free)身份保持 IPT2V 模型,通過頻率分解的控制信號(hào)來保持視頻主角的身份一致性。

- 提出了一種分層訓(xùn)練策略,包括粗到細(xì)的訓(xùn)練過程、動(dòng)態(tài)Mask損失(dynamic mask loss)以及動(dòng)態(tài)跨臉損失(dynamic cross-face loss),共同促進(jìn)模型訓(xùn)練并有效提升泛化能力。

- 大量實(shí)驗(yàn)表明,受益于我們的頻率感知身份保持 T2V DiT 控制方案,ConsisID 能夠生成高質(zhì)量、可編輯且身份一致性強(qiáng)的視頻。

總結(jié)速覽

解決的問題提出一種解決生成一致人物身份的視頻問題(Identity-preserving text-to-video,IPT2V)的方法,重點(diǎn)解決當(dāng)前生成模型存在的兩個(gè)難題:

- 去除繁瑣的逐個(gè)問題(case-by-case)進(jìn)行微調(diào)(tuning-free)。

- 提供頻率感知的身份一致性控制方案。

提出的方案

- ConsisID: 一個(gè)基于 Diffusion Transformer (DiT) 的可控 IPT2V 模型,通過頻率域的身份控制信號(hào)保持生成視頻中的人類身份一致性。

- 低頻控制: 引入全局人臉特征提取器,將參考圖像和人臉關(guān)鍵點(diǎn)編碼為包含低頻信息的特征,并集成到網(wǎng)絡(luò)淺層以緩解訓(xùn)練難度。

- 高頻控制: 設(shè)計(jì)局部人臉特征提取器,捕獲高頻細(xì)節(jié)并注入 Transformer 模塊,增強(qiáng)模型對(duì)細(xì)粒度特征的保留能力。

- 提出分層訓(xùn)練策略,利用頻率信息從預(yù)訓(xùn)練視頻生成模型轉(zhuǎn)化為IPT2V 模型。

應(yīng)用的技術(shù)

- 頻率分析的視覺/擴(kuò)散 Transformer 理論,通過分解人臉特征為低頻全局特征(如輪廓、比例)和高頻內(nèi)在特征(如身份tokens)。

- 結(jié)合全局和局部人臉特征提取器,將低頻和高頻特征注入網(wǎng)絡(luò)。

- 分層訓(xùn)練策略,使模型能夠靈活控制身份一致性。

達(dá)到的效果

- ConsisID 無需逐案例微調(diào),實(shí)現(xiàn)了高效的控制能力。

- 生成高質(zhì)量且身份一致性強(qiáng)的視頻,在IPT2V任務(wù)中取得優(yōu)異表現(xiàn)。

- 推動(dòng)了身份一致性視頻生成技術(shù)的進(jìn)一步發(fā)展。

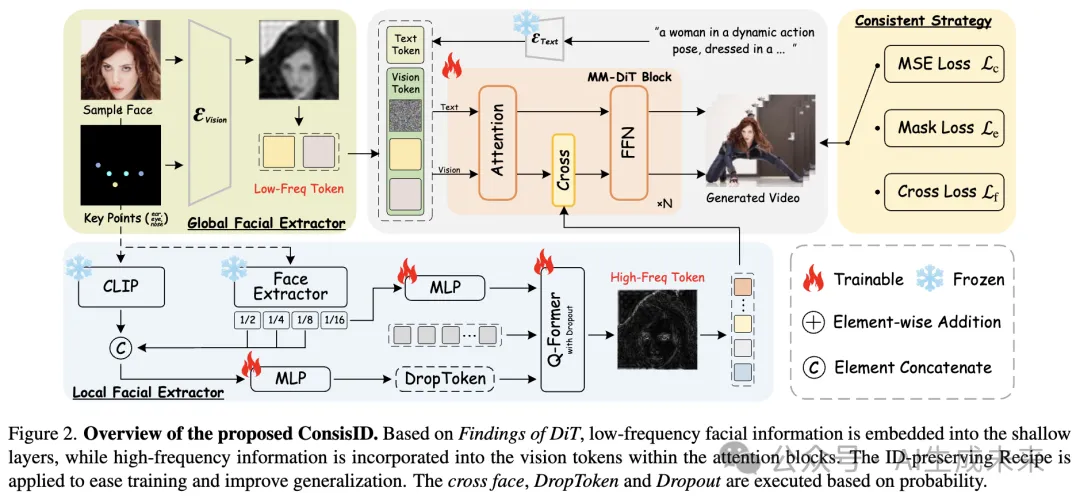

發(fā)現(xiàn) 1:淺層(例如,低級(jí)別、低頻率)特征對(duì)于擴(kuò)散模型中的像素級(jí)預(yù)測(cè)任務(wù)至關(guān)重要,因?yàn)樗鼈冇兄谀P陀?xùn)練。U-Net 通過長跳躍連接將淺層特征聚合到解碼器,從而促進(jìn)模型的收斂,而 DiT 沒有采用這種機(jī)制;發(fā)現(xiàn) 2:Transformer對(duì)于高頻信息的感知能力有限,而高頻信息對(duì)于保持面部特征非常重要。U-Net 的編碼器-解碼器架構(gòu)天然具備多尺度特征(例如,豐富的高頻信息),而 DiT 缺乏類似的結(jié)構(gòu)。要開發(fā)基于 DiT 的控制模型,首先需要解決這些問題。

方法

ConsisID: 保持身份一致性

概述如下圖 2 所示。給定參考圖像,全局人臉特征提取器和局部人臉特征提取器將高頻和低頻的人臉信息注入模型,并在一致性訓(xùn)練策略的輔助下生成身份一致性視頻。

低頻視角:全局人臉特征提取器

基于發(fā)現(xiàn) 1,增強(qiáng)低層次(例如淺層、低頻)特征能夠加速模型收斂。為了讓預(yù)訓(xùn)練模型更容易適應(yīng) IPT2V 任務(wù),最直接的方法是將參考人臉與噪聲輸入的潛變量進(jìn)行拼接。然而,參考人臉同時(shí)包含高頻細(xì)節(jié)(如眼睛和嘴唇紋理)和低頻信息(如面部比例和輪廓)。

根據(jù)發(fā)現(xiàn) 2,過早將高頻信息注入 Transformer 不僅效率低下,還可能阻礙模型對(duì)低頻信息的處理,因?yàn)?Transformer 主要關(guān)注低頻特征。

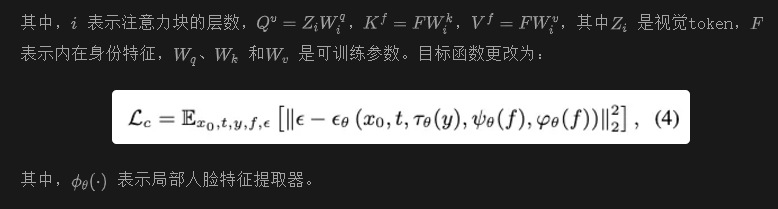

此外,直接將參考人臉輸入模型可能引入諸如光照和陰影等無關(guān)噪聲。為了解決這個(gè)問題,我們提取面部關(guān)鍵點(diǎn),將其轉(zhuǎn)換為 RGB 圖像,然后將其與參考圖像拼接,如圖 2 所示。這一策略使模型的注意力集中在人臉的低頻信號(hào)上,同時(shí)最大限度減少多余特征的影響。發(fā)現(xiàn),當(dāng)這一組件被移除時(shí),模型會(huì)出現(xiàn)梯度爆炸。目標(biāo)函數(shù)被修改為:

高頻視角:局部人臉特征提取器

根據(jù)發(fā)現(xiàn) 2,認(rèn)識(shí)到 Transformer 對(duì)高頻信息的敏感度有限。因此,僅依賴全局人臉特征不足以滿足 IPT2V 生成的需求,因?yàn)槿秩四樚卣髦饕傻皖l信息組成,缺乏編輯所需的內(nèi)在特征。本任務(wù)不僅需要保持身份一致性,還需要具備編輯能力,例如生成具有相同身份但不同年齡或妝容的視頻。

實(shí)現(xiàn)這一目標(biāo)需要提取不受非身份屬性(如表情、姿態(tài)和形狀)影響的面部特征,因?yàn)槟挲g和妝容不會(huì)改變一個(gè)人的核心身份。我們將這些特征定義為內(nèi)在身份特征(例如高頻特征)。

先前的研究 [14–16] 使用 CLIP 圖像編碼器的局部特征作為內(nèi)在特征以提升編輯能力。然而,由于 CLIP 未專門在面部數(shù)據(jù)集上訓(xùn)練,提取的特征包含有害的非面部信息。因此,選擇使用人臉識(shí)別骨干網(wǎng)絡(luò)提取內(nèi)在身份特征。與直接使用骨干網(wǎng)絡(luò)輸出作為內(nèi)在身份特征不同,我們使用其倒數(shù)第二層的輸出,因?yàn)樵搶颖A袅烁嗯c身份相關(guān)的空間信息。然而,這些特征仍然缺乏足夠的語義信息,而語義信息對(duì)個(gè)性化視頻生成至關(guān)重要。

為了解決這些問題,首先使用人臉識(shí)別骨干網(wǎng)絡(luò)提取在內(nèi)在身份表示方面具有優(yōu)勢(shì)的特征,并使用 CLIP 圖像編碼器捕獲具有強(qiáng)語義的信息。然后,使用 Q-Former融合這兩種特征,生成包含高頻語義信息的內(nèi)在身份特征。為減少 CLIP 中無關(guān)特征的影響,在輸入 Q-Former 之前應(yīng)用了 dropout。此外,通過插值將來自人臉識(shí)別骨干網(wǎng)絡(luò)的淺層多尺度特征與 CLIP 特征拼接。這種方法確保模型有效捕獲必要的內(nèi)在身份特征,同時(shí)過濾掉與身份無關(guān)的外部噪聲。

在提取內(nèi)在身份特征后,通過交叉注意力與預(yù)訓(xùn)練模型每個(gè)注意力塊生成的視覺標(biāo)記交互,有效增強(qiáng) DiT 中的高頻信息。

一致性訓(xùn)練策略

在訓(xùn)練過程中,從訓(xùn)練幀中隨機(jī)選擇一幀,應(yīng)用 Crop & Align提取面部區(qū)域作為參考圖像,并將其與文本一起用作身份控制信號(hào)。

粗到細(xì)的訓(xùn)練相比于身份保持的圖像生成,視頻生成需要同時(shí)在空間和時(shí)間維度上保持一致性,確保高頻和低頻的人臉信息與參考圖像匹配。為了降低訓(xùn)練的復(fù)雜性,本文提出了一種分層策略,讓模型先學(xué)習(xí)全局信息,再局部細(xì)化。在粗粒度階段(例如對(duì)應(yīng)發(fā)現(xiàn) 1),使用全局人臉特征提取器,使模型優(yōu)先關(guān)注低頻特征,如面部輪廓和比例,從而確保能夠快速從參考圖像中獲取身份信息并在視頻序列中保持一致性。在細(xì)粒度階段(例如對(duì)應(yīng)發(fā)現(xiàn) 2),局部人臉特征提取器將模型的注意力轉(zhuǎn)移到高頻細(xì)節(jié)上,例如眼睛和嘴唇的紋理細(xì)節(jié)(如內(nèi)在身份特征),以提高面部表情的逼真度和生成面部的整體相似性。

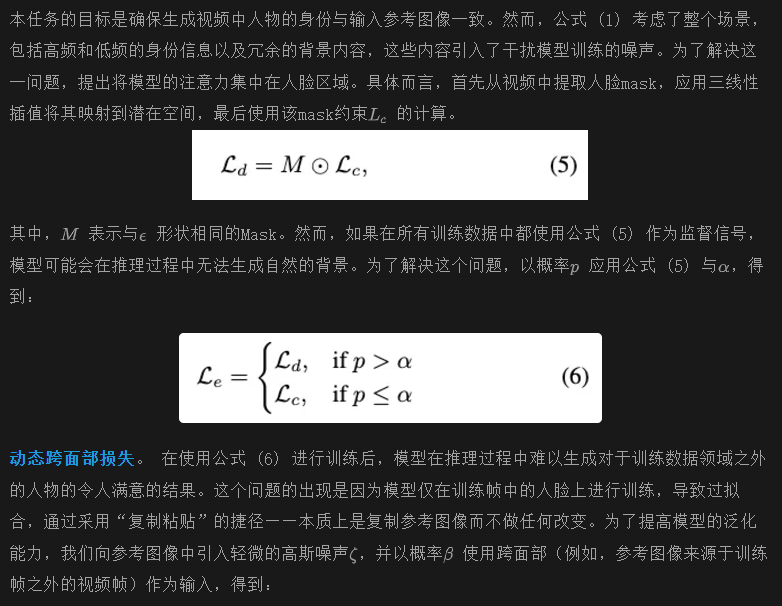

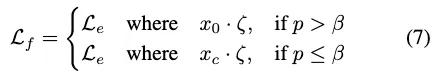

動(dòng)態(tài)Mask損失

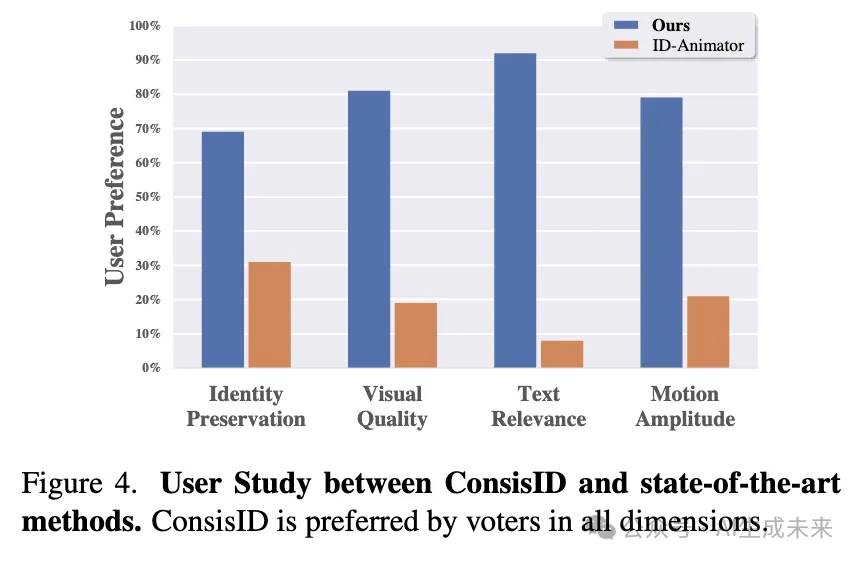

設(shè)置

實(shí)現(xiàn)細(xì)節(jié)

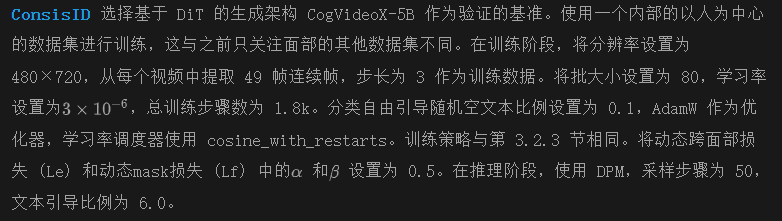

基準(zhǔn)測(cè)試由于缺乏評(píng)估數(shù)據(jù)集,選擇了 30 名未包含在訓(xùn)練數(shù)據(jù)中的人,并從互聯(lián)網(wǎng)上為每個(gè)身份來源了五張高質(zhì)量的圖像。然后,設(shè)計(jì)了 90 個(gè)不同的提示,涵蓋了各種表情、動(dòng)作和背景進(jìn)行評(píng)估。基于以往的研究 [15, 38],從四個(gè)維度進(jìn)行評(píng)估:

(1).身份保持:使用 FaceSim-Arc 并引入 FaceSim-Cur,通過測(cè)量生成視頻中面部區(qū)域與真實(shí)面部圖像在 ArcFace 和 CurricularFace 特征空間中的特征差異來評(píng)估身份保持。(2).視覺質(zhì)量:我們通過計(jì)算生成幀與真實(shí)面部圖像在 InceptionV3 特征空間中的面部區(qū)域特征差異來使用 FID進(jìn)行評(píng)估。(3).文本相關(guān)性:我們使用 CLIPScore 來測(cè)量生成的視頻與輸入提示之間的相似性。(4).運(yùn)動(dòng)幅度:由于缺乏可靠的度量標(biāo)準(zhǔn),我們通過用戶研究進(jìn)行評(píng)估。

定性分析

本節(jié)將 ConsisID 與 ID-Animator(例如,唯一可用的開源模型)進(jìn)行比較,以進(jìn)行無需調(diào)優(yōu)的 IPT2V 任務(wù)。我們隨機(jī)選擇了四個(gè)個(gè)體的圖像和文本提示進(jìn)行定性分析,這些個(gè)體均不包含在訓(xùn)練數(shù)據(jù)中。如下圖 5 所示,ID-Animator 無法生成超出面部的人體部位,并且無法根據(jù)文本提示(例如,動(dòng)作、屬性、背景)生成復(fù)雜的動(dòng)作或背景,這顯著限制了其實(shí)際應(yīng)用。此外,身份的保持也不足;例如,在案例 1 中,參考圖像似乎經(jīng)過了皮膚平滑處理。

在案例 2 中,引入了皺紋,降低了美學(xué)質(zhì)量。在案例 3 和 4 中,由于缺乏低頻信息,面部發(fā)生了扭曲,導(dǎo)致身份一致性受到損害。相比之下,提出的 ConsisID 始終生成高質(zhì)量、逼真的視頻,準(zhǔn)確匹配參考身份并符合提示。

定量分析

本屆展示了不同方法的全面定量評(píng)估,結(jié)果如下表 1 所示。

與上圖 5 一致,本文的方法在五個(gè)指標(biāo)上超過了現(xiàn)有的最先進(jìn)方法。在身份保持方面,ConsisID 通過從頻率角度為 DiT 設(shè)計(jì)適當(dāng)?shù)纳矸菪盘?hào),取得了更高的分?jǐn)?shù)。相比之下,ID-Animator 并未針對(duì) IPT2V 進(jìn)行優(yōu)化,僅部分保留了面部特征,導(dǎo)致 FaceSim-Arc 和 FaceSim-Cur 的分?jǐn)?shù)較低。在文本相關(guān)性方面,ConsisID 不僅通過提示控制表情,還調(diào)整動(dòng)作和背景,取得了更高的 CLIPScore。關(guān)于視覺質(zhì)量,F(xiàn)ID 僅作為參考呈現(xiàn),因?yàn)樗c人類感知的對(duì)齊有限 。有關(guān)視覺質(zhì)量的定性分析,請(qǐng)參見上圖 5 和 下圖4。

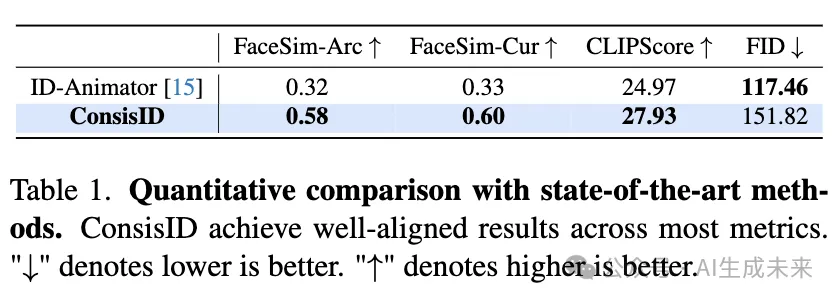

用戶研究

基于之前的工作,使用二元投票策略進(jìn)行人工評(píng)估,每份問卷包含80個(gè)問題。參與者需要觀看40個(gè)視頻片段,這一設(shè)置旨在提高參與度和問卷的有效性。對(duì)于 IPT2V 任務(wù),每個(gè)問題要求參與者分別判斷哪個(gè)選項(xiàng)在身份保持、視覺質(zhì)量、文本對(duì)齊和運(yùn)動(dòng)幅度方面表現(xiàn)更好。這一組成確保了人工評(píng)估的準(zhǔn)確性。由于此評(píng)估需要大量的參與者,我們成功收集了103份有效問卷。結(jié)果如上圖4所示,證明本文的方法在多個(gè)方面顯著優(yōu)于 ID-Animator,驗(yàn)證了所設(shè)計(jì)的 DiT 在 IPT2V 生成中的有效性。

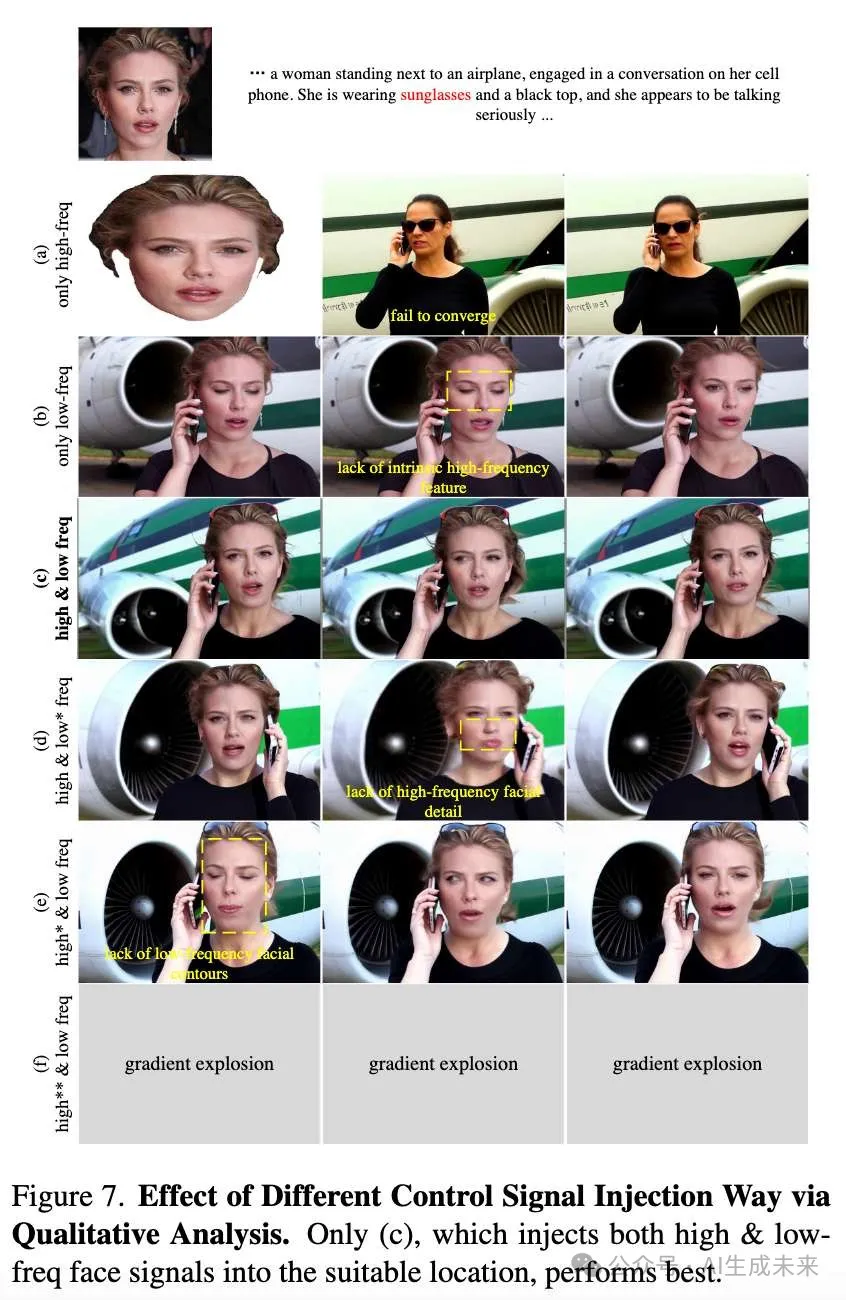

身份信號(hào)注入對(duì) DiT 的影響

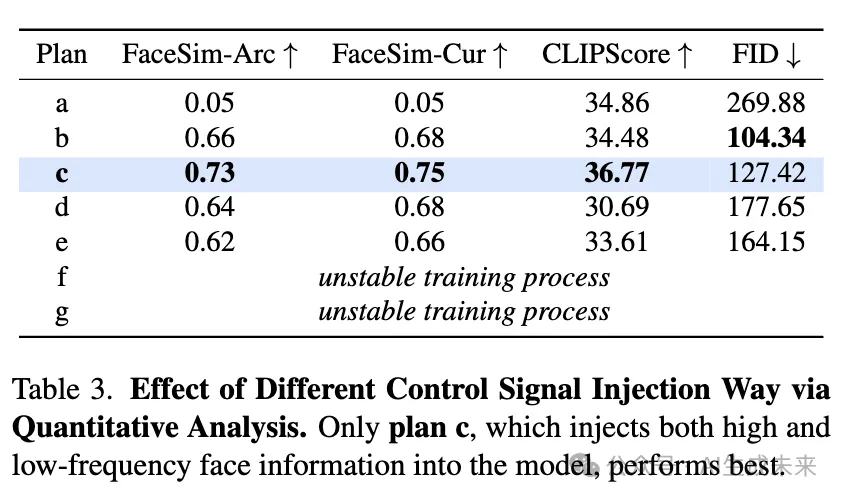

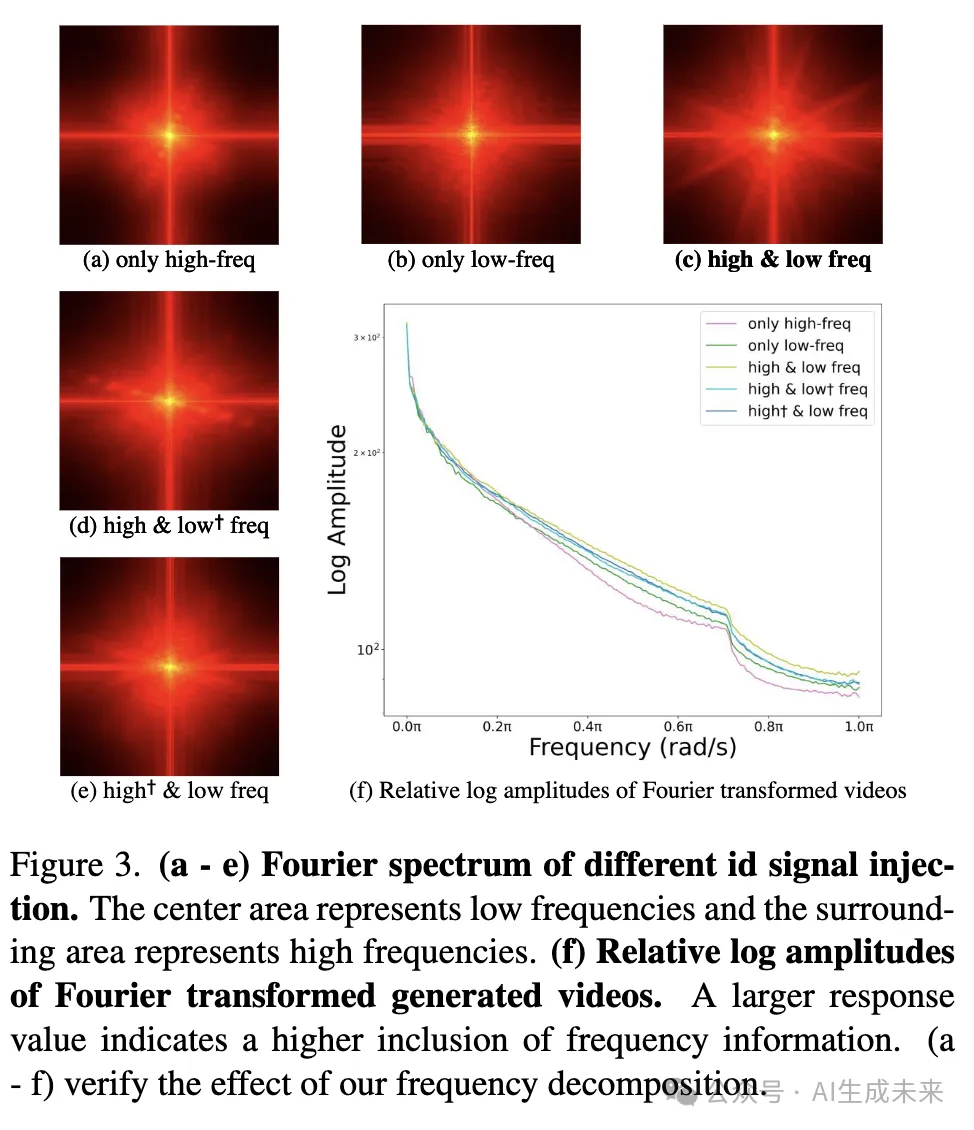

為了評(píng)估發(fā)現(xiàn)1和發(fā)現(xiàn)2的有效性,對(duì)不同的信號(hào)注入方法進(jìn)行了消融實(shí)驗(yàn)。具體來說,這些實(shí)驗(yàn)包括:(a)僅將低頻面部信息和關(guān)鍵點(diǎn)注入噪聲潛在空間,(b)僅將高頻面部信號(hào)注入注意力塊,(c)結(jié)合(a)和(b),(d)基于(c),但低頻面部信息不包含關(guān)鍵點(diǎn),(e - f)基于(c),但高頻信號(hào)注入到注意力塊的輸入或輸出,(g)僅將高頻面部信號(hào)注入注意力塊之前。結(jié)果如下圖7和表3所示。

對(duì)于發(fā)現(xiàn)1,觀察到僅注入高頻信號(hào)(a)會(huì)大大增加訓(xùn)練難度,導(dǎo)致模型由于缺乏低頻信號(hào)注入而無法收斂。此外,加入面部關(guān)鍵點(diǎn)(d)使得模型能夠更多地關(guān)注低頻信息,從而促進(jìn)訓(xùn)練并提高模型性能。

對(duì)于發(fā)現(xiàn)2,當(dāng)僅注入低頻信號(hào)(b)時(shí),模型缺乏高頻信息。這種對(duì)低頻信號(hào)的依賴使得生成的視頻中的面部直接復(fù)制參考圖像,難以通過提示控制面部表情、動(dòng)作和其他特征。此外,將身份信號(hào)注入到注意力塊輸入(f - g)會(huì)打亂 DiT 的頻域分布,導(dǎo)致梯度爆炸。將控制信號(hào)嵌入到注意力塊(c)中,比將其嵌入到輸出(e)中更優(yōu),因?yàn)樽⒁饬K主要處理低頻信息。通過內(nèi)部嵌入高頻信息,注意力塊能夠突出內(nèi)在的面部特征,而將其注入輸出僅僅是特征的拼接,無法引導(dǎo)關(guān)注,降低了 DiT 的建模能力。

此外,對(duì)生成的視頻(僅面部區(qū)域)應(yīng)用了傅里葉變換,以視覺比較不同組件對(duì)面部信息提取的影響。如下圖3所示,傅里葉譜和傅里葉變換的對(duì)數(shù)幅度顯示,注入高頻或低頻信號(hào)確實(shí)增強(qiáng)了生成面部的相應(yīng)頻率信息。此外,低頻信號(hào)通過與面部關(guān)鍵點(diǎn)的匹配可以進(jìn)一步增強(qiáng),而將高頻信號(hào)注入注意力塊具有最高的特征利用率。本文的方法(c)展示了最強(qiáng)的高頻和低頻,進(jìn)一步驗(yàn)證了發(fā)現(xiàn)1和發(fā)現(xiàn)2帶來的效率提升。為了減少開銷,我們對(duì)每個(gè)身份僅選擇了2個(gè)參考圖像進(jìn)行評(píng)估。

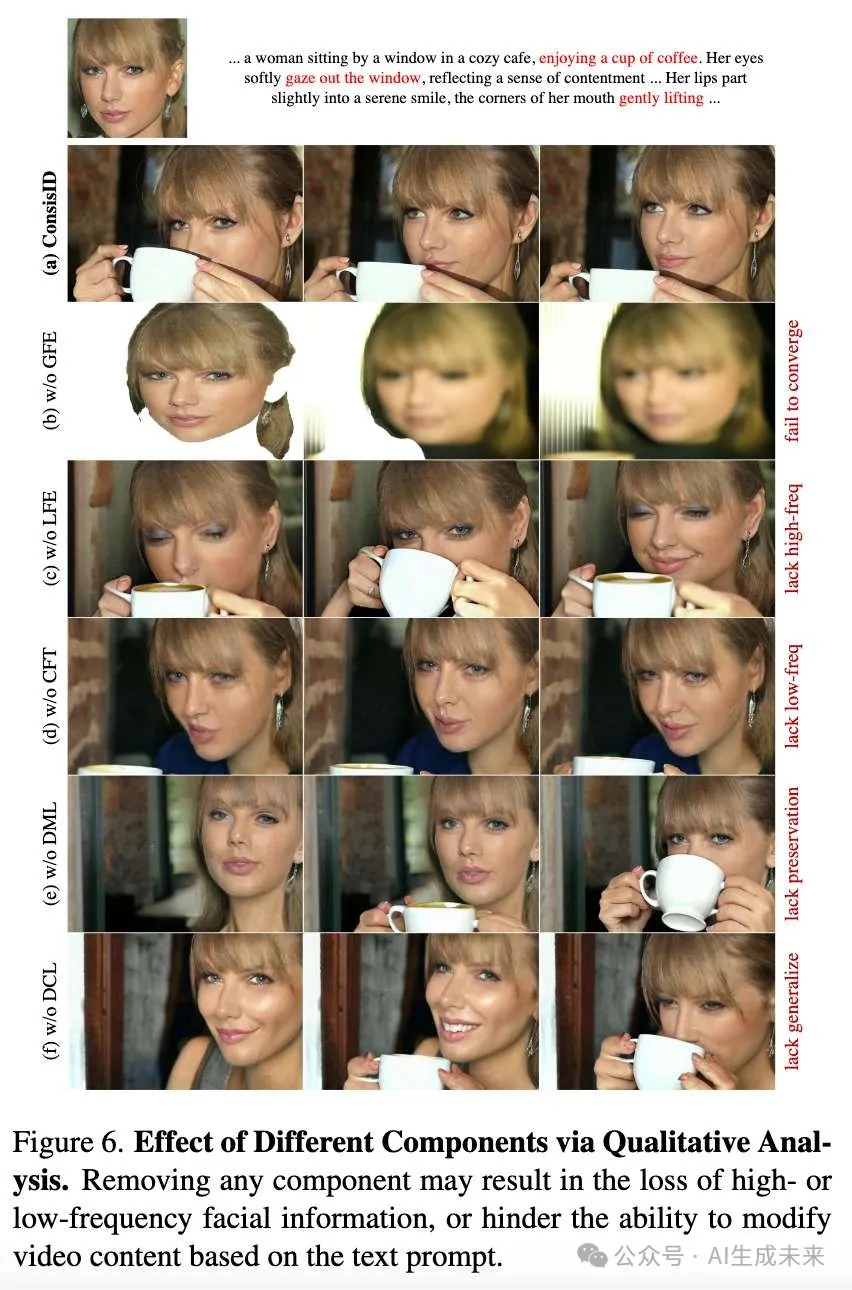

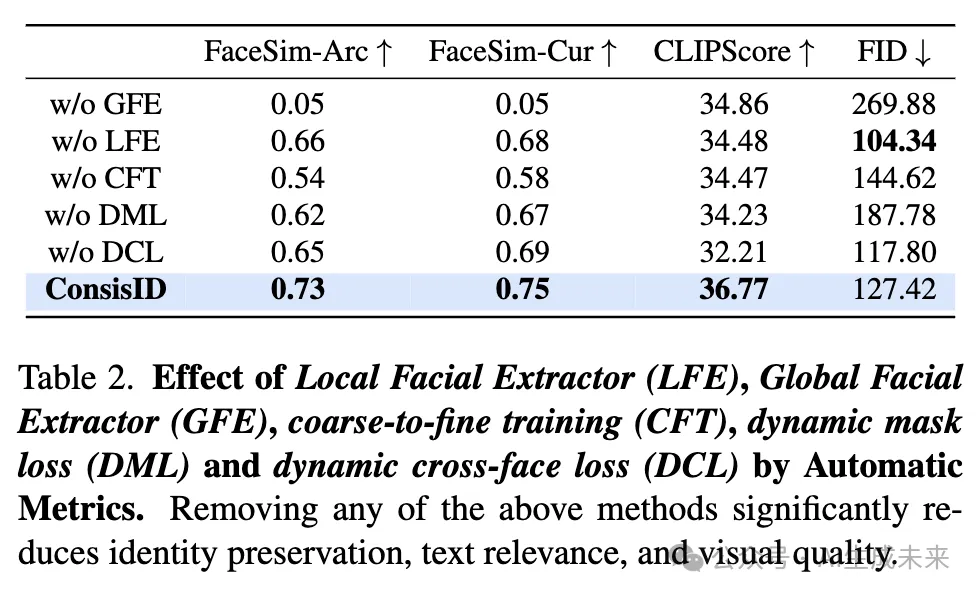

一致性訓(xùn)練策略的消融實(shí)驗(yàn)

為了減少開銷,在以下實(shí)驗(yàn)中為每個(gè)身份僅選擇2個(gè)參考圖像。為了證明所提出的一致性訓(xùn)練策略的好處,對(duì)粗到精訓(xùn)練(CFT)、動(dòng)態(tài)Mask損失(DML)和動(dòng)態(tài)跨臉損失(DCL)進(jìn)行了消融實(shí)驗(yàn),結(jié)果如下圖6和表2所示。去除CFT時(shí),GFE和LFE表現(xiàn)出競(jìng)爭(zhēng)行為,導(dǎo)致模型無法準(zhǔn)確優(yōu)先處理高頻和低頻信息,進(jìn)而使得模型收斂到次優(yōu)點(diǎn)。去除DML使得模型必須同時(shí)關(guān)注前景和背景元素,背景噪聲對(duì)訓(xùn)練產(chǎn)生負(fù)面影響,降低了面部一致性。同樣,去除DCL削弱了模型的泛化能力,降低了面部的忠實(shí)度,特別是對(duì)于訓(xùn)練集之外的人物,影響了生成符合身份保持的視頻效果。

反轉(zhuǎn)步數(shù)量的消融實(shí)驗(yàn)

為了評(píng)估反轉(zhuǎn)步數(shù)量變化對(duì)模型性能的影響,在ConsisID的推理階段進(jìn)行了一項(xiàng)消融研究。鑒于計(jì)算資源的限制,從評(píng)估數(shù)據(jù)集中隨機(jī)選擇了60個(gè)提示。每個(gè)提示與一個(gè)唯一的參考圖像配對(duì),生成60個(gè)視頻用于每種設(shè)置。通過固定的隨機(jī)種子,在t值為25、50、75、100、125、150、175和200的范圍內(nèi)變化反轉(zhuǎn)步驟參數(shù)。結(jié)果如圖8和表4所示。盡管理論預(yù)期表明增加反轉(zhuǎn)步驟數(shù)量會(huì)持續(xù)提升生成質(zhì)量,但我們的研究表明,生成質(zhì)量呈現(xiàn)非線性關(guān)系,質(zhì)量在t = 50時(shí)達(dá)到峰值,之后下降。具體而言,在t = 25時(shí),模型生成的面部輪廓不完整;在t = 75時(shí),模型未能生成上身衣物;超過t = 125時(shí),模型喪失了重要的低頻面部信息,導(dǎo)致面部特征失真;超過t = 150時(shí),視覺清晰度逐漸下降。推測(cè)去噪過程的初期階段主要由低頻信息主導(dǎo),如生成面部輪廓,而后期階段則專注于高頻細(xì)節(jié),如面部?jī)?nèi)在特征。t = 50是平衡這兩個(gè)階段的最佳設(shè)置。

結(jié)論

ConsisID,一個(gè)通過頻率分解保持面部一致性的視頻生成統(tǒng)一框架。它能夠無縫集成到現(xiàn)有的基于DiT的文本到視頻(T2V)模型中,用于生成高質(zhì)量、可編輯、符合身份保持要求的視頻。大量實(shí)驗(yàn)表明,ConsisID超越了當(dāng)前最先進(jìn)的身份保持T2V模型。研究結(jié)果表明,基于頻率感知的DiT控制方案是IPT2V生成的最佳解決方案。

限制與未來工作

現(xiàn)有的度量標(biāo)準(zhǔn)無法準(zhǔn)確衡量不同ID保持模型的能力。盡管ConsisID能夠根據(jù)文本提示生成真實(shí)自然的視頻,但諸如CLIPScore 和FID等度量標(biāo)準(zhǔn)與以前的方法差異不大。一個(gè)可行的方向是尋找一種與人類感知更匹配的度量標(biāo)準(zhǔn)。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來

原文鏈接:??https://mp.weixin.qq.com/s/HAoPAf2t1GHMGPKtJoaZ4Q??