怎么評價一個模型的好壞?大模型應用重要環節之——模型評估 原創

“ 任何產品最真實的評價,就是市場(用戶)反饋”

從根本上來說,設計和訓練一款大模型的目的是用來解決我們生活和工作中的問題,從更加抽象的角度來說是為了提升生產力和生產效率。

因此評價一款大模型的好壞不是看它使用了什么架構,也不是它用了多少訓練數據,而是它實際應用中的表現能力;而這也是大模型從理論或者說實驗推向實際業務場景的必要環節。

因此,怎么評價一款大模型就成了一個問題,而怎么解決這個問題?

大模型的評價體系

其實從實際角度來說,任何評價的標準都沒有直接實際檢驗來的快,來的有效;模型好不好直接拿過來用不就知道了,讓使用者感到好用,那就是好,否則就是不好。

就像當年支付寶剛推出時那樣,馬云親自體驗支付寶的使用,然后自己一眼看不明白不知道怎么用的功能就需要重新設計和優化,不要談什么用了什么設計理念,有什么天才般的構想,好用才是一切。

大模型也是如此,能用并且好用才是大模型追求的標準。

但由于大模型的成本問題,比如需要大量的訓練數據,以及大量的計算資源等;這就導致大模型訓練需要很大的成本,因此為了節約成本就需要有一套大模型性能評價的標準,這樣才能用最小的成本來訓練一個更好用的模型。

那怎么評價一個大模型呢?也就是設計一個大模型評價標準的方法。

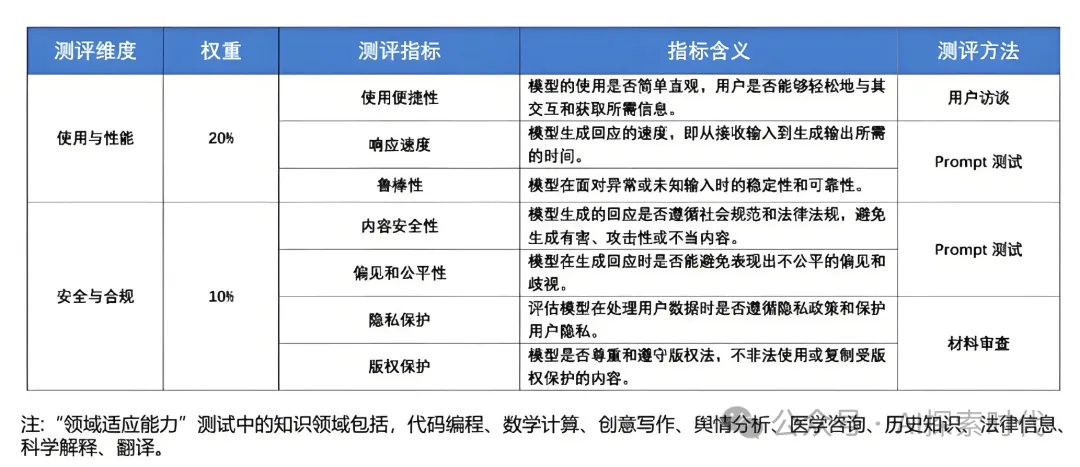

評估一款大模型涉及到多個方面,確保模型在性能,效率,魯棒性和實用性等方面都能滿足要求。下面是一些主要的評估維度和方法:

性能評估

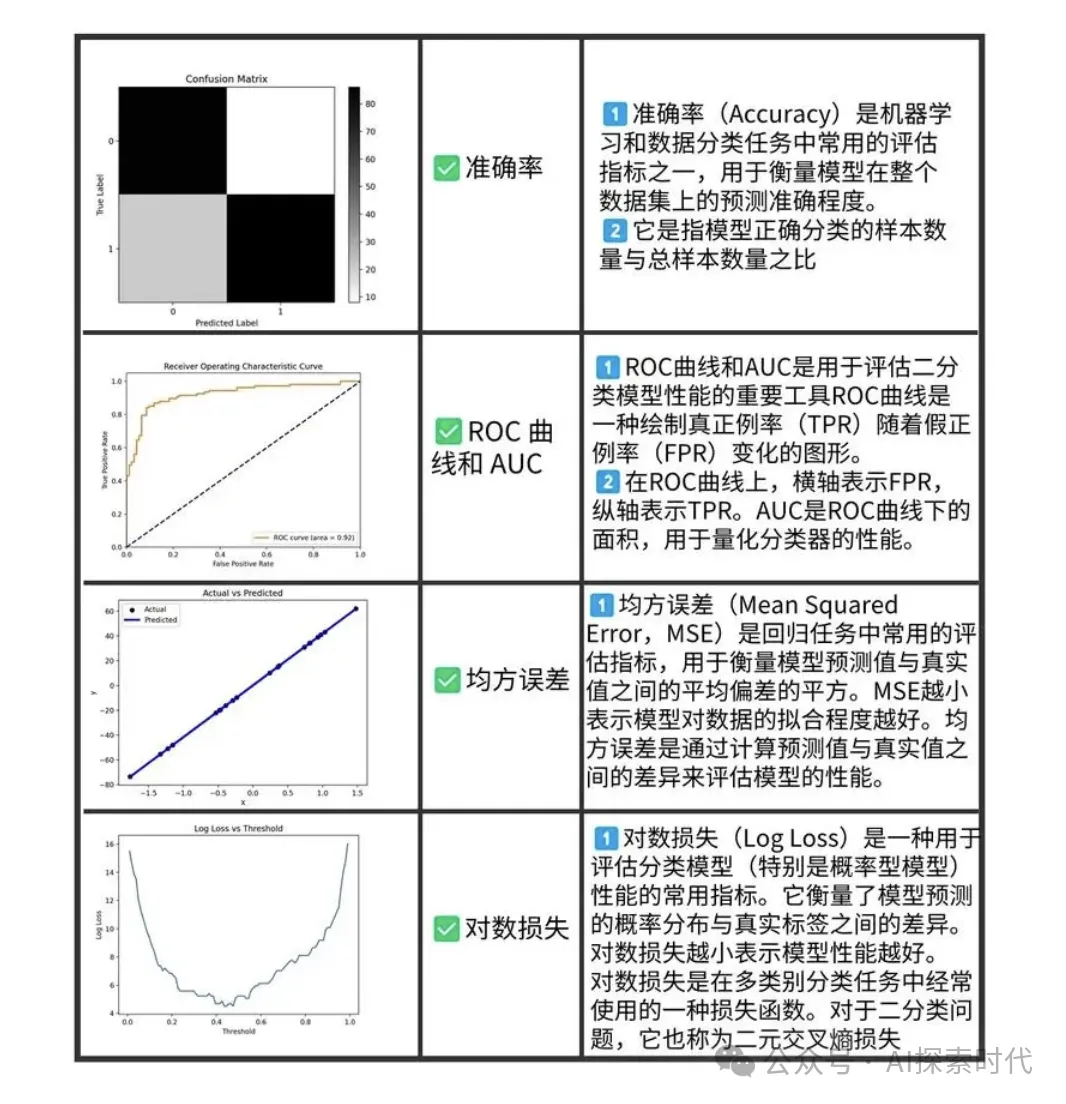

準確性

任務特定指標:根據模型應用的具體任務使用相應的性能指標,如分類準確率,回歸誤差,BLEU分數(用于翻譯),ROUGE分數(用于摘要)

基準測試:使用標準數據集和任務(如GLUE,SQuAD,COCO等)進行評估,比較模型在這些任務上的表現

生成質量

流暢性和連貫性:評估生成文本的語法正確性,語義連貫性。可以使用人工評估或自動化平分工具(如perplexity,BLEU分數)

創造性和多樣性:評估生成文本的多樣性和創造性;可以使用自動化指標(如N-gram多樣性)或人工評估

效率評估

計算效率

推理時間:測量模型在給定輸入上的推理時間,包括處理速度和響應時間

訓練時間:評估模型從初始訓練到收斂所需的時間

內存和計算資源

內存消耗:評估模型在推理和訓練時的內存占用

計算開銷:測量模型的計算復雜度,通常以FLOPs(每秒浮點運算次數)或其它計算資源的消耗來表示

魯棒性和穩定性

抗噪聲能力

處理異常輸入:評估模型在面對輸入噪聲或異常數據時的表現,例如錯誤拼寫,語法錯誤等

一致性

穩定性測試:檢測模型在不同隨機種子,不同輸入順序等條件下的表現是否穩定

通用性和適用性

遷移學習

任務適用性:評估模型在不同但相關任務上的表現,例如預訓練模型在下游任務上的微調效果

泛化能力

跨領域表現:評估模型在不同領域,不同類型的數據上的表現

倫理和公平性

偏見檢測

公平性測試:檢測模型是否對特定群體存在偏見,例如種族,性別,年齡等方面的偏見

倫理考慮

生成內容監控:評估模型生成的內容是否符合倫理標準,避免生成有害或不準確的信息

用戶體驗

實用性

用戶反饋:收集用戶對模型輸出的反饋,評估模型的實用性和滿意度

易用性

界面和集成:評估模型的API或用戶界面的易用性,是否方便集成到現有系統中

可解釋性

透明度

解釋能力:評估模型的可解釋性和透明度,即能否理解模型的決策過程或輸出的原因

可視化

結果可視化:使用可視化工具展示模型的內部機制或預測結果,幫助理解和分析模型的行為

安全性

防御能力

攻擊測試:評估模型在面對對抗性攻擊(如對抗樣本)時的防御能力

數據隱私

隱私保護:確保模型在處理用戶數據時遵循數據隱私和安全標準

總結

評估大模型的過程包括多個維度,涉及性能、效率、魯棒性、通用性、倫理、公平性、用戶體驗、可解釋性和安全性。每個維度都需要通過特定的方法和指標進行評估,以確保模型在實際應用中的有效性和可靠性。通過綜合考慮這些評估因素,可以全面了解模型的優缺點,并為進一步優化和應用提供指導。

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/0ojExjjSBLhj-iNGBZFkpg??