專用于理解游戲場景的開源大模型-VideoGameBunny

大模型在游戲開發領域扮演了重要角色,從AI機器人生成到場景搭建覆蓋各個領域。但在游戲場景理解、圖像識別、內容描述方面很差。

為了解決這些難題,加拿大阿爾伯塔的研究人員專門開源了一款針對游戲領域的大模型VideoGameBunny(以下簡稱“VGB”)。

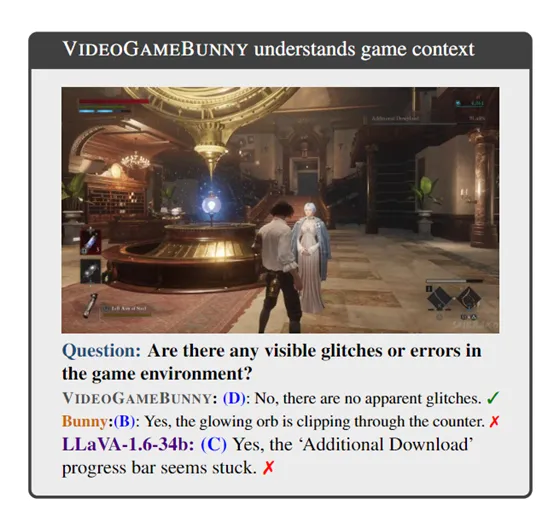

VGB可以作為視覺AI助理,能夠理解游戲環境并提供實時反饋。例如,在探索型的3A游戲中,可以幫助玩家識別關鍵物品或進行問答,幫助玩家能夠更快地掌握游戲技巧,從而增強游戲的互動性和沉浸感。

VGB也可以通過分析大量的游戲圖像數據,夠檢測到圖形渲染的錯誤、物理引擎的不一致性等,幫助開發人員快速識別和修復游戲中的bug和異常。

開源地址:https://huggingface.co/VideoGameBunny/VideoGameBunny-V1/tree/main

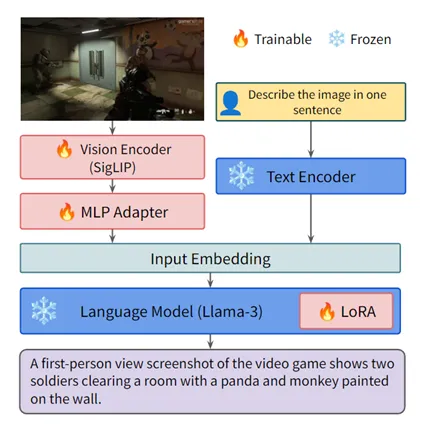

VGB是基于Bunny模型(高性能低消耗版本)基礎之上開發而成,這個模型的設計方法類似于LLaVA,采用多層感知器網絡作為投影層,將來自強預訓練視覺模型的視覺嵌入轉化為圖像標記,供語言模型處理,可有效利用了預訓練的視覺和語言模型使它們能夠高效地協同處理數據。

Bunny模型支持最高1152×1152像素的圖像分辨率,這在處理視頻游戲圖像時非常重要,因為游戲畫面通常包含從UI圖標到大型物體等不同尺寸的視覺元素。多尺度特征的提取有助于模型捕捉這些元素,從而提高對游戲內容的理解能力。

為了使VGB能夠更好地理解和處理游戲的視覺內容,研究人員使用了Meta開源的LLama-3-8B作為語言模型,并結合了SigLIP視覺編碼器以及S2包裝器。這種多尺度特征提取方法能夠捕捉游戲中不同尺度的視覺元素,從微小的用戶界面圖標到大型游戲對象,從而為模型提供了豐富的上下文信息。

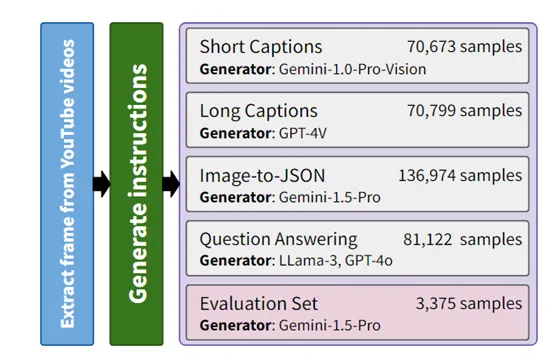

此外,為了生成和游戲圖像相匹配的指令數據,研究人員使用了多種先進的模型,包括Gemini-1.0-Pro-Vision、GPT-4V、GPT-4o等,以生成不同類型的指令。這些指令包括簡短的標題、詳細的標題、圖像到JSON的描述以及基于圖像的問答等,可以幫助模型更好地理解和響應玩家的查詢和命令。

在模型訓練方面,VGB使用了比較流行的LoRA參數高效微調方法,允許模型在保持預訓練權重的同時,對特定任務進行微調,從而在不顯著增加計算成本的情況下提高模型的性能。此外,研究團隊還使用了PEFT庫來指導模型的訓練過程,進一步提升了訓練的高效性和穩定性。

訓練數據方面,研究人員收集了來自413款不同游戲的超過185,000多張圖像以及將近39萬個圖像-指令對,涵蓋了圖像說明、問答對以及136,974張圖像的JSON表示。

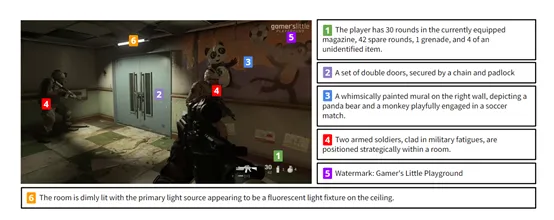

JSON格式的數據包含了16個元素,能夠捕捉圖像的多層次細節信息,包括整體概述、具體的人物描述、天氣信息、用戶界面和玩家庫存的摘要、場景中的物體、照明和環境效果等。

為了創建圖像到JSON的數據集,研究團隊使用Gemini-1.5-Pro結合特定的指示,將給定的圖像轉換成一個具有層次結構細節和信息的JSON文件。

研究人員認為,全球游戲市場總額超過3000億美元,在游戲開發、性能測試、提升游戲體驗等方面對大模型有著巨大需求,VGB是可以輔助開發人員以及玩家達到這些目的。

本文轉自 AIGC開放社區,作者:AIGC開放社區