專用于法律的兩個開源大模型,最高1410億參數(shù)

法國國家高等教育計算中心、巴黎薩克雷大學(xué)的研究人員聯(lián)合開源了專用于法律領(lǐng)域的大模型——SaulLM。

SaulLM一共有540億、1410億兩種參數(shù),以及基礎(chǔ)模型和指令微調(diào)兩種版本。SaulLM的最大特色是使用了5400億token的專業(yè)法律數(shù)據(jù)進行了預(yù)訓(xùn)練,包括美國、歐洲、澳大利亞等地的法律文本,輸出內(nèi)容的準確率高于很多同類模型。

開源地址:https://huggingface.co/Equall/SaulLM-54-Base

指令微調(diào):https://huggingface.co/Equall/SaulLM-141B-Instruct

SaulLM-54B和SaulLM-141B是基于Mixtral系列模型開發(fā)而成,通過引入專家混合(MoE)機制,顯著提升了模型處理大量數(shù)據(jù)的能力。

MoE架構(gòu)的核心思想是將大型模型分解為多個小型專家網(wǎng)絡(luò),這些專家可以根據(jù)輸入數(shù)據(jù)的不同特點被動態(tài)地激活。這種方法不僅提高了模型的計算效率,還增強了模型處理復(fù)雜法律文本的能力。

SaulLM-54B由32層組成,模型維度為4096,隱藏維度為14336;而SaulLM-141B則由56層構(gòu)成,模型維度增至6144,隱藏維度達到16384。使得兩個模型最多能支持長達32768和65536個token的上下文長度。

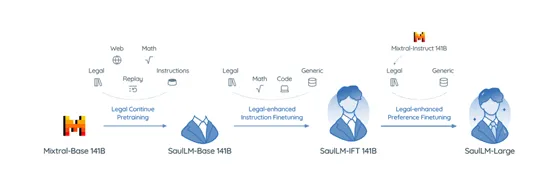

研究人員使用了分段策略來訓(xùn)練SaulLM模型,包括持續(xù)預(yù)訓(xùn)練、專業(yè)法律指令遵循協(xié)議的實施,以及模型輸出與人類偏好的對齊。

第一步使用了超過5400億token的專業(yè)法律語料庫對模型進行預(yù)訓(xùn)練,蓋了來自不同法律體系的廣泛文本,包括美國、歐洲、澳大利亞等地的法律文獻。

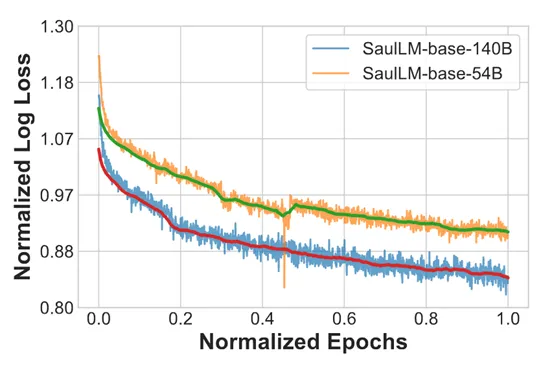

在預(yù)訓(xùn)練過程中,研究人員采用了AdamW優(yōu)化器,并設(shè)置了特定的學(xué)習(xí)速率和梯度累積策略,以優(yōu)化模型的學(xué)習(xí)效率和穩(wěn)定性。此外,為了應(yīng)對模型在訓(xùn)練過程中可能出現(xiàn)的災(zāi)難性遺忘等問題,研究團隊還引入了重放策略,重新引入早期訓(xùn)練分布中的數(shù)據(jù),以增強模型的記憶能力。

法律領(lǐng)域?qū)Υ竽P洼敵鰞?nèi)容的準確性和專業(yè)性要求極高。為了提升模型在法律任務(wù)上的表現(xiàn),研究人員使用了專業(yè)法律指令遵循協(xié)議,訓(xùn)練模型理解和執(zhí)行法律場景中的指令。

在這一階段,模型接受了包括法律分析、案件總結(jié)、法規(guī)解讀等多種法律相關(guān)任務(wù)的訓(xùn)練。通過這種方式,模型學(xué)會了如何根據(jù)法律專家的需求,提供準確和相關(guān)的信息。

為了使模型的輸出更加符合法律專業(yè)人士的期望和偏好,使用了模型輸出與人類偏好的對齊方法。主要使用了合成數(shù)據(jù)和人類反饋來調(diào)整模型的輸出。合成數(shù)據(jù)的生成是基于模型的自我對話,模擬法律專家在分析案件時可能提出的問題和答案。通過這種方式,模型能夠?qū)W習(xí)到法律推理的深層邏輯和結(jié)構(gòu)。

同時,研究人員還引入了人類反饋機制,通過評估模型輸出的準確性、相關(guān)性和邏輯一致性,進一步優(yōu)化模型的性能。

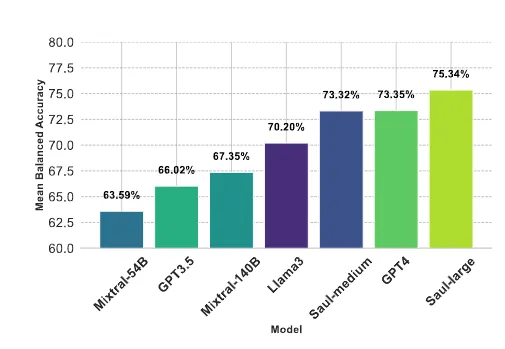

研究人員在專業(yè)法律基準測試平臺LegalBench - Instruct 和多基準平臺MMLU上對模型進行了綜合評估。

實驗結(jié)果顯示, SaulLM – 54B優(yōu)于 Mixtral - 54B,SaulLM -141B也優(yōu)于Mixtral - 141B,比GPT-4、Llama-3也更加出色。此外,繼續(xù)預(yù)訓(xùn)練顯著增強了模型在法律領(lǐng)域的性能,在 IFT和 DPO階段都有大約 7% 的顯著提升。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)