即插即用 | 時間編碼+LSTM+全局注意力

1 模型創新點介紹

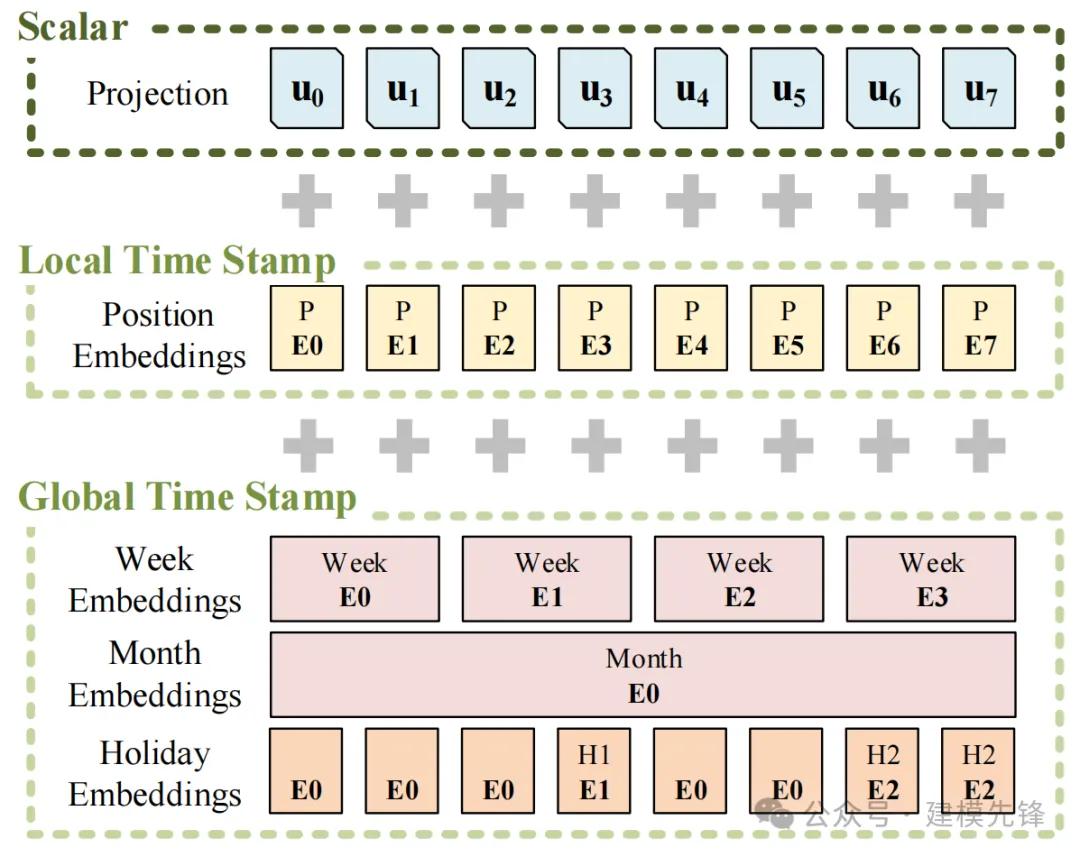

1.1 時間編碼

輸入信息編碼參考 Informer 論文,我們把源碼和數據集制作進行了優化,方便任何帶有時間特征列的數據集進行輸入信息的編碼。

Informer在原始向量上不止增加了Transformer架構必備的PositionEmbedding(位置編碼)還增加了與時間相關的各種編碼:

- 日周期編碼:表示一天中的時間點。

- 周周期編碼:表示一周中的時間點。

- 月周期編碼:表示一個月中的時間點。

在時間序列預測任務中,不同時間節點可能蘊藏著重要信息,例如分層時間戳(周、月和年)和不可知時間戳(假期、事件)。

具體在這里增加什么樣的GlobalTimeStamp還需要根據實際問題來確認,如果計算高鐵動車車站的人流量,顯然“假期”的時間差就是十分重要的。如果計算公交地鐵等通勤交通工具的人流量,顯然“星期”可以更多的揭示是否為工作日。

大家根據自己數據集的時間分辨率可靈活調整!

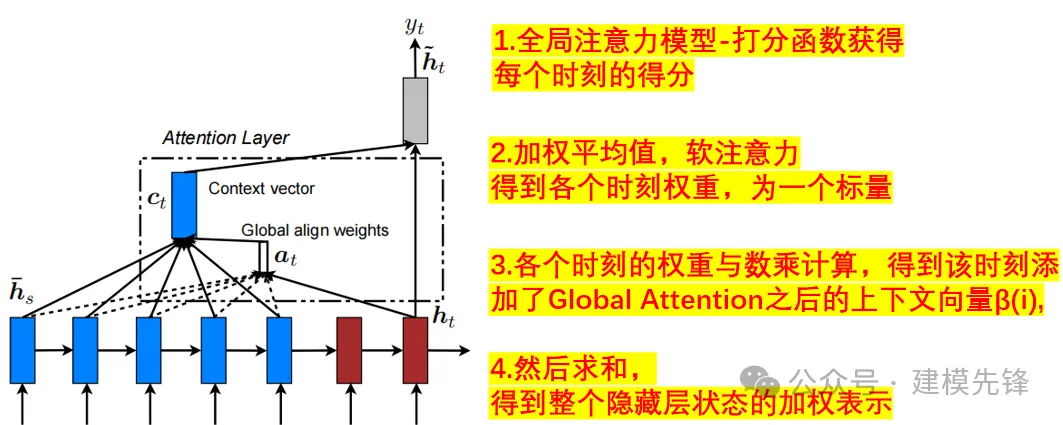

1.2 基于GlobalAttention優化的LSTM網絡

把基于注意力機制的循環網絡改進優化為基于全局注意力機制LSTM神經網絡:

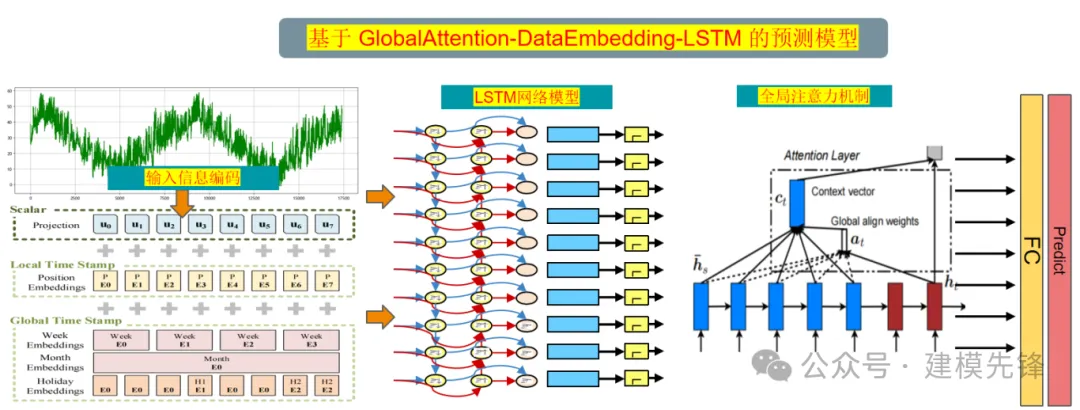

2 模型整體結構

模型整體結構如下所示,多特征變量時間序列數據先經過輸入信息編碼:

TokenEmbedding -時序數據編碼

PositionalEmbedding-位置編碼

TemporalEmbedding-時間編碼通過這三種數據編碼方式的結合使用,可以更好地捕獲輸入數據的語義、位置和時間特征,增強模型對時間序列數據的理解和預測能力。

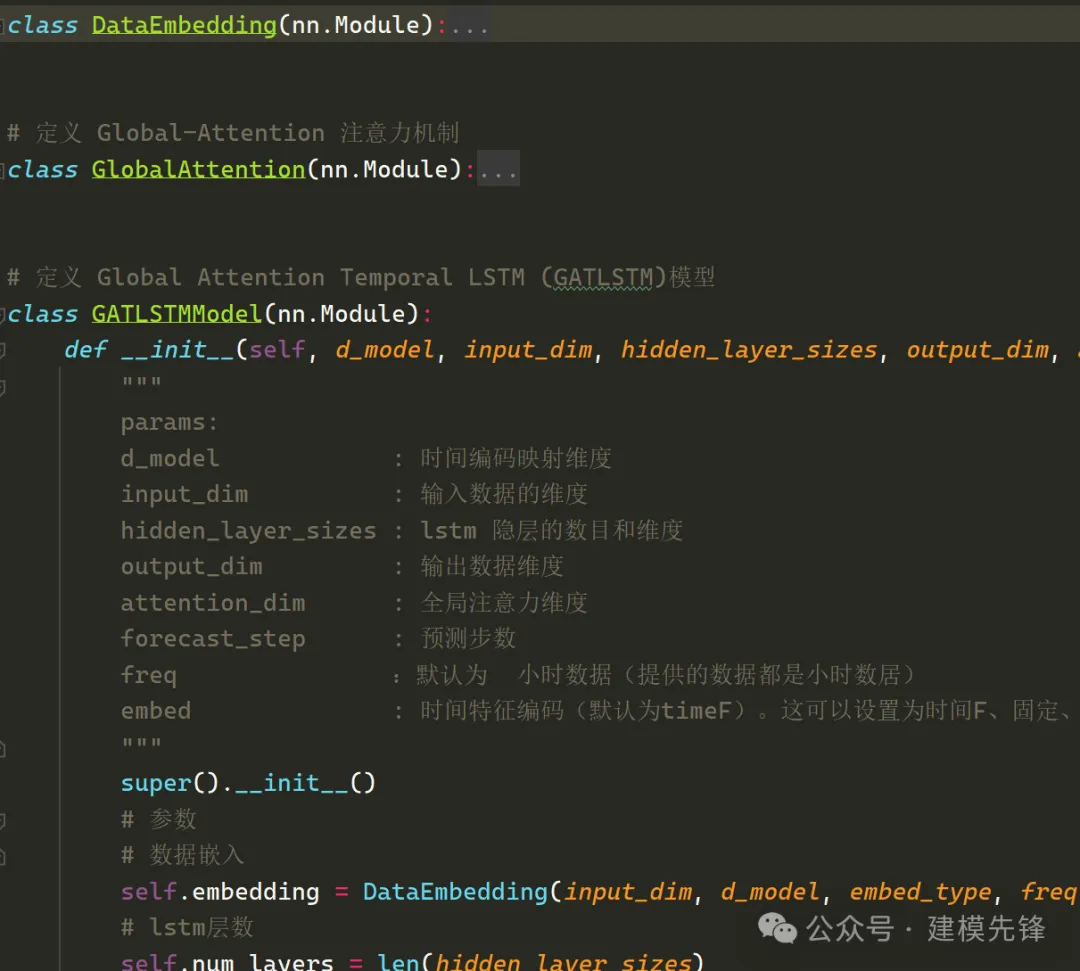

編碼后的數據通過基于GlobalAttention優化的LSTM網絡提取全局時序特征,GlobalAttention是一種用于加強模型對輸入序列不同部分的關注程度的機制。在 LSTM 模型中,全局注意力機制可以幫助模型更好地聚焦于輸入序列中最相關的部分,從而提高模型的性能和泛化能力。在每個時間步,全局注意力機制計算一個權重向量,表示模型對輸入序列各個部分的關注程度,然后將這些權重應用于 LSTM 輸出的特征表示,通過對所有位置的特征進行加權,使模型能夠更有針對性地關注重要的時域特征, 提高了模型對多特征序列時域特征的感知能力。

我們對模型起名為:

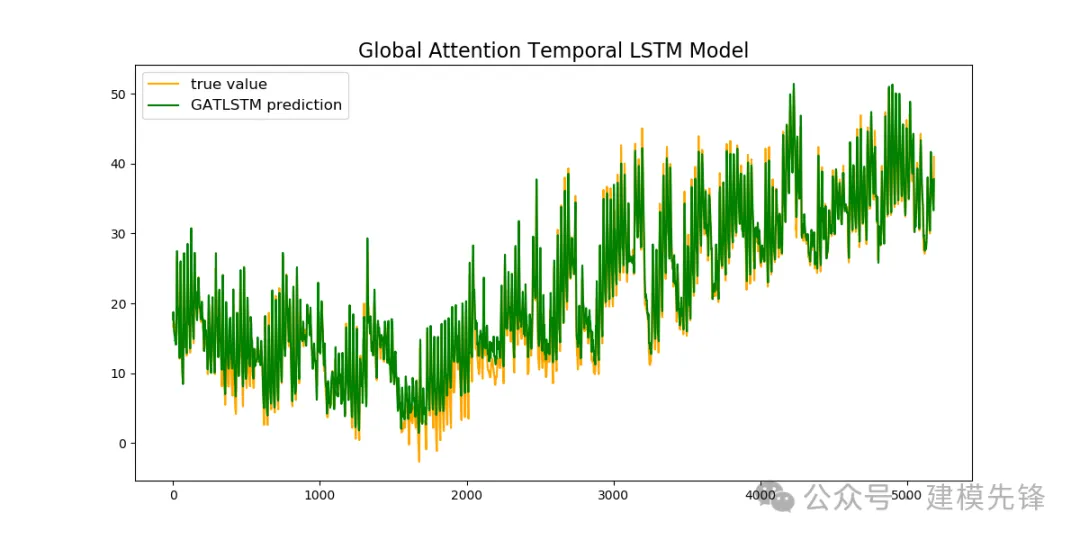

Global Attention Temporal LSTM -(GATLSTM)

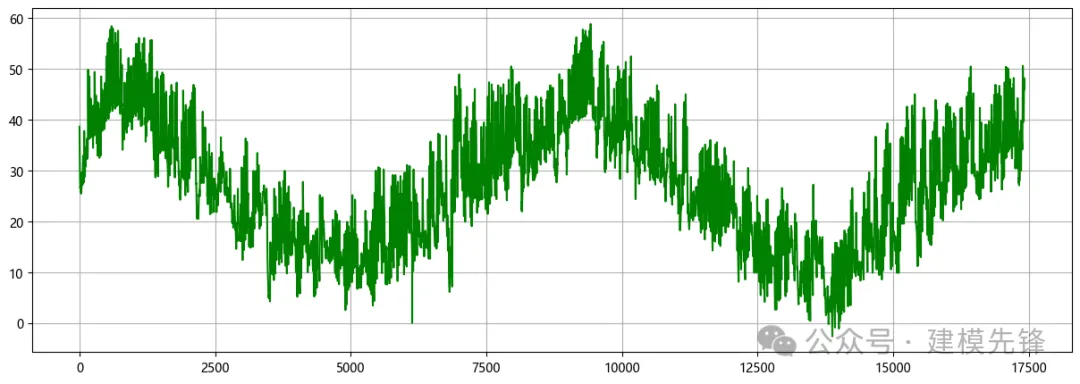

3 電力變壓器數據集預處理

電力變壓器數據集的詳細介紹可以參考下文:

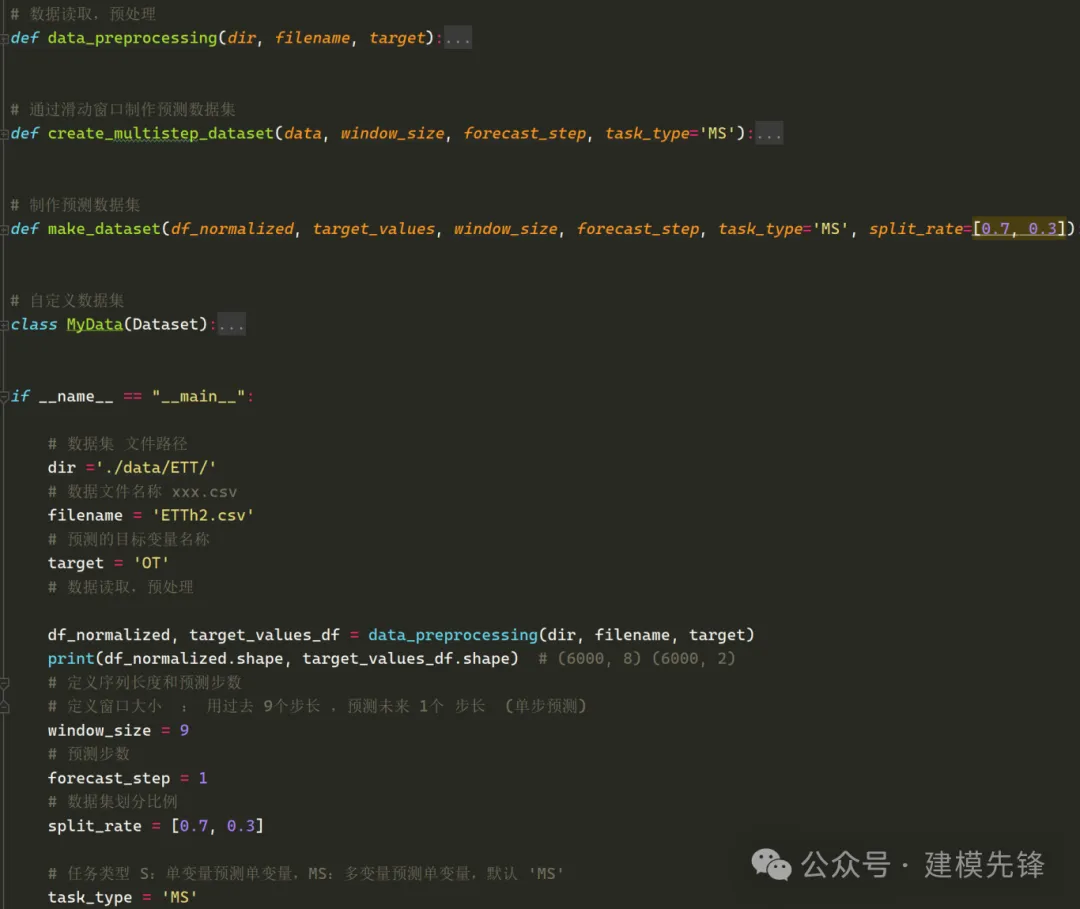

3.1 導入數據

3.2 數據集制作與預處理

詳細介紹見提供的文檔!

4 基于 GATLSTM 的預測模型

4.1 定義 GATLSTM 預測網絡模型

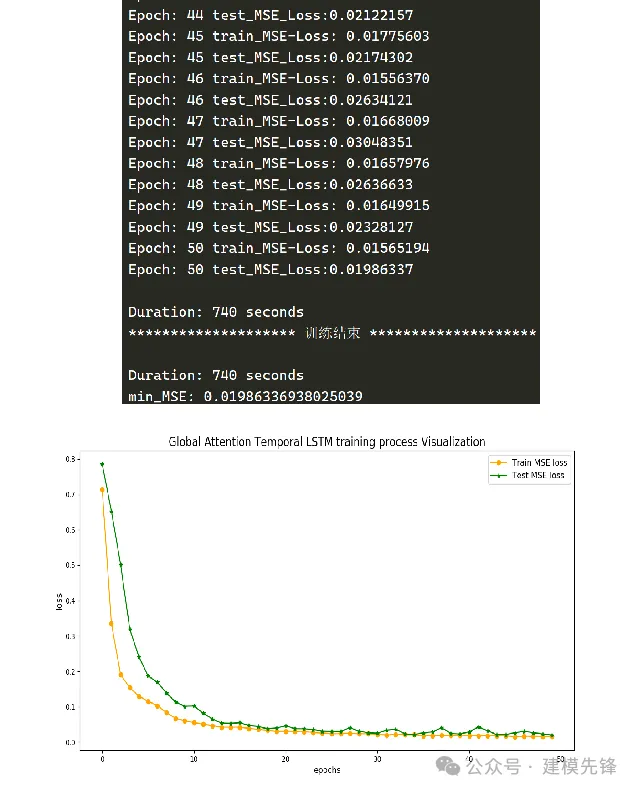

4.2 設置參數,訓練模型

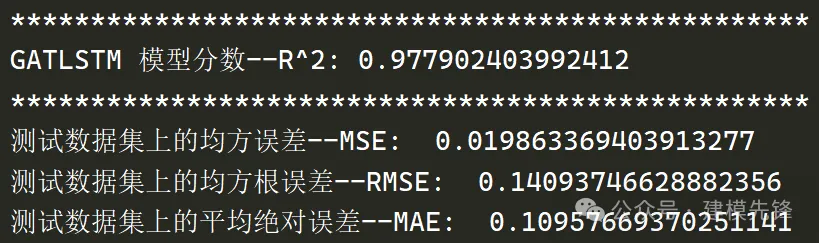

50個epoch,MSE 為0.0198,GATLSTM預測效果顯著,模型能夠充分提取時間序列的全局上下文信息,收斂速度快,性能優越,預測精度高,適當調整模型參數,還可以進一步提高模型預測表現。

5 結果可視化和模型評估

5.1 預測結果可視化

5.2 模型評估