剖析Transformer模型時間復雜度:從矩陣乘法到自注意力機制和前饋神經網絡的全解析

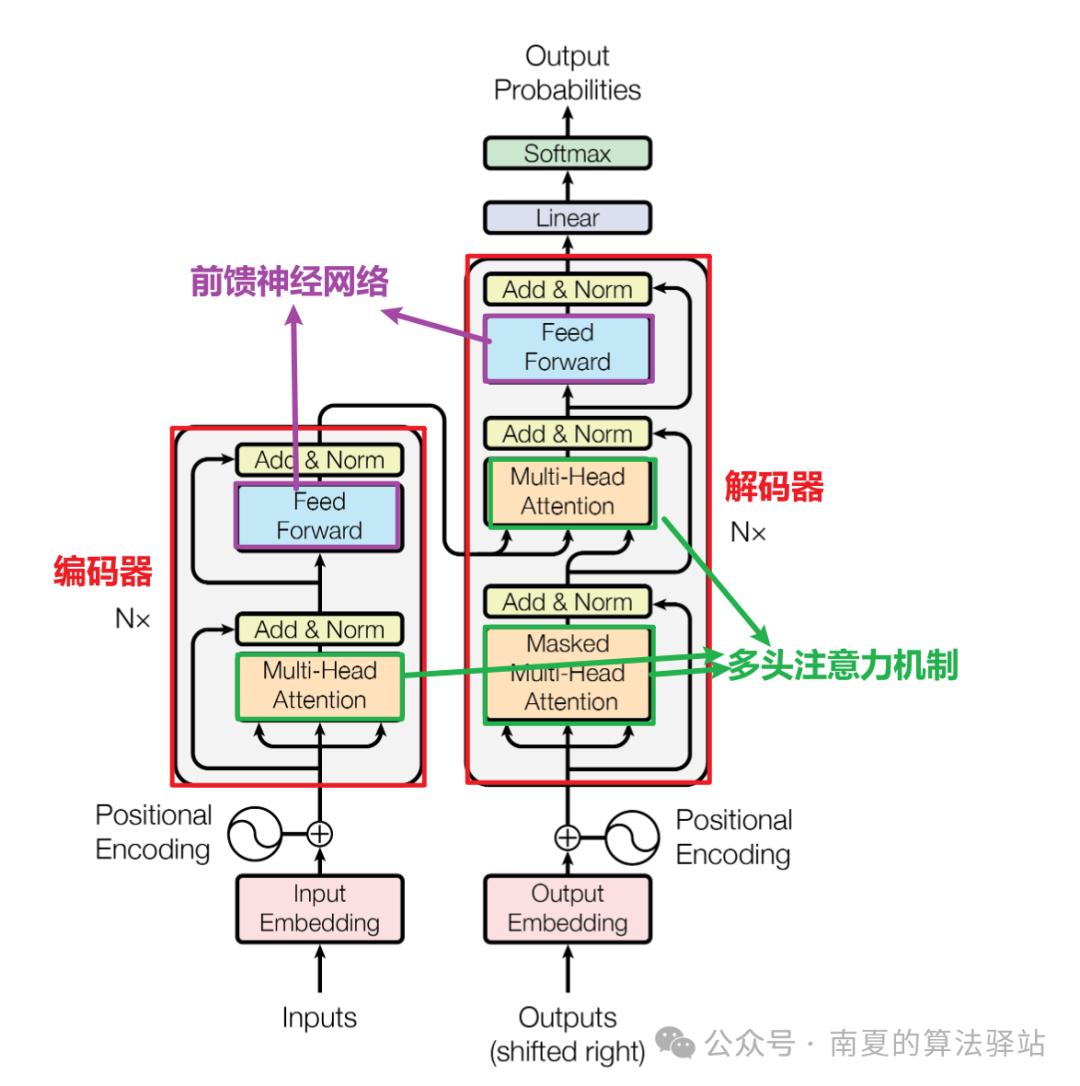

Transformer模型的時間復雜度主要由其核心模塊自注意力機制和前饋神經網絡決定,其中自注意力機制的計算復雜度占主導地位。

本文將從單個矩陣乘法的時間復雜度計算出發,分析自注意力機制、多頭注意力機制、前饋神經網絡的時間復雜度,從而得到整個Transformer模型的時間復雜度,并說明優化方法。

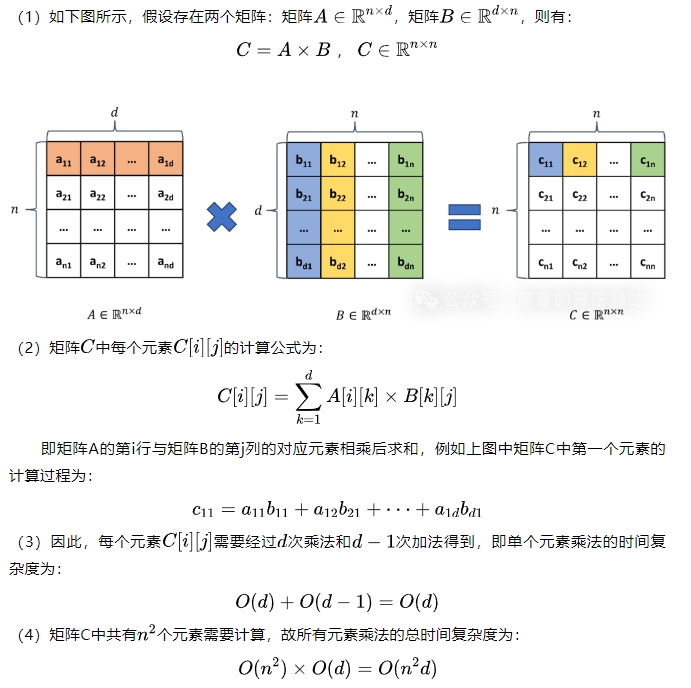

1.單個矩陣乘法的時間復雜度

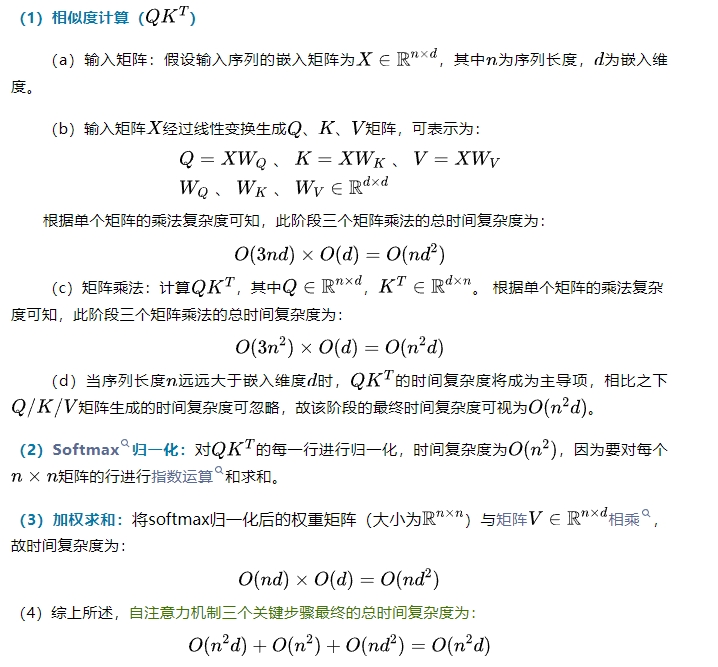

2.自注意力機制的時間復雜度

3.多頭自注意力機制的時間復雜度

4.前饋神經網絡的時間復雜度

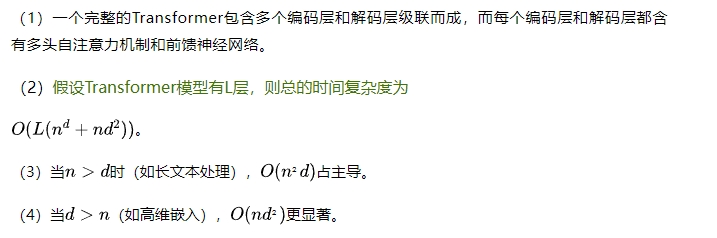

5.Transformer模型的時間復雜度

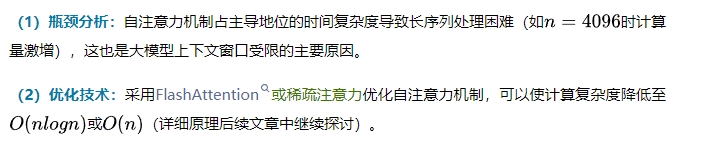

6.時間復雜度優化

本文轉載自??南夏的算法驛站??,作者:趙南夏

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦