麻省理工創(chuàng)新模型:用2D視頻擴(kuò)散,生成 3D 視頻 精華

傳統(tǒng)的3D 視頻生成主要有兩種方法,一種是通過2D 視頻模型和靜態(tài) 3D 場景模型的分類器指導(dǎo)來優(yōu)化動態(tài)3D 視頻場景表示,不過這種對算力的需求極大,生成一個 3D 視頻需要數(shù)小時;

另一種是通過變形初始 3D 場景表示來實現(xiàn),但需要嚴(yán)格的時間結(jié)構(gòu)并且需調(diào)整復(fù)雜的參數(shù)。

為了解決這些難題,麻省理工、Databricks 馬賽克科研所和康奈爾大學(xué)聯(lián)合推出了創(chuàng)新模型Vid3D。該模型假設(shè)無需明確建模 3D 時間動態(tài),通過生成2D視頻的時序動態(tài)輪廓,然后獨立地為視頻中的每一幀生成3D表示,而無需考慮前后幀之間的時間連貫性。

論文地址:https://arxiv.org/abs/2406.11196

簡單來說,就像在制作動畫電影時,先繪制故事板,然后每個關(guān)鍵幀單獨創(chuàng)建3D模型,而不是試圖在三維空間中模擬整個場景的連續(xù)變化,這不僅節(jié)省算力復(fù)雜度也大幅度降低。

例如,我們想要生成一個貓在花園里玩耍的動態(tài)3D場景,Vid3D通過將生成任務(wù)分解為生成場景的2D時間動態(tài)和為每個時間步生成3D表示兩個部分,極大降低了生成時間并簡化了生成流程。

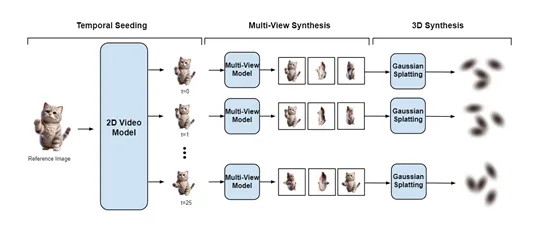

Vid3D先從一張參考圖像開始,生成該場景的2D視頻種子,也稱為“時序播種”,旨在捕捉場景隨時間變化的動態(tài)特征。再通過查詢一個2D視頻模型并輸入?yún)⒖紙D像,Vid3D能夠獲得動態(tài)渲染的對象,盡管此時只限于單一視角。這一步類似于在制作動畫前先繪制出關(guān)鍵幀的故事板,為后續(xù)步驟提供了動態(tài)變化的基礎(chǔ)框架。

在多視圖合成階段,Vid3D針對種子視頻中的每個時間步,獨立生成多個視圖來豐富場景的細(xì)節(jié),并增強3D表示的準(zhǔn)確性。

Vid3D使用了高斯濺射方法來生成3D場景的連續(xù)表示。高斯濺射是一種基于點云的方法,它通過在3D空間中散布大量的點,并為每個點分配一個高斯權(quán)重來表示場景的表面。這些點的集合,以及它們的高斯權(quán)重,共同定義了場景的3D形狀和外觀。

在Vid3D中,每個時間步的多視角視圖被用來訓(xùn)練一個高斯濺射模型,該過程涉及到優(yōu)化每個點的位置和權(quán)重,以便它們能夠最好地表示從不同視角觀察到的場景。這些訓(xùn)練好的高斯濺射模型序列定義了一個動態(tài)的3D視頻,其中每個模型對應(yīng)視頻中的一個時間步。

最后在3D視頻合成階段,Vid3D將每個時間步的多視圖集合轉(zhuǎn)化為3D表示。這里使用的是Gaussian Splatting技術(shù),這是一種能夠?qū)?D圖像轉(zhuǎn)換為3D幾何結(jié)構(gòu)的有效手段。通過訓(xùn)練一個Gaussian Splatting模型,Vid3D能夠基于先前生成的多視圖集合,構(gòu)建出每個時間步的3D場景。

同時在種子視頻的每一個時間步重復(fù)進(jìn)行,最終形成了一個由一系列獨立3D表示組成的動態(tài)3D視頻。

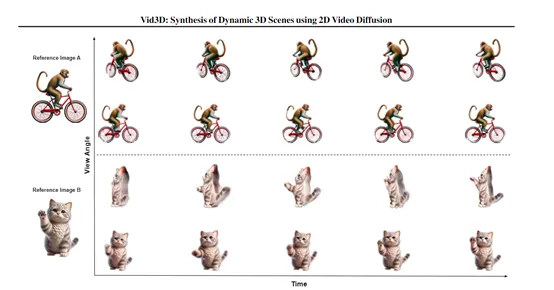

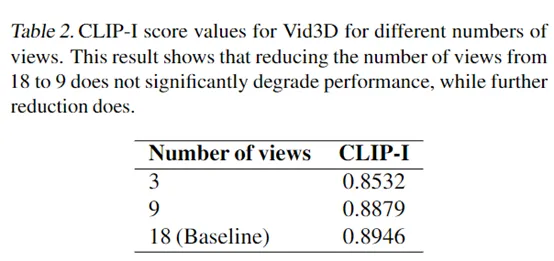

為了評估Vid3D的性能,研究人員使用了最新評估基準(zhǔn)。在評估過程中,為了測試每個 3D 視頻的質(zhì)量,從十個不同的均勻采樣相機角度渲染 10 個 2D 視頻,并使用 CLIP - I 分?jǐn)?shù)作為定量評估指標(biāo)。

結(jié)果顯示,Vid3D在生成動態(tài) 3D 視頻場景方面非常出色,例如,Vid3D 的 CLIP - I 分?jǐn)?shù)為0.8946高于Animate124 的 0.8544。此外,研究人員還對Vid3D中每個時間步生成的視圖數(shù)量進(jìn)行了消融實驗。隨著視圖數(shù)量的減少,CLIP - I分?jǐn)?shù)也開始降低,從18幀減少到9幀時,分?jǐn)?shù)僅下降了0.0067,性能幾乎沒有變化。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)