LeCun轉發!已開源!大連理工盧湖川、賈旭團隊提出可插入圖像/視頻/3D生成的StableIdentity

Github:https://github.com/qinghew/StableIdentity(代碼已全部開源)

Project Page:https://qinghew.github.io/StableIdentity/

Paper:???https://arxiv.org/abs/2401.15975??

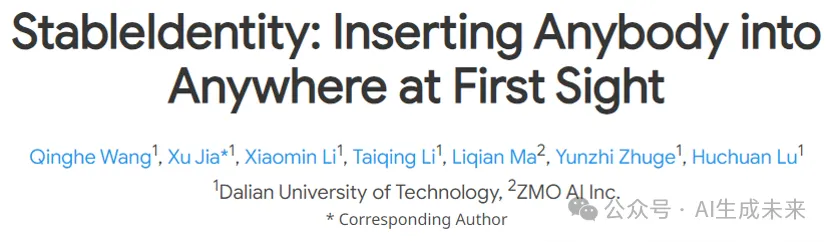

最近,來自大連理工大學的IIAU團隊提出StableIdentity,允許用戶只需上傳一張圖片,通過優化學習身份,即可結合包含動作、背景、風格的文本提示實現圖像定制生成,并且無需微調即可插入視頻/3D生成。

Yann LeCun此前也點贊轉發,調侃自己從沒戴過這樣的帽子。

一、引言:

隨著擴散模型的發展,定制化生成任務受到廣泛關注。這項任務旨在為文本到圖像模型注入新的主題(如身份),并在對齊輸入文本提示的同時,生成在不同語境下主題一致的圖像。例如,用戶可以上傳自己的照片以獲得有趣的圖片,如 "穿著超人服裝"。定制生成的成功可以促進許多應用,如個性化肖像照片虛擬試穿和藝術設計。然而,現有的定制方法是通過微調模型的部分/全部參數或學習通用編碼器來解決這一問題的。參數微調方法需要花費很長時間來搜索最佳參數,但往往會返回一個不準確的平凡解來表示身份。尤其是在只有單張圖像的情況下,這些方法往往會過擬合輸入圖像,導致可編輯性下降。另外,基于編碼器的方法需要大規模的數據集進行訓練,很難捕捉到獨特的身份和細節。此外,目前的方法所學習到的身份在不同的語境下容易與目標身份不一致。因此,迫切需要提出一種新的框架來解決這一任務所面臨的巨大挑戰(如身份保持不穩定、可編輯性差等)。

二、方法

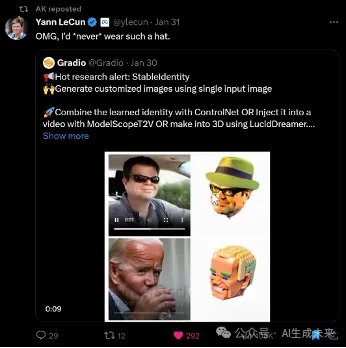

在這項工作中,研究者們提出了 StableIdentity,如圖所示,給定一張輸入人臉圖像,它將身份先驗和可編輯先驗集成到了人的定制生成中,旨在通過優化學習可以表示目標身份的詞向量。

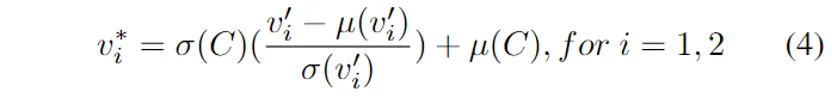

具體來說,本文首先引入了一個經過人臉識別任務預訓練的編碼器來精確地捕捉身份表示。此外,研究者們收集了在Stable Diffusion中可以在不同上下文中生成一致身份的名人姓名,構建了統一維度的嵌入空間,以作為定制生成的先驗身份分布。為了激勵目標身份在預訓練擴散模型中表現得像名人姓名一樣,本文進一步將身份表示通過AdaIN落入到這一先驗空間。

此外,為了學習更穩定的身份和細粒度重建,本文設計了一種two phase擴散損失,分別在降噪訓練的前期和后期階段分配專門的目標函數。其中降噪前期已被證明決定了生成圖像的布局,因此前期使用原始的降噪損失以保證學到的身份可以適應多樣的布局。降噪后期使用對預測的的重建損失,以提升對輸入圖像的像素級感知,從而學習更穩定的身份。

三、實驗結果

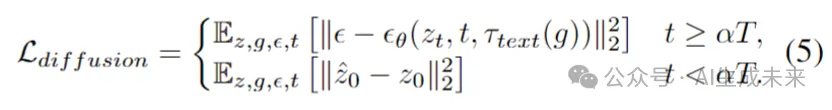

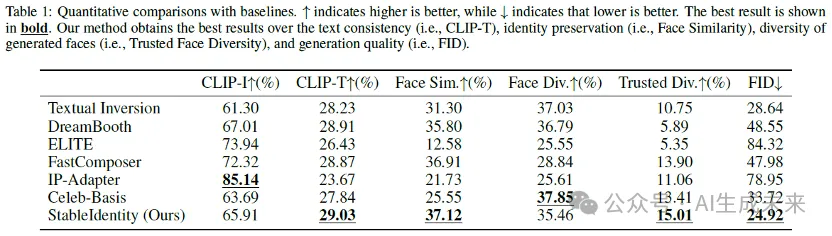

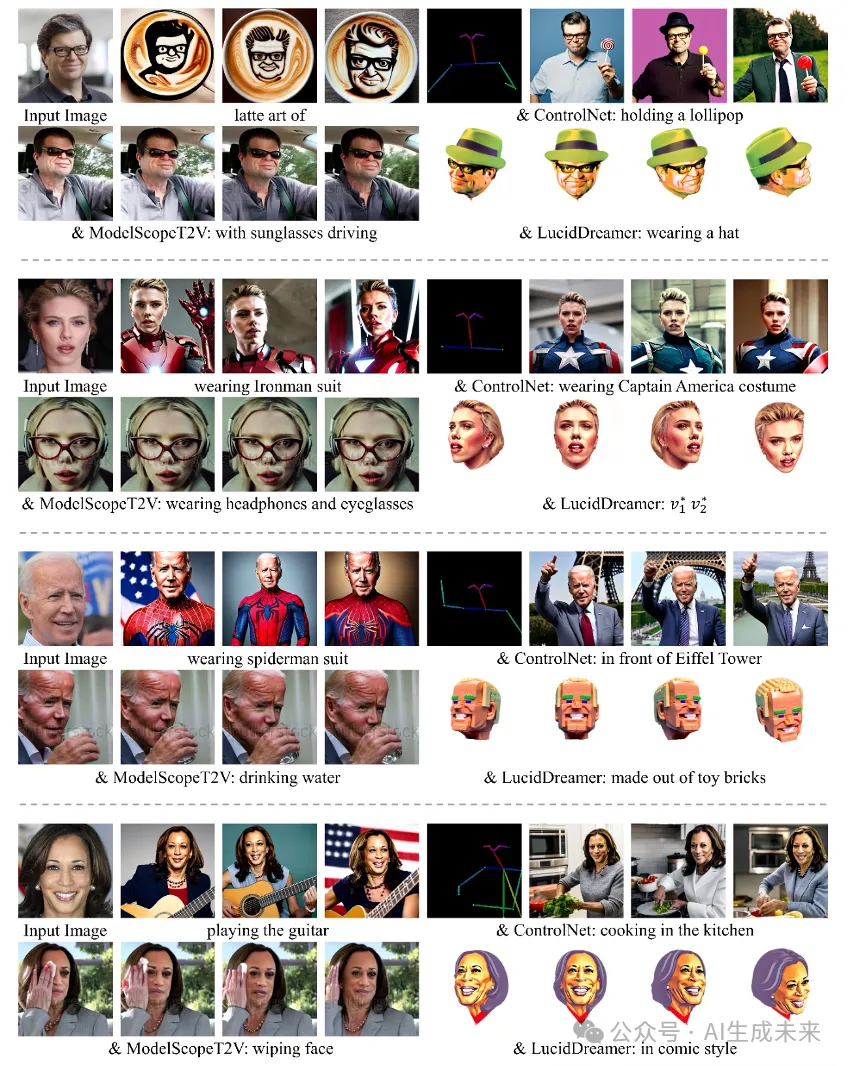

- 在實驗環節,本文在多個指標上與6個baselines進行了定性和定量的對比。如圖1和表4所示,本文的方法取得了最佳的人臉相似性、可編輯性、圖像質量。

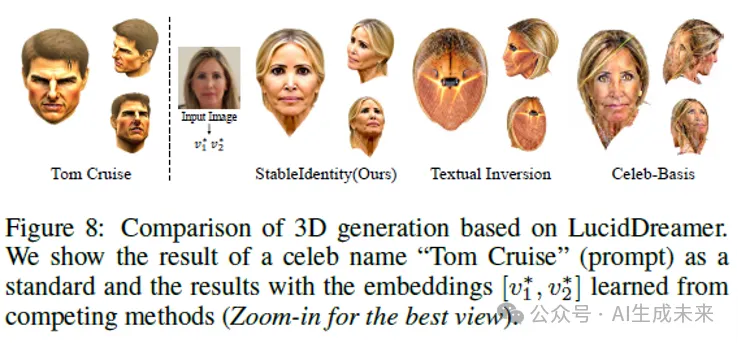

- 此外,本文進一步在與3D模型的結合上與同類型基于詞向量的方法進行了對比,可以看出StableIdentity可以更好地插入到3D生成中。

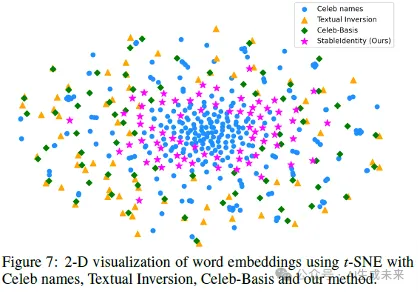

本文用TSNE可視化了學到的身份編碼與具有可編輯性的名人名字編碼的2D分布。可以看出,本文的StableIdentity學到的embedding分布更加緊湊,更接近于真實的名人名字embedding的分布。

3. 本文也用單張名人照片作為輸入進行了實驗,可以看出,學到的身份在圖像/視頻/3D上都表現不錯。

更多的結果可以在https://qinghew.github.io/StableIdentity/中查看。

四、展望

這一方法可以直接與ControlNet等基于Stable Diffusion的即插即用的模塊配合使用,甚至可以將學習到的身份插入現成的視頻/3D生成的模型中,而無需進行微調即可產生出色的效果。這項工作被認為是統一圖像、視頻和3D定制化生成任務的重要一步。未來的工作將進一步探索通過更高效的方式學習泛化性強的身份表示,以更好地適應和解決實際應用中的挑戰。

本文轉自 AI生成未來 ,作者:Qinghe Wang