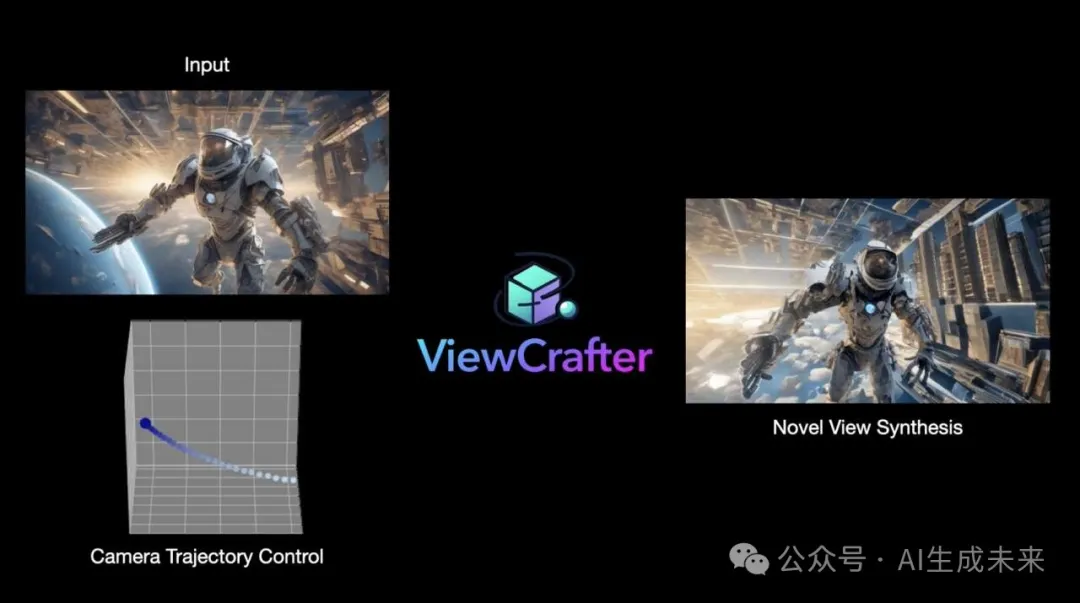

Amazing!精準可控新視角視頻生成+場景級3D生成!北大&港中文&騰訊等開源ViewCrafter

論文鏈接: https://arxiv.org/abs/2409.02048

GitHub鏈接:https://github.com/Drexubery/ViewCrafter

項目鏈接: https://drexubery.github.io/ViewCrafter/

Demo鏈接: https://huggingface.co/spaces/Doubiiu/ViewCrafter

?

亮點直擊

- 本文提出了一種迭代視圖合成策略,并結合內容自適應相機軌跡規劃算法,以逐步擴展新視圖覆蓋的區域和重建的點云,從而實現遠距離和大范圍的新視圖合成。

- 本文的方法在多個具有挑戰性的數據集上表現出色,不僅在合成新視圖的質量方面表現優異,還在相機姿態控制的精確度方面表現出色。該方法不僅適用于新視圖合成,還可以通過高效優化基于3D-GS的表示,實現實時渲染的沉浸式體驗,以及用于場景級別的文本到3D生成,以創造更具想象力的藝術作品。

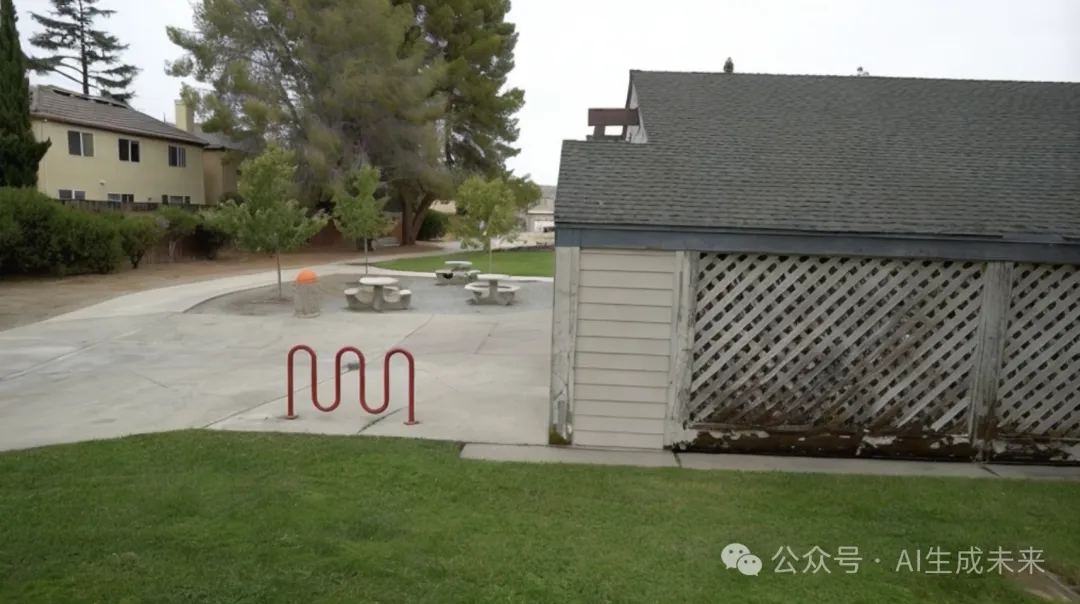

Reference image | Camera trajecotry | Generated novel view video |

|

|

|

|

|

|

|

|

|

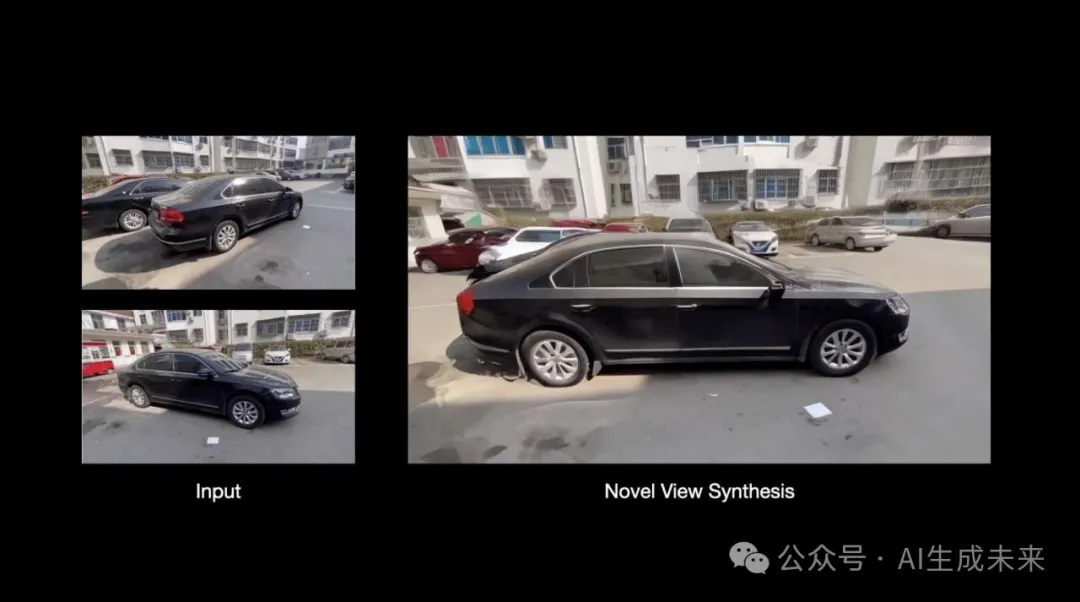

Reference image 1 | Reference image 2 | Generated novel view video |

|

|

|

|

|

|

|

|

|

來自北大、港中文、騰訊等機構的研究人員提出ViewCrafter,可以從根據單張或稀疏輸入圖像生成精確相機可控的新視角視頻,并支持場景級圖生3D,文生3D和稀疏視角重建等應用。

傳統的新視生成方法如NeRF和3D-GS等技術依賴于密集的多視角訓練數據,這限制了它們在僅有稀疏甚至單張輸入視角的情況下的應用。同時,這些方法沒有需要逐場景優化,不具備范化能力,限制了他們在訓練資源受限場景下的應用。

在實際應用中,一個更理想的問題場景是從稀疏視角甚至單張輸入圖像中生成任意規模場景的新視角。這項任務相當具有挑戰性,因為它需要模型對3D物理世界有全面的理解。而本文提出的新視角生成方法,ViewCrafter,能夠對任意輸入圖像實現相機軌跡精確可控的新視角視頻生成,并進一步支持圖生3D,文生3D和稀疏視角重建等應用。

目前論文和代碼均已開源,并提供了在線Huggingface demo供用戶使用。

效果展示

相機軌跡可控的視頻生成,單視角輸入

相機軌跡可控的視頻生成,2視角輸入

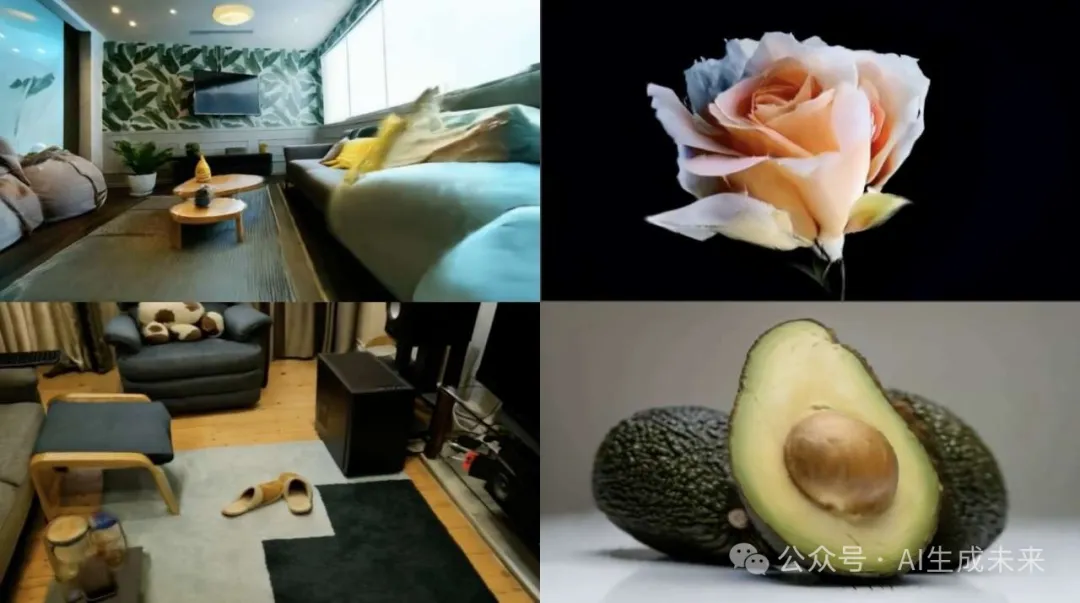

文生3D

文生3D

單圖生3D

單圖生3D

方法介紹

視頻擴散模型

Sora等在大規模真實場景視頻數據集上訓練得到視頻擴散模型能夠學到對3D物理世界的深入理解,從而使其從單張圖像或文本提示中生成復合物理規律和現實世界規則的視頻內容。然而,由于它們缺乏場景的底層3D信息,因此難以在視頻生成過程中實現精確的相機視角控制。

點云先驗

快速多視圖/單視圖stereo技術的發展使得僅從單張或稀疏圖像中快速重建點云表征成為可能。點云表征能夠提供粗略的3D場景信息,支持自由視角渲染和精確的相機位置控制。然而,由于其表示能力較差,以及極其稀疏的輸入圖像所提供的3D線索非常有限,它在處理遮擋、缺失區域和幾何變形方面存在問題,限制了其在新視角合成中的應用。

ViewCrafter

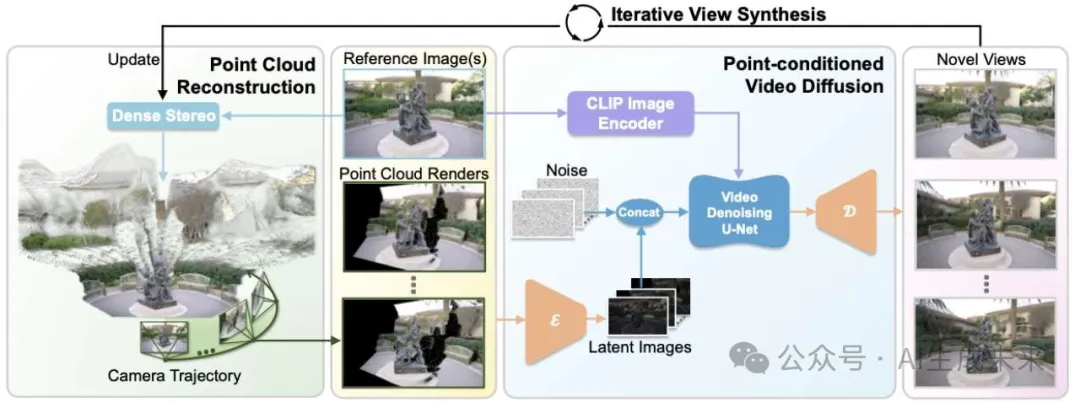

研究者們提出將視頻擴散模型的生成能力與點云表征提供的粗略3D先驗相結合,以實現相機精準可控的任意場景高保真度新視角視頻生成。

如上圖所示, 給定單張或稀疏視角輸入圖像,研究者們首先使用快速多視圖Stereo方法構建其點云表示,這樣可以準確地移動相機進行自由視角渲染。隨后,為了解決點云渲染結果中存在的大面積缺失區域、幾何失真和點云偽影,研究者們訓練了一個以點云渲染結果為控制信號的視頻擴散模型,作為增強渲染器,以便根據粗糙的點云渲染結果生成高保真且一致的新視角。利用點云中的顯式3D信息以及視頻擴散模型的生成能力,本文的方法能夠實現6自由度的精準相機位姿控制,并生成高保真度、一致性強的新視角視頻。

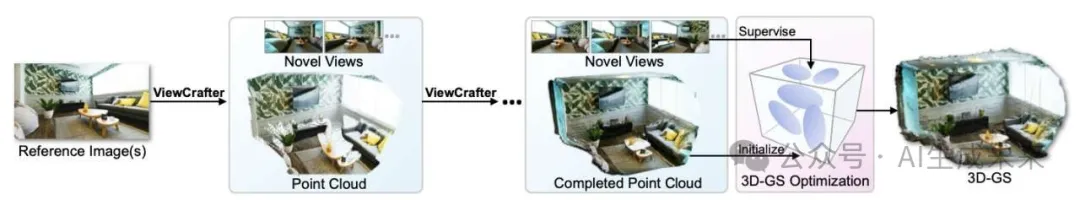

迭代生成

視頻擴散模型在生成長視頻時往往面臨挑戰,因為長視頻推理會造成巨大的計算成本開銷。為了解決這一問題,研究者們提出了一種迭代式的新視角生成策略,并提出了一種內容自適應的攝像機軌跡規劃算法,以逐步擴展重建的點云和新視圖覆蓋的區域。具體來說,從輸入圖像構建的初始點云開始,首先使用攝像機軌跡規劃算法,從當前點云預測一段相機軌跡,以有效揭示遮擋區域。接著,根據預測的軌跡渲染點云,并利用ViewCrafter根據渲染的點云生成高質量的新視角。隨后,用生成的新視角更新點云,以擴展全局點云表征。通過迭代執行這些步驟,最終可以獲得覆蓋大視場范圍和擴展點云的高保真新視圖。

3D高斯重建

基于研究者們提出的迭代新視角生成算法,可以從單張圖像/稀疏視角甚至一段文字描述中中進行3D高斯重建。

實驗結果

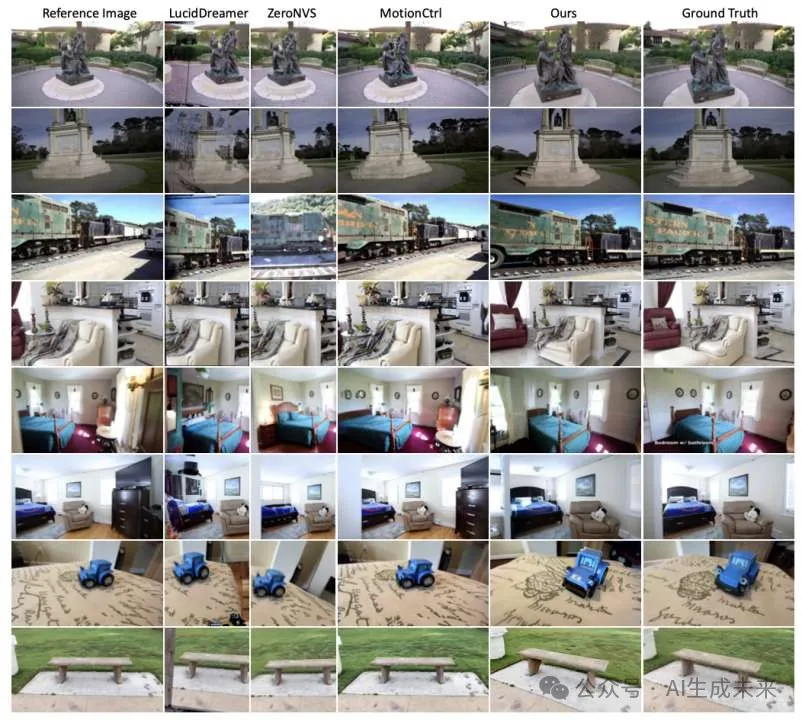

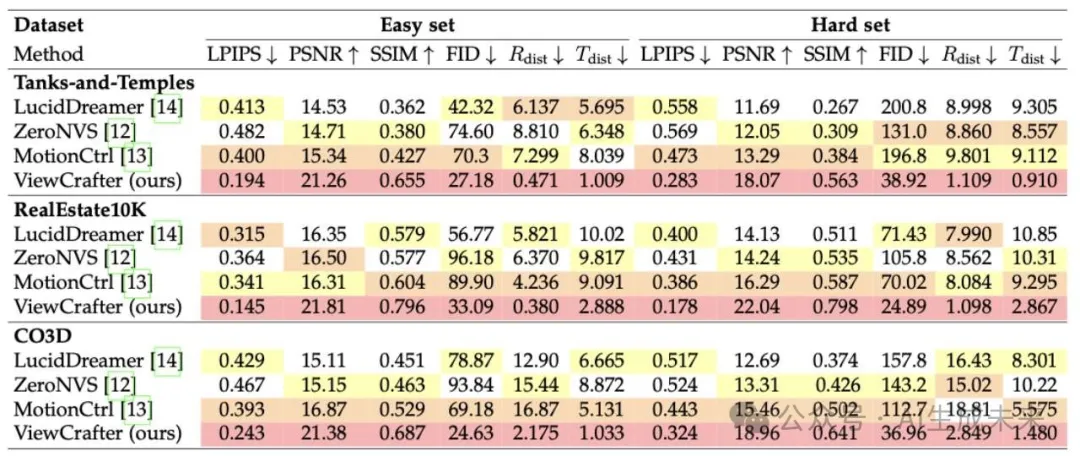

零樣本新視角生成

研究者們在Tanks-and-Temples,CO3D, RealEstate10K這三個真實世界數據集上與發表在CVPR2024,SIGGRAPH2024等頂會上的SOTA方法進行了定量和定性比較,實驗結果證明本文的方法在相機位姿控制的精準程度,以及生成新視角的視覺質量上都大幅超過對比方法。

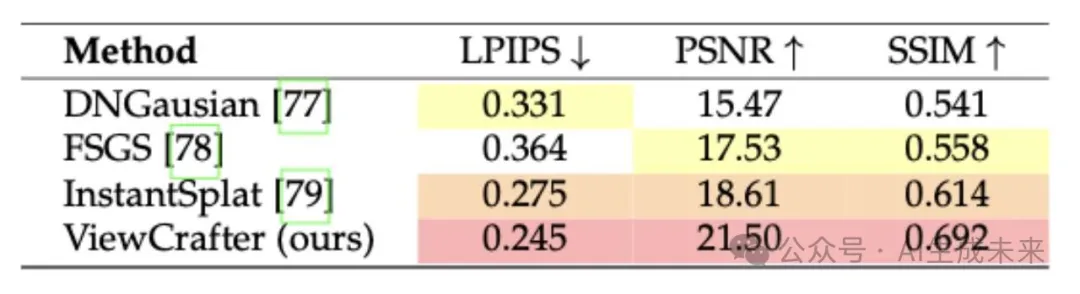

稀疏視角3D高斯重建

研究者們在Tanks-and-Temples數據集上與發表在CVPR2024,ECCV2024等頂會上的SOTA方法進行了定量和定性比較,實驗結果證明本文的方法在生成新視角的視覺質量上大幅超過對比方法

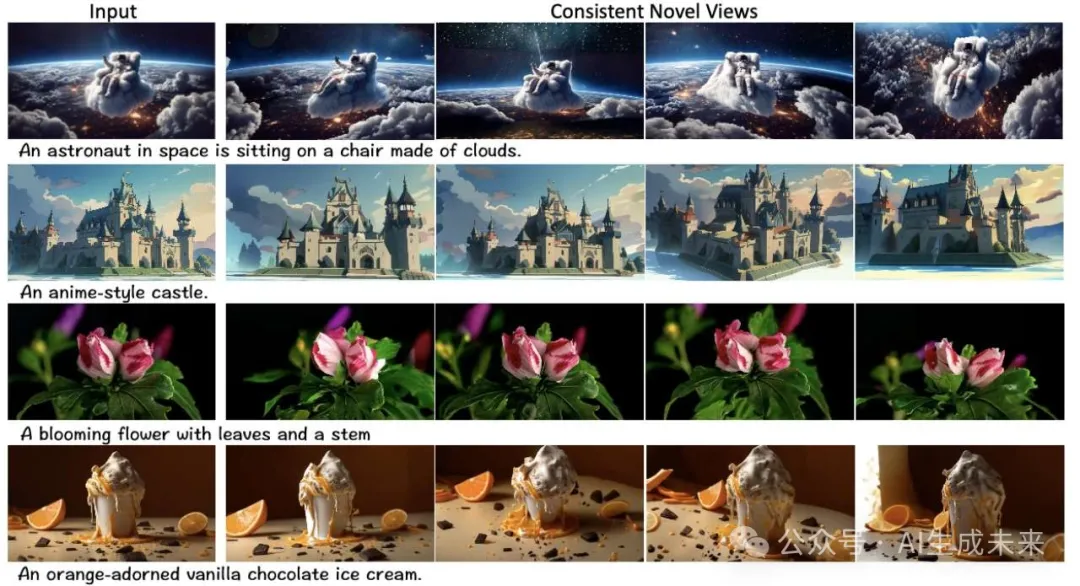

文生3D效果

啟發

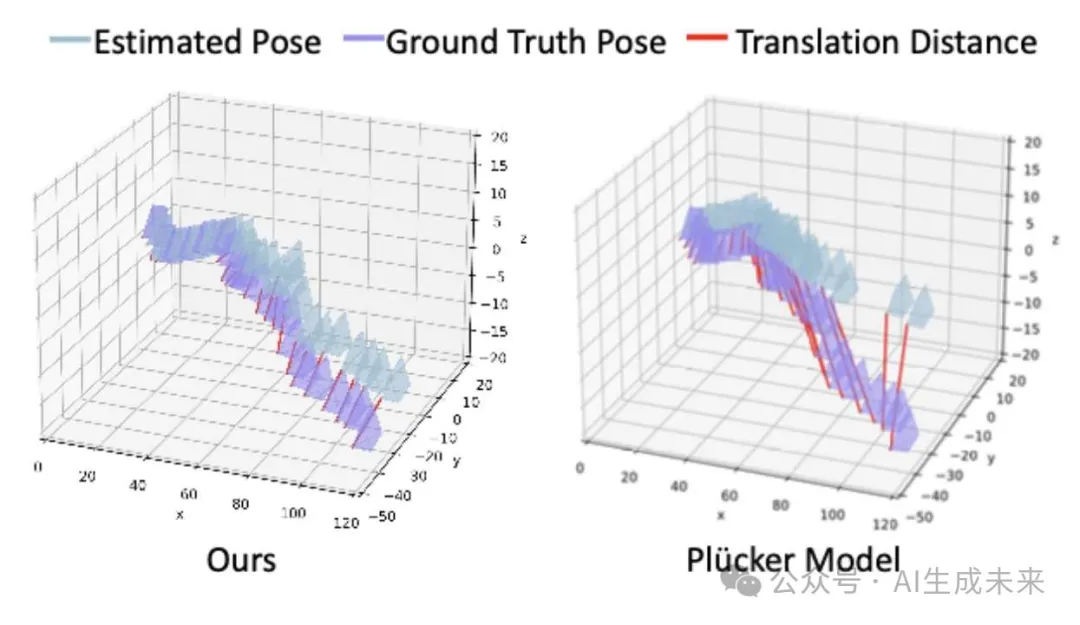

一些同期工作采用普呂克坐標作為視頻生成模型的控制信號,實現相機可控的新視角生成。作為對比,為了驗證點云控制信號的優越性,訓練了一個以普呂克坐標為控制信號的新視角生成模型,并進行控制變量實驗,保證除了控制信號外其他模型結構與ViewCrafter一致。兩個模型在新視角生成任務上對比結果如下所示:

實驗結果證明,不管是在新視角生成質量還是在相機控制的精準程度上,使用的基于點云的控制信號都要優于基于普呂克坐標的控制信號。

結論

本文提出了 ViewCrafter,一種結合視頻擴散模型和點云先驗的高保真度和準確的新視圖合成框架。本文的方法通過為各種場景類型提供泛化能力和對單幅圖像及稀疏圖像輸入的適應性,同時保持新視圖的質量一致性和準確性,克服了現有方法的局限性。此外,引入了迭代視圖合成方法和自適應相機軌跡規劃程序,促進了長范圍新視圖合成和多樣場景的自動相機軌跡生成。除了新視圖合成外,還探索了 3D-GS 表示的高效優化,以實現實時、高幀率的新視圖渲染,并將本文的框架適配于文本到 3D 生成。

未來計劃

研究者們驗證了ViewCrafter對于靜態場景的強大新視角生成能力。在未來的工作中,將探索和視頻深度估計方法結合,實現單目動態視頻的新視角生成和4D重建。

本文轉自 AI生成未來 ,作者: AI生成未來