Llama 3.2:AI視覺革新,手機也能跑大模型

Meta最新發(fā)布的Llama 3.2不僅能"看",還能在你的手機上運行。這次更新帶來了多模態(tài)支持的Llama Vision和專為設備端優(yōu)化的"tiny"模型,共推出10個新模型,規(guī)模從1B純文本到90B多模態(tài)(文本+圖像)不等。

Llama 3.2的核心亮點:

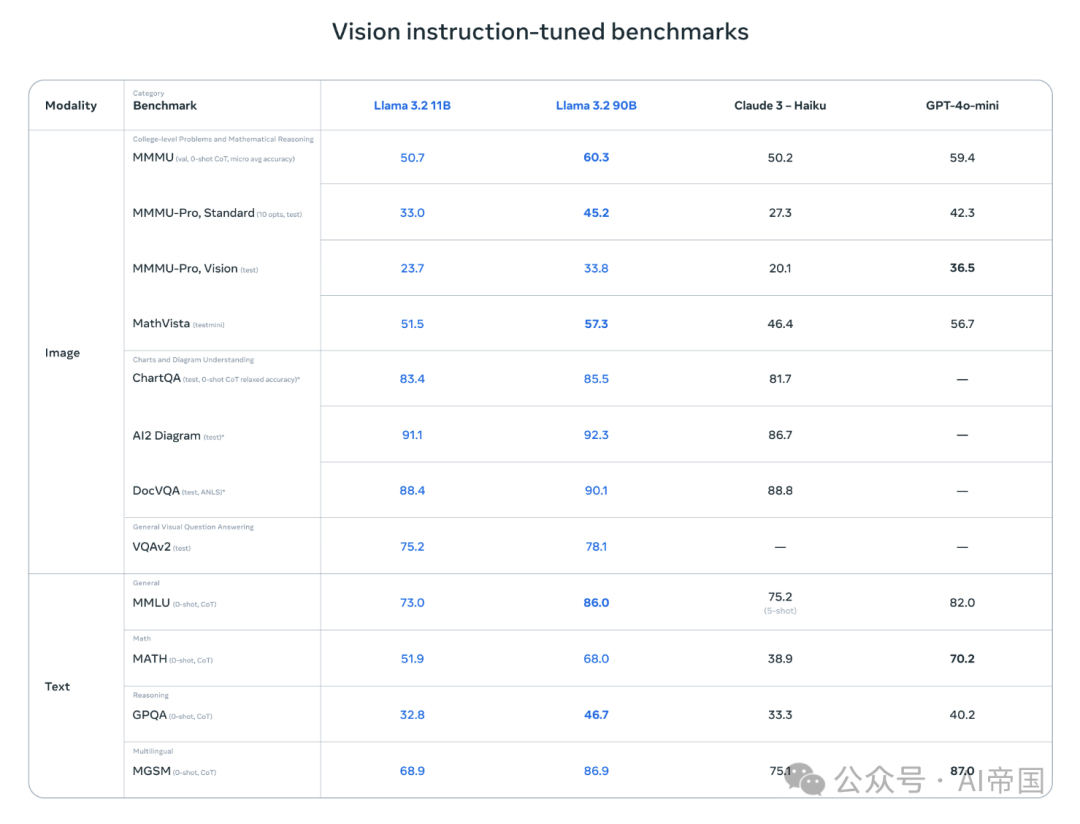

1.Llama 3.2 Vision:推出11B和90B兩種規(guī)模的多模態(tài)模型,支持文本+圖像輸入并生成文本輸出。這些模型基于Llama 3.1文本模型,通過6B圖像-文本對訓練而成。

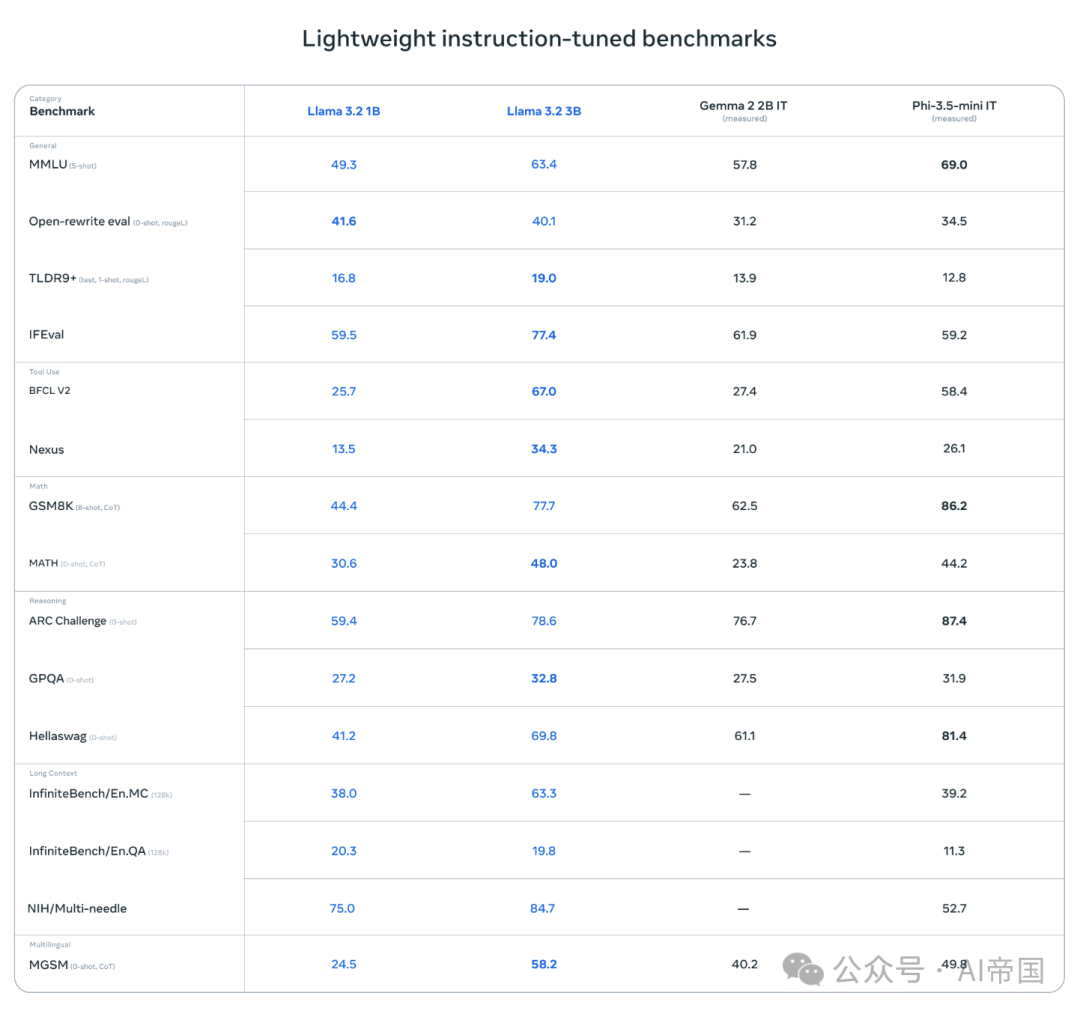

2.Llama 3.2 Edge:專為高效本地部署設計的1B和3B多語言純文本模型。

3.所有Llama 3.2模型均支持128k token的超長上下文。

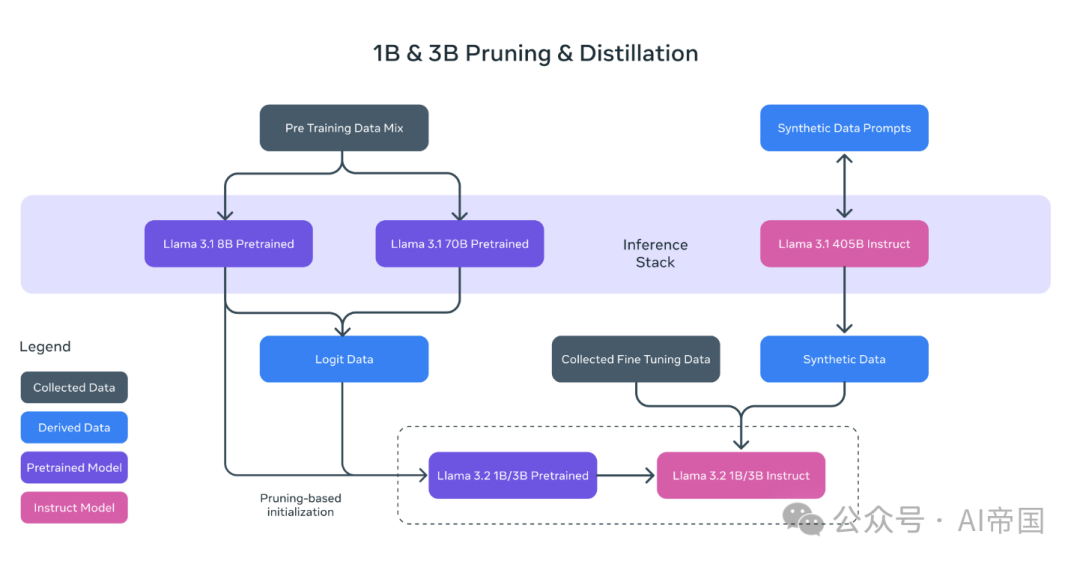

4.新訓練方法:通過知識蒸餾和剪枝技術,從8B/70B模型中提煉出高效的1B/3B模型。

5.Llama Guard 3.2:兩個增強版安全守護模型,新增視覺支持功能。

6.性能突破:Llama 3.2 3B模型在IFEval評測中達到了Llama 3.1 8B的水平,為設備端RAG或智能代理應用提供了強大支持。

Llama 3.2的發(fā)布標志著邊緣AI和視覺技術的新紀元。此次更新引入了小型和中型視覺大語言模型(11B和90B),以及適用于移動設備的輕量級文本模型(1B和3B)。這些模型支持高達128K的上下文長度,旨在實現(xiàn)本地處理的即時性與隱私保護,滿足用戶在摘要、指令跟隨和文本重寫等任務中的需求。

在圖像理解領域,Llama 3.2的視覺模型表現(xiàn)出色,能夠處理文檔級理解、圖表解讀及圖像標注等任務。通過與大語言模型的無縫對接,用戶可以直接用自然語言提問,模型將結合圖像信息提供精確的答案。此外,這些模型通過在本地運行,保證了數(shù)據(jù)的私密性,使得應用程序在安全性和效率上都得到了極大的提升。

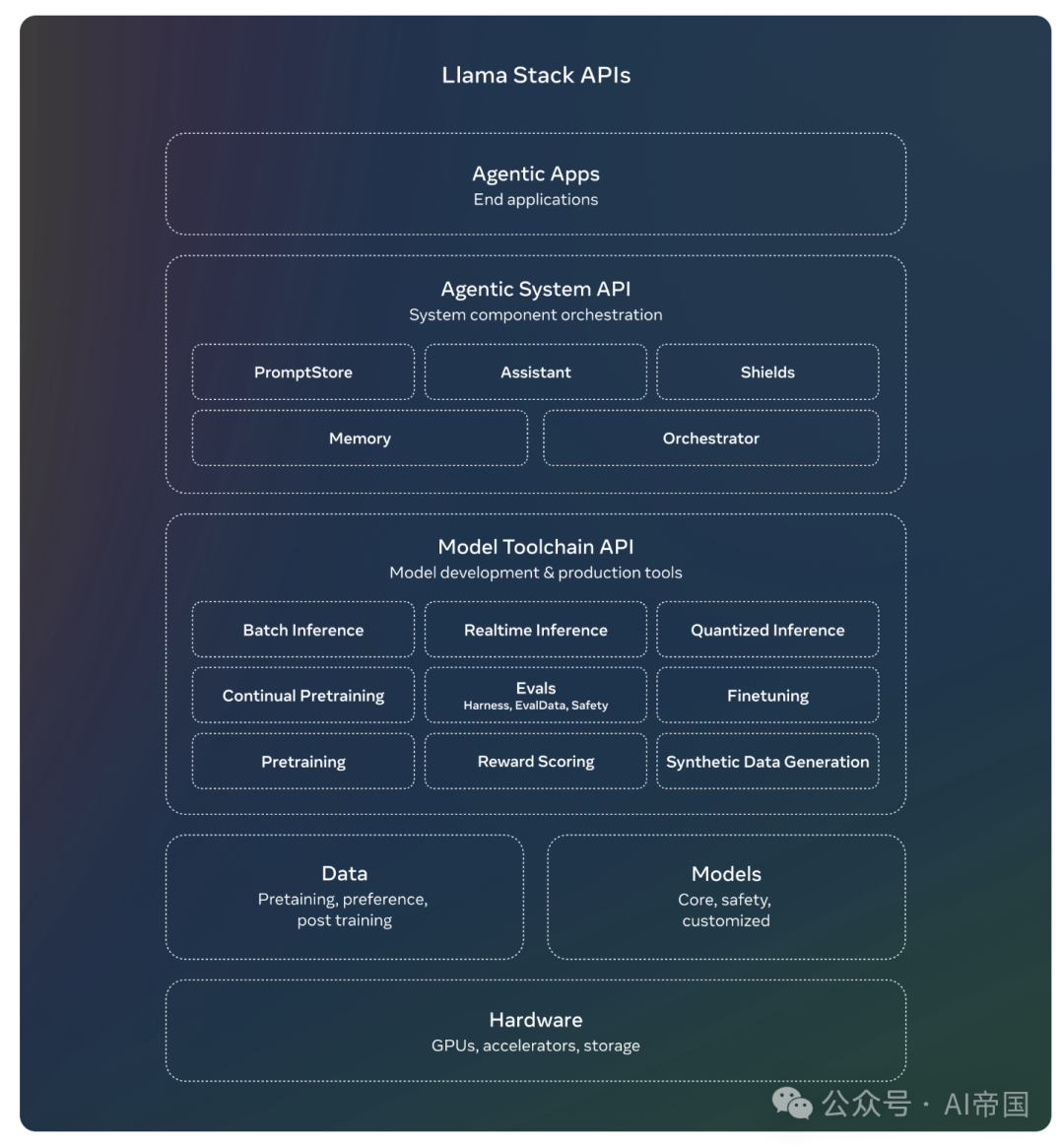

Llama 3.2的架構創(chuàng)新使其在處理圖像與文本的結合時表現(xiàn)更為出色。通過引入適配器技術,模型不僅保持了文本處理的強大能力,還增添了對圖像的深度理解與推理能力。Meta還與多家合作伙伴共同開發(fā)了Llama Stack分發(fā)版,簡化了開發(fā)者在不同環(huán)境下的使用流程,推動了生成式AI的可用性與創(chuàng)新性。

總之,Llama 3.2不僅增強了邊緣設備的AI能力,還為開發(fā)者提供了豐富的自定義選項。隨著開放性與可修改性的持續(xù)推進,Llama 3.2將推動更多創(chuàng)造性和實用性的突破,改變我們與AI互動的方式。

鏈接:???https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/??