RAG:如何通過實時數據提升AI準確性并減少“幻覺” 原創 精華

?在人工智能的發展中,內容生成的準確性始終是一個重要挑戰,特別是當模型生成出看似可信但實際錯誤的回答時,即所謂的“幻覺”(Hallucinations)。為了解決這一問題,出現了一項先進的AI技術——檢索增強生成(Retrieval-Augmented Generation,簡稱RAG),它通過結合實時檢索與內容生成的雙重能力,顯著提升AI的回答準確性。本文將深入探討RAG的原理、技術架構、向量數據庫的應用及其如何減少AI的常見問題,讓讀者全方位了解如何通過RAG實現更可靠、更貼近實際的內容生成。

01、RAG的核心理念:什么是檢索增強生成?

簡單來說,RAG是一種通過先檢索再生成來提升回答準確性的AI方法。傳統的AI生成內容通常基于模型的訓練數據,但往往無法反映實時的動態信息,這可能導致回答與實際情況脫節。RAG則不同,它首先從知識庫中檢索出與問題相關的最新信息,然后基于這些信息生成回答。通過將檢索式模型與生成式模型相結合,RAG不僅顯著提升了內容的質量和準確性,也增強了模型在自然語言處理任務中的表現。

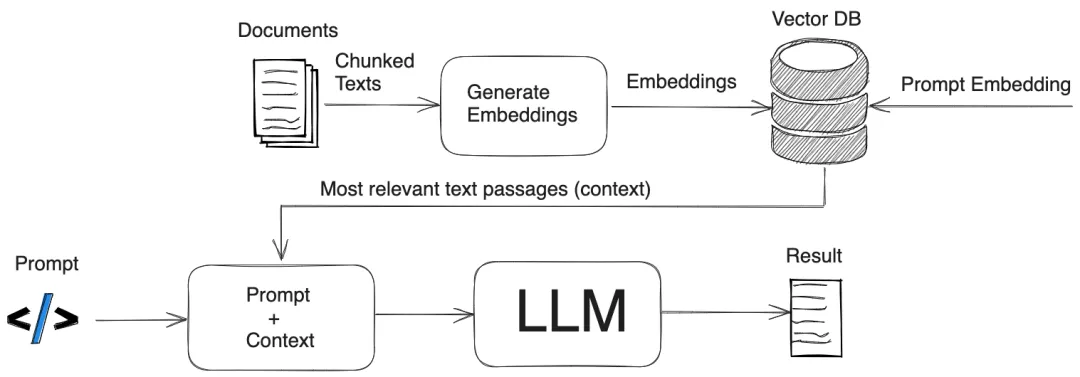

02、深入解析RAG的架構流程

RAG的流程分為兩個主要階段:檢索階段和生成階段。以下為RAG的詳細工作步驟:

1. 檢索階段

- 輸入:用戶輸入問題或提示,例如“量子計算的最新進展是什么?”。

- 檢索:系統會在一個知識庫或文檔集合中(通常是向量數據庫)進行搜索,通過相似度檢索找到相關文檔。

- 返回結果:系統將檢索出的最相關的信息片段返回(例如前5或10條最匹配的內容)。

2. 生成階段

- 結合信息:將檢索到的內容與用戶的輸入整合,以提供更加全面的上下文。

- 生成答案:使用生成式模型(如GPT等)基于這些信息生成回答,同時結合模型的已有知識與檢索內容。

- 輸出結果:系統返回基于檢索信息生成的最終回答,確保其準確性和實時性。

這種雙重過程使得RAG生成的回答更具可信度,特別是在知識密集型或需要實時更新的領域中表現出色。

對比RAG與傳統生成模式

在沒有RAG的情況下,傳統AI模型只能依賴已訓練的靜態數據來回答問題,缺乏對新知識的適應能力。這導致了生成的內容往往不夠準確,甚至出現“幻覺”或“虛構”內容。而RAG通過引入實時信息,彌補了這一短板,為AI生成的內容增添了時效性和真實性。

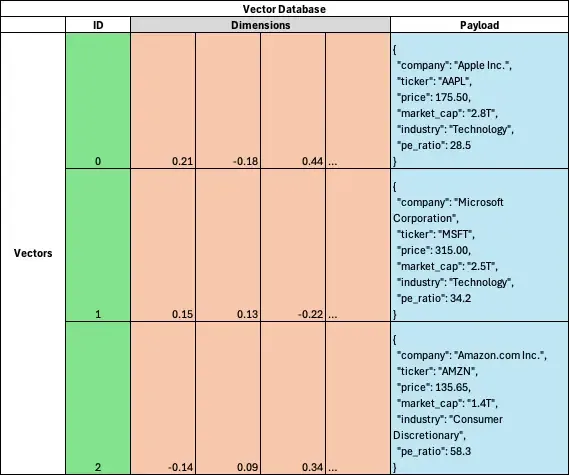

03、什么是向量數據庫?RAG工作流中的關鍵角色

向量數據庫在RAG的檢索階段中起到至關重要的作用,它能夠通過語義相似性高效地檢索相關信息。與傳統的關鍵詞匹配系統不同,向量數據庫將文本轉化為高維空間中的向量,并將具有相似含義的文本向量放置在相鄰位置,從而實現更精準的信息檢索。

向量數據庫示例

以下為向量數據庫中一個數據點的結構示例:

{

"id": 0,

"vector": [0.01, -0.03, 0.15, ..., -0.08],

"payload": {

"company": "Apple Inc.",

"ticker": "AAPL",

"price": 175.50,

"market_cap": "2.8T",

"industry": "Technology",

"pe_ratio": 28.5

}

}這種結構使得向量數據庫能夠以語義相似度而非簡單的關鍵詞來檢索信息,非常適用于需要快速檢索相關內容的AI系統。

04、RAG常用的距離度量方法

在向量數據庫中,為了更準確地匹配信息,系統需要使用距離度量來衡量數據點之間的相似性。不同的距離度量適用于不同場景,以下是RAG常用的幾種距離度量方法:

這些度量方法通過計算數據點間的相似性,確保RAG能夠找到最匹配的信息,從而生成更精準的回答。

05、如何利用RAG減少AI幻覺與虛構問題?

在AI生成內容時,有時會產生“幻覺”,即看似合理但卻錯誤的回答。例如:

- 問題:“澳大利亞的首都是哪里?”

- 錯誤回答:“澳大利亞的首都是悉尼。”(正確答案應為堪培拉)

這類問題源于模型試圖根據已知的模式來預測回答,卻無法訪問實時或正確的信息。RAG通過將生成過程建立在外部信息檢索之上,從根本上減少了這種錯誤。另外,RAG還能有效應對另一類問題,即“虛構”,即AI模型用錯誤的理由來支撐一個回答。RAG通過確保模型生成的內容基于實際檢索的數據,降低了生成不準確信息的風險。

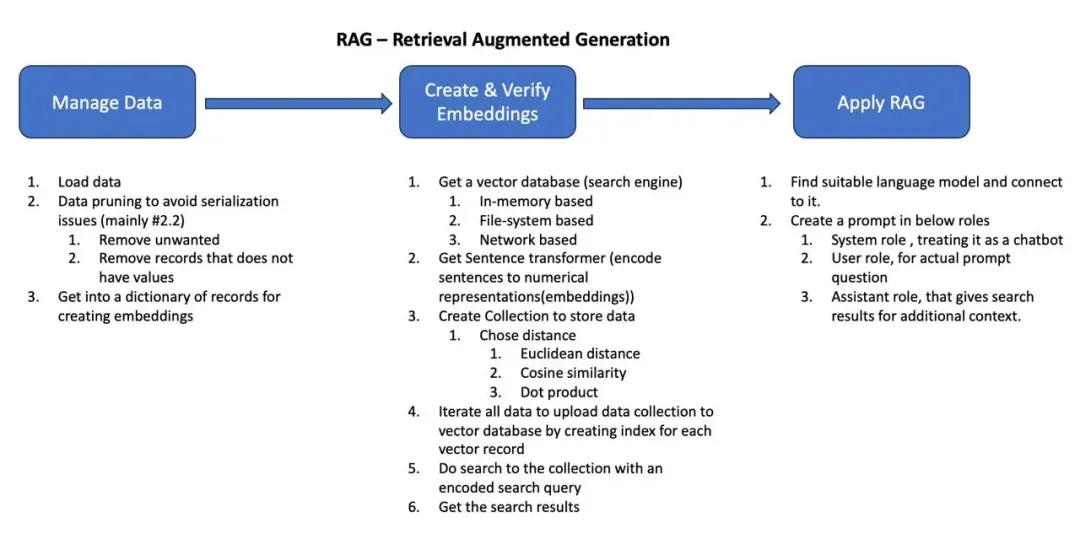

06、RAG實現步驟:從數據管理到向量數據庫檢索

以下是實現RAG的基本流程:

- 數據管理:整理和驗證用于檢索的數據,確保數據的完整性。

- 創建并驗證向量嵌入:使用語言模型將文本轉化為向量嵌入,以便后續的相似性匹配。

- 應用RAG流程:將用戶的查詢轉換為向量,檢索數據庫并生成回答。

示例:Python實現RAG流程

以下為RAG流程的Python代碼實現步驟:

Step 1:初始設置與配置

import pandas as pd

from sentence_transformers import SentenceTransformer

# 加載句子嵌入模型

encoder = SentenceTransformer('all-MiniLM-L6-v2')Step 2:數據清洗

# 讀取JSON格式的數據

df = pd.read_json('../../stock_data.json')

df = pd.json_normalize(df['stocks'])

df = df[df['company'].notna()]

data = df.to_dict('records')Step 3:初始化向量數據庫

from qdrant_client import QdrantClient

# 創建內存中的向量數據庫

qdrant = QdrantClient(":memory:")Step 4:創建向量集合

# 創建集合以存儲向量數據

qdrant.recreate_collection(

collection_name="top_stocks",

vectors_cnotallow=models.VectorParams(

size=encoder.get_sentence_embedding_dimension(),

distance=models.Distance.COSINE

)

)Step 5:數據向量化并上傳

# 向量化數據并上傳至向量數據庫

valid_data = [doc for doc in data if isinstance(doc.get("company", ""), str) and doc["company"].strip()]

qdrant.upsert(

collection_name="top_stocks",

points=[

models.PointStruct(

id=idx,

vector=encoder.encode(doc["company"]).tolist(),

payload=doc

) for idx, doc in enumerate(valid_data)

]

)Step 6:執行查詢并檢索結果

# 執行查詢并獲取相似結果

query_prompt = "市值較高的科技公司"

query_vector = encoder.encode(query_prompt).tolist()

search_results = qdrant.search(

collection_name="top_stocks",

query_vector=query_vector,

limit=3,

with_payload=True

)

for result in search_results:

print(f"公司:{result.payload['company']},行業:{result.payload['industry']},市值:{result.payload['market_cap']}")結合檢索結果進行生成

RAG還可以將檢索結果傳遞給生成式模型,用于增強回答的準確性。例如:

from openai import OpenAI

client = OpenAI(base_url="http://127.0.0.1:8080/v1", api_key="your_api_key")

completion = client.chat.completions.create(

model="LLaMA_CPP",

messages=[

{"role": "system", "content": "你是股票領域的專家,幫助用戶選擇股票并回答他們的問題。"},

{"role": "user", "content": "NVIDIA的市值和市盈率是多少?"},

{"role": "assistant", "content": str(search_results)}

]

)

print(completion.choices[0].message["content"])通過RAG的檢索增強,回答不僅限于模型訓練的靜態數據,還加入了最新的市場動態信息,使回答更加準確和實時。

07、結語

在追求AI內容生成準確性和可靠性的時代,RAG技術無疑是一項突破。通過將外部實時數據融入到生成過程,RAG顯著降低了“幻覺”和“虛構”現象的發生,使AI生成的回答更具實際意義。結合向量數據庫的語義搜索功能,RAG能夠為用戶提供更相關、更符合現實的信息。

RAG的檢索與生成相結合,正推動AI走向更高層次的智能化應用,為需要知識密集型內容的場景提供了新的解決方案。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯