騰訊&新加坡國立發布IFAdapter:即插即用,提升文生圖模型實例特征和位置生成準確性 精華

文章鏈接:https://arxiv.org/pdf/2409.08240

項目鏈接:https://ifadapter.github.io/

亮點直擊

- 提出了實例特征生成任務,旨在解決擴散模型在多實例生成中面臨的定位和特征準確性問題。此外,引入了COCO IFG基準和驗證pipeline,用于評估和比較模型性能。

- 提出了IFAdapter,該模塊利用新的外觀tokens和實例語義圖來增強擴散模型對實例的描繪,從而實現高保真度的實例特征生成。

- 全面的實驗結果表明,本模型在定量和定性評估中均優于基線模型。

- IFAdapter設計為即插即用的組件,能夠無縫增強各種社區模型的布局控制能力,無需重新訓練。

總結速覽

解決的問題:

傳統的文本生成圖像 (T2I) 擴散模型在生成單個實例時效果很好,但在多個實例的特征生成和準確定位上存在挑戰。盡管布局生成圖像 (L2I) 任務通過使用邊界框提供空間控制來解決定位問題,但在實例特征的精確生成上仍然不足。

提出的方案:

為了解決這一問題,提出了實例特征生成 (IFG) 任務,旨在同時確保生成實例的準確定位和特征保真度。為此,引入了實例特征適配器 (IFAdapter) ,作為一種模塊,能夠在不同模型中靈活應用。該模塊通過額外的外觀tokens和實例語義圖對齊實例特征與空間位置,從而增強特征表現。

應用的技術:

IFAdapter 利用了外觀tokens來增強特征生成,并通過實例語義圖將實例特征與空間位置對齊。這種方法可作為擴散過程中的模塊,適配不同的社區模型。

達到的效果:

實驗結果表明,IFAdapter 在定量和定性評估中均優于其他模型,有效提升了實例的定位準確性和特征保真度。同時,為此任務貢獻了IFG 基準,并開發了驗證pipeline,客觀比較不同模型生成實例的能力。

方法

問題定義

IFAdapter

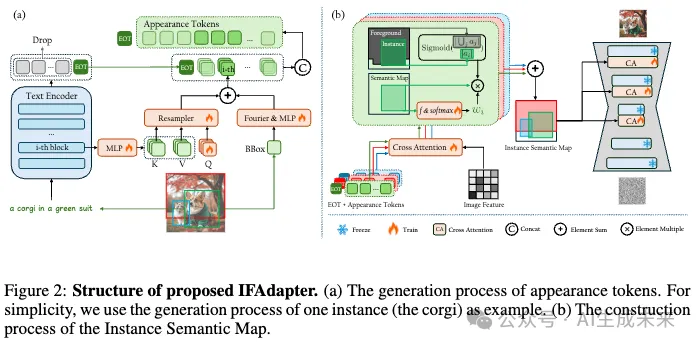

在本工作中,IFAdapter 旨在控制實例特征和位置的生成。使用開源的Stable Diffusion 作為基礎模型。為了解決實例特征丟失的問題,引入了外觀tokens,作為高頻信息的補充。此外,為了引入更強的空間先驗,確保對位置和特征的準確控制,利用外觀tokens構建了實例語義圖,以引導生成過程。

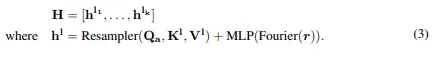

外觀tokens

L2I Stable Diffusion 通過引入局部描述和位置作為附加條件,具有豐富特征的實例。現有的方法通常使用預訓練的 CLIP 文本編碼器生成的上下文化token(即文本結束token,EoT token)來引導實例特征的生成。盡管 EoT token 在前景生成中起著關鍵作用,但主要用于生成粗略的結構內容,因此需要額外的標記來補充高頻細節。因此,現有的 L2I 方法若丟棄其他所有標記,則無法生成詳細的實例特征。

一種簡單的緩解方法是使用 CLIP 文本編碼器生成的所有 77 個 tokens作為實例級條件。然而,這種方法在推理和訓練過程中都會顯著增加內存需求。此外,這 77 個 tokens中包含大量的填充token,它們對生成沒有貢獻。雖然移除填充 token可以降低計算成本,但由于描述長度的不同,這種策略無法與批量訓練兼容。為了解決這一問題,本文提出將特征信息壓縮到一小組外觀tokens中,并利用這些tokens來補充 EoT token。

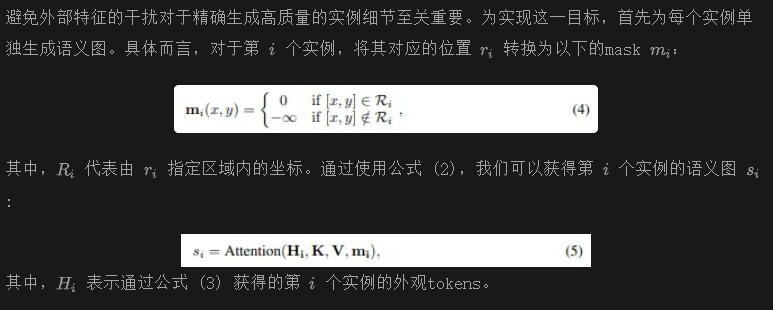

實例語義圖引導生成

除了確保生成詳細的實例特征外,IFG 任務還要求在指定位置生成實例。先前的方法使用順序錨定標記作為條件,這種方法缺乏強健的空間對應性,可能會導致特征錯位或泄漏等問題。因此,引入了一種名為實例語義圖 (ISM) 的地圖,作為更強的引導信號。由于所有實例的生成都由 ISM 引導,在構建該語義圖時必須考慮兩個主要問題:

- 為每個實例生成詳細且準確的特征,同時避免特征泄漏;

- 處理多個實例存在的重疊區域。

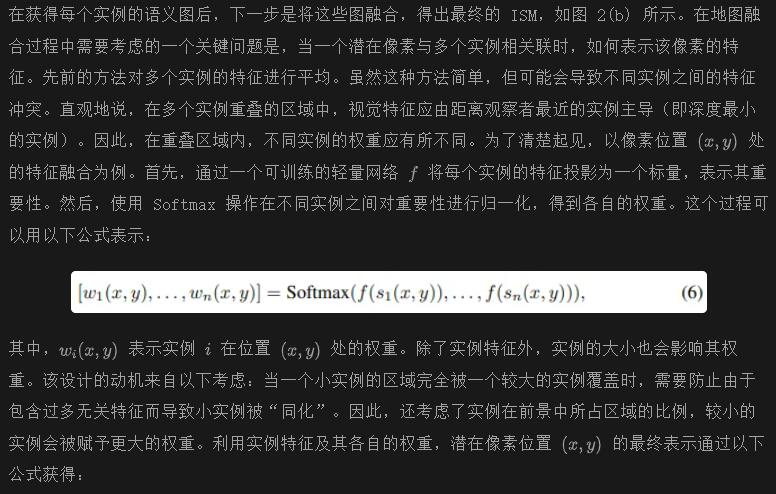

為了解決這些問題,首先獨立生成每個實例,然后在重疊區域進行聚合。以下部分將詳細解釋這些過程。

單實例特征生成

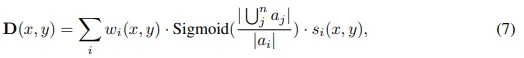

門控語義融合

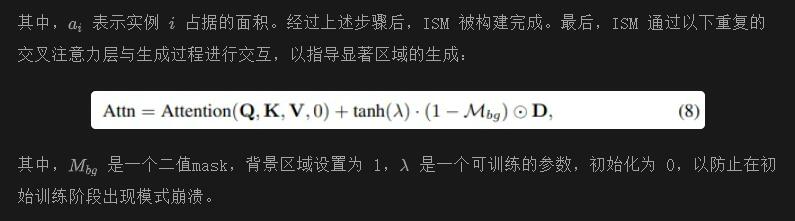

學習過程

在訓練過程中,凍結了 SD 的參數,僅訓練 IFAdapter。用于訓練的損失函數是包含實例級條件的 LDM 損失:

為了使本文的方法在推理階段執行無分類器引導 (CFG),在訓練期間將全局條件y和局部條件c隨機設置為 0。

實驗

實施細節

訓練數據集。使用 COCO2014數據集和 LAION 5B 的 100 萬子集作為數據來源。利用 Grounding-DINO和 RAM對圖像中的實例位置進行標注。然后,我們使用最先進的視覺語言模型 (VLMs) QWen和 InternVL為圖像和單個實例生成標題。

訓練細節。使用 SDXL,因其強大的細節生成能力,作為我們的基礎模型。IFAdapter 應用于 SDXL 的中層和解碼器層的子集,這些層對前景生成貢獻顯著。使用 AdamW優化器,以學習率 0.0001 訓練 IFAdapter 100,000 步,批量大小為 160。在訓練過程中,有 15% 的概率丟棄局部描述,30% 的概率丟棄全局標題。

在推理階段,使用 EulerDiscreteScheduler進行 30 次采樣步驟,并將無分類器引導 (CFG) 比例設置為 7.5。

實驗設置

Baselines

將本文的方法與先前的 SOTA L2I 方法進行了比較,包括基于訓練的方法 InstanceDiffusion、MIGC和 GLIGEN,以及無訓練方法 DenseDiffusion和 MultiDiffusion。

評估數據集

按照先前的設置(Li et al., 2023; Zhou et al., 2024b; Wang et al., 2024c),在標準的 COCO2014 數據集上構建了 COCO IFG 基準。具體而言,使用與訓練數據相同的方法對驗證集中的位置和局部描述進行標注。每種方法都需要生成 1,000 張圖像進行驗證。

評估指標

對于 IFG 任務的驗證,模型必須生成具有準確特征的實例,并在適當的位置生成。

- 實例特征成功率

- Frechet Inception Distance (FID)

- 全局 CLIP 分數

比較

定量分析

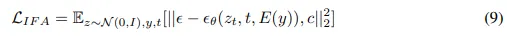

下表 1 展示了在 IFG 基準上的定性結果,包括 IFS 率、空間準確性和圖像質量的指標。

IFS 率

為了計算 IFS 率,我們利用了三個最先進的視覺-語言模型 (VLMs):QWenVL、InternVL 和 CogVL。這種多模型方法確保了更全面和嚴格的驗證。如上表 1 所示,本文的模型在所有三個 IFS 率指標上均優于基線模型。引入外觀tokens和在訓練中納入密集實例描述顯著提升了我們模型生成準確實例細節的能力。值得注意的是,InstanceDiffusion 在 IFS 率上表現優于其他基線模型。這可能是因為其訓練數據集也包含了密集的實例級描述。這一觀察進一步強調了高質量實例級標注的必要性。

空間準確性

如上表 1 所示,IFAdapter 在 GroundingDINO AP 中取得了最佳結果。這一成功歸因于地圖引導生成設計,該設計結合了額外的空間先驗,從而實現了更準確的實例位置生成。

圖像質量

如前面表 1 所示,本文的方法在 CLIP 評分上表現更高,表明增強局部細節有助于圖像與標題一致性的同時提高。此外,本文的方法實現了更低的 FID,說明本文的方法生成的圖像質量高于基線模型。將這一改善歸因于本文模型的適配器設計,該設計使得在不顯著妨礙圖像質量的情況下實現空間控制。

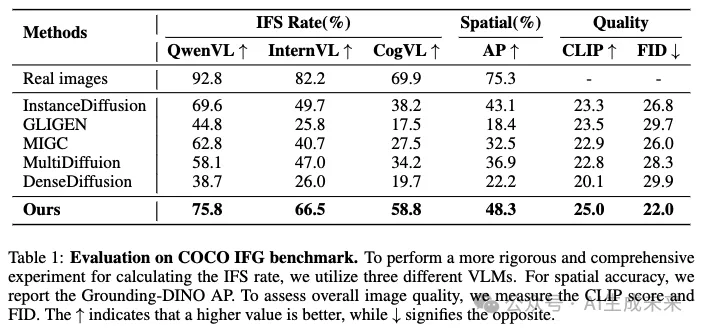

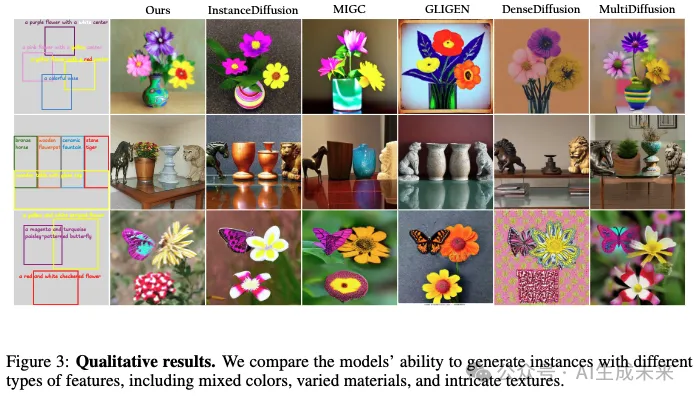

定性分析

在下圖 1(a) 中,我們展示了生成的具有多個復雜實例的場景結果。研究者們進一步在下圖 3 中評估了模型生成多樣化特征實例的能力。如所示,本文的方法在各種實例細節的保真度方面表現最佳。

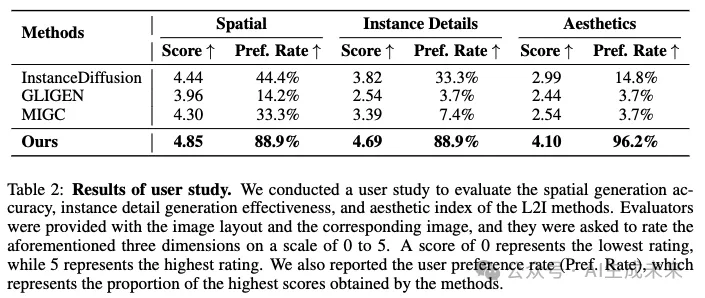

用戶研究

盡管 VLMs 可以在一定程度上驗證實例細節,但與人類感知相比仍存在差距。因此,邀請了專業標注員進行進一步驗證。

設置

進行了一個包含 270 個問題的研究,每個問題都關聯到一個隨機抽樣的生成圖像。評估者被要求對圖像質量、實例位置準確性和實例細節進行評分。總共收集了 30 個有效響應,產生了 7,290 個評分。

結果

如下表 2 所示,本文的方法在所有三個維度上都達到了最高的分數和用戶偏好率。值得注意的是,這些維度的趨勢與表 1 中的結果一致,進一步證明了 VLM 驗證的有效性。

與社區模型的集成

由于 IFAdapter 的即插即用設計,它可以對預訓練的擴散模型施加空間控制,而不會顯著影響生成圖像的風格或質量。這使得 IFAdapter 能夠有效地與各種社區擴散模型和 LoRAs集成。如下圖 4 所示,將 IFAdapter 應用到幾個社區模型,包括 PixlArt、LeLo-LEGO、Claymation和 BluePencil。生成的圖像不僅符合指定的布局,而且準確反映了各自的風格。

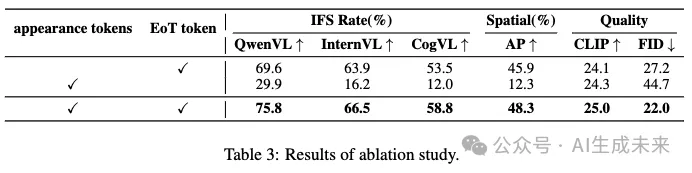

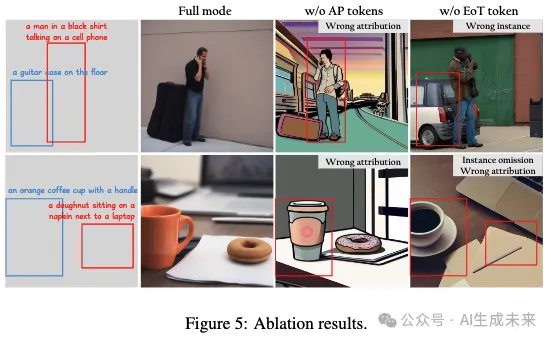

消融研究

本文引入外觀tokens以解決 EoT tokens在生成高頻細節方面的不足。這個消融研究主要探討了這兩種標記類型在實例生成中的作用。

appearance tokens. 如下表 3 所示,去除外觀tokens會導致模型的 IFS 率和 FID 下降,表明詳細特征的丟失。此外,如下圖 5 所示,沒有外觀tokens生成的圖像表現出實例特征的不匹配,進一步證明了外觀tokens主要負責生成高頻外觀特征。

EoT token. 在沒有 EoT token的情況下生成圖像時,IFS 率顯著下降。這主要是因為 EoT token負責生成實例的粗略語義。此外,上圖 5 指出,去除 EoT token會導致語義級別的問題,如實例類別錯誤和實例遺漏。

結論

本文提出了 IFAdapter,以對預訓練的 Stable Diffusion 模型進行細粒度的實例級控制。通過引入外觀tokens,增強了模型生成詳細實例特征的能力。利用外觀tokens構建實例語義圖,將實例級特征與空間位置對齊,從而實現了強大的空間控制。定性和定量結果都表明本文的方法在生成詳細實例特征方面表現出色。此外,由于其即插即用的特性,IFAdapter 可以作為插件無縫集成到社區模型中,而無需重新訓練。

本文轉自 AI生成未來 ,作者: AI生成未來