超越SDEdit等七大SOTA,免訓練多模態圖像編輯里程碑:HeadRouter帶來精準語義調整

文章鏈接:https://arxiv.org/pdf/2411.15034

項目鏈接:https://yuci-gpt.github.io/headrouter/

亮點直擊

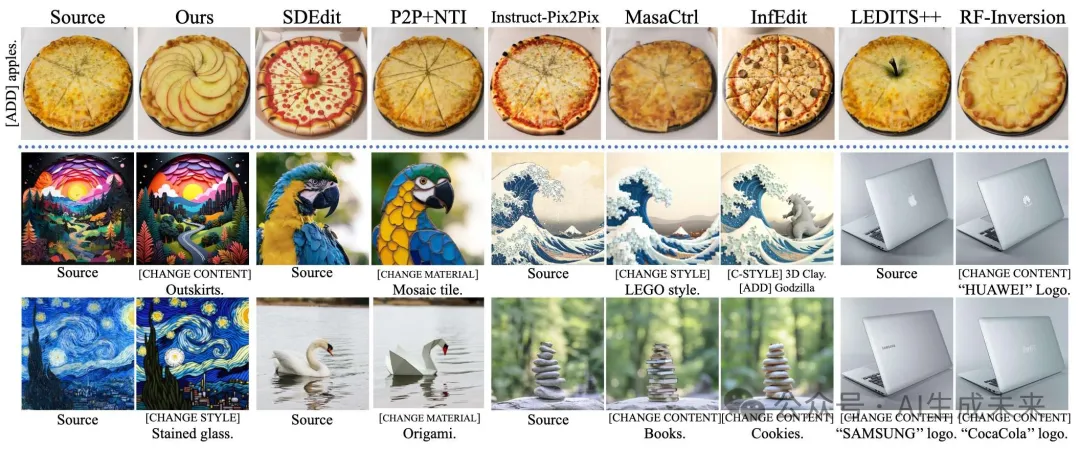

- 提供了對不同注意力頭對各種編輯語義的影響的深入分析,以及在無交叉注意力的MM-DiTs中,文本和圖像token之間的相互作用。

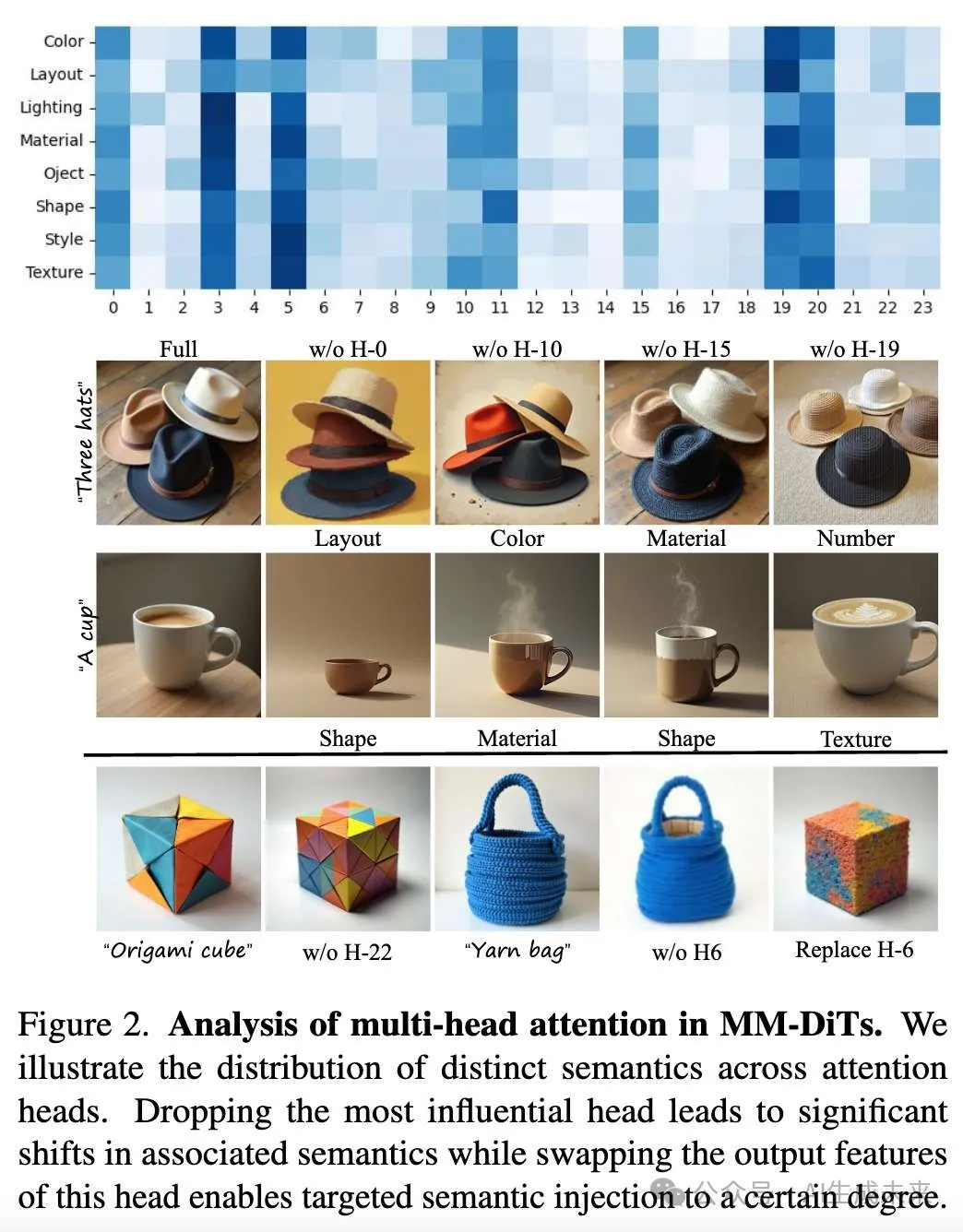

- 提出了HeadRouter,這是一種適用于MM-DiTs的新型圖像編輯方法,其中包括一個實例自適應Router,用于增強關鍵注意力頭的語義表示,以及一個雙重token優化模塊,用于精確的文本引導和關鍵區域表達。

- 在多個文本引導的圖像編輯基準測試上的實驗評估表明,本文的方法在不同任務中提供了更精確的區域、語義和屬性級別的編輯效果,超越了現有的最先進基線方法。

總結速覽

解決的問題

MM-DiTs(多模態擴散Transformer)在文本引導的圖像編輯任務中面臨顯著挑戰。與UNet結構不同,MM-DiTs缺乏明確且一致地結合文本引導的能力,導致編輯結果和文本之間存在語義不一致。

提出的方案

本研究提出了HeadRouter框架,通過自適應地將文本引導Router到MM-DiTs中的不同注意力頭,從而編輯源圖像。該框架無需訓練即可實現圖像編輯。此外,研究還提出了雙重token優化模塊,用于細化文本和圖像的token表示,以提供精確的語義引導和準確的區域表達。

應用的技術

- HeadRouter:一種無需訓練的圖像編輯框架,基于自適應文本引導Router。

- 雙重token優化模塊:優化文本和圖像token表示以提高語義精度。

達到的效果

在多個基準測試上的實驗結果表明,HeadRouter在編輯忠實度和圖像質量方面表現出色。

方法

本文主要提出了兩種技術:實例自適應注意力頭Router(Instance-adaptive Attention Head Router),通過識別和強調最有效的注意力頭來提高目標編輯語義的表示;以及雙重token優化模塊(Dual-token refinement module, DTR),通過將文本的注意力權重應用到圖像token上來精煉關鍵圖像token的編輯。

實例自適應注意力頭Router

基于對注意力頭對不同編輯語義的敏感性分析,目標是識別并強調最有效的注意力頭,用于特定的編輯任務。通過利用圖像重建分支的信息,我們引導圖像編輯分支專注于最相關的注意力頭,從而提高編輯效果。

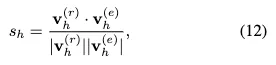

首先識別有效的注意力頭。方法的關鍵在于識別哪些注意力頭對所需的編輯語義最敏感。給定一個具有 H 個注意力頭的 DiT 模型,我們首先計算在生成有和沒有特定語義的圖像時,相應注意力頭輸出的余弦相似度。設 和 分別表示重建分支和編輯分支中第 h 個注意力頭的輸出特征,頭 h 的余弦相似度 計算公式為:

其中 "·" 表示點積,|| · || 表示歐幾里得范數。

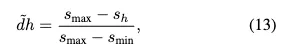

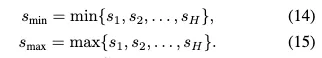

為了量化每個注意力頭對特定語義的敏感性,并在單步中對不相似度得分進行歸一化,設計了歸一化不相似度得分 作為:

其中

這個歸一化得分 反映了每個注意力頭的輸出與特定語義的不同程度,依據所有注意力頭中觀察到的不相似度范圍。

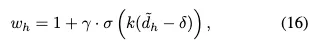

為了平滑地激活最敏感的語義注意力頭,提出了一個實例自適應注意力頭Router(IARouter),它應用于不同注意力頭的輸出特征。IARouter 的設計目標是:(1) 強調不相似的頭:為具有較低 的頭分配較高的注意力,以突出它們在表示所需編輯語義中的重要性;(2) 維持相似的頭:確保與編輯不太相關的頭的貢獻不會被過度改變,從而保持圖像中其他視覺方面的完整性;(3) 平滑權重:通過防止突變的權重變化避免偽影,并保持模型穩定性。

基于這些目標,IARouter 使用軟激活注意力頭。頭 h 的權重 定義為:

其中 γ 是最大權重增量,k 控制 sigmoid 曲線的陡峭度,δ 移動 sigmoid 的中心,σ(x) 是定義為:

在圖像生成過程中,將每個注意力頭的輸出乘以其對應的權重,以獲得增強后的輸出。

提出的 IARouter 作為一種平滑的語義特定增強器,通過識別和強調對特定語義敏感的注意力頭,IARouter 能夠實現更精確和有效的編輯。使用 sigmoid 函數可以使權重逐漸增加,從而避免突然的變化可能引入的偽影。

雙token優化模塊

文本token與圖像token之間的注意力權重反映了文本提示對每個圖像token的影響。我們利用這些權重將編輯聚焦在與期望語義對應的關鍵圖像區域,從而進行語義優化。此外,提出修改注意力歸一化以增強重要文本token對圖像token的影響。

面向語義的圖像token增強

MM-DiTs 的自注意力機制生成的注意力權重反映了文本token對圖像token的影響。具體來說,對于每個圖像token,與文本token相關的注意力權重指示了該圖像token關注每個文本token的程度。利用這一特性來識別并聚焦于受到編輯提示影響最大的圖像token。設 表示從文本token到圖像token的注意力權重矩陣,其中 是圖像token的數量, 是文本token的數量。元素 表示從文本token 到圖像token 的注意力權重。

我們提出了面向語義的圖像token增強方法,以聚焦編輯關鍵圖像token,同時考慮文本對不同圖像token的影響。形式化地,權重映射定義為:

其中, 表示第 個文本token對第 個圖像token的注意力權重。我們使用基于 softmax 的函數對圖像token的注意力權重進行歸一化,并使用 sigmoid 函數限制大權重的增長。 是權重增強系數, 用于幅度調整。關于 和 影響的進一步討論可以在補充材料中找到。

接下來,我們使用歸一化權重 對編輯分支中的圖像token進行重新加權。最終的圖像token 計算公式為:

這種公式確保了受到文本提示高度影響的圖像token(具有更高的 )被賦予更高的權重,而受影響較小的token則保持接近原始值。

基于殘差的文本token增強

由于文本token與圖像token之間的注意力權重在連續的注意力塊中逐漸衰減,我們利用殘差文本token在每個 Transformer 塊中保留文本引導。具體而言,該設計將前一注意力塊的文本引導傳遞到當前塊中。隨著信息在更深的塊中傳播,前一塊的輸入被作為殘差項,并與當前塊的輸入相結合,從而增強文本引導的連續性。此機制在每個塊中引入一致的文本信息,加強了文本引導,并提高了圖像編輯的準確性。

實驗

實現細節

實驗中,使用 Flux-1.0[dev] 及其默認超參數,并利用 RF-Inversion 將真實圖像逆映射到其潛在空間,同時遵循其基本設置。

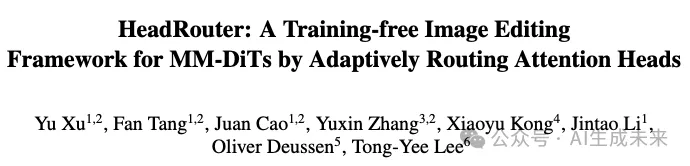

基線方法將本文的方法與七種最先進的文本引導圖像編輯方法進行了比較,包括兩種基于 Flux 的方法:RF-Inversion 和 SDEdit,以及五種基于 UNet 的方法:結合 Prompt-to-Prompt 的 Null-textual Inversion、Instruct-Pix2Pix、MasaCtrl、InfEdit 和 LEDITS++。所有這些方法都無需訓練。

數據集

在兩個文本引導圖像編輯基準數據集上評估了本文的方法與基線方法:

- TEDBench++:這是 TEDBench 的修訂擴展版,共包含 120 個實體。

- PIE-Bench:該數據集由 700 張圖像組成,每張圖像都對應 10 種不同的編輯類型。

評價指標

根據以往的文本引導圖像編輯工作,從三個指標評估所提出的方法:整體圖像質量、與文本引導的對齊程度以及與源圖像的結構一致性。具體來說,我們使用 LPIPS 評估整體質量,使用 CLIP-T 測量文本對齊程度,并使用 DINO 評估與原始圖像的結構一致性。此外,還進行用戶研究以進一步評估性能。

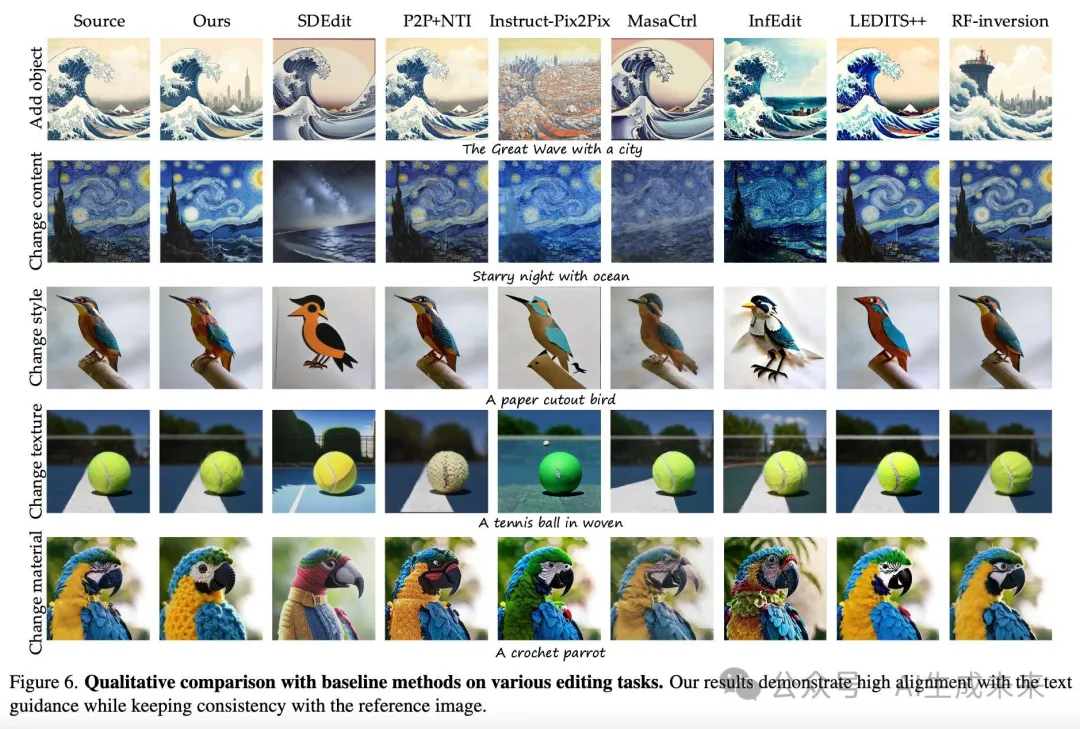

定性比較

在下圖 6 中,展示了不同編輯類型與基線方法的可視化結果。SDEdit 能夠在文本條件下生成新概念(例如,海洋、剪紙風格),但難以保持源圖像的語義信息(如第 2 行和第 3 行)。P2P+NTI 難以實現令人滿意的圖像編輯結果,往往忽略了文本條件中包含的信息(如第 1 ~ 3 行)。Instruct-Pix2Pix 同樣在涉及顯著變化的圖像編輯指令上表現不佳,導致語義丟失(如第 1 行)或編輯不準確(如第 2、4 和第 5 行)。MasaCtrl 和 InfEdit 同樣未能準確保留源圖像的語義(如第 3 行)以及編輯不準確(如第 1、2 和第 5 行)。LEDITS++ 在實驗中實現了改變圖像風格的編輯效果,但在特定語義編輯上仍存在問題(如第 1、2、4、5 行),同時源圖像細節丟失(如第 3 行)。RF-inversion 難以實現穩健的圖像編輯效果,導致部分輸出與源圖像幾乎相同(如第 3 和第 5 行)。本文的方法在結構保留和編輯效果上均表現最佳,超越了基線方法的性能。

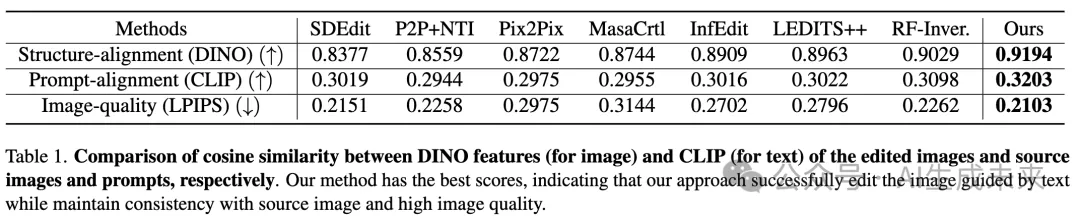

定量比較

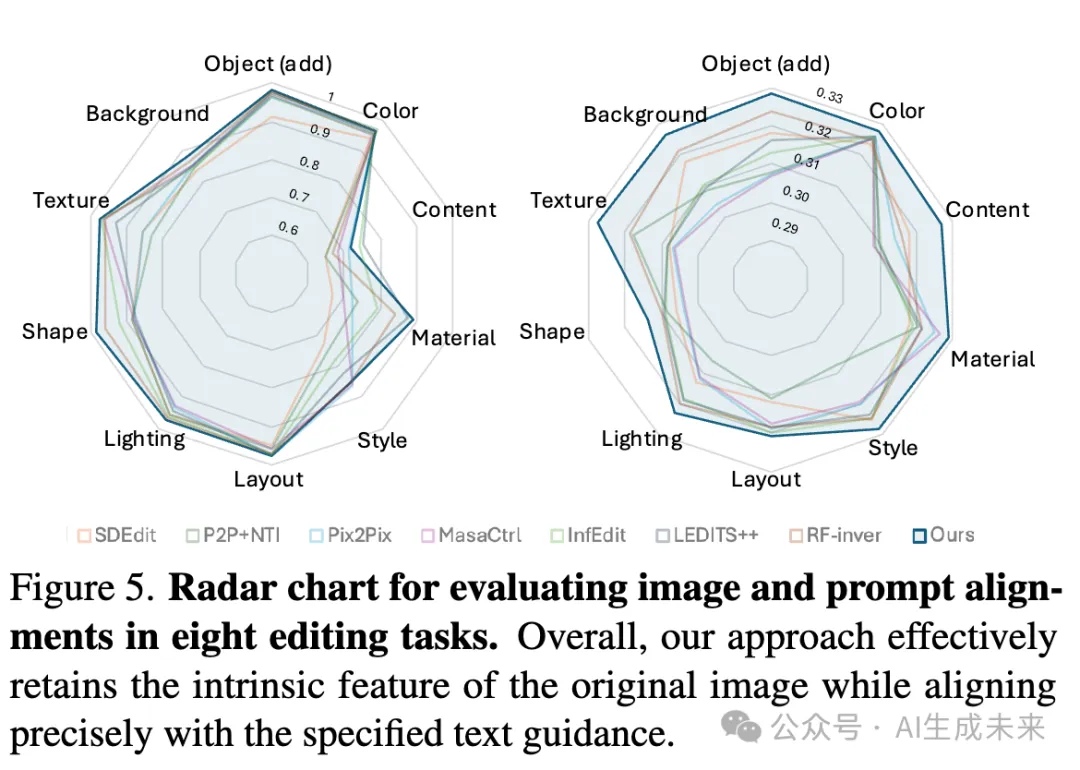

下表 1 展示了定量比較結果,包括編輯圖像與源圖像之間的結構對齊、編輯圖像與文本引導之間的對齊以及整體生成質量。還針對八種不同的編輯類型評估了圖像與文本的對齊。

如下圖 5 的雷達圖所示。在“更改內容”類別中,盡管 InfEdit 和 LEDITS++ 的某些指標與我們的結果相當,但其文本對齊顯著較低,表明這些方法未能實現有效的“更改對象”編輯。類似的結論可以從前面圖 6 中觀察到。此外,“更改內容”得分明顯低于其他指標,因為內容更改對圖像的主要區域進行了大幅度修改,從而降低了與原始圖像的結構相似性。然而,與基線結果相比,本文的結果仍然顯著更優。

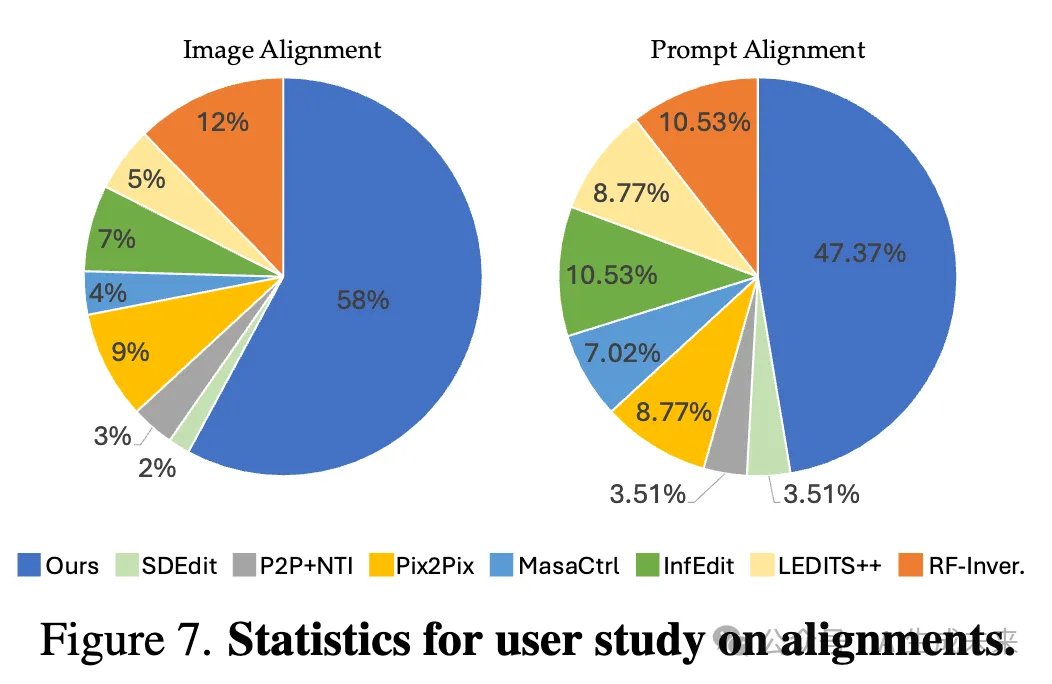

用戶研究

本文進行了一項用戶研究,重點考察兩個主要方面:與給定提示的對齊程度以及圖像中無關區域的保留情況。我們針對各種編輯任務生成了 50 組圖像,每組包含 8 張由本文的方法生成的圖像以及 7 張由基線方法基于相同提示生成的圖像。共有 56 名參與者查看了每組圖像,并被要求選擇最符合提示且保留原始圖像質量的圖像。下圖 7 的結果表明,我們方法生成的結果在緊跟提示的同時,能夠保留與編輯提示無關區域的質量。

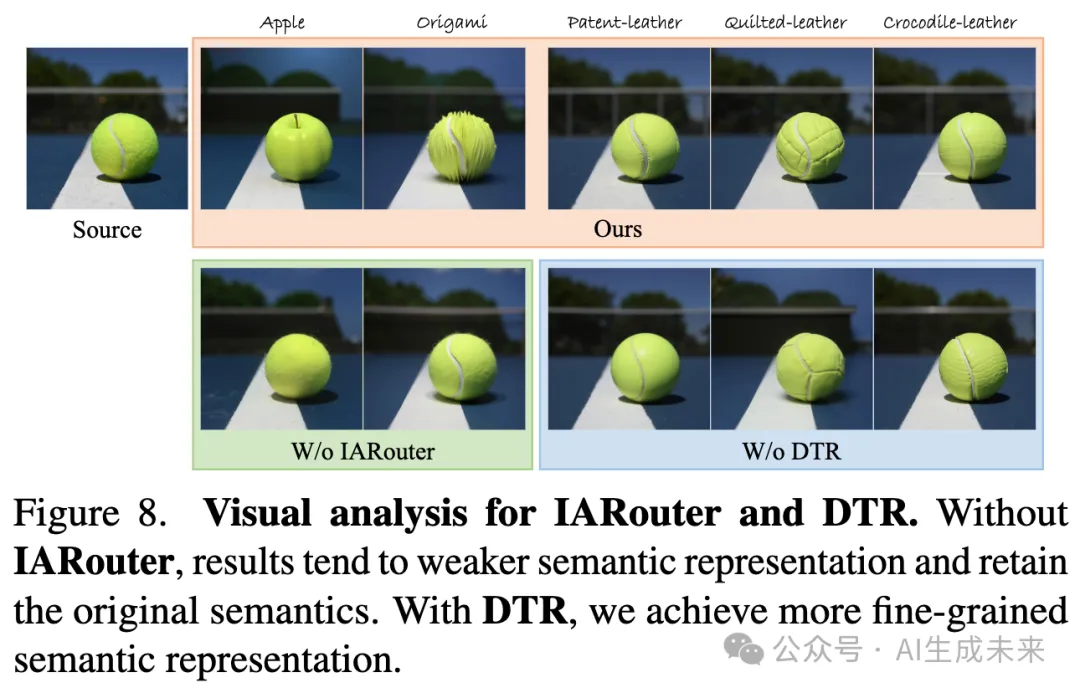

消融研究

本節通過提出的兩個關鍵模塊——實例自適應注意力頭Router (IARouter) 和 雙token細化模塊 (DTR) ——進行消融,驗證方法的有效性。

首先,在 IARouter 的消融中,在推理過程中移除了所有的頭部約束。如下圖 8 左下所示,這導致語義表達較弱(例如,在“蘋果”和“折紙”示例中,盡管某種程度上實現了所需的編輯語義,但原始網球圖像的殘余紋理依然存在)。相比之下,IARouter 通過根據語義內容對不同的頭進行Router,增強了特定語義的表達能力。

接下來,對 DTR 進行消融,結果如圖 8 右下所示。結果表明,通過加強圖像token和文本引導,本文的方法能夠捕捉所需的語義,并在響應詳細文本引導時實現更細粒度的語義表示。

局限性

由于預訓練模型中的多模態文本-圖像先驗,當編輯常見元素(如“埃菲爾鐵塔”)時,使用“一個<描述>埃菲爾鐵塔”的提示可能會產生有限的結果,因為這些提示已經編碼了特定的視覺細節。此外,本文的方法需要將圖像反演到潛在空間,因此編輯結果與原始圖像的對齊程度取決于反演過程的準確性。

結論

本文探討了 MM-DiTs 中的多頭注意力在圖像編輯中的作用,揭示了不同圖像語義信息在各個頭部中的分布。此外,分析了文本對圖像token的引導作用,發現文本影響在更深的注意力塊中逐漸減弱。基于這些見解,引入了實例自適應注意力頭Router,以增強關鍵注意力頭對目標編輯語義的表示能力,同時提出了雙token細化模塊,以確保精確的文本引導并強調關鍵區域。大量的定量和定性評估以及用戶研究表明,本文的方法在現有最先進方法中具有顯著優勢。

本文轉自AI生成未來 ,作者:AI生成未來