超越DiffEdit、SDEdit等6大編輯模型!字節等提出人像服飾、卡通表情編輯新SOTA! 精華

文章鏈接:https://arxiv.org/pdf/2407.20455

亮點直擊:

- 一種數據生成技術,提供了具有更好身份和布局對齊的配對數據;

- 一種多條件擴散模型,能夠生成保留特征的結果,并在推理中提供準確的編輯mask指導;

- 實現了最先進的人像編輯效果。

現有的技術在進行人像編輯時面臨挑戰,難以保留主體特征(如身份)。本文提出了一種基于訓練的方法,通過自動生成的配對數據來學習所需的編輯,同時確保保留未更改的主體特征。具體來說,本文設計了一個數據生成過程,以低成本創建合理的編輯訓練對。基于這些數據對,引入了一個多條件擴散模型(Multi-Conditioned Diffusion Model),能夠有效地學習編輯方向并保留主體特征。在推理過程中,該模型生成準確的編輯mask,可以在推理過程中進一步指導,保留主體的細節特征。在服裝編輯和卡通表情編輯的實驗中,本文的方法在定量和定性方面均達到了最先進的質量水平。

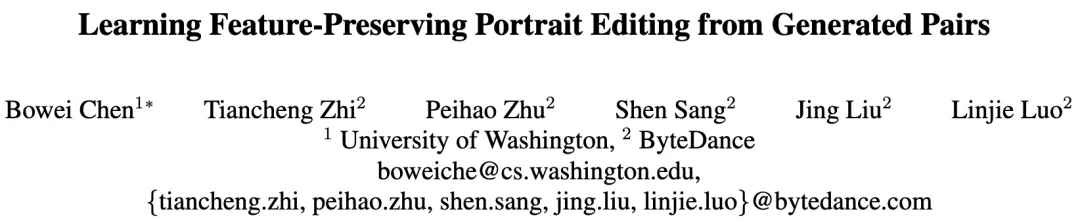

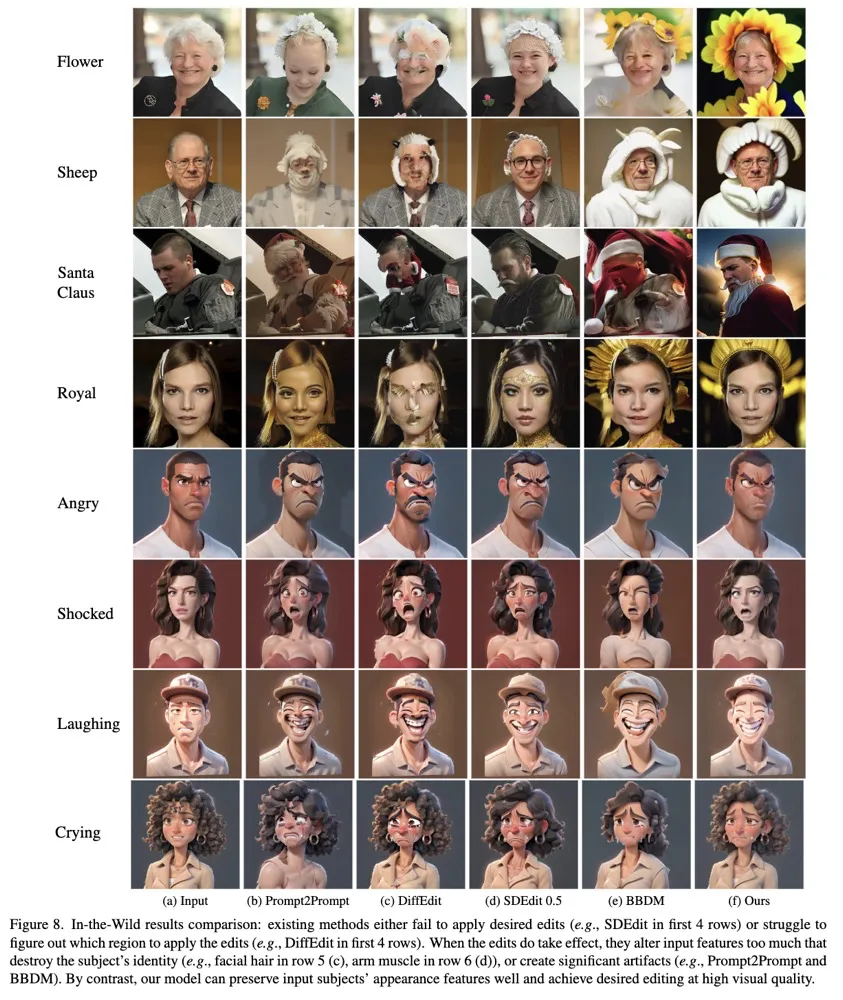

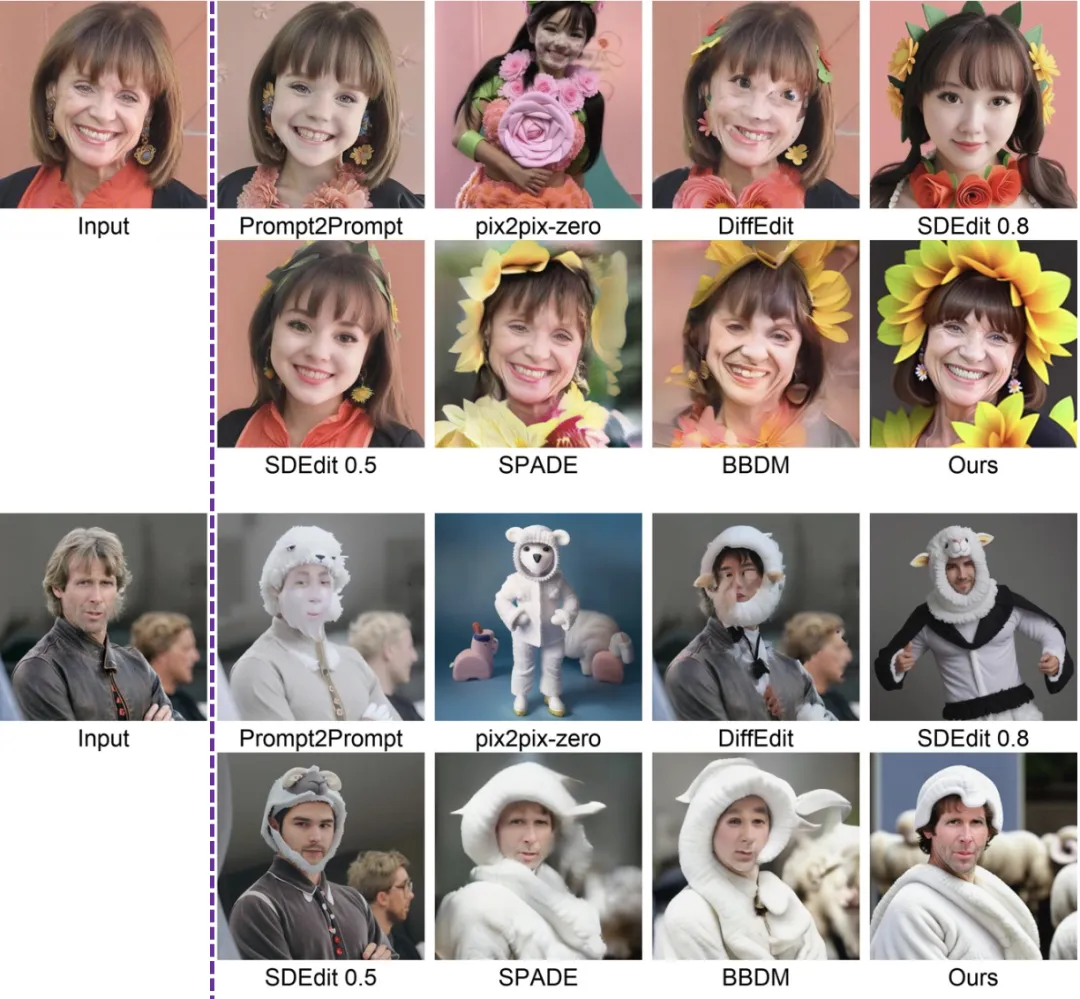

效果對比鎮樓

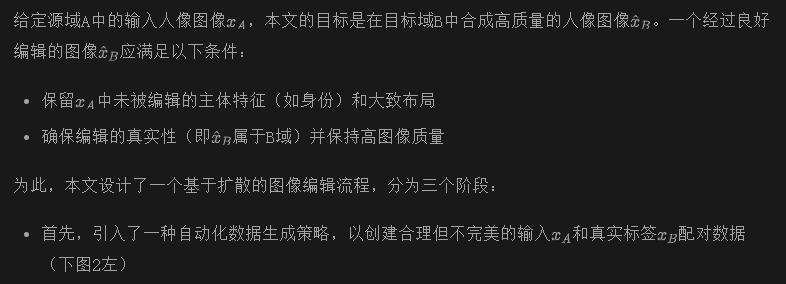

Pipeline

- 然后,設計并訓練了一個多條件擴散模型(MCDM)(圖2右)在生成的數據集上進行訓練。通過以不同方式利用多個條件,MCDM能夠有效地從訓練數據對中學習編輯方向,同時保留不應改變的主體細節特征

- 在推理過程中,使用訓練好的MCDM生成編輯結果,并通過自動生成的編輯mask進一步保留中的主體細節

配對數據生成

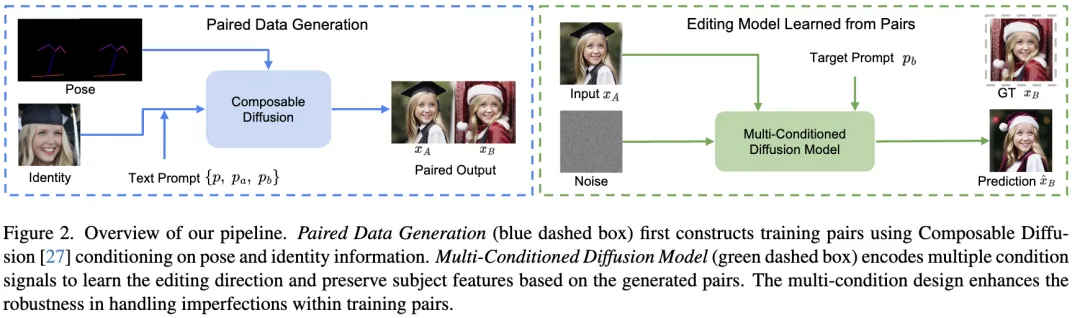

本文的目標是設計一種數據生成策略,能夠根據文本提示定義的特定編輯方向(例如,從普通服裝到圣誕老人服裝)生成配對樣本。然而,生成具有完美空間對齊和身份一致性的配對樣本非常具有挑戰性。因此,尋求設計一種策略(上圖2左),能夠生成合理的配對數據,并滿足以下基本條件:

相反,本文在Composable Diffusion的基礎上構建了一種條件配對生成策略,以滿足上述三個要求。關鍵設計包括:

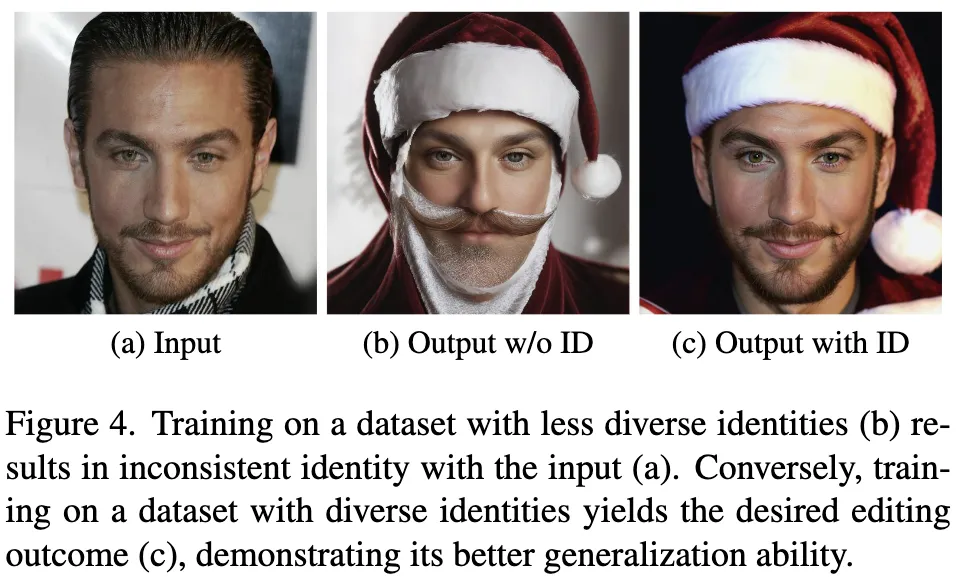

值得注意的是,設計(2)(用于姿態)和設計(3)(用于身份)在生成良好配對樣本中起著至關重要的作用。前面圖3說明了這一點。省略其中一個設計會導致明顯的空間錯位(圖(b))和面部形狀的顯著差異(圖(c))。此外,設計(3)也有助于在不同的配對樣本中生成多樣化的個體。這對于增強泛化能力至關重要,如下圖4所示。

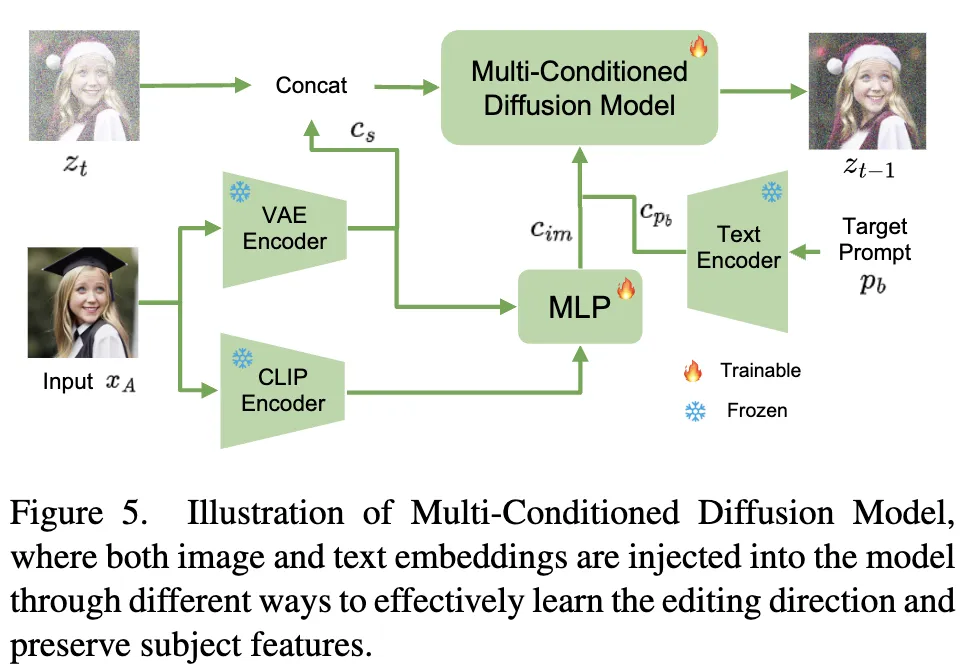

訓練多條件擴散模型

因此,針對這些不完美的配對數據,本文設計了一個圖像編輯模型,以有效地從生成的配對數據中學習相關信息,如編輯方向和未編輯的主體特征的保留,同時過濾掉意外的噪聲——特別是身份和布局中的細微變化。受到[22]的啟發,本文的模型的關鍵設計是在Stable Diffusion架構中以不同方式整合各種條件。將此模型稱為多條件擴散模型(Multi-Conditioned Diffusion Model,MCDM)。將首先定義這些條件,并詳細說明它們如何通過不同的注入方式幫助從不完美數據中學習相關信息。MCDM的詳細結構如下圖5所示。

為了將這些embeddings整合到本文的模型中,對Stable Diffusion架構進行了如下修改:

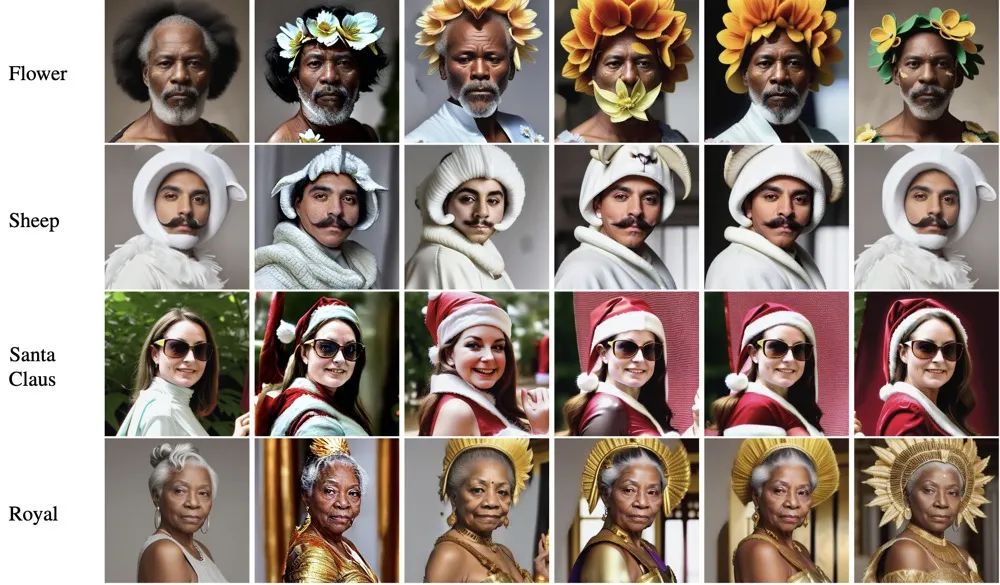

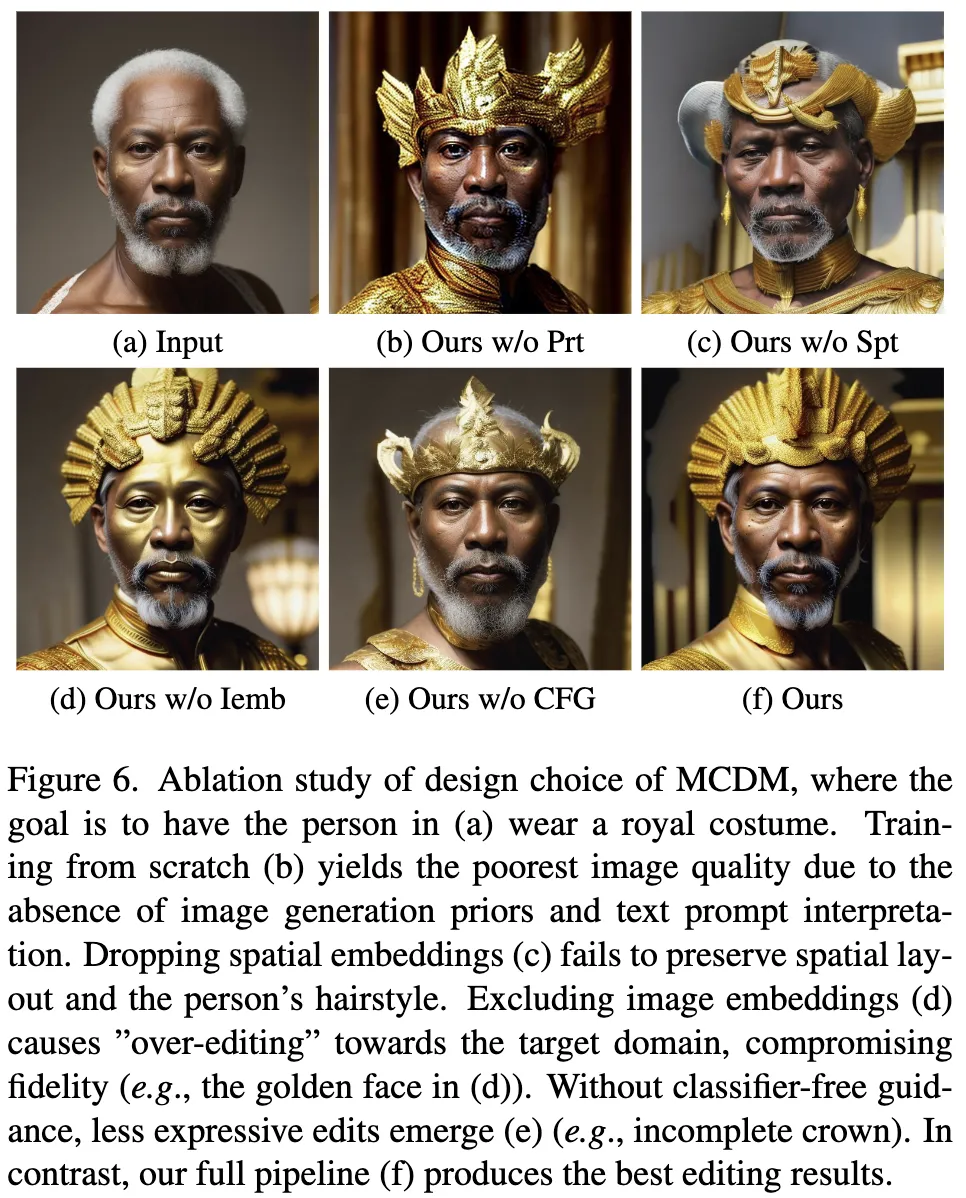

下圖6展示了這些設計選擇的消融實驗結果,強調了同時使用所有條件信號的有效性,如前文所述。

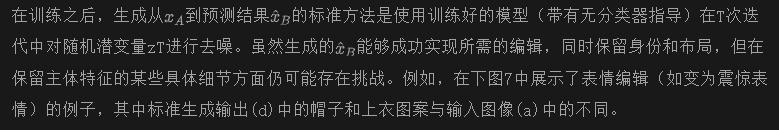

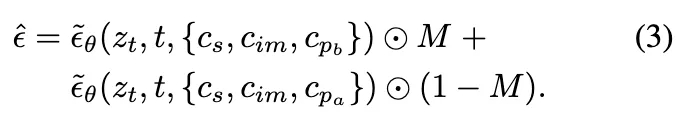

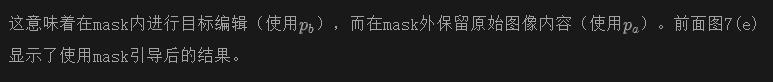

使用訓練模型進行mask引導編輯

為了增強這些細節的保留,可以從訓練好的MCDM中生成一個mask,為去噪過程提供明確的指導。這個mask指示了需要編輯的區域和不應更改的區域。本文采用了DiffEdit的方法來自動生成這樣的mask。本文與DiffEdit的mask生成策略的主要區別在于,本文并非依賴預訓練的Stable Diffusion模型,而是利用訓練好的MCDM及其重構能力來實現更精確的mask生成。通過將DiffEdit應用于本文的MCDM而非原始Stable Diffusion模型,可以通過MCDM的重構能力實現更精確的mask生成。

上面圖7(c)展示了一個由本文訓練的模型生成的編輯mask示例,其精確度比用于生成配對數據的DiffEditmask(圖7(b))更高。這一演示突顯了MCDM即使在不完美的數據集上訓練,也能夠辨別應進行編輯的內容類型的能力。

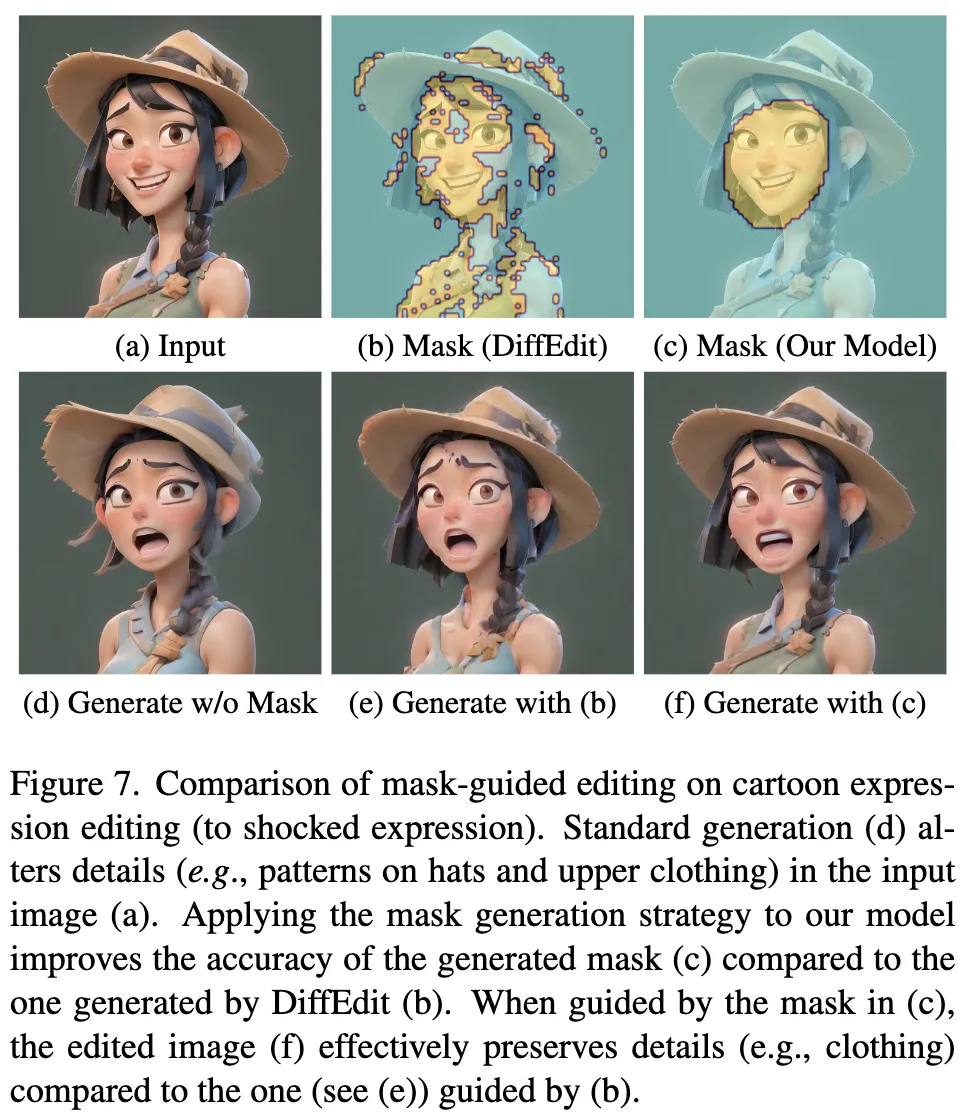

一旦得到了mask M,在每個時間步t,通過以下方式計算mask引導的預測噪聲:

實驗

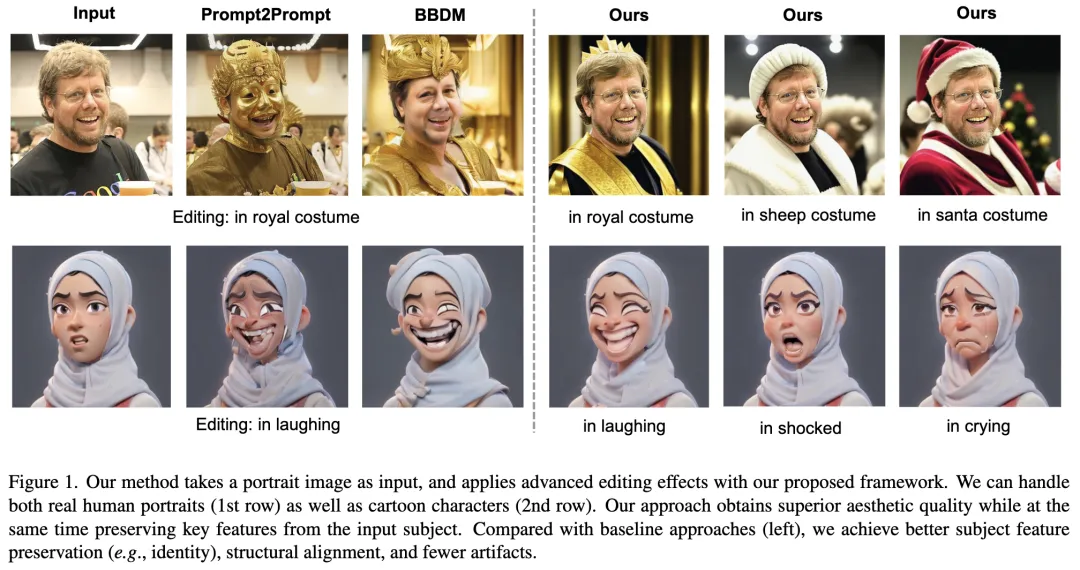

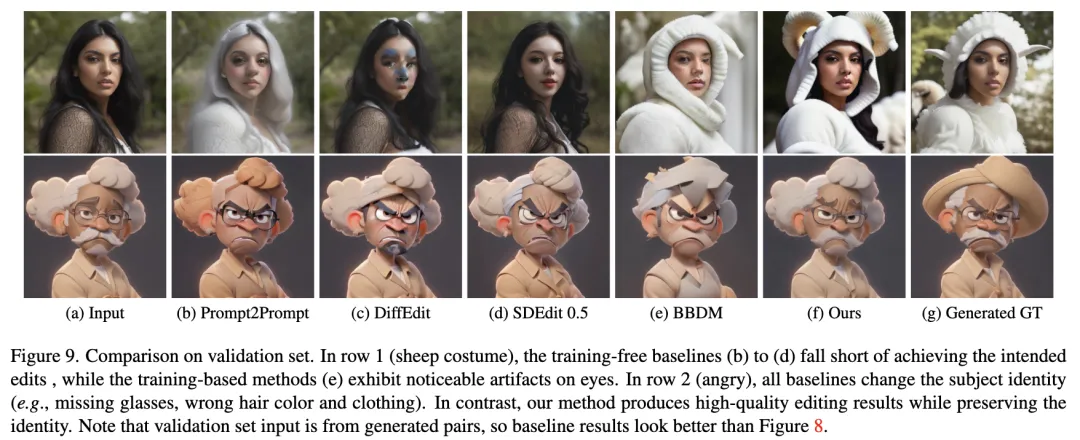

數據集: 在兩個不同的人像編輯任務中評估了本文的pipeline性能:服裝編輯和卡通表情編輯。對于每個任務,我們在特定域中定義了四個不同的編輯方向。對于服裝編輯,輸入圖像是穿著日常服裝的真實人像,輸出是同一人物穿著花朵、羊、圣誕老人或皇家服裝的圖像。對于卡通表情編輯,輸入圖像是帶有中性表情的卡通肖像,而輸出是相同的卡通角色,帶有四種不同的表情:生氣、震驚、大笑或哭泣。對于每個任務,本文生成了一個包含69,900對圖像的訓練數據集(每個編輯方向17475對圖像)。用于測試的野外圖像來自[40]。

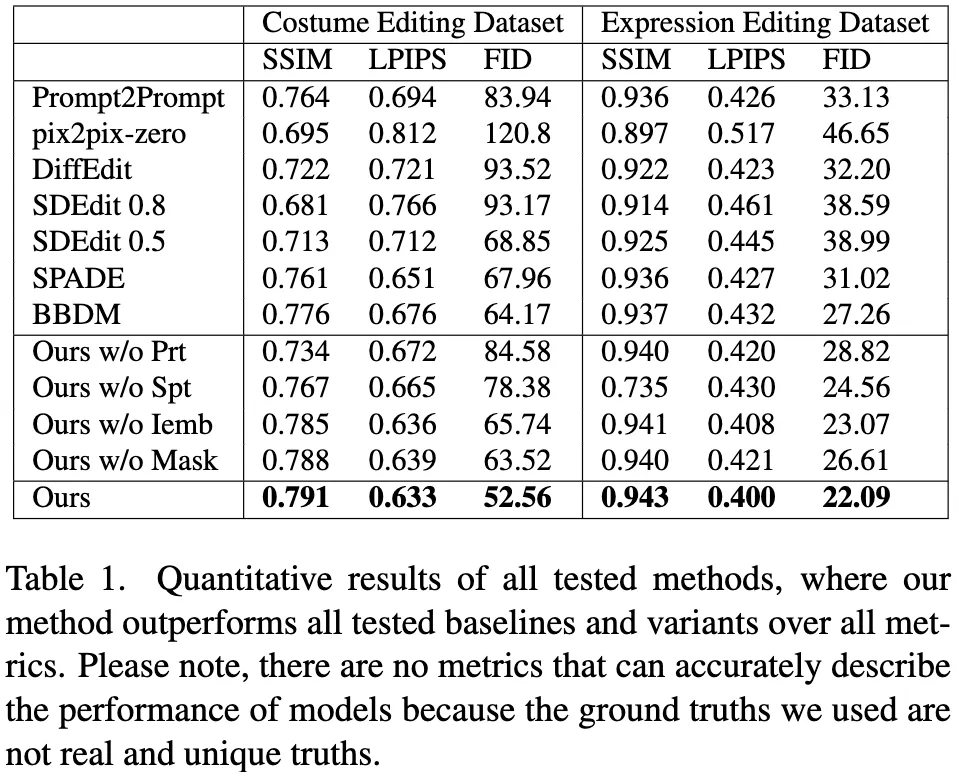

Baselines: 本文選擇了6種最新的圖像編輯baselines方法進行比較。特別是,Prompt2Prompt、pix2pix-zero、DiffEdit、SDEdit是無需訓練的擴散方法,通過文本提示引導編輯方向。由于SDEdit對強度參數敏感,本文測試了它的兩個不同參數,即SDEdit 0.5和SDEdit 0.8。較大的強度會生成遵循編輯方向但偏離輸入圖像的輸出。SPADE 和BBDM是基于生成對抗網絡和擴散模型的訓練型圖像編輯框架。

實際應用: 本文通過兩個不同場景展示了在兩個數據集上訓練的模型的實際應用。第一個應用涉及真實人像的服裝編輯,其中輸入是野外拍攝的人像圖像。如下圖8的前四行所示,無論是訓練型還是無需訓練的方法,結果都不令人滿意;前者顯示出明顯的偽影,而后者往往未能與提供的提示對齊。

第二個應用是貼紙包生成。目標是基于野外拍攝的人像圖像生成一個卡通貼紙包。為此,首先對真實輸入圖像進行數據增強,包含裁剪和單應性變換等處理。然后,使用這些增強的數據訓練DreamBooth。接著,利用訓練好的DreamBooth生成受精心設計的文本提示指導下的卡通化人像圖像。最后,本文的模型應用于卡通化圖像,以生成四種不同訓練過的表情。請注意,直接使用DreamBooth生成具有各種表情的圖像由于布局變化和過擬合問題,效果并不理想。如前面圖8的最后四行所示,無需訓練的baselines方法優于其訓練型對手。這是因為訓練型baselines方法在處理不完美的訓練配對時不夠魯棒。相比之下,本文的方法在編輯準確性和主體特征保留方面超越了所有baselines,同時保持了高圖像質量。

用戶研究: 本文在兩個實際應用場景上進行了用戶研究,每個場景有12個示例。參與者被展示了由DiffEdit、SDEdit 0.5、SPADE、BBDM和本文提出的pipeline生成的輸入和輸出圖像,順序隨機打亂。32名參與者被要求對每個輸出圖像給予1到5的評分(評分越高表示效果越好)。研究者們對每個示例和用戶的評分進行了歸一化處理,以消除用戶偏差。在服裝編輯任務中,本文的方法獲得了最高的平均評分,超過了DiffEdit 3.3倍,SDEdit 0.5 1.8倍,SPADE 2.1倍,BBDM 2.5倍。同樣,在表情編輯任務中,本文的方法也獲得了最佳評分,超越了DiffEdit 1.7倍,SDEdit 0.5 1.4倍,SPADE 2.9倍,BBDM 1.6倍。這些結果表明,本文的方法在兩個任務中均比baselines方法產生了更優的視覺效果。

局限性和未來工作: 數據集生成策略假設Stable Diffusion能夠生成源域和目標域的圖像,但這并非總是可能的。當處理大多數配對數據中存在顯著噪聲(如顯著的布局和身份差異)時,編輯性能會受到影響。未來計劃:(1)擺脫配對數據的限制,探索有效處理非配對數據的方法,(2)減少所需的訓練數據量,使pipeline更加高效和可擴展。

結論: 本文旨在實現人像編輯,如更改服裝和表情,同時保留未目標化的特征。本文引入了一種新穎的多條件擴散模型,該模型在我們提出的數據集生成策略生成的訓練配對上進行訓練。在推理過程中,模型生成一個編輯mask,并使用它進一步保留主體特征的細節。在兩個編輯任務上的結果在定量和定性上均顯示出相對于現有最先進方法的優越性。

本文轉自 AI生成未來 ,作者:Bowei Chen等