即插即用,無縫集成各種模型,港科大&螞蟻等發布Edicho:圖像編輯一致性最新成果!

文章鏈接:https://arxiv.org/pdf/2412.21079

項目鏈接:https://ezioby.github.io/edicho/

亮點直擊

- 顯式對應性引導一致性編輯:通過將顯式圖像對應性融入擴散模型的去噪過程,改進自注意力機制與分類器自由引導(CFG),在保持高質量的同時顯著提升編輯一致性。

- 融合無條件嵌入特征:受 NULL-text Inversion 技術啟發,提出融合無條件嵌入特征的方法,進一步增強一致性效果,實現更精細的編輯控制。

- 廣泛適用性與優越性能:方法具有免訓練和即插即用特性,適配多種擴散模型與任務場景。通過實驗驗證,展現出在定量指標與定性評估上的卓越性能。

總結速覽

解決的問題

跨圖像一致性編輯是計算機視覺和圖像處理領域中的重要挑戰,尤其是面對多樣的姿態、光照條件和拍攝環境時。這種一致性編輯廣泛應用于產品展示、個性化內容創作以及主題活動等場景。然而,現有方法在處理多圖像一致性時常表現出不穩定性或失真,難以滿足實際需求。

提出的方案本文提出了一種基于擴散模型的免訓練解決方案 Edicho。其核心設計理念是通過顯式圖像對應性引導編輯過程,避免傳統隱式對應性方法的局限性。包括:

- 注意力操作模塊:增強注意力機制,通過圖像之間的對應性引導特征傳遞。

- 優化的分類器自由引導(CFG)去噪策略:結合預計算的對應性,在編輯過程中保持高質量和一致性。

應用的技術

- 利用擴散模型的中間特征與生成圖像空間的對齊特性,通過顯式對應性指導編輯。

- 在注意力機制中對查詢特征進行變換,從源圖像借用相關特征,確保編輯一致性。

- 修改分類器自由引導的計算方式,融合無條件嵌入特征,提升一致性和圖像質量。

- 特別設計處理真實世界場景圖像的能力,保證方法對光照、背景、視角和遮擋變化的魯棒性。

達到的效果

- 一致性提升:實現了多圖像間的一致性編輯,編輯結果在各種場景下保持高度協調。

- 通用性:作為推理時的算法,可與大多數基于擴散的編輯方法(如 ControlNet 和 BrushNet)無縫兼容。

- 實用性:適用于個性化內容創作、3D重建以及一致性紋理應用,擴展了編輯工具的適用范圍。

- 高效性:無需訓練數據,具備即插即用特性,能夠直接應用于實際任務,代碼公開以支持進一步研究。

方法

本文專注于一致性圖像編輯任務,即同時對多張圖像進行操作以實現一致且統一的視覺效果。首先利用現有的視覺理解方法提取圖像對之間的顯式語義對應性。再借助構建于 Stable Diffusion 之上的預訓練編輯模型,通過這些預計算的顯式對應性指導去噪過程,從而確保編輯的一致性。

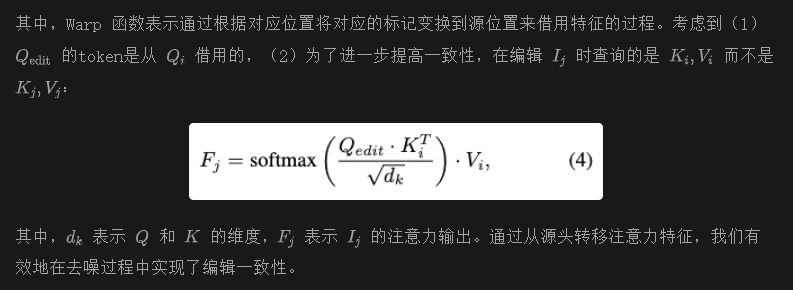

本節首先回顧擴散模型的一些基本概念,隨后討論顯式對應性指導的去噪過程,該過程包括兩個層次:注意力特征層和噪聲隱空間變量層。需要注意的是,這些特征操作僅應用于部分去噪步驟和層級,以保留預訓練模型的強生成先驗。

預備知識

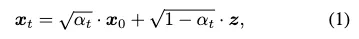

擴散模型是一類概率生成模型,通過逐步添加和去除噪聲的過程進行訓練。前向過程將噪聲添加到圖像中,具體如下:

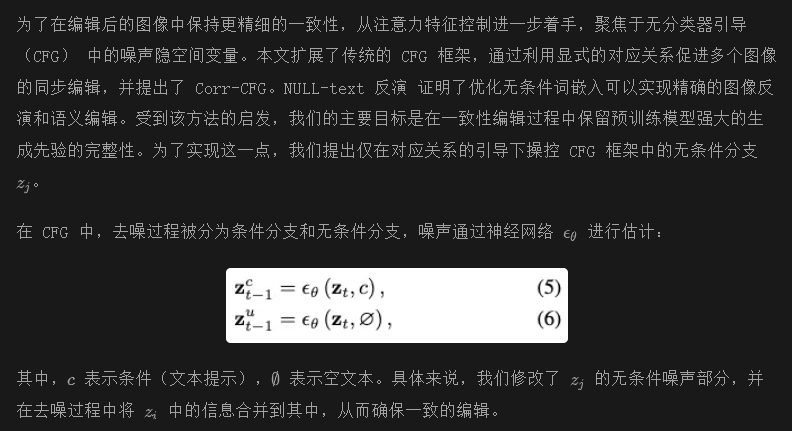

無分類器引導(CFG)

無分類器引導(CFG)是一種創新技術,旨在通過擴散模型在不依賴額外分類器的情況下提高生成圖像的質量和多樣性。具體而言,CFG 引入了一個混合系數,用于融合去噪模型生成的條件預測和無條件預測。無條件預測通常通過將條件設置為空或默認值來獲得。

編輯的參考網絡

最近的編輯方法 [25, 60] 通過在預訓練的大型擴散模型上學習一個額外的參考網絡來實現編輯,同時保持預訓練骨干網絡固定。這種網絡拓撲結構保持的設計成功地將控制信號與預訓練的生成先驗分離開。

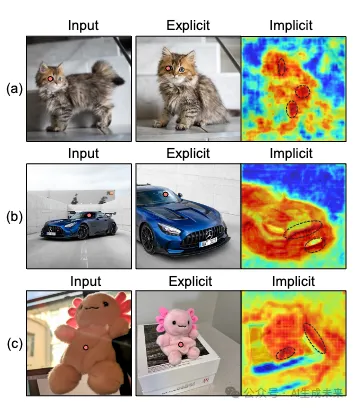

對應性比較與預測

對應性比較

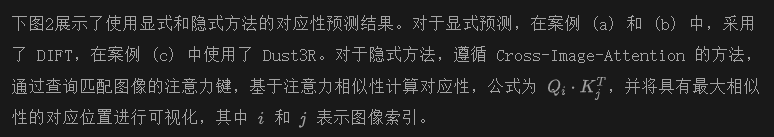

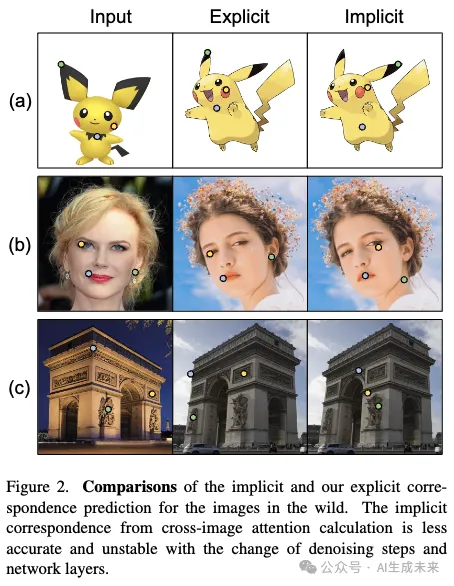

為了實現一致性編輯的目標,首先從顯式和隱式對應性之間的比較開始匹配。顯式提取器通過單次前向過程從輸入圖像中預測對應性,并將此預測應用于所有目標網絡層和去噪步驟。而隱式提取器則通過計算每一層和去噪步驟中注意力查詢與鍵的相似性來預測對應性。如同之前的無訓練編輯方法,這些對應性隨后被應用于當前層和步驟以進行編輯。

此外,對于案例 (a)、(b) 和 (c),選擇了不同的網絡層和去噪步驟 (1, 10)、(2, 15)、(4, 25) 進行提取,以實現更全面的探索,其中(x,y)表示擴散模型的解碼器層編號和去噪步驟編號。上面圖 2 中的可視化結果表明,通過顯式預測獲得的對應性明顯比隱式方法更準確。而且,隱式方法的預測結果隨著網絡層和去噪步驟的變化往往變得不穩定。這些結果與之前的研究 [50, 59] 一致,表明只有生成模型的特定層或步驟適合有效的視覺理解,例如點匹配。

不準確的對應性匹配會在執行跨圖像注意力時引入不準確的特征,這阻礙了僅基于隱式注意力的編輯方法的編輯一致性。這進一步強化了本文引入更穩健的顯式對應性來指導去噪過程的動機。

對應性預測

使用對應性的注意力操作

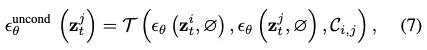

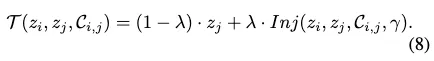

無分類器引導與對應關系

其中, T表示融合函數,用于對齊無條件噪聲, t表示時間步長。

實驗

實驗設置

設置:使用Stable Diffusion 作為基礎模型,并采用BrushNet 和ControlNet 作為編輯的參考網絡。采用DDIM調度器,并進行50步的去噪。默認情況下,提出的基于對應關系的去噪策略應用于第4步到第40步,并從第8個注意力層開始應用,以確保一致性并保持強大的生成先驗。需要注意的是,在使用不同基礎模型時,這些選擇的最優設置可能有所不同。測試樣本部分來自互聯網,其他樣本來自DreamBooth和Custom Diffusion的數據集。

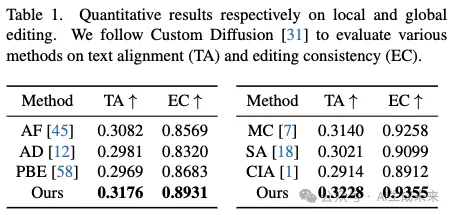

評估指標:遵循Custom Diffusion的方法,采用流行的多模態模型CLIP來評估各種方法在文本對齊(TA)和編輯一致性(EC)方面的表現。具體來說,一方面,通過計算目標提示和模型輸出的特征相似度來判斷文本對齊;另一方面,通過計算編輯圖像的特征相似度來評估編輯一致性。此外,還納入了用戶研究(US)來進一步評估實際應用性和用戶滿意度。

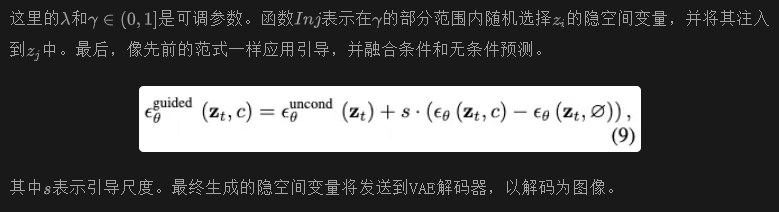

基準:包含了局部和全局編輯任務,并且與眾多先前的圖像編輯方法進行了全面對比。具體來說,對于局部編輯任務,包括了Adobe Firefly 、Anydoor和Paint-by-Example等先前的工作進行比較。

在上述方法中,Firefly是Adobe開發的最先進的商業圖像修復工具,可以根據給定的文本提示重新繪制輸入圖像的局部區域。為了實現一致的編輯任務,該組圖像將根據相同的詳細提示進行修復。Anydoor和Paint-by-example都是支持根據給定參考圖像重新繪制目標區域的隱空間變量擴散模型(LDM)。因此,我們將修復后的圖像發送給這些模型作為參考,期望得到一致的編輯結果。

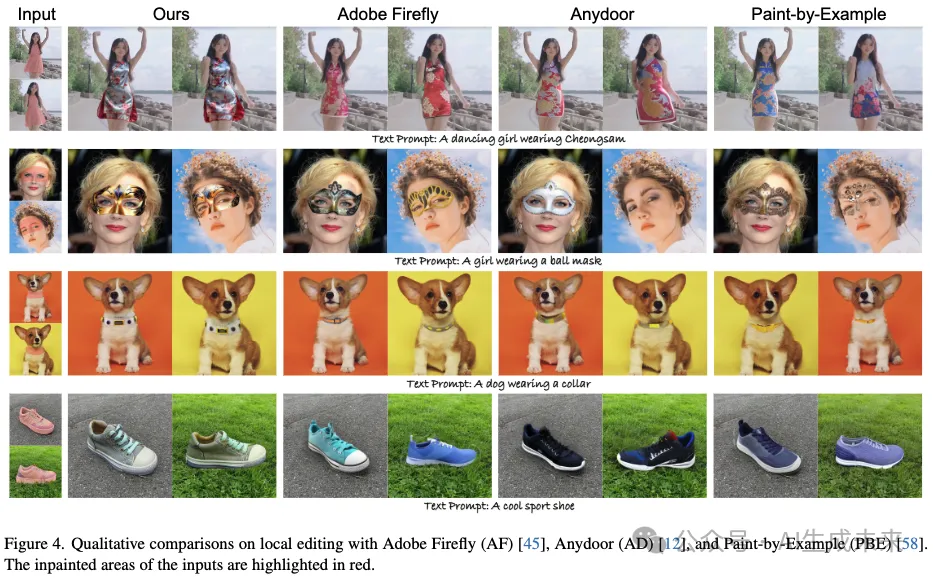

對于全局編輯,將本文的方案與MasaCtrl、StyleAlign和Cross-image attention進行比較。上述方法通過操作和融合來自不同源的注意力特征來實現編輯。與本文的方法不同,它們通過計算注意力權重中的隱式對應關系來確保編輯結果的一致性。

評估

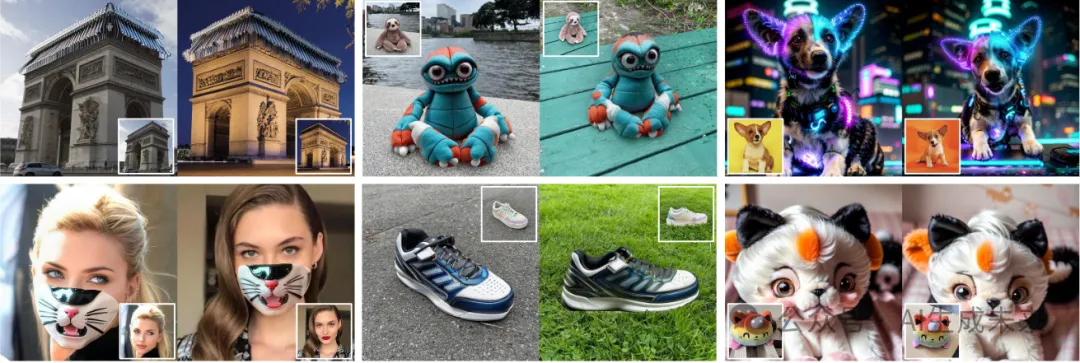

定性結果:本文展示了對一致性編輯方法的定性評估,重點關注局部編輯(圖像修復)和全局編輯(圖像轉換)。在下圖4中的局部編輯比較中,本文的方法、Adobe Firefly (AF)、Anydoor (AD)和Paint-by-Example (PBE)的結果進行了展示。結果表明,本文的方法通過引入顯式的對應關系,始終保持了輸入圖像在不同修改下的完整性,包括衣物紋理、面罩和領口外觀,甚至鞋子的孔眼數量。

全局編輯的基準主要包括僅由隱式注意力預測的方案——MasaCtrl (MC)、StyleAligned (SA)和Cross-Image-Attention (CIA)。如下圖5所示,本文的方法也在編輯過程中取得了更好的一致性和主題一致性,如貓的裙子。與之相比,隱式方法(如MasaCtrl)在汽車車頂、精靈的高領以及機器人的孔洞數量方面未能實現一致的編輯。

定量結果:對本文提出的方法進行了全面的定量評估,重點關注文本對齊(TA)和編輯一致性(EC)指標。正如下表1所示,在局部編輯任務中,本文的方法在TA和EC得分上均取得了最佳成績,展示了相較于其他方法的顯著改進。在全局編輯任務中,本文的方法繼續超越其他對比方法,達到了0.3228的TA得分和0.9355的EC得分。這些結果清楚地證明了本文的方法在實現局部和全局編輯場景中的高文本對齊和編輯一致性方面的有效性。

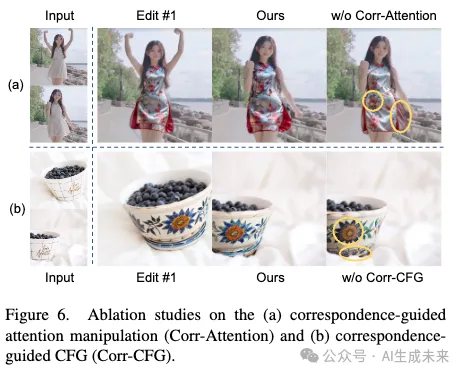

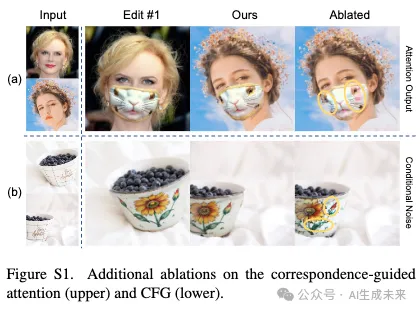

消融實驗

為了驗證所提出的基于對應關系的注意力操作(Corr-Attention)和基于對應關系的CFG(Corr-CFG)的有效性,我們通過分別禁用其中一個方法,并在一致性編輯任務上進行測試來進行消融實驗。當禁用所提出的基于對應關系的注意力操作(Corr-Attention)時,擴散模型依賴于隱式注意力對應關系來保持一致性,類似于之前的方法[1,7]。如下圖6(a)所示,生成模型會產生錯誤數量的花朵,并且位置不當。花朵的數量和紋理的不一致證明了引入顯式對應關系到注意力操作中的有效性。

基于對應關系的CFG(Corr-CFG)旨在通過在LDM的潛空間中進行更精細的一致性控制,這一點在圖6(b)中得到了驗證,Corr-CFG生成了更一致的花朵紋理和碗底的條紋。

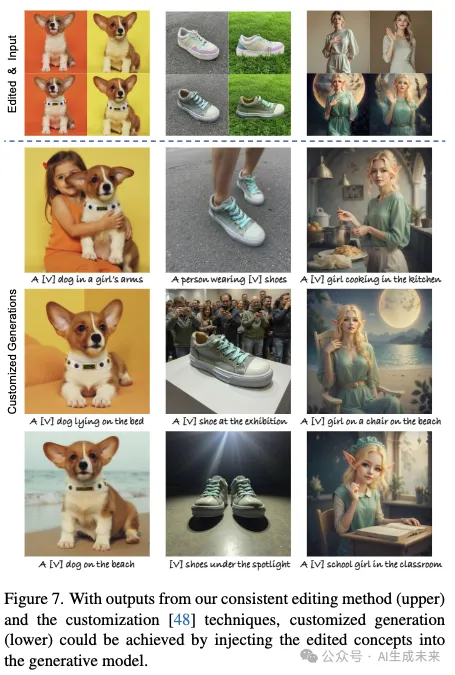

額外的應用和結果

基于一致性編輯的定制化:為了進一步展示所提方法的實際應用,我們展示了一個集成DreamBooth和低秩適應(LoRA)技術的定制化圖像生成應用示例。利用我們方法生成的編輯輸出,我們采用DreamBooth對生成模型進行500步的微調,以進行概念注入。同時,我們還整合了LoRA技術,通過引入低秩矩陣作為適應參數,進一步提高了這一過程的效率。如下圖7所示,微調后的生成模型能夠生成與編輯對應的理想圖像。因此,新的概念生成和概念編輯可以通過這種方式實現,成為一致性編輯的應用示例。

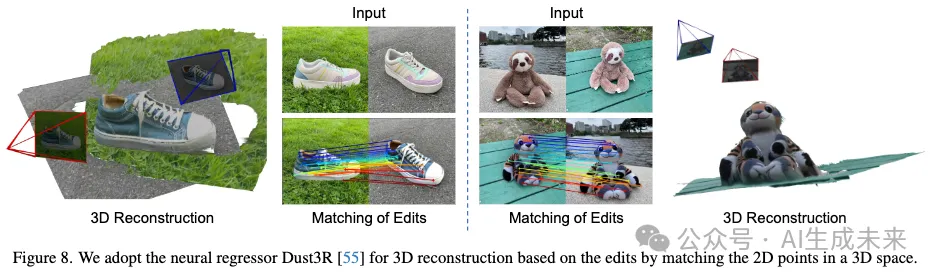

基于一致性編輯的3D重建:一致性編輯還能夠促進編輯內容的3D重建。我們通過神經回歸器實現了3D重建,該回歸器能夠根據一致的圖像對預測準確的3D場景表示。以編輯后的圖像為輸入,學習到的神經回歸器能夠預測3D點云模型和2D匹配點,而不需要其他輸入,如相機參數。重建和匹配結果如下圖8所示,結果也進一步表明了我們方法的編輯一致性。該回歸器分別為兩組編輯獲取了11,515對和13,800對匹配點,且僅展示了其中的一部分以便清晰理解。

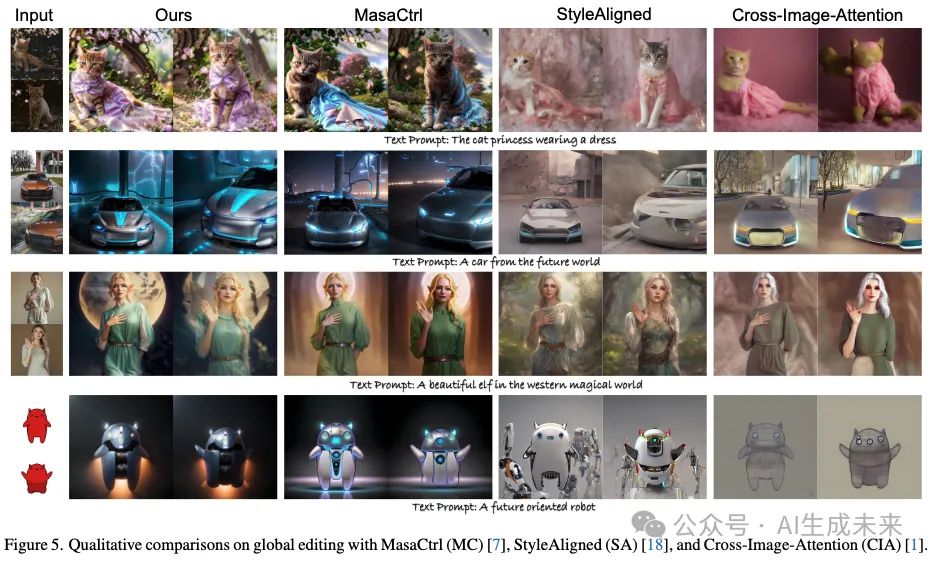

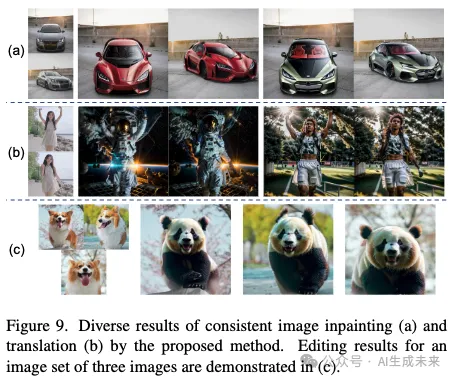

額外結果:我們提供了通過所提方法實現的多圖像修復和轉換的多樣結果,如下圖9(a)和(b)所示。圖9(c)展示了包含三張圖像的圖像集的編輯結果。

結論

本文提出了Edicho,一種新穎的免訓練的方法,通過利用不同圖像之間的顯式對應關系,實現一致性的圖像編輯。本文的方法通過將對應關系信息整合到去噪過程中,增強了自注意力機制和無分類器引導計算,從而確保了編輯的一致性。方法的即插即用特性使其能夠無縫集成到各種模型中,且適用于廣泛的任務。

在局限性方面,有時由于對應關系的錯位,生成的紋理可能不一致,預計隨著更好的對應關系提取器的出現,這一問題能夠得到改進。并且,由于繼承了預訓練的編輯模型,偶爾會生成失真紋理。

本文轉自AI生成未來 ,作者:AI生成未來