LLM-ESR@NeurIPS 2024: 大語言模型破解推薦系統的長尾難題

在現實世界的推薦系統中,大多數用戶只與少數項目互動,而大多數項目很少被消費,這導致了所謂的長尾挑戰。為了解決這一問題,研究者們提出了一種新框架LLM-ESR,它利用大型語言模型的強大語義理解能力來增強推薦系統的性能,專門優化那些互動較少的用戶和項目的效果。

序列推薦系統(SRS)旨在基于用戶的歷史互動預測用戶隨后的選擇,并在電子商務和社交媒體等多個領域得到應用。然而,在現實世界的系統中,大多數用戶只與少數項目互動,而大多數項目很少被消費。這兩個問題被稱為長尾用戶和長尾項目挑戰,常常給現有的SRS帶來困難。這些挑戰可能會對用戶體驗和賣家利益產生不利影響,因此解決它們至關重要。盡管一些工作已經解決了這些挑戰,但它們仍然因為互動的內在稀缺性而受到蹺蹺板效應或噪聲問題的困擾。大型語言模型(LLMs)的進步為從語義角度解決這些問題提供了有希望的解決方案。作為該領域的先驅之一,我們提出了序列推薦的大型語言模型增強框架(LLM-ESR)。該框架利用從LLMs派生的語義嵌入來增強SRS,而不會增加LLMs的額外推理負擔。為了解決長尾項目挑戰,我們設計了一個雙視圖建模框架,結合了LLMs的語義和傳統SRS的合作信號。對于長尾用戶挑戰,我們提出了一種檢索增強的自蒸餾方法,利用來自相似用戶的更有信息量的互動來增強用戶偏好表示。為了驗證我們提出的增強框架的有效性和通用性,我們在三個真實世界的數據集上進行了廣泛的實驗,使用了三種流行的SRS模型。結果表明,我們的方法始終超過現有的基線,并特別有利于長尾用戶和項目。

1 引言

序列推薦的目標是基于用戶的歷史記錄預測用戶下一個可能的項目[7, 53]。由于序列推薦的本質是從未用戶互動記錄中提取用戶偏好,近年來提出了幾種創新架構。例如,SASRec[18]應用自注意力技術捕捉用戶的長期偏好,而FMLPRec[24]引入了一個純MLP架構來識別用戶偏好的動態變化。

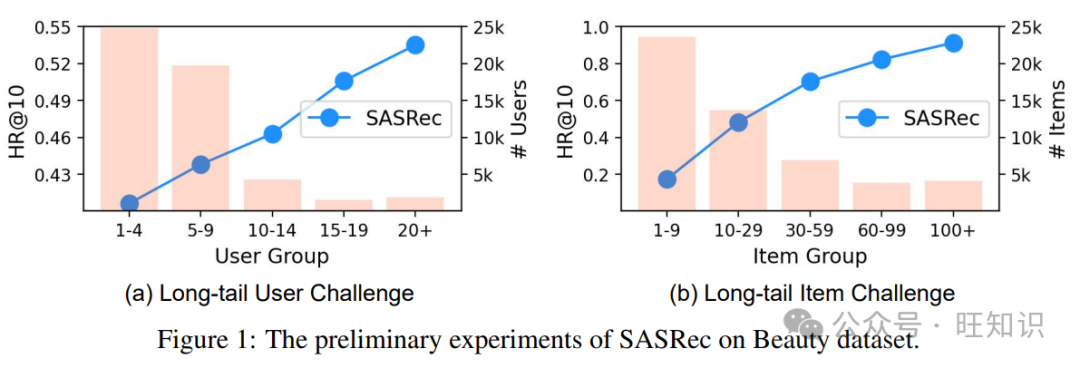

盡管在序列推薦方面取得了顯著進展,但長尾挑戰繼續削弱其實際應用價值。一般來說,這些挑戰可以分為影響用戶或項目方面的兩種類型。為了說明,我們在圖1中展示了在亞馬遜美容數據集上的知名SRS模型SASRec[18]的性能,以及其統計數據。

- i) 長尾用戶挑戰:在圖1(a)中,我們注意到超過80%的用戶與少于10個項目互動(即長尾用戶),與那些有更多互動記錄的用戶相比,SASRec的性能較差。這表明大多數用戶獲得的推薦服務不如預期。

- ii) 長尾項目挑戰:圖1(b)表明SASRec在更受歡迎的項目上表現更好。然而,直方圖表明,大約71.4%的項目擁有不超過30個互動記錄,意味著它們較少被消費。解決這些長尾挑戰對于提升用戶體驗和賣家利益至關重要。

為了解決長尾項目挑戰,現有研究[17, 20]檢查了流行項目和長尾項目之間的共現模式,旨在用流行項目的表示來豐富長尾項目的表示。然而,忽視項目之間真實關系可能會導致蹺蹺板問題[35]。至于長尾用戶挑戰,現有研究[36, 34]探索了所有用戶之間的互動歷史,試圖為尾部用戶增加偽項目。然而,這些方法仍然只依賴于合作信息,傾向于生成由于用戶之間不準確的相似性而導致的噪聲項目[34]。此時,用戶或項目之間的出色語義關系可以發揮作用,這表明了利用語義來面對長尾挑戰的潛力。

大型語言模型(LLMs)的最新進展為從語義角度減輕長尾挑戰提供了希望。然而,LLMs最初是為自然語言處理任務而不是推薦任務設計的。一些作品[62, 42]已經做出了努力以適應,但仍然存在兩個問題。i) 效率低下的整合:最近的研究探索了派生信息性提示以激活ChatGPT[54, 10]或修改LLaMA[25, 27, 58]的標記化方法以進行序列推薦。盡管它們表現出色,但這些方法在工業環境中難以應用。這是因為推薦系統通常需要低延遲以進行在線部署,而LLMs往往涉及高推理成本[11]。ii) 語義信息的缺陷:幾項最近的工作[13, 16]提出利用LLMs派生的嵌入來初始化序列推薦模型的項目嵌入層,從而整合語義信息。然而,如果微調過程中沒有凍結嵌入層,可能會侵蝕項目之間的原始語義關系。此外,這些方法只關注項目方面,忽視了在用戶方面整合語義信息的潛在好處,這可能有助于SRS的序列編碼器。

在本文中,為了更好地將LLMs整合到SRS中以解決長尾挑戰,我們設計了一個大型語言模型增強框架,用于序列推薦(LLM-ESR)。首先,我們通過編碼LLMs的提示文本來派生項目和用戶的語義嵌入。由于這些嵌入可以提前緩存,我們的整合不會增加LLMs的任何額外推理負擔。為了解決長尾項目挑戰,我們設計了一個雙視圖建模框架,結合了語義和合作信息。具體來說,為了避免語義的缺陷,凍結了從LLMs派生的嵌入。接下來,我們提出了一種檢索增強的自蒸餾方法,使用相似用戶來增強SRS模型的序列編碼器。用戶之間的相似性是通過LLMs的用戶表示來測量的。最后,重要的是要注意,所提出的框架是模型不可知的,允許它適應任何序列推薦模型。本文的貢獻如下:

- 我們提出了一個大型語言模型增強框架,可以通過引入LLMs的語義信息來緩解SRS的長尾用戶和項目挑戰。

- 為了避免LLMs的推理負擔,我們設計了一個基于嵌入的增強方法。此外,派生的嵌入被直接使用,以保留原始的語義關系。

- 我們在三個真實世界的數據集上進行了廣泛的實驗,使用了三種背景SRS模型,以驗證LLM-ESR的有效性和靈活性。

2 問題定義

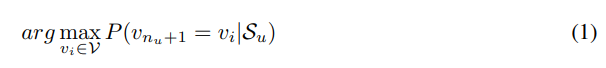

序列推薦的目標是基于用戶的互動記錄給出用戶可能互動的下一個項目。用戶集和項目集分別表示為U = {u1, ..., ui, ..., u|U|}和V = {v1, ..., vi, ..., v|V|},其中|U|和|V|是用戶和項目的數量。每個用戶都有一個互動序列,按時間線排列互動的項目,表示為Su = {v(u)1, ..., v(u)i, ..., v(u)nu}。nu表示用戶u的互動數量。為簡便起見,我們在以下部分省略了上標(u)。然后,序列推薦問題可以定義如下:

遵循與長尾SRS相關的現有工作[17, 20],我們可以將用戶和項目分為尾部和頭部組。設nu和pv分別表示用戶互動序列的長度和項目v的流行度(即總互動數)。首先,我們按nu和pv的值降序排序用戶和項目。然后,根據帕累托原則[4],取出前20%的用戶和項目作為頭部用戶和頭部項目,表示為Uhead和Vhead。其余的用戶和項目是尾部用戶和尾部項目,即Utail = U \ Uhead和Vtail = V \ Vhead。為了緩解長尾挑戰,我們的目標是提高對Utail和Vtail的推薦性能。

3 LLM-ESR

3.1 概述

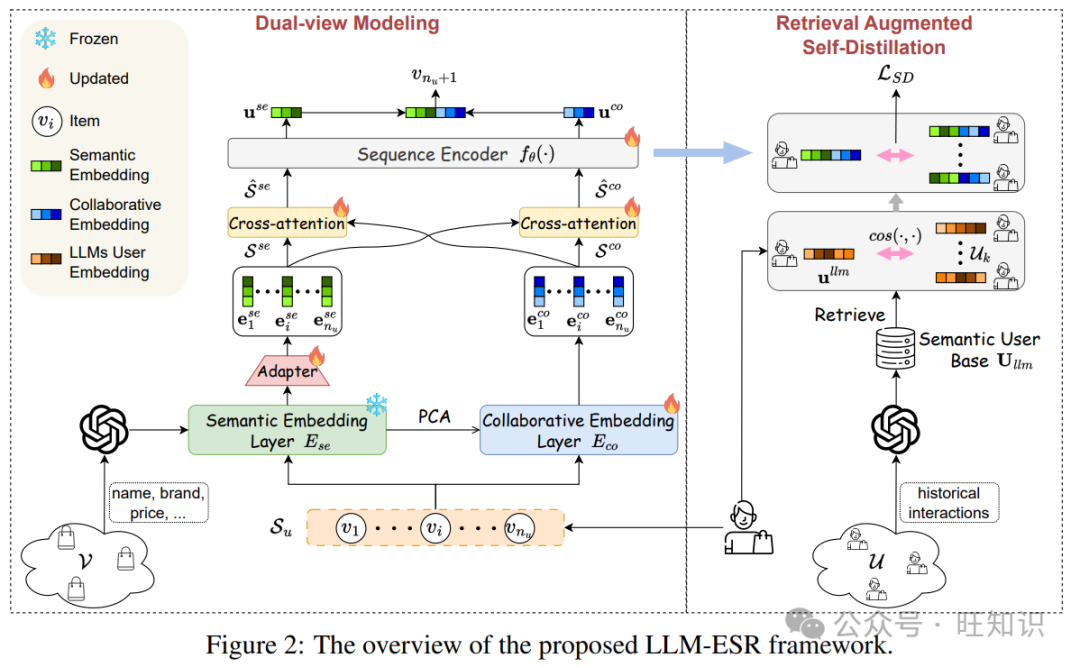

我們提出的LLM-ESR的概述如圖2所示。為了獲得語義信息,我們采用LLMs對用戶的文本歷史互動和項目的屬性進行編碼,得到LLMs用戶嵌入和LLMs項目嵌入。然后,提出了兩個模塊分別增強長尾項目和長尾用戶,即雙視圖建模和檢索增強的自蒸餾。i) 雙視圖建模:該模塊由兩個分支組成。一個分支是語義視圖建模,旨在從用戶的互動序列中提取語義信息。它首先使用從LLMs項目嵌入派生的語義嵌入層對項目進行編碼。然后,設計了一個適配器用于維度適配和空間轉換。輸出的項目嵌入序列將被送入交叉注意力進行融合,然后通過序列編碼器得到用戶在語義視圖中的表示。另一個分支是合作視圖建模,它通過合作嵌入層將互動序列轉換為嵌入序列。接下來,通過交叉注意力和序列編碼器,獲得合作用戶偏好。在該模塊的最后,將兩個視圖中的用戶表示融合以進行最終推薦。ii) 檢索增強的自蒸餾:該模塊希望通過相似用戶的有信息量的互動來增強長尾用戶。首先,將派生的LLMs用戶嵌入視為語義用戶基礎,用于檢索相似用戶。然后,將相似用戶送入雙視圖建模以獲得他們的用戶表示,這些表示是自蒸餾的引導信號。最后,派生的蒸餾損失將用作訓練的輔助損失。

3.2 雙視圖建模

傳統的SRS模型擅長捕捉合作信號,可以很好地推薦流行項目[20, 17]。然而,由于缺乏語義,它們在長尾項目上妥協[2]。因此,我們從雙重視圖對用戶的偏好進行建模,以同時覆蓋所有項目。此外,我們提出了兩級融合,以更好地結合這兩個視圖的好處。

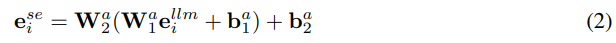

語義視圖建模。一般來說,項目的屬性和描述包含豐富的語義。為了利用LLMs的強大語義理解能力,我們將屬性和描述組織成文本提示(提示模板可以在附錄A.1中找到)。然后,為了避免LLMs可能帶來的推理負擔,我們緩存了LLMs的嵌入以供使用。具體來說,可以通過取出開源LLMs(如LLaMA[50])的最后一個隱藏狀態或公共API(如text-embedding-ada-0022)的嵌入來獲得嵌入。本文采用了后者。設Ese ∈ R|V|×dllm表示所有項目的LLMs嵌入,其中dllm是LLMs嵌入的維度。然后,可以從LLMs派生的語義嵌入層Ese用于語義視圖建模,以增強長尾項目。然而,以前的工作[13, 16]通常將其作為項目嵌入層的初始化,這可能會在微調期間破壞原始的語義關系。為了保留語義,我們凍結了Ese,并提出了一個適配器,將原始的語義空間轉換為推薦空間。對于每個項目i,我們可以通過取出Ese的第i行得到其LLMs嵌入ellm_i。然后,它將被送入可調的適配器以獲得語義嵌入:

其中Wa1 ∈ R^{dllm×dllm/2}, Wa2 ∈ R^{d×dllm/2} 和 ba1 ∈ R^{dllm/2×1}, ba2 ∈ R^{d×1} 是適配器的權重矩陣和偏置。通過這個過程,我們可以得到用戶互動記錄的項目嵌入序列,表示為Sse = [ese_1, ..., ese_nu]。類似于一般的SRS模型,我們采用序列編碼器fθ(例如,用于SASRec[18]的自注意力層)來獲得用戶在語義視圖中的偏好表示,如下所示:

其中use ∈ R^{d×1} 是用戶在語義視圖中的偏好表示,θ表示SRS模型中序列編碼器的參數。

合作視圖建模。為了利用合作信息,我們采用可訓練的項目嵌入層,并通過互動數據對其進行監督更新。設Eco ∈ R^|V|×d 表示項目的合作嵌入層。然后,通過從Eco中提取相應的行,獲得項目嵌入序列Sco = [eco_1, ..., eco_nu]。為了獲得用戶在合作視圖中的偏好uco,我們將嵌入序列輸入到序列編碼器,即,uco = fθ(Sco)。值得注意的是,序列編碼器fθ在語義和合作視圖中是相同的,用于共享的序列模式和更高的效率[45]。此外,兩個視圖中的嵌入層處于不平衡的訓練階段(一個預先訓練,另一個從頭開始),這可能導致優化困難[1]。為了解決這個問題,我們通過降維的Ese初始化Eco。本文使用主成分分析(PCA)[43]作為降維方法。

兩級融合。有效整合語義視圖和合作視圖對于吸收這兩個視圖的好處至關重要。然而,直接合并雙視圖中的用戶表示可能會忽略項目序列之間的細微相互關系。因此,我們為雙視圖建模模塊設計了一個兩級融合方法,即序列級和對數級。前者旨在隱式捕獲雙視圖中項目序列之間的相互關系,而后者明確針對推薦能力的組合。具體來說,我們提出了一個交叉注意力機制用于序列級融合。為了簡化描述,我們只取語義視圖與合作視圖的交互為例,另一個視圖也是如此。具體來說,Sse被視為查詢,Sco作為注意力機制中的鍵和值。設Q = SseWQ, K = ScoWK, V = ScoWV,其中WQ, WK, WV ∈ R^d×d 是權重矩陣。然后,交互的合作嵌入序列可以表示如下:

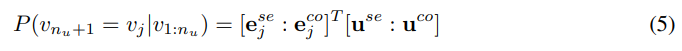

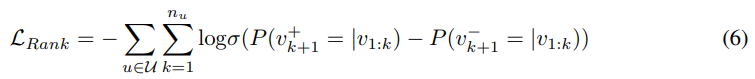

按照交叉注意力的相同過程,我們也可以得到相應的語義嵌入序列?Sse。最后,Sse, Sco被?Sse, ?Sse替換,送入fθ(·)。至于對數級融合,我們將雙視圖的用戶和項目嵌入進行拼接以進行推薦。因此,為用戶u推薦項目j的概率分數計算如下:

其中“:”表示兩個向量的拼接操作。基于概率分數,我們采用成對排名損失來訓練框架:

其中v+k+1 和 v?k+1 是真實項目和配對的負項目。值得注意的是,排名損失可能會根據不同的SRS模型略有不同,例如GRU4Rec[14]的序列到一成對損失。

3.3 檢索增強的自蒸餾

長尾用戶問題源于SRS中序列編碼器捕獲用戶偏好的互動不足。因此,我們提出了一種自蒸餾方法來增強序列編碼器的提取能力。自蒸餾[12, 60]是一種知識蒸餾類型,它將一個模型視為學生和教師,用于模型增強。對于SRS,由于多個相似用戶擁有更有信息量的互動,將它們的知識轉移到目標用戶上是有希望的。因此,這種知識轉移有兩個關鍵挑戰,即如何檢索相似用戶以及如何轉移知識。

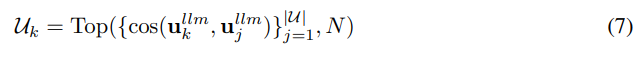

檢索相似用戶。以前的工作已經證實LLMs可以理解文本用戶互動記錄的語義含義,用于推薦[25, 10]。基于他們的觀察,我們將用戶互動的項目標題組織成文本提示(提示模板可以在附錄A.1中找到)。然后,類似于LLMs項目嵌入Ese的派生,我們可以獲得并保存LLMs用戶嵌入,表示為Ullm ∈ R^{|U|×dllm}。它也被稱為本文中的語義用戶基礎,因為語義關系已編碼在其中。對于每個目標用戶k,我們可以檢索相似用戶集Uk如下:

其中cos(·, ·)是余弦相似性函數,用于測量兩個向量之間的距離。N表示相似用戶集的大小,這是一個超參數。

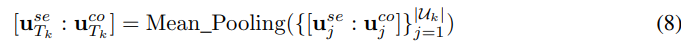

自蒸餾。如前所述,我們設計了自蒸餾,將幾個相似用戶的知識轉移到目標用戶。由于用戶偏好表示,即use和uco,編碼了用戶的綜合知識,我們將這種表示配置為蒸餾的中介。為了獲得教師中介,我們首先利用雙視圖建模框架(第3.2節)為每個相似用戶獲得用戶表示,表示為{use_j, uco_j}^|Uk|_j=1。然后,教師中介通過平均池化計算,如下公式:

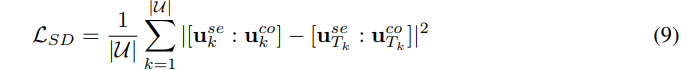

學生中介是目標用戶k的表示,即[use_k : uco_k]。基于教師和學生中介,自蒸餾損失可以表示如下:

請注意,use_Tk和uco_Tk的梯度被停止,因為它們只提供引導信號而不是優化模型。

3.4 訓練和推理

訓練。基于第3.2節和第3.3節的說明,我們在訓練期間只更新合作嵌入層、適配器、交叉注意力和序列編碼器,同時凍結語義嵌入層和語義用戶基礎。由于原始LLMs嵌入Ese和Ullm被凍結,原始的語義關系得到了很好的保留。優化的訓練損失是成對排名損失和自蒸餾損失的組合,可以寫成如下:

其中α是調整自蒸餾幅度的超參數。

推理。在LLM-ESR的推理過程中,免除了檢索增強的自蒸餾模塊,因為不需要輔助損失。因此,我們遵循雙視圖建模過程,通過方程(5)進行最終推薦。此外,由于語義嵌入層可以提前緩存,避免了對LLMs的調用,從而防止了額外的推理成本。由于空間有限,算法位于附錄A.2中,以更清晰。

4 實驗

4.1 實驗設置

數據集。我們應用了三個真實世界的數據集進行評估,即Yelp、亞馬遜時尚和亞馬遜美容。我們遵循以前的SRS工作[18, 49]進行預處理和數據分割。更多關于數據集和預處理的詳細信息可以在附錄B.1中看到。

基線。為了驗證靈活性,我們將競爭基線和LLM-ESR與三種知名的SRS模型結合:GRU4Rec[14]、Bert4Rec[48]和SASRec[18]。然后,在實驗中比較了兩組基線。一組是傳統的長尾序列推薦增強框架,包括CITIES[17]和MELT[20]。另一組是基于LLM的增強框架,包括RLMRec[44]和LLMInit[13, 16]。更多關于基線的詳細信息已放入附錄B.2。

實現細節。所有實驗中使用的硬件是帶有Tesla V100 32G GPU的Intel Xeon Gold 6133平臺,而基本軟件要求是Python 3.9.5和PyTorch 1.12.0。超參數N和α從{2, 6, 10, 14, 18}和{1, 0.5, 0.1, 0.05, 0.01}中搜索。更多關于實現細節的詳細信息在附錄B.3中。實現代碼可在https://github.com/Applied-Machine-Learning-Lab/LLM-ESR獲得。

評估指標。在實驗中,我們采用了Top-10列表進行評估。具體來說,采用了命中率(H@10)和歸一化折扣累積增益(N@10)。按照[18],我們隨機抽取了100個用戶未互動的項目作為負樣本配對以計算指標。為了保證實驗結果的魯棒性,我們報告了三次測試的平均結果,隨機種子為{42, 43, 44}。

4.2 總體性能

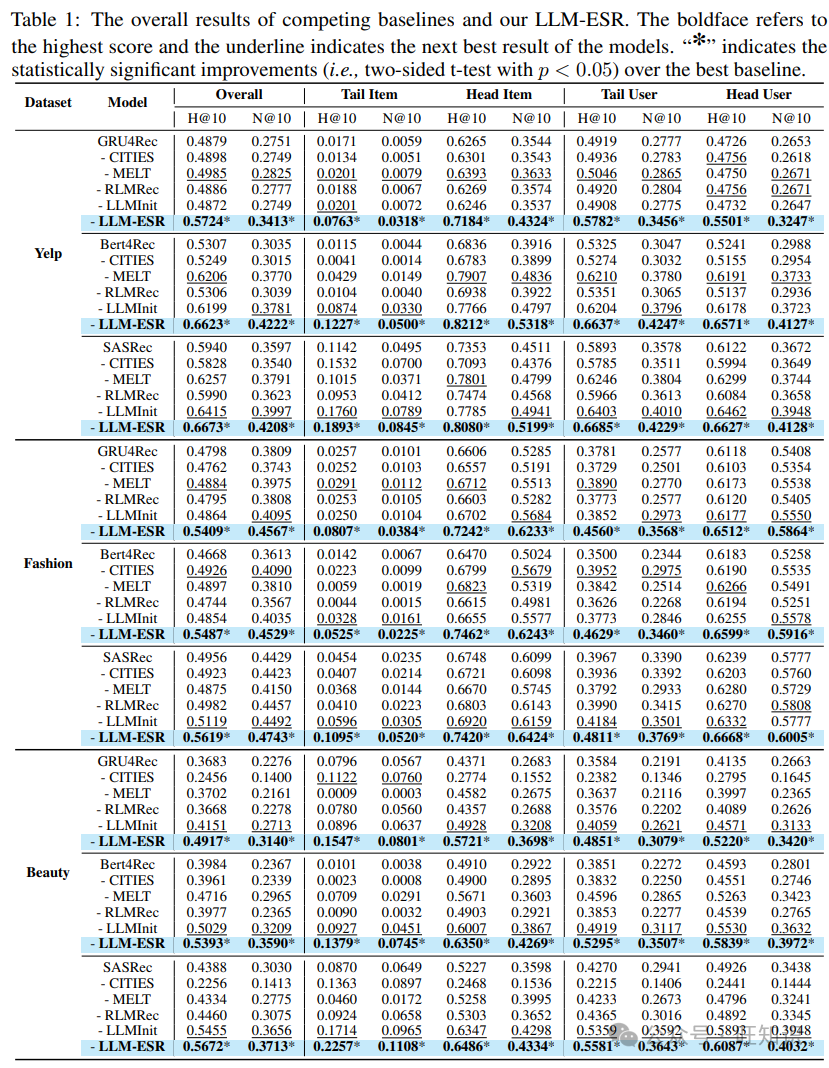

為了驗證所提出的LLM-ESR的有效性和靈活性,我們在表1中展示了三個數據集上的總體、尾部和頭部性能。一目了然,我們發現所提出的LLM-ESR在所有SRS模型下都能超越所有競爭基線,驗證了我們框架的有用性。然后,我們通過以下分析得出更多結論。

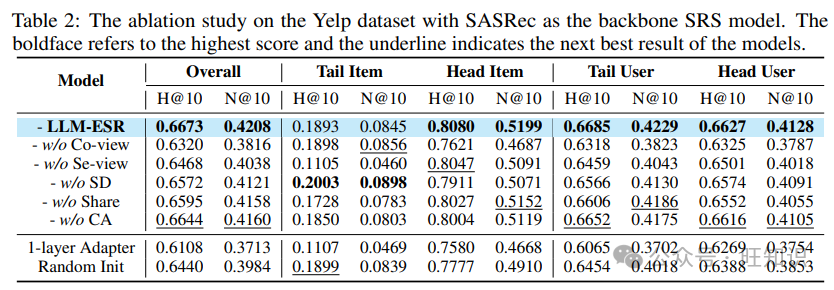

表2:在Yelp數據集上以SASRec為背景SRS模型的消融研究。粗體表示最高分數,下劃線表示模型的次優結果。

總體比較。從結果中,我們觀察到所提出的LLM-ESR在兩個指標下都領先于總體性能,這表明了更好的增強效果。LLMInit通常是次優的。這一現象表明,從LLMs注入的語義實際上增強了SRS。然而,與其它基于LLM的方法相比,RLMRec通常表現不佳,因為它是為了協同過濾算法而設計的,與SRS不兼容。至于傳統基線,MELT在大多數情況下都處于領先地位。原因在于它同時解決了長尾用戶和長尾項目挑戰。相比之下,CITIES有時甚至不如背景SRS模型,因為蹺蹺板問題,即流行項目的急劇下降。

長尾項目和用戶比較。根據第2節中說明的分割方法,項目被分為尾部項目和頭部項目。從表1中,我們觀察到我們的LLM-ESR不僅在尾部項目組上取得了最佳成績,而且在頭部項目組上也獲得了第一名。這種性能比較突出了我們通過雙視圖建模結合語義和合作信號的組合。LLMInit在所有基線中領先于尾部組,這表明語義信息可以惠及長尾項目。值得注意的是,CITIES有時在尾部組表現更好,但對流行項目有害,這意味著它存在蹺蹺板問題。此外,結果表明MELT、LLMInit和LLM-ESR可以顯著增強尾部用戶組。MELT旨在增強尾部用戶,但由于其合作視角的局限性,不如我們的方法。盡管LLMInit也可以通過引入語義來惠及尾部用戶,但它忽略了從用戶端利用LLMs的潛力。

靈活性。表1顯示,所提出的框架可以在所有三種背景SRS模型上獲得最大的性能提升,這表明了LLM-ESR的靈活性。相比之下,其他基線傾向于依賴SRS的類型。傳統方法,即CITIES和MELT,傾向于對GRU4Rec表現更好,而LLMInit對Bert4Rec和SASRec更有益。

4.3 消融研究

消融研究的結果如表2所示。首先,我們移除合作視圖或語義視圖以研究雙視圖建模,表示為無合作視圖和無語義視圖。結果表明,無合作視圖顯著降低了頭部組的性能,而無語義視圖對尾部項目的性能損害明顯。這些變化表明合作和語義信息的明顯特點,突出了兩者的結合。無自蒸餾意味著放棄自蒸餾,這表明長尾用戶的性能下降。這表明所提出的檢索增強自蒸餾的效果。這些變體的結果驗證了為LLM-ESR設計每個組件的動機。無共享和無交叉注意力代表使用分開的序列編碼器和移除交叉注意力。這兩個的性能下降說明了共享設計和序列級融合的有效性。更多結果可以在附錄C.1中看到。

此外,我們有兩個設計來緩解整個LLM-ESR框架的優化。一個是,我們使用降維的LLM項目嵌入來初始化合作嵌入層,而不是隨機初始化。另一方面,我們提出了一個雙層適配器來填補LLM嵌入和項目嵌入之間的大維度差距。為了說明這兩個設計的有效性,我們比較了1層適配器和隨機初始化變體的LLM-ESR。表2中的結果表明,這兩個變體都低于原始的LLM-ESR,驗證了我們特殊設計的成功。

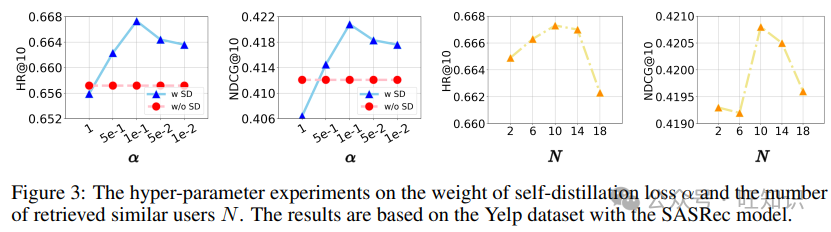

圖3:在Yelp數據集上,自蒸餾損失的權重α和檢索到的相似用戶數量N的超參數實驗。結果基于SASRec模型。

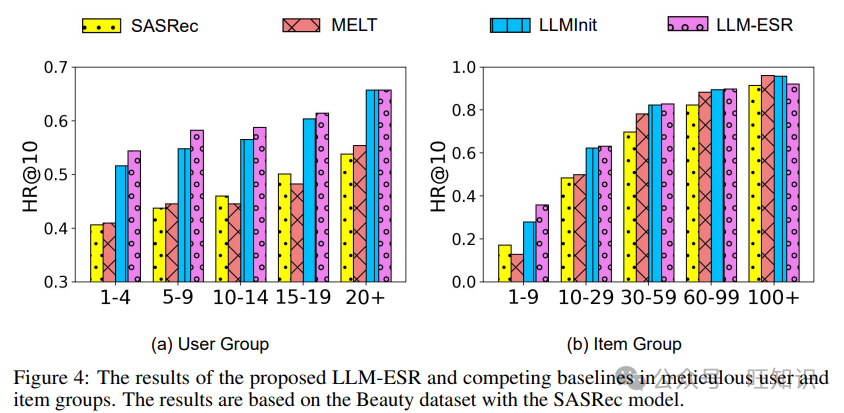

圖4:所提出的LLM-ESR和競爭基線在詳細的用戶和項目組中的結果。結果基于SASRec模型的美容數據集。

4.4 超參數分析

為了研究LLM-ESR中的超參數的影響,我們展示了它們變化時的性能趨勢,如圖3所示。超參數α控制設計的自蒸餾在優化中的影響程度。隨著α從1變化到0.01,推薦準確性先上升后下降。大α的性能下降的原因在于過分強調自蒸餾會影響排名損失的收斂。較小的α也會降低性能,這表明設計的自蒸餾的有用性。至于檢索到的用戶數量N,最佳選擇是10。原因是更多的用戶可以提供更有信息量的互動。然而,過大的N可能會降低檢索到的用戶的相關性。

4.5 組分析

為了更細致的分析,我們根據序列長度nu和流行度pv將用戶和項目分為5組,并在圖4中展示了每組的性能。從結果中,我們觀察到基于LLM的框架在每個用戶和項目組中都取得了增長,而MELT對某些特定組有積極影響。它反映了MLET的蹺蹺板問題,并揭示了利用LLMs的語義嵌入的好處。比較LLMInit與LLM-ESR,LLM-ESR在長尾組(例如,1-4用戶組和1-9項目組)上可以獲得更多的增長,這證明了我們的框架更好地保留了LLMs的語義信息。以Bert4Rec和GRU4Rec為背景的組分析在附錄C.3中。

5 相關工作

5.1 序列推薦

序列推薦的核心是指捕捉序列模式以預測下一個可能的項目[29, 38, 31, 37, 59, 24, 23, 26, 39]。因此,在早期階段,研究人員專注于制造架構以提高模型容量。GRU4Rec[14]和Caser[49]應用RNN和CNN[21]進行序列建模。后來,受到自注意力[51]在自然語言處理中的巨大成功的啟發,SASRec[18]和Bert4Rec[48]驗證了其在SRS中的潛力。此外,Zhou等人[65]提出了一個純MLP架構,與SASRec相比,實現了類似的準確性但更高的效率。盡管在SRS方面取得了巨大進步,但長尾問題仍然未被充分探索。對于長尾項目問題,CITIES[17]設計了一個嵌入推斷函數,專門為長尾項目設計。就長尾用戶問題而言,數據增強是主要方式[36, 34]。只有一項工作,MELT[20],同時解決了這兩個問題,但仍然堅持合作視角。相比之下,所提出的LLM-ESR通過引入LLMs,更好地從語義視角處理這兩個長尾問題。

5.2 為推薦使用LLMs

大型語言模型[62, 42]因其在語義理解方面的強大能力而受到廣泛關注。最近,出現了幾項工作探索如何利用LLMs在推薦系統(RS)中[63, 28, 22, 40, 56, 57, 64, 32, 30],可以分為兩類,即LLMs作為RS和LLMs增強RS。第一行研究旨在直接通過LLMs完成推薦任務。在早期階段,研究人員傾向于制造提示模板,通過對話激發LLMs的推薦能力。例如,ChatRec[10]提出了一個對話過程,逐步完成推薦任務。DRDT[54]通過基于檢索的動態反思過程,通過上下文學習[6]整合SRS。LLMRerank[9]和UniLLMRec[61]制造了鏈式思考提示,分別針對重排階段和整個推薦過程。此外,一些其他研究人員探索了微調開源LLMs以用于RS。TALLRec[2]是第一個,通過參數高效的微調技術[15, 33]微調LLaMA-7B。一些后續工作,包括E4SRec[25]、LLaRA[27]和RecInterpreter[58],通過修改標記化,將合作信號整合到LLMs中。然而,這項工作面臨高推理成本的挑戰。另一行,LLMs增強RS,更為實用,因為它們在推薦時避免了使用LLMs。例如,RLMRec[44]通過輔助損失與LLMs對齊。AlphaRec[46]采用LLMs嵌入來增強合作過濾模型。另一方面,LLM4MSR[55]和Uni-CTR[8]提出利用LLMs增強多域推薦模型。至于LLMs增強序列推薦,Harte等人[13]和Hu等人[16]采用LLMs嵌入作為傳統模型的初始化。所提出的LLM-ESR屬于后者類別,但進一步緩解了語義信息缺陷的問題。

6 結論

在本文中,我們提出了一個大型語言模型增強框架,用于序列推薦(LLM-ESR),以處理長尾用戶和長尾項目挑戰。首先,我們獲取并緩存了LLMs的語義嵌入,這是為了推理效率。然后,提出了一個雙視圖建模框架,結合了LLMs的語義和傳統模型中的合作信號。它可以幫助增強SRS中的長尾項目。接下來,我們設計了檢索增強的自蒸餾來緩解長尾用戶挑戰。通過綜合實驗,我們驗證了LLM-ESR的有效性和靈活性。

參考資料

標題:LLM-ESR: Large Language Models Enhancement for Long-tailed Sequential Recommendation

作者:Qidong Liu, Xian Wu, Yejing Wang, Zijian Zhang, Feng Tian, Yefeng Zheng, Xiangyu Zhao

單位:1 School of Auto. Science & Engineering, MOEKLINNS Lab, Xi’an Jiaotong University; 2 City University of Hong Kong; 3 Jarvis Research Center, Tencent YouTu Lab; 4 Jilin University; 5 School of Comp. Science & Technology, MOEKLINNS Lab, Xi’an Jiaotong University; 6 Medical Artificial Intelligence Lab, Westlake University

標簽:Sequential Recommendation, Large Language Models, Long-tail Challenge, Semantic Embedding

概述:本文提出了一種利用大型語言模型(LLMs)增強長尾序列推薦的框架LLM-ESR,以改善用戶體驗和提升推薦系統性能。

鏈接:https://arxiv.org/pdf/2405.20646

本文轉載自旺知識,作者: 旺知識 ????