LN和BN的愛恨糾葛!為什么Transformer要用LayerNorm? 精華

在聊“二選一”的問題前,我們先介紹下什么是Layer Normalization?什么是Batch Normalization?

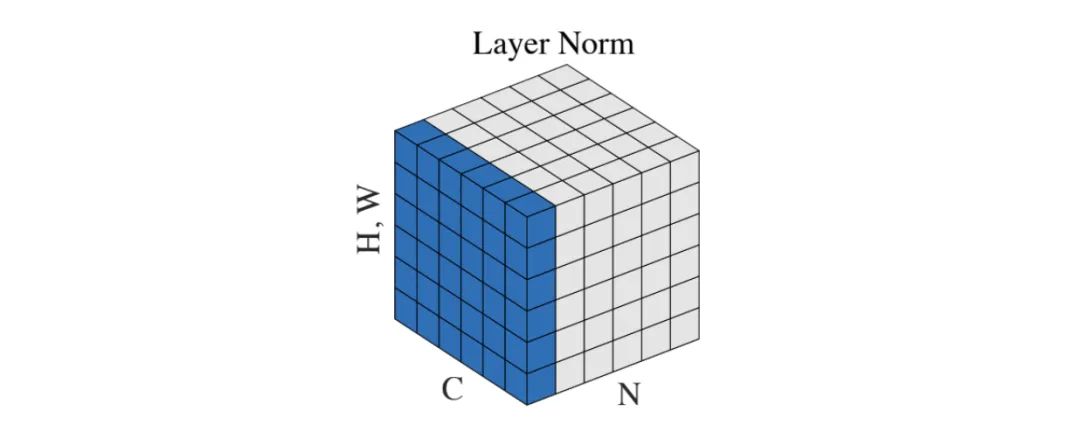

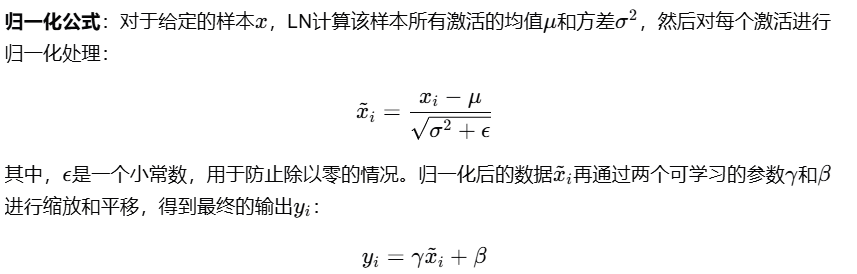

Layer Normalization(層規范化)

Layer Normalization(簡稱LN),是一種在深度學習中使用的規范化技術,由Jimmy Lei Ba和Jamie Ryan Kiros等人在2016年提出。它的主要目的是幫助神經網絡更快、更穩定地收斂。Layer Normalization與其它規范化技術,如Batch Normalization和Group Normalization,有著相似的目的,但操作方式略有不同。

工作原理:

1. 操作對象:Layer Normalization在單個樣本的層級上進行操作,而非在批量(Batch)的層級。這意味著它對每個樣本獨立計算規范化參數(均值和標準差),而不是在整個批量的基礎上。

2. 計算方式:對于給定的樣本,在其所有特征(或通道)上計算均值和標準差。然后,使用這些統計數據來規范化該樣本的每個特征。

具體步驟包括:

1. 計算均值和標準差。

2. 使用計算得到的均值和標準差來規范化每個特征。

3. 引入兩個可學習的參數:縮放因子(scale factor)γ和偏移因子(shift factor)β。這兩個參數允許模型學習規范化數據的最佳表示。

LN的適用場景

Layer Normalization特別適用于處理序列數據,如自然語言處理(NLP)任務中的文本數據,以及循環神經網絡(RNN)。

- 序列數據處理LN對每個樣本獨立進行歸一化,不受批次大小和序列長度的影響,這使得它在處理變長序列時表現更加穩定。

- 數據支持在一項針對機器翻譯任務的研究中,使用LN的Transformer模型在處理不同長度的輸入序列時,比使用BN的模型取得了更好的性能。

LN的優點

Layer Normalization在Transformer模型中相較于Batch Normalization具有多個顯著優點。

- 不受批量大小影響LN不依賴于批量數據的統計信息,因此即使在小批量或單個樣本的情況下也能保持穩定的歸一化效果。

- 數據支持一項實驗表明,在小批量大小(如1)的情況下,使用LN的模型性能下降幅度遠小于使用BN的模型。

- 適應性強LN能夠適應不同長度的輸入序列,這對于Transformer模型在處理NLP任務時尤為重要。

- 減少過擬合LN作為一種正則化手段,能夠在一定程度上減少模型的過擬合現象。

- 數據支持在一項針對文本分類任務的研究中,使用LN的模型在驗證集上的錯誤率比使用BN的模型低1.5%,顯示出更好的泛化能力。

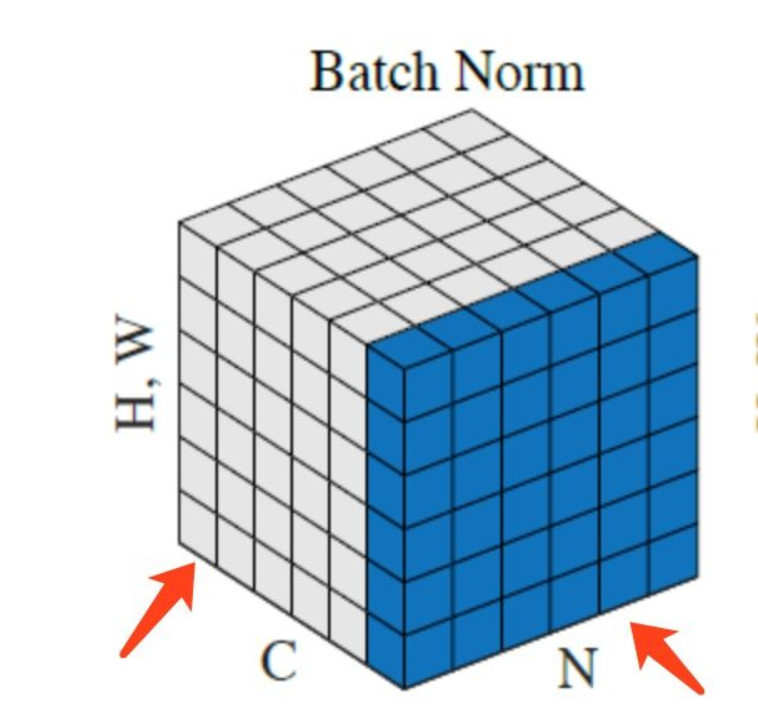

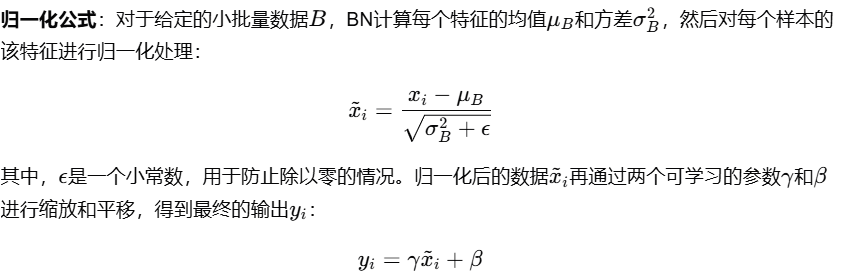

Batch Normalization(批量規范化)

Batch Normalization(簡稱BN),是另一種在深度學習中廣泛使用的規范化技術,尤其在卷積神經網絡(CNN)和全連接網絡中。它通過規范化層的輸入來減少內部協變量偏移,加速深度網絡的訓練,并且有助于提高模型的穩定性和性能。

工作原理:

1. 操作對象:Batch Normalization在批量(Batch)的層級上進行操作,即對整個小批量數據的同一個特征進行歸一化。

2. 計算方式:計算小批量數據的每個特征的均值和方差,然后利用這些統計數據來規范化該特征的所有數據點。

具體步驟包括:

1. 計算小批量數據的均值和方差。

2. 使用計算得到的均值和方差來規范化小批量中的每個數據點。

3. 同樣引入兩個可學習的參數:縮放因子γ和偏移因子β,以允許模型學習規范化數據的最佳表示。

BN的適用場景

Batch Normalization主要適用于批量大小較大的情況,尤其是在圖像處理任務中。BN能夠有效地減少內部協變量偏移,加速模型的訓練過程,并提高模型的泛化能力。

- 圖像分類任務在圖像分類任務中,BN被廣泛應用于卷積層和全連接層之后,激活函數之前,以穩定訓練過程并提高性能。

- 數據支持在CIFAR-10數據集上的實驗結果表明,使用BN的網絡在測試集上的錯誤率比不使用BN的網絡低2.5%。

Layer Normalization與Batch Normalization的區別

1.計算方式大不同

首先,得說說這倆兄弟的計算方式。BN是在一個小批量(batch)的數據上計算均值和方差的,這意味著它依賴于每個批次的數據。而LN呢,它是對每個樣本的所有特征進行歸一化的,不依賴于批次大小。這就像是,BN需要一幫朋友一起開派對,而LN則是一個人也能玩得很開心。

2.應對序列數據的能力

接下來,我們得聊聊它們應對序列數據的能力。BN因為是在批次上計算的,所以它不太適合處理那些長度不一的序列數據,比如我們說話時的句子,有時候長有時候短。而LN就不同了,它能夠很好地處理這種變長序列,因為它不依賴于批次中其他樣本的信息,每個樣本都是獨立的。

3.靈活性和穩定性

再來說說靈活性和穩定性。LN因為是在每個樣本上單獨歸一化的,所以它在處理位置上更加靈活,不會因為批次的變化而影響模型的表現。

4.訓練效率和泛化能力

最后,我們得提提訓練效率和泛化能力。LN因為減少了內部協變量偏移,所以能夠幫助模型更快地學習,加速訓練過程。同時,LN還能提高模型的泛化能力,因為它讓模型不會過分依賴于某些特定的特征,這樣在面對新的數據時,模型也能表現得更好。

Transformer模型特點

聊完LN核BN,再來看看Transformer模型特點。

1.處理序列數據

Transformer模型之所以在處理序列數據方面表現出色,主要得益于其獨特的架構設計。

- 變長序列處理:Transformer模型不限制輸入序列的長度,這在自然語言處理任務中尤為重要,因為文本數據的長度是高度可變的。

2.自注意力機制

Transformer模型的核心是自注意力機制(Self-Attention),它允許模型在處理序列時同時考慮輸入序列的所有位置,而不是像傳統遞歸結構(如LSTM、GRU)那樣逐步處理序列。

- 全局依賴捕捉:自注意力機制使得Transformer能夠捕捉序列中任意兩個位置之間的依賴關系,無論它們之間的距離有多遠。這種全局依賴捕捉能力是Transformer在處理長距離依賴任務時表現優異的關鍵因素。一項研究顯示,在使用自注意力機制的Transformer模型中,長距離依賴的準確率比使用傳統RNN結構的模型高出約5%。

- 并行計算優勢:與傳統的序列處理模型(如RNN)相比,Transformer的自注意力機制可以并行處理序列中的所有位置,這大大加快了模型的訓練速度。一項實驗表明,Transformer模型的訓練速度比傳統的RNN模型快3倍以上。

為什么Transformer選擇LayerNorm

1.LayerNorm的獨立性

首先,咱們得聊聊LN的一個超級棒的特性——獨立性。LayerNorm對每個樣本的所有特征進行歸一化,這意味著它不依賴于批次的大小。這對于Transformer來說,就像是量身定做的一樣。因為Transformer處理的是序列數據,這些數據的長度可以變化,而且每個詞的位置信息非常重要。如果使用BN,它可能會因為批次大小的變化而破壞這些寶貴的位置信息。但LN就不會有這個問題,它能夠保持模型的穩定性,不管輸入序列有多長。

2.LayerNorm的靈活性

接下來,我們得說說LN的靈活性。在Transformer中,每個詞都能獨立地關注到其他所有詞,這種機制需要模型在每個位置上都能獨立地處理信息。LN正好滿足了這個需求,因為它允許模型在每個位置上獨立地進行歸一化,而不受批次中其他樣本的干擾。這種靈活性讓Transformer能夠更好地捕捉序列數據中的長距離依賴關系。

3.LayerNorm的穩定性和效率

再來看看穩定性和效率。在訓練深度網絡時,LN可以幫助加速收斂,因為它減少了內部協變量偏移。這意味著模型可以在訓練過程中更快地學習。而且,LN在處理不同長度的序列時更加穩定,因為它不會受到批次大小的影響。這對于Transformer來說至關重要,因為它需要處理各種長度的文本。

4.LayerNorm與Transformer的默契配合

最后,我們得聊聊LN和Transformer之間的默契配合。LayerNorm和Transformer就像是一對默契的搭檔,它們一起在NLP的世界里大展拳腳。LN的獨立性和靈活性與Transformer的自注意力機制相得益彰,使得模型能夠更好地處理序列數據,捕捉到句子中每個詞之間的關系。

總之,LayerNorm之所以成為Transformer的首選,是因為它的獨特優勢和Transformer的需求完美匹配。雖然BatchNorm在其他領域也有出色的表現,但在Transformer的世界里,LayerNorm才是那個最佳拍檔。

本文轉載自?? 智駐未來??,作者: 小智