谷歌提出大規模ICL方法——強化和無監督

大語言模型在自然語言處理任務中取得了顯著的突破,尤其是是在少樣本學習和上下文學習(in-context learning,簡稱“ICL”)方面。雖然在少樣本學習中表現出色,但無法探索更大規模的上下文學習潛力。

隨著大模型上下文窗口的大幅度增長,例如,谷歌的Gemini 1.5 Pro模型支持100萬tokens上下文,使得研究人員有機會探索更多的ICL示例,以增強大模型的學習和輸出能力。

谷歌Deepmind的研究人員提出了強化和無監督兩種ICL學習方法,可顯著提升模型的數學問題解決、文本問答、摘要生成、算法推理、低資源機器翻譯等場景能力,同時大幅度降低人工標注的成本。

論文地址:https://arxiv.org/abs/2404.11018

強化ICL

傳統的ICL主要依賴于人類生成的示例來學習新的輸出模式,但這種方法受限于高質量數據的可用性。而谷歌提出的強化ICL通過使用模型生成的推理鏈來代替人類編寫的示例輸出,可有效減少對人類生成數據的依賴。

強化ICL主要通過已有的模型來生成問題解決的候選推理鏈,從少量或零示例的鏈式思考提示開始,使模型能夠為每個訓練問題生成多個推理鏈。

然后,使用一個獨立的評估模塊,對生成的推理鏈、輸出對進行打分過濾,只保留高質量的部分,并將它們作為上下文示例應用在模型的學習中。

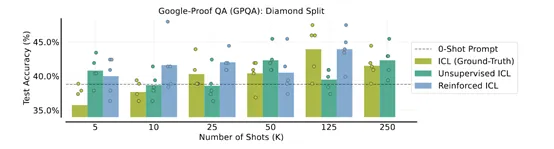

研究人員在一系列推理和問答數據集上測試了強化ICL性能,結果顯示,可以在不依賴額外人工標注的情況下,持續提升模型的多ICL性能。

例如,在谷歌的GPQA數據集上,使用強化ICL產生的8192個示例,使得大模型的準確率高達67.8%,大幅超過了僅使用128個人工標注示例50.2%。

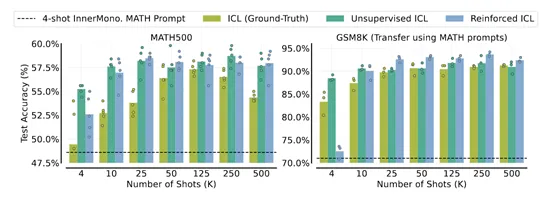

在谷歌的GSM8K編程問題數據集上,使用500個強化ICL生成的示例,模型的準確率達到84%,而僅使用4個人工標注示例時的準確率只有78.1%。

除了大模型的性能獲得顯著提升,強化ICL還顯著降低了人工成本。以MATH數學題為例,生成4000個高質量的問題解答示例,純人工標注需180人小時,而使用強化ICL生成只需10人小時,大幅度降低了18倍的人力成本。

無監督ICL

?

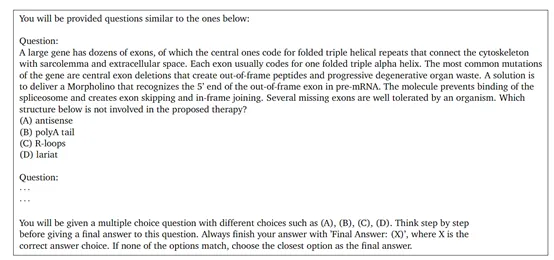

無監督ICL不依賴于傳統的輸入-輸出示例對,而是僅通過問題本身的上下文來引導模型學習,幫助模型能夠利用其在預訓練階段獲得的知識,來理解和解決問題,而無需額外的示例指導。

首先,根據任務的需求,從未標注的數據中選取合適的文本片段作為上下文。這些上下文可以是單個句子、段落或者更長的文本。然后將構建好的上下文輸入到大語言模型中,讓模型根據上下文的內容進行推理和預測。

最后,將模型推理的結果與真實情況進行對比,計算損失函數并更新模型的參數。但需要注意的是,由于無監督ICL沒有標注任何數據,很多示例是基于某種啟發式方法或者先驗知識實現的。

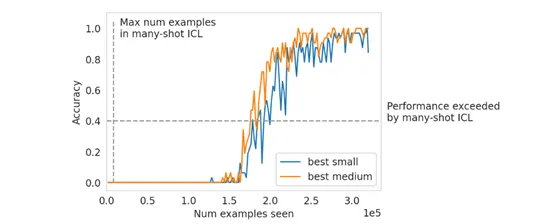

此外,在研究過程中,研究人員還發現了一些有趣的現象,大規模ICL與少樣本學習存在差異。但大模型可以克服預訓練偏差,并解決具有數值輸入的高維預測任務,例如,順序奇偶預測和線性分類等。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區