從低清到4K的魔法:FlashVideo突破高分辨率視頻生成計(jì)算瓶頸(港大&港中文&字節(jié))

論文鏈接:https://arxiv.org/pdf/2502.05179

項(xiàng)目鏈接:https://github.com/FoundationVision/FlashVideo

亮點(diǎn)直擊

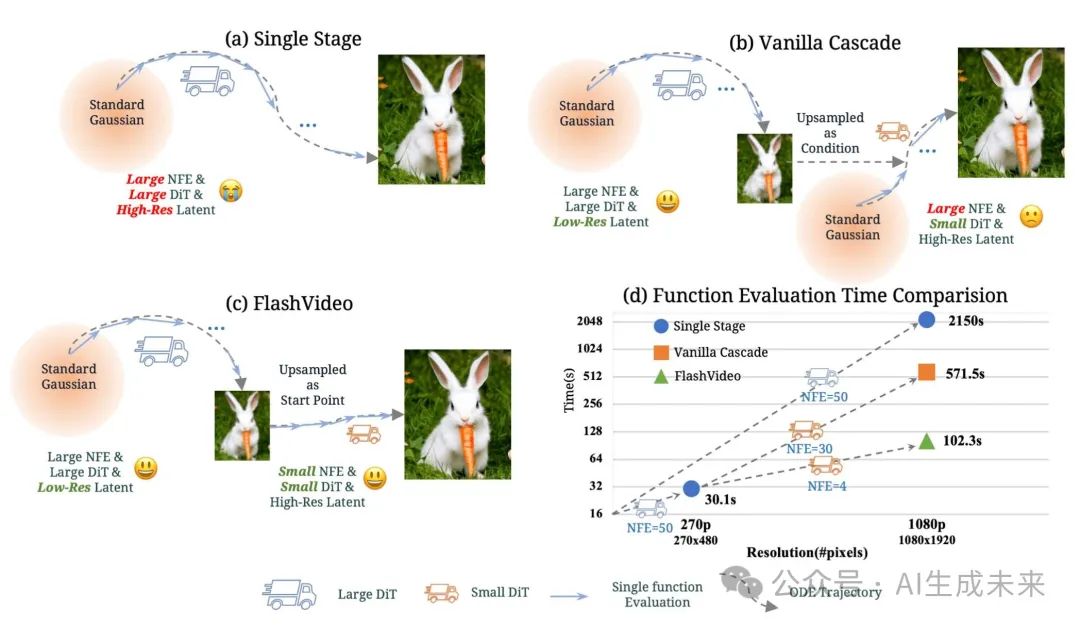

- 提出了FlashVideo,一種將視頻生成解耦為兩個(gè)目標(biāo)的方法:提示匹配度和視覺質(zhì)量。通過在兩個(gè)階段分別調(diào)整模型規(guī)模、分辨率和優(yōu)化策略,本文的方法相比現(xiàn)有方法實(shí)現(xiàn)了更高的效果和效率。

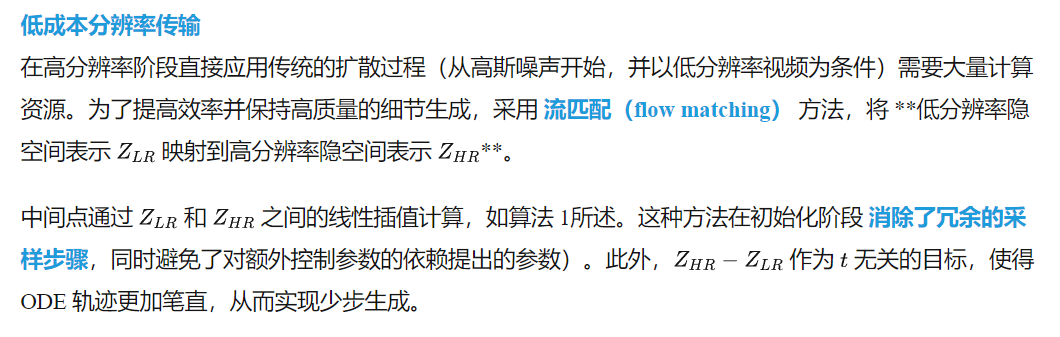

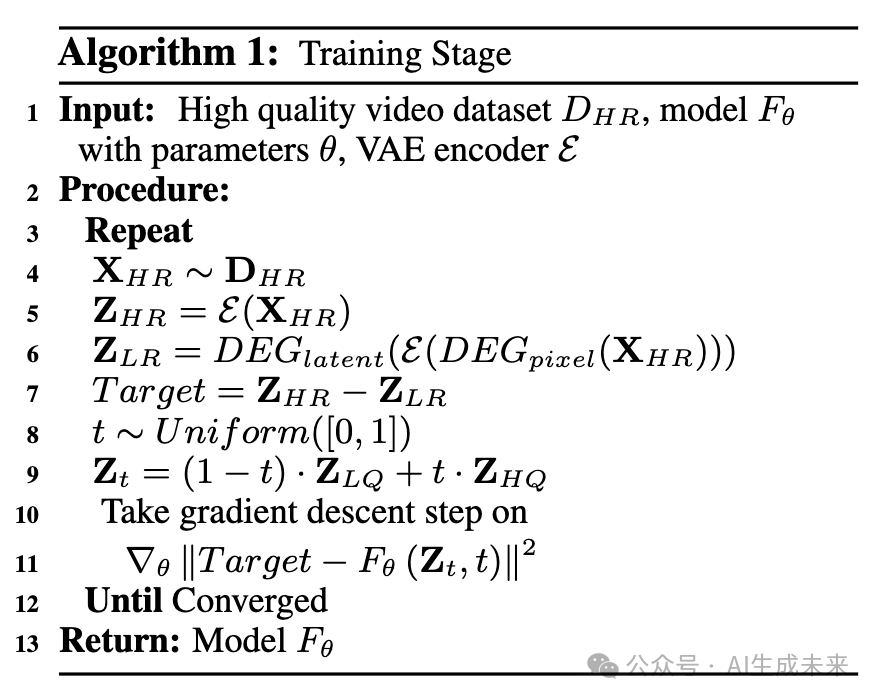

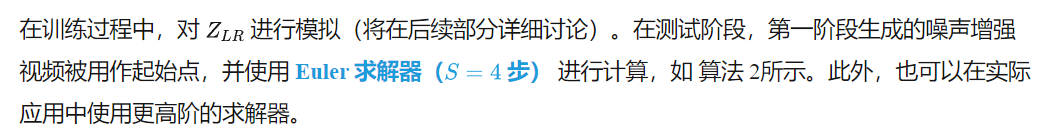

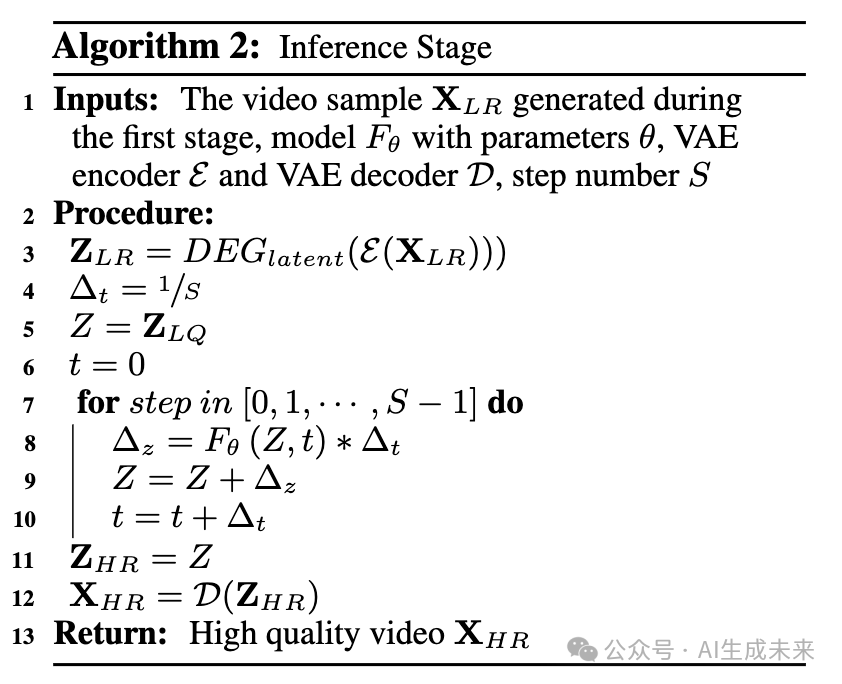

- 通過流匹配(flow matching)構(gòu)造了從低質(zhì)量視頻到高質(zhì)量視頻的近乎直線的 ODE 軌跡,使得視頻在僅 4 次函數(shù)評(píng)估內(nèi)即可融入豐富細(xì)節(jié)。

- 本文的方法在 VBench-Long 上達(dá)到了82.99的頂級(jí)分?jǐn)?shù),同時(shí)實(shí)現(xiàn)了極快的函數(shù)評(píng)估時(shí)間。兩階段設(shè)計(jì)使用戶能夠在全分辨率生成前預(yù)覽初始輸出,從而降低計(jì)算成本和等待時(shí)間。

總結(jié)速覽

解決的問題

- 現(xiàn)有 DiT 生成的視頻模型需要大規(guī)模參數(shù)和大量計(jì)算資源,導(dǎo)致計(jì)算成本高昂。

- 生成高質(zhì)量視頻需要高分辨率和大量去噪步驟,進(jìn)一步增加計(jì)算負(fù)擔(dān)。

- 現(xiàn)有的兩階段方法仍然依賴從高斯噪聲重建高分辨率視頻,計(jì)算效率低下。

提出的方案

- 設(shè)計(jì) FlashVideo 兩階段框架:

- 第一階段低分辨率視頻生成,保證內(nèi)容和運(yùn)動(dòng)的語義一致性。

- 第二階段通過流匹配(flow matching)提升分辨率,增強(qiáng)細(xì)節(jié),同時(shí)減少計(jì)算開銷。

- 采用流匹配技術(shù),直接優(yōu)化 ODE 軌跡,使第二階段生成不依賴高斯噪聲。

應(yīng)用的技術(shù)

- DiT(Diffusion Transformer)架構(gòu),利用 3D 全注意力機(jī)制建模時(shí)間和空間關(guān)系。

- 流匹配(flow matching),直接優(yōu)化低分辨率到高分辨率的 ODE 軌跡,避免從高斯噪聲重建。

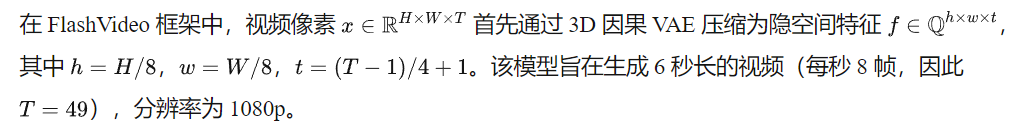

- 計(jì)算優(yōu)化,第一階段使用 5B 參數(shù)模型,第二階段降至 2B 參數(shù),并減少函數(shù)評(píng)估步驟至 4 步。

達(dá)到的效果

- 大幅提升計(jì)算效率:1080p 視頻生成時(shí)間從單階段 2150s 降至 102s,比傳統(tǒng)兩階段方法快 5 倍。

- 保障生成質(zhì)量:低分辨率階段保證語義一致性,高分辨率階段增強(qiáng)細(xì)節(jié),確保視覺質(zhì)量。

- 更高的商業(yè)可行性:允許用戶在低分辨率階段預(yù)覽結(jié)果,減少不必要的計(jì)算成本。

方法

總覽

低分辨率階段 I

在第一階段,目標(biāo)是生成與輸入提示高度匹配的內(nèi)容和運(yùn)動(dòng)模式。為此,初始化了一個(gè)大規(guī)模模型 CogVideoX-5B,其包含 50 億 參數(shù)。為了提高計(jì)算效率,采用 參數(shù)高效微調(diào)(PEFT),使模型適應(yīng) 270p 的低分辨率。

調(diào)整 MMDiT 架構(gòu)的目標(biāo)分辨率相對(duì)簡單,可通過在所有 注意力層、前饋網(wǎng)絡(luò)(FFN) 以及 自適應(yīng)層歸一化(adaptive layer normalization) 中應(yīng)用 LoRA(秩設(shè)為 128)來實(shí)現(xiàn)。

與全參數(shù)微調(diào)相比,PEFT 在小批量(batch size = 32)訓(xùn)練時(shí)表現(xiàn)出更強(qiáng)的魯棒性,而全參數(shù)微調(diào)在如此小的批量下會(huì)顯著降低生成質(zhì)量。所有其他配置設(shè)置(包括去噪調(diào)度器和預(yù)測目標(biāo))均與 CogVideoX-5B 保持一致。

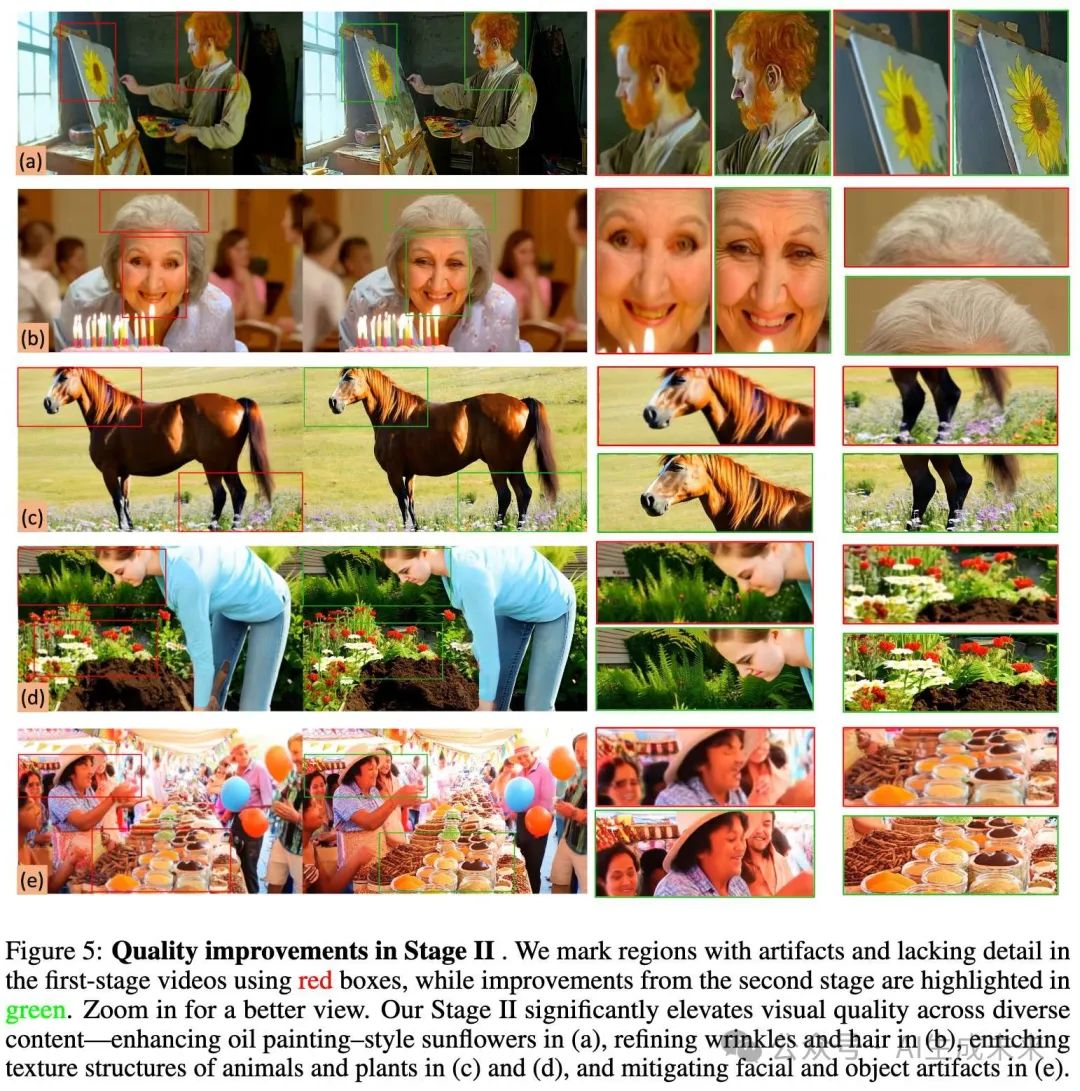

高分辨率階段 II

模型架構(gòu)

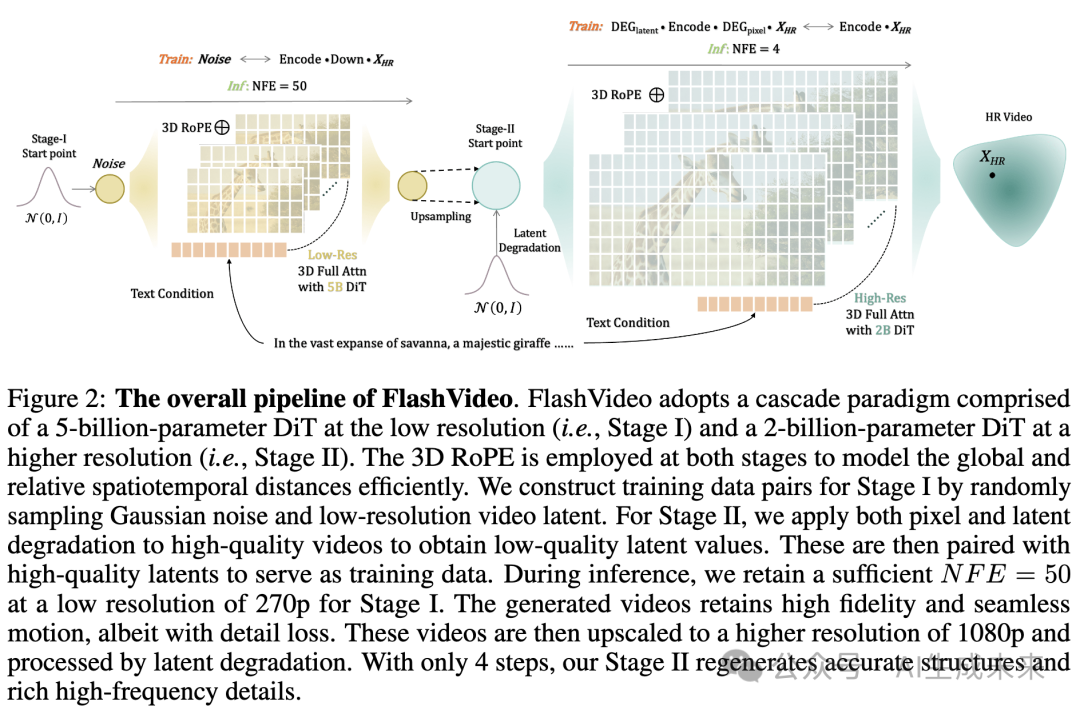

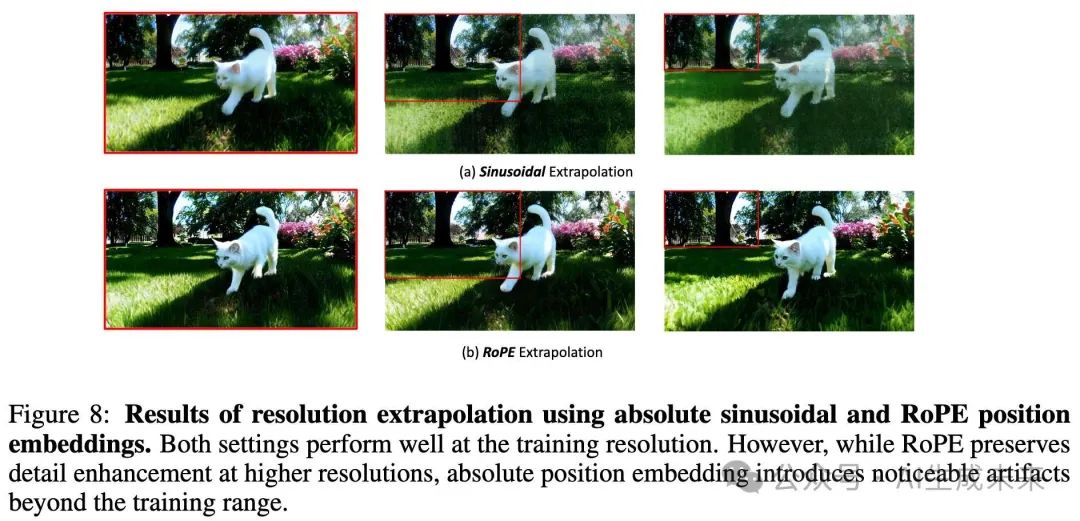

為了增強(qiáng)細(xì)粒度細(xì)節(jié),本文采用了另一種遵循 CogVideoX-2B設(shè)計(jì)的模型。用 3D RoPE 替換了原始位置頻率嵌入,以在推理時(shí)更好地?cái)U(kuò)展至更高分辨率(見下圖 8)。

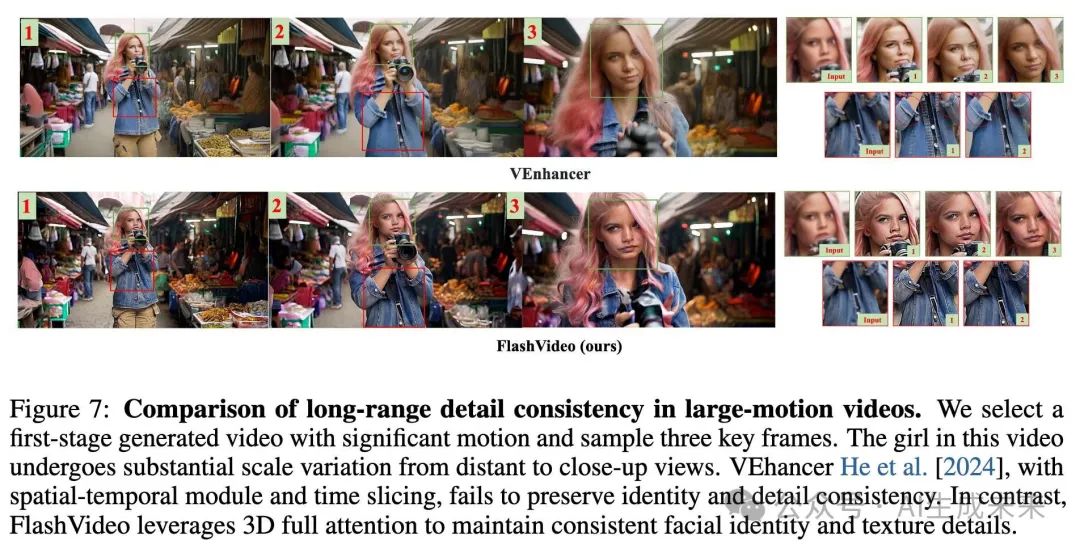

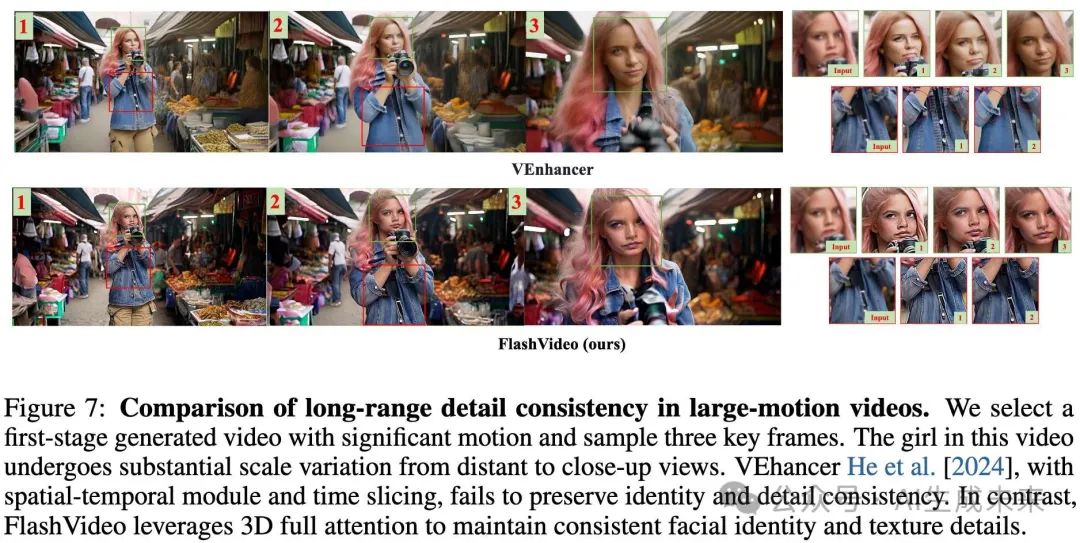

與 [He et al. 2024] 采用的 時(shí)空分解(spatial-temporal decomposition) 和 時(shí)間切片注意力(time-slicing attention) 方法不同,完整的 3D 注意力機(jī)制 對(duì)于保持視頻在劇烈運(yùn)動(dòng)和尺度變化情況下的增強(qiáng)視覺細(xì)節(jié)一致性至關(guān)重要(見下圖 7)。如上圖 2所示,第一階段的語言嵌入被直接用于該階段。

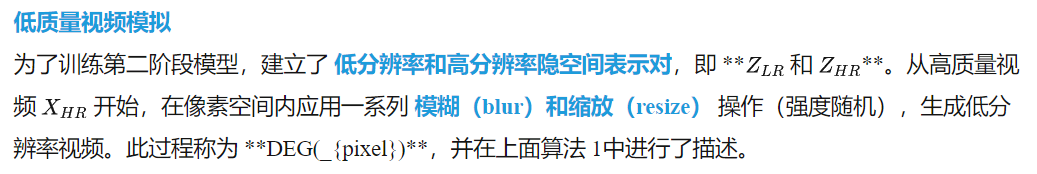

在此模擬數(shù)據(jù)上訓(xùn)練,使模型能夠增強(qiáng)高頻細(xì)節(jié),從而改善整體清晰度(見下圖 3)。然而,僅通過 DEG(_{pixel}) 進(jìn)行低分辨率數(shù)據(jù)模擬會(huì)使低、高分辨率視頻之間保持較強(qiáng)的保真度,這限制了模型在高分辨率下對(duì)小物體的結(jié)構(gòu)再生能力,尤其是在第一階段輸出中存在偽影時(shí)。例如,當(dāng)結(jié)構(gòu)表現(xiàn)較差時(shí),小物體可能會(huì)變得模糊,如下圖 3中的樹枝,或下圖 5(e) 中失真的眼部特征。

為了解決這個(gè)問題,本文引入了 隱空間退化(latent degradation, DEG({latent})**),即在隱空間表示中加入高斯噪聲。這一方法允許模型在輸入數(shù)據(jù)的基礎(chǔ)上產(chǎn)生偏離,從而為小物體生成更合理的結(jié)構(gòu)。如上圖 3所示,相比 **DEG({pixel}),DEG(_{latent}) 組合策略能夠生成更加清晰且細(xì)節(jié)豐富的樹枝及背景小物體,顯著提升視覺質(zhì)量。

訓(xùn)練過程中的整體模擬流程如下所述:

首先,對(duì)高質(zhì)量視頻在像素空間進(jìn)行退化處理,得到退化版本;然后,該退化視頻被編碼至隱空間空間,表示為

參數(shù) step 決定了噪聲增強(qiáng)的強(qiáng)度。為了確保模型能夠感知隱空間空間中的噪聲強(qiáng)度,我們引入了噪聲強(qiáng)度嵌入,并將其添加到時(shí)間嵌入中。在推理階段,僅對(duì)第一階段的輸出應(yīng)用 DEGlatent。

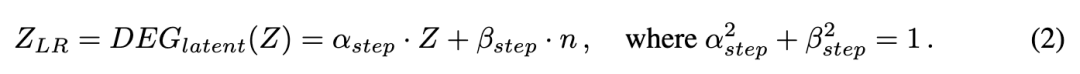

為了確定合適的 DEGlatent 強(qiáng)度,在初始訓(xùn)練時(shí)使用較寬的噪聲步長范圍(600-900)。然后,我們?cè)诓煌脑肼暡介L下評(píng)估模型的結(jié)果(如圖 9 (c) 和表 10 所示)。根據(jù)這些結(jié)果,我們?cè)诤罄m(xù)訓(xùn)練階段將噪聲范圍限制在 650-750。

粗到精訓(xùn)練

直接在高分辨率上訓(xùn)練需要大量計(jì)算成本。3D RoPE作為一種相對(duì)時(shí)空編碼,為我們的模型提供了良好的分辨率可擴(kuò)展性。因此,首先在低分辨率圖像和視頻(540×960)上進(jìn)行大規(guī)模預(yù)訓(xùn)練,然后再擴(kuò)展到目標(biāo)分辨率 1080p(1080 ×1920)。在后期訓(xùn)練中,觀察到明顯的性能波動(dòng),因此進(jìn)一步使用一小部分符合人類偏好的高質(zhì)量樣本進(jìn)行微調(diào)。這個(gè)低成本的額外微調(diào)階段顯著提升了模型的性能。

實(shí)驗(yàn)

數(shù)據(jù)收集

首先收集了大量 1080p 視頻,并通過美學(xué)和運(yùn)動(dòng)特征篩選,構(gòu)建了一個(gè)高質(zhì)量數(shù)據(jù)集,最終獲得 200 萬個(gè)高質(zhì)量樣本。運(yùn)動(dòng)篩選使用 RAFT 計(jì)算平均光流,并丟棄運(yùn)動(dòng)得分低于 1.1 的片段。

為了確保第二階段模型學(xué)習(xí)多樣化的紋理細(xì)節(jié),進(jìn)一步收集了 150 萬張分辨率為 2048 ×2048 的高質(zhì)量圖像。所有視頻和圖像均使用內(nèi)部字幕生成模型進(jìn)行詳細(xì)標(biāo)注。此外,手動(dòng)篩選了 50,000 個(gè)視頻,這些視頻具有高美學(xué)質(zhì)量、豐富的紋理和顯著的運(yùn)動(dòng)多樣性,以用于人類偏好對(duì)齊。

訓(xùn)練設(shè)置

對(duì)于第一階段模型的訓(xùn)練,我們僅使用視頻數(shù)據(jù),并將其調(diào)整為 270p 分辨率。模型訓(xùn)練了 50,000 次迭代,批次大小為 32,基礎(chǔ)學(xué)習(xí)率為 4 ×10??。使用 AdamW 優(yōu)化器,β1 = 0.9,β2 = 0.95,權(quán)重衰減為 1 ×10??,并將梯度裁剪設(shè)置為 0.1。

第二階段模型,包括預(yù)訓(xùn)練和人類偏好對(duì)齊,使用批次大小為 64,其他超參數(shù)與第一階段相同。預(yù)訓(xùn)練分為三個(gè)階段:(1)在 540 ×960 的圖像補(bǔ)丁上訓(xùn)練 25,000 次迭代,這些補(bǔ)丁來自 2048 ×2048 的高分辨率圖像;(2)在混合數(shù)據(jù)集上訓(xùn)練 30,000 次迭代,數(shù)據(jù)集包括 540 ×960 的圖像補(bǔ)丁和視頻,比例為 1:2;(3)在全分辨率的 1080 ×1920 視頻上訓(xùn)練 5000 次迭代。最后,在人類偏好對(duì)齊數(shù)據(jù)集上進(jìn)行 700 次迭代的微調(diào)。

對(duì)于隱空間退化,在階段(1)、(2)和(3)的前 1000 次迭代中,初步應(yīng)用了 600–900 的噪聲步長范圍。根據(jù)下表 10 中的發(fā)現(xiàn),我們隨后將噪聲范圍縮小到 650–750,用于(3)和(4)中的剩余訓(xùn)練。

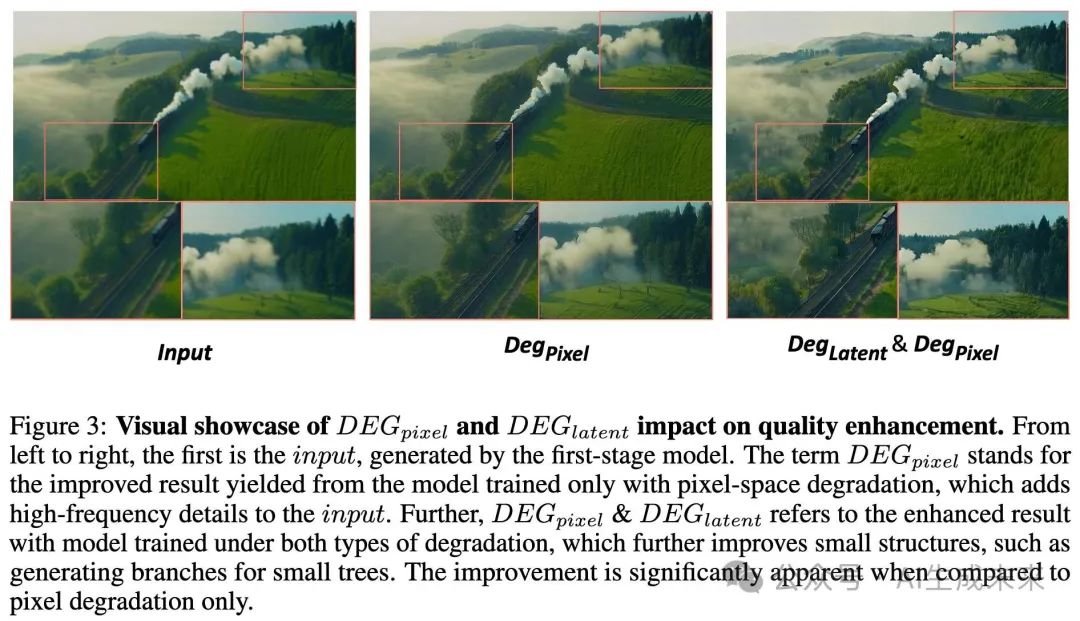

定性結(jié)果

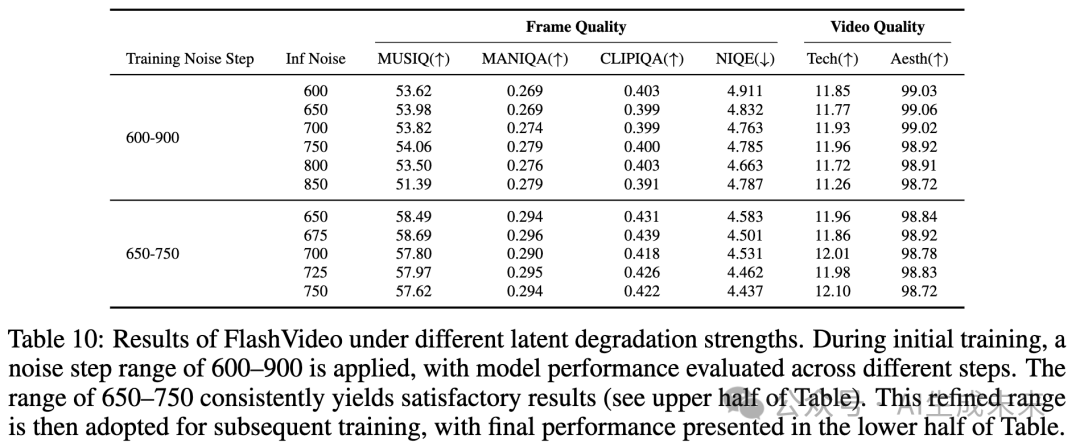

本節(jié)展示了基于不同用戶提示的二階段視頻生成結(jié)果的可視化。第一階段的輸出優(yōu)先保證內(nèi)容和運(yùn)動(dòng)的高保真度,而第二階段進(jìn)一步細(xì)化細(xì)節(jié),減少生成偽影,從而增強(qiáng)整體視覺質(zhì)量。

二階段生成結(jié)果

如下圖 4 所示,第一階段輸出(頂部行)展現(xiàn)了強(qiáng)烈的提示保真度和流暢的運(yùn)動(dòng)。提示中指定的關(guān)鍵視覺元素(加粗部分)被準(zhǔn)確生成。然而,仍可能存在偽影和細(xì)節(jié)不足的紋理問題(由紅色框標(biāo)出)。相比之下,第二階段的輸出(底部行)通過精細(xì)化小物體的結(jié)構(gòu)和增強(qiáng)紋理豐富度,顯著提高了視覺質(zhì)量。顯著的改進(jìn)包括人臉細(xì)節(jié)的細(xì)化(a, d)、動(dòng)物毛發(fā)的精細(xì)渲染(b, c)、植物結(jié)構(gòu)的復(fù)雜細(xì)節(jié)(a, b)以及織物紋理的提升(d),這些都在第二行的綠色框中突出顯示。此外,盡管存在大量運(yùn)動(dòng),由于第二階段集成了完整的注意力機(jī)制,高頻細(xì)節(jié)依然保持了時(shí)間一致性。更多未壓縮的案例可見于我們的項(xiàng)目頁面。

第二階段的偽影修正與細(xì)節(jié)增強(qiáng)

為了進(jìn)一步展示第二階段細(xì)化的有效性,在下圖 5 中提供了關(guān)鍵幀的額外示例。與第一階段的輸出(紅色標(biāo)記)相比,第二階段的結(jié)果(綠色標(biāo)記)通過抑制偽影和豐富細(xì)節(jié),表現(xiàn)出了顯著的改進(jìn)。這些增強(qiáng)表現(xiàn)為:更連貫的油畫風(fēng)格向日葵(a)、更精細(xì)的皺紋和發(fā)絲渲染(b)、動(dòng)物和植物紋理結(jié)構(gòu)的改善(c, d)以及面部和物體偽影的修正(e)。

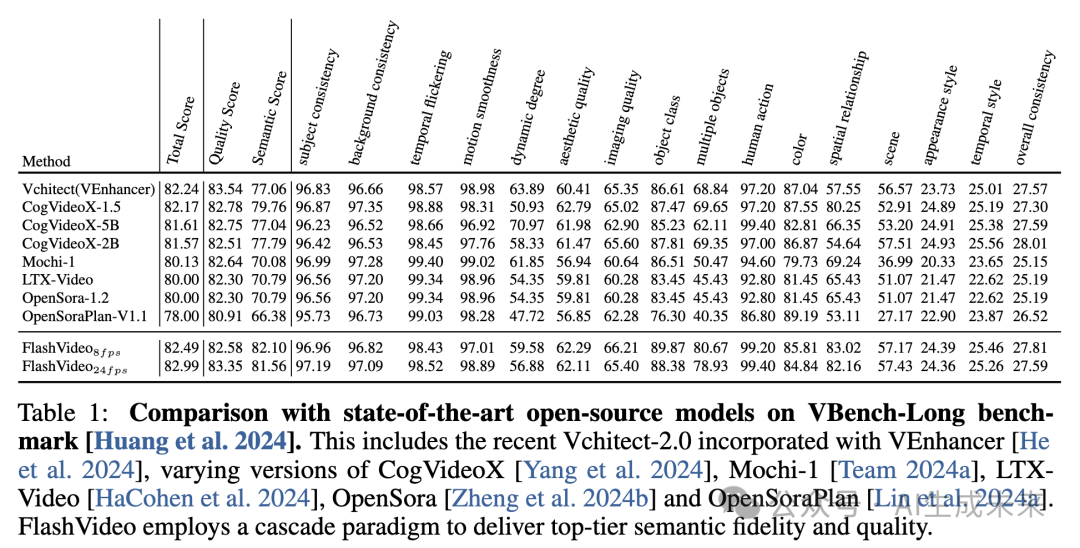

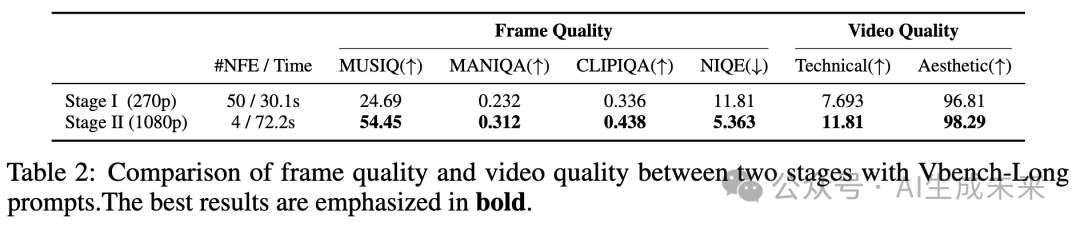

定量結(jié)果

首先在 VBench-Long基準(zhǔn)上評(píng)估我們的模型,使用其長提示進(jìn)行評(píng)估。通過使用多種廣泛使用的非參考圖像和視頻質(zhì)量評(píng)估指標(biāo),評(píng)估第二階段的視覺質(zhì)量提升。

VBench-Long 基準(zhǔn)遵循 VBench-Long 的標(biāo)準(zhǔn)評(píng)估協(xié)議,每個(gè)提示生成五個(gè)視頻。需要注意的是,由于 VBench 的評(píng)估指標(biāo)傾向于偏好較高的幀率,應(yīng)用了一個(gè)實(shí)時(shí)視頻幀插值方法 ,將幀率從 8 fps 升級(jí)到 24 fps。這個(gè)插值過程幾乎沒有后處理時(shí)間(在 4 秒以內(nèi)),確保了與高幀率方法的公平比較。關(guān)于 VBench 幀率偏好的更詳細(xì)討論,見補(bǔ)充材料。

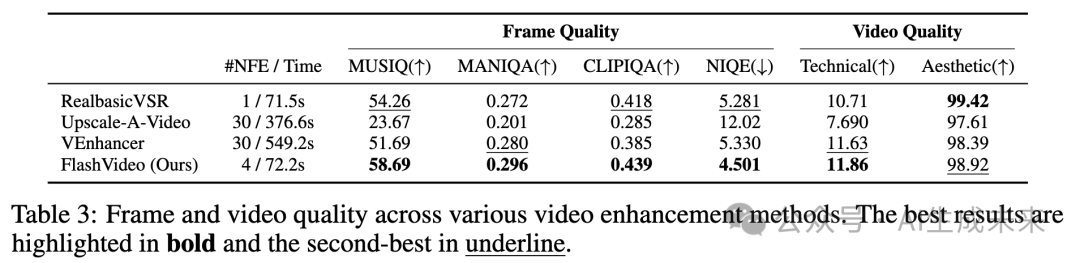

如下表 1 所示,8fps 和 24fps 模型都取得了超過 81 的高語義分?jǐn)?shù)。然而,僅使用第一階段模型時(shí),審美和成像質(zhì)量分?jǐn)?shù)低于頂級(jí)方法,270p 的得分分別為 60.47 和 61.39。應(yīng)用第二階段后,兩個(gè)質(zhì)量分?jǐn)?shù)顯著提高,分別達(dá)到了大約 62.29 和 66.21,如表 1 所示。這些結(jié)果驗(yàn)證了本文的方法,即在第一階段初步降低分辨率,以確保在較低計(jì)算成本下保持高提示保真度,隨后在第二階段進(jìn)行質(zhì)量提升。另一方面,整個(gè)功能評(píng)估只需約 2 分鐘,顯著優(yōu)于其他方法的效率。例如,Hunyuan Video使用一個(gè)較大的 13B 單階段模型,生成 720p(720 ×1280)結(jié)果的總評(píng)估時(shí)間為 1742 秒。相比之下,本文的方法不僅展示了更高的效率,還生成了更高分辨率的輸出。此外,用戶可以在僅 30 秒內(nèi)獲得 270p 的初步預(yù)覽,從而決定是否繼續(xù)進(jìn)行第二階段或調(diào)整輸入提示。這種靈活性顯著提升了用戶體驗(yàn)。

與視頻增強(qiáng)方法的比較

本節(jié)通過將第二階段方法與幾種最先進(jìn)的視頻增強(qiáng)方法進(jìn)行比較,全面評(píng)估其有效性。這些方法包括VEnhancer、Upscale-a-Video和RealBasicVSR 。本文的評(píng)估包括基于第一階段輸出的定量和定性分析。

為了進(jìn)行此評(píng)估,創(chuàng)建了一個(gè)精心挑選的測試集Texture100,該測試集包含100個(gè)多樣化的文本提示,描述了角色、動(dòng)物、織物、景觀等視覺元素。這些提示被用來生成低分辨率的6秒49幀視頻,作為視頻增強(qiáng)比較的輸入。

定量分析

如下表2所示,FlashVideo在各種質(zhì)量指標(biāo)上始終優(yōu)于競爭方法,展示了在視覺質(zhì)量和效率上的顯著優(yōu)勢。盡管RealBasicVSR(基于GAN的方法)在一些指標(biāo)上取得了有競爭力的結(jié)果,但其輸出常常表現(xiàn)出過度平滑,這可能與人類的感知偏好不一致。因此,建議將定量指標(biāo)視為補(bǔ)充參考,重點(diǎn)關(guān)注定性評(píng)估。

與此同時(shí),基于擴(kuò)散的VEnhancer展示了更強(qiáng)的生成能力,但它的輸出經(jīng)常與輸入視頻偏離,導(dǎo)致保真度受到損害。它的輸出通常經(jīng)歷了顯著的結(jié)構(gòu)性變化,這與我們?cè)鰪?qiáng)視覺質(zhì)量的設(shè)計(jì)原則相違背。此外,VEnhancer使用了獨(dú)立的空間-時(shí)間模塊和時(shí)間切片,這可能會(huì)減少在擴(kuò)展視頻序列中的內(nèi)容一致性——這是我們將在后續(xù)討論中進(jìn)一步探討的限制。另外,它的高NFE(網(wǎng)絡(luò)函數(shù)評(píng)估)導(dǎo)致了更大的計(jì)算開銷,使得高分辨率生成變得更加耗時(shí)。

與此相比,FlashVideo在速度上幾乎比VEnhancer快了七倍,同時(shí)生成更清晰的高頻細(xì)節(jié),如上表2所示。

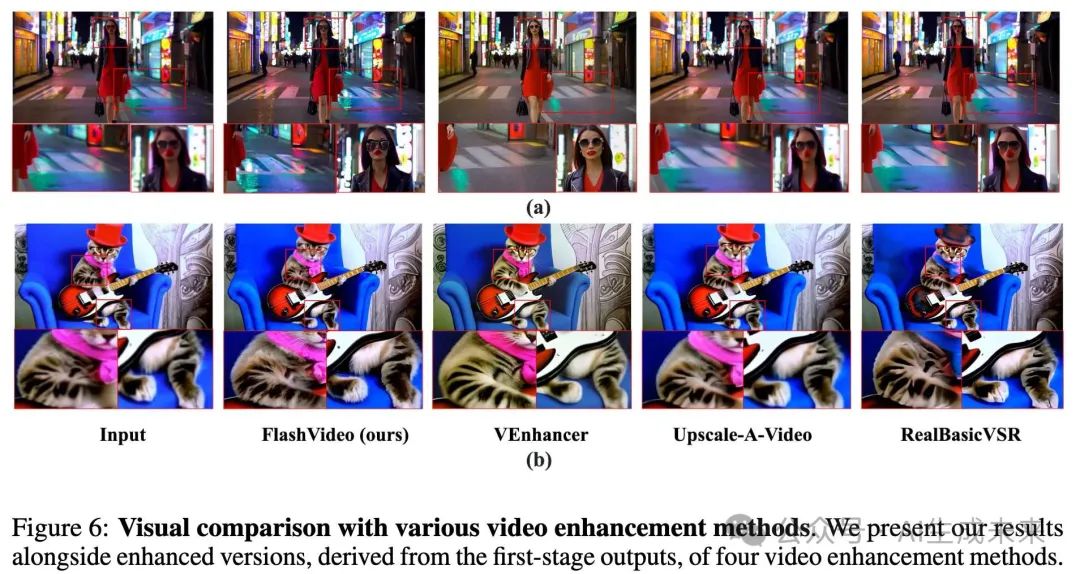

定性分析

下圖6和圖7提供了FlashVideo與其他方法的視覺質(zhì)量比較。

- 圖6 (a):這是一場展示女人面部和模糊背景的場景,突出了性能差異。本文的方法有效地重建了復(fù)雜的面部細(xì)節(jié),并通過高頻紋理豐富了背景,同時(shí)保持了結(jié)構(gòu)完整性和保真度。相比之下,VEnhancer提高了面部清晰度,但顯著改變了背景,失去了場景中重要的視覺元素,如“站立水域”和暗色調(diào)。其他方法,如Upscale-a-Video和RealBasicVSR未能糾正面部偽影,并引入了過度平滑,降低了逼真度。

- 圖6 (b):在這個(gè)案例中,F(xiàn)lashVideo增強(qiáng)了貓?bào)w上的紋理細(xì)節(jié),同時(shí)保持了原始輸入的一致性,并生成了更清晰的個(gè)體毛發(fā)。我們模型中的全注意力機(jī)制確保了內(nèi)容一致性,超越了VEnhancer,后者在細(xì)節(jié)上出現(xiàn)不一致。

- 圖7:在這個(gè)序列中,攝像機(jī)從遠(yuǎn)景過渡到近景,導(dǎo)致了顯著的運(yùn)動(dòng)和尺度變化。FlashVideo和VEnhancer在初始輸入上都顯示了改進(jìn)。然而,VEnhancer在保持面部身份方面遇到困難,并引入了夾克紋理和背景元素的不一致。FlashVideo有效地緩解了這些問題,確保了整個(gè)序列中的視覺質(zhì)量穩(wěn)定一致。

消融研究

本節(jié)進(jìn)行了一系列消融研究,以評(píng)估本文方法中的關(guān)鍵設(shè)計(jì)。首先,比較了LoRA微調(diào)與全參數(shù)微調(diào)在將第一階段適配到新分辨率時(shí)的優(yōu)勢。接著,評(píng)估了Stage II中RoPE的有效性。然后,我們?cè)敿?xì)描述了用于訓(xùn)練Stage II模型的低質(zhì)量視頻模擬策略。此外,還探討了將模型輸出與人類偏好對(duì)齊的重要性。最后,分析了不同推理超參數(shù)對(duì)最終性能的影響。

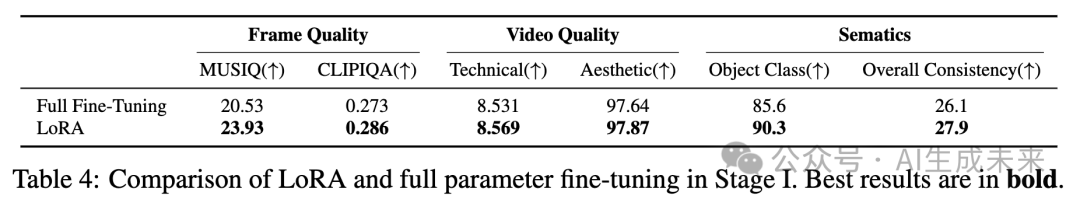

LoRA與全參數(shù)微調(diào)在第一階段的比較

在批量大小為32的設(shè)置中,將LoRA微調(diào)與全參數(shù)微調(diào)進(jìn)行了比較,目的是在相同的迭代次數(shù)下訓(xùn)練第一階段模型,并將其適配到270p分辨率。使用Texture100評(píng)估幀和視頻質(zhì)量,使用VBench-Long評(píng)估與語義相關(guān)的分?jǐn)?shù),如下表4所示。在這種配置下,全參數(shù)微調(diào)傾向于產(chǎn)生更多的偽影,導(dǎo)致視覺質(zhì)量和語義保真度的下降。相反,LoRA微調(diào)在有效適配到較低分辨率的同時(shí),保留了原始模型的生成能力。根據(jù)效率和性能的綜合考慮,選擇了LoRA策略。

第二階段中的位置嵌入

為了實(shí)現(xiàn)高效訓(xùn)練,首先在低分辨率下訓(xùn)練第二階段模型,然后在更高分辨率下應(yīng)用微調(diào)。此外,我們的目標(biāo)是使模型能夠生成比訓(xùn)練時(shí)使用的分辨率更高質(zhì)量的視頻。為了實(shí)現(xiàn)有效的分辨率泛化,我們探索了使用代表性的位置嵌入。具體而言,我們比較了來自2億DiT模型的默認(rèn)絕對(duì)位置嵌入 和旋轉(zhuǎn)位置嵌入(RoPE),發(fā)現(xiàn)RoPE在此類視頻增強(qiáng)任務(wù)中表現(xiàn)更優(yōu)。

使用兩種位置嵌入在540×960分辨率下訓(xùn)練模型,并在三個(gè)設(shè)置下進(jìn)行測試:540×960、1080×1920和1440×2560。對(duì)于更大的分辨率,我們使用位置嵌入外推。如下圖8所示,雖然兩種位置嵌入在訓(xùn)練分辨率下都能產(chǎn)生令人滿意的結(jié)果,但RoPE在推理更大分辨率時(shí)能夠始終增強(qiáng)細(xì)節(jié)。相比之下,絕對(duì)位置嵌入在超過訓(xùn)練分辨率時(shí)顯現(xiàn)出明顯的偽影。基于這些發(fā)現(xiàn),在訓(xùn)練第二階段模型時(shí)采用了RoPE。

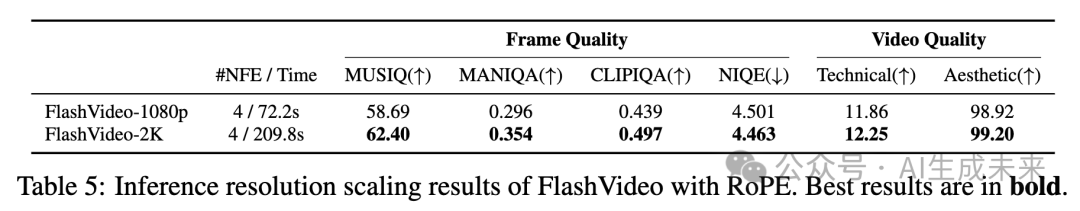

在使用RoPE訓(xùn)練完1080p(1080×1920)分辨率的模型后,我們進(jìn)一步擴(kuò)展推理分辨率到2K(1440×2560),并使用基于RoPE的外推方法。如下表5所示,本文的模型在2K分辨率下的視覺質(zhì)量有所提升,從視覺比較中可以觀察到。然而,推理時(shí)間顯著增加,從74.4秒增加到209.8秒。推測,更大的分辨率更好地激發(fā)了我們模型的細(xì)節(jié)生成能力,這與在大型語言模型中觀察到的推理擴(kuò)展規(guī)律相一致。

第二階段中的低質(zhì)量視頻模擬

本文通過視覺示例(見前面圖3)展示了在第二階段訓(xùn)練過程中,結(jié)合隱空間和像素降解模擬低質(zhì)量視頻的重要性。在本節(jié)中,提供了更為詳細(xì)的定量評(píng)估。

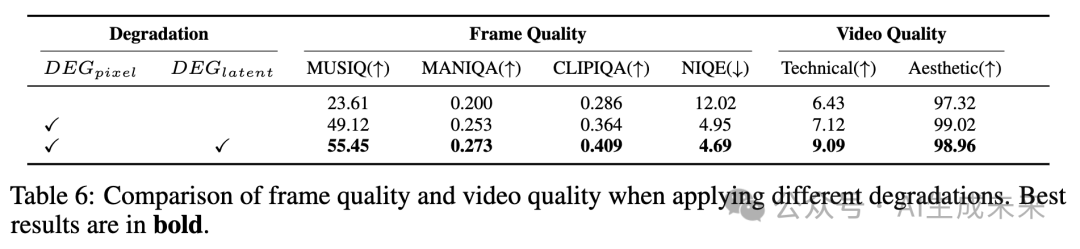

為了提高計(jì)算效率,使用5幀1080p視頻輸入進(jìn)行實(shí)驗(yàn)。訓(xùn)練了兩個(gè)模型,迭代10,000次:一個(gè)僅應(yīng)用像素降解,另一個(gè)同時(shí)應(yīng)用像素和隱空間降解。如下表6所示,基線表示第一階段的結(jié)果。當(dāng)在第二階段模型中應(yīng)用像素降解(DEGpixel)時(shí),第一階段的輸出得到了顯著改善,高頻紋理被加入,整體視覺質(zhì)量得到了提升。此外,結(jié)合隱空間降解(DEGlatent)進(jìn)一步增強(qiáng)了效果,產(chǎn)生了更清晰、更真實(shí)的小物體和背景細(xì)節(jié)。

第二階段中的人類偏好對(duì)齊

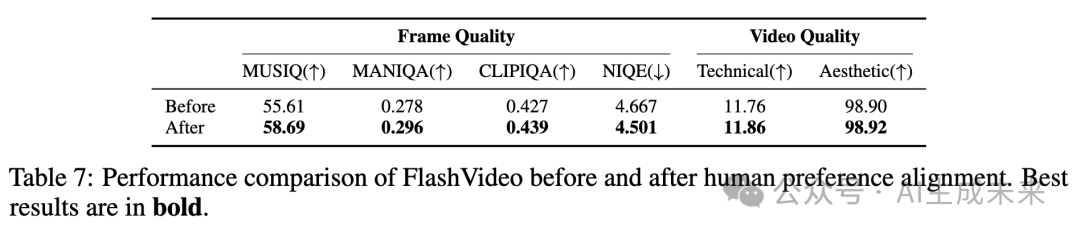

在實(shí)驗(yàn)中,1080p分辨率下的訓(xùn)練表現(xiàn)出不穩(wěn)定性,表現(xiàn)為不同檢查點(diǎn)(每500次迭代)間性能波動(dòng)。我們將這種不一致歸因于訓(xùn)練樣本質(zhì)量的變化。為了解決這個(gè)問題,我們手動(dòng)策劃了一個(gè)包含50,000個(gè)樣本的高質(zhì)量數(shù)據(jù)集,特別根據(jù)強(qiáng)烈的人類偏好選擇。我們的模型在這個(gè)精細(xì)化的數(shù)據(jù)集上進(jìn)行快速微調(diào),以穩(wěn)定訓(xùn)練并提高性能,然后在Texture100基準(zhǔn)上進(jìn)行評(píng)估,如下表7所示。盡管選定數(shù)據(jù)集的大小相對(duì)較小,但我們觀察到美學(xué)質(zhì)量和細(xì)節(jié)豐富度方面的顯著提升。這些結(jié)果突出了在微調(diào)過程中融入人類偏好的有效性。

推理超參數(shù)

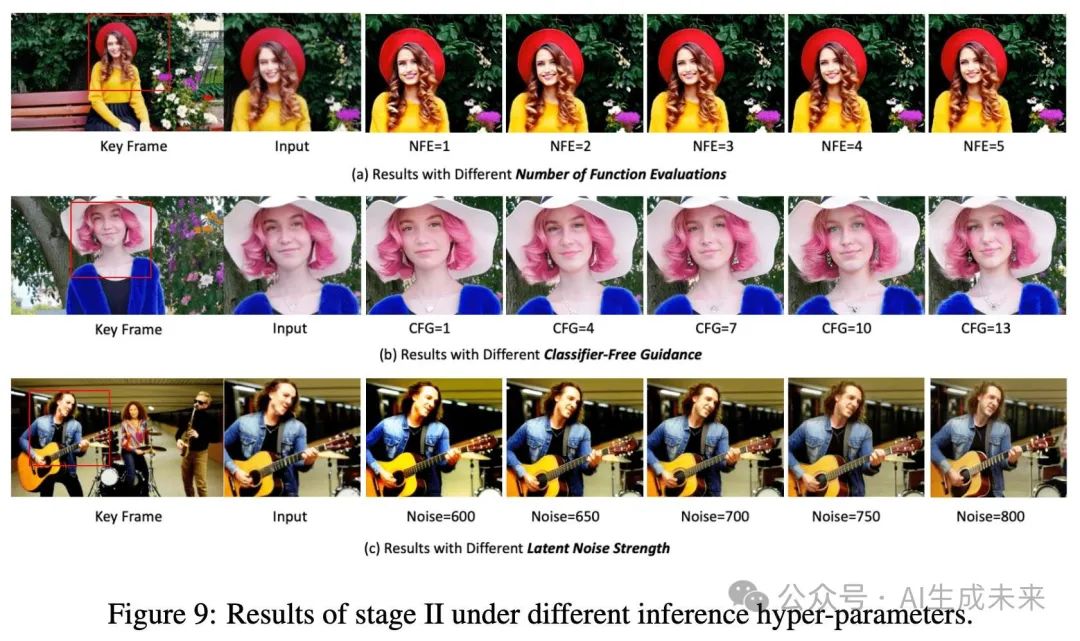

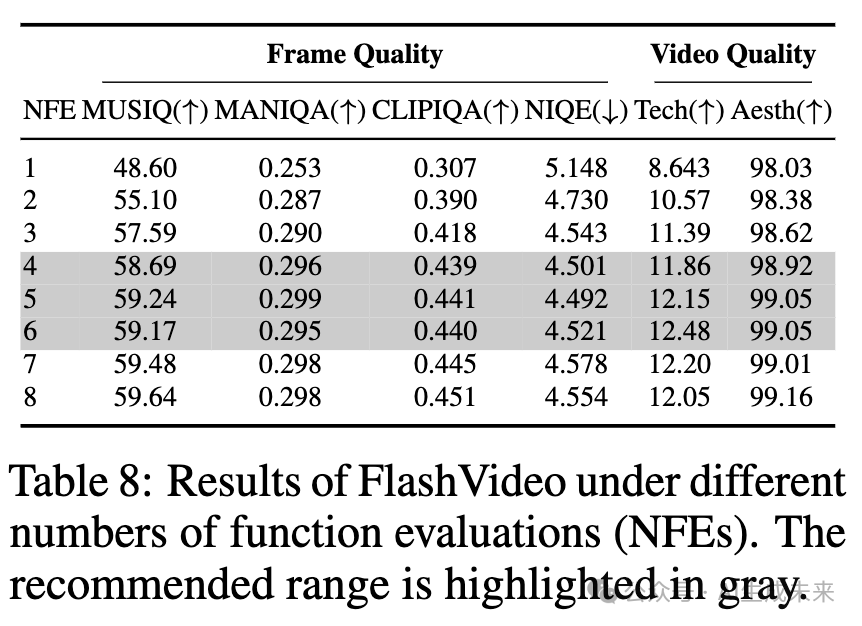

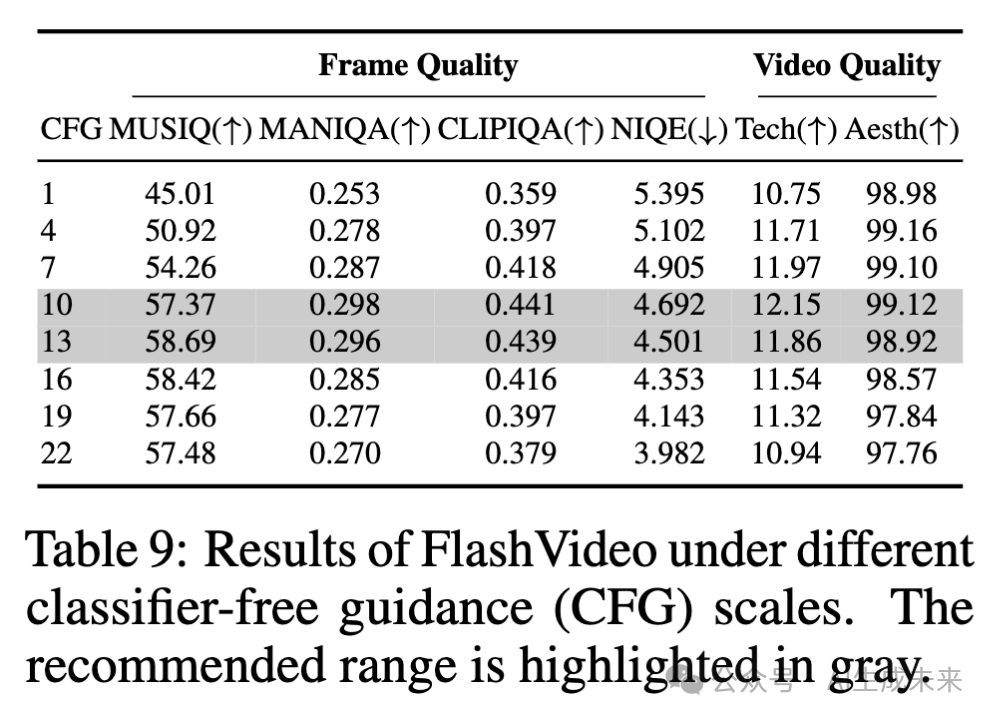

在測試階段,用戶可以靈活調(diào)整多個(gè)超參數(shù)——即函數(shù)評(píng)估次數(shù)(NFE)、無分類器引導(dǎo)(CFG)和隱空間降解強(qiáng)度(噪聲強(qiáng)度)——以滿足特定需求。在圖9中提供了這些超參數(shù)如何影響性能的詳細(xì)分析,并在表8、9和10中報(bào)告了相應(yīng)的質(zhì)量評(píng)分。除非另有說明,否則這些超參數(shù)的默認(rèn)值設(shè)置為NFE=4、CFG=13和NOISE=675。

函數(shù)評(píng)估次數(shù)(NFE)

如下圖9(a)所示,當(dāng)NFE=1時(shí),處理后的視頻呈現(xiàn)輕微的模糊感。增加NFE可以提高視覺質(zhì)量,面部細(xì)節(jié)更加清晰,例如牙齒和頭發(fā),樹葉和毛衣等元素的紋理更加銳利,在NFE=4時(shí)表現(xiàn)尤為明顯。當(dāng)NFE超過4時(shí)(即NFE=5或更高),大多數(shù)情況下增加該值不會(huì)帶來顯著的視覺提升。下表8中報(bào)告的某些指標(biāo)的定性結(jié)果驗(yàn)證了這一趨勢,與視覺觀察一致。建議用戶在實(shí)際使用中將NFE調(diào)整至4到6之間。

無分類器引導(dǎo)(CFG)

圖9(b)展示了CFG尺度的影響。當(dāng)CFG=1時(shí),結(jié)果仍然模糊,細(xì)節(jié)不足。隨著CFG值的增加,視頻內(nèi)容變得更加清晰且細(xì)節(jié)更為豐富,例如耳環(huán)等細(xì)節(jié)變得更加明顯。具體而言,CFG值在10到13之間可以獲得令人滿意的結(jié)果,能夠平衡銳度和細(xì)節(jié)。然而,CFG值超過13后,銳度過高,導(dǎo)致紋理顯得不自然。如下表9所示,隨著CFG從1增加到13,圖像和視頻質(zhì)量評(píng)分都有所提高,但當(dāng)CFG超過13時(shí),多個(gè)指標(biāo)的評(píng)分下降。

隱空間降解強(qiáng)度

隱空間降解強(qiáng)度通過公式2中的NOISE步驟量化,表示施加到第一階段視頻隱空間變量上的降解程度。如圖9(c)所示,在較低的降解水平下,增強(qiáng)后的視頻保持較高的與原始輸入的一致性。這種一致性有助于維持整體內(nèi)容的完整性,但可能會(huì)妨礙偽影的修復(fù),并限制細(xì)節(jié)的生成,如手指、吉他弦和表面紋理等。然而,增加噪聲強(qiáng)度有助于生成更多的視覺細(xì)節(jié),但如果噪聲過多,可能會(huì)扭曲結(jié)構(gòu)或引入模糊,這是由于第二階段生成能力的固有限制。在初始訓(xùn)練階段,使用了600-900的廣泛噪聲步長范圍。通過評(píng)估不同噪聲步長下的模型性能(如前面表10上部所示),發(fā)現(xiàn)650-750的范圍能夠獲得與視覺觀察一致的令人滿意的結(jié)果。因此,在后續(xù)訓(xùn)練階段,采用了更窄的范圍,最終性能如表10下部所示。

討論與局限性

討論

在這一部分,分享了一些洞見,旨在幫助讀者更清晰地理解我們工作設(shè)計(jì)原則和定位,并為隱空間的未來改進(jìn)提供指導(dǎo)。

隱空間降解強(qiáng)度的調(diào)整原則

選擇合適的隱空間降解強(qiáng)度對(duì)于訓(xùn)練Stage II模型至關(guān)重要。我們認(rèn)為,最小化偽影和保持原始內(nèi)容完整性之間的平衡是關(guān)鍵。我們建議根據(jù)信噪比(SNR)調(diào)整隱空間降解強(qiáng)度,即當(dāng)分辨率或視頻幀數(shù)增加時(shí),應(yīng)增加噪聲步長。值得注意的是,幀數(shù)對(duì)噪聲步長的影響大于分辨率,因?yàn)榭缍鄠€(gè)幀的視覺內(nèi)容展現(xiàn)出更強(qiáng)的相關(guān)性,不容易被干擾。例如,在初步實(shí)驗(yàn)中,當(dāng)使用17幀視頻時(shí),輸入中的偽影可以通過噪聲步長500得到糾正,而當(dāng)幀數(shù)增加到49幀時(shí),最佳噪聲范圍則為650到750,明顯高于前者。

保真度與視覺質(zhì)量提升的平衡

在維持保真度與提高視覺質(zhì)量之間存在微妙的平衡。與真實(shí)世界的視頻增強(qiáng)不同,輸入視頻通常缺乏高頻細(xì)節(jié),而第一階段生成的視頻往往包含一些微妙的結(jié)構(gòu)缺陷或偽影,需要進(jìn)一步修復(fù)。傳統(tǒng)的超分辨率方法專注于保持高保真度,無法有效地解決這些問題。相反,將第一階段輸出作為粗略指導(dǎo)并再生新內(nèi)容也無法達(dá)到理想效果,因?yàn)檫@與我們的設(shè)計(jì)理念相沖突。我們將第一階段的輸出視為低成本的預(yù)覽,它必須與最終結(jié)果密切對(duì)齊。為實(shí)現(xiàn)這一平衡,我們仔細(xì)調(diào)整了兩種策略的強(qiáng)度,確保在不妥協(xié)原始內(nèi)容完整性的情況下提高視覺質(zhì)量。

Stage II是否可以作為通用的視頻增強(qiáng)模型?

值得注意的是,目前的訓(xùn)練設(shè)置是專門為1080p設(shè)計(jì)的,不適合作為處理不同分辨率或幀數(shù)視頻的通用增強(qiáng)方法。然而,我們相信,隨著進(jìn)一步的優(yōu)化,例如引入關(guān)于分辨率和幀數(shù)的更多輸入信息,模型可以適應(yīng)處理更廣泛的場景。我們計(jì)劃在未來的工作中探索這一方向。

視頻長度增加帶來的挑戰(zhàn)

視頻增強(qiáng)比單張圖像處理更具挑戰(zhàn)性,因?yàn)樗枰_保在整個(gè)視頻序列中新增細(xì)節(jié)的一致性。這要求模型不僅要提高視覺質(zhì)量,還要管理跨幀的復(fù)雜視覺關(guān)系和運(yùn)動(dòng)。在Stage II中,通過采用3D全注意力機(jī)制和調(diào)整降解強(qiáng)度來解決這些挑戰(zhàn)。然而,隨著視頻長度的增加,3D全注意力的計(jì)算需求呈平方級(jí)增長。此外,如果降解強(qiáng)度沒有仔細(xì)調(diào)整,模型可能會(huì)通過直接引用多個(gè)幀來恢復(fù)細(xì)節(jié),從而在推理過程中妥協(xié)其生成能力。

Stage II中的稀疏注意力

可視化了Stage II中的注意力圖,發(fā)現(xiàn)空間上的稀疏性特別顯著,相較于時(shí)間上的稀疏性。我們將這一現(xiàn)象歸因于當(dāng)前第一階段輸出中的適度運(yùn)動(dòng)強(qiáng)度。為減少Stage II的計(jì)算成本,應(yīng)用了FlexAttention,通過實(shí)現(xiàn)基于窗口的時(shí)空注意力(H=11, W=11, T=7)。結(jié)果表明,當(dāng)?shù)谝浑A段的輸出包含低運(yùn)動(dòng)時(shí),該方法具有顯著提高的效率表現(xiàn)。然而,當(dāng)運(yùn)動(dòng)較大時(shí),我們觀察到再生的視覺細(xì)節(jié)存在不一致和模糊的情況。建議,未來的工作可以通過根據(jù)運(yùn)動(dòng)強(qiáng)度動(dòng)態(tài)調(diào)整窗口大小來解決這一問題。

兩階段的分辨率無論是在第一階段(從270p到360p,結(jié)果見補(bǔ)充材料)還是在第二階段(從1080p到2K),提高分辨率都會(huì)改善我們的結(jié)果。在足夠的計(jì)算資源下,可以在兩個(gè)階段都追求更高的分辨率。選擇270p作為第一階段的分辨率,是因?yàn)樗軌蛟趦H30秒的時(shí)間內(nèi)生成初步結(jié)果,使用戶能夠迅速評(píng)估是否需要在Stage II中進(jìn)行進(jìn)一步計(jì)算。這相比于當(dāng)代方法具有明顯的優(yōu)勢。

局限性

高分辨率視頻的VAE解碼耗時(shí)

由于GPU內(nèi)存限制,解碼1080p視頻需要進(jìn)行空間和時(shí)間切片,這一過程十分耗時(shí)。并行處理的工程進(jìn)展以及更高效的VAE架構(gòu)對(duì)于加速高分辨率視頻的生成至關(guān)重要。

推理時(shí)的長文本提示

訓(xùn)練中采用的文本描述通常較長且詳細(xì),這可能增加用戶在推理時(shí)提供提示的復(fù)雜性。未來的研究可以通過聯(lián)合訓(xùn)練短文本提示或使用專門用于提示重寫的語言模型來改進(jìn)。這一進(jìn)展能夠顯著提升用戶體驗(yàn)。

快速運(yùn)動(dòng)的挑戰(zhàn)由于數(shù)據(jù)量、質(zhì)量和多樣性的限制,Stage II可能在處理快速運(yùn)動(dòng)的視頻時(shí)失敗。隱空間的解決方案包括增加更多包含大運(yùn)動(dòng)的數(shù)據(jù)和擴(kuò)大模型容量。

結(jié)論

FlashVideo,一種新穎的兩階段框架,分別優(yōu)化了提示保真度和視覺質(zhì)量。這種解耦使得模型能力和函數(shù)評(píng)估次數(shù)(NFE)能夠在兩個(gè)分辨率之間進(jìn)行策略性分配,從而大大提高了計(jì)算效率。在第一階段,F(xiàn)lashVideo優(yōu)先考慮低分辨率下的保真度,利用較大的參數(shù)和足夠的NFE;第二階段則在低分辨率和高分辨率之間進(jìn)行流匹配,利用較少的NFE有效生成細(xì)節(jié)。大量實(shí)驗(yàn)和消融研究驗(yàn)證了我們方法的有效性。此外,F(xiàn)lashVideo能夠在極低成本下提供初步結(jié)果,使用戶能夠決定是否繼續(xù)進(jìn)入增強(qiáng)階段。這一決策能力可以顯著降低用戶和服務(wù)提供商的成本,具有巨大的商業(yè)價(jià)值。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來