看懂網(wǎng)飛版「三體」!Reka Core登場:挑戰(zhàn)GPT-4、Claude 3

多模態(tài)語言模型又雙叒叕上新了!

近日,由DeepMind、谷歌和Meta的研究人員創(chuàng)立的AI初創(chuàng)公司Reka,推出了他們最新的多模態(tài)語言模型——Reka Core。

它被譽(yù)為該公司「最大、最有能力」的模型,在性能上與GPT-4和Claude 3 Opus不相上下!

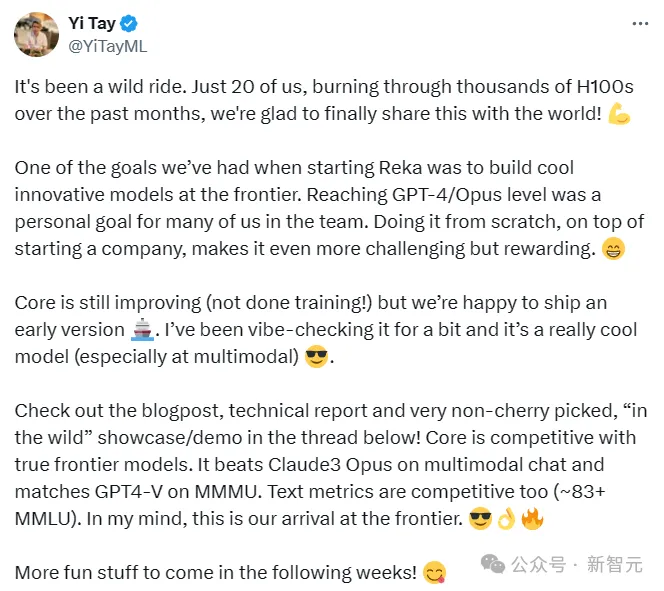

Reka的首席科學(xué)家兼聯(lián)合創(chuàng)始人Yi Tay興奮地表示,過去幾個(gè)月,該公司使用了「數(shù)千臺H100」來開發(fā)Reka Core。

能夠達(dá)到GPT-4或Opus的水平是研究團(tuán)隊(duì)中許多人的目標(biāo)。

從頭開始訓(xùn)練模型來與OpenAI的GPT-4和Claude 3 Opus相媲美無疑是一項(xiàng)壯舉。

目前Core仍在改進(jìn),在后續(xù)的時(shí)間里,興許會有更多有趣的內(nèi)容陸續(xù)推出!

對于這個(gè)新推出的模型,網(wǎng)友們叫好聲一片~

還有網(wǎng)友看了官方發(fā)布的視頻后驚嘆:這莫不就是傳說中的AGI,有點(diǎn)迫不及待了!!!

Core是Reka語言模型系列中的第三個(gè)成員,由多個(gè)來源訓(xùn)練而成,包括公開數(shù)據(jù)、授權(quán)數(shù)據(jù)以及涵蓋文本、音頻、視頻和圖像文件的合成數(shù)據(jù)。

它能夠理解圖像、音頻和視頻等多種模式的數(shù)據(jù)內(nèi)容。

最重要的是,盡管只用了不到一年的時(shí)間就完成了訓(xùn)練,但它的性能卻可以媲美或超越人工智能領(lǐng)域領(lǐng)先的頂級模型。

雖然Reka Core的確切參數(shù)數(shù)量尚未披露,但該公司首席執(zhí)行官Dani Yogatama認(rèn)為它是一個(gè)「非常龐大的模型」(上一個(gè)模型Reka Flash有210億個(gè)參數(shù))。

Core還支持32種語言和128,000個(gè)詞組的上下文窗口,這也就讓該模型在處理長篇文檔方面具備了極強(qiáng)的優(yōu)勢。

可以說,Core是繼谷歌的Gemini Ultra之后第二個(gè)涵蓋從文本到視頻等所有數(shù)據(jù)模式并且能夠提供高質(zhì)量輸出的模型了。

此外,Yogatama還表示,研究團(tuán)隊(duì)正在訓(xùn)練Core以進(jìn)一步提高其性能,同時(shí)也在開發(fā)下一個(gè)版本,并且表示該公司沒有開源該技術(shù)的計(jì)劃。

技術(shù)細(xì)節(jié)

訓(xùn)練數(shù)據(jù)

訓(xùn)練數(shù)據(jù)由公開可用和專有/許可數(shù)據(jù)集組成,其中包括包括文本、圖像、視頻和音頻剪輯,獲取數(shù)據(jù)的截止日期為2023年11月。

雖然并未對語料庫的內(nèi)容進(jìn)行嚴(yán)格意義上的分類,但預(yù)訓(xùn)練數(shù)據(jù)中大約25%的數(shù)據(jù)是與代碼相關(guān)的,30%的數(shù)據(jù)是與STEM相關(guān)。

其中約有25%的數(shù)據(jù)是網(wǎng)絡(luò)爬取獲得的并且約10%的數(shù)據(jù)跟數(shù)學(xué)相關(guān)。

總體混合率一般遵循優(yōu)先考慮獨(dú)特標(biāo)記的原則,但會根據(jù)數(shù)量有限的小規(guī)模消融產(chǎn)生的信號進(jìn)行人工調(diào)整

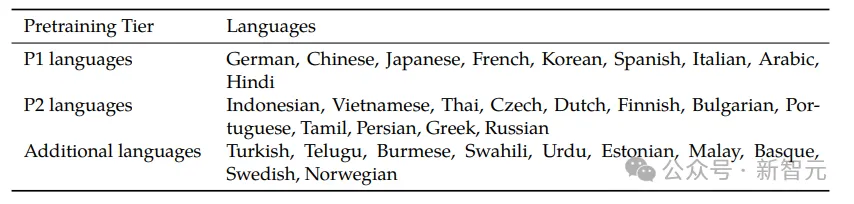

預(yù)訓(xùn)練數(shù)據(jù)中大約15%是明確的多語言數(shù)據(jù),由32種不同的語言按分層加權(quán)組成。

除了這些明確加權(quán)的語言之外,為了讓大多數(shù)語言都有基準(zhǔn)性能,研究團(tuán)隊(duì)還在包含110種語言的維基百科上進(jìn)行訓(xùn)練。

模型架構(gòu)

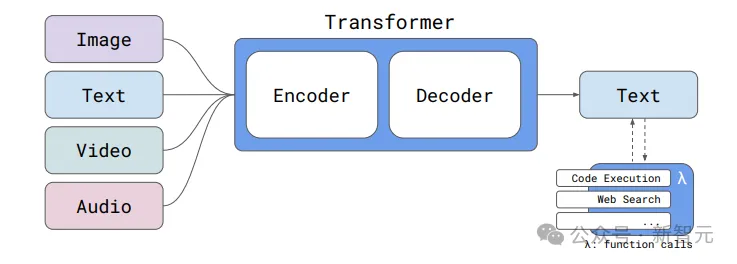

Reka模型架構(gòu)是一個(gè)模塊化的編碼器-解碼器架構(gòu),支持文本、圖像、視頻 和音頻輸入。目前,我們的模型僅支持文本輸出。

模型主要使用Pytorch在Nvidia H100上進(jìn)行訓(xùn)練。

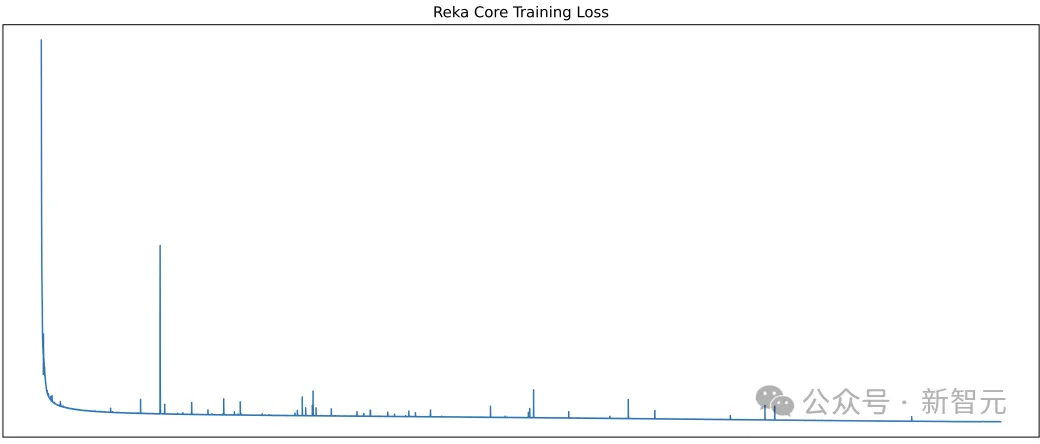

研究團(tuán)隊(duì)表示,盡管訓(xùn)練過程學(xué)習(xí)率非常高,但損失峰值很少,因此模型預(yù)訓(xùn)練過程相對比較順利。

后訓(xùn)練(Post-Training)

經(jīng)過預(yù)訓(xùn)練后,模型使用強(qiáng)正則化技術(shù)對多個(gè)epoch進(jìn)行指令調(diào)整。

對于SFT,研究團(tuán)隊(duì)使用混合數(shù)據(jù)集進(jìn)行訓(xùn)練,其中包括他們的專有數(shù)據(jù)和公開數(shù)據(jù)。

SFT之后,使用RLHF方法進(jìn)行對齊。

此外,在后訓(xùn)練過程中,研究人員還考慮了工具使用、函數(shù)調(diào)用和網(wǎng)絡(luò)搜索等內(nèi)容。

性能亮點(diǎn)

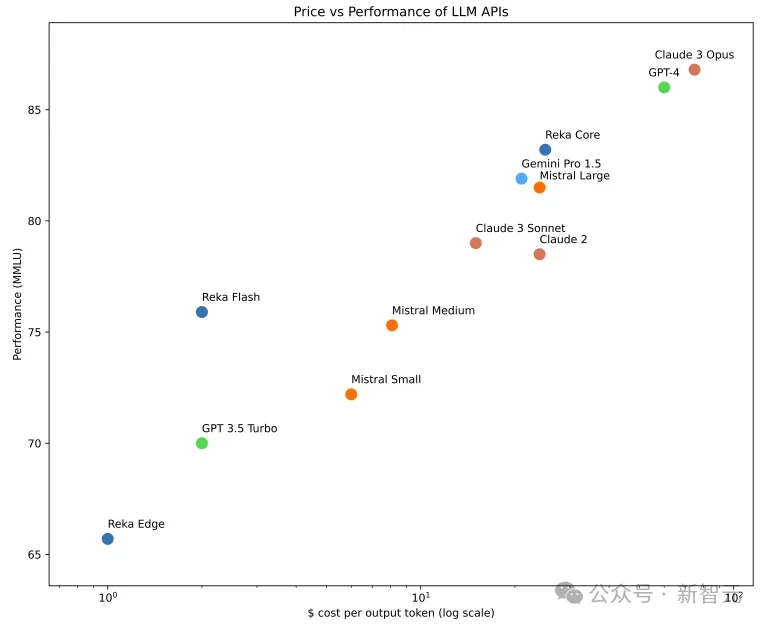

在業(yè)界公認(rèn)的關(guān)鍵評估指標(biāo)方面,Core與OpenAI、Anthropic和谷歌的模型相比具有很強(qiáng)的競爭力。

考慮到它的模型大小和性能,從總體成本的角度來看,Core能帶來巨大的價(jià)值。

Core擁有強(qiáng)大功能的同時(shí),部署也十分靈活,由此開啟了大量新的應(yīng)用案例。

在視頻感知測試中,Core的表現(xiàn)遠(yuǎn)遠(yuǎn)超過其唯一的競爭對手Gemini Ultra(59.3 分對 54.7 分)。

同時(shí),在針對圖像任務(wù)的MMMU基準(zhǔn)測試中,Core以56.3的得分緊隨GPT-4(56.8)、Claude 3 Opus(59.4)、Gemini Ultra(59.4)和 Gemini Pro 1.5(58.5)之后。

即使在其他基準(zhǔn)測試中,Core也能媲美行業(yè)領(lǐng)先模型。

例如,在知識任務(wù)的MMLU測試中,它獲得了83.2分,緊隨GPT-4、Claude 3 Opus和Gemini Ultra之后。

在推理的GSM8K基準(zhǔn)測試和編碼的HumanEval測試中,它分別以92.2分和76.8分擊敗了GPT-4。

下表總結(jié)了Core與目前市場上領(lǐng)先模型的比較。

模型能力

1. 多模態(tài)(圖像和視頻)理解

Core 不僅僅是一個(gè)前沿的大型語言模型,它對圖像、視頻和音頻具有強(qiáng)大的上下文理解能力,是僅有的兩個(gè)商用綜合多模態(tài)解決方案之一。

2. 128K上下文窗口

Core能夠攝取并精確準(zhǔn)確地調(diào)用更多信息。

3. 推理能力

Core在語言或者數(shù)學(xué)方面具有出色的推理能力,使其適用于需要精密分析的復(fù)雜任務(wù)。

4. 編碼和代理工作流

Core是頂級代碼生成器。它的編碼能力與其他功能相結(jié)合時(shí),可以增強(qiáng)代理工作流程的能力。

5. 支持多種語言

Core是在32種語言的文本數(shù)據(jù)上進(jìn)行的預(yù)訓(xùn)練,因此,它能說流利的英語以及好幾種亞洲和歐洲的語言。

6. 部署靈活性

與Reka其他型號的模型(Flash和Edge)一樣,Core可通過API、本地或設(shè)備部署,以滿足客戶和合作伙伴的部署限制。

本文轉(zhuǎn)自 新智元 ,作者:新智元