入口控制:多智能體強化學習在自動駕駛中的應用研究 精華

隨著自動駕駛技術的快速發展,人們對于自主車輛的期待也在不斷提高。然而,盡管現有的技術已經能夠實現車輛在高速公路上的自動駕駛,以及無人駕駛出租車在主要城市開始運營,技術上所謂的“L5”全自動駕駛仍未完全實現。實現這一目標需要解決多個技術難題,其中之一便是提供能夠在高速公路匝道入口安全、可靠運行的全自動控制功能。

現階段的自動駕駛技術雖然取得了顯著進展,但仍面臨許多挑戰。社會普遍認為自動駕駛汽車需要比人類駕駛更安全、更不易出錯,實現這一目標并非易事。近期隨著對自動駕駛技術的審查力度增加,一些大公司已經削減了開發資金并關閉了相關技術合作伙伴關系。此外,公眾對于自動駕駛技術的信任度下降,呼吁加強監管的聲音日益高漲。這些都表明當前的自動駕駛技術在實際應用中仍存在諸多不足,需要進一步優化和改進。

在這樣的背景下,來自Flex 和密歇根大學的研究團隊開啟多智能體深度強化學習(MA DRL)在高速公路匝道入口控制中的應用。通過博弈論和多智能體方法,他們希望實現車輛在合并到主路交通流中的自主控制,最大限度地減少碰撞風險。特別是他們使用基于深度強化學習的控制器,在虛擬環境中通過自我對弈的方式,讓合并車輛學習如何在匝道入口的漸變式合并過程中控制縱向位置,從而確保其安全性和穩健性。11 月 24 日,他們的論文《A Systematic Study of Multi-Agent Deep Reinforcement Learning for Safe and Robust Autonomous Highway Ramp Entry》發表于arXiv 學術交流平臺。

研究團隊由來自Flex的Larry Schester和密歇根大學迪爾伯恩分校的Luis E. Ortiz組成。Larry Schester在全球領先的技術制造服務公司Flex工作,擁有豐富的自動駕駛和智能系統領域的經驗。而Luis E. Ortiz則是密歇根大學迪爾伯恩分校的教授,在多智能體系統和機器學習方面有著深厚的研究背景。兩位研究人員的專業知識和實踐經驗為本研究提供了堅實的基礎。

自動駕駛的挑戰

一直以來,行業內對自動駕駛技術的質疑聲不斷增強,并且監管也在逐步加強。近年來多起涉及自動駕駛汽車的事故,引發了公眾和監管機構對其安全性的擔憂。這些事故不僅損害了公眾對自動駕駛技術的信任,也促使政府加大了對自動駕駛技術的審查和監管力度。例如,一些重大公司在意識到自動駕駛技術面臨的挑戰后,撤回了資金支持,暫停了相關項目。此外由于自動駕駛汽車在事故發生時的責任界定問題尚未解決,一旦發生事故,制造商通常將責任歸咎于駕駛員,進一步引發了對其安全性的質疑。

自動駕駛技術在實際應用中也暴露出許多不足之處。當前,大多數自動駕駛系統仍依賴于遠程人類操作來處理復雜和緊急情況,顯示出技術在完全自主駕駛方面的局限性。特別是在高速公路匝道入口等高風險場景下,自動駕駛系統需要應對多種動態交通狀況,這對其感知、決策和控制能力提出了極高的要求。此外,現有的技術標準和測試方法尚未完全覆蓋所有潛在的交通場景和突發情況,導致自動駕駛汽車在面對復雜路況時表現出不穩定性。

改進方向包括進一步優化自動駕駛系統的算法和控制器,以提高其在各種交通環境中的表現。同時,加強對自動駕駛技術的測試和驗證,特別是在真實世界中的測試,以確保其在不同場景下的安全性和可靠性。此外,需要完善相關的法律法規,明確自動駕駛汽車在事故中的責任界定,為其大規模應用創造有利的法律環境。

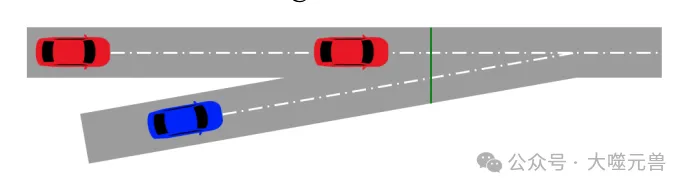

圖1:三車高速公路合并:目標線為綠色。Ego合并車輛(藍色)和兩輛交通車輛(紅色)。

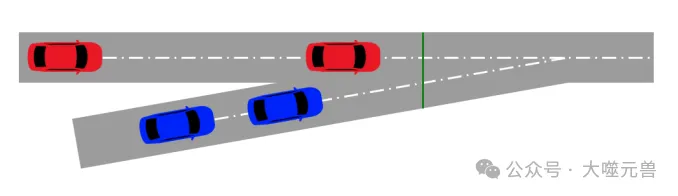

圖2:全場景高速公路合并:兩輛車在合并車道上,兩輛或更多輛車在行車道上。

入口控制的研究方法

在探索自動駕駛技術的多智能體深度強化學習(MA DRL)應用時,研究團隊采用了一些前沿的方法和技術。

博弈論是研究戰略性互動的數學方法,它在多智能體系統中尤為重要。博弈論幫助分析智能體(在本研究中為自動駕駛車輛)之間的競爭和合作關系,以便找到最佳策略。在高速公路匝道入口場景中,每輛車(智能體)都需要決定如何調整速度和位置,以便在不發生碰撞的情況下順利并入主路交通流。這種情境下,博弈論提供了理論基礎,幫助智能體預估其他車輛的動作,并做出相應的決策。

多智能體系統涉及多個獨立智能體,這些智能體彼此之間可以進行通信、協調和競爭。在自動駕駛的應用中,多智能體系統可以模擬復雜的交通環境,每個智能體都能根據實時信息和預測調整其行為,以實現整體最優的交通流。通過這種方法,可以更好地理解和優化車輛在高速公路匝道入口的合并行為。

深度強化學習(DRL)結合了深度學習和強化學習的優勢,使得智能體能夠通過與環境的交互學習最優策略。在自動駕駛中,DRL被廣泛應用于解決各種復雜的控制和決策問題。DRL的核心思想是通過獎勵和懲罰機制,引導智能體學習一系列動作,以最大化累計獎勵。

在高速公路匝道入口控制中,DRL的優勢在于其能夠處理高維度的輸入數據,并且能在動態環境中進行自適應學習。通過使用深度神經網絡,DRL能夠從大量的傳感器數據中提取關鍵特征,并學習到復雜的非線性映射關系,從而實現對車輛行為的精確控制。這使得自動駕駛系統能夠在復雜的交通環境中進行實時決策,提高行駛的安全性和穩定性。

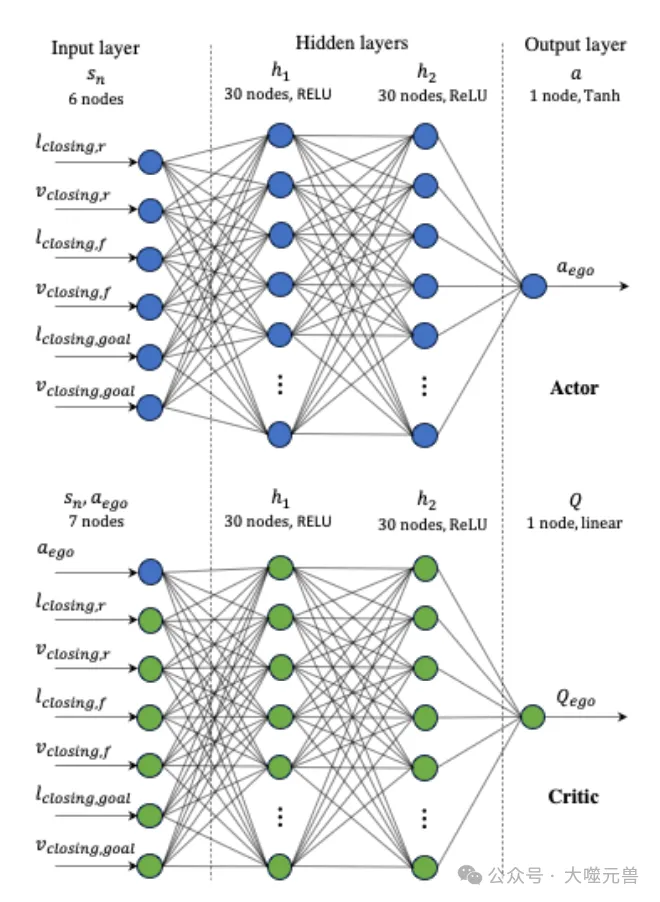

本研究中使用了深度確定性策略梯度(DDPG)算法,這是DRL的一種,該算法特別適用于連續動作空間。DDPG通過actor-critic架構,分別優化策略網絡(actor)和價值網絡(critic),從而實現對智能體行為的高效學習與優化。

為了驗證多智能體深度強化學習在高速公路匝道入口控制中的有效性,研究團隊在虛擬環境中進行了自我對弈訓練及數據模擬。虛擬環境提供了一個安全且可控的測試平臺,智能體可以在其中不斷嘗試和調整策略,以適應不同的交通狀況。

在自我對弈訓練中,智能體通過模擬與其他車輛(智能體)的互動,不斷學習和改進其控制策略。每個智能體在訓練過程中通過自我對弈(self-play),模擬真實交通場景,積累經驗數據。在每個訓練步驟中,智能體根據當前狀態采取行動,并根據環境反饋更新其策略。這種訓練方式不僅提高了智能體的學習效率,還增強了其對復雜交通場景的適應能力。

通過自我對弈訓練,研究團隊能夠生成大量的模擬數據,這些數據用于訓練深度強化學習模型。模擬數據的使用不僅減少了真實車輛測試的風險和成本,還可以在短時間內測試和優化各種可能的交通情景和策略。虛擬環境中的自我對弈訓練為實現安全、可靠的高速公路匝道入口控制提供了堅實的基礎。

三車輛仿真實驗

在本研究中,為了驗證多智能體深度強化學習(MA DRL)在高速公路匝道入口控制中的有效性,研究團隊設計了一系列三車輛仿真實驗。這些實驗旨在通過模擬不同的交通場景,評估自動駕駛車輛的控制策略,并確保其在復雜環境中能夠安全、穩健地運行。

圖3:三個車輛參與者-評論家神經網絡圖。

實驗設計

三車輛仿真實驗模型包括合并車道上的一輛“自合并車輛”(ego vehicle)和交通車道上的兩輛“交通車輛”(traffic vehicles)。此模型旨在模擬高速公路匝道入口的典型場景,其中自合并車輛必須在應對前后交通車輛的同時,避免與其他車輛發生碰撞。

實驗設置的主要參數包括匝道長度、車輛加速度范圍以及初始位置和速度等。在仿真中,匝道長度設置為256米,這是美國交通運輸部推薦的高速公路匝道長度。所有車輛的加速度范圍為-5至4米每秒平方(??/??2),這些參數能夠真實模擬車輛在匝道入口的動態行為。

狀態變量與獎勵函數的詳細介紹

在仿真實驗中,狀態變量用于描述自合并車輛和交通車輛的狀態。這些狀態變量包括閉合間隙、閉合速度等,它們能夠準確反映車輛相對于其他車輛和目標位置的距離和速度。例如,自合并車輛的狀態集合包括與后方交通車輛、前方交通車輛和目標位置相關的閉合間隙和閉合速度。

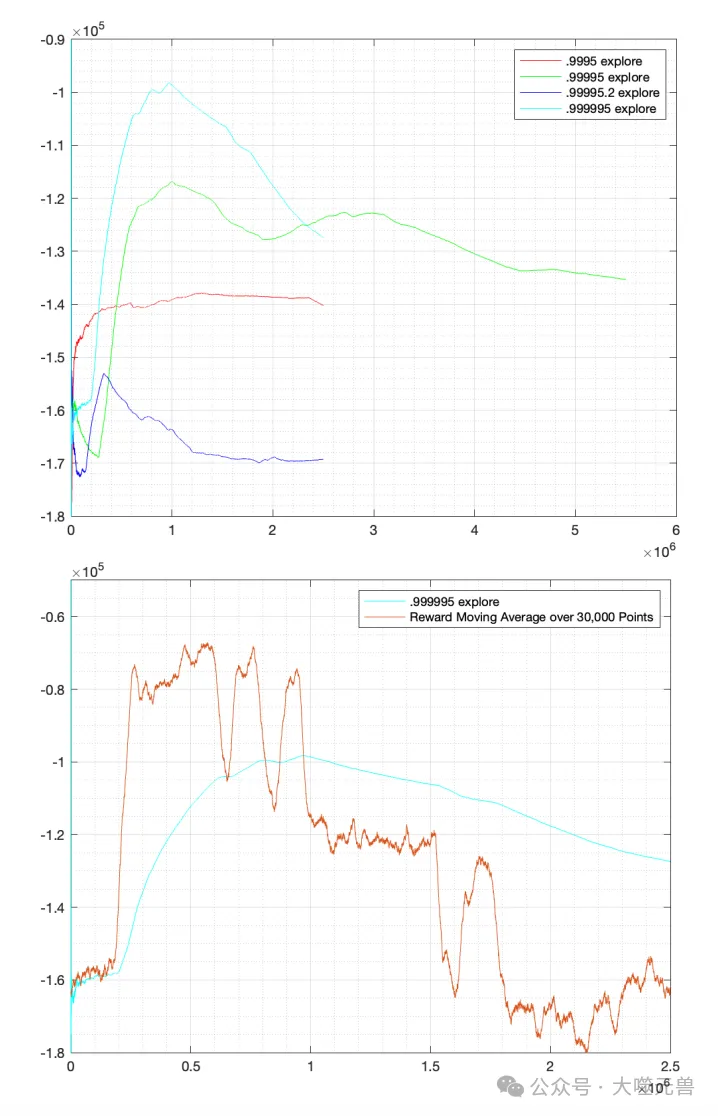

圖4:頂部:四個單獨勘探值的累積獎勵平均值。底部:最佳變量的累積獎勵平均值和移動平均值:0.999995探索。

獎勵函數在強化學習中起著關鍵作用,它指導智能體(自動駕駛車輛)采取合適的行動以最大化累計獎勵。在本研究中,獎勵函數對不同的行為給予不同的獎勵或懲罰。例如,加速和減速動作會受到小的懲罰,成功合并則會得到較大的獎勵,而發生碰撞則會受到更大的懲罰。具體來說,成功合并的獎勵為103,碰撞的懲罰在-10?到-10?之間,加速或減速的任何動作都根據其大小受到懲罰。這種設計的目的是為了讓算法學到自動駕駛應比人類駕駛更安全,并盡量減少碰撞。

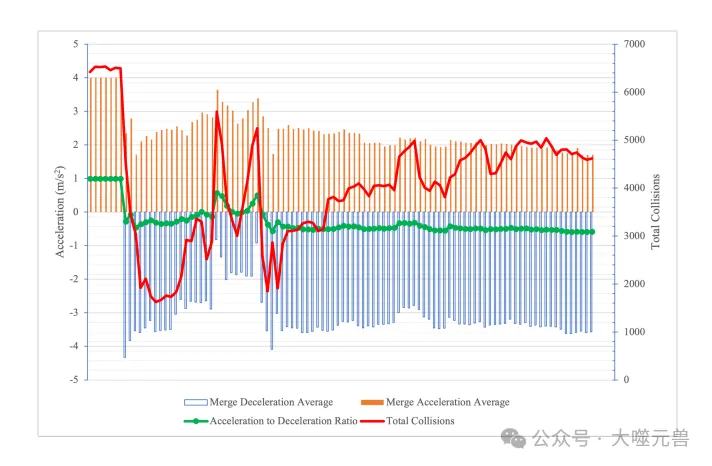

圖5:三輛車場景的標準測試性能,數據按訓練順序排序。藍色和橙色條表示每個測試實例的平均減速度和加速度。綠線是加速和減速發生之間的差異。紅線是次軸(右),表示總碰撞。水平軸值表示以25??的間隔進行的測試。

訓練過程及控制器的性能表現

在三車輛仿真實驗中,深度確定性策略梯度(DDPG)強化學習算法用于訓練自合并車輛的神經網絡控制器(NN)。DDPG是一種適用于連續動作空間的算法,通過actor-critic架構,分別優化策略網絡(actor)和價值網絡(critic)。訓練過程中,自合并車輛在每一劇集的每一步都更新其NN控制器,根據當前狀態采取行動,并根據環境反饋不斷改進其策略。

仿真訓練總共進行250萬劇集,但最佳表現大約在35萬劇集。訓練過程中,智能體的表現會有所波動,但總體上會逐漸提高并達到峰值。在訓練初期,智能體會嘗試各種不同的策略,以找到最優解。當訓練達到一定階段時,智能體的表現趨于穩定,累積獎勵在一個較小的波動范圍內穩定下來。

控制器的性能通過標準測試進行評估。在測試中,智能體需要在不同的初始條件和交通情境下進行操作,以驗證其在真實交通場景中的表現。標準測試結果顯示,使用DRL訓練的控制器能夠有效避免碰撞,并在復雜交通環境中表現出較高的穩健性。

標準測試結果分析:碰撞避免與獎勵機制

通過對標準測試結果的分析,可以看出使用深度強化學習訓練的控制器在不同交通情境下的表現。智能體在碰撞避免方面表現出色,能夠在大多數情況下成功合并進入交通流。

在標準測試中,智能體的成功率與初始條件和交通情境密切相關。例如,在間隙較大的情況下,自合并車輛更容易找到合適的合并時機,從而避免碰撞。而在間隙較小時,智能體需要更精細的控制策略,以確保安全合并。實驗結果還表明,獎勵函數的設計在智能體的學習過程中起到重要作用。通過給予成功合并較大的獎勵和碰撞較大的懲罰,智能體能夠學到有效的控制策略,最大限度地減少碰撞風險。

在實際應用中,這種基于深度強化學習的控制策略有助于提高自動駕駛系統在復雜交通環境中的安全性和可靠性。未來,通過進一步優化模型和訓練方法,可以進一步提高控制器的性能,并推廣到更廣泛的自動駕駛應用中。

三車輛仿真實驗驗證了多智能體深度強化學習在高速公路匝道入口控制中的有效性。通過精確的狀態變量描述和合理的獎勵函數設計,智能體能夠學到有效的控制策略,并在復雜交通環境中表現出較高的安全性和穩健性。這為實現全自動駕駛提供了重要的理論支持和實踐基礎。

全場景仿真實驗

在探索多智能體深度強化學習(MA DRL)在高速公路匝道入口控制中的應用時,研究團隊設計并實施了全場景仿真實驗。這些實驗旨在驗證在更復雜交通環境中,多車輛模型的表現,以及所訓練控制器的性能和可靠性。

實驗設計

全場景仿真實驗模型比三車輛仿真更加復雜,包含了兩個合并車道的車輛和多個交通車道的車輛。這種設計更加接近實際高速公路的交通狀況,旨在模擬真實環境中的多車互動與合并行為。研究團隊通過系統性地擴展道路場景,加入額外的交通和自合并車輛,構建了這一多智能體場景。

實驗中的自合并車輛必須同時處理前后交通車輛的動態變化,并避免碰撞。設置的主要參數包括車道數量、車輛間距、加速度范圍和初始速度等。實驗中,所有車輛的加速度范圍仍然設置為-5至4米每秒平方(??/??2),以確保仿真結果的可比性。

控制器的訓練與性能表現

與三車輛仿真類似,全場景仿真實驗也采用了深度確定性策略梯度(DDPG)強化學習算法訓練控制器。在這個設置中,兩輛合并車道的自合并車輛在每一劇集的每一步都更新其神經網絡控制器(NN),而所有具有反應策略的交通車輛也在每一步更新其控制器。訓練過程中,自合并車輛和交通車輛的NN使用不同的權重參數,以適應各自的控制需求。

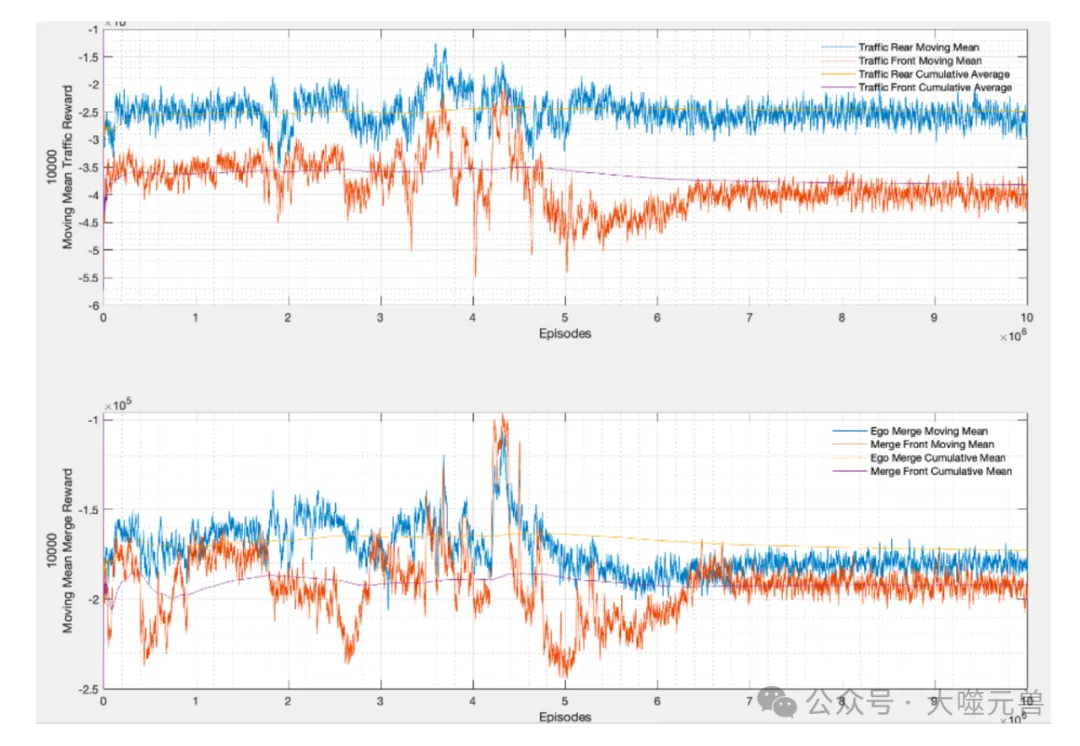

圖6:移動平均和累積訓練圖。平均獎勵。在7??事件附近,合并和交通車輛的加速動作都會持續選擇-5??/??的動作極限值2加速度,不考慮狀態值。

圖6顯示了前后合并車輛和交通車輛的累積獎勵和移動平均訓練圖。在訓練過程中,累積獎勵值隨著訓練的進行逐漸提高,并在達到峰值后趨于穩定。實驗結果表明,最佳性能出現在訓練到4.2至4.5百萬劇集之間,訓練總計達到10百萬劇集。在達到最佳性能后,控制器的表現趨于穩定,累積獎勵在一個較小的波動范圍內保持穩定。

值得注意的是,在訓練的早期階段,智能體的表現會有所波動,但總體上會逐漸提高并達到峰值。隨著訓練的進行,累積獎勵值趨于穩定,表明智能體已經學會了在復雜交通環境中采取合適的控制策略。

標準測試結果分析

為了評估所訓練控制器在實際交通情境中的表現,研究團隊進行了標準測試。在測試中,使用了不同的間隙設置,包括5米、15米和25米,以模擬各種不同的初始條件和交通狀況。

測試結果表明,所訓練的控制器在不同間隙設置下的表現各異。總體來看,間隙較大的情況下(例如15米和25米),自合并車輛能夠更容易地找到合適的合并時機,從而避免碰撞。在這些情況下,控制器表現出接近最佳的性能。然而,在間隙較小的情況下(例如5米),自合并車輛需要更加精確的控制策略才能成功合并,碰撞的風險也相對較高。

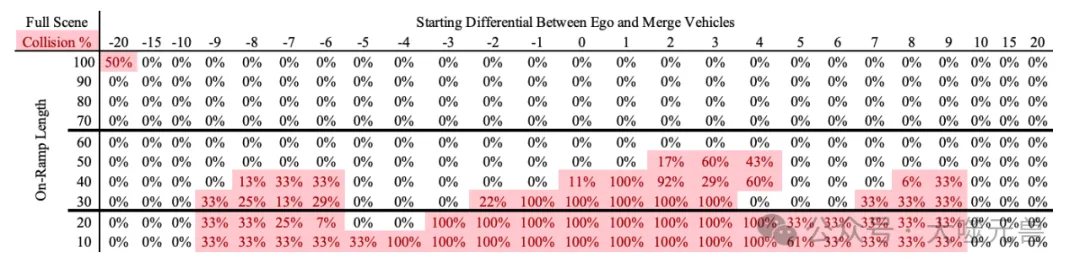

圖7:全場景碰撞測試表。恒定和隨機策略標準測試表,具有5??、15 ??和25 ??的多個間隙設置。

圖7顯示了全場景仿真中的隨機和恒定策略測試結果。在每個標準測試劇集中,交通車道的車輛使用相同的策略(恒定、反應或隨機),以評估控制器在不同策略下的性能。測試結果表明,即使在復雜的全場景仿真中,所訓練的控制器仍能夠有效避免碰撞,并表現出較高的魯棒性。

在總結這些結果時,可以看出全場景仿真實驗成功驗證了多智能體深度強化學習在高速公路匝道入口控制中的應用潛力。通過在更復雜的交通環境中進行測試,研究團隊證明了其所設計的控制器能夠在實際交通情境中保持良好的性能和穩健性。這為進一步推廣和應用多智能體深度強化學習技術提供了重要的理論依據和實踐經驗。未來,通過進一步優化模型和訓練方法,可以進一步提高控制器的性能,并推廣到更廣泛的自動駕駛應用中。

結果與討論

在分析多智能體深度強化學習(MA DRL)在高速公路匝道入口控制中的應用效果時,研究團隊進行了三車輛和全場景兩種仿真實驗。通過對這兩種實驗結果的比較和分析,可以深入理解不同交通情境下的控制策略及其表現。

三車輛仿真實驗模擬的是一個較為簡單的場景,包括一輛自合并車輛和兩輛交通車輛。在這種設置中,自合并車輛僅需應對前后兩輛交通車輛,控制策略相對單一。實驗結果顯示,自合并車輛在多數情況下能夠成功合并,避免與其他車輛發生碰撞。該實驗驗證了MA DRL在處理較簡單交通場景時的有效性。

相比之下,全場景仿真實驗包含了更多的交通車輛,情境更加復雜。兩個合并車道的車輛和多個交通車道的車輛使得控制策略的復雜性顯著增加。在這種設置中,自合并車輛不僅需要處理更多的交通車輛,還需要應對車道內的車輛動態變化。實驗結果表明,即使在復雜的全場景仿真中,所訓練的控制器仍然能夠有效避免碰撞,并表現出較高的魯棒性。

通過對比這兩種實驗可以發現,全場景仿真實驗的控制策略更為復雜,但其結果更接近實際交通狀況。研究團隊通過系統性地增加交通和自合并車輛,驗證了MA DRL在更復雜環境中的應用效果,從而證明了其在實際應用中的潛力。

研究結果表明,多智能體深度強化學習在高速公路匝道入口控制中具有顯著的優勢。通過訓練,智能體能夠學習到在不同交通情境下的最優控制策略,從而提高車輛合并的成功率和安全性。特別是在復雜的全場景仿真實驗中,所訓練的控制器展示了較高的魯棒性和可靠性,這為未來自動駕駛技術的應用提供了有力支持。

此外研究還發現,獎勵函數的設計在智能體的學習過程中起到了關鍵作用。通過合理的獎勵和懲罰機制,可以引導智能體學習到有效的控制策略,從而最大限度地減少碰撞風險。這一發現為進一步優化自動駕駛系統的設計提供了重要參考。

盡管研究結果令人鼓舞,但現有模型仍存在一些局限性,需要進一步優化。首先,訓練過程中智能體的表現會出現波動,可能是由于隨機初始化和訓練參數設置造成的。為了提高模型的穩定性,可以考慮使用更先進的優化算法和參數調整方法。

當前的仿真實驗主要基于虛擬環境,雖然提供了安全、可控的測試平臺,但與實際交通環境仍有差距。未來的研究應更多地關注真實世界中的測試和驗證,以確保所設計的控制策略在不同交通情境下都能可靠運行。

研究還可以擴展到更多維度,例如考慮不同天氣條件、道路狀況和駕駛行為對控制策略的影響。此外,進一步探索多智能體系統之間的協同控制,以實現更高效的交通流和更安全的駕駛體驗,也將是未來研究的重要方向。

總體而言,本研究通過深入分析三車輛和全場景仿真實驗,驗證了多智能體深度強化學習在高速公路匝道入口控制中的應用效果。研究結果不僅為提升自動駕駛技術的安全性和可靠性提供了重要支持,也為未來的優化方向和實際應用提供了寶貴的經驗和啟示。通過持續的研究和改進,相信多智能體深度強化學習將在自動駕駛領域發揮越來越重要的作用,為實現安全、高效的智能交通系統做出更大貢獻。(END)

參考資料:https://arxiv.org/pdf/2411.14593

本文轉載自 ??大噬元獸??,作者: FlerkenS