3D任意部位分割:FIND 3D模型實(shí)現(xiàn)零樣本開放世界文本查詢分割 原創(chuàng) 精華

在3D世界中,尋找任何物體的一部分聽起來像是科幻小說中的情節(jié),但加州理工學(xué)院的Ziqi Ma、Yisong Yue和Georgia Gkioxari卻將其變成了現(xiàn)實(shí)。他們開發(fā)的FIND 3D模型,不僅能夠根據(jù)任何文本查詢分割任何物體的任何部分,還能在開放世界中零距離應(yīng)用。想象一下,你只需說“汽車的輪子”,F(xiàn)IND 3D就能精確地找到并分割出這個(gè)部分,無論是從網(wǎng)絡(luò)上的3D資產(chǎn),還是從iPhone拍攝的照片中重建的3D模型。

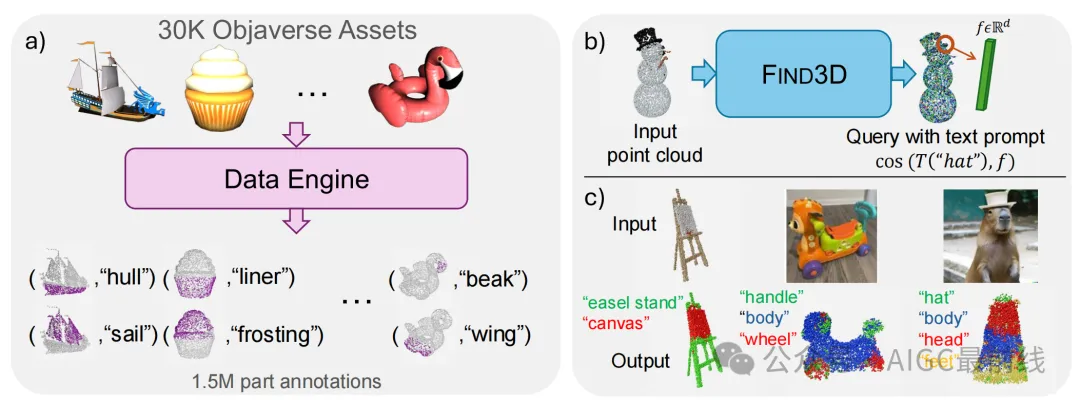

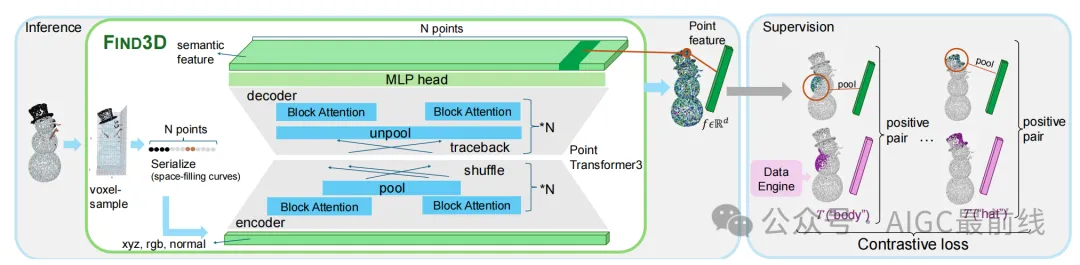

FIND 3D的背后是一個(gè)由2D基礎(chǔ)模型(如SAM和Gemini)驅(qū)動(dòng)的數(shù)據(jù)引擎,它能夠自動(dòng)從網(wǎng)絡(luò)上的3D資產(chǎn)中進(jìn)行標(biāo)注。通過這些標(biāo)注數(shù)據(jù),F(xiàn)IND 3D訓(xùn)練了一個(gè)基于transformer的點(diǎn)云模型,并采用對(duì)比訓(xùn)練方法,使其在多個(gè)數(shù)據(jù)集上表現(xiàn)出色,mIoU(平均交并比)比現(xiàn)有最佳方法提高了3倍。

這個(gè)模型的應(yīng)用前景廣闊,從機(jī)器人到VR/AR,都需要精確的3D物體及其部分的定位。FIND 3D不僅能夠處理一般的物體類別和部分查詢,還能在推理速度上比現(xiàn)有方法快6到300倍。為了推動(dòng)開放世界3D部分分割的研究,他們還發(fā)布了一個(gè)包含多樣物體和部分的基準(zhǔn)。

FIND 3D的誕生,不僅是技術(shù)上的突破,更是對(duì)未來3D理解和交互方式的一次大膽想象。正如他們所說,我們離一個(gè)理解3D世界的基石模型還有多遠(yuǎn)?FIND 3D給出了一個(gè)令人振奮的答案。在3D世界中尋找任何部分聽起來像是科幻小說中的情節(jié),但FIND 3D模型讓它變成了現(xiàn)實(shí)。這個(gè)模型不僅能夠根據(jù)任何文本查詢來分割任何對(duì)象的任何部分,還能在零樣本的情況下應(yīng)用于任何對(duì)象。想象一下,你只需要說“給我找到那輛車的輪子”,模型就能精確地標(biāo)記出輪子的位置,是不是很神奇?

FIND 3D的核心在于它的數(shù)據(jù)引擎和對(duì)比訓(xùn)練方法。數(shù)據(jù)引擎利用2D基礎(chǔ)模型自動(dòng)標(biāo)注來自網(wǎng)絡(luò)的3D資產(chǎn),而對(duì)比訓(xùn)練方法則幫助模型處理部分層次和模糊性。這種結(jié)合使得模型在多個(gè)數(shù)據(jù)集上表現(xiàn)出色,甚至在mIoU(平均交并比)上比現(xiàn)有最佳方法提高了3倍。

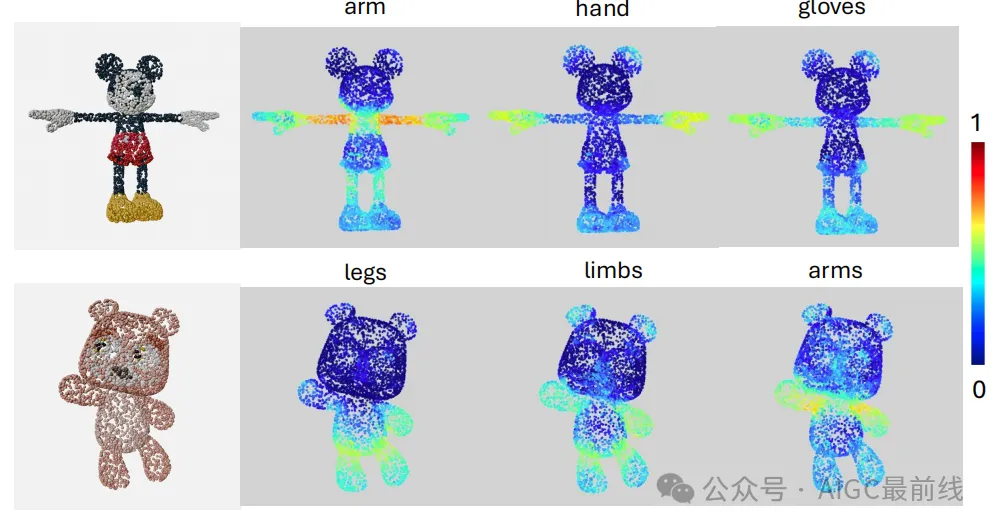

但FIND 3D的魔力不止于此。它還能處理各種查詢類型,無論是“手”還是“手套”,都能準(zhǔn)確找到對(duì)應(yīng)的部分。而且,它還能在各種旋轉(zhuǎn)和數(shù)據(jù)域變化下保持魯棒性,甚至在從iPhone照片或AI生成的圖像中重建的3D點(diǎn)云上也能表現(xiàn)出色。

當(dāng)然,F(xiàn)IND 3D也有它的局限性,比如在處理非常細(xì)小的部分時(shí)可能會(huì)有些吃力。但總體來說,它無疑是3D部分分割領(lǐng)域的一大進(jìn)步,為機(jī)器人和VR/AR應(yīng)用提供了強(qiáng)大的支持。

圖:FIND 3D模型的整體示意圖

數(shù)據(jù)引擎

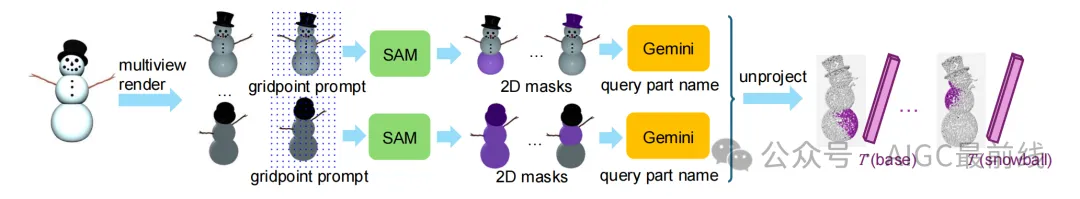

數(shù)據(jù)引擎利用SAM和Gemini模型自動(dòng)標(biāo)注Objaverse中的3D資產(chǎn)。首先,對(duì)每個(gè)對(duì)象進(jìn)行10次渲染,并使用Gemini選擇最佳方向。然后,將所有渲染結(jié)果傳遞給SAM進(jìn)行分割,并使用Gemini為每個(gè)掩碼命名。最后,將掩碼映射到點(diǎn)云中的點(diǎn),并將標(biāo)簽文本嵌入到預(yù)訓(xùn)練模型的潛在嵌入空間中,生成(點(diǎn),文本嵌入)對(duì)。數(shù)據(jù)引擎處理了36044個(gè)高質(zhì)量對(duì)象,最終獲得了30K個(gè)帶標(biāo)注的對(duì)象,涵蓋761個(gè)類別和150萬個(gè)部分標(biāo)注。

圖:數(shù)據(jù)引擎

開放世界3D部分模型

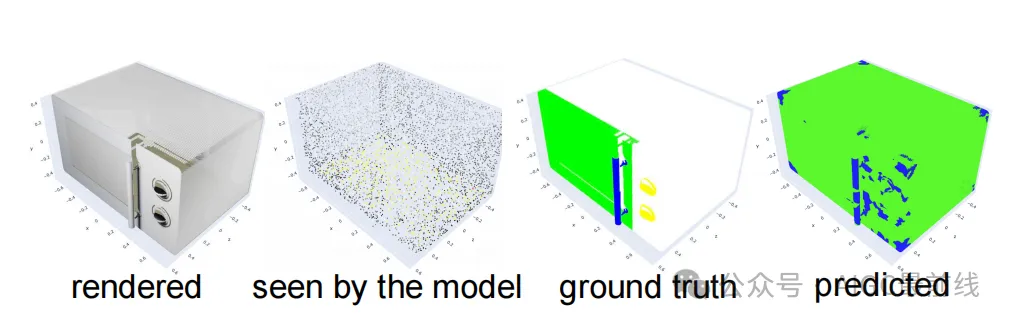

FIND 3D模型接收點(diǎn)云輸入,并返回每個(gè)點(diǎn)的語義特征,這些特征可以通過余弦相似度與任何自由形式的文本查詢進(jìn)行查詢。模型首先將文本查詢嵌入到SigLIP文本編碼器中,然后計(jì)算每個(gè)點(diǎn)與文本查詢的余弦相似度。為了生成3D分割,模型將每個(gè)點(diǎn)分配給余弦相似度最高的文本查詢,如果所有查詢的相似度分?jǐn)?shù)均為負(fù),則分配“無標(biāo)簽”。

圖:FIND 3D:開放世界部分分割模型

實(shí)驗(yàn)設(shè)置

基準(zhǔn)測(cè)試

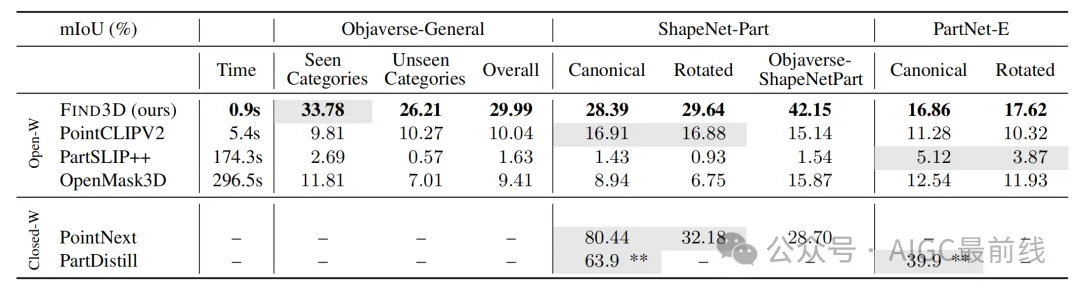

除了自建的基準(zhǔn)測(cè)試外,還在ShapeNet-Part和PartNet-E數(shù)據(jù)集上進(jìn)行了評(píng)估。ShapeNet-Part包含16個(gè)對(duì)象類別,PartNet-E結(jié)合了PartNet和PartNet-Mobility,包含45個(gè)家用對(duì)象類別。對(duì)這兩個(gè)數(shù)據(jù)集的測(cè)試集進(jìn)行了評(píng)估,包括在規(guī)范姿態(tài)和隨機(jī)旋轉(zhuǎn)姿態(tài)下的評(píng)估。

評(píng)估指標(biāo)

報(bào)告了類別平均交并比(mIoU)作為評(píng)估指標(biāo),即所有標(biāo)注部分在所有對(duì)象類別上的平均IoU。

競(jìng)爭(zhēng)方法

比較了現(xiàn)有的最先進(jìn)的開放世界和封閉世界3D分割方法,包括PointCLIPV2、PartSLIP++、OpenMask3D、PointNeXt和PartDistill。

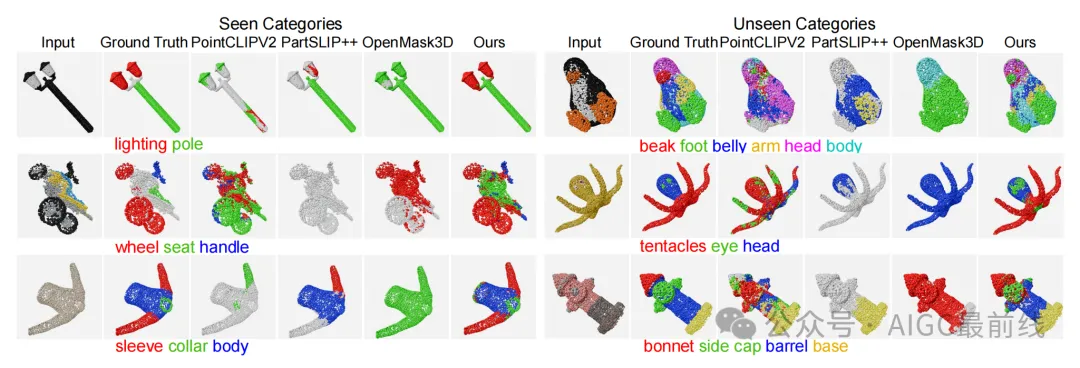

實(shí)驗(yàn)結(jié)果

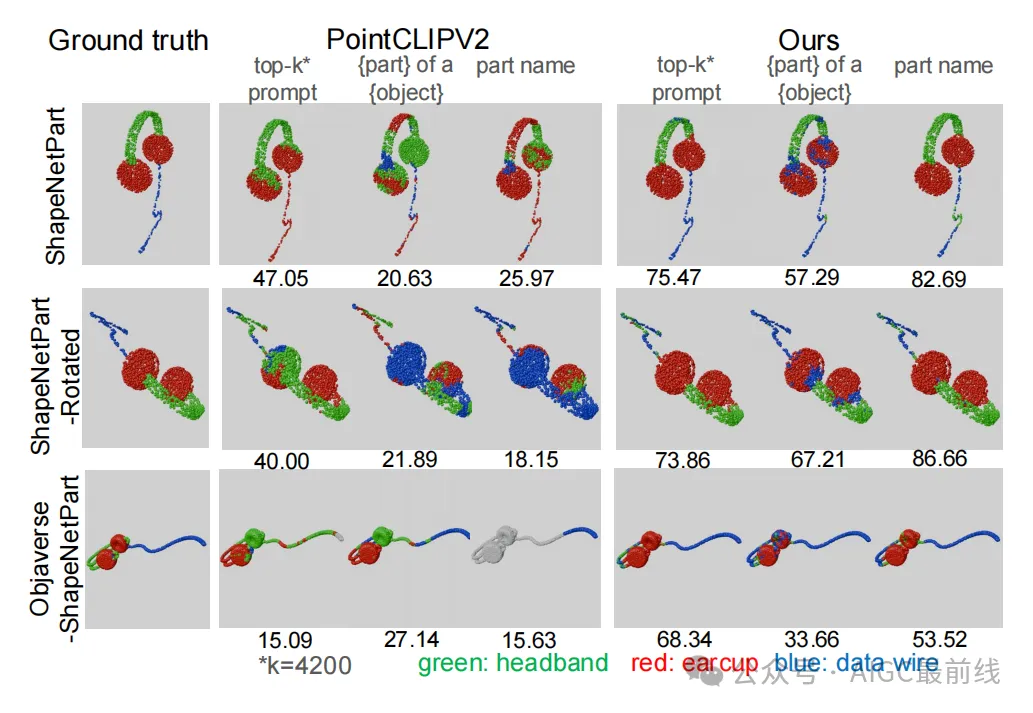

FIND 3D在通用對(duì)象類別上表現(xiàn)出色,無論是已見類別還是未見類別,均取得了比第二好的方法高出3倍的mIoU。模型展示了強(qiáng)大的分布外泛化能力,并且在基線方法表現(xiàn)不佳的數(shù)據(jù)集上表現(xiàn)優(yōu)異。此外,F(xiàn)IND 3D在推理速度上比開放詞匯基線方法快6到300倍。

圖:在Objaverse-General基準(zhǔn)測(cè)試上的定性結(jié)果

表:在Objaverse-General、ShapeNet-Part和PartNet-E上的性能比較

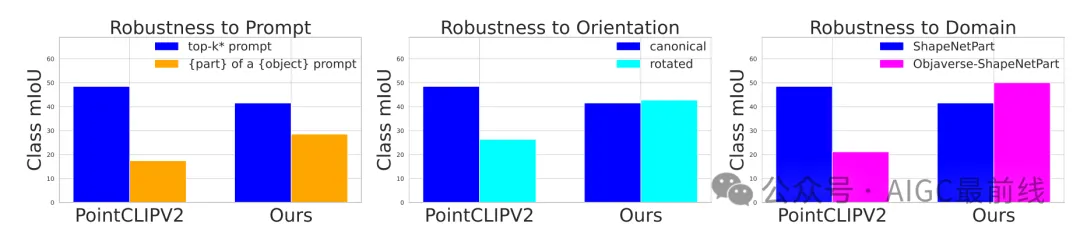

魯棒性評(píng)估

FIND 3D對(duì)查詢文本提示的變化、對(duì)象方向的變化以及數(shù)據(jù)域的變化表現(xiàn)出較強(qiáng)的魯棒性。相比之下,基線方法對(duì)這些變化較為敏感。

圖:PointCLIPV2和FIND 3D的魯棒性比較

圖:在所有ShapeNet-Part類別上的魯棒性評(píng)估

野外結(jié)果

FIND 3D能夠分割從iPhone照片或DALL-E生成的圖像重建的3D點(diǎn)云,展示了其在實(shí)際應(yīng)用中的潛力。此外,模型支持各種查詢類型,展示了其在查詢粒度和描述風(fēng)格上的靈活性。

圖:本方法支持靈活的文本查詢

失敗模式

FIND 3D在處理幾何上不顯著的細(xì)粒度部分(如表面上的按鈕)時(shí)存在局限性。此外,由于模型訓(xùn)練為旋轉(zhuǎn)等變,它傾向于對(duì)所有對(duì)稱部分做出相同的預(yù)測(cè)。

圖:失敗示例

總結(jié)與展望

在計(jì)算機(jī)視覺領(lǐng)域,3D對(duì)象的開放世界部分分割一直是一個(gè)具有挑戰(zhàn)性的問題。傳統(tǒng)的分割方法往往局限于特定的對(duì)象類別或部分詞匯,無法靈活地處理任意對(duì)象和任意文本查詢。然而,隨著人工智能技術(shù)的飛速發(fā)展,尤其是2D圖像理解模型的顯著進(jìn)步,我們看到了構(gòu)建開放世界3D部分分割模型的可能性。

本文介紹的FIND 3D模型,正是這一領(lǐng)域的重大突破。FIND 3D不僅能夠基于任意文本查詢對(duì)任意3D對(duì)象的任意部分進(jìn)行分割,而且通過結(jié)合2D基礎(chǔ)模型(如SAM和Gemini)的數(shù)據(jù)引擎,實(shí)現(xiàn)了對(duì)大規(guī)模互聯(lián)網(wǎng)3D資產(chǎn)的自動(dòng)標(biāo)注。這一創(chuàng)新的數(shù)據(jù)引擎與對(duì)比訓(xùn)練方法相結(jié)合,使得FIND 3D在多個(gè)數(shù)據(jù)集上表現(xiàn)出色,其mIoU(平均交并比)比現(xiàn)有最佳方法提升了3倍。

FIND 3D的強(qiáng)大之處不僅在于其性能的顯著提升,還在于其對(duì)未見類別的出色泛化能力。該模型在處理通用對(duì)象類別時(shí),無論是已見類別還是未見類別,均表現(xiàn)出卓越的性能。此外,F(xiàn)IND 3D在推理速度上也遠(yuǎn)超現(xiàn)有方法,最高可達(dá)300倍的加速。這些優(yōu)勢(shì)使得FIND 3D在機(jī)器人和VR/AR應(yīng)用中具有巨大的潛力,能夠?yàn)榫_操作、交互和空間感知提供強(qiáng)有力的支持。

展望未來,F(xiàn)IND 3D的成功為開放世界3D部分分割的研究開辟了新的方向。首先,結(jié)合2D和3D模態(tài)以捕捉那些在3D幾何中不顯著但在2D圖像中易于感知的部分,將是一個(gè)值得探索的方向。其次,隨著訓(xùn)練數(shù)據(jù)和模型參數(shù)的進(jìn)一步擴(kuò)展,我們有望揭示開放世界3D分割的縮放規(guī)律,從而進(jìn)一步提升模型的性能和泛化能力。

總之,F(xiàn)IND 3D不僅為3D對(duì)象的開放世界部分分割提供了一個(gè)強(qiáng)大的解決方案,也為未來的研究奠定了堅(jiān)實(shí)的基礎(chǔ)。我們期待這一領(lǐng)域的持續(xù)發(fā)展,并鼓勵(lì)讀者常來我們的公眾號(hào)學(xué)習(xí),共同探索3D視覺的無限可能。

本文轉(zhuǎn)載自公眾號(hào)AIGC最前線 作者: 不是小馬哥啊