字節提出新一代數據集COCONut,比COCO粒度分割更密集

隨著人工智能的發展,語言模型和生成模型獲得了大量的成功并且在設計模型的過程中,模型的參數量也越來越大。對于細粒度理解任務,模型參數量也同樣在增加。然而目前現有的數據集存在規模和精度的矛盾,例如 SA-1B 數據集中 99.1% 的 mask 都是機器生成的,但沒有賦予語義的標簽,而其他一些公開數據集也同樣存在精度問題并且這些數據集的規模一般都比較小。

近期,字節跳動提出了新一代細粒度理解的數據集,針對當代深度學習模型的設計需求,給總量為 383K 的圖片進行了全景分割的人工標注,最后達到了 5.18M 張 mask,是至今最大規模的帶人工標簽的全景分割理解數據集,命名為 COCONut。該成果已入選 CVPR2024。

- 論文鏈接:https://arxiv.org/abs/2404.08639

- 代碼和數據集鏈接: https://xdeng7.github.io/coconut.github.io/ ?

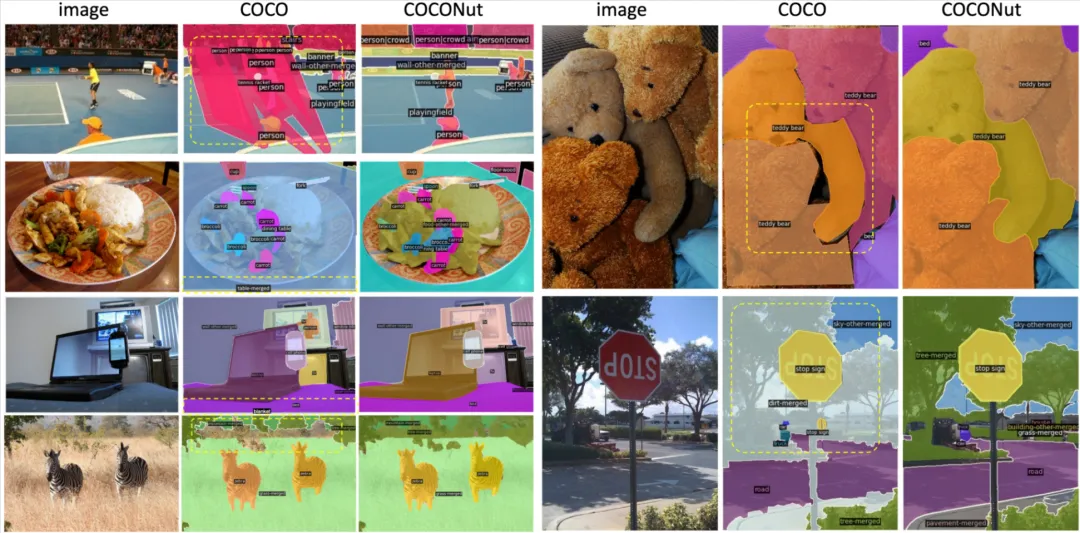

視頻展示了 COCONut 的單張圖片的 mask 密度以及語義類別的統計,可以看出,數據集的語義豐富以及 mask 分割粒度精細。該數據集還支持多種理解任務,例如全景分割,實例分割,語義分割,目標檢測,語義控制生成和開放詞匯分割,在多項任務上,僅通過替換數據集就達到了明顯的性能提升。

標注方法

通常只采用人工標注是非常昂貴的,這也是目前現存的大多數公開數據集規模上不去的一個重要原因。還有一些數據集直接使用模型生成的標簽,但往往這種生成的標簽對模型的訓練不會有太大的提高,本文也驗證了這一點。所以本文提出了一種新穎的標注方式,結合人工的半自動標簽生成。既能保證數據標注的精度又能實現人工勞動力的節省成本,同時還能加速標注過程。

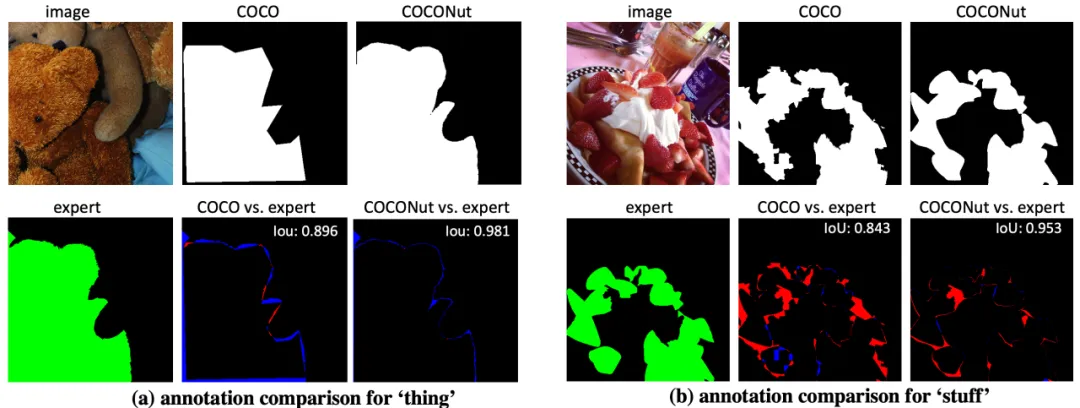

標注精度對比

研究者把 COCONut 和 COCO 在同一張圖上的標注進行對比。從下圖的對比可以看到本文提出的標注方法達到了和純人工用 Photoshop 標注幾乎一致的精度,但是在標注速度上提高了 10 倍以上。

COCONut 數據集詳情

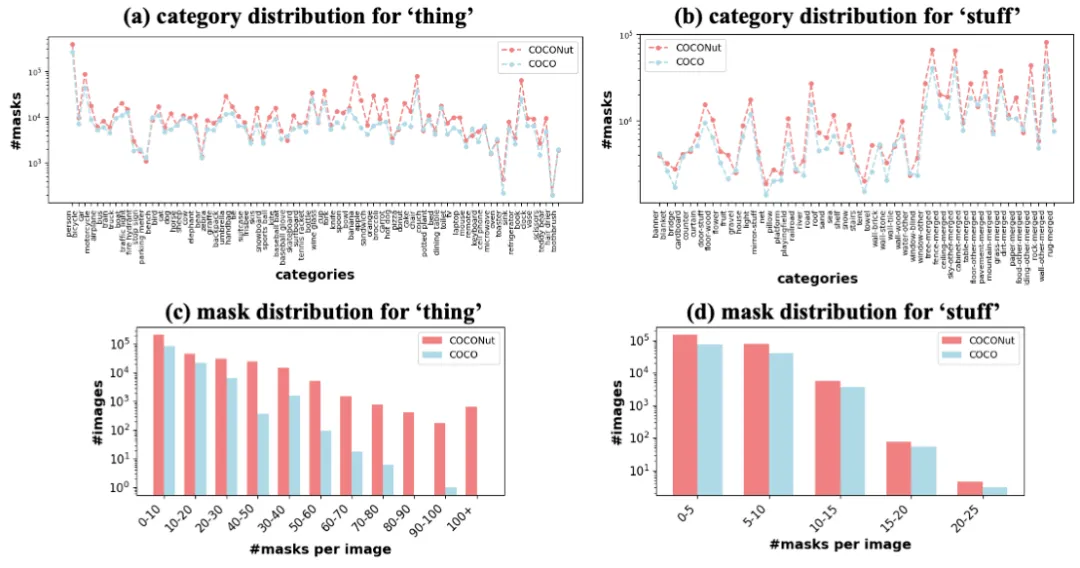

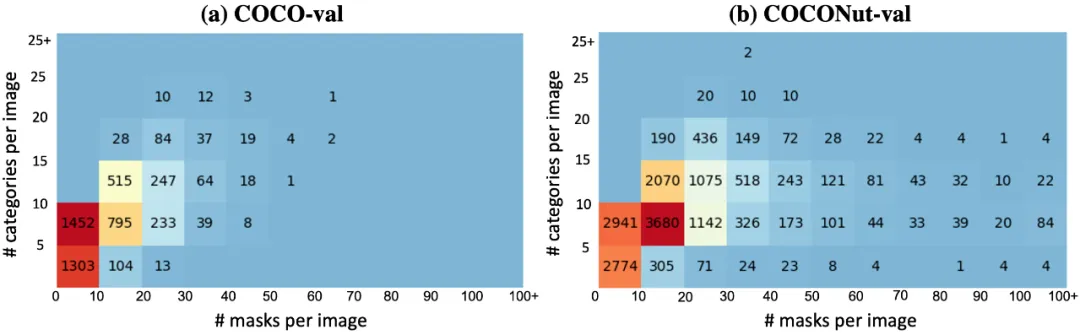

和已有的 COCO 數據集相比,數據集各個類別的分布比較相近,但是在每張圖的 mask 總量上是超過 COCO 數據集的,尤其是有大量單張圖片有超過 100 張 mask 的情況,由此說明了 COCONut 的標注更為精細,粒度分割更密集。

實驗驗證

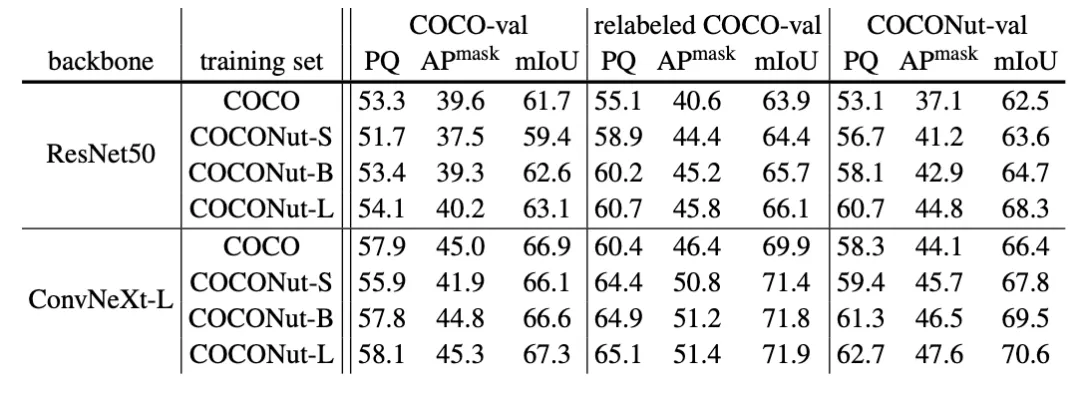

除了提出一個更好的訓練集,研究者還發現現有的驗證集不能很好的體現模型性能的提升,因此本文還提出了一個更加富有挑戰性的、可以反映模型的提升的測試集,命名為 COCONut-val. 從下表可以看到,僅替換數據集,更高精度的訓練集可以帶來模型很大的提升,例如在全景分割上達到超過 4 個點的 PQ。然而當訓練集的規模增加了之后,可以發現,用現有的測試集做測試并不能反映出模型的提升,而 COCONut-val 則能反映出模型在增加了訓練集數據量之后仍然有明顯的提升。

下圖為驗證集語義類別和 mask 密度的對比,可以看出新提出的驗證集更具有挑戰性,更能反映模型的提升。

了解更多實驗結果可參考原論文,團隊后續將在 GitHub 主頁提供數據集和相應的模型公開下載。

字節跳動智能創作團隊

智能創作團隊是字節跳動 AI & 多媒體技術團隊,覆蓋了計算機視覺、音視頻編輯、特效處理等技術領域,借助公司豐富的業務場景、基礎設施資源和技術協作氛圍,實現了前沿算法 - 工程系統 - 產品全鏈路的閉環,旨在以多種形式為公司內部各業務提供業界前沿的內容理解、內容創作、互動體驗與消費的能力和行業解決方案。

目前,智能創作團隊已通過字節跳動旗下的云服務平臺火山引擎向企業開放技術能力和服務。更多大模型算法相關崗位開放中。

本文轉自機器之心 ,作者:機器之心