直擊痛點(diǎn),新一代身份保持視頻生成解決方案!阿里等提出FantasyID:多視角與3D融合!

文章鏈接:https://arxiv.org/pdf/2502.13995

項(xiàng)目鏈接:https://fantasy-amap.github.io/fantasy-id/

亮點(diǎn)直擊

- 首次嘗試從單視角參考圖像中提取3D面部先驗(yàn),以增強(qiáng)面部結(jié)構(gòu)的穩(wěn)定性,從而在整個(gè)視頻生成過程中有益于身份(ID)保持。

- 通過采用多視角面部增強(qiáng)策略,能夠顯著增強(qiáng)對(duì)廣泛視角下2D面部外觀的感知,從而有益于與面部表情和頭部姿勢(shì)相關(guān)的運(yùn)動(dòng)動(dòng)態(tài)。

- 設(shè)計(jì)了一種可學(xué)習(xí)的層次化特征引導(dǎo)機(jī)制,以促進(jìn)對(duì)身份保持和動(dòng)態(tài)建模的精確控制,從而生成具有更好時(shí)間一致性和身份一致性的高保真人物視頻。

總結(jié)速覽

解決的問題

- 面部動(dòng)態(tài)表現(xiàn)不足:現(xiàn)有的身份保持文本到視頻生成(IPT2V)方法在生成視頻時(shí),難以在保持身份一致性的同時(shí),實(shí)現(xiàn)滿意的面部動(dòng)態(tài)表現(xiàn)。

- “復(fù)制-粘貼”問題:使用單視角參考面部圖像進(jìn)行模型調(diào)優(yōu)時(shí),模型可能會(huì)簡(jiǎn)單地復(fù)制參考面部圖像,導(dǎo)致生成視頻中的面部表情和頭部姿勢(shì)缺乏多樣性。

- 層次化控制信號(hào)的敏感性:擴(kuò)散Transformer(DiT)的層次化結(jié)構(gòu)導(dǎo)致不同層對(duì)控制信號(hào)的敏感性不同,需要專門的調(diào)節(jié)策略來平衡身份保持和時(shí)間一致性。

提出的方案

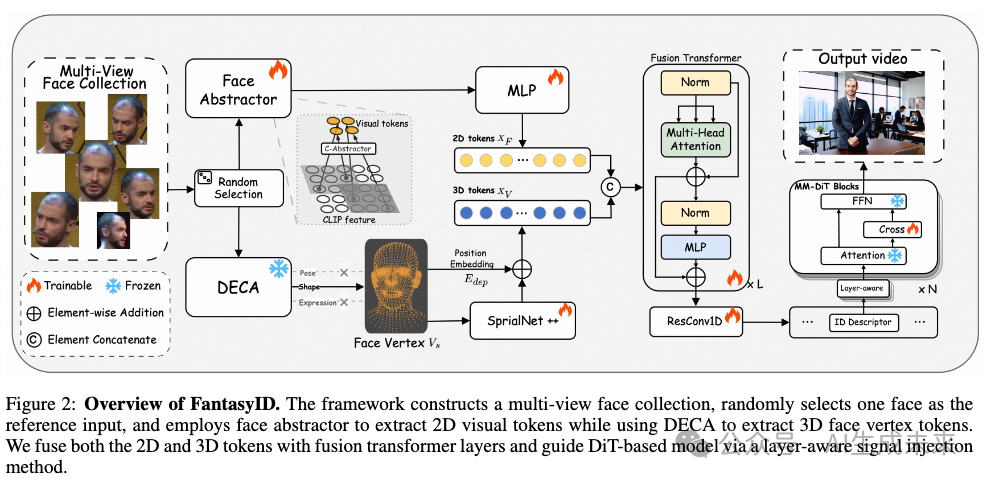

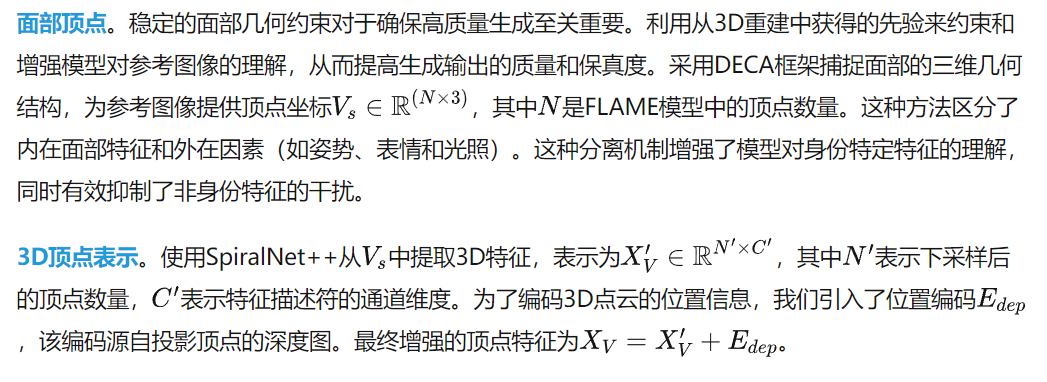

- 引入3D面部幾何先驗(yàn):通過集成3D面部幾何先驗(yàn),確保在視頻合成過程中面部結(jié)構(gòu)的穩(wěn)定性和一致性。使用DECA提取身份特定的3D特征(如形狀點(diǎn)云),并丟棄與身份無關(guān)的特征(如姿勢(shì)和表情)。

- 多視角面部增強(qiáng)策略:通過從不同視角增強(qiáng)單視角參考面部圖像,形成一個(gè)面部池,從中隨機(jī)選擇圖像作為預(yù)訓(xùn)練視頻模型的輸入,以避免模型學(xué)習(xí)“復(fù)制-粘貼”的捷徑。

- 層次化自適應(yīng)注入機(jī)制:將融合的2D和3D面部特征通過基于Transformer的特征融合模塊進(jìn)行混合,并引入層次化自適應(yīng)注入機(jī)制,選擇性地將融合特征注入到每個(gè)DiT層中,以平衡身份保持和運(yùn)動(dòng)動(dòng)態(tài)。

應(yīng)用的技術(shù)

- 3D面部幾何先驗(yàn):使用DECA提取3D面部幾何特征。

- 多視角面部增強(qiáng):通過多視角圖像增強(qiáng)技術(shù),生成多樣化的面部圖像。

- Transformer特征融合:使用基于Transformer的特征融合模塊,將2D和3D面部特征進(jìn)行融合。

- 層次化自適應(yīng)注入機(jī)制:引入層次化自適應(yīng)注入機(jī)制,選擇性地將融合特征注入到DiT的不同層中。

達(dá)到的效果

- 提升面部動(dòng)態(tài)表現(xiàn):通過引入3D面部幾何先驗(yàn)和多視角面部增強(qiáng)策略,顯著提升了生成視頻中面部表情和頭部姿勢(shì)的多樣性。

- 避免“復(fù)制-粘貼”問題:多視角面部增強(qiáng)策略有效避免了模型簡(jiǎn)單地復(fù)制參考面部圖像,增強(qiáng)了生成視頻的動(dòng)態(tài)性。

- 平衡身份保持和運(yùn)動(dòng)動(dòng)態(tài):層次化自適應(yīng)注入機(jī)制使得模型能夠自適應(yīng)地選擇最有益的特征,從而在保持身份一致性的同時(shí),實(shí)現(xiàn)更好的運(yùn)動(dòng)動(dòng)態(tài)表現(xiàn)。

- 實(shí)驗(yàn)驗(yàn)證:實(shí)驗(yàn)結(jié)果表明,該方法在當(dāng)前的無調(diào)優(yōu)IPT2V方法中具有優(yōu)越性。

方法

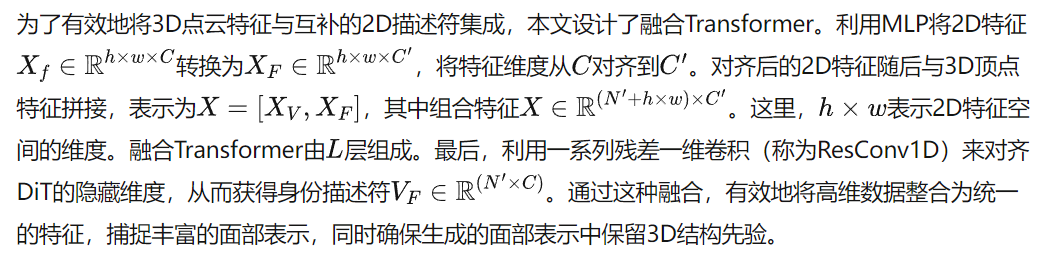

給定一張參考面部圖像,FantasyID旨在生成一個(gè)忠實(shí)保留個(gè)體身份特征的視頻。下圖2展示了FantasyID的概述。對(duì)于每個(gè)訓(xùn)練視頻,構(gòu)建一個(gè)多視角面部集合,并隨機(jī)選擇一張參考圖像作為輸入條件。接著,利用面部抽象器提取2D clip tokens,使用DECA解耦與核心身份無關(guān)的特征(如表情、姿勢(shì))并提取3D結(jié)構(gòu)信息,并通過融合Transformer將2D tokens和3D tokens融合為面部描述符嵌入。此外,通過采用層次化信號(hào)注入方法對(duì)基于DiT的模型進(jìn)行控制,確保每一層的精確調(diào)制。

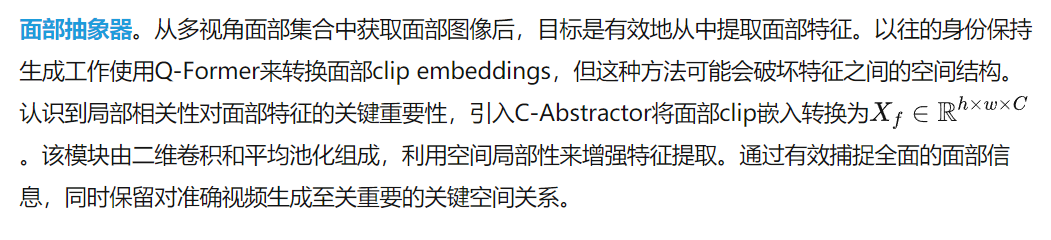

多視角集合與面部抽象器

多視角面部集合。在訓(xùn)練階段獲取有效的身份參考至關(guān)重要。為了確保模型專注于關(guān)鍵區(qū)域,首先從視頻的每一幀中裁剪出面部區(qū)域,消除背景干擾。借鑒MovieGen的方法,單一參考圖像可能導(dǎo)致模型學(xué)習(xí)直接復(fù)制面部的捷徑,因此在訓(xùn)練階段構(gòu)建了一個(gè)包含不同視角的面部圖像集合。使用RetinaFace提取面部關(guān)鍵點(diǎn)之間的幾何關(guān)系,以計(jì)算頭部姿勢(shì)角度,并選擇六張視角差異最顯著的圖像形成一個(gè)多視角面部集合I。通過為模型提供多樣化的視角,它能夠更全面地理解主體,從而增強(qiáng)其在各種姿勢(shì)和表情下保持身份一致性的能力。

3D約束

融合Transformer

層次化控制信號(hào)注入

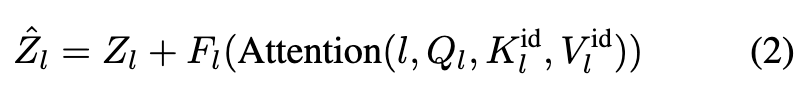

受DiT架構(gòu)中每一層對(duì)整體性能有獨(dú)特貢獻(xiàn)的觀察啟發(fā),本文采用類似的方法來控制基于DiT的面部視頻生成。不同層對(duì)控制信號(hào)的敏感性不同。為了解決這一問題,本文提出了一種層次化控制信號(hào)注入機(jī)制,根據(jù)每一層的作用動(dòng)態(tài)調(diào)整控制信號(hào)的集成。

對(duì)于每個(gè)MM-DiT塊,采用一個(gè)輕量級(jí)模型Fl來學(xué)習(xí)最優(yōu)特征表示。該輕量級(jí)網(wǎng)絡(luò)由一個(gè)卷積塊和歸一化組成。每一層的獨(dú)立權(quán)重增強(qiáng)了保真度和多樣性,使控制信號(hào)精確地適應(yīng)每一層的需求。這確保了輸出的穩(wěn)定性和表現(xiàn)潛力。該過程由以下公式定義:

實(shí)驗(yàn)

實(shí)驗(yàn)設(shè)置

評(píng)估指標(biāo)。本文采用 ArcFace嵌入相似度來評(píng)估兩個(gè)關(guān)鍵方面。首先,參考相似度(Reference Similarity, RS) 計(jì)算參考圖像與視頻幀之間的相似度,以評(píng)估身份保持能力。其次,幀間相似度(Inter-Frame Similarity, IFS) 測(cè)量連續(xù)視頻幀之間的相似度,以評(píng)估運(yùn)動(dòng)過程中身份特征的穩(wěn)定性。此外,我們通過分析面部區(qū)域的 Fréchet Inception Distance (FID) [3] 來評(píng)估視頻質(zhì)量,并使用由平均密集光流 測(cè)量的面部運(yùn)動(dòng)(Face Motion, FM) 來評(píng)估運(yùn)動(dòng)程度。我們使用了 50 張細(xì)節(jié)豐富的肖像參考圖像。為了更準(zhǔn)確地衡量身份保持能力,我們從每個(gè)視頻中裁剪出面部區(qū)域進(jìn)行定量評(píng)估。

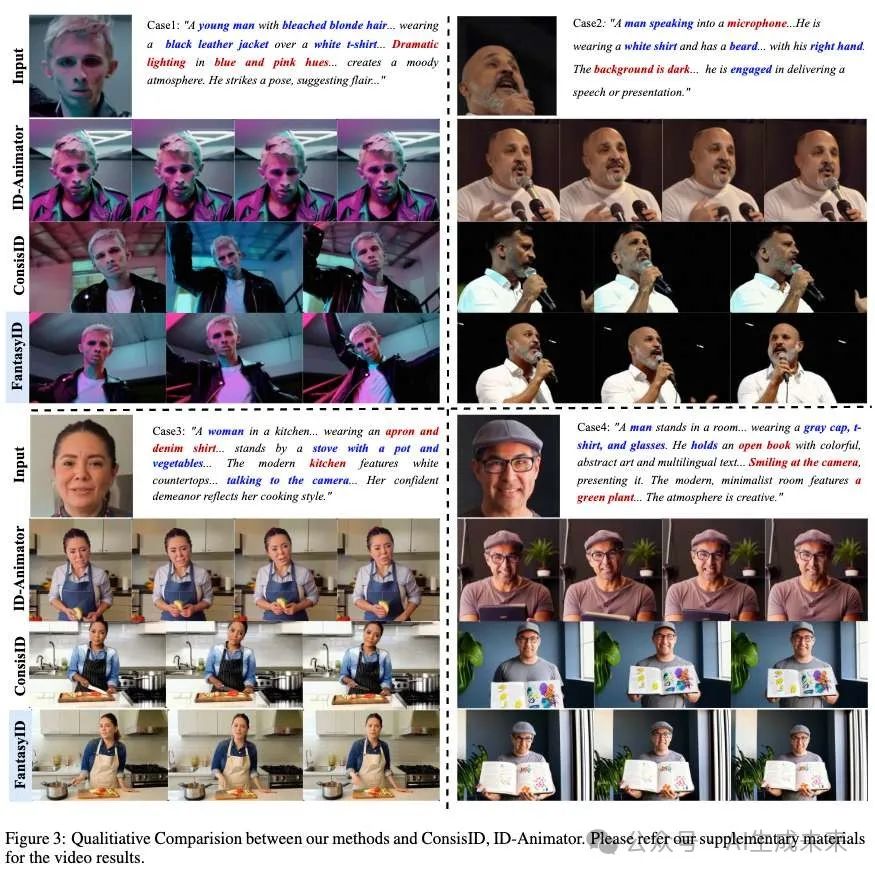

定性分析

為了進(jìn)行定性評(píng)估,展示了與基于擴(kuò)散的身份保持模型(ConsisID 和 ID-Animator)的比較結(jié)果。其他模型,如 VideoMaker和 MagicMirror,由于未開源,因此未包含在直接比較中。

下圖 3 展示了 ID-Animator 在生成面部以外的人體部位時(shí)存在困難,并表現(xiàn)出明顯的“復(fù)制-粘貼”偽影。此外,生成的內(nèi)容通常顯得過于靜態(tài),缺乏自然運(yùn)動(dòng)。這些限制顯著限制了其在需要?jiǎng)討B(tài)和真實(shí)人類行為或交互的場(chǎng)景中的實(shí)際應(yīng)用。對(duì)于 ConsisID,雖然整體視覺質(zhì)量較高,但在面部運(yùn)動(dòng)過程中仍存在結(jié)構(gòu)不穩(wěn)定的問題,如案例 1 所示。盡管 ConsisID 保留了參考圖像中的皮膚紋理等特征,但在案例 3 和 4 中未能準(zhǔn)確再現(xiàn)整體面部結(jié)構(gòu)。相比之下,本文的方法在視覺質(zhì)量、從參考圖像中保留主體身份以及在運(yùn)動(dòng)過程中保持幀間一致的面部結(jié)構(gòu)方面取得了最佳效果。

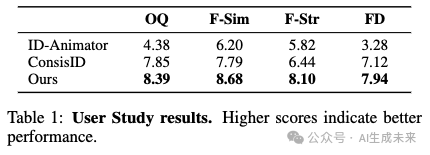

為了進(jìn)一步驗(yàn)證我們提出方法的有效性,本文進(jìn)行了一項(xiàng)包含 32 名參與者的綜合用戶研究。每位參與者被要求評(píng)估四個(gè)關(guān)鍵方面:整體質(zhì)量(Overall Quality, OQ)、面部相似度(Face Similarity, F-Sim)、面部結(jié)構(gòu)(Facial Structure, F-Str) 和 面部動(dòng)態(tài)(Facial Dynamics, FD),并在 0 到 10 的范圍內(nèi)對(duì)每個(gè)方面進(jìn)行評(píng)分。如下表 1 所示,評(píng)分結(jié)果表明 FantasyID 在所有評(píng)估維度上均優(yōu)于基線方法,證明了其在人類評(píng)估中的優(yōu)越感知質(zhì)量。

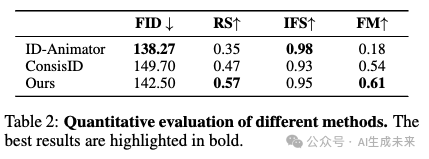

定量分析

下表 2 展示了各種面部視頻生成方法的綜合定量評(píng)估結(jié)果。ID-Animator 在 FID 分?jǐn)?shù)和 IFS 分?jǐn)?shù)上表現(xiàn)優(yōu)異。然而,這種表現(xiàn)可以歸因于其傾向于生成更靜態(tài)的內(nèi)容,從而確保了高質(zhì)量和出色的身份一致性。這種對(duì)靜態(tài)表示的關(guān)注可能限制了其生成多樣化和動(dòng)態(tài)面部運(yùn)動(dòng)的能力。相比之下,盡管本文的方法在 FID 分?jǐn)?shù)上略高,但在捕捉動(dòng)態(tài)表情方面表現(xiàn)出色,面部運(yùn)動(dòng)分?jǐn)?shù)達(dá)到 0.61,同時(shí)取得了最高的 RS 分?jǐn)?shù) 0.57,反映了卓越的身份保持能力。值得注意的是,本模型在所有指標(biāo)上均優(yōu)于 ConsisID,展現(xiàn)了在動(dòng)態(tài)性和身份保持方面的卓越能力。

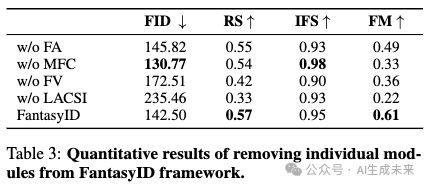

消融實(shí)驗(yàn)

這些實(shí)驗(yàn)系統(tǒng)地移除了各個(gè)組件,以評(píng)估它們對(duì)模型整體性能的影響,結(jié)果如下表 3 所示。本文研究了排除多視角面部集合(Multi-View Face Collection, MFC)、面部抽象器(Face Abstractor, FA)、面部頂點(diǎn)(Face Vertex, FV) 和 層次化控制信號(hào)注入(Layer-Aware Control Signal Injection, LACSI) 的影響。此外,修改了不同輸入的面部頂點(diǎn)數(shù)據(jù),以驗(yàn)證 3D 約束的有效性。

定性分析

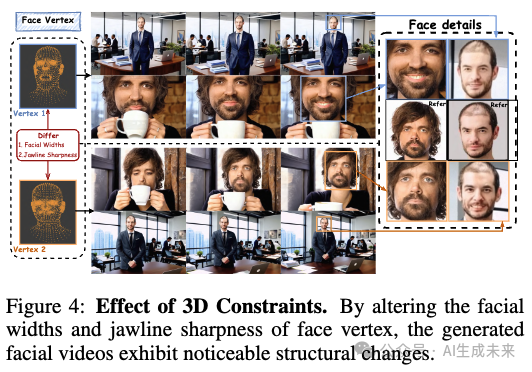

3D 約束的效果。為了驗(yàn)證 3D 約束控制機(jī)制的有效性,修改了 3D 面部頂點(diǎn)以生成具有不同面部寬度和下頜線銳度的視頻。下圖 4 展示的定性結(jié)果顯示了面部結(jié)構(gòu)的顯著變化,從而證實(shí)了3D 約束在引導(dǎo)面部特征生成方面的有效性。這證明了本文的方法在控制面部特征方面的靈活性和精確性。

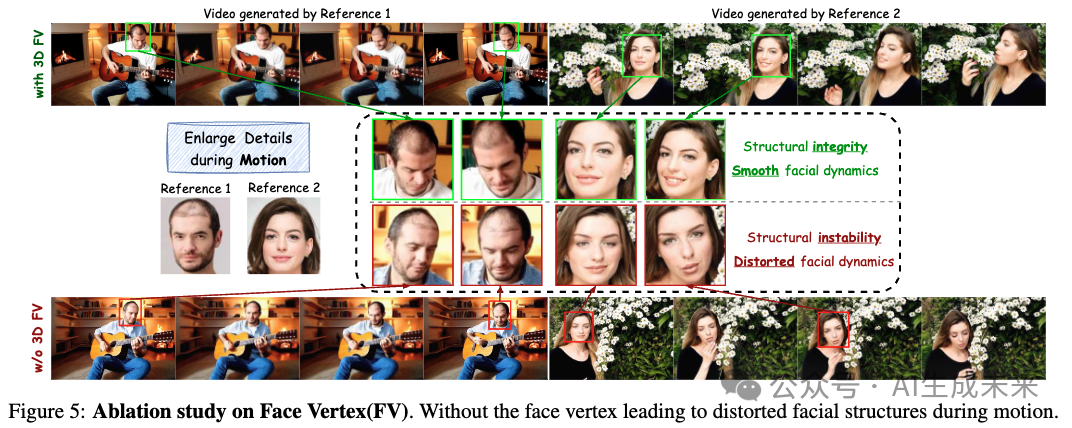

無面部頂點(diǎn)。我們通過排除框架中的面部頂點(diǎn)來評(píng)估 3D 約束的重要性。下圖 5 的定性結(jié)果表明,缺少 3D 面部頂點(diǎn)數(shù)據(jù)會(huì)導(dǎo)致模型僅依賴 2D 特征提取,從而導(dǎo)致運(yùn)動(dòng)過程中面部結(jié)構(gòu)的扭曲。前面表 2 的定量結(jié)果顯示所有指標(biāo)均有所下降,表明面部運(yùn)動(dòng)更加不穩(wěn)定。這些結(jié)果表明,3D 頂點(diǎn)集成在保持結(jié)構(gòu)完整性和確保平滑面部動(dòng)態(tài)方面起著關(guān)鍵作用。

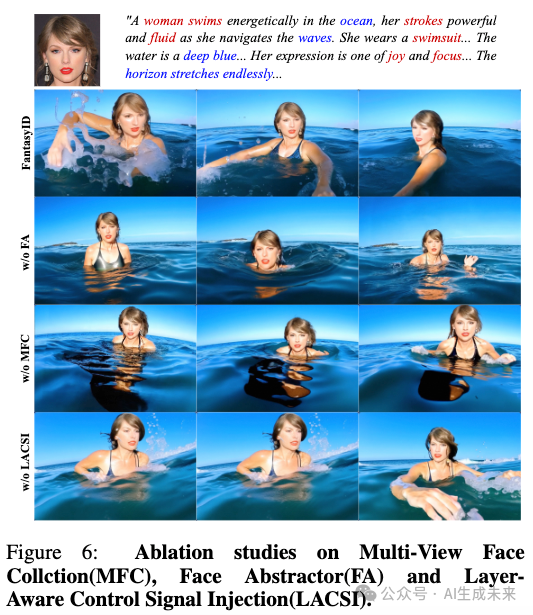

無多視角面部集合。我們?cè)谟?xùn)練階段用單一面部圖像替換了多視角面部集合。如下圖 6 所示,這種方法顯著減少了捕捉到的面部運(yùn)動(dòng)范圍,限制了模型理解和表示不同角度的能力。如前面表 3 所示,這種方法在 FID 和 IFS 分?jǐn)?shù)上表現(xiàn)最佳。這種表現(xiàn)可以歸因于模型傾向于通過優(yōu)先考慮與參考圖像的更高相似性來走捷徑,從而以犧牲動(dòng)態(tài)范圍為代價(jià)保持一致性。

無面部抽象器將面部抽象器替換為 Q-Former,如上面圖 6 所示,這導(dǎo)致了一些面部扭曲。這些扭曲可能是由于 Q-Former 傾向于破壞面部 CLIP 特征的空間特性。此外,上表 2 中的結(jié)果表明,這種方法在 FID、RS 和 IFS 分?jǐn)?shù)上表現(xiàn)較低。這表明面部抽象器在捕捉全面且空間一致的面部信息方面更為有效。

無層次化控制信號(hào)注入通過移除層次化控制信號(hào)注入模塊 ,觀察到面部相似度顯著下降,如上圖 6 所示,同時(shí)所有指標(biāo)分?jǐn)?shù)也有所下降,詳見前面表 3。這些結(jié)果表明視頻質(zhì)量和身份保持能力均有所下降。相比之下,層次化控制方法通過學(xué)習(xí)每一層最合適的特征控制信號(hào),能夠更有效地適應(yīng)不同 DiT 塊之間的獨(dú)特特征分布。這種方法在生成身份特征時(shí)確保了最佳性能和保真度。

結(jié)論

FantasyID 提出了一種突破性的身份保持人物視頻生成方法,克服了傳統(tǒng)方法的局限性。通過采用多視角面部集合、面部抽象器、3D 約束和層次化控制信號(hào)注入,它顯著提升了視頻質(zhì)量、身份保持能力和時(shí)間一致性。這種可擴(kuò)展的無訓(xùn)練解決方案在復(fù)雜運(yùn)動(dòng)中保持了高保真表示。未來的工作將專注于優(yōu)化多身份保持,并擴(kuò)展 FantasyID 在動(dòng)態(tài)視頻制作和個(gè)性化內(nèi)容創(chuàng)作中的作用。

本文轉(zhuǎn)自 AI生成未來 ,作者:AI生成未來