輕松拿捏4K高清圖像理解!這個多模態大模型自動分析網頁海報內容,打工人簡直不要太方便

一個可以自動分析PDF、網頁、海報、Excel圖表內容的大模型,對于打工人來說簡直不要太方便。

上海AI Lab,香港中文大學等研究機構提出的InternLM-XComposer2-4KHD(簡寫為IXC2-4KHD)模型讓這成為了現實。

相比于其他多模態大模型不超過1500x1500的分辨率限制,該工作將多模態大模型的最大輸入圖像提升到超過4K (3840 x1600)分辨率,并支持任意長寬比和336像素~4K動態分辨率變化。

發布三天,該模型就登頂Hugging Face視覺問答模型熱度榜單第一。

輕松拿捏4K圖像理解

先來看效果~

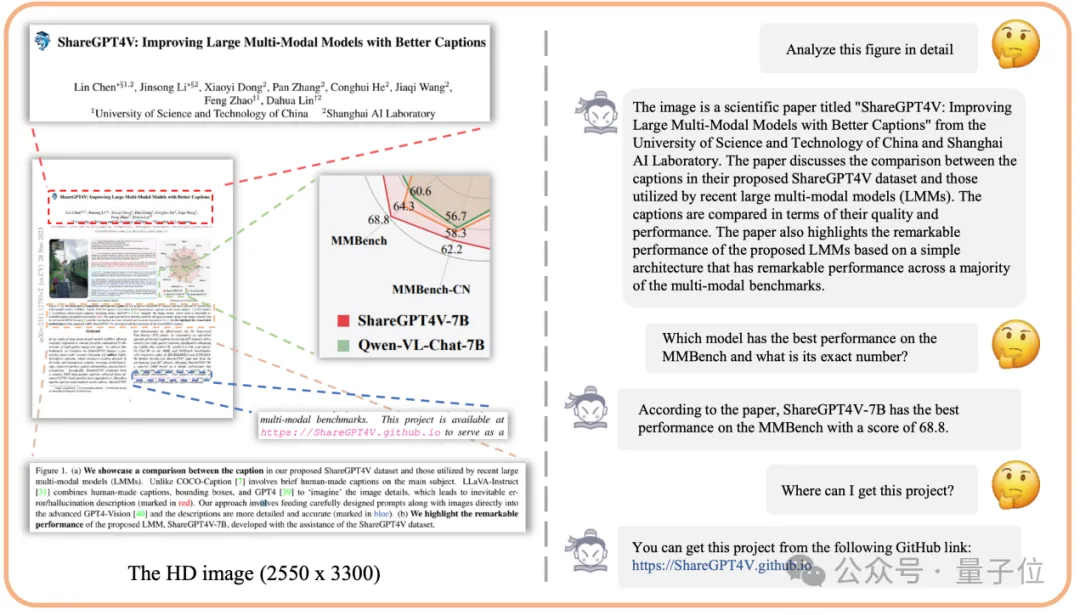

研究人員輸入論文(ShareGPT4V: Improving Large Multi-Modal Models with Better Captions)的首頁截圖(分辨率為2550x3300),并詢問論文哪個模型在MMBench上的性能最高。

需要注意的是,該信息在輸入截圖的正文文字部分并未提及,僅僅出現在一個相當復雜的雷達圖中。面對這么刁鉆的問題,IXC2-4KHD成功理解了雷達圖中的信息,正確回答問題。

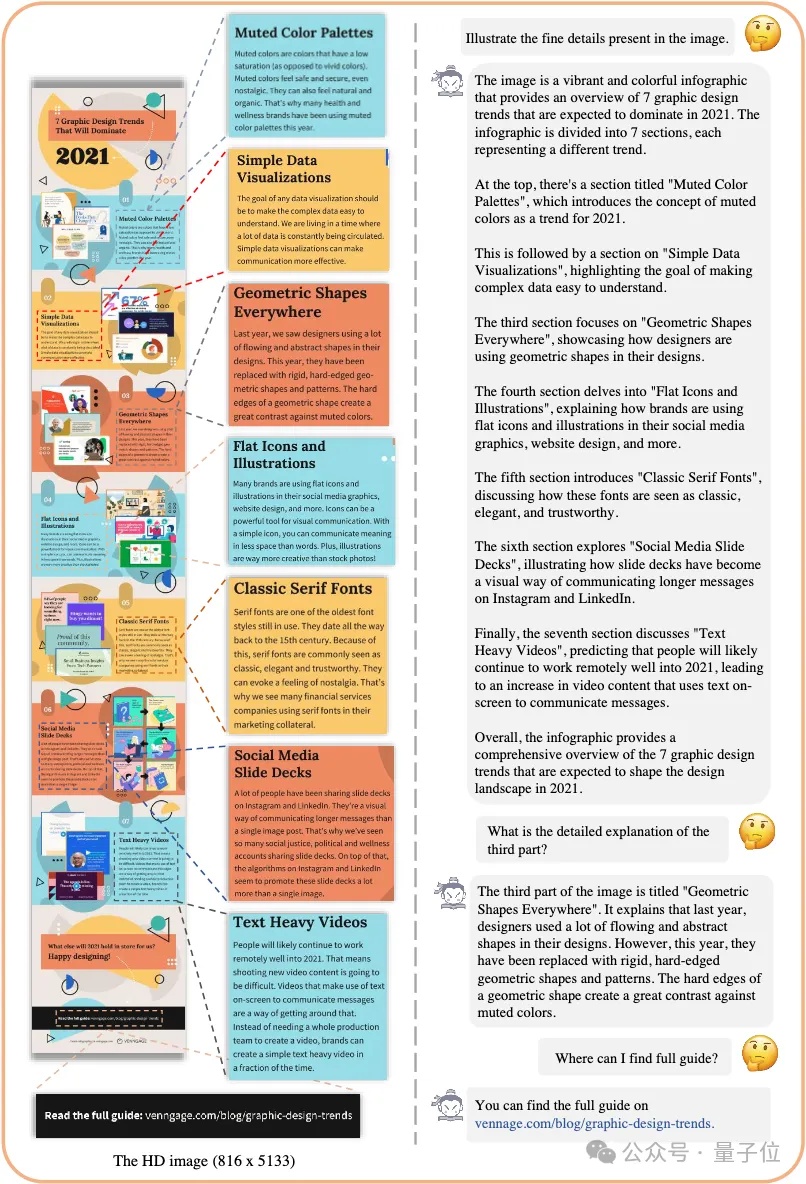

面對更加極端分辨率的圖像輸入(816 x 5133),IXC2-4KHD輕松理解圖像包括7個部分,并準確說明了每個部分包含的文字信息內容。

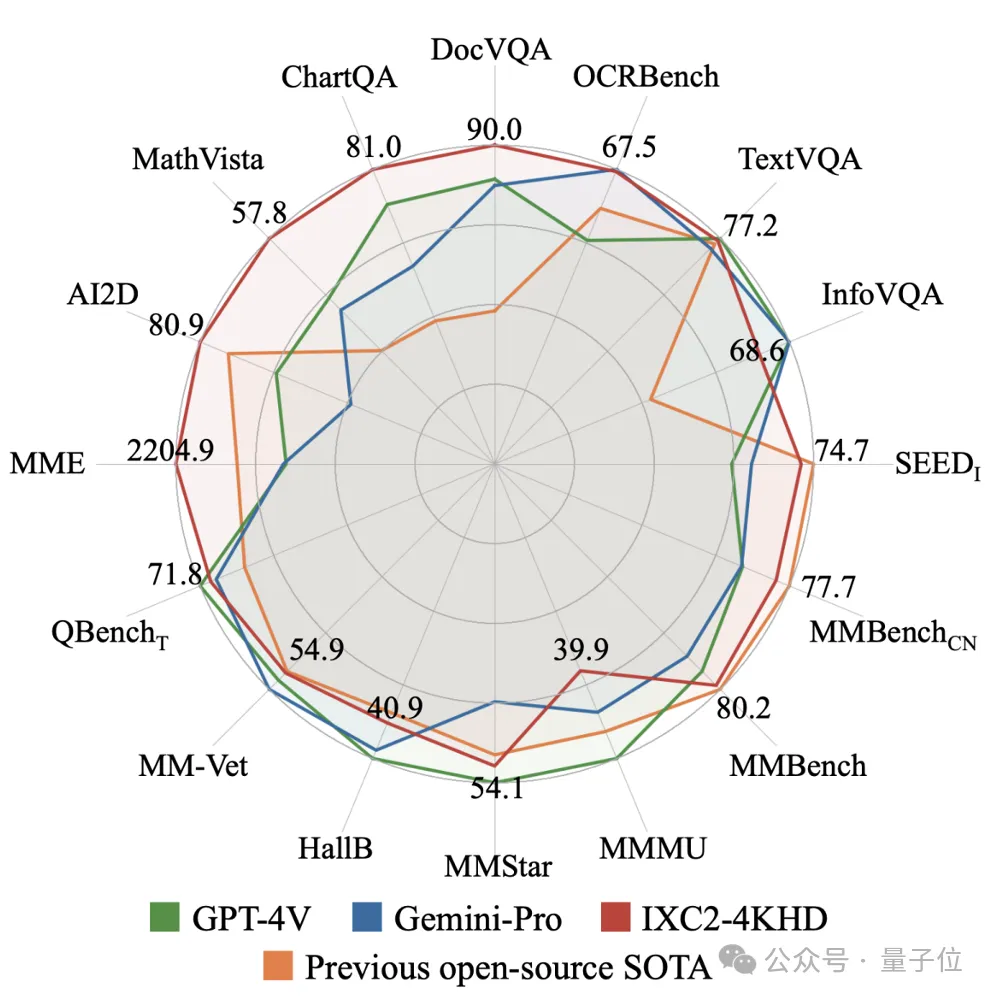

隨后,研究人員還在16項多模態大模型評測指標上全面測試了IXC2-4KHD的能力,其中5項評測(DocVQA、ChartQA、InfographicVQA、TextVQA、OCRBench)關注模型的高分辨率圖像理解能力。

僅僅使用7B參數量,IXC2-4KHD在其中10項評測取得了媲美甚至超越GPT4V和Gemini Pro的結果,展現了不局限于高分辨率圖像理解,而是對各種任務和場景的泛用能力。

△僅7B參數量的IXC2-4KHD性能媲美GPT-4V和Gemini-Pro

如何實現4K動態分辨率?

為了實現4K動態分辨率的目標,IXC2-4KHD包括了三個主要設計:

(1)動態分辨率訓練:

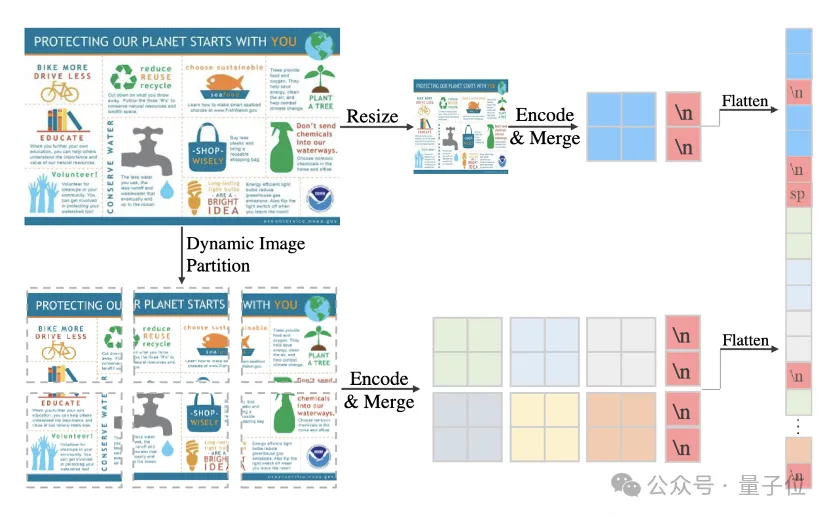

△4K分辨率圖像處理策略

在IXC2-4KHD的框架中,輸入圖像在保持長寬比的情況下,被隨機放大到介于輸入面積和最大面積(不超過55x336x336,等價于3840 x1617分辨率)的一個中間尺寸。

隨后,圖像被自動切塊成多個336x336的區域,分別抽取視覺特征。這種動態分辨率的訓練策略可以讓模型適應任意分辨率的視覺輸入,同時也彌補了高分辨率訓練數據不足的問題。

實驗表明,隨著動態分辨率上限的增加,模型在高分辨率圖像理解任務(InfographicVQA、DocVQA、TextVQA)上實現了穩定的性能提升,并且在4K分辨率仍然未達到上界,展現了更高分辨率進一步擴展的潛力。

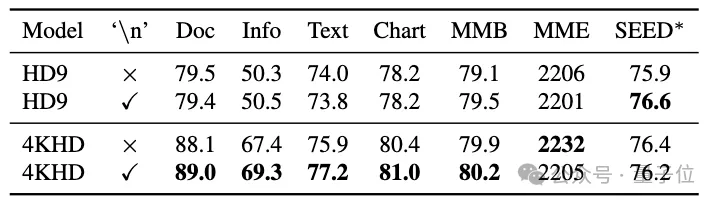

(2)添加切塊布局信息:

?

為了使模型能夠適應變化豐富的動態分辨率,研究人員發現需要將切塊布局信息作為額外的輸入。為了實現這個目的,研究人員采取了一種簡單的策略:一個特殊的‘換行’(’\n’)令牌被插入到每一行的切塊之后,用于告知模型切塊的布局。實驗表明,添加切塊布局信息,對于變化幅度比較小的動態分辨率訓練(HD9代表切塊區域個數不超過9)影響不大,而對于動態4K分辨率訓練則可以帶來顯著的性能提升。

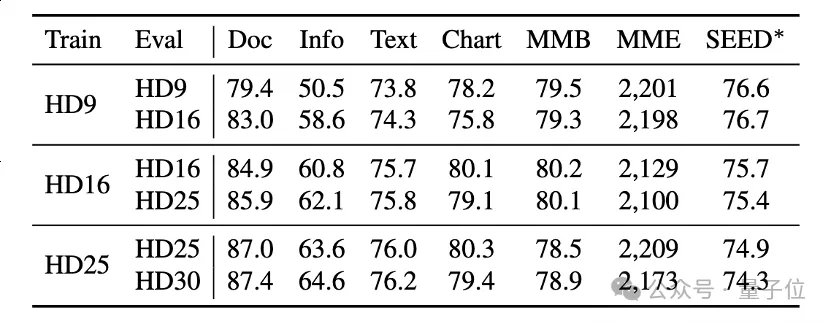

(3)推理階段擴展分辨率

?

研究人員還發現,使用動態分辨率的模型,可以在推理階段通過增加最大切塊上限直接擴展分辨率,并且帶來額外的性能增益。例如將HD9(最多9塊)的訓練模型直接使用HD16進行測試,可以在InfographicVQA上觀察到高達8%的性能提升。

IXC2-4KHD將多模態大模型支持的分辨率提升到了4K的水平,研究人員表示目前這種通過增加切塊個數支持更大圖像輸入的策略遇到了計算代價和顯存的瓶頸,因此他們計劃提出更加高效的策略在未來實現更高分辨率的支持。

論文鏈接:

???https://arxiv.org/pdf/2404.06512.pdf???

項目鏈接:

???https://github.com/InternLM/InternLM-XComposer??

本文轉自 量子位 ,作者:量子位