AI界的"小而美":Mistral AI的最新力作如何重新定義邊緣計算 | 多智能體協作讓大語言模型訓練效率暴增

大模型領域的發展日新月異,每天都有許多有趣的論文值得深入品讀。下面是本期覺得比較有意思的論文:

1、AI界的"小而美":Mistral AI的最新力作如何重新定義邊緣計算

2、多智能體協作讓大語言模型訓練效率暴增

1、AI界的"小而美":Mistral AI的最新力作如何重新定義邊緣計算

在人工智能飛速發展的今天,一個令人振奮的消息從Mistral AI傳來。就在Mistral 7B模型發布一周年之際,這家創新公司再次為我們帶來了驚喜:Ministral 3B和Ministral 8B——兩款專為邊緣計算和設備端應用而生的尖端模型。這兩個被親切地稱為"les Ministraux"(小部長們)的模型,不僅在10B以下類別中樹立了新的標桿,更是為AI的未來指明了方向。

想象一下,在沒有網絡的環境中,你的智能助手依然能夠流暢地為你翻譯文檔、分析數據,甚至控制機器人。這正是Ministral模型的強項所在。它們不僅在知識儲備、常識推理和功能調用等方面表現出色,更重要的是,它們將高性能與高效率完美結合。特別值得一提的是,Ministral 8B采用了創新的交錯滑動窗口注意力模式,這意味著更快的推理速度和更低的內存占用。

但Mistral AI的野心不止于此。通過與更大型的語言模型(如Mistral Large)配合使用,Ministral系列可以在多步驟代理工作流中充當高效的中間人。它們能夠以極低的延遲和成本處理輸入解析、任務路由,并根據用戶意圖調用API。這種靈活性使得Ministral模型從獨立愛好者到全球制造團隊,都能找到其獨特的應用場景。

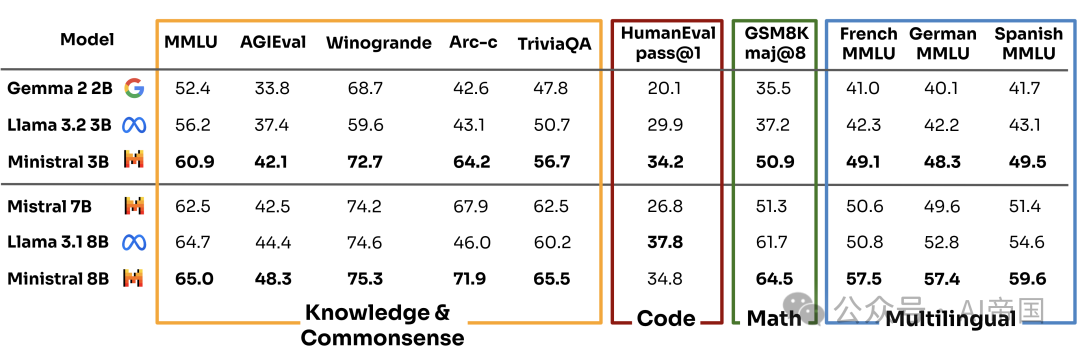

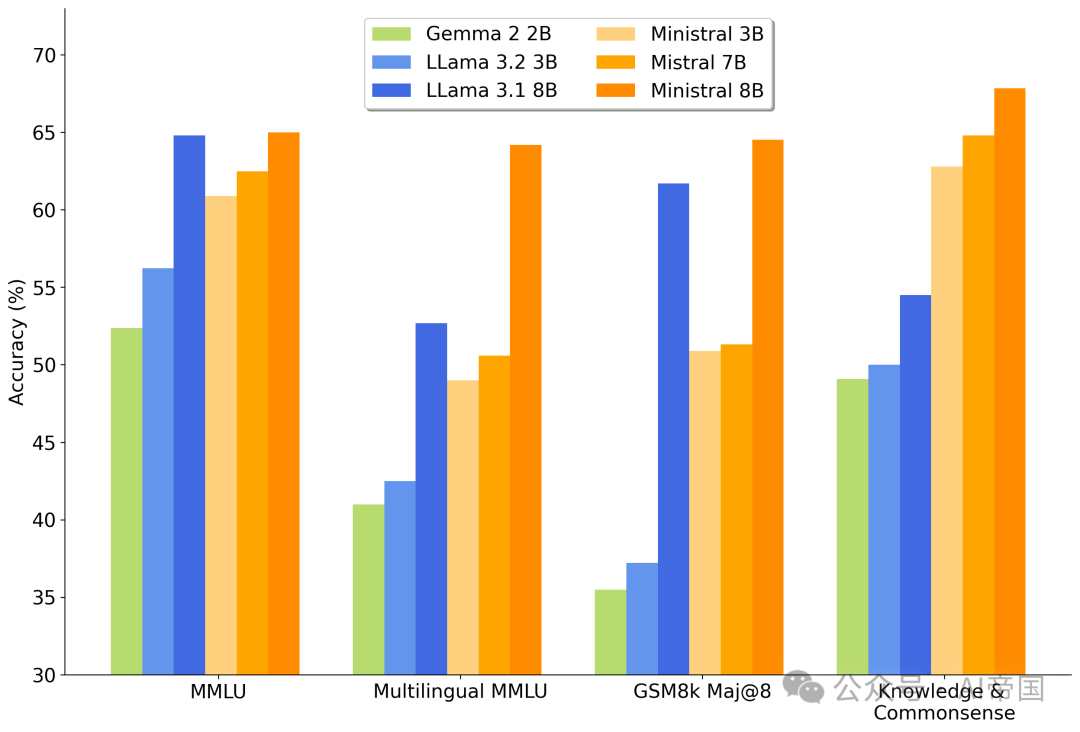

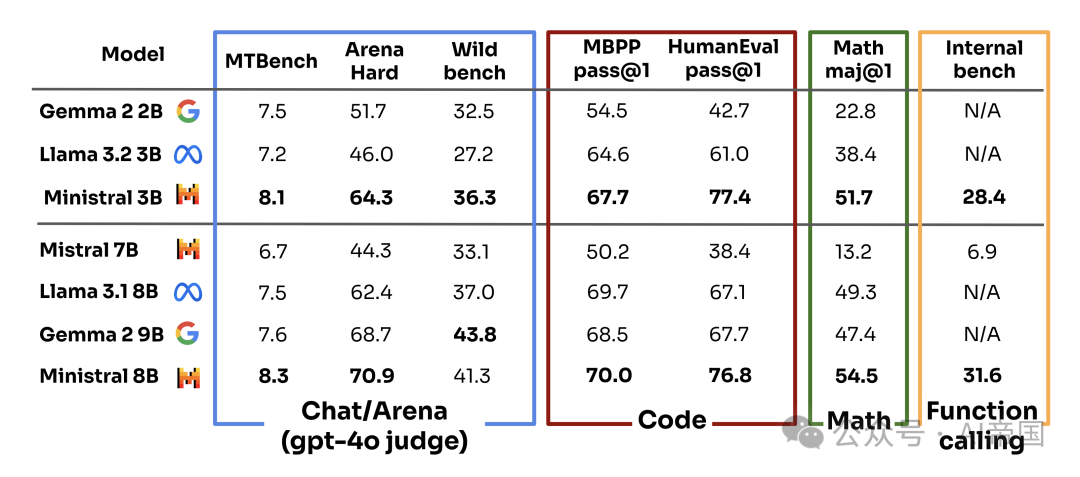

在各項基準測試中,Ministral系列的表現令人矚目。無論是在預訓練模型還是指令模型的評估中,它們都展現出了超越同類產品的實力。特別是Ministral 3B,盡管體積小巧,卻在多數基準測試中超越了體積更大的Mistral 7B,這無疑是AI小型化和效率優化的一個重要里程碑。隨著這些模型的商業化應用和進一步研究的展開,我們有理由相信,AI的"小而美"時代已經悄然來臨。

鏈接:https://mistral.ai/news/ministraux/

2、多智能體協作讓大語言模型訓練效率暴增

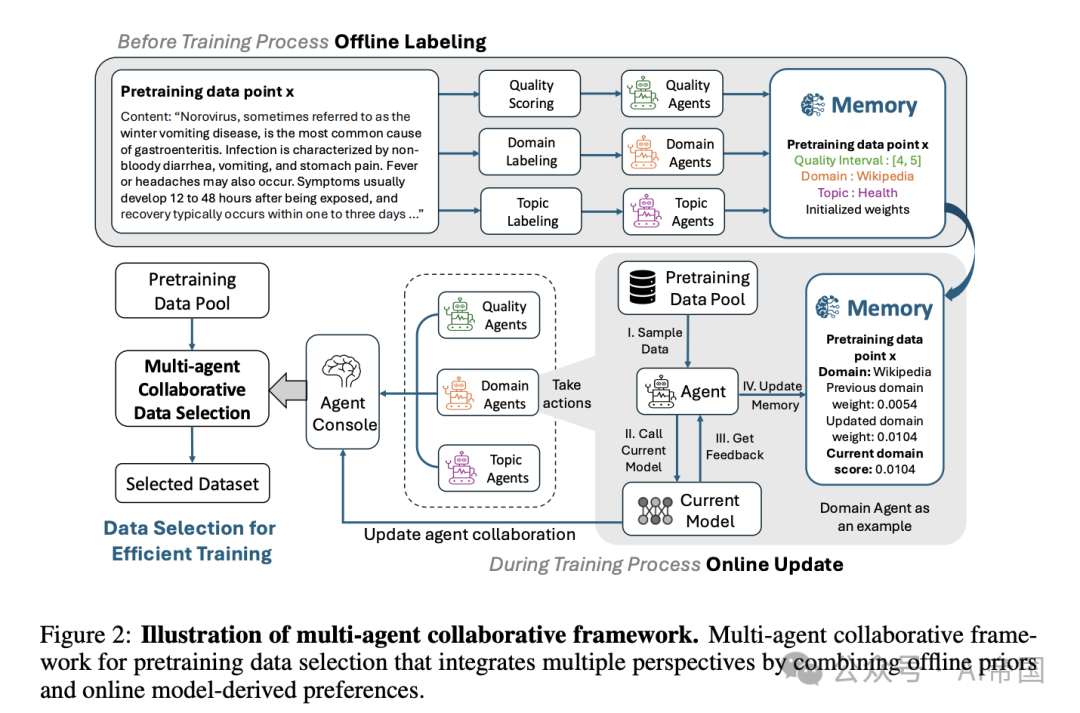

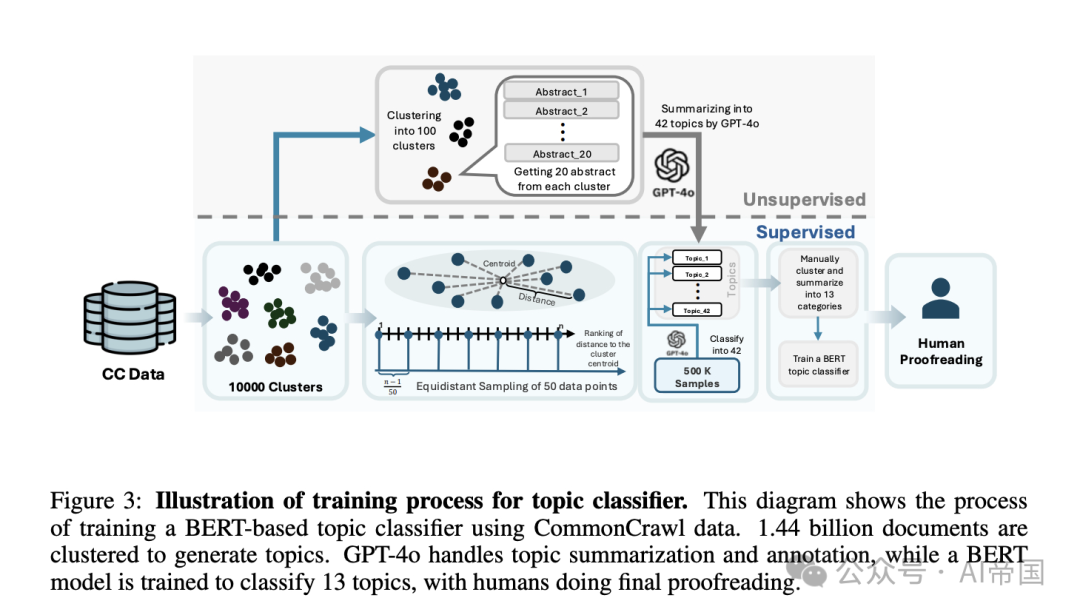

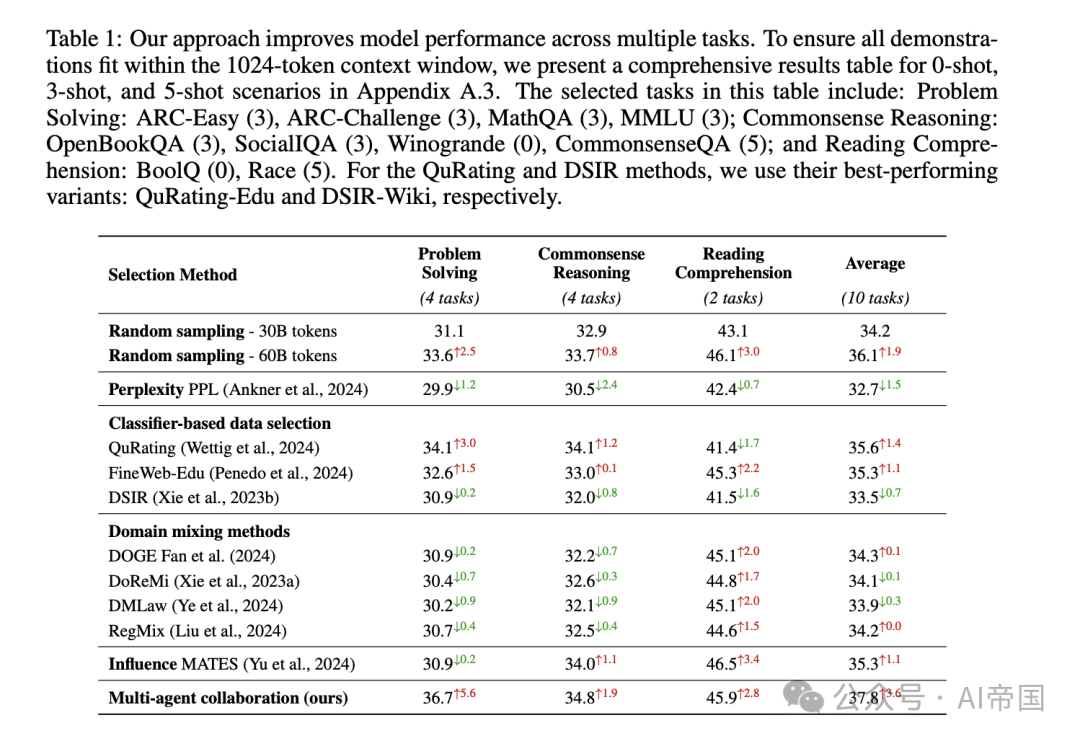

想象一下,如果能讓多個"數據專家"共同為AI挑選最佳訓練素材,會發生什么?一群研究者最近給出了令人振奮的答案!他們提出的多智能體協作數據選擇機制,讓大語言模型的訓練效率突飛猛進,性能提升高達10.5%!

這項突破性研究巧妙地將不同的數據選擇方法視為獨立的"智能體"。每個智能體都有自己的專長,比如篩選高質量數據、平衡主題多樣性等。更厲害的是,研究團隊設計了一個"智能體控制臺",能夠在整個訓練過程中動態整合所有智能體的信息,實現真正的協同作戰。

這種創新方法不僅大幅提升了數據效率,還加快了模型訓練的收斂速度。在多項語言模型基準測試中,它的表現遠超當前最先進的方法。這意味著我們可能很快就能看到更強大、訓練更快的AI模型問世!

然而,這項研究的意義遠不止于此。它為我們展示了一種全新的思路:通過智能協作,我們可以化解不同方法之間的沖突,讓它們優勢互補。這種方法不僅適用于AI訓練,也可能啟發其他領域的創新。未來,我們是否會看到更多領域出現類似的"最強大腦"協作模式呢?讓我們拭目以待!

論文標題:Multi-Agent Collaborative Data Selection for Efficient LLM Pretraining

論文鏈接:??https://arxiv.org/abs/2410.08102??

本文轉載自 ??AI帝國??,作者: 無影寺