場景圖知識增強多模態結構化表示能力

一、引言

視覺語言模型(VLMs)已在多種多模態理解和生成任務中展現了顯著的性能表現。然而,盡管這些多模態模型在廣泛的任務中表現出色,但是它們能否有效地捕獲結構化知識(即理解對象間關系以及對象與其屬性間關系的能力)仍然是一個未解決的問題。

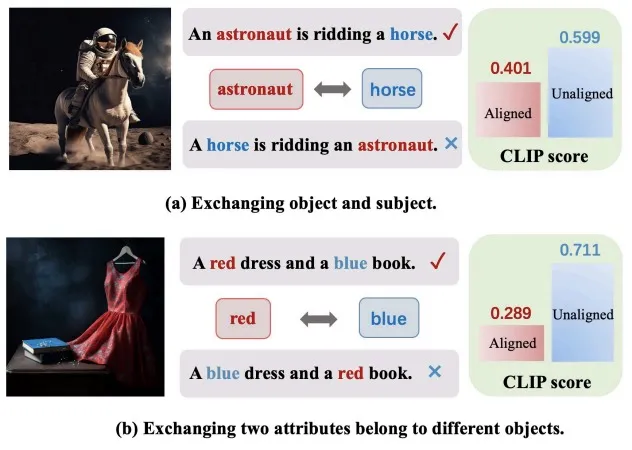

如圖(a)所示,我們在分析CLIP模型時發現,與圖像不匹配的標題(A horse is riding an astronaut)相比,圖像與正確匹配的標題(An astronaut is riding a horse)之間的CLIP分數(即語義相似性)表現出較低的數值。圖(b)展示了當交換用來修飾兩個對象的屬性時,模型在準確區分它們的語義上可能遇到挑戰。這些發現表明,CLIP模型產生的通用表征能力無法區分那些包含相同單詞但在結構化知識方面存在差異的文本段落。換言之,CLIP模型表現出類似于詞袋模型的特點,未能有效理解和捕捉句子中的細粒度語義。

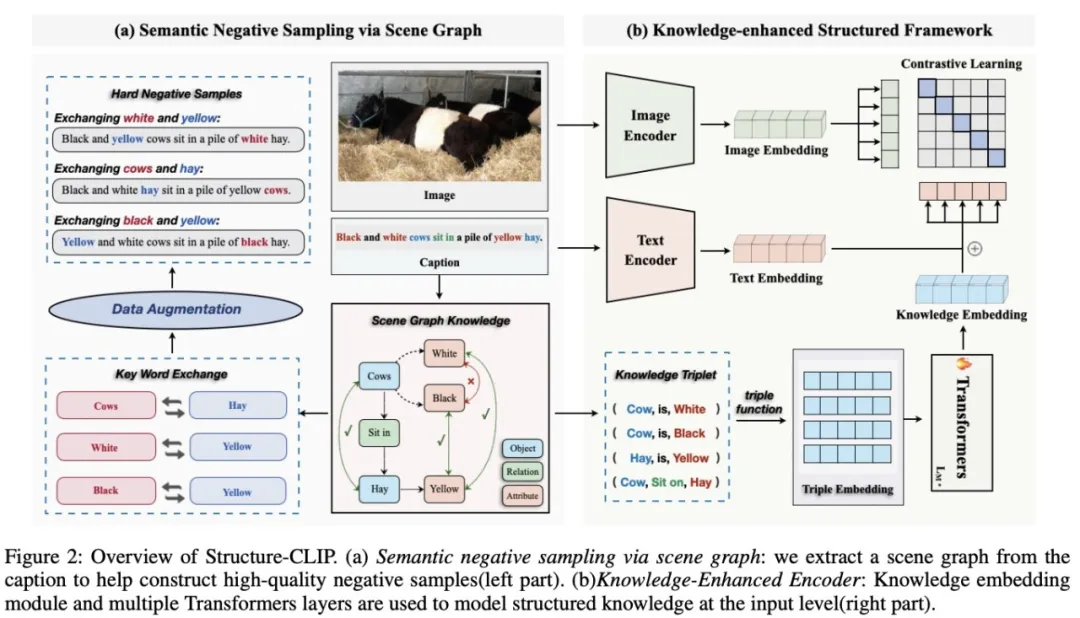

針對上述問題,我們提出了Structure-CLIP,旨在通過場景圖知識增強多模態結構化表示。與NegCLIP的隨機交換方法不同,Structure-CLIP采用了基于場景圖的引導策略來進行單詞交換,以更精確地捕捉底層語義意圖。此外,我們提出了一種知識增強編碼器,它利用場景圖來提取關鍵的結構信息,并通過在輸入層面上融合結構化知識,從而增強結構化表示的能力。在Visual Genome Relation和Visual Genome Attribution兩個數據集上的實驗結果展示了我們的Structure-CLIP模型的卓越性能以及其組件的有效性。此外,我們在MSCOCO數據集上進行了跨模態檢索評估,結果表明Structure-CLIP仍保留了充分的通用表征能力。

總的來說,我們的貢獻點可以總結成以下三點:

- 據我們所知,Structure-CLIP是第一種通過構建語義負樣本來增強細粒度結構化表示的方法。

- Structure-CLIP引入了結構化知識增強編碼器,利用結構化知識作為輸入來增強結構化表征能力,實現從結構化信息到文本信息的有效知識轉移。

- 我們進行了全面的實驗,證明Structure-CLIP能夠在結構化表示的下游任務上實現最先進的性能,并在結構化表示方面取得了顯著的改進。

二、問題設定和解決思路

給定一個圖像,以及兩個圖像標題和,其中圖像標題與圖像內容匹配,而則與圖像不匹配。重要的是,這兩個文本標題由相同的單詞構成,但其單詞順序有所不同。細粒度圖文匹配任務的核心目標是在兩個高度相似的圖像標題中準確識別出與當前圖像匹配的標題。具體來說,任務要求模型使得圖像與匹配文本的得分高于圖像與不匹配文本的得分。

如圖所示是我們提出的Structure-CLIP模型的框架圖。在該模型中,我們首先利用場景圖來生成由相同詞匯構成但含有不同細粒度語義的高質量語義負樣本,然后通過對比學習的方式來提升細粒度結構化表示的能力(如圖左側所示)。其次,我們設計并實現了一種結構化知識增強的編碼器,該編碼器以場景圖作為輸入,并將結構化知識融入到結構化表示中(如圖右側所示),從而實現了結構化信息向文本信息的有效知識遷移。

三、方法

1.基于場景圖的語義負采樣對比學習策略

- 場景圖生成

在描述視覺場景時,場景圖通過更細致地刻畫對象間的屬性和關系,提供了更精確和全面的語義信息。我們利用場景圖解析工具,將文本句子解析成相應的場景圖。以標題 Black and white cows sit in a pile of yellow hay 為例,在生成的場景圖中,我們可以關注到文本中的關鍵元素,如 cow 和 hay ;相關屬性,如white和yellow,用于描述對象的顏色或其他屬性;以及關系,如 sit in ,表示對象之間的空間位置或其他類型的關系。通過這種方式生成的場景圖能夠將文本信息轉換為更詳細的對象描述和關系,從而提供更精細的結構化知識表達。這有助于我們更深入地理解句子中表達的結構化知識,可以增強細粒度的視覺-語言聯合表示,從而提高模型的整體性能和效果。

- 語義負樣本的選擇

在本研究中,我們采用了一種基于場景圖引導的策略來構建高質量的語義負樣本。這一方法與先前隨機交換句子中單詞位置的方法形成了鮮明對比。我們的語義負樣本在保持句子的基本結構不變的同時,改變了句子的細粒度語義。這一策略確保了負樣本在語義層面上與正樣本存在顯著的差異,同時保持了詞匯的基本組成。因此,借助這些高質量的語義負樣本,我們的模型能夠更有效地學習和掌握細粒度的結構化語義表示。

具體來說,對于文本場景圖中的三元組,我們通過交換文本中的兩個對象主體來生成高質量語義負樣本。例如,通過交換文本 An astronaut is ridding a horse 中的對象 astronaut 和 horse,我們可以得到高質量負樣本``A horse is ridding an astronaut”。

- 對比學習目標

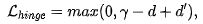

在本研究中,我們采用的對比學習方法旨在通過靠近圖像Ii與其對應原始標題Wi,同時將圖像Ii與生成的高質量語義負樣本Wi-分離,以此來學習高效的多模態表征。為此,我們設計了一個多模態對比學習模塊,其損失函數定義如下:

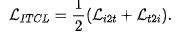

為了確保模型在不同應用場景中均能展現出穩定的通用表征能力,我們采用了一種聯合訓練策略。該策略結合了傳統的小批量圖像-文本對比學習損失和新提出的損失函數。具體而言,原始的圖像-文本對比學習損失LITCL整合了從圖像到文本的對比損失Li2t以及從文本到圖像的對比損失Lt2i。因此,綜合考慮兩個方向的損失,圖像-文本對比學習的總體損失可表示為:

因此,我們的方法結合了hinge損失與InfoNCE損失,從而實現更全面的優化。具體地,最終的損失函數表達式為:

我們實施的聯合訓練策略一方面有效地保持了模型的通用性,這一點在跨模態檢索任務中表現為顯著的性能提升。另一方面,該策略極大地增強了模型在處理結構化表示方面的能力。這種改進不僅有效提高了模型在理解句子中細粒度語義信息的能力,還增強了捕獲深層次語義聯系的能力,從而在處理復雜文本和圖像數據時表現出更高的準確性。

2.結構化知識增強框架

編碼器采用場景圖作為文本輸入的輔助信息,旨在通過這種獨特的結構化輸入來增強模型的結構化表征能力,并實現從結構化表征到文本表征的高效知識遷移。我們設計的知識增強編碼器旨在將知識結構化并整合到模型輸入中。結構化知識包括對象及其屬性和對象間的關系。通過從生成的場景圖中提取這些結構化信息,我們能夠獲取豐富的語義信息,從而有效地捕捉文本的細粒度語義。這一過程涉及了對對象及其屬性和對象間關系的明確建模。

首先,我們為兩種結構化知識(即屬性對和三元組)制定了統一的輸入格式,然后通過三元組編碼方式來獲取三元組向量表示,將 K 個三元組轉換為 K 個語義嵌入向量。再然后將三元組語義嵌入向量輸入到Transformer層中來獲得最終的結構化表征。知識增強編碼器能夠從提供的所有三元組輸入中提取豐富的結構化知識。這種結構化知識對于增強模型的表征能力至關重要,并且對提升模型的整體性能有顯著影響。然而,僅僅依靠結構化知識可能在某種程度上限制模型在捕捉通用語義方面的能力。因此,為了實現更全面的語義理解,我們提出了一種將文本嵌入與結構化知識嵌入結合的方法,來得到文本側的整體表征。通過這種方式,我們的模型不僅能夠捕捉到整個句子所蘊含的詞匯級信息,還能夠綜合理解句子中的結構化知識,從而捕獲更詳細的語義信息。?

四、實驗

1.實驗結果

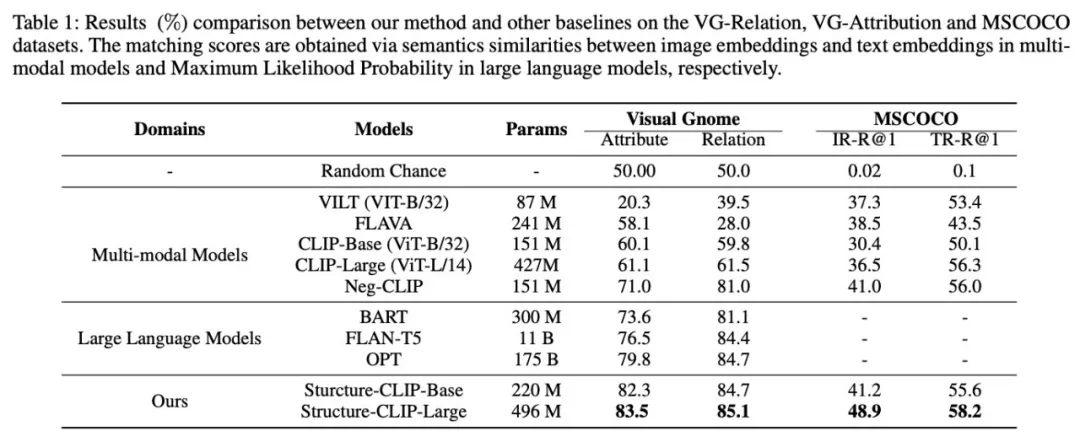

我們將Structure-CLIP與八種代表性的現有方法進行了比較,這包括多種多模態模型以及先進的大型語言模型。在VG-Relation和VG-Attribution數據集上,我們的Structure-CLIP模型展現出了卓越的性能,超越了所有參考的基線模型,實現了最先進的性能表現。這一結果也表明了通過結合場景圖知識,我們的模型顯著增強了其結構話表示能力。

我們也對Structure-CLIP模型在通用表示任務上的性能進行了詳細評估。實驗結果表明,在顯著增強結構化表示能力的同時,Structure-CLIP模型仍然保持了良好的通用表示能力。

2.消融實驗

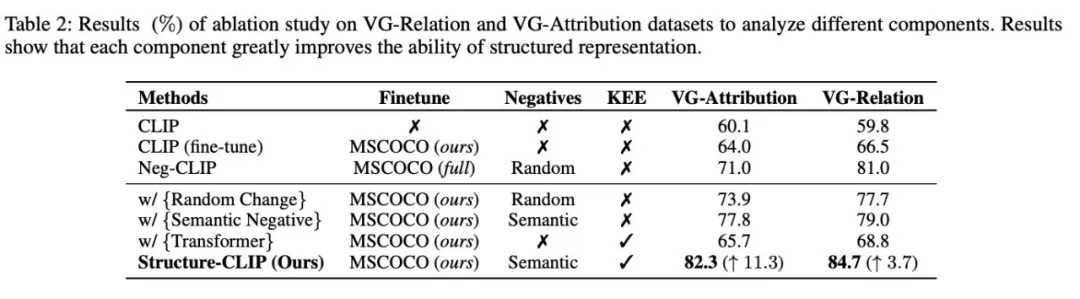

- 成分分析

我們對CLIP-base模型的多個增強版本進行了詳細的消融研究。在采用語義負采樣策略的情況下,模型性能相比于傳統的隨機負樣本采樣策略實現了顯著提升。當知識增強編碼器與語義負采樣策略結合使用時,模型性能實現了顯著提升,這表明知識增強編碼器在此組合策略下的效果得到了顯著加強。

- 超參數分析

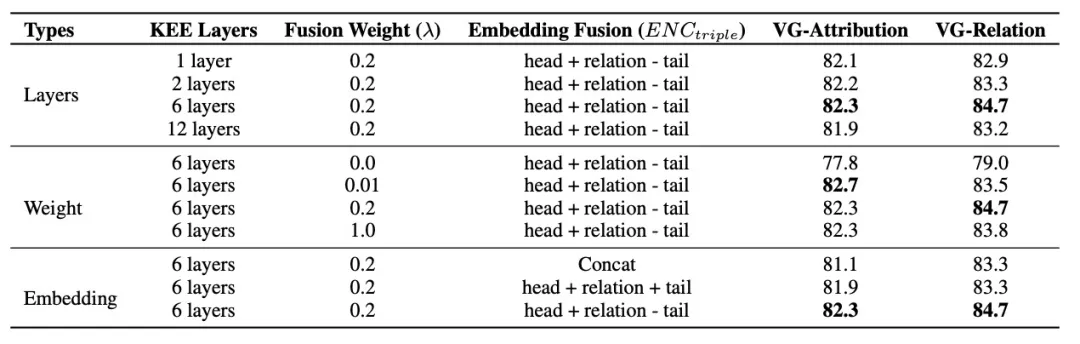

我們對Structure-CLIP在不同超參數和嵌入方法下進行了消融實驗。

- 三元組編碼方式分析

我們探索了三種不同的三元組嵌入方法,以有效整合三元組信息。相比之下,我們提出的三元組嵌入方法既考慮了元素的位置,又綜合了它們的組合信息。我們的Structure-CLIP模型在捕捉句子中的細粒度語義信息方面表現出更強的能力,并顯著增強了多模態結構化表示的性能。

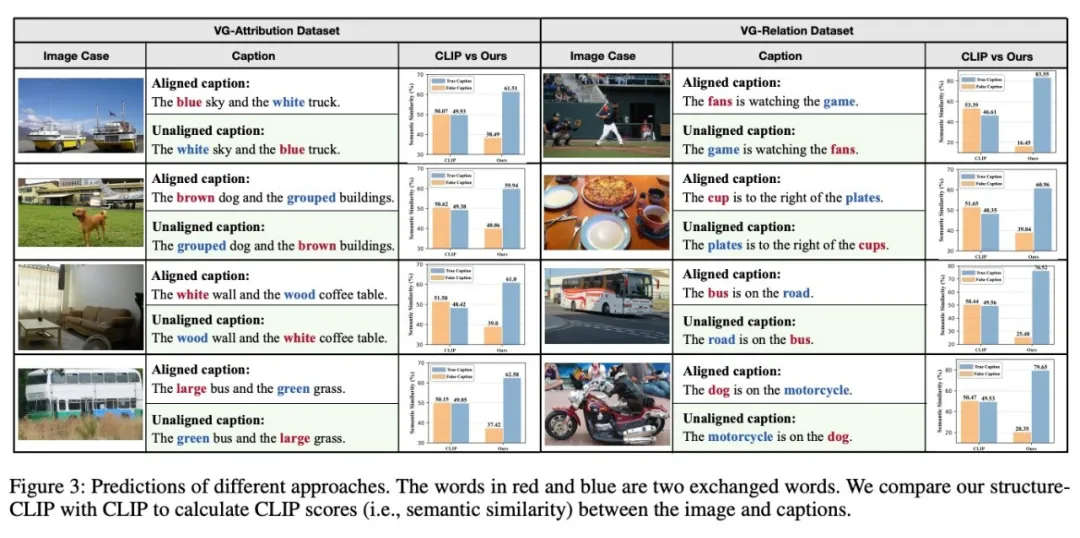

3.Case分析

這些案例清晰地展示了Structure-CLIP在給定圖像的情況下成功區分匹配和未匹配的標題,且區分效果非常顯著。CLIP模型在確定這些標題與給定圖像之間的語義相似性時面臨了一定的挑戰。特別是在兩個屬性或對象被交換的情況下,CLIP模型表現出了接近相同的語義相似性判斷,揭示了其在捕捉結構化語義方面的局限性。相較于CLIP模型,Structure-CLIP對細粒度語義的微小變化展現了更高的敏感性,這突顯了其在結構化知識表征方面的優勢。

五、總結

在本文中,我們提出了Structure-CLIP,旨在整合場景圖知識來增強多模態結構化表示。首先,我們使用場景圖來指導語義否定樣例的構建。此外,我們引入了一個知識增強編碼器來利用場景圖知識作為輸入,從而進一步增強了結構化表示。我們提出的Structure-CLIP在預訓練任務和下游任務上優于所有最近的方法,這表明Structure-CLIP可以有效地和魯棒地理解多模態場景中的細粒度語義。

本文轉載自:??ZJUKG??

作者:黃雨峰