KAM-CoT:知識增強(qiáng)多模態(tài)鏈?zhǔn)剿季S推理 原創(chuàng)

摘要:大型語言模型(LLM)通過利用鏈?zhǔn)剿季S(CoT)實現(xiàn)逐步思考,在自然語言處理任務(wù)中展示了令人印象深刻的表現(xiàn)。將 LLM 擴(kuò)展到多模態(tài)能力是近期的研究熱點,但這會帶來計算成本并需要大量硬件資源。為了解決這些挑戰(zhàn),我們提出了 KAM-CoT,一個將 CoT 推理、知識圖譜(KG)和多種模態(tài)集成起來的框架,以全面理解多模態(tài)任務(wù)。KAM-CoT 采用了一個包含 KG 基礎(chǔ)的兩階段訓(xùn)練過程,以生成有效的推理和答案。通過在推理過程中引入來自 KG 的外部知識,模型獲得了更深的上下文理解,減少了幻覺現(xiàn)象并提升了答案質(zhì)量。這種知識增強(qiáng)的 CoT 推理使模型能夠處理需要外部上下文的問題,提供更為知情的答案。實驗結(jié)果表明,KAM-CoT 優(yōu)于現(xiàn)有的最先進(jìn)方法。在 ScienceQA 數(shù)據(jù)集上,我們達(dá)到了 93.87% 的平均準(zhǔn)確率,超過了 GPT-3.5(75.17%)18% 和 GPT-4(83.99%)10%。值得注意的是,KAM-CoT 實現(xiàn)了這些結(jié)果時,僅使用了 280M 的可訓(xùn)練參數(shù),展示了其成本效益和有效性。

1.引言

大型語言模型(LLM),特別是 GPT-3(Kojima 等,2022a),ChatGPT(OpenAI 2022)和最近的 LLaMA、LLaMA2(Touvron 等,2023a, b),在自然語言處理任務(wù)中展示了卓越的性能。此外,在 LLM 中引入鏈?zhǔn)剿季S(CoT)方法徹底改變了機(jī)器處理推理密集型任務(wù)的方式(Zhou 等,2023)。CoT 指的是 LLM 以逐步方式進(jìn)行思考和推理的能力,類似于人類的認(rèn)知過程(Wei 等,2022b)。傳統(tǒng)的語言模型(LM)在生成響應(yīng)時沒有明確的中間步驟,這可能在復(fù)雜推理場景中導(dǎo)致次優(yōu)答案。CoT 通過引入中間步驟,使語言模型能夠進(jìn)行推理,從而增強(qiáng)模型解決問題的能力,解決了這一局限性。

最近,擴(kuò)展 LLM 以具備多模態(tài)能力的趨勢日益增長。視覺和文本信息的融合在視覺與語言任務(wù)(如視覺問答(VQA)、圖像描述和圖像-文本檢索)方面取得了顯著進(jìn)展,并開啟了變革性進(jìn)步的潛力。Liu 等(2023a);Gao 等(2023);Lu 等(2023a)作者們認(rèn)識并提倡將視覺和語言模態(tài)結(jié)合的價值。然而,這些模型的龐大規(guī)模需要大量的計算資源,特別是在硬件基礎(chǔ)設(shè)施方面。Zhang 等(2023c)提出微調(diào)較小的模型以適應(yīng)多模態(tài)并引出 CoT 能力。然而,這種方法往往會導(dǎo)致幻覺現(xiàn)象,即模型生成看似合理但不正確的推理和答案。一個可能的解決方案是集成知識圖譜(KG)以增強(qiáng)模型理解。

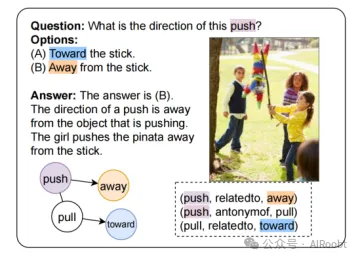

知識圖譜作為寶貴的結(jié)構(gòu)化知識來源,捕捉來自各個領(lǐng)域的信息。對于 CoT 推理,知識圖譜可以補(bǔ)充逐步推理。通過引入知識圖譜中的信息,語言模型可以更連貫地推理,并利用實體和屬性之間的上下文關(guān)系。考慮圖 1 中的問題,關(guān)于推動方向的知識對于回答問題至關(guān)重要。圖 1 右下角顯示的關(guān)于對象關(guān)系和方向的知識圖譜三元組,使模型能夠正確回答問題。這種集成提高了生成響應(yīng)的質(zhì)量,尤其是在需要復(fù)雜推理和上下文感知理解的任務(wù)中。

圖1: 來自ScienceQA數(shù)據(jù)集(Lu等人,2022年)的一個示例,展示了圖表如何輔助多模態(tài)問答。

(注釋:這是來自ScienceQA數(shù)據(jù)集的一個例子(Lu等人,2022年),展示了如何利用圖來輔助多模態(tài)問答(multi-modal QA)。在這個例子中,有一個問題和幾個選項,以及一個答案,還有一個圖解來幫助理解問題和答案。

問題:這個推力的方向是什么?

選項:

(A) 向棍子方向。

(B) 遠(yuǎn)離棍子方向。

答案:答案是 (B)

解釋:一個推力的方向是遠(yuǎn)離正在施加推力的物體。在這個例子中,女孩正在推一個彩罐(pinata),使其遠(yuǎn)離棍子。

圖解中還包含了一些詞匯和它們之間的關(guān)系:

- "push"(推)與 "away"(遠(yuǎn)離)相關(guān)聯(lián)。

- "push"(推)是 "pull"(拉)的反義詞。

- "pull"(拉)與 "toward"(向...方向)相關(guān)聯(lián)。

圖解中的箭頭和文字說明了 "push" 和 "pull" 的方向性,以及它們與 "away" 和 "toward" 的關(guān)系。這種圖示可以幫助用戶更好地理解問題和答案,尤其是在涉及物理概念或動作方向時。通過視覺化這些關(guān)系,可以增強(qiáng)對問題的理解,并幫助找到正確的答案。)

在這項工作中,我們提出通過知識圖譜增強(qiáng)多模態(tài),以幫助模型解決復(fù)雜問題并引出 CoT 能力。提出的方法 KAM-CoT 包括一個接收語言上下文的語言模型,一個編碼視覺特征的視覺編碼器,以及一個在知識圖譜上進(jìn)行推理的圖神經(jīng)網(wǎng)絡(luò)(GNN)。遵循 Zhang 等(2023c),我們將推理過程分為兩個連續(xù)階段。在第一階段,我們生成合理的推理。在第二階段,我們將生成的推理由作為額外輸入并提供答案。KAM-CoT 無縫地將文本、視覺和圖形特征結(jié)合在一起,使機(jī)器能夠像人類認(rèn)知一樣連貫地思考和推理。我們在 ScienceQA(Lu 等,2022)基準(zhǔn)上評估了我們提出的模型,達(dá)到了 93.87% 的平均準(zhǔn)確率,超過了 GPT-3.5(75.17%)18% 和 GPT-4(83.99%)10%。此外,KAM-CoT 在實現(xiàn)這些結(jié)果時僅使用了 280M 的可訓(xùn)練參數(shù),展示了其成本效益和有效性。

本文的貢獻(xiàn)如下:

1. 圖譜提取:我們根據(jù)給定的問答上下文從 ConceptNet(Speer、Chin 和 Havasi 2017)中提取顯著的三元組。

2. 與知識圖譜的融合:我們提出了一些指示性機(jī)制,將文本和圖像模態(tài)與知識圖譜融合,并檢驗其效率。

3. KAM-CoT:我們提出了知識增強(qiáng)的多模態(tài) CoT 方法 KAM-CoT。該 280M 模型在不同階段聯(lián)合處理視覺、文本和知識圖譜,逐步推理以生成合理的推理和答案。

我們在 ScienceQA 數(shù)據(jù)集(Lu 等,2022)上進(jìn)行了廣泛的實驗和評估,達(dá)到了新的最先進(jìn)性能。我們還考察了各組件的效果和貢獻(xiàn),并討論了未來研究的潛在方向。

2.相關(guān)工作

我們從四個關(guān)鍵領(lǐng)域探索相關(guān)工作:上下文學(xué)習(xí)、通過微調(diào)方法的CoT(Chain of Thought,思維鏈)、視覺-語言模型和知識增強(qiáng)方法。

上下文學(xué)習(xí)的大型語言模型(LLMs,Zhao等人,2023年)通過兩種主要模式展示了CoT的能力:零樣本(Zero shot)和少樣本(Few shot)。零樣本不需要任何明確的例子或指導(dǎo)即可進(jìn)行推理。最近的研究表明,當(dāng)用“讓我們一步一步思考”(Kojima等人,2022a)這樣的提示語時,LLMs能夠取得令人滿意的結(jié)果。在少樣本情境中,LLMs提供了一組示范性的例子作為指導(dǎo),使它們能夠從這些實例中把握和學(xué)習(xí)模式。這些例子由人類專家策劃。

Auto-CoT(Zhang等人,2023b)引入了使用LLMs自動構(gòu)建示范性例子的方法。它生成帶有固有噪聲的例子。通過自動采樣多樣化的問題和后處理質(zhì)量控制機(jī)制,它得到了可用的鏈。Wang等人(2022a)提出了一種解碼自洽策略,從多樣化的推理路徑中采樣,然后通過邊緣化所有可能的路徑選擇最一致的答案。PROMPTPG(Lu等人,2023b)采用策略梯度技術(shù),獲得從有限的訓(xùn)練樣本集中辨別上下文相關(guān)例子的能力,然后為給定的樣本構(gòu)建相應(yīng)的提示。Chen等人(2022)提出了思維程序,將計算委托給一個解釋器,將復(fù)雜計算與推理和理解解耦。另一項有趣的工作,最少到最多提示(Zhou等人,2023)提出將復(fù)雜問題分解為更簡單的問題,并通過利用之前解決的子問題的答案依次解決它們。

然而,所有這些方法都限于LLMs,合理地超過100B參數(shù)(Wei等人,2022a)。

通過微調(diào)方法的CoT,Lu等人(2022)提出了一個科學(xué)問題-答案(ScienceQA)數(shù)據(jù)集,它包含有相應(yīng)講座、解釋和正確答案的多模態(tài)多項選擇題。作者觀察到,通過在少量樣本GPT-3和微調(diào)后的UnifiedQA(Khashabi等人,2020)中使用CoT,問題回答的準(zhǔn)確率分別提高了1.20%和3.99%。MM-CoT(Zhang等人,2023c)提出在ScienceQA數(shù)據(jù)集上使用CoT方法對LM進(jìn)行微調(diào)。他們提出了兩個階段的模型:理由生成和答案推理。該模型在該數(shù)據(jù)集上的表現(xiàn)超過了GPT-3.5的16%,并超過了人類的表現(xiàn)。

視覺-語言模型隨著視覺問答任務(wù)(Antol等人,2015)的提出,已經(jīng)有大量工作在對齊視覺和語言模態(tài)。ViLT(Kim、Son和Kim,2021)提出了一個單一的變換器架構(gòu),用于文本和圖像模態(tài),促進(jìn)了無縫的跨模態(tài)交互。Patch-TRM(帶有跨模態(tài)TRM的變換器)將圖像解析成有序的塊,在層次化的金字塔布局中(Lu等人,2021)。這些塊被預(yù)訓(xùn)練的ResNet編碼,并通過視覺變換器傳遞。VisualBERT提出了一個統(tǒng)一的架構(gòu),利用基于變換器的BERT模型的表達(dá)能力,并對齊從圖像中提取的特征(Li等人,2019,2020)。特別是,視覺和文本輸入都被掩蔽,模型學(xué)習(xí)預(yù)測掩蔽的輸入,使其能夠捕獲上下文對齊。BLIP2(Li等人,2023)提出了QFormer,通過兩階段策略預(yù)訓(xùn)練,以對齊圖像編碼器和LLMs。Liu等人(2023b)提出了Prism模型,該模型使用領(lǐng)域?qū)<业募稀OSMOS(Huang等人,2023)在包括任意交錯的文本和圖像、圖像-標(biāo)題對和文本數(shù)據(jù)的網(wǎng)絡(luò)規(guī)模多模態(tài)語料庫上從頭開始訓(xùn)練模型。

最近,隨著LLaMA模型的出現(xiàn),在指令遵循語言建模方面取得了顯著進(jìn)展。LLaVA(Liu等人,2023a)依賴于僅文本的GPT-4(OpenAI,2023)模型,生成多模態(tài)數(shù)據(jù)。作者提出了兩階段訓(xùn)練:特征對齊的預(yù)訓(xùn)練和指令遵循的微調(diào)。LLaMA-Adapter V2(Gao等人,2023)提出了一個基于參數(shù)高效的適配器的視覺指令模型,將指令遵循能力分布在整個模型中。LaVIN(Luo等人,2023)是另一種基于模態(tài)混合的參數(shù)高效技術(shù)。SCITUNE(Horawalavithana等人,2023)和T-SciQ(Wang等人,2023)是專注于科學(xué)的視覺和語言理解模型。Chameleon(Lu等人,2023a)通過為LLMs增加即插即用模塊來減輕訪問最新信息的限制,用于組合推理。然而,所有這些指令遵循方法都需要更大的模型,通常超過7B參數(shù)。

知識增強(qiáng)方法最近幾項研究探索了將結(jié)構(gòu)化知識注入LLMs。SKILL(Moiseev等人,2022)提出將知識圖譜(KG)三元組轉(zhuǎn)換為句子,然后用于預(yù)訓(xùn)練。KagNet(Lin等人,2019)提出將問題-答案對從語義空間定位到基于知識的符號空間作為模式圖,然后用層次路徑注意力機(jī)制訓(xùn)練圖卷積網(wǎng)絡(luò)。QA-GNN(Yasunaga等人,2021)提出使用LLMs來估計知識圖譜中節(jié)點的重要性,并在統(tǒng)一的圖上進(jìn)行聯(lián)合推理。Zhang等人(2022)提出了GreaseLM模型,該模型在多層語言-KG交互中融合了預(yù)訓(xùn)練LLMs和圖神經(jīng)網(wǎng)絡(luò)的編碼表示。擴(kuò)展到多模態(tài),VQA-GNN(Wang等人,2022b)提出將圖像級場景圖與概念知識統(tǒng)一,以在統(tǒng)一的圖上進(jìn)行聯(lián)合推理。

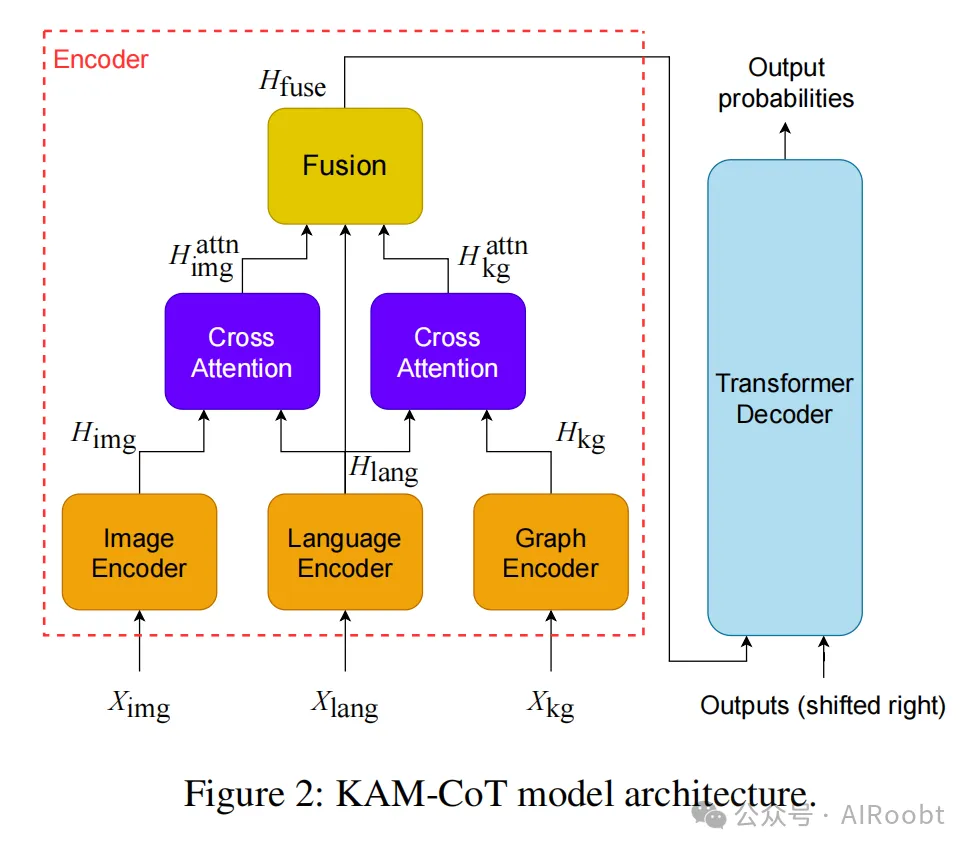

3.方法

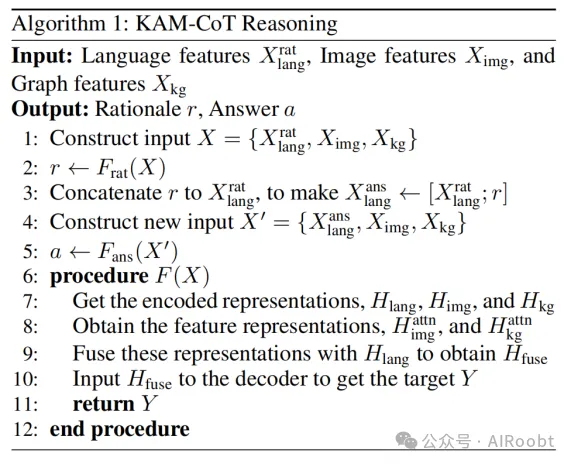

在本節(jié)中,我們描述了提出的KAM-CoT方法。概述而言,KAM-CoT包括對語言、圖像和圖結(jié)構(gòu)輸入的編碼。需要注意的是,圖結(jié)構(gòu)是從語言輸入中派生出來的。然后,這三種模態(tài)通過交叉注意力機(jī)制進(jìn)行交互。最后,將融合的特征輸入到一個transformer解碼器中,生成自回歸文本。

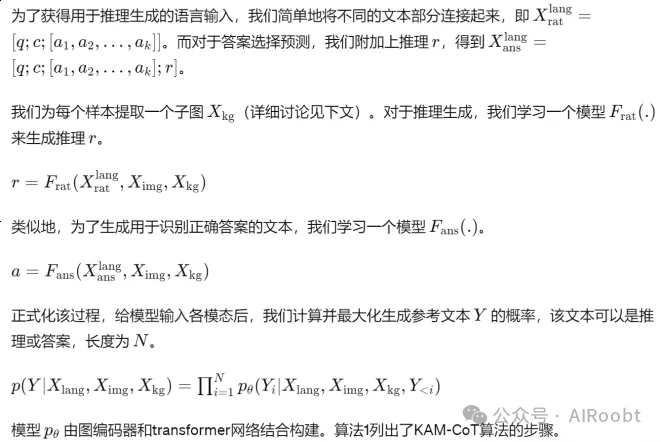

3.1 任務(wù)表述

給定一個問題 q 以及 k 個答案選項 {a1, a2, . . . , ak},,任務(wù)是選擇正確的選項。問題 q 可選地附帶一個圖像 Ximg 和一個提供背景信息的文本 c 。

一種可能的方法是使用神經(jīng)網(wǎng)絡(luò)直接生成正確的選項。然而,已經(jīng)證明,鏈?zhǔn)剿季S推理有助于得出正確答案,特別是對于復(fù)雜推理任務(wù)(Wei et al. 2022b; Kojima et al. 2022b)。因此,我們訓(xùn)練模型在第一步生成答案的推理 r 。下一步是在生成過程中結(jié)合 r 及現(xiàn)有輸入來選擇正確答案。推理生成和答案識別模型是相同的,但它們從相同的初始化獨立訓(xùn)練。這與Zhang et al. (2023c)處理僅圖像和文本模態(tài)的方法類似。在我們的案例中,我們擴(kuò)展了他們的方法,以處理作為附加模態(tài)的圖結(jié)構(gòu),從而將生成過程基于事實知識。

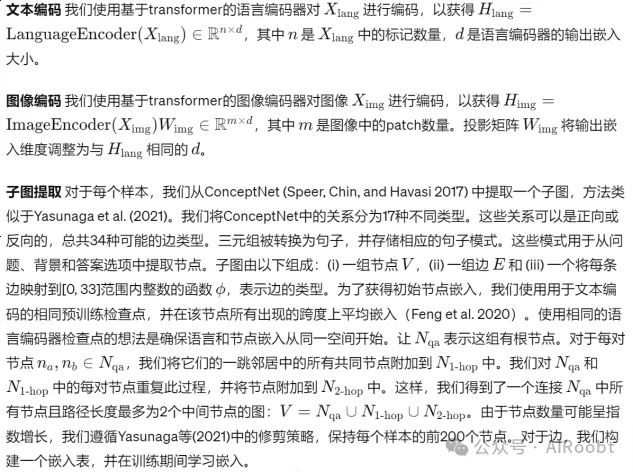

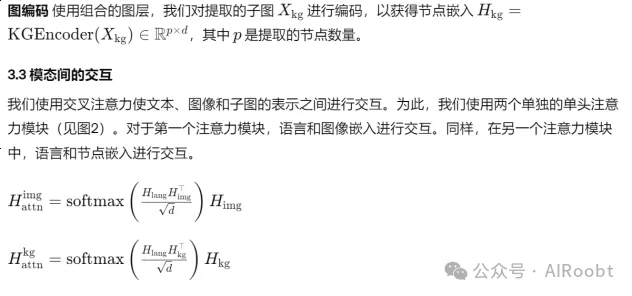

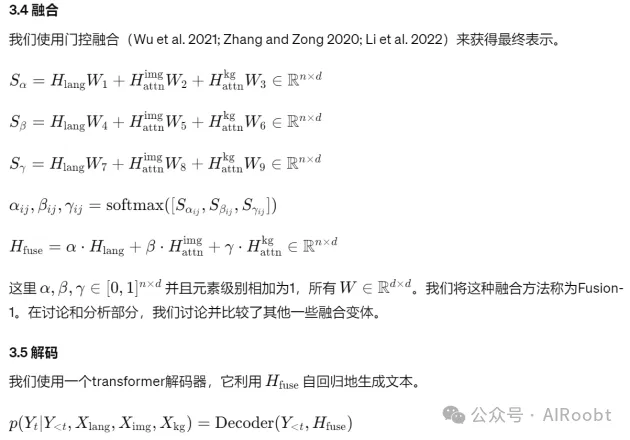

3.2 編碼不同模態(tài)的輸入

4.實驗(略)

5.討論和分析(略)

6.結(jié)論

在本文中,我們提出了KAM-CoT,即知識增強(qiáng)的多模態(tài)鏈?zhǔn)酵评恚蕴岣哒Z言模型的推理能力和答案質(zhì)量。我們提出了一個框架,該框架使用鏈?zhǔn)酵评恚弥R圖譜和其他模態(tài)對多模態(tài)任務(wù)進(jìn)行全面理解。我們提供了一些可能的方法來融合這些模態(tài)。我們發(fā)現(xiàn),在兩階段訓(xùn)練過程中引入知識圖譜有助于減少幻覺現(xiàn)象。我們的方法在參數(shù)量僅為280M的情況下,達(dá)到了新的最先進(jìn)水平,準(zhǔn)確率為93.87%,分別比GPT-3.5和GPT-4高出18%和10%。未來,我們希望進(jìn)一步整合特定的知識密集領(lǐng)域,并探索高效的融合機(jī)制。我們還希望將我們的解決方案擴(kuò)展到更大規(guī)模的模型,如LLaMA系列。

Mondal D, Modi S, Panda S, et al. Kam-cot: Knowledge augmented multimodal chain-of-thoughts reasoning[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2024, 38(17): 18798-18806.

Samsung R&D Institute India - Bangalore

本文轉(zhuǎn)載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/HbgOqHeeJAKT9je1uLHnbA??