大模型中的知識存儲,到底是怎么回事

1. 引言

大型語言模型(LLMs)在訓練過程中從龐大的知識語料庫(如維基百科)中獲取了大量的事實知識,并在各種自然語言任務中展現出卓越的性能。因此,LLMs 常被視為支撐知識導向任務的知識庫。然而,要有效利用這些模型中的知識,需要深入理解 LLMs 存儲和管理事實知識的機制。這種理解對于模型編輯等任務至關重要,這些任務涉及修改模型中嵌入的知識。

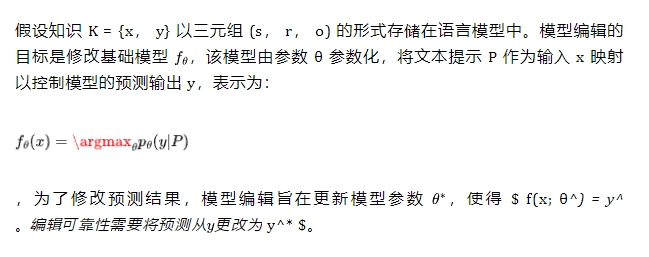

當前的研究主要集中在研究 LLMs 中嵌入的知識。這些工作將知識視為三元組 (s, r, o),包括頭實體(主語,s)、尾實體(賓語,o)和它們之間的關系 r。研究人員探索了語言模型如何在其參數中封裝知識。

例如,Dai 等人采用知識歸因方法,識別出表達事實知識的特定神經元,而 Meng 等人使用因果追蹤發現主語與 MLP 模塊之間存在強因果關系。

然而,這些研究主要從實體的角度調查 LLMs 中的知識。如果我們從關系的角度來處理相同的知識,可能會得到完全不同的觀察結果。理論上,一條知識包括實體和它們之間的關系;缺少任何一個,知識就是不完整的。因此,在這種情況下,實體和關系應該是等價的,這也是當前許多模型編輯工作的前提,因為需要在模型參數中修改知識。

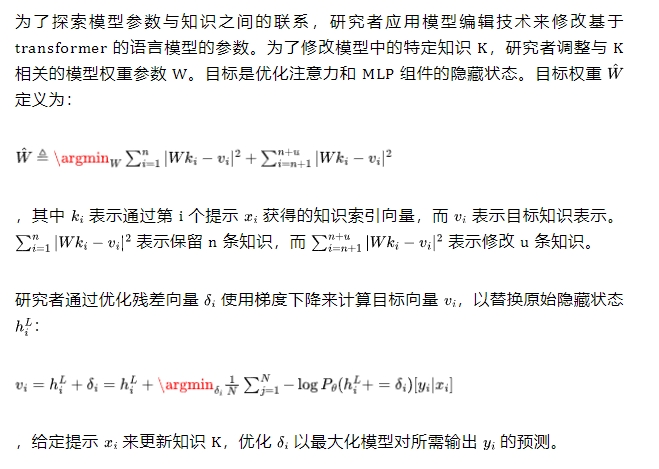

盡管如此,目前的研究還沒有探討這種等價性是否成立。為了填補這一空白,本文調查了實體和關系之間的差異。為了探索這種潛在的等價性,研究者采用了模型編輯技術,這是一種用于更新或糾正語言模型中新的或錯誤知識的技術。

研究目標是通過修改實體或關系知識來確定這些變化是否會產生一致的結果,并從兩個角度觀察效果。理想情況下,這些效果應該是相同的,因為編輯的知識涉及同一條信息。

2. 相關工作

隨著事實信息的不斷演變,存儲在大型語言模型(LLMs)中的知識可能會變得過時或不正確。因此,迫切需要及時更新 LLMs 中不恰當的知識,同時保留其他有價值的知識。最近,這個問題引起了研究人員的廣泛關注。

雖然參數高效微調和增量學習技術提供了修改 LLMs 的途徑,但需要注意的是,這些方法可能容易過擬合,并且在應用于具有極大參數規模的 LLMs 時可能會產生巨大的計算成本。為了解決這些問題,Sinitsin 等人提出了模型編輯(Model Editing)的概念,旨在高效準確地改變模型中存儲的事實知識。

目前,主要有三種類型的模型編輯方法:

- 基于記憶的方法:這些技術利用額外的可訓練參數來存儲記憶或學習 LLMs 中知識更新所需的調整(Δ)。

- 定位-編輯方法:這些方法采用因果中介分析來定位 LLMs 中的知識神經元,然后修改這些識別出的區域。本文主要探討這種知識定位方法。

- 上下文內知識編輯方法:這些方法是一種免訓練的范式,通過在輸入上下文中連接演示來實現知識編輯。

3. 背景與方法

3.1 任務定義

3.2 模型編輯方法

3.3 定位關系知識

因果追蹤

截斷因果分析

4. 實驗

為了研究知識如何存儲在模型參數中,研究者提出了以下研究問題(RQs):

- RQ1:關系知識存儲在哪里?它是否像實體知識一樣存儲在 MLPs 中?

- RQ2:無論存儲位置如何,關系和實體知識在知識三元組中是否同等重要?

4.1 實驗設置

在實驗中,研究者使用 GPT-2 XL(1.5B)和 GPT-J(6B)作為基礎語言模型。實驗在四個 NVIDIA RTX A6000 GPU 和十個 NVIDIA GeForce RTX 3090 GPU 上進行。評估指標包括可靠性和泛化性。

可靠性量化編輯過程的可靠性,可靠性越高表示編輯越成功。為了衡量可靠性,研究者評估編輯準確性如下:

$ M_{rel} = E_{(x,y^) \sim D}[1_{f(x;θ^(x,y^)) = y^}] $

,泛化性衡量編輯后模型的預測在各種輸入或上下文中的泛化能力:

$ M_{gen} = E_{(\tilde{x}) \sim N(x)}[1_{f(\tilde{x};θ^) = f(x;θ^) = y^*}] $

其中 指重新表述的文本提示,N(x) 表示等價于 x 的重新表述提示集。

4.2 RQ1:關系的因果分析

研究者進行了因果追蹤分析,以確定關系知識在模型參數中的位置,結果如圖 2 所示。通過在提示的不同位置和不同模型組件(如單個狀態、MLP 層和注意力層)之間改變中介,計算了 1207 個事實陳述的平均間接效應(AIE)。結果顯示,與先前的發現一致,最后一個標記的最后幾層存在高 AIE 分數。

這表明恢復這些層中 MLP 的隱藏狀態可以恢復大部分必要信息。此外,研究者觀察到故意損壞的關系標記的早期層也存在高 AIE 分數,強調了這些早期層在預測合理性方面的重要性。

同樣,研究者注意到最后一個損壞標記的中間注意力層存在顯著的 AIE。研究者發現,通過知識三元組中的關系 r 識別的知識存儲位置與 MLP 層和注意力層都有很強的相關性,如圖 3 所示。

這一結論與先前通過實體定位識別較低 MLP 層中知識存儲的工作不同。研究者發現,通過關系定位的知識表達與較高的 MLP 層和中上層注意力層密切相關。當探索模型知識表達從實體視角到關系視角時,知識表達的因果位置在模型中發生了顯著變化。

這表明模型參數中的知識存儲位置是復雜的,不能簡單地通過單一視角的因果追蹤來確定,假設知識被隔離在特定的模型層中。因此,研究者認為,通過這種定位來修改相應的模型參數以控制知識的表達是不合理的。

4.3 RQ2:探究等價性

在假設實體和關系視角在知識三元組中在邏輯上等價的前提下,如圖 3 所示,實體知識和關系知識被認為是可互換的。基于這一假設,研究者假設通過改變關系知識來修改實體知識在理論上是可能的。

為了驗證這一假設,研究者應用模型編輯技術從關系和實體角度修改語言模型中的知識,并觀察效果是否相同。表1展示了應用基于關系的模型編輯方法后,從關系和實體兩個角度的評估結果。

表1:編輯關系知識后的性能

方法 | 實體知識 | 關系知識 | ||

可靠性 | 泛化性 | 可靠性 | 泛化性 | |

GPT-2 XL | ||||

FT | 23.92 | 25.44 | 98.79 | 79.03 |

KN | 22.53 | 24.61 | 97.52 | 76.16 |

MEND | 22.33 | 24.63 | 100.0 | 83.24 |

ROME | 27.92 | 28.12 | 99.99 | 84.47 |

MEMIT | 24.15 | 24.63 | 91.36 | 76.24 |

GPT-J | ||||

MEND | 15.51 | 17.99 | 100.0 | 81.52 |

ROME | 30.95 | 31.87 | 100.0 | 95.97 |

MEMIT | 18.92 | 19.37 | 100.0 | 88.50 |

與研究者的假設相反,結果令人驚訝地發現,實體的評估分數遠遠落后于關系的評估分數。編輯關系知識在關系方面取得了高指標,表明這些編輯方法是有效的。然而,實體知識的結果明顯較低,這表明編輯關系并不能有效地改變實體知識。這是令人困惑的,因為同一三元組中的實體和關系定義了一條知識。理論上,改變三元組的任何部分都應該改變整個三元組,這意味著它們應該是等價的。

表2展示了應用基于實體的編輯方法后,從關系和實體角度的評估結果。

表2:通過編輯實體知識的性能

方法 | 實體知識 | 關系知識 | ||

可靠性 | 泛化性 | 可靠性 | 泛化性 | |

GPT-2 XL | ||||

ROME | 99.93 | 96.6 | 96.12 | 74.46 |

MEMIT | 93.88 | 79.6 | 97.28 | 76.01 |

GPT-J | ||||

ROME | 99.99 | 99.49 | 91.37 | 74.52 |

MEMIT | 99.87 | 95.08 | 92.36 | 74.20 |

表2中的結果顯示,評估結果相對穩定,波動較小。關系知識的可靠性有所提高,但泛化性指標顯著下降。這些發現表明,從實體角度進行模型編輯可能會改變知識片段之間的關系信息。然而,這些變化是不一致的。

上述發現表明,編輯實體知識和關系知識并不完全等價。

5. 結論

本文揭示了LLMs中的關系知識不僅編碼在MLP層中,還顯著地編碼在注意力模塊中。這一發現與之前假設知識主要存儲在MLP權重中的觀點形成對比。研究者的分析表明,實體和關系知識在LLMs中是分開存儲的,突出了知識存儲機制的復雜性。

這些見解對于改進模型可解釋性和開發先進的基于知識的應用至關重要。此外,研究者的發現為未來在LLM相關任務(如模型編輯)的研究和開發提供了新的視角。具體來說:

- 知識存儲的復雜性:研究結果表明,LLMs中的知識存儲機制比之前認為的更為復雜。實體和關系知識并不簡單地存儲在相同的位置或以相同的方式表示。這意味著在設計知識編輯或提取算法時,需要考慮這種復雜性。

- 模型編輯的挑戰:研究發現,編輯實體知識和關系知識并不完全等價。這對當前的模型編輯技術提出了挑戰,因為許多現有方法假設可以通過修改一個方面(如實體)來影響另一個方面(如關系)。未來的模型編輯方法需要更細致地考慮知識的不同方面。

- 注意力機制的重要性:研究結果強調了注意力模塊在存儲關系知識方面的重要性。這表明在分析和修改LLMs中的知識時,不能僅僅關注MLP層,還需要考慮注意力機制的作用。

- 模型解釋的新方向:這項研究為理解LLMs如何表示和處理知識提供了新的視角。這可能會引導新的模型解釋方法,幫助研究者更好地理解這些復雜模型的內部工作原理。

- 知識表示的多樣性:研究發現實體和關系知識可能以不同的方式存儲和表示。這暗示了LLMs中知識表示的多樣性,可能需要更復雜的方法來全面理解和操作模型中的知識。

這項研究不僅挑戰了現有的關于LLMs中知識存儲的假設,還為未來的研究指明了方向。它強調了需要更細致、多角度的方法來理解和操作這些復雜模型中的知識。這些見解可能會推動更有效的模型編輯技術、更準確的知識提取方法,以及更深入的模型可解釋性研究。

本文轉載自??芝士AI吃魚??,作者:芝士AI吃魚