Kimi思考模型k1.5是怎么練成的?細節曝光

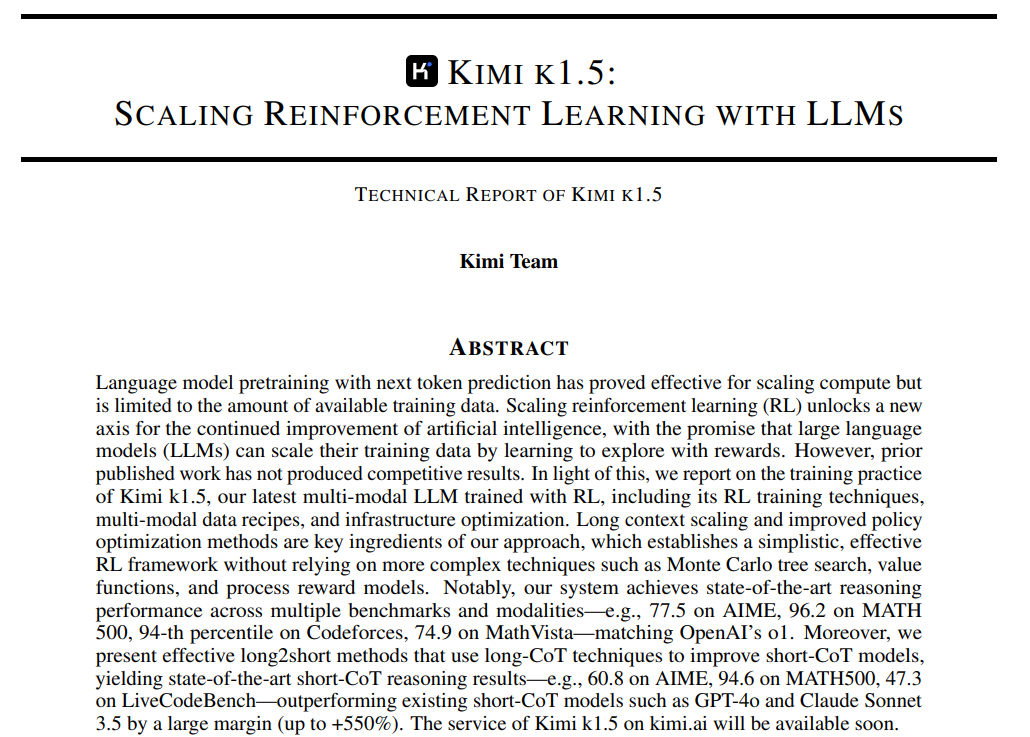

Kimi發布新一代多模態思考模型k1.5,在競賽數學、代碼能力及視覺思考等測試中,k1.5模型性能已達到全球領先模型OpenAI o1 正式版水平,月之暗面也成為OpenAI 之外,全球第二家到達該水平的人工智能企業。

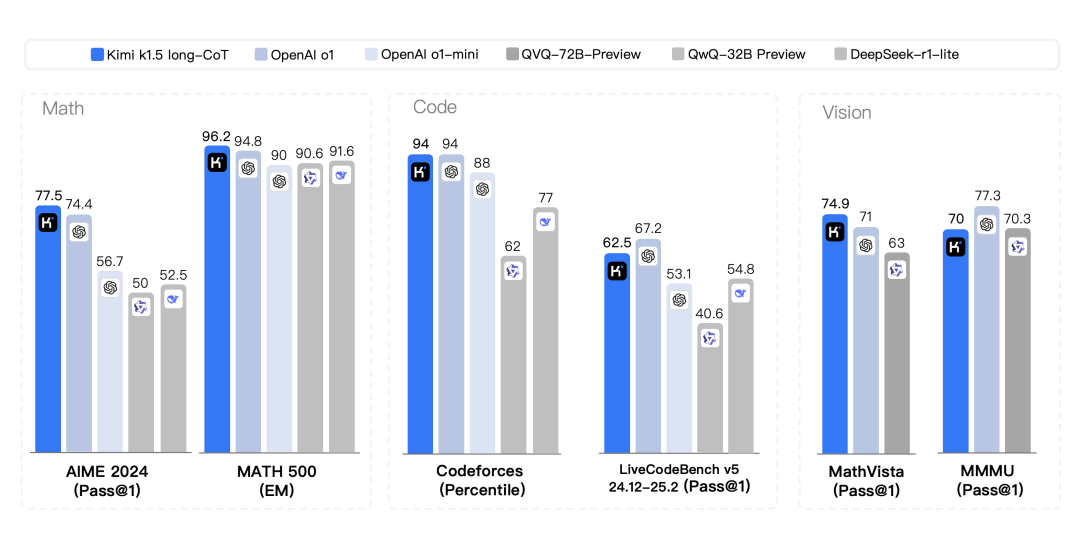

Kimi 1.5 long-CoT評測結果

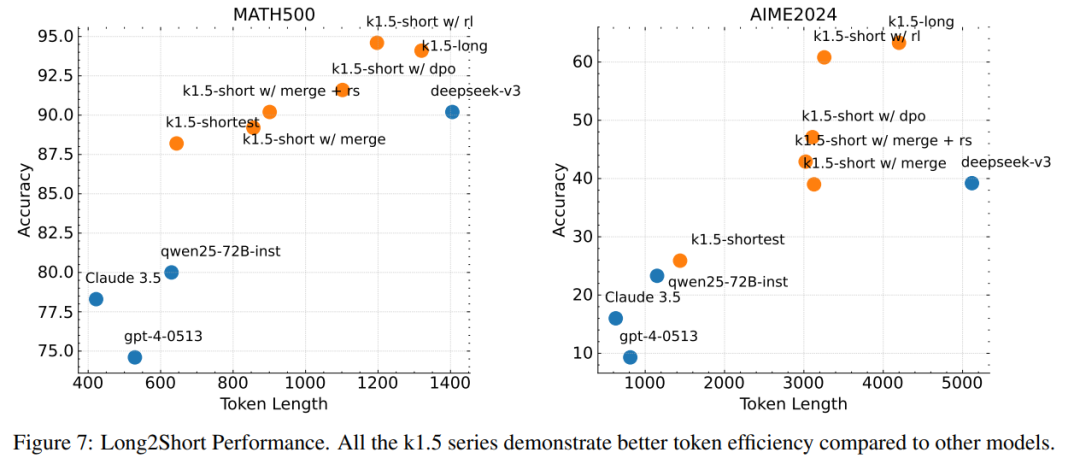

long to short,用長鏈式思考技術改進短鏈式思考模型,在短鏈式推理性能測試中,k1.5模型在數學、代碼、視覺多模態和通用能力等方面到達或超越GPT-4o、Claude Sonnet 3.5等全球領先模型。

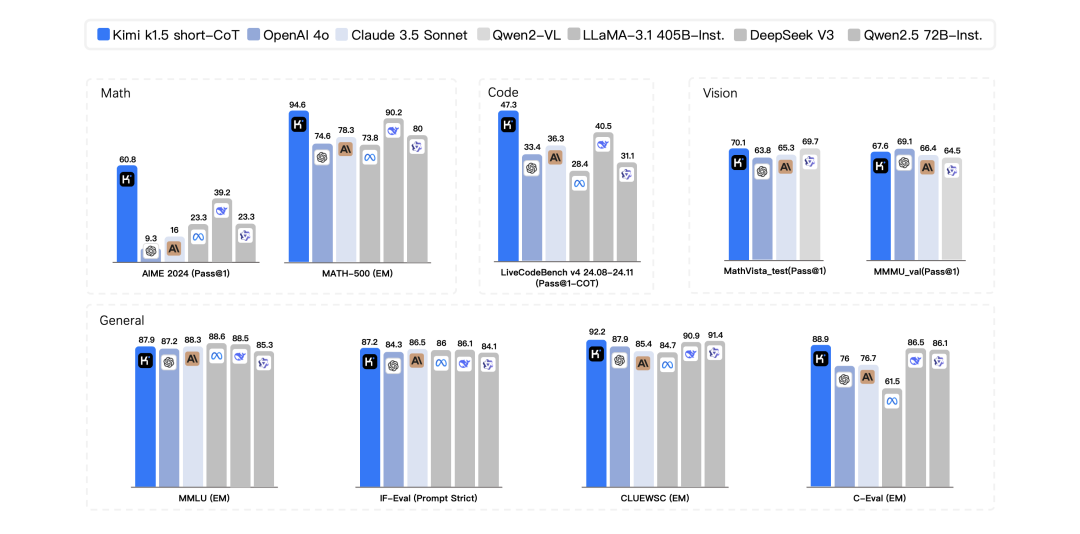

Kimi 1.5 short-CoT評測結果

新模型發布的同時,kimi還首次對外公布了多模態模型技術訓練報告,k1.5的訓練包括這幾個階段:

預訓練 -> SFT -> Long-CoT SFT -> RL

其中,預訓練與SFT要點概況如下:

- 預訓練:k1.5 的預訓練涉及多模態數據(文本、視覺、OCR 等),并分為三個階段:視覺-語言預訓練、冷啟動階段和長文本激活階段。

- 監督微調:使用高質量的標注數據進行分階段學習率調整微調,涵蓋問答、寫作、數學、編程和視覺-文本數據。

25頁的技術報告重點聚焦在強化學習部分:

數據構建 -> 預熱 Long-CoT SFT -> RL -> Long2Short

https://github.com/MoonshotAI/Kimi-k1.5/blob/main/Kimi_k1.5.pdf

1. RL數據構建

數據質量和多樣性對強化學習的效果至關重要。高質量的提示集可以引導模型進行穩健的推理,并減少 reward hacking 和 overfitting 的風險。

- 多樣化覆蓋:涵蓋廣泛的學科領域(如 STEM、編程和通用推理),以增強模型的適應性。

- 難度平衡:包含不同難度級別的問題,以支持模型的逐步學習。

- 可驗證性:答案和推理過程應能夠被準確驗證,避免模型通過錯誤的推理過程得出正確答案。

2、預熱-Long-CoT微調

通過構建小的高質量 Long-CoT 熱身數據集并進行微調,目的是讓模型內化人類推理的關鍵認知過程(如規劃、評估、反思和探索),從而提升其在復雜推理任務中的表現和邏輯連貫性。

3、強化學習

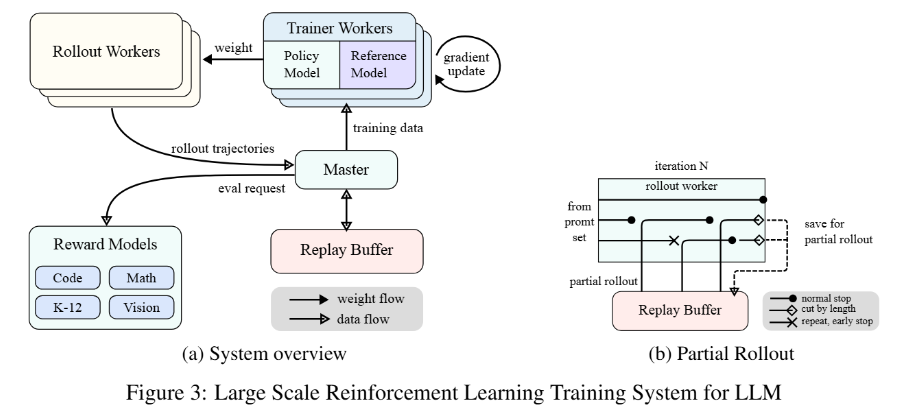

強化學習是 k1.5 的核心訓練階段,無需依賴蒙特卡洛樹搜索(MCTS)、價值函數或過程獎勵模型等復雜技術,通過長上下文擴展和策略優化實現高效學習。

- 長上下文擴展是k1.5的核心創新之一。通過將上下文窗口擴展到128k,模型能夠處理更復雜的推理任務。背后的關鍵技術是 partial rollout ,它允許模型在訓練過程中復用之前生成的軌跡片段,避免從頭開始生成新軌跡,從而顯著提高訓練效率。

- k1.5采用在線鏡像下降算法的變體進行策略優化,通過采樣策略、長度懲罰和數據配方優化,進一步提升模型性能。長度懲罰機制通過限制模型生成過長的推理過程,提高推理效率,同時避免“過度思考”問題。此外,模型還采用了curriculum sampling和 prioritized sampling 策略,優先訓練模型在困難問題上的表現。

4、Long2short

Long-CoT模型表現出色,但在測試時消耗的token數量比Short-CoT更多。有沒可能將Long-CoT推理模型的思維先驗轉移到Short-CoT推理模型中,從而即使在測試時的token預算有限的情況下,也能提升性能,答案是肯定,k1.5嘗試了以下方法:

- 模型融合(Model Merging):通過平均權重合并Long-CoT 和Short-CoT 模型。?

- 最短拒絕采樣(Shortest Rejection Sampling):從多次采樣中選擇最短的正確答案。?

- 直接偏好優化(DPO):通過正負樣本對訓練Short-CoT 模型。?

- Long2Short RL 訓練:通過 RL 進一步優化Short-CoT 模型的性能。

本文轉載自?? PaperAgent??,作者: PaperAgent