ICLR2024杰出論文——Never Train from Scratch!

今天給大家介紹一篇ICLR2024的杰出論文,這篇文章深入探討了自監督預訓練對于使用Transformer進行長序列建模的重要性。

論文標題:Never Train from Scratch: FAIR COMPARISON OF LONGSEQUENCE MODELS REQUIRES DATA-DRIVEN PRIORS

下載地址:??https://arxiv.org/pdf/2310.02980??

1、背景介紹

在一些長序列建模數據集benchmark中,例如Long Range Arena,使用RNN或者SSM這種基礎的序列模型效果要顯著優于Transformer模型。

然而,文中提出這種評估方式并不科學。現有的基于LRA這類benchmark評估模型效果的方法,都是直接在這些長序列上從0開始擬合目標。這種情況下,Transformer的效果確實會比RNN、SSM等模型效果差很多。

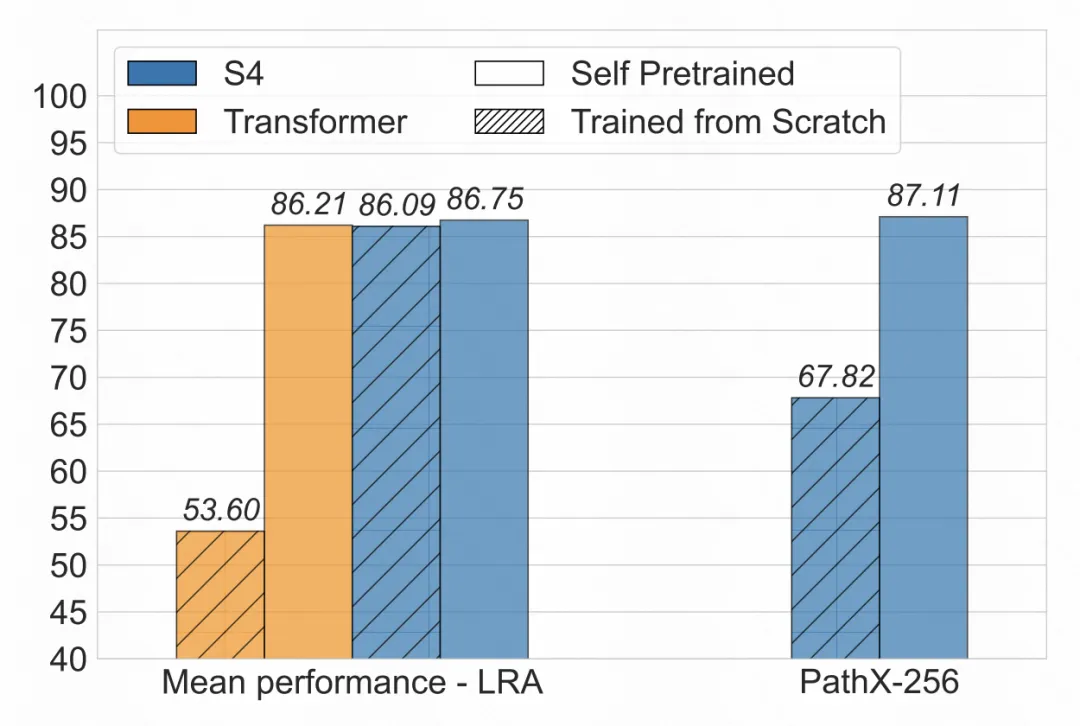

但是如果使用這些數據先對模型做一下預訓練,就會發現Transformer的效果和SSM基本一致。如下圖所示,從頭訓練,Transformer的效果和S4有很大差距;而如果使用mask language model等預訓練任務進行自監督學習,就會發現Transformer的效果取得了大幅提升。同時,S4的效果也會有一定的提升。

2、實驗方法

針對上述現象,文中提出在進行長序列benchmark等任務上的評估時,直接從0訓練對比不同模型效果是不公平的,因為模型并沒有被充分訓練。文中提出應該先用SFT在目標數據上進行訓練,使模型有一個良好的初始化點,再進行finetune,才能實現不同模型公平的對比。

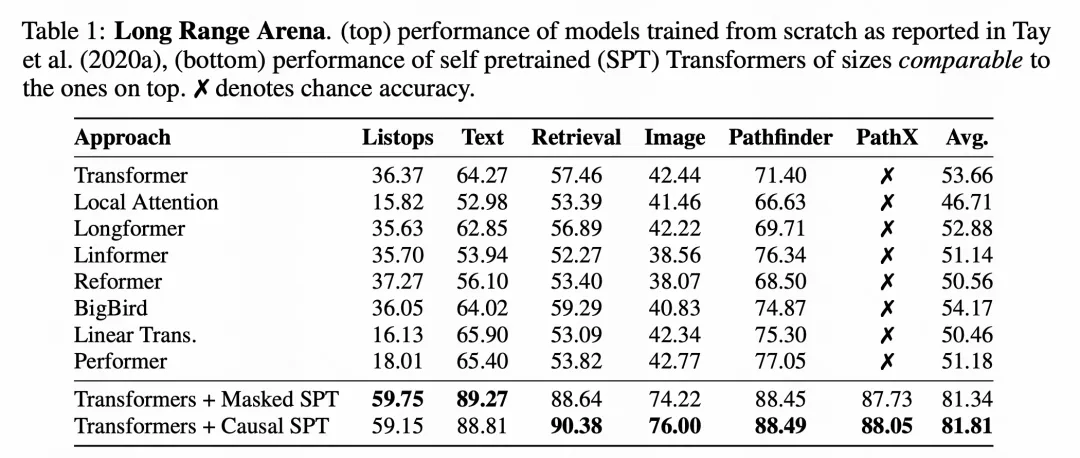

文中主要在LRA數據集上進行Transformer和SSM的效果對比驗證。LRA主要包括6個長序列分類任務,包括長文本的匹配任務、列表分類任務、一維化圖像的分類任務等等。

在訓練方法使用,增加預訓練緩解,使用自回歸預測下一個token,或者mask序列中部分token進行還原,作為自監督學習的目標。整個預訓練都是在目標數據集中進行的,不會引入其他外部數據。

3、實驗效果

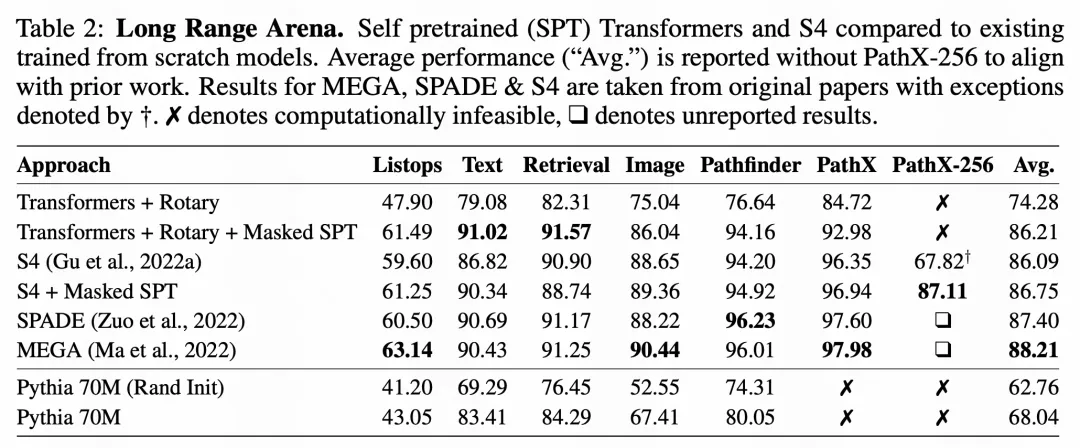

下表是一個主要的實驗結果,其中上半部分是各個模型從頭進行訓練的效果,由A benchmark for efficient transformers. In 9th International Conference on Learning Representations(ICLR 2021)論文中發表,包括各類優化版Transformer效果。下面兩行是本文提出的使用預訓練進行Transformer充分訓練后,再在目標數據上進行finetune。可以看到,經過SFT,Transformer的效果得到了非常大幅度的提升。

即使是在S4模型上,引入自監督預訓練后,在某些困難數據集上也會取得提升。并且從下面實驗來看,充分預訓練的公平對比下,Transformer效果和S4接近,遠沒有從頭訓練時二者效果差異大。

由此可見,充分的自監督訓練,找到一個比較好的初始點,對于公平對比不同模型性能是非常重要的。同時,這也啟發我們在使用Transformer這類inductive bias較少的模型時,可以通過自監督學習來提升模型效果。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise