圖上的推理:忠實且可解釋的大型語言模型推理(ICLR2024) 原創

摘要:大型語言模型(LLMs)在復雜任務中展示了令人印象深刻的推理能力。然而,它們缺乏最新的知識,并在推理過程中出現幻覺,這可能導致不正確的推理過程,從而降低其性能和可信度。知識圖譜(KGs)以結構化格式捕捉大量事實,為推理提供了可靠的知識來源。然而,現有的基于KG的LLM推理方法僅將KG視為事實知識庫,忽視了其結構信息在推理中的重要性。在本文中,我們提出了一種新方法,稱為圖上推理(RoG),它將LLMs與KGs協同作用,以實現忠實且可解釋的推理。具體而言,我們提出了一個規劃-檢索-推理框架,其中RoG首先生成由KGs支撐的關系路徑作為忠實的計劃。這些計劃隨后用于從KGs檢索有效的推理路徑,以便LLMs進行忠實的推理。此外,RoG不僅通過訓練從KGs中提煉知識以提高LLMs的推理能力,還允許在推理過程中與任何任意的LLMs無縫集成。在兩個基準KGQA數據集上的廣泛實驗表明,RoG在KG推理任務上達到了最先進的性能,并生成了忠實且可解釋的推理結果。

1、引言

大型語言模型(LLMs)在許多自然語言處理(NLP)任務中表現出色(Brown et al., 2020; Bang et al., 2023)。尤其引人注目的是它們通過推理處理復雜任務的能力(Wei et al., 2022; Huang & Chang, 2023)。為了進一步釋放LLMs的推理能力,提出了計劃-解決范式(Wang et al., 2023c),其中LLMs被提示生成一個計劃并執行每個推理步驟。通過這種方式,LLMs將復雜的推理任務分解為一系列子任務并逐步解決(Khot et al., 2022)。

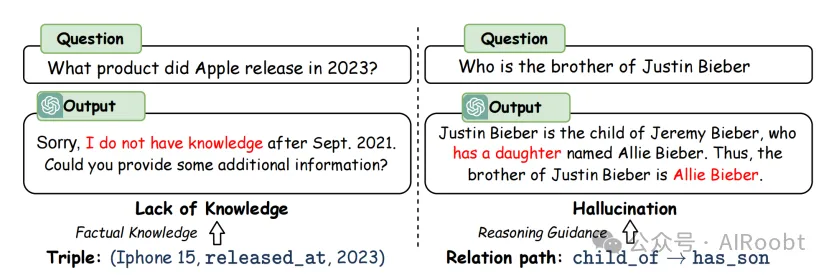

盡管取得了成功,LLMs仍然受到知識缺乏的限制,并在推理過程中容易出現幻覺,這可能導致推理過程中的錯誤(Hong et al., 2023; Wang et al., 2023b)。例如,如圖1所示,LLMs沒有最新的知識并且幻覺出一個錯誤的推理步驟:“有一個女兒”。這些問題在高風險場景(例如法律判斷和醫療診斷)中大大降低了LLMs的性能和可信度。

圖1:大型語言模型(LLMs)推理中知識缺乏和幻覺的問題,以及如何通過知識圖譜(KGs)中的三元組和關系路徑來解決這些問題。

為了解決這些問題,知識圖譜(KGs)被引入以提高LLMs的推理能力(Pan et al., 2024; Luo et al., 2023a)。KGs以結構化格式捕獲豐富的事實知識,為推理提供可信的知識源。作為典型的推理任務,知識圖譜問答(KGQA)旨在根據KG中的知識獲取答案(Sun et al., 2019)。先前將KGs與LLMs聯合用于KGQA推理的工作大致可以分為兩類:1)語義解析方法(Lan & Jiang, 2020; Ye et al., 2022),這些方法使用LLMs將問題轉換為在KG上執行的邏輯查詢以獲取答案;2)檢索增強方法(Li et al., 2023; Jiang et al., 2023),這些方法從KGs中檢索三元組作為知識上下文,并使用LLMs獲得最終答案。

盡管語義解析方法通過利用KGs進行推理可以生成更準確和可解釋的結果,但生成的邏輯查詢通常不可執行,且由于語法和語義限制而得不到答案(Yu et al., 2022a)。檢索增強方法更加靈活,并利用LLMs的推理能力。然而,它們僅將KGs視為事實知識庫,忽視了其結構信息在推理中的重要性(Jiang et al., 2022)。例如,如圖1所示,一個關系路徑,即關系序列“子女→有兒子”,可以用來回答“賈斯丁·比伯的兄弟是誰?”這個問題。因此,使LLMs能夠直接在KGs上推理是實現忠實和可解釋推理的關鍵。

在本文中,我們提出了一種新方法,稱為圖上推理(RoG),它將LLMs與KGs協同作用,以進行忠實和可解釋的推理。為了解決幻覺和知識缺乏的問題,我們提出了一種規劃-檢索-推理框架,其中RoG首先通過規劃模塊生成由KGs支撐的關系路徑作為忠實的計劃。這些計劃隨后被用于通過檢索-推理模塊從KGs中檢索有效的推理路徑,以進行忠實推理。通過這種方式,我們不僅從KGs中檢索最新的知識,還考慮了KG結構對推理和解釋的指導。此外,RoG的規劃模塊可以在推理期間與不同的LLMs進行即插即用的集成,以提高它們的性能。基于該框架,RoG通過兩個任務進行優化:1)規劃優化,我們從KGs中提煉知識以生成忠實的關系路徑作為計劃;2)檢索-推理優化,我們使LLMs能夠基于檢索到的路徑進行忠實推理,并生成可解釋的結果。我們在兩個基準KGQA數據集上進行了廣泛實驗,結果表明,RoG在KG推理任務上達到了最先進的性能,并生成了忠實和可解釋的推理結果。

2、相關工作

LLM推理提示。許多研究提出了通過提示利用LLMs的推理能力來處理復雜任務(Wei et al., 2022; Wang et al., 2022; Yao et al., 2023; Besta et al., 2023)。計劃-解決(Wang et al., 2023c)提示LLMs生成一個計劃并根據其執行推理。DecomP(He et al., 2021)提示LLMs將推理任務分解為一系列子任務并逐步解決。然而,幻覺和知識缺乏的問題影響了LLMs推理的可信度。ReACT(Yao et al., 2022)將LLMs視為代理,與環境互動以獲取最新的推理知識。為了探索忠實推理,FAME(Hong et al., 2023)引入蒙特卡洛規劃來生成忠實的推理步驟。RR(He et al., 2022)和KD-CoT(Wang et al., 2023b)進一步從KGs中檢索相關知識,以為LLMs生成忠實的推理計劃。

知識圖譜問答(KGQA)。傳統的基于嵌入的方法在嵌入空間中表示實體和關系,并設計特殊的模型架構(例如,關鍵值記憶網絡、序列模型和圖神經網絡)來推理答案(Miller et al., 2016; He et al., 2021; Yasunaga et al., 2021)。為了將LLMs與KGQA結合,檢索增強方法旨在從KGs中檢索相關事實,以提高推理性能(Li et al., 2023; Karpukhin et al., 2020)。最近,UniKGQA(Jiang et al., 2022)將圖檢索和推理過程統一為一個與LLMs的單一模型,達到了KGQA任務的最佳性能。語義解析方法通過LLMs將問題轉換為結構查詢(例如SPARQL),這些查詢可以由查詢引擎執行以在KG上推理答案(Sun et al., 2020; Lan & Jiang, 2020)。然而,這些方法在很大程度上依賴于生成查詢的質量。如果查詢不可執行,則不會生成答案。DECAF(Yu et al., 2022a)結合語義解析和LLMs推理以聯合生成答案,在KGQA任務中也取得了顯著性能。

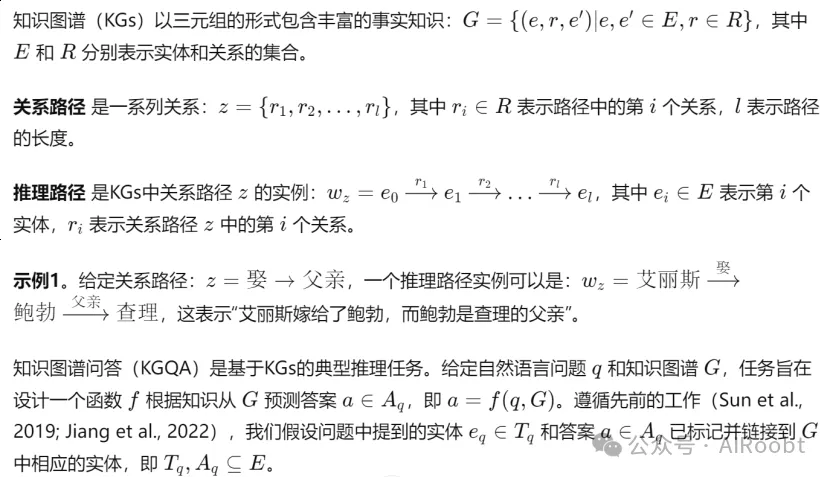

3、初步概念

4、方法

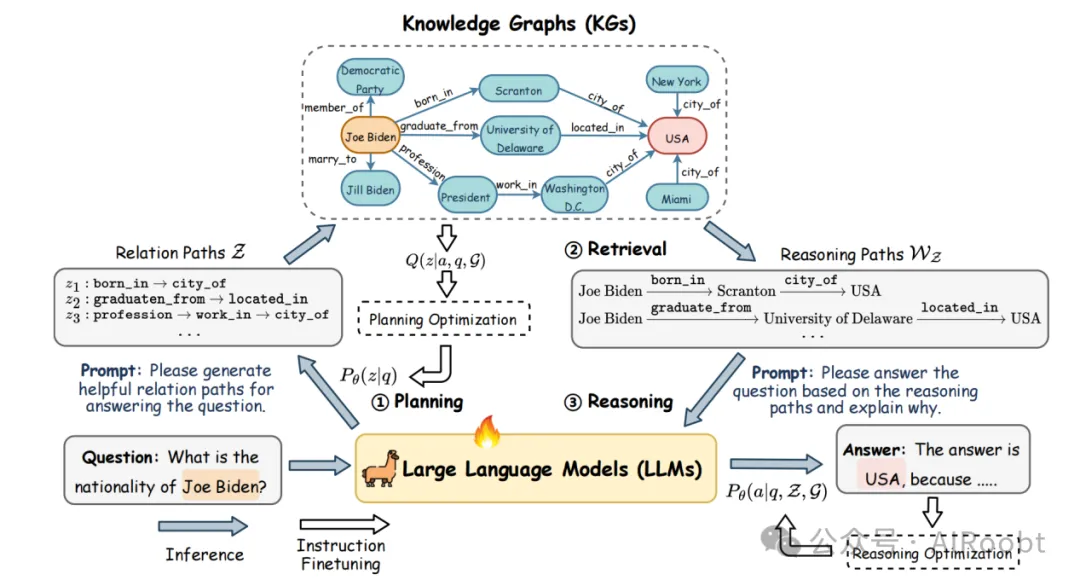

在這一部分,我們介紹我們的方法:圖上推理(RoG),它包含兩個組件:1)一個生成基于KGs的忠實關系路徑作為問題回答計劃的規劃模塊;2)一個檢索-推理模塊,首先根據計劃從KGs中檢索有效的推理路徑,然后根據檢索到的推理路徑進行忠實推理并生成可解釋的答案。RoG的整體框架如圖2所示。

圖2:圖上推理(RoG)的整體框架。1)給定一個問題,我們首先提示大型語言模型(LLMs)生成幾個以知識圖譜(KGs)為基礎的關系路徑作為計劃。2)然后,我們使用這些計劃從KGs中檢索推理路徑。3)最后,我們基于檢索到的推理路徑進行忠實推理,并生成帶有可解釋解釋的答案。橙色和紅色矩形分別表示問題和答案中提到的實體。

4.1 圖上推理:規劃-檢索-推理

最近,許多技術被探索以通過規劃提高LLMs的推理能力,首先提示LLMs生成推理計劃,然后根據該計劃進行推理(Wang et al., 2023c)。然而,LLMs已知存在幻覺問題,容易生成不正確的計劃并導致錯誤答案(Ji et al., 2023)。為了解決這個問題,我們提出了一種新穎的規劃-檢索-推理框架,使推理計劃基于KGs,從而檢索出忠實的推理路徑供LLMs進行推理。

關系路徑捕獲了實體之間的語義關系,已在許多KG上的推理任務中得到應用(Wang et al., 2021; Xu et al., 2022)。此外,與動態更新的實體相比,KG中的關系更穩定(Wang et al., 2023a)。通過使用關系路徑,我們始終可以從KGs中檢索到最新的知識進行推理。因此,關系路徑可以作為回答KGQA任務的忠實計劃。

示例2。給定問題“艾麗斯的孩子是誰?”,我們可以生成一個關系路徑作為計劃:z = 嫁→父親。這個關系路徑表達了計劃:1)找到“艾麗斯”所嫁的人;2)找到該人的孩子。我們可以通過從KGs檢索推理路徑來執行該計劃(關系路徑):wz = 艾麗斯嫁→鮑勃父親→查理。最后,我們可以根據推理路徑回答問題,答案是“查理”。

通過將關系路徑視為計劃,我們可以確保這些計劃基于KGs,從而使LLMs能夠在圖上進行忠實和可解釋的推理。簡而言之,我們將RoG表述為一個優化問題,旨在通過生成關系路徑z作為計劃,最大化從知識圖譜G推理答案的概率:

其中 θ表示大型語言模型(LLMs)的參數,z 表示LLMs生成的關系路徑(計劃),而 Z 表示可能關系路徑的集合。后一個項 Pθ(z∣q) 是在給定問題 q 的情況下生成基于知識圖譜(KG)的忠實關系路徑 z 的概率,這由規劃模塊實現。前一個項Pθ(a∣q,z,G) 是在給定問題 q、關系路徑 z和知識圖譜 G的情況下推理答案 a的概率,這由檢索-推理模塊計算得出。

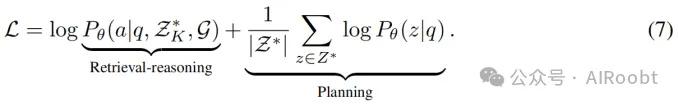

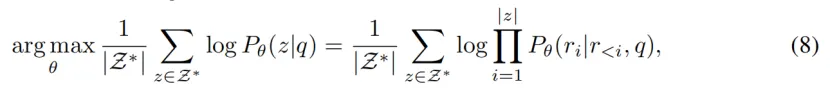

4.2 優化框架

盡管生成關系路徑作為計劃具有優勢,但LLMs對KGs中包含的關系幾乎沒有知識。因此,LLMs無法直接生成基于KGs的忠實計劃的關系路徑。此外,LLMs可能無法正確理解推理路徑并基于它們進行推理。為了解決這些問題,我們設計了兩個指令調優任務:

1)規劃優化,旨在將KG中的知識提煉到LLMs中,以生成忠實的關系路徑作為計劃;

2)檢索-推理優化,旨在使LLMs能夠基于檢索到的推理路徑進行推理。

公式(1)中的目標函數可以通過最大化證據下界(ELBO)進行優化(Jordan et al., 1999),其形式為:

其中 Q(z) 表示基于KGs的忠實關系路徑的后驗分布。后一個項最小化后驗分布與先驗分布之間的KL散度,這鼓勵LLMs生成忠實的關系路徑(規劃優化)。前一個項最大化期望,即檢索-推理模塊基于關系路徑和KGs生成正確答案的概率(檢索-推理優化)。

規劃優化。在規劃優化中,我們的目標是將KG中的知識提煉到LLMs中,以生成忠實的關系路徑作為計劃。這可以通過最小化與KGs中的忠實關系路徑的后驗分布 Q(z) 的KL散度來實現。

給定問題q和答案a ,我們可以在KG中找到路徑實例

連接 eq 和 ea 。相應的關系路徑z={r1,r2,…,rl}可以被視為有效的,并作為回答問題 q 的忠實計劃。后驗分布 Q(z) 可以形式化地近似為:

其中我們假設在所有有效關系路徑 Z 上均勻分布,且 ?wz(eq, ea) ∈ G 表示連接問題 e_q 和答案 e_a 的路徑實例在 G 中存在。因此,KL散度可以計算為:

其中我們使用KGs中 e_q 和 e_a 之間的最短路徑 Z ?Z 作為監督信號(Zhang et al., 2022)。詳細推導可以在附錄A.1中找到。通過優化公式(4),我們最大化LLMs生成忠實關系路徑的概率,同時從KG中提煉知識。

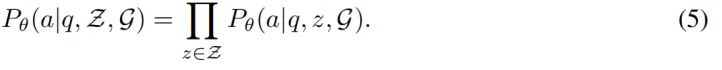

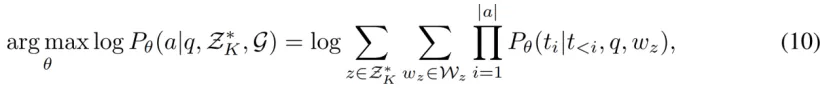

檢索-推理優化。在檢索-推理優化中,我們的目標是使LLMs能夠基于檢索到的推理路徑進行推理。對于檢索-推理模塊,我們遵循FiD框架(Izacard & Grave, 2021; Singh et al., 2021),該框架允許在多個檢索到的推理路徑上進行推理,形式化為:

通過用采樣的 K 個計劃 ZK ?Z 近似期望,推理優化的目標函數可以寫為:

這最大化LLMs基于檢索到的推理路徑生成正確答案的概率。

RoG的最終目標函數是規劃優化和檢索-推理優化的組合,可以形式化為:

從公式(7)可以看出,我們對規劃和推理使用相同的LLM,這兩個任務(規劃和檢索-推理)在共同訓練。我們將在接下來的子部分討論這兩個任務的實現細節。

4.3 規劃模塊

規劃模塊旨在生成忠實的關系路徑,作為回答問題的計劃。為了利用大型語言模型(LLMs)的指令跟隨能力(Wei et al., 2021),我們設計了一個簡單的指令模板,提示LLMs生成關系路徑:

請生成一個有效的關系路徑,以幫助回答以下問題:<Question>

其中 <Question> 表示問題q。問題和指令模板一起輸入LLMs,以生成關系路徑,這些路徑結構化格式化為一個句子:

z = <PATH> r1 <SEP> r2 <SEP> . . . <SEP> rl </PATH>

其中 <PATH>、<SEP> 和 </PATH> 是特殊標記,分別表示關系路徑的開始、分隔符和結束。

因此,規劃的優化可以表示為:

其中 Pθ(z|q) 表示生成忠實關系路徑z的先驗分布,Pθ(ri|r<i, q) 表示LLMs生成路徑 z 中每個標記的概率。

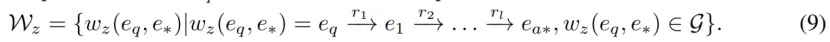

4.4 檢索-推理模塊

檢索。給定問題q和作為計劃的關系路徑z,檢索模塊旨在從知識圖譜G中檢索推理路徑Wz。檢索過程可以通過找到在 G 中從問題實體 eq開始并遵循關系路徑 z的路徑來進行,公式化為:

我們采用受限的廣度優先搜索從知識圖譜中檢索推理路徑 wz 。在實驗中,所有檢索到的路徑都用于推理。詳細的檢索算法可以在附錄 A.3 中找到。

盡管我們可以利用檢索到的推理路徑并通過多數投票直接獲得答案,但檢索到的推理路徑可能是噪聲且與問題無關,這會導致錯誤答案(He et al., 2021;Zhang et al., 2022)。因此,我們提出了一個推理模塊,以探索大型語言模型(LLMs)識別重要推理路徑的能力,并基于這些路徑回答問題。

推理。推理模塊接受問題 q 和一組推理路徑 Wz 來生成答案 a 。類似地,我們設計了一個推理指令提示,引導LLMs基于檢索到的推理路徑 Wz 進行推理。 Wz 也格式化為一系列結構化句子。詳細的提示可以在附錄 A.10 中找到。

推理的優化可以寫為:

其中Pθ(a|q, ZK, G) 表示基于K條關系路徑ZK 推理正確答案a的概率,t表示答案a的標記。

5、實驗

在我們的實驗中,我們旨在回答以下研究問題:RQ1:RoG能否在KGQA任務中實現最先進的性能?RQ2:RoG的規劃模塊能否與其他大型語言模型(LLMs)集成以提高它們的性能?RQ3:RoG能否進行忠實推理并生成可解釋的推理結果?

5.1 實驗設置

數據集。我們在兩個基準知識圖譜問答(KGQA)數據集上評估RoG的推理能力:WebQuestionSP(WebQSP)(Yih et al., 2016)和復雜網頁問答(CWQ)(Talmor & Berant, 2018),這兩個數據集包含最多4跳的問題。Freebase(Bollacker et al., 2008)是這兩個數據集的背景知識圖譜,包含大約8800萬個實體、2萬個關系和1.26億個三元組。數據集的詳細信息在附錄A.4中描述。

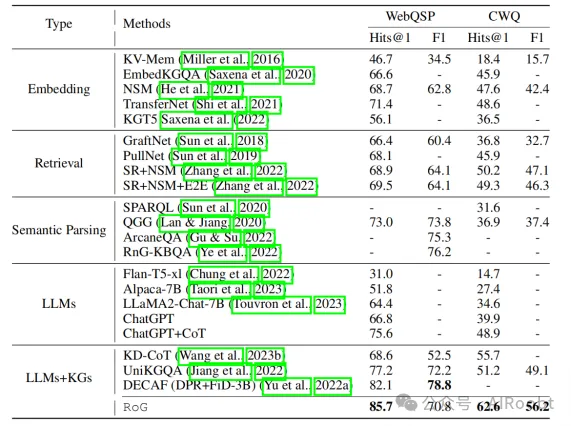

基線。我們將RoG與21個基線進行比較,這些基線分為5類:1)基于嵌入的方法,2)檢索增強的方法,3)語義解析的方法,4)大型語言模型(LLMs),以及5)LLMs+KGs的方法。每個基線的詳細信息在附錄A.5中描述。

評估指標。根據先前的研究,我們使用Hits@1和F1作為評估指標。Hits@1衡量的是預測答案的前1個正確的問答比例。由于一個問題可能對應多個答案,F1考慮了所有答案的覆蓋率,從而平衡了預測答案的精準度和召回率。

實現。對于RoG,我們使用LLaMA2-Chat-7B(Touvron et al., 2023)作為大型語言模型的基礎,該模型在WebQSP和CWQ的訓練集以及Freebase上進行了3個周期的指令微調。我們為每個問題生成前3個關系路徑,使用的是束搜索算法。由于UniKGQA(Jiang et al., 2022)和DECAF(Yu et al., 2022a)是最先進的方法,我們直接引用它們的結果以及其他基線在其論文中報告的結果進行比較。對于LLMs,我們使用0-shot提示進行KGQA。詳細設置在附錄A.6中描述。

5.2 RQ1: KGQA性能比較

主要結果。在本節中,我們比較RoG與其他基線在KGQA任務上的表現。結果如表1所示。我們的方法在兩個數據集上大多數指標上都達到了最佳性能。具體來說,與最先進的方法DECAF(Yu et al., 2022a)在WebQSP上的比較,我們的方法將Hits@1提高了4.4%。在CWQ數據集中,由于多跳問題的挑戰,我們的方法在Hits@1和F1上分別提高了22.3%和14.4%,相比于最先進模型UniKGQA(Jiang et al., 2022)。這些結果展示了我們方法在KGQA中的卓越推理能力。

表1:RoG與基線方法的性能比較

在其他方法中,檢索增強方法通過從KGs中檢索相關子圖,超越了傳統的基于嵌入的方法,從而降低了推理復雜性。此外,SR+NSM和SR+NSM+E2E采用基于關系路徑的檢索,取得了更好的性能,強調了關系路徑的重要性。語義解析方法在WebQSP上的表現優于檢索方法,但在CWQ上表現較差,這是由于CWQ中復雜問題的邏輯查詢生成的復雜性。盡管基于LLMs的方法表現可比,但如第5.4節所示,它們受到幻覺和知識缺乏的限制。LLMs+KGs的方法取得了第二好的性能,這證明了統一KGs和LLMs進行推理的有效性。

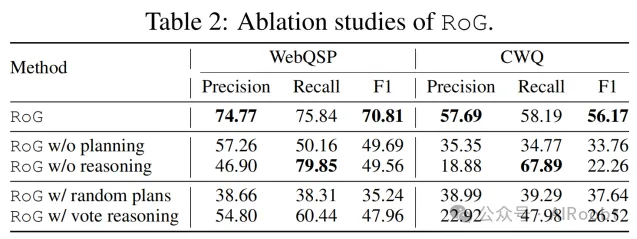

消融研究。我們進行了一項消融研究,以分析我們的方法(RoG)中規劃模塊和推理模塊的有效性。我們比較了四個變體:1)不使用規劃(w/o planning),在此情況下,我們移除規劃模塊,進行沒有檢索推理路徑的推理;2)不使用推理(w/o reasoning),在此情況下,我們移除推理模塊,使用從檢索推理路徑中獲得的所有答案作為結果;3)使用隨機計劃(w/ random plans),在此情況下,我們隨機從KGs中檢索推理路徑并將其輸入到推理模塊;4)使用投票推理(w/ vote reasoning),在此情況下,我們采用多數投票從檢索的推理路徑中選擇前5個答案。結果如表2所示。從結果中明顯可以看出,沒有規劃模塊,我們的方法退化為僅依賴問題作為輸入的傳統LLMs,遭受知識缺乏的問題。雖然移除推理模塊會導致由于答案數量增加而回憶率較高,但由于檢索路徑中的噪聲,精準度顯著下降。這證明了推理模塊在識別重要推理路徑和過濾噪聲方面的有效性。此外,使用隨機計劃的性能還不如移除規劃模塊,強調了規劃模塊生成忠實推理計劃的重要性。使用簡單的多數投票推理可以改善結果,這也證明了推理模塊的必要性。

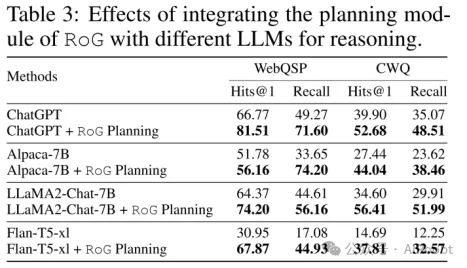

5.3 RQ2: 即插即用的RoG規劃模塊

在本節中,我們評估將RoG的規劃模塊與不同的LLMs集成以提高其性能的有效性。具體而言,我們首先采用RoG的規劃模塊生成關系路徑,并將檢索到的推理路徑作為上下文輸入到不同的LLMs中進行推理。結果如表3所示。

考慮到從LLMs的輸出中提取答案數量的困難,我們僅報告Hits@1和召回率指標。從結果中,我們可以注意到,所有LLMs的性能在集成RoG的規劃模塊后都有顯著改善。具體而言,ChatGPT、Alpaca、LLaMA2和Flan-T5的Hits@1分別提高了8.5%、15.3%和119.3%。這證明了RoG的規劃模塊可以與其他LLMs無縫集成,以提高其性能,而無需重新訓練。

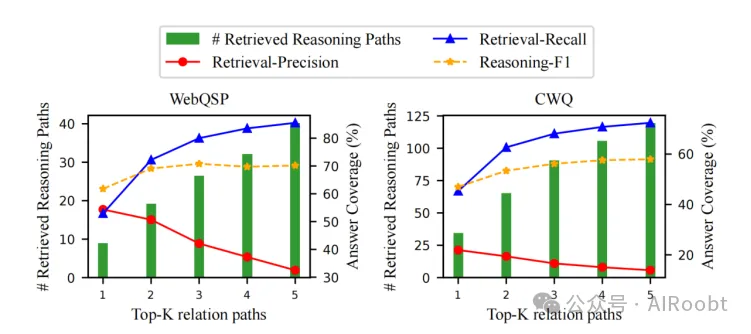

5.4 RQ3: 忠實推理和可解釋結果

定量結果。為了評估關系路徑的忠實性,我們在圖3中展示了定量結果。在實驗中,我們調整了RoG生成的前K個關系路徑的數量。從結果中可以看出,檢索到的推理路徑的數量隨著K的增加而增加,這也導致覆蓋更多答案(召回)。這證明了通過檢索答案實現關系路徑的忠實性。然而,更多的檢索推理路徑也會導致更多的噪聲和檢索時間(如附錄A.7.4所示),這降低了精確度,并對最終結果(推理-F1)貢獻甚微。因此,我們在實驗中設置K=3。

圖3:前K個生成關系路徑的忠實性。綠色條形表示檢索到的推理路徑的平均數量,實線表示檢索路徑的答案覆蓋率,虛線表示基于檢索到的推理路徑的推理模塊的答案覆蓋率。

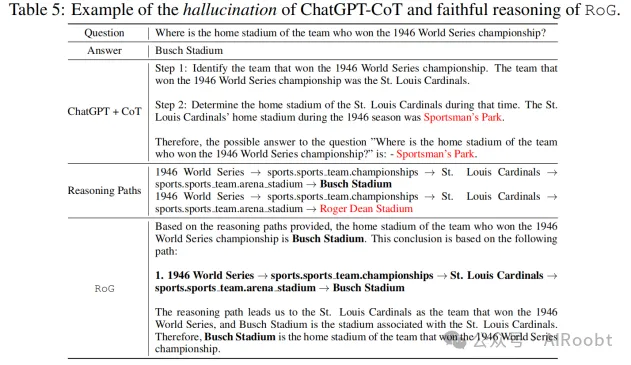

案例研究。我們還在表4和表5中展示了兩個案例研究。在表4中,我們發現ChatGPT+CoT遭遇了知識缺乏的問題,無法回答問題。相反,RoG能夠生成忠實的關系路徑,并從KGs中檢索有效的推理路徑進行推理。此外,RoG可以基于推理路徑提供可解釋的解釋。在表5中,我們看到ChatGPT+CoT受到幻覺的影響,生成了錯誤的答案。相比之下,盡管檢索到的推理路徑包含噪聲,推理模塊仍能夠識別出正確的推理路徑并進行忠實推理。這些結果證明了RoG在進行忠實推理和生成可解釋結果方面的有效性。更多案例可以在附錄A.8和A.9中找到。

5.4 討論

RoG的實驗結果顯示,通過規劃和檢索結合的方式,可以顯著提升LLMs在KGQA任務中的推理性能。生成的關系路徑為推理提供了結構支持,從而降低了幻覺的可能性。

6、結論

在本文中,我們提出了圖上推理(RoG)框架,結合了規劃和檢索-推理模塊,利用知識圖譜提升LLMs的推理能力。我們的實驗結果表明,RoG在多個KGQA任務上達到了最先進的性能,并生成了可解釋的推理結果。未來的工作將致力于擴展RoG框架,以支持更多類型的推理任務,并進一步提高推理的準確性和解釋性。

本文轉載自公眾號AIRoobt ,作者:AIRoobt