大佬怎么看OpenAI 和Google 本周相繼發布的模型及未來發展的?

作為 scale_ai 的 ceo, Alexandr Wang 今天在X上發布了他對于最近OpenAI和Google的公告引發了一些思考,以及這對未來人工智能發展的暗示。讓我們一起來看看吧!

提示:后訓練真的非常重要...

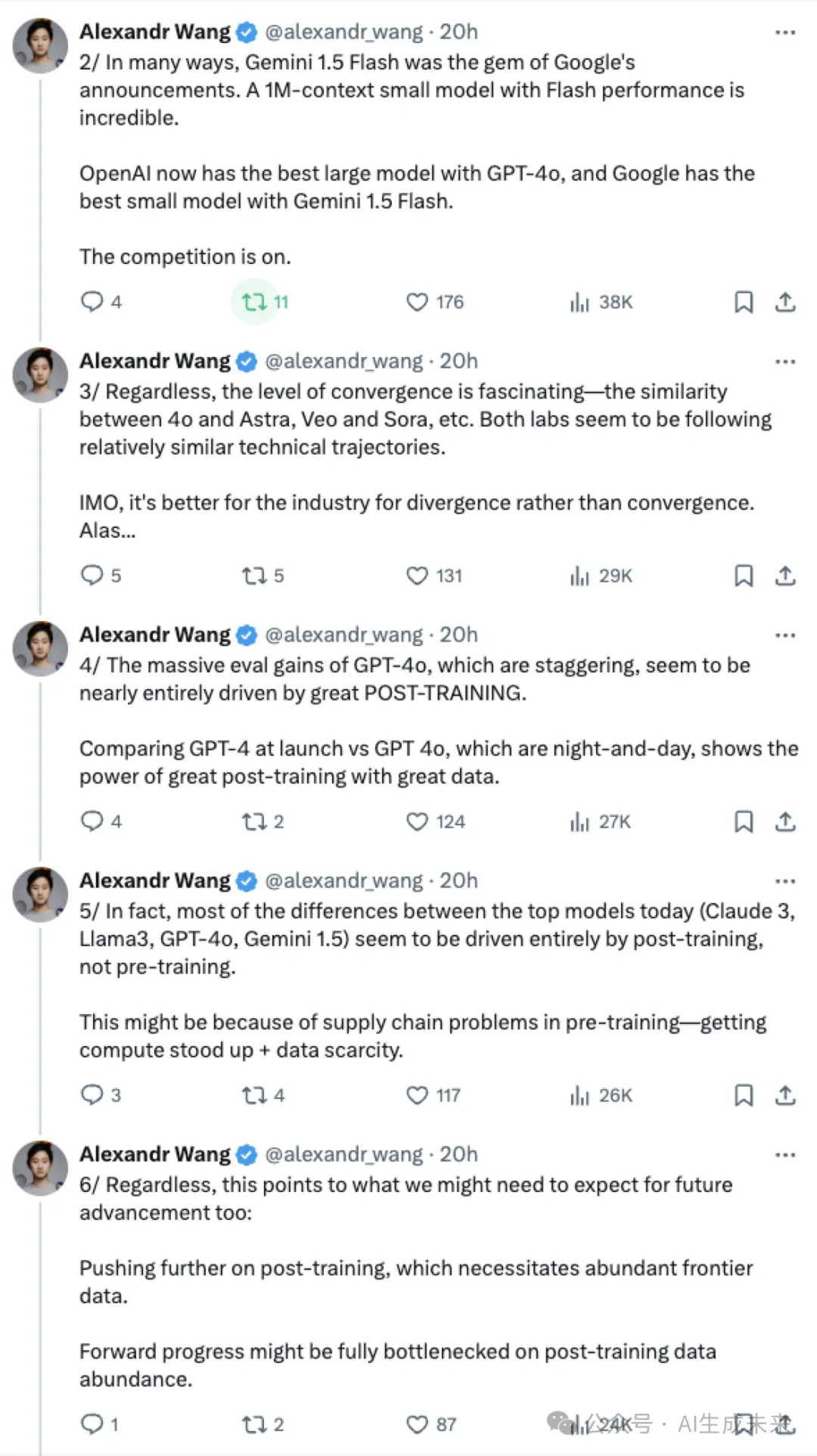

在許多方面,谷歌宣布的Gemini 1.5 Flash是一顆明珠。具備閃電般性能的100萬上下文小型模型令人難以置信。

OpenAI現在擁有最優秀的大型模型GPT-4o,而谷歌則擁有Gemini 1.5 Flash這款最佳小型模型。

競爭激烈進行中。

無論如何,收斂水平都是令人著迷的——比如4o和Astra、Veo和Sora之間的相似性等等。兩個實驗室似乎都在遵循相對相似的技術發展軌跡。

在我看來,對于行業而言,分歧而非趨同更為有利。可惜啊……

GPT-4o的巨大評估增益令人瞠目,幾乎完全歸功于出色的后訓練。

比較發布時的GPT-4和GPT-4o,二者之間的差異巨大,展示了出色數據與出色后訓練的力量。

實際上,如今頂級模型(比如Claude 3、Llama3、GPT-4o、Gemini 1.5)之間的大部分差異似乎完全是由后訓練而非預訓練所驅動。

這可能是由于預訓練中的供應鏈問題——計算資源的獲取和數據稀缺。

不過,這也指向了我們對未來進展可能需要期待的方向:

進一步推動后訓練,這需要充足的前沿數據支持。

未來進步可能完全取決于后訓練數據的豐富程度。

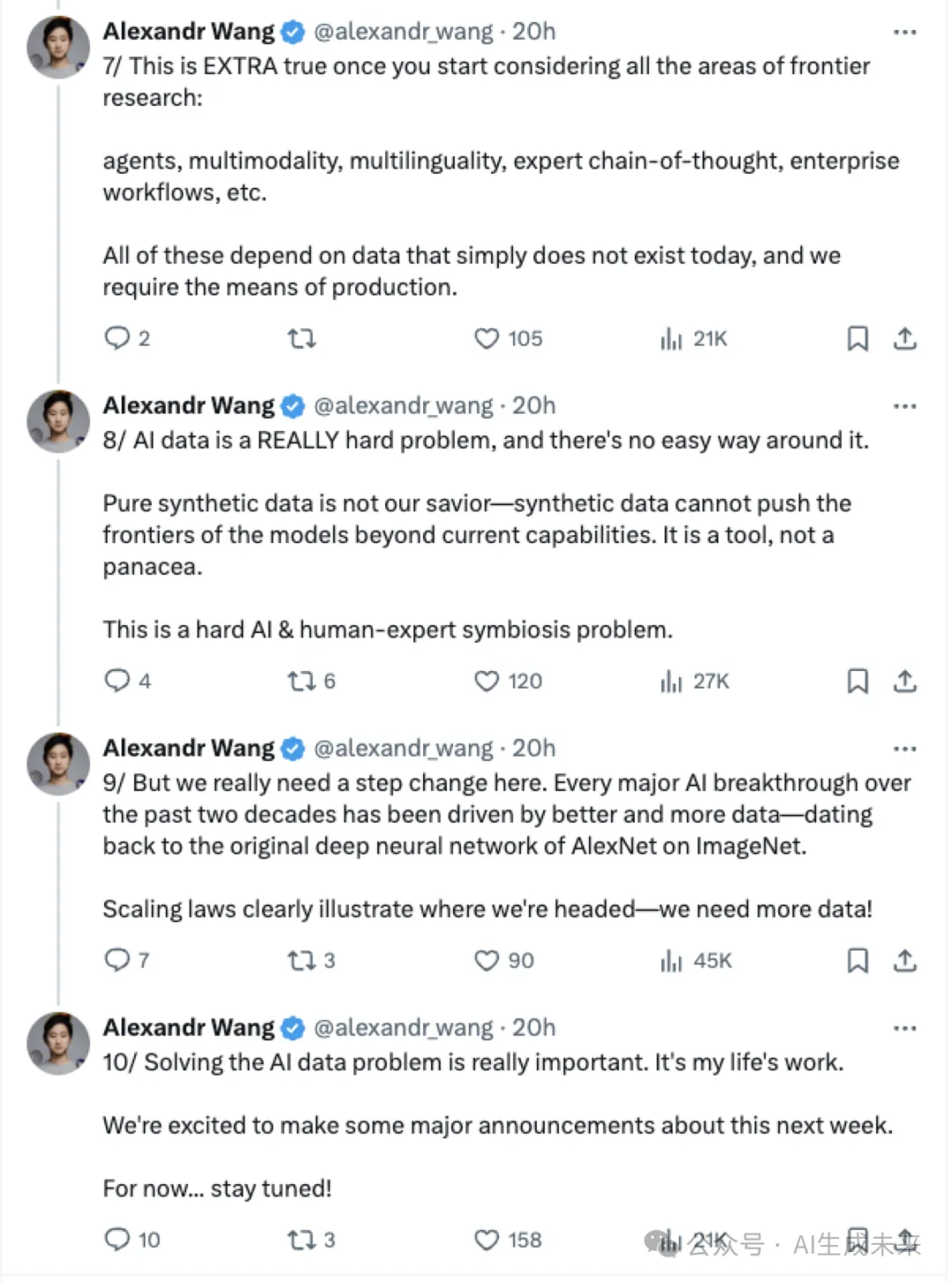

一旦開始考慮所有前沿研究領域,情況就會變得更為明顯:

代理、多模態、多語言、專家思維鏈、企業工作流程等。

所有這些都依賴于當今根本不存在的數據,而我們需要生產這些數據的手段。

AI數據是一個非常棘手的問題,沒有簡單的解決辦法。

純合成數據并不能拯救我們——合成數據無法將模型的前沿推進到超越當前能力的水平。它只是一種工具,而不是靈丹妙藥。

這是一個棘手的人工智能與人類專家共生的問題。

但我們真的需要在這方面邁出一大步。過去二十年里的每一次重大人工智能突破都是由更好、更多的數據推動的——從AlexNet在ImageNet上的原始深度神經網絡開始。

Scaling laws 清楚地說明了我們的發展方向——我們需要更多的數據!

解決人工智能數據問題非常重要。這是我一生的事業。

我們很高興地宣布,下周將有一些重大消息。

目前先... 敬請關注!

以下是原文:

本文轉自 AI生成未來 ,作者:AI生成未來