ICML 2024:從視覺語言基礎模型反饋中進行強化學習 原創

獎勵工程長期以來一直是強化學習研究中的挑戰,因為它通常需要大量人力投入。在本文中,研究人員提出了RL-VLM-F,它可以自動生成代理學習新任務的獎勵函數,僅利用任務目標的文本描述和代理的視覺觀察,通過利用視覺語言基礎模型(VLMs)的反饋。該方法的關鍵在于查詢這些模型,根據任務目標的文本描述對代理的圖像觀察對進行偏好,并從偏好標簽中學習獎勵函數。RL-VLM-F成功地在各種領域中產生了有效的獎勵和策略,包括經典控制,以及剛性、關節和可變形物體的操作,而無需人工監督,在相同假設下優于使用大型預訓練模型進行獎勵生成的先前方法。

RL-VLM-F組件

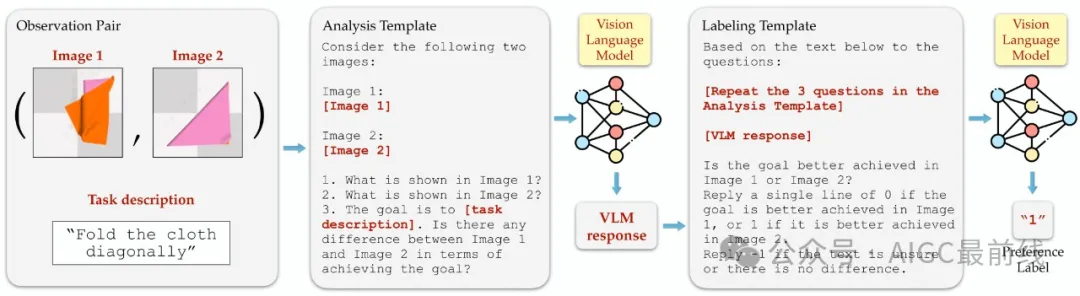

RL-VLM-F自動為代理生成獎勵函數,以學習新任務,僅利用任務目標的文本描述和代理的視覺觀察,通過利用視覺語言基礎模型(VLMs)的反饋。該方法的關鍵在于查詢這些模型,根據任務目標的文本描述對代理的圖像觀察對進行偏好,并從偏好標簽中學習獎勵函數。研究人員使用基于偏好的強化學習同時學習策略和獎勵函數。

RL-VLM-F查詢設計

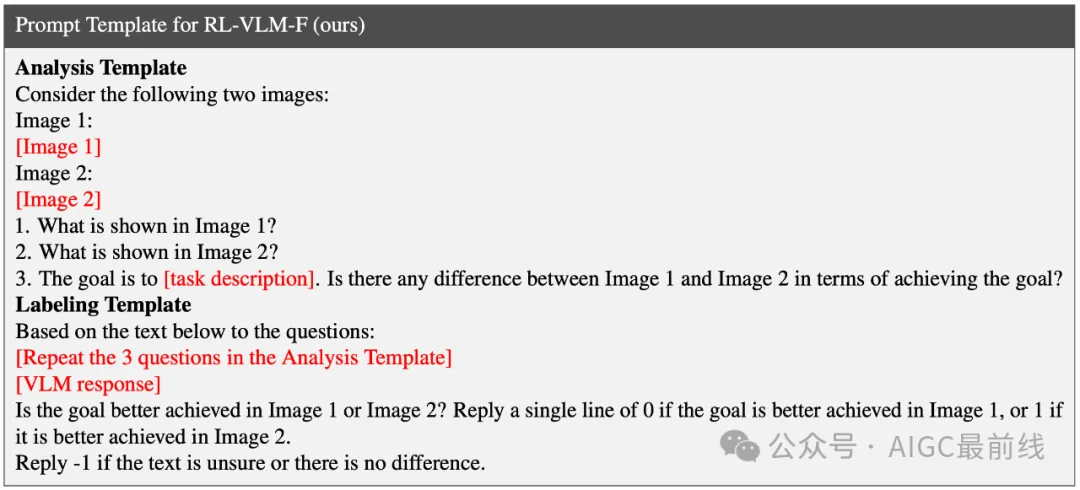

RL-VLM-F兩階段查詢:首先,查詢VLM以生成自由形式的響應,比較兩個圖像分別完成任務的效果。接下來,使用第一階段的文本響應提示VLM,以提取對兩個圖像的偏好標簽。研究人員對所有任務使用相同的查詢模板,將任務描述替換為特定任務的目標描述。

RL-VLM-F:提示和策略

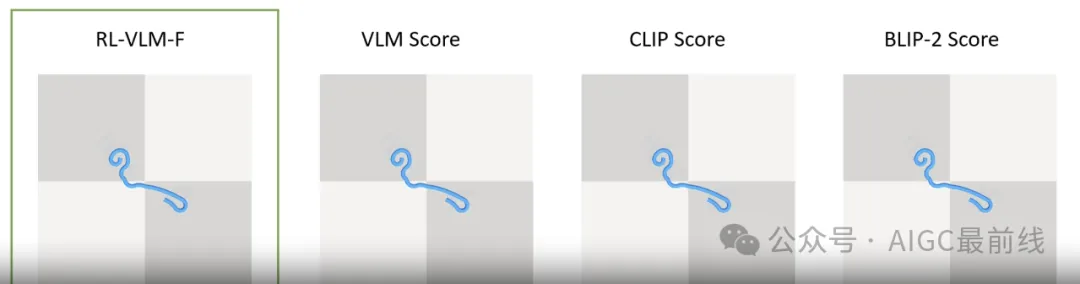

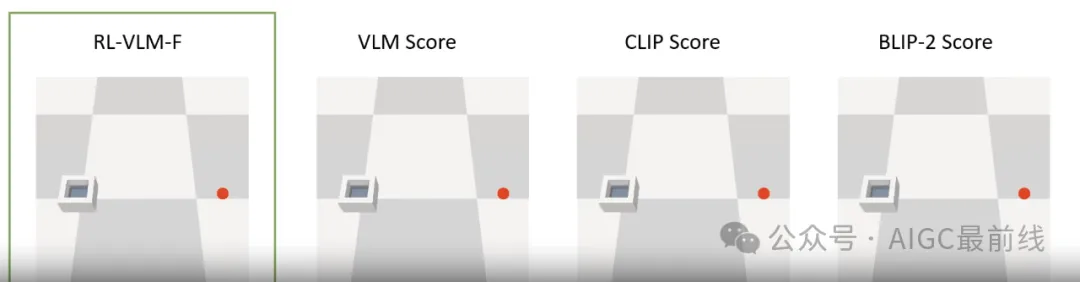

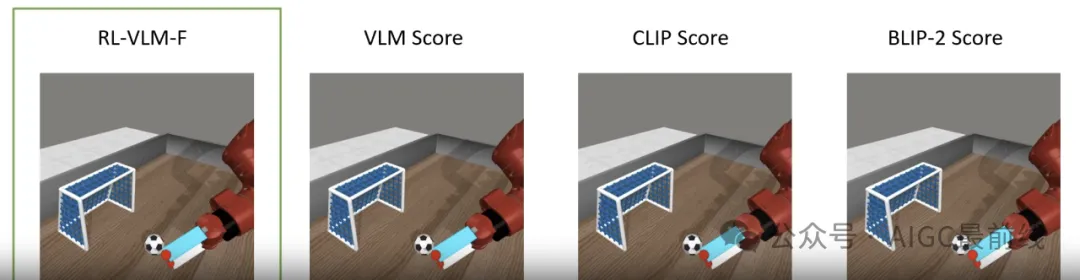

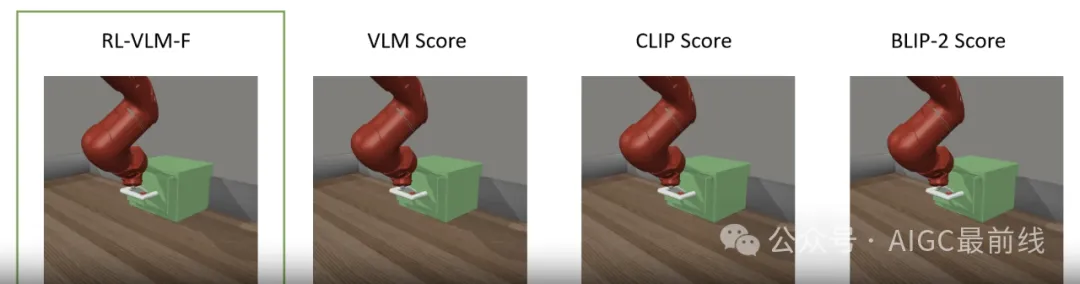

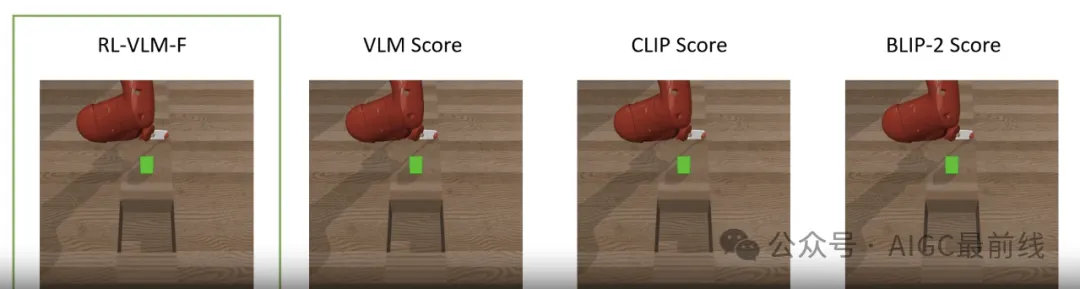

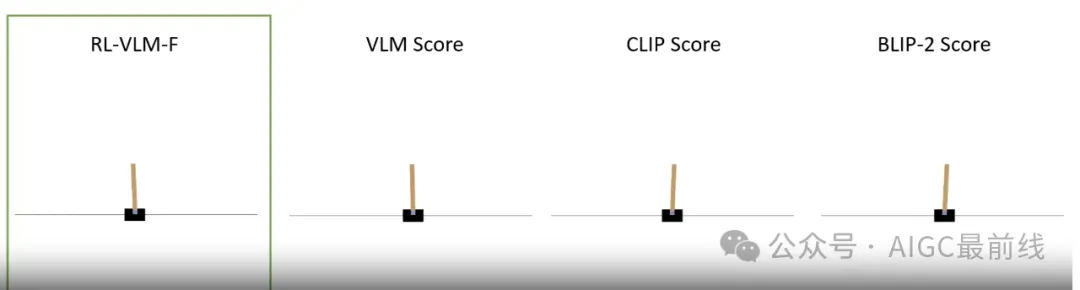

下面展示了該方法和基線在七項任務上的策略執行,包括剛性、關節和可變形物體的操作。對于每個任務,展示了任務目標的簡短文本描述,與下面的模板提示結合起來,形成用于查詢VLM偏好的完整提示。

- 折疊布料對角線

任務描述:“將布料從左上角對角線對折到右下角”

- 拉直繩子

任務描述:“拉直藍色繩子”

- 不溢水地傳遞水

任務描述:“將裝水的容器移動到距離紅色圓圈盡可能近的地方,而不會導致太多水滴溢出”

- 將足球移入球門

任務描述:“將足球移入球門”

- 打開抽屜

任務描述:“打開抽屜”

- 將方塊掃入洞中

任務描述:“使綠色方塊與洞之間的距離最小化”

- CartPole

任務描述:“在黑色小車上平衡棕色桿,使其直立”

實驗和結果

研究人員對RL-VLM-F在各種任務上進行了全面評估,包括經典控制,以及剛性、關節和可變形物體的操作,無需人工監督,在相同假設下優于使用大型預訓練模型進行獎勵生成的先前方法。

與基線方法的比較

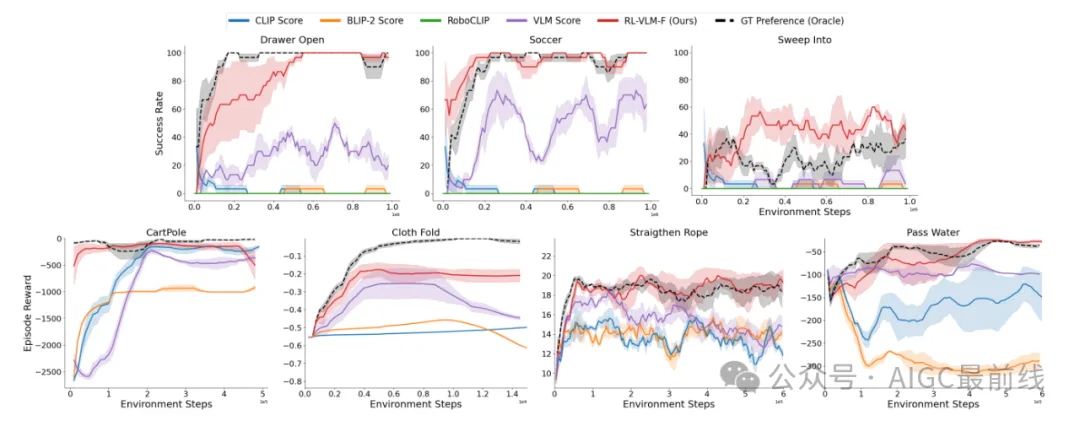

如所有對比方法在7項任務上的學習曲線所示,RL-VLM-F在所有任務上均優于所有基線,并且在7項任務中的6項任務上與地面真實偏好的表現相匹配或超越。

VLM偏好標簽的準確性

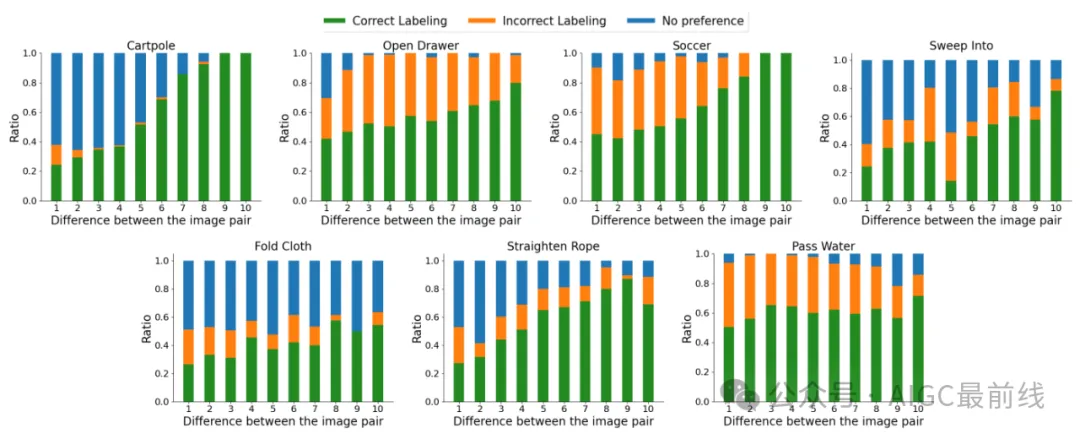

研究人員提供了與環境獎勵函數定義的地面真實偏好標簽相比,VLM偏好標簽準確性的分析。x軸表示圖像對之間的不同水平,離散為10個區間,其中差異是指與圖像對關聯的地面真實任務進展之間的差異。y軸顯示了VLM偏好標簽正確、不正確或無法對圖像對進行偏好的比例。像人類一樣,當兩個圖像在實現目標方面有明顯不同時,VLM更擅長評估兩個圖像,并且當兩個圖像非常相似時,其表現較差。

學習獎勵與地面真實任務進展的一致性

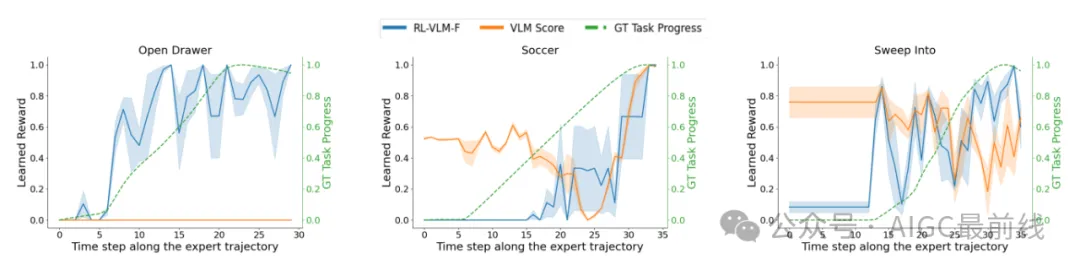

研究人員比較了RL-VLM-F學習的獎勵與地面真實任務進展在3個MetaWorld任務上的一致性。如所示,RL-VLM-F生成的獎勵與地面真實任務進展更一致。學習的獎勵是通過3個具有不同種子的訓練獎勵模型進行平均的,陰影區域表示標準誤差。

譯自(有刪改):https://rlvlmf2024.github.io

本文轉載自公眾號AIGC最前線