32專家MoE大模型免費商用!性能全面對標Llama3,單token推理消耗僅5.28%

每個token只需要5.28%的算力,精度就能全面對標Llama 3。

開源大模型,再添一位重量級選手——

來自浪潮信息的32專家MoE模型,源2.0-M32。

不僅擁有極高的回報投入比,而且全面開放,訓練代碼和模型權重都可任意下載,商業使用也免費、無需授權。

那么,這到底是怎樣的一款模型?

1/19算力消耗,性能對標Llama 3

首先了解一下模型的基本信息,源2.0-M32模型采用MoE架構,專家數量為32,總參數量40B,激活專家數為2,激活參數量3.7B。

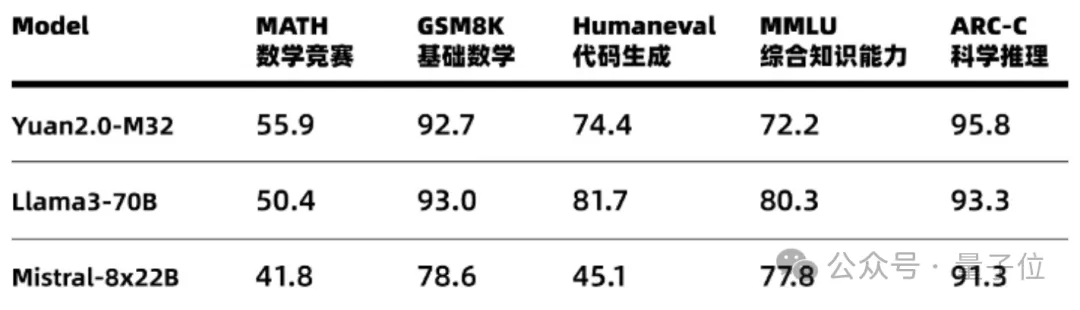

精度上,源2.0-M32在多個測評數據集上全面對標Llama3(70B,以下同),在MATH(數學競賽)和ARC-C(科學推理)榜單還上超越了Llama3。

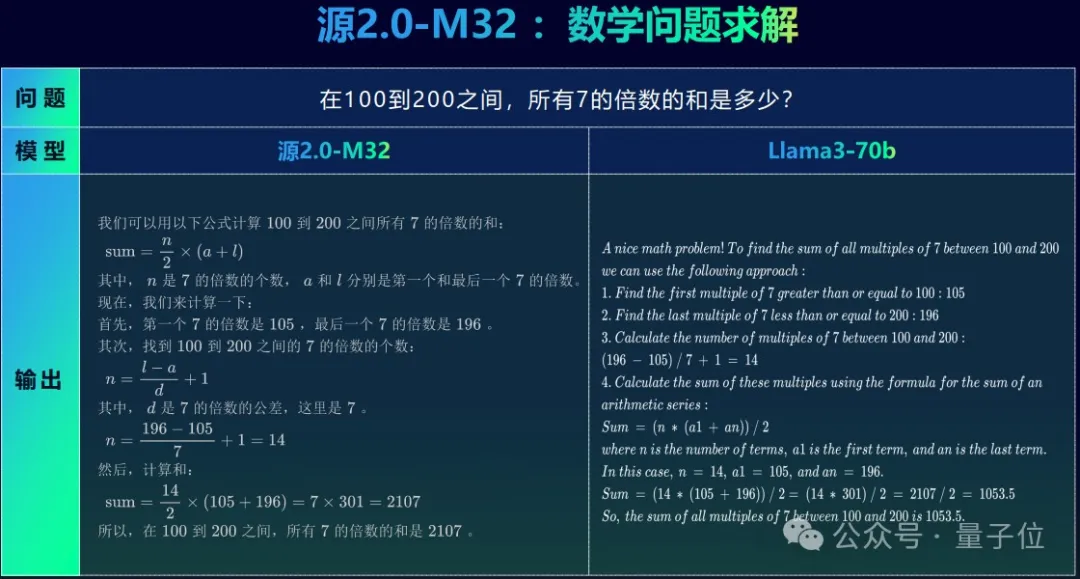

舉個例子,在求解一道中文數學題目時,源2.0-M32能夠用中文進行完整、準確作答,而Llama3雖然能理解中文題目,但回答時還是用了英文。

而且看一下Llama3的答案,雖然前面的過程也沒什么問題,但最終得到的結果錯得離譜,硬生生把一堆整數的和算出了小數點。

在實現與業界領先開源大模型性能相當的同時,在模型的訓練、推理和微調過程中,源2.0-M32的資源消耗也都顯著更低。

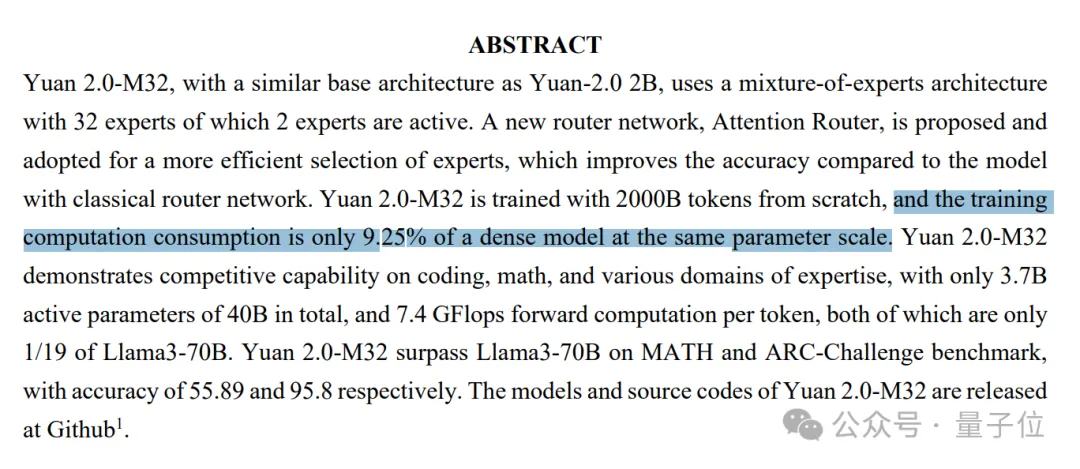

在訓練階段,使用2萬億token對源2.0-M32進行預訓練,計算量只有同參數規模稠密模型的9.25%。

在推理階段,在達到相當精度的條件下,源2.0-M32平均每個token消耗的算力為7.4GFLOPS,Llama3則需要140GFLOPS,前者的消耗僅為后者的1/19,即5.28%。

換言之,源2.0-M32每Token算力下的平均精度是Llama3的18.8倍,擁有更高的模算效率。

微調上,使用1萬條平均長度為1024 token的數據進行微調,Llama3-70B消耗為0.05PD(PetaFLOPs/s-Day),源2.0-M32只用0.0026PD,僅為Llama3的5.2%。

當然不得不說的是,雖然源2.0-M32的微調消耗已經降低到了Llama3的5.2%,但微調本身對于一些用戶來說就是無法負擔的成本。

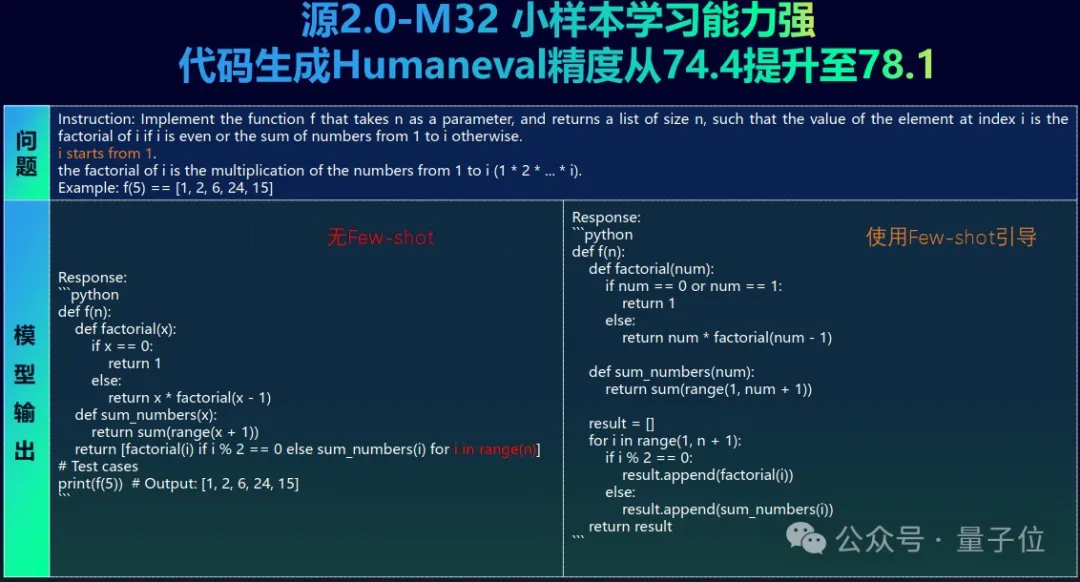

而得益于源2.0-M32強大的少樣本學習能力,讓用戶即使沒有條件進行微調,也能快速構建大模型應用。

以代碼生成為例,僅需很少量的樣本引導,源2.0-M32在HumanEval上獲得的精度就能從74.4提升到78.1,增幅達到了4.97%。

浪潮信息提供了預訓練、微調和推理服務腳本,開發人員可以高效完成部署。

模型部署可端可云,可以在自有的云服務上部署,也可以在浪潮信息推出的企業大模型開發平臺EPAI中快速構建,還可以通過浪潮信息開源的本地大模型對話工具YuanChat,在PC端完成快速部署。

而且源2.0-M32模型激活參數量僅3.7B,算力需求只有2B模型(單專家)的1點多倍,用筆記本就能帶動。

總之,浪潮信息始終追求更高效的智能涌現——本次發布“源2.0-M32”大模型,就是希望資源有限的條件下,實現能耗更低、推理和訓練效果更優的大模型開發。

那么,浪潮信息是如何實現用更少的算力開銷,對標行業領先模型的呢?

算法、算力、數據的全面創新

自浪潮信息涉足AI領域以來,一直將“算法、算力、數據”視為AI應用的“三駕馬車”。

實際上,整個“源”系列大模型的研發過程亦是如此,所有的相關研究,都是圍繞著這三個維度展開的。

在算法上,源2.0-M32選擇了MoE架構,解決了稠密模型訓練成本過高、數據和算力不足的問題。

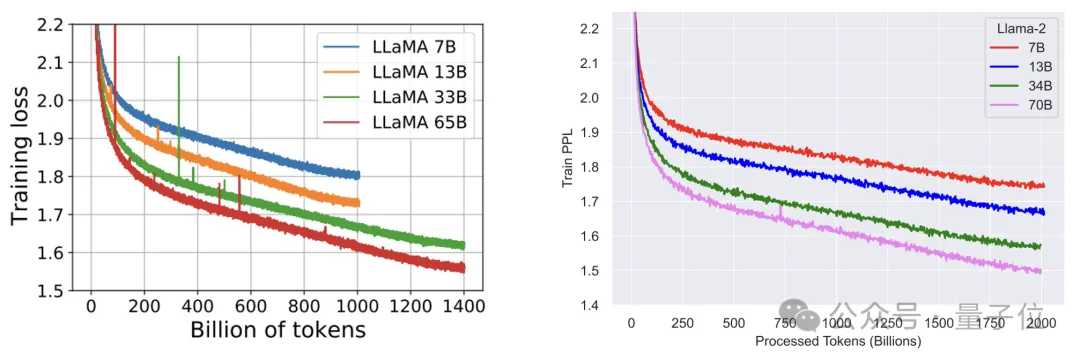

從Llama1(65B)、Llama2(70B)到Llama3(70B)的迭代過程可以看出,三代模型的參數量接近,但隨著訓練Token數從1.4T增加到了15T,模型表現也隨之顯著提升。

△數據來自Llama1與Llama2的論文

大模型的擴展率揭示出:增大模型的參數量與增大訓練的token數對模型能力提升的作用類似,如果按照Llama3的訓練數據量(15T tokens)外推,500B參數的模型若想充分的訓練,所需的高質量文本token數高達107T,已經遠遠超過了當前業界已知的數據量。

退一步講,即使真的有這么多數據,訓練過程所需的算力投入同樣無法承受。

按照計算,如果用107T訓練token訓一個500B參數規模的Dense模型,需要的算力是321000Z(10^21)Flops。

即使在2萬顆加速卡的集群上,訓練效率按40%來算(實際還不一定能達到),也需要耗時464天,單是電費就要花費約3億元。

相比之下,MoE模型的一個顯著優勢就是,能夠在遠少于稠密模型所需的計算資源下,進行有效的預訓練。

同時,源2.0-M32沒有采用Mixtral等MoE模型中更常見的8專家結構,而是將專家數量設定為了32,運行時只激活兩個專家。

這一參數的選擇,是研發團隊進行了大量的實驗調優之后確定的。

浪潮信息人工智能首席科學家吳韶華介紹說,模算效率是浪潮信息設計自己的大模型時的核心出發點,在提升模型能力的同時,盡可能降低算力開銷。

業界中像Mixtral這樣的模型,獲得更高精度的方式是固定專家數量,增加單個專家的參數量,但源2.0-M32則反其道而行之。

吳韶華介紹,在研發團隊的實驗中,隨著專家數量從8個專家增加到32個專家,在模型精度上取得了非常不錯的回報。

但即使總的專家數量增加到了32個,激活的專家依然只有兩個。在這種情況下,激活參數量不變,算力開銷不變。

至于源2.0-M32中的單個專家,則是選用了源2.0-2B模型,這樣做的考量是控制單個專家的參數量不至于過大,以便在企業場景應用中可以有更好的模算效率。

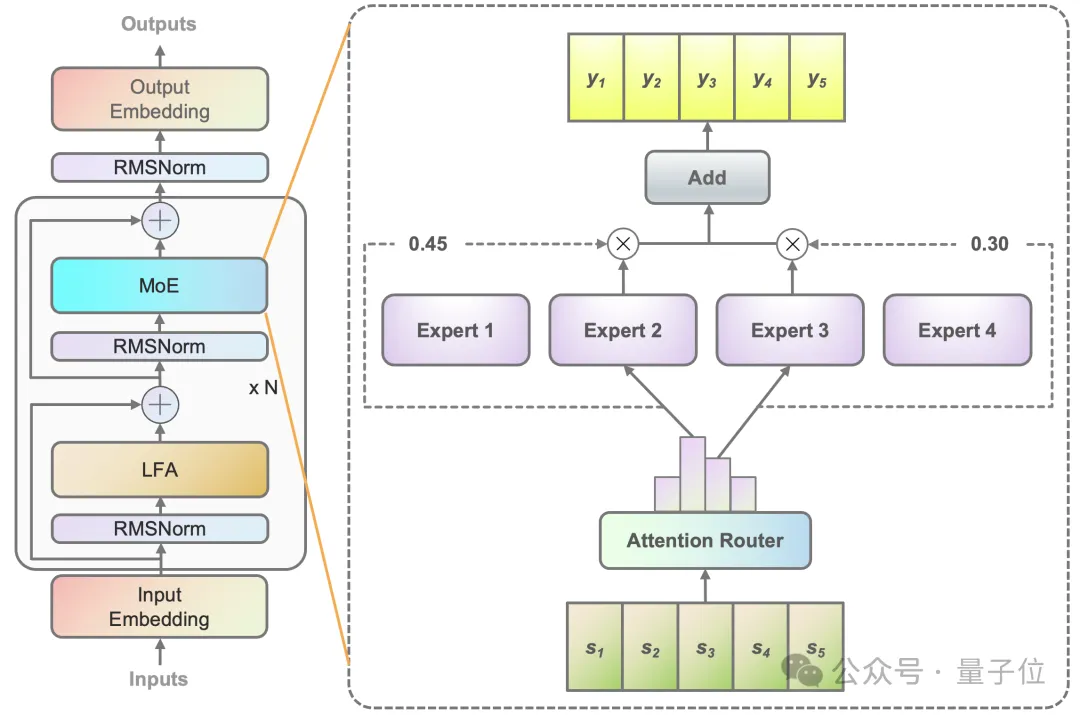

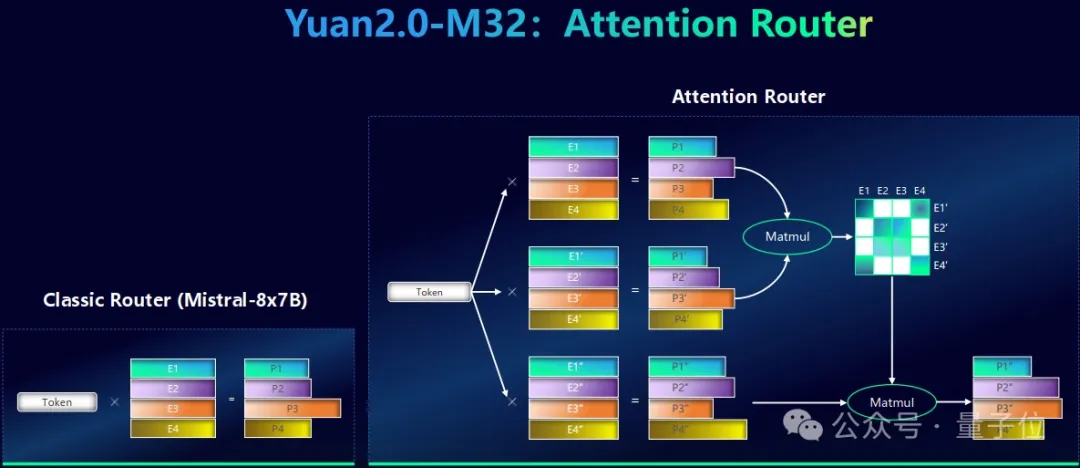

除了在專家數量的設置上另辟蹊徑,團隊也對源2.0-M32的門控網絡進行了全新設計,采用了獨創的Attention Router門控網絡,相比傳統的門控網絡獲得了精度提升。

當前流行的MoE結構大都采用簡單的調度策略,其本質是對token與代表每個專家的特征向量求點積,隨后挑選點積結果最大的幾個專家。

這種方式只考慮了token和專家的關系,卻忽略了專家與專家之間的相關性,但實際過程中往往需要多個專家協同參與計算,如果忽視專家之間相關性,無疑會降低模型的精度。

而源2.0-M32大模型中的Attention Router,就創造了一種專家間協同性的度量方法,解決了傳統的門控機制中專家關聯性缺失的問題。

具體來說,對于每一個專家,研發團隊都構建了3個向量,并利用類似Attention的機制來構建專家之間的關系。最終選擇的專家不僅與Token匹配度高,兩個專家的協同效果也更好。

此外,源2.0-M32也沿用了源2.0系列中首創的局部注意力過濾增強(LFA)機制,和經典的Llama結構相比,模型在幾百億token數據的訓練之后,在100億token的測試集上做測試,會有3.5%的精度提升。

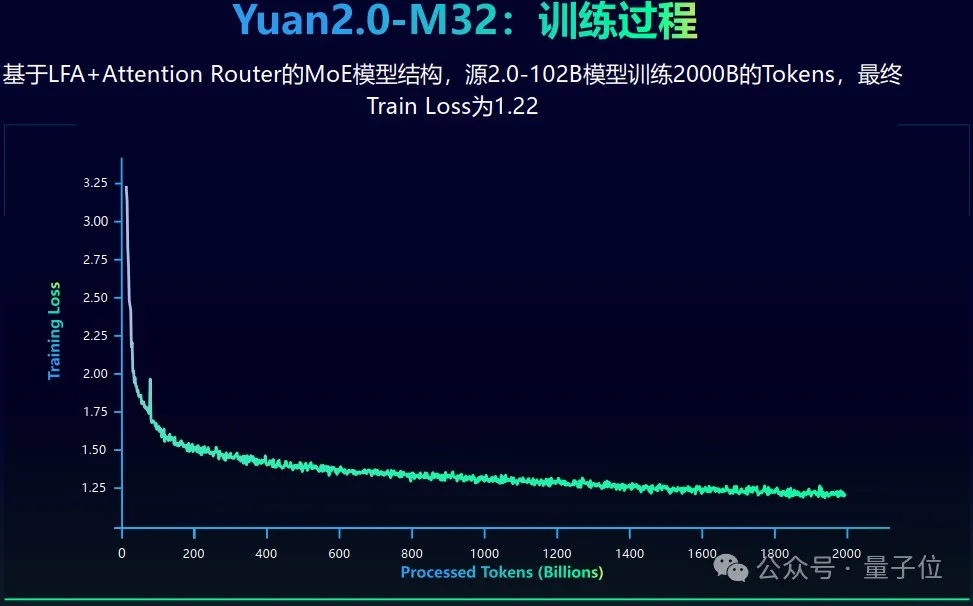

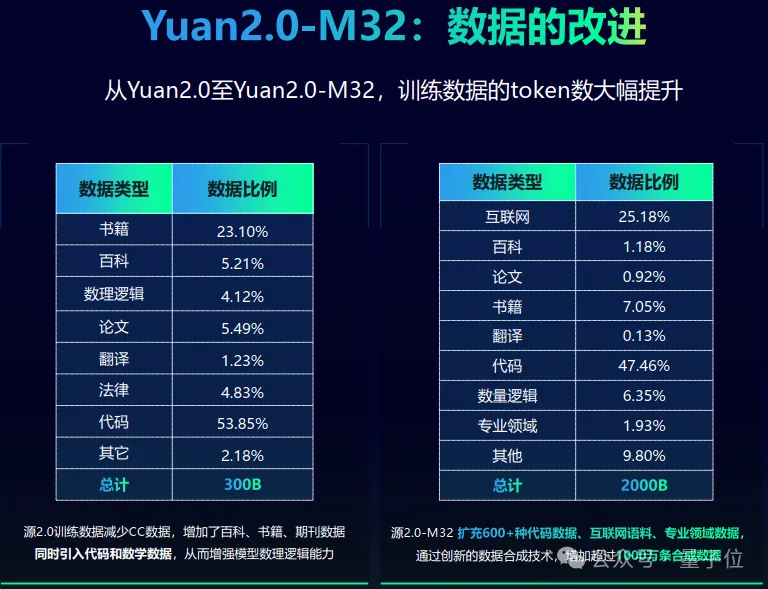

在數據層面,源2.0-M32一共使用2萬億token進行訓練,相比之前的2.0版本大幅提升。

整個訓練過程也非常穩定,沒有出現數值不穩定或異常的中斷的情況,最終訓練損失為1.22。

數據類型上看,源2.0-M32這個模型的2萬億token中,差不多有一半的數據都是代碼,包含中文代碼和英文代碼。

同時,團隊也引入了互聯網數據和各類學科數據等類型,來補充數據的多樣性。

另外,研發團隊還通過源2.0合成數據的工具,獲得并增加了超過1000萬條的合成數據,重點是針對于數學和中文代碼。

因為互聯網上中文數學的語料實在太少,研發團隊曾經清洗了10PB左右的互聯網數據,但實際只得到了幾十GB的中文數學數據。

所以,這片空白需要通過數據合成來進行填補,這也是研發團隊持續做的工作。

在算力層面,源2.0-M32延續了源2.0提出的分布式訓練方法,綜合運用流水線并行+數據并行的策略,顯著降低了大模型對芯片間P2P帶寬的需求,為硬件差異較大訓練環境提供了一種高性能的訓練方法。

針對MoE模型的稀疏專家計算,采用合并矩陣乘法的方法,模算效率得到大幅提升。

將開源進行到底

了解了模型背后的技術細節,浪潮信息又為什么能夠打造出如此高效的大模型技術和產品呢?

主觀上,浪潮信息始終堅持在算法、架構等層面進行創新,對于這樣做的原因,吳韶華這樣介紹:

如果想提升大模型的能力,沿用當前的結構當然是一個比較好的路徑。

但我們始終堅持:要從算法層面和模型架構層面做探索、創新,這樣才能更快速的實現模型能力的提升。

客觀上,也至少包括以下三點原因。

一是從AI時代開始之前,浪潮信息就是專業的算力供應商,在算力側擁有大量的生態伙伴,對不同類型算力特點有深入的研究,能夠更高效地對算力進行利用。

實際上,自從2021年的源1.0開始,浪潮信息的一系列模型就都實現了比業界更高的訓練效率。

同時期的GPT-3,算力的利用效率只有21.3%,而源1.0效率則達到了44.8%,達到了業界領先水平。

二是在浪潮信息內部,也有非常多的場景和團隊,包括客服、軟件研發、生產制造、運維等等,都有很多實際的應用案例,或者實際需要模型去做規模化轉型的場景。

這些場景為源大模型的使用、迭代提供了天然的試驗場,同時從中能夠積累更多的經驗、更多的能力,從而滿足更多的需求。

三是始終堅持開源開放,同樣對模型能力的進化非常有幫助。

源系列模型的開源從1.0版本就已開始,從源1.0到源2.0再到今天的源2.0-M32,始終在堅持做開源,也已賦能了很多開發者。

這些開發者基于源1.0做了很有趣的應用探索,給了浪潮信息很好的反饋,指明了在模型能力上和開發者實際的應用需求上,到底應該關注在哪些層面。

吳韶華表示,從源1.0開源至今,浪潮信息一直在開源活動中持續受益,后續也會很堅定的繼續開源。

總之,從創新研發到開源開放,浪潮信息將堅持致力于研發基礎大模型,為企業用戶降低大模型使用門檻,加速推進產業智能化升級。

GitHub地址:??https://github.com/IEIT-Yuan/Yuan2.0-M32???

論文地址:???https://arxiv.org/abs/2405.17976???

Huggingface地址:???https://huggingface.co/IEITYuan/Yuan2-M32-hf???

ModelScope地址:???https://modelscope.cn/models/YuanLLM/Yuan2-M32-hf/summary???

Wisemodel地址:???https://www.wisemodel.cn/models/IEIT-Yuan/Yuan2-M32-hf??

本文轉自 量子位 ,作者:量子位