突破AI性能瓶頸!揭秘LLaMA-MoE模型的高效神經元分配策略

本文介紹了一種名為“LLaMA-MoE”的方法,通過將現有的大型語言模型(LLMs)轉化為混合專家網絡(MoE),從而解決了訓練MoE時遇到的數據饑餓和不穩定性問題。該方法基于著名的LLaMA-2 7B模型,并將其參數分為多個專家,然后對轉換后的MoE模型進行持續預訓練以進一步提高性能。實驗結果表明,在使用200B個標記進行訓練后,LLaMA-MoE-3.5B模型在激活參數相似的情況下顯著優于密集模型。

下載地址和項目代碼見文末

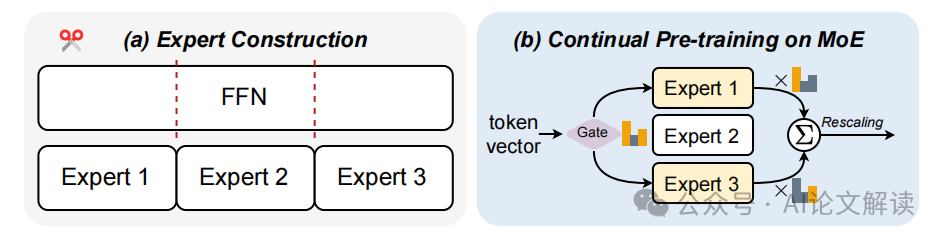

圖1:構建LLaMA-MoE模型的主要框架。(a)LLaMA中的原始ffn被分為不同的專家。(b)在轉換后的LLaMA-MoE中,隱藏狀態是由部分選擇的專家而不是所有的專家進行處理的。

專家構建

1. 概述

專家構建是將原始Feed-Forward Networks (FFNs)的參數劃分為多個專家。傳統的FFN層包含大量參數,這些參數可以被分解為多個子集,每個子集稱為一個專家。通過這種方法,可以減少每次計算所需的激活參數數量,從而在保證模型性能的同時顯著降低計算成本。

2. 參數劃分方法

在構建專家時,常用的兩種方法是獨立神經元劃分和共享神經元劃分。

- 獨立神經元劃分:這種方法將FFN中的神經元均勻地劃分為多個子集,每個子集獨立組成一個專家。例如,可以通過隨機劃分或基于聚類的方法來實現這種劃分。隨機劃分是將所有神經元隨機分配給不同的專家,而聚類方法則基于神經元的特征將其分配給不同的專家。

- 共享神經元劃分:與獨立神經元劃分不同,共享神經元劃分允許多個專家共享部分神經元。這種方法可以通過評估神經元的重要性來決定哪些神經元需要共享。共享神經元的目標是保留模型的表示能力,同時減少計算資源的消耗。

3. 實踐案例

在LLaMA-MoE模型的構建過程中,研究人員嘗試了多種參數劃分方法,最終發現隨機劃分方法(IndependentRandom)在保持模型性能方面效果最佳。這種方法簡單而高效,有助于平衡不同專家之間的負載,避免某些專家過度頻繁使用而其他專家很少被激活的問題。

持續預訓練

1. 必要性

由于轉換后的MoE模型在結構上與原始的密集模型(dense model)有所不同,直接使用轉換后的模型可能會導致性能下降。為了恢復和提升模型的語言建模能力,必須對轉換后的MoE模型進行持續預訓練。

2. 預訓練策略

在持續預訓練階段,研究人員使用了兩種主要的數據采樣策略:靜態數據采樣和動態數據采樣。

- 靜態數據采樣:使用固定的采樣權重,從預定義的數據集中提取訓練數據。這種方法簡單直接,但可能無法充分適應不同訓練階段的需求。

- 動態數據采樣:根據模型在訓練過程中的表現動態調整采樣權重,以更好地優化模型性能。盡管這種方法可以提高訓練效率,但也增加了計算復雜度。

3. 數據過濾

為了提高訓練數據的質量,研究人員在預訓練前對數據進行了過濾,去除了約50%的廣告內容和約15%的非流利文本。這一策略有助于加快模型的收斂速度,提高訓練效果。

增強推理能力

1. 激活部分模型參數

在處理具體任務時,MoE模型通過激活部分模型參數來提高推理能力。每個輸入token僅激活與其最相關的幾個專家,從而減少了不必要的計算。這種稀疏激活方式不僅提高了計算效率,還能在保持高性能的同時降低推理成本。

2. 性能提升

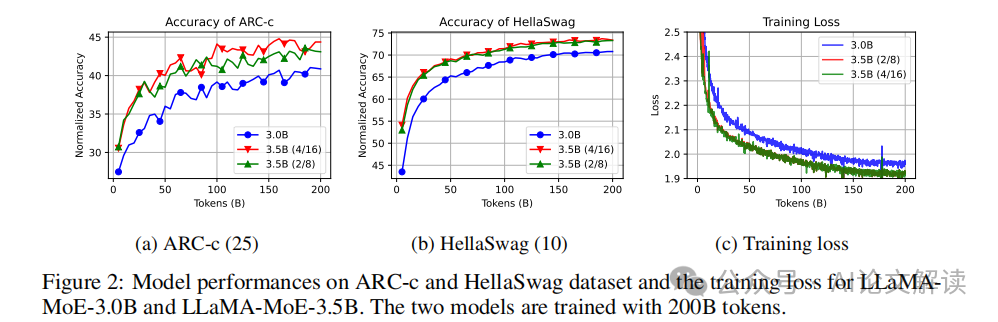

實驗證明,經過200B tokens的預訓練后,LLaMA-MoE-3.5B模型在多個下游任務上顯著優于具有相同激活參數的密集模型。這一結果表明,通過適當的專家劃分和持續預訓練,MoE模型能夠在保持語言能力的同時顯著提升推理性能。

提高可解釋性

1. 部分參數激活

由于每次僅有部分參數被激活,MoE模型在決策過程中的激活路徑更加清晰。這使得研究人員能夠更容易地追蹤和解釋模型的行為,了解模型是如何處理和響應不同輸入的。

2. 實例分析

在實驗中,研究人員觀察到深層網絡層比淺層網絡層有更強的路由偏好,這意味著深層網絡層捕捉更多任務特定的特征,而淺層網絡層則更關注通用特征。這一發現有助于進一步優化專家劃分策略,提高模型的整體性能。

降低計算成本

MoE(Mixture-of-Experts)模型相比傳統的密集模型,通過只激活部分參數來處理輸入,可以顯著降低計算成本。傳統的密集模型在處理每一個輸入時都需要使用所有參數,這樣隨著模型容量的增加,計算成本也會急劇上升。而MoE模型則通過引入專家網絡和門控網絡,只激活一部分專家,從而降低了計算成本。

例如,LLaMA-MoE模型在構建過程中,將原始LLaMA模型的FFN(Feed-Forward Network)分割成多個專家網絡。這種分割方法在維持模型性能的前提下,顯著減少了需要激活的參數量,進而減少了計算開銷。通過訓練200B tokens,LLaMA-MoE-3.5B模型在激活參數量相當的情況下,顯著優于類似的密集模型。

工程應用

MoE模型在需要高效推理的實際應用中展現出巨大的潛力。例如,在實時翻譯和智能助手等場景中,計算成本的降低和推理效率的提高尤為重要。MoE模型可以根據輸入動態選擇合適的專家,從而實現快速而準確的推理。

以實時翻譯為例,傳統模型可能需要大量計算資源來處理復雜的語言轉換,而MoE模型則能夠通過激活少量專家,快速處理翻譯任務,降低延遲并提高響應速度。同樣地,在智能助手中,MoE模型可以根據用戶的不同需求,動態分配計算資源,從而提供更加個性化和高效的服務。

理論研究

在模型架構設計和優化方面,MoE模型提供了新的思路和方法。傳統模型在擴展過程中面臨著計算成本急劇上升的挑戰,而MoE模型通過稀疏激活部分參數,為解決這一問題提供了有效的途徑。

研究表明,通過將密集模型的FFN參數隨機分割成多個專家,并在每一層引入MoE模塊,可以在保持模型性能的同時,減少計算開銷。例如,獨立隨機拆分方法在實驗中取得了最佳性能。與其他方法相比,該方法在專家和門控網絡同時訓練時,可以減少偏差,快速恢復模型的語言能力。

非重疊隨機拆分法

非重疊隨機拆分法通過隨機拆分原始FFN的參數來構建專家,這種方法在實踐中取得了顯著效果。具體而言,給定一個包含所有中間神經元索引的集合U,通過將U隨機分割成等大小的子集,從而構建出多個專家網絡。這種方法能夠在保持模型原有表示能力的基礎上,減少計算復雜度。

在LLaMA-MoE模型的構建中,采用了非重疊隨機拆分法,將FFN層中的中間神經元均勻分割成多個子集,每個子集對應一個專家網絡。實驗結果表明,該方法不僅在減少計算成本方面表現出色,還能夠在持續預訓練階段快速恢復模型的語言能力。研究還發現,對專家輸出進行重新縮放操作,可以顯著提升MoE模型的性能。

通過這些研究和實踐,MoE模型不僅在理論上提供了新的研究方向,還在實際應用中展現出了顯著優勢,為未來的大規模語言模型發展提供了重要參考。

共享神經元方法

共享神經元方法通過結構化裁剪來保留模型的部分表示能力,這種方法主要分為內部共享和外部共享兩種策略。

1. 內部共享

內部共享策略主要是通過對神經元的重要性進行排序,并根據排序結果選擇部分神經元進行共享。具體來說,首先對每個神經元進行重要性評估,可以使用一階泰勒展開來度量每個神經元對損失變化的影響。然后,根據這些重要性分數,將最重要的神經元在不同的專家間共享,而其余神經元則分配給特定的專家。這種方法可以在不顯著降低模型表示能力的情況下,實現有效的參數裁剪和共享。

2. 外部共享

外部共享策略則是在不同專家間直接共享部分神經元,而不進行重要性排序。這種方法通過預先定義的規則,將一些神經元設定為共享神經元,并將其余神經元分配給特定專家。這種方法的優點在于實現簡單且計算開銷較小,但可能在某些情況下無法達到內部共享策略所帶來的性能提升。

數據采樣權重

在訓練過程中,數據采樣權重的選擇對模型的收斂速度和最終性能有重要影響。我們研究了靜態和動態兩種數據采樣策略,以期獲得最快的收斂速度和最佳的性能提升。

1. 靜態采樣

靜態采樣策略是指在訓練過程中使用固定的采樣權重,不隨時間變化。這種方法的優點在于實現簡單且計算開銷較小,但可能無法適應數據分布的動態變化。

2. 動態采樣

動態采樣策略則會在訓練過程中不斷調整采樣權重,以適應當前模型的訓練需求和數據分布變化。具體來說,可以每隔一段時間(例如每2.5B tokens)調整一次采樣權重,根據當前模型在不同數據域上的表現進行調整。這種方法雖然計算開銷較大,但可以顯著提升模型的收斂速度和性能。

數據過濾

為了加快模型的收斂速度,我們對訓練數據進行了嚴格的質量過濾。具體來說,我們過濾掉了低質量的文本數據,如廣告和不流暢的文本。

1. 廣告過濾

廣告通常包含大量冗余和無關信息,對模型的訓練效果影響較大。我們通過特定的規則和算法,過濾掉了大約50%的廣告數據,從而提升了數據集的整體質量。

2. 不流暢文本過濾

不流暢的文本通常表現為語法錯誤、拼寫錯誤或邏輯不連貫。我們使用自然語言處理技術,過濾掉了大約15%的不流暢文本數據,從而進一步提升了模型的訓練效率和效果。

實驗設置

我們的實驗在112個A100 (80G) GPU上進行訓練,最大學習率為2e-4。訓練數據集采用了SlimPajama,該數據集經過清洗和去重處理,包含627B tokens的數據。訓練過程中,我們設置了全局批次大小為15M tokens,最大上下文長度為4096。在經過100步的熱身訓練后,學習率逐步下降到2e-5,采用余弦調度策略。整個訓練過程中,我們對每個模型進行了13.6k步(約200B tokens)的訓練。

通過以上方法和設置,我們成功構建并訓練了LLaMA-MoE模型,并在多項任務中顯著超越了同類模型。

實驗結果

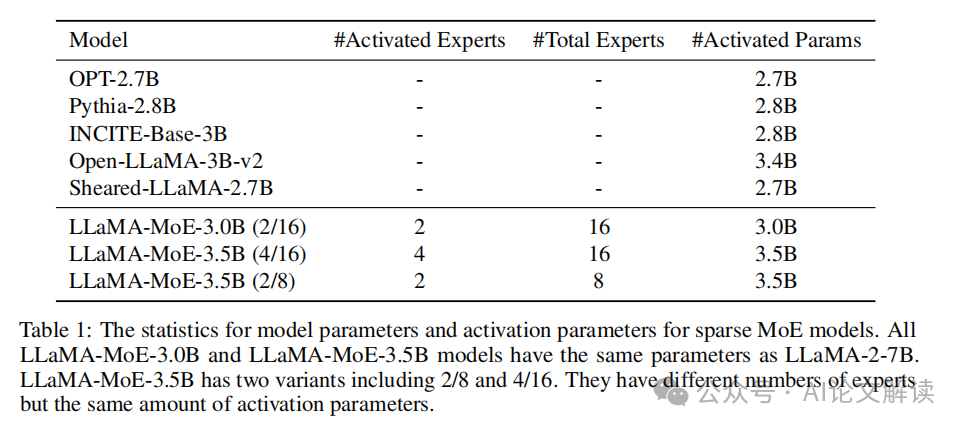

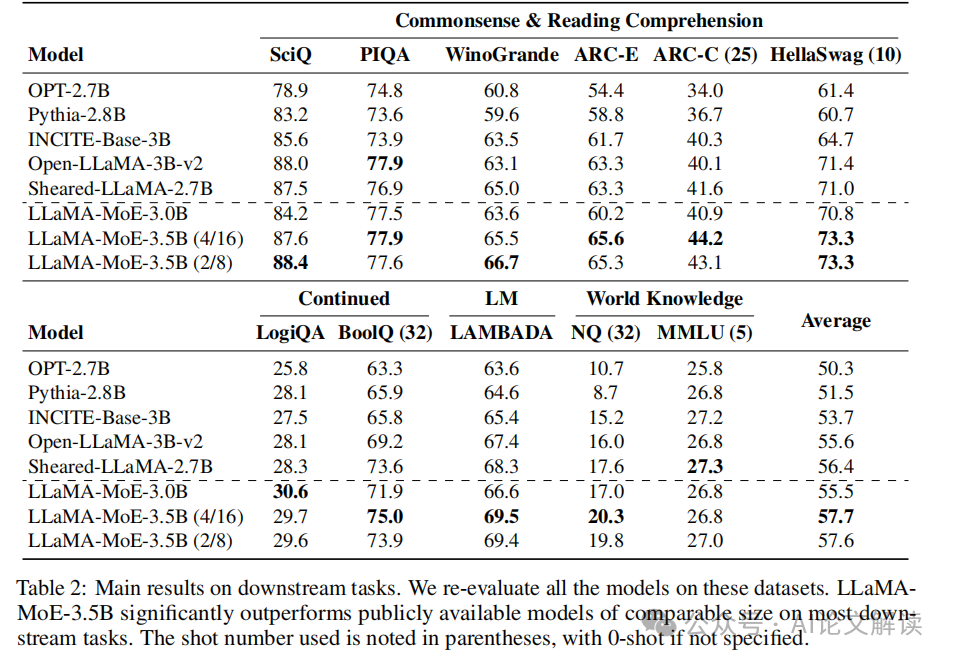

LLaMA-MoE-3.5B在多個下游任務上的表現顯著優于其他具有相似激活參數的開源模型,如Sheared-LLaMA和Open-LLaMA-3B-v2。具體來說,LLaMA-MoE-3.5B(4/16)在各種任務中的平均分數超過了最具競爭力的模型Sheared-LLaMA 1.3分。此外,LLaMA-MoE-3.0B與Open-LLaMA-3B-v2表現相當。

在ARC-c和HellaSwag數據集上的表現顯示,隨著訓練過程的推進,模型的性能穩步提升。盡管ARC-c的結果波動較大,但HellaSwag提供了較為平滑的結果。訓練損失方面,LLaMA-MoE-3.0B和LLaMA-MoE-3.5B分別收斂到1.95和1.90,這兩個模型激活的參數較少,因此損失較LLaMA-2 7B略高。

專家構建方法對比

在實驗中,我們比較了四種不同的專家構建方法。結果顯示,非重疊隨機拆分法(IndependentRandom)表現最佳。這種方法在訓練200B tokens后,表現出最佳的平均分數。相比之下,共享神經元構建方法(SharingInter和SharingInner)在初始階段表現良好,但隨著訓練的進行,其性能顯著下降。

我們還進行了專家輸出重新縮放的消融研究,結果表明,重新縮放操作顯著提高了MoE模型的性能。這表明,專家構建方法對模型最終性能有著重要影響,而重新縮放操作則進一步提升了專家的表現能力。

數據采樣策略

在數據采樣策略的比較中,靜態采樣權重策略(StaticSheared)在性能上優于動態采樣策略。盡管StaticSheared在訓練損失上并不是最低的,但其在下游任務上的表現最佳。動態采樣權重策略(DynamicUniform和DynamicLLaMA)在訓練損失上波動較大,顯示出不穩定性。

在數據采樣權重的變化中,我們發現不同策略對不同領域的數據有不同的權重分配。靜態采樣策略的權重在整個訓練過程中保持不變,而動態采樣策略的權重則隨著訓練的進行逐漸變化。這表明,數據采樣策略的選擇對模型的訓練效率和最終性能有著重要影響。

數據過濾策略

數據過濾策略在提高模型性能方面也起到了關鍵作用。通過過濾掉廣告和不流暢文本,訓練損失顯著降低。具體而言,過濾掉廣告數據的方法在下游任務上的表現不如過濾不流暢文本的方法。這可能是由于廣告數據中的知識和信息較多,被過濾掉的數量較大,從而影響了模型的性能。

基于這些結果,我們最終選擇使用過濾掉不流暢文本的數據集進行訓練。盡管沒有引入新的數據集,但通過過濾部分低質量數據,我們加快了模型的收斂速度,并提高了模型的整體表現。

地址:https://arxiv.org/pdf/2406.16554

代碼:https://github.com/pjlab-sys4nlp/llama-moe

本文轉載自 AI論文解讀,作者:柏企