多模態思維鏈推理在語言模型中的應用 原創

?摘要:大型語言模型(LLMs)通過利用思維鏈(CoT)提示生成中間推理鏈作為推斷答案的理由,在復雜推理方面展現出了令人印象深刻的表現。然而,現有的CoT研究一直專注于語言模態。我們提出了多模態CoT,它將語言(文本)和視覺(圖像)模態結合到一個兩階段框架中,該框架將理由生成和答案推斷分開。通過這種方式,答案推斷可以利用基于多模態信息更好地生成的理由。使用多模態CoT,我們的模型在1億參數以下的情況下,比以前最先進的LLM(GPT-3.5)提高了16個百分點(從75.17%提高到91.68%的準確率),甚至在ScienceQA基準測試中超過了人類的表現。代碼已公開可用。

1. 引言

想象一下閱讀一本沒有圖表的教科書。我們獲取知識的能力在很大程度上得益于對多種數據模態(如視覺、語言和音頻)進行聯合建模。近期,大型語言模型(LLMs)(Brown 等人,2020;Thoppilan 等人,2022;Rae 等人,2021;Chowdhery 等人,2022)在通過生成中間推理步驟來推斷答案之前,已經在復雜推理任務中展現出了令人印象深刻的性能。這種引人入勝的技術被稱為鏈式思考(Chain-of-Thought,CoT)推理(Wei 等人,2022b;Kojima 等人,2022;Zhang 等人,2022)。

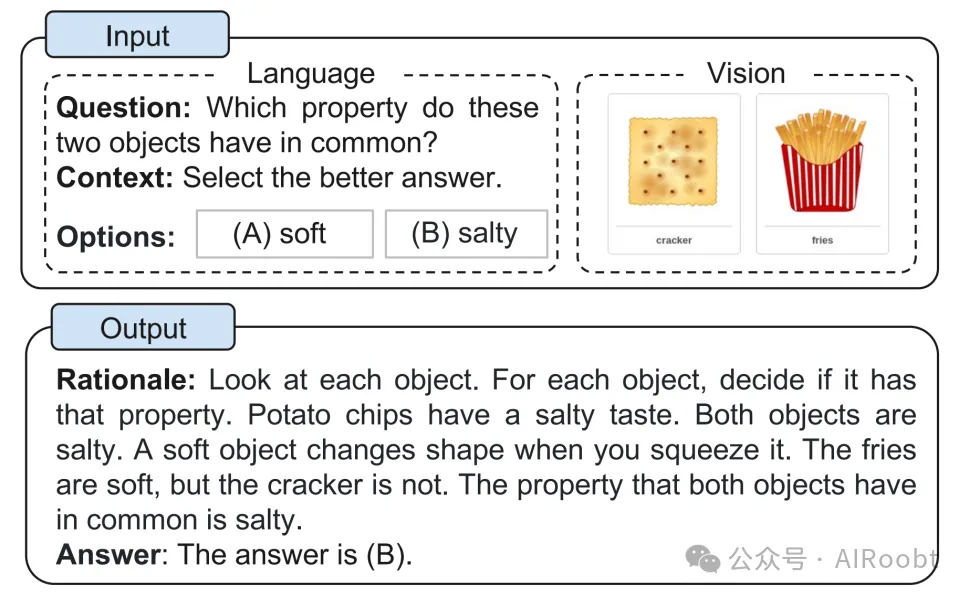

然而,與CoT推理相關的現有研究大多局限于語言模態(Wang等人,2022b;Zhou等人,2022;Lu等人,2022b;Fu等人,2022),很少考慮多模態場景。為了在多模態中激發CoT推理,我們提倡一種多模態CoT范式。鑒于不同模態的輸入,多模態CoT將多步驟問題分解為中間推理步驟(理由),然后推斷答案。由于視覺和語言是最受歡迎的兩種模態,我們在這項工作中專注于這兩種模態。一個例子如圖1所示。一般來說,有兩種方式可以激發多模態CoT推理:(i)提示LLMs和(ii)微調小型模型。

圖1. 多模態CoT任務的示例。

執行多模態CoT最直接的方法是將不同模態的輸入轉換為一種模態,并提示LLMs執行CoT。例如,可以通過標題生成模型提取圖像的標題,然后將標題與原始語言輸入連接起來,輸入到LLMs中(Lu等人,2022a)。然而,在標題生成過程中存在嚴重的信息丟失;因此,使用標題(而不是視覺特征)可能會因不同模態的表示空間中缺乏相互協同而受到影響。

為了促進模態之間的交互,另一種潛在的解決方案是通過融合多模態特征來微調較小的語言模型(LMs)(Zhang等人,2023)。由于這種方法允許調整模型架構以納入多模態特征的靈活性,我們在這項工作中研究了微調模型,而不是提示LLMs。關鍵的挑戰在于,參數少于100億的語言模型往往會生成誤導答案推斷的幻覺理由(Ho等人,2022;Magister等人,2022;Ji等人,2022)。

為了緩解幻覺的挑戰,我們提出了多模態CoT,它將語言(文本)和視覺(圖像)模態納入到一個兩階段框架中,該框架將理由生成和答案推斷分開。通過這種方式,答案推斷可以利用基于多模態信息更好地生成的理由。我們在ScienceQA基準測試(Lu等人,2022a)上進行了實驗,這是最新的具有注釋推理鏈的多模態推理基準測試。實驗結果表明,我們的方法在基準測試上超越了以前的最先進GPT-3.5模型16%(75.17%→91.68%)。我們的貢獻總結如下:

(i)據我們所知,這項工作是第一個研究不同模態中CoT推理的工作。

(ii)我們提出了一個通過微調語言模型來融合視覺和語言表示以執行多模態CoT的兩階段框架。該模型能夠生成有助于推斷最終答案的信息性理由。

(iii)我們的方法在ScienceQA基準測試上取得了新的最佳性能,超越了GPT-3.5的準確率16%,甚至超過了人類的表現。

2. 背景

本節回顧了通過提示和微調語言模型來激發CoT推理的最新進展。

2.1. 用LLMs進行CoT推理

最近,CoT已被廣泛用于激發LLMs的多步推理能力(Wei等人,2022b)。具體來說,CoT技術鼓勵LLM生成解決一個問題的中間推理鏈。研究表明,LLMs可以使用兩種主要的技術范式進行CoT推理:零樣本CoT(Kojima等人,2022)和少樣本CoT(Wei等人,2022b;Zhang等人,2022)。對于零樣本CoT,Kojima等人(2022)通過在測試問題后添加提示,如“Let’s think step by step”(讓我們一步步來),來激發CoT推理,表明LLMs是不錯的零樣本推理器。對于少樣本CoT,使用幾個逐步推理的示例作為推理的條件。每個示例都有一個問題和一個推理鏈,該鏈引導至最終答案。這些示例通常通過手工制作或自動生成獲得。相應的技術因此被稱為手動CoT(Wei等人,2022b)和自動CoT(Zhang等人,2022)。

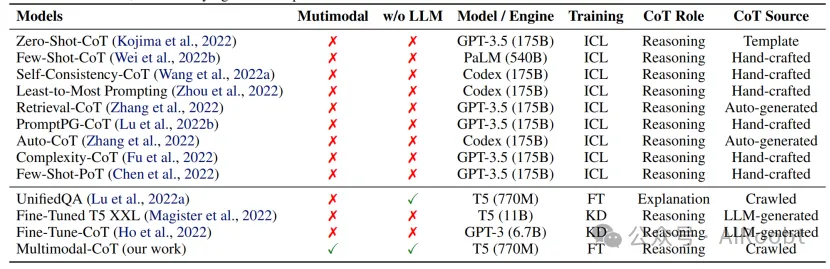

有了有效的示例,少樣本CoT通常比零樣本CoT表現更強,并且吸引了更多的研究興趣。因此,大多數最近的研究集中在如何改進少樣本CoT上。這些研究被歸類為兩個主要的研究線索:(i)優化示例;(ii)優化推理鏈。表1比較了典型的CoT技術。

表1. 典型的CoT技術(FT:微調;KD:知識蒸餾)。第1部分:上下文學習技術;第2部分:微調技術。據我們所知,我們的工作是第一個研究不同模態中的CoT推理。此外,我們專注于10億參數模型,而不依賴于LLMs的輸出。

優化示例 少樣本CoT的性能依賴于示例的質量。正如Wei等人(2022b)所報告的,使用不同注釋者編寫的示例在符號推理任務中導致了顯著的準確性差異。除了手工制作示例,最近的研究還探討了如何優化示例選擇過程。值得注意的是,Rubin等人(2022)檢索了與測試實例語義相似的示例。然而,當推理鏈中存在錯誤時,這種方法顯示出性能下降(Zhang等人,2022)。為了解決這個限制,Zhang等人(2022)發現關鍵是示例問題的多樣性,并提出了自動CoT:(i)將給定數據集的問題劃分為幾個簇;(ii)從每個簇中抽取一個代表性問題,并使用簡單的啟發式方法生成其推理鏈。此外,還提出了強化學習(RL)和基于復雜度的選擇策略來獲得有效的示例。Fu等人(2022)選擇了具有復雜推理鏈的示例(即,具有更多推理步驟)作為示例。Lu等人(2022b)訓練了一個代理,從候選池中找到最優的上下文示例,并在與GPT-3.5交互時最大化給定訓練示例的預測獎勵。

優化推理鏈 優化推理鏈的一個顯著方法是問題分解。Zhou等人(2022)提出了最少到最多的提示,將復雜問題分解為子問題,然后按順序解決這些子問題。結果,解決給定子問題的便利性得到了之前解決的子問題的答案的幫助。同樣,Khot等人(2022)使用了多樣化的分解結構,并設計了不同的提示來回答每個子問題。除了將推理鏈作為自然語言文本提示,Chen等人(2022)提出了思維程序(PoT),它將推理過程建模為程序,并提示LLMs通過執行生成的程序來推導出答案。另一種趨勢是為測試問題投票多個推理路徑。Wang等人(2022a)引入了一種自一致性解碼策略,對LLMs的多個輸出進行采樣,然后對最終答案采取多數投票。Wang等人(2022b)和Li等人(2022b)在輸入空間引入了隨機性,以產生更多樣化的輸出進行投票。

2.2. 通過微調模型激發CoT推理

最近的興趣是通過微調語言模型來激發CoT推理。Lu等人(2022a)在具有CoT注釋的大規模數據集上微調了編碼器-解碼器T5模型。然而,當使用CoT來推斷答案時,即在答案之前生成推理鏈(推理),觀察到性能顯著下降。相反,CoT僅作為答案后的解釋使用。Magister等人(2022)和Ho等人(2022)通過在由更大的教師模型生成的思維鏈輸出上微調學生模型,采用了知識蒸餾。提出的方法在算術、常識和符號推理任務中顯示了性能提升。

在訓練10億參數模型成為CoT推理器方面存在一個關鍵挑戰。正如Wei等人(2022b)所觀察到的,參數少于100億的模型傾向于產生不合邏輯的CoT,導致錯誤的答案。換句話說,對于10億參數模型來說,生成有效的CoT可能比直接生成答案更難。在多模態設置中,回答這個問題還需要理解多模態輸入,這使得挑戰變得更加艱巨。在接下來的部分中,我們將探索多模態CoT的挑戰,并研究如何有效地進行多步推理。

3. 多模態CoT的挑戰

現有的研究表明,CoT(鏈式思考)推理能力可能在一定規模的語言模型中出現,例如超過1000億參數(Wei等人,2022a)。然而,在1B(10億)模型中激發這種推理能力仍然是一個未解決的挑戰,更不用說在多模態場景中了。這項工作專注于1B模型,因為它們可以使用消費級GPU(例如,32G內存)進行微調和部署。在本節中,我們將探討為什么1B模型在CoT推理上失敗,并研究如何設計一種有效的方法來克服這一挑戰。

3.1. 探索CoT的作用

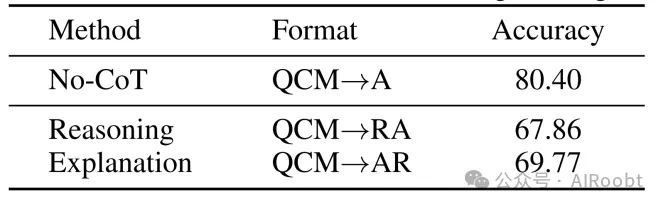

首先,我們在ScienceQA基準測試上微調一個僅文本的CoT推理基線(Lu等人,2022a)。按照Lu等人(2022a)的做法,我們采用UnifiedQABase(Khashabi等人,2020)作為后端語言模型。( UnifiedQA (Khashabi et al., 2020) 被采用,因為它是Lu等人(2022a)中最佳的微調模型。模型信息和實現細節在附錄B.1中介紹。)我們的任務被建模為一個文本生成問題,模型將文本信息作為輸入,并生成包含理由和答案的輸出序列。如圖1所示的例子,模型將問題文本(Q)、上下文文本(C)和多個選項(M)的標記連接作為輸入。為了研究CoT的效果,我們將性能與三個變體進行比較:(i)無CoT,直接預測答案(QCM→A);(ii)推理,答案推斷以理由為條件(QCM→RA);(iii)解釋,理由用于解釋答案推斷(QCM→AR)。

表2. 在單階段設置中CoT(鏈式思考)的效果。

令人驚訝的是,我們觀察到如果模型在預測答案之前先預測推理過程(QCM→RA),準確率會下降12.54%(從80.40%降至67.86%)。這一結果表明,推理過程并不一定會促進正確答案的預測。在Lu等人(2022a)的研究中也觀察到了類似現象,可能的原因是模型在獲得所需答案前就達到了最大令牌限制,或者過早停止了預測的生成。然而,我們發現生成的推理過程(RA)的最大長度總是少于400個令牌,這遠低于語言模型的長度限制(例如,在UnifiedQABase中為512個令牌)。因此,深入探究為何推理過程會對答案推斷產生負面影響,顯得尤為重要。

(注釋:當我們讓一個智能模型先去猜測解題的思考步驟(就像先想好怎么算再給出答案),它的答題正確率降低了12.54%,從原來的80.40%掉到了67.86%。這說明,盡管看似多了一個“思考”的步驟,但這個步驟并不總是幫助模型找到正確答案。其他研究者也發現了類似的問題,可能是模型在還沒找到答案時就已經“說”夠了它能說的字數,或者是提前結束了回答。有趣的是,這些思考步驟其實并不長,遠遠沒有達到模型能處理的最大字數限制。所以,現在有個重要的問題需要研究:為什么這個“先想后答”的過程反而會讓模型答錯更多的題呢?)

3.2. 幻覺理由產生的誤導

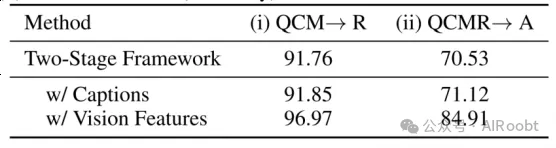

為了深入探究理由如何影響答案預測,我們將CoT問題分為兩個階段:理由生成和答案推斷。我們分別報告了理由生成和答案推斷的RougeL得分和準確率。表3顯示了基于兩階段框架的結果。盡管兩階段基線模型在理由生成上達到了91.76的RougeL得分,但答案推斷的準確率僅為70.53%。與表2中的QCM→A變體(80.40%)相比,結果表明兩階段框架中生成的理由并沒有提高答案的準確率。

表3展示了兩階段設置的評估指標:(i) 理由生成(使用RougeL評分)和(ii) 答案推斷(使用準確性評分)。

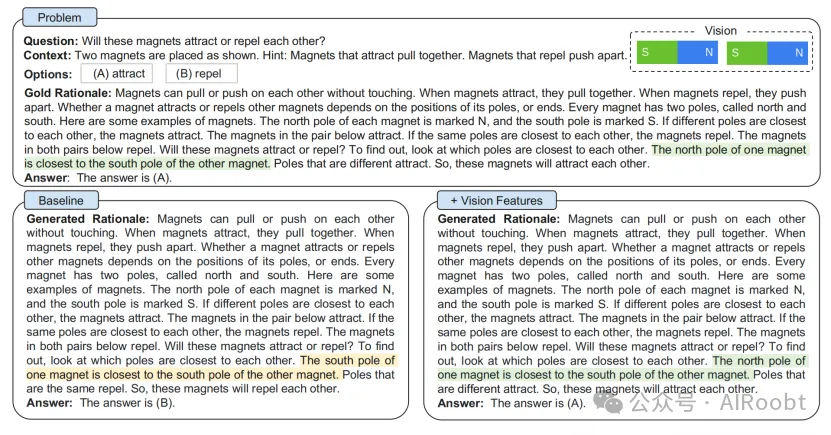

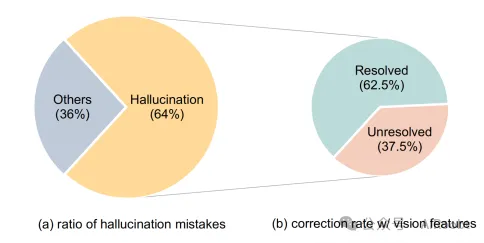

然后,我們隨機抽取了50個錯誤案例,并發現模型傾向于生成誤導答案推斷的幻想理由。如圖2所示的例子,模型(左側部分)幻想出,“一個磁鐵的南極最靠近另一個磁鐵的南極”,這是由于缺乏對視覺內容的引用。我們發現,在錯誤案例中,這類錯誤發生的比例為64%(見圖3(a))。

圖2展示了在不使用視覺特征(基線)和結合視覺特征(我們的方法)的情況下,用于生成推理理由和預測答案的兩階段框架示例。上半部分展示了帶有真實推理依據的問題細節,而下半部分則展示了基線方法及我們結合視覺特征的方法的輸出結果。我們注意到,由于受到虛構推理依據的誤導,基線方法未能預測出正確答案。更多示例請參見附錄A.1。

(圖片解釋:兩階段框架的示例,該框架用于生成理由(rationales)和預測答案:

問題(Problem)

- 問題:這些磁鐵會相互吸引還是相互排斥

上下文(Context)

- 兩個磁鐵如圖所示放置。提示:相互吸引的磁鐵會相互拉近。相互排斥的磁鐵會相互推開。

選項(Options)

- (A) 吸引 (attract)

- (B) 排斥 (repel)

理由(Gold Rationale)

- 磁鐵無需接觸即可相互拉動或推開。當磁鐵相互吸引時,它們會彼此靠近;當磁鐵相互排斥時,它們會彼此遠離。一個磁鐵是吸引還是排斥其他磁鐵,取決于其磁極(或兩端)的位置。每個磁鐵都有兩個磁極,稱為北極和南極。以下是一些磁鐵的例子。每個磁鐵的北極標有N,南極標有S。如果不同的磁極彼此靠近,磁鐵就會相互吸引。如下一對磁鐵會相互吸引。如果相同的磁極彼此靠近,磁鐵則會相互排斥。如下兩對磁鐵都會相互排斥。這些磁鐵會吸引還是排斥呢?要找出答案,只需看哪些磁極彼此最靠近。一個磁鐵的北極離另一個磁鐵的南極最近。不同的磁極會相互吸引。因此,這些磁鐵將會相互吸引。

答案(Answer)

- 根據黃金理由,答案是(A) 吸引。

基線模型生成理由(Generated Rationale)

- 生成的推理:磁鐵無需觸碰就能相互拉動或推開。當磁鐵相互吸引時,它們會彼此靠近。當磁鐵相互排斥時,它們會彼此推開。一個磁鐵是否吸引或排斥其他磁鐵,取決于其磁極或兩端的位置。每個磁鐵有兩個磁極,分別稱為北極和南極。以下是一些磁鐵的例子。每個磁鐵的北極標記為N,南極標記為S。如果不同的磁極彼此最靠近,磁鐵就會相互吸引。如下一對磁鐵會相互吸引。如果相同的磁極彼此最靠近,磁鐵則會相互排斥。如下兩對磁鐵都會相互排斥。這些磁鐵會吸引還是排斥呢?要找出答案,只需觀察哪個磁極彼此最靠近。一個磁鐵的南極離另一個磁鐵的南極最近。相同的磁極會相互排斥。因此,這些磁鐵將會相互排斥。

答案,基線模型的最終答案是(B) 排斥,這與黃金理由相矛盾。回答錯誤

+視覺特征的生成理由(Generated Rationale)

磁鐵能夠不通過接觸而相互拉扯或推開。當磁鐵相互吸引時,它們會聚在一起。當磁鐵相互排斥時,它們會分散開來。一個磁鐵是吸引還是排斥其他磁鐵,取決于其磁極或兩端的位置關系。每個磁鐵都有兩個磁極,分別稱為北極和南極。以下是一些磁鐵的例子。每個磁鐵的北極被標記為N,南極被標記為S。如果不同磁極相互間距離最近,磁鐵就會相互吸引。如下圖這一對磁鐵會相互吸引。如果相同磁極相互間距離最近,磁鐵則會相互排斥。如下兩對磁鐵都顯示出相互排斥的現象。要判斷這些磁鐵會吸引還是排斥,只需查看哪兩個磁極距離最近。一個磁鐵的北極與另一個磁鐵的南極距離最近。不同的磁極會相互吸引。因此,這兩個磁鐵會相互吸引。

答案是:(A)。回答正確

圖3 (a) 幻想錯誤的比例以及(b) 結合視覺特征后的糾錯率。

4. 多模態-CoT

基于第3節中的觀察和討論,我們提出多模態-CoT框架,旨在將語言(文本)和視覺(圖像)兩種模態融入一個兩階段框架中。本節首先概述該框架的流程,然后詳述模型架構的技術設計。

4.1. 框架概覽

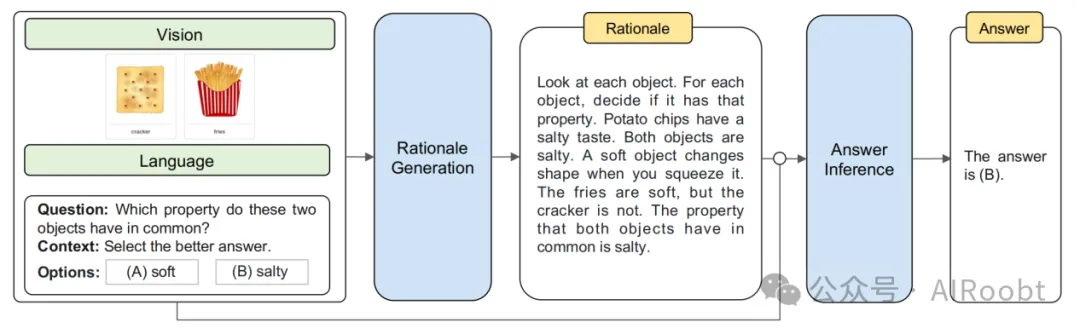

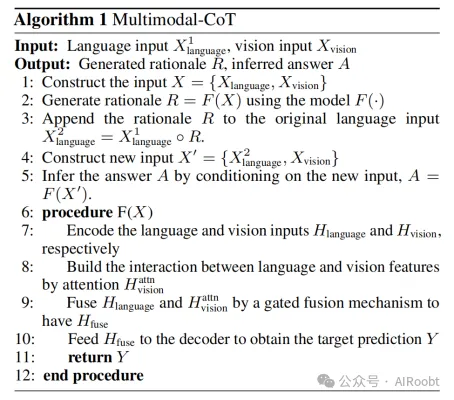

多模態-CoT包括兩個訓練階段:(i) 理由生成和(ii) 答案推斷。這兩個階段采用相同的模型架構,但在輸入X和輸出Y上有所區別。整個流程如圖4所示。我們將以視覺-語言為例來展示多模態-CoT的工作原理。

圖4. 我們的多模態-CoT框架概覽。多模態-CoT包含兩個階段:(i) 理由生成和(ii) 答案推斷。這兩個階段共享相同的模型架構,但在輸入和輸出上有所不同。在第一階段,我們向模型輸入語言和視覺信息以生成推理理由。在第二階段,我們將原始語言輸入與第一階段生成的推理理由相結合。隨后,我們將更新后的語言輸入與原始視覺輸入一起饋送給模型,以推斷出答案。

(理由翻譯:查看每一個物體。對于每個物體,判斷它是否具有那種屬性。薯片具有咸味。兩個物體都是咸的。柔軟的物體會在你擠壓時改變形狀。薯條是軟的,但餅干不是。兩個物體共有的屬性是咸味。)

在理由生成階段,我們向模型輸入X = {X1language, Xvision},其中X1language代表第一階段的語言輸入,Xvision代表視覺輸入,即圖像。例如,X可以實例化為一個組合,包含問題、上下文和多項選擇推理問題的選項(如Lu等人,2022a),如圖4所示。目標是學習一個理由生成模型R = F(X),其中R即為推理理由。

在答案推斷階段,將理由R附加到原始語言輸入X1language上,構建第二階段的語言輸入X2language = X1language?R,其中?表示連接操作。然后,我們將更新后的輸入X’ = {X2language, Xvision}傳遞給答案推斷模型以推斷最終答案A = F(X’)。

在這兩個階段中,我們獨立地使用相同架構訓練兩個模型。它們從訓練集中取注釋元素(例如,X → R,XR → A)進行監督學習。在推理過程中,給定X,使用第一階段訓練的模型為測試集生成理由;這些理由在第二階段用于答案推斷。

4.2. 模型架構

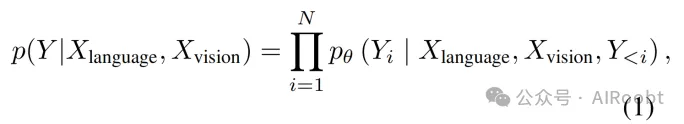

給定語言輸入Xlanguage ∈ {X1language, X2language}和視覺輸入Xvision,我們計算長度為N的目標文本Y(圖4中的理由或答案)的生成概率為

其中pθ (Yi | Xlanguage, Xvision, Y<i) 通過基于Transformer的網絡(Vaswani等人,2017)實現。該網絡包括三個主要步驟:編碼、交互和解碼。具體而言,我們將語言文本輸入到Transformer編碼器中以獲得文本表示,然后與視覺表示進行交互并融合,再輸入到Transformer解碼器中。

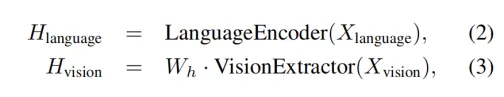

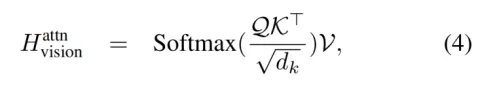

編碼 模型F(X)同時接受語言和視覺輸入,并通過以下函數獲取文本表示Hlanguage和圖像特征Hvision:

其中LanguageEncoder(·)實現為Transformer模型。我們使用Transformer編碼器最后一層的隱藏狀態作為語言表示Hlanguage∈Rn×d ,其中n為語言輸入的長度,d為隱藏維度。同時,VisionExtractor(·)用于將輸入圖像向量化為視覺特征。受Vision Transformers(Dosovitskiy等人,2021)近期成功的啟發,我們使用現成的視覺提取模型(如DETR(Carion等人,2020))獲取圖像的patch級特征。獲取到patch級視覺特征后,我們應用一個可學習的投影矩陣Wh將VisionExtractor(Xvision)的形狀轉換為Hlanguage的形狀,因此我們有Hvision∈Rm×d,其中m為patch的數量。

交互 獲得語言和視覺表示后,我們使用單頭注意力網絡來關聯文本令牌和圖像patch,其中查詢(Q)、鍵(K)和值(V)分別是Hlanguage、Hvision和Hvision。注意力輸出Hattnvision ∈ Rn×d定義為:

其中dk與Hlanguage的維度相同,因為僅使用了一個頭。

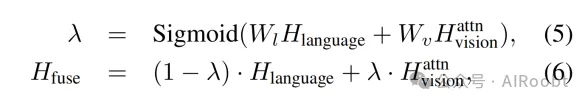

接著,我們應用門控融合機制(Zhang等人,2020;Wu等人,2021;Li等人,2022a)來融合Hlanguage和Hvision。融合輸出Hfuse ∈ Rn×d通過以下公式獲得:

其中Wl和Wv是可學習參數。

解碼 最終,融合輸出Hfuse被送入Transformer解碼器以預測目標Y。多模態-CoT的完整流程如算法1所示。

5. 實驗

本節將介紹基準數據集、我們技術的實現以及用于比較的基線。然后,我們將報告我們的主要結果和發現。

5.1. 數據集

我們的方法在ScienceQA基準測試(Lu等人,2022a)上進行評估。ScienceQA是第一個大規模多模態科學問題數據集,它用詳細的講座和解釋注釋答案。它包含21k多模態多項選擇題,涵蓋3個主題、26個話題、127個類別和379個技能的豐富領域多樣性。基準數據集分為訓練集、驗證集和測試集,分別包含12726、4241和4241個示例。

5.2. 實現

以下部分介紹了多模態CoT和基線方法的實驗設置。

實驗設置 由于多模態CoT任務需要生成推理鏈并利用視覺特征,我們使用T5編碼器-解碼器架構(Raffel等人,2020)。具體來說,我們采用UnifiedQA(Khashabi等人,2020)來初始化兩個階段的模型,因為它在Lu等人(2022a)中取得了最佳的微調結果。為了驗證我們方法在不同語言模型(LMs)中的通用性,我們還使用FLAN-T5(Chung等人,2022)作為第6.3節的主干。由于在第3.3節中使用圖像標題并沒有帶來顯著的性能提升,我們沒有使用標題。我們對模型進行最多20個epoch的微調,學習率為5e-5。最大輸入序列長度為512。基礎和大型模型的批量大小分別為16和8。我們的實驗在4個NVIDIA Tesla V100 32G GPU上運行。

基線模型 按照Lu等人(2022a)的做法,我們的基線包括:(i)視覺問答(VQA)模型(Anderson等人,2018;Kim等人,2018;Yu等人,2019;Gao等人,2019;Kim等人,2021;Lu等人,2021;Li等人,2019);(ii)文本到文本的語言模型(Khashabi等人,2020);(iii)GPT-3.5模型(Chen等人,2020)。更多細節在附錄B.1中介紹。

5.3. 主要結果

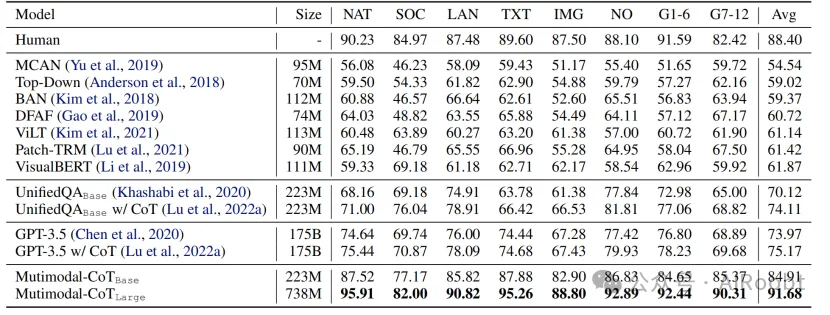

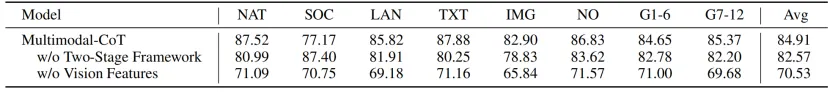

表4顯示了主要結果。多模態CoTLarge在性能上超過了GPT-3.5的16.51%(75.17%→91.68%),并且超過了人類表現。具體來說,在8個問題類別中,多模態CoTLarge對于配對圖像(IMG)的問題實現了21.37%的性能提升(67.43%→88.80%)。與現有的利用圖像標題在上下文中提供視覺語義的UnifiedQA和GPT-3.5方法相比,結果表明使用圖像特征更有效。此外,根據我們在表5中的消融研究結果,我們的兩階段框架有助于取得優越的結果。總體而言,結果驗證了多模態的有效性以及通過我們的兩階段框架實現1B模型CoT推理的潛力。

表4. 主要結果(%)。大小 = 主干模型大小。問題類別:NAT = 自然科學,SOC = 社會科學,LAN = 語言科學,TXT = 文本上下文,IMG = 圖像上下文,NO = 無上下文,G1-6 = 1-6年級,G7-12 = 7-12年級。除我們的結果外,其他結果均摘自Lu等人(2022a)。第1段:人類表現;第2段:VQA基線;第3段:UnifiedQA基線;第4段:GPT-3.5基線;第5段:我們的多模態CoT結果。加粗的結果表示最佳表現。

表5. 多模態CoT的消融研究結果。

6. 分析

以下分析將探討多模態CoT的工作原理,并討論影響因素和局限性。除非另有說明,我們使用基礎大小的模型進行分析。

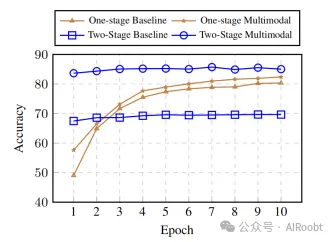

6.1. 多模態加速收斂

圖5顯示了不同訓練周期下基線和多模態CoT的評估準確率曲線。“單階段”基于QCM→A輸入輸出格式,因為它在表2中表現最佳,“雙階段”是我們的雙階段框架。我們發現,與直接生成答案而不進行CoT的單階段基線相比,雙階段方法在開始時的準確率相對較高。然而,沒有視覺特征,雙階段基線隨著訓練的進行無法產生更好的結果,因為理由質量低(如第3節觀察到的)。相比之下,使用視覺特征有助于生成更有效的推理,這有助于我們雙階段多模態變體中更好的答案準確率。

圖5. 無CoT基線和多模態CoT變體在各個epoch(訓練周期)上的準確率曲線。

6.2. 使用不同的視覺特征

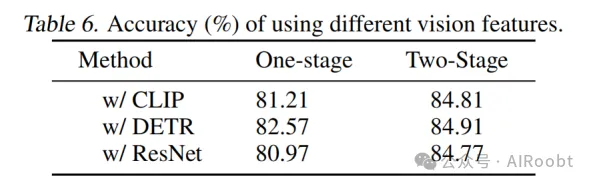

不同的視覺特征可能會影響模型性能。我們比較了三種廣泛使用的視覺特征類型,CLIP(Radford等人,2021)、DETR(Carion等人,2020)和ResNet(He等人,2016)。CLIP和DETR是類似補丁的特征,其中DETR基于目標檢測。對于ResNet特征,我們將ResNet-50的池化特征重復到與文本序列相同的長度,以模仿補丁特征,其中每個補丁與池化圖像特征相同。視覺特征的更多細節在附錄B.2中介紹。

表6顯示了視覺特征的比較結果。我們觀察到使用視覺特征通常比僅使用語言的基線表現更好。具體來說,DETR通常表現更好。因此,在多模態CoT中,我們默認使用DETR。

6.3. 在不同主干模型上的普遍有效性

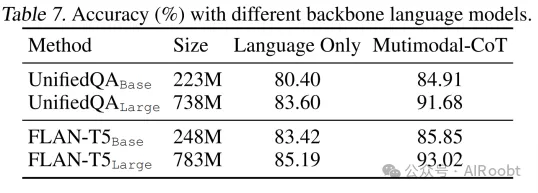

為了測試我們方法的好處對其他主干模型的普遍性,我們將底層語言模型更改為不同大小或類型的其他變體。如表7所示,我們的方法對于廣泛使用的主干模型通常是有效的。

6.4. 錯誤分析

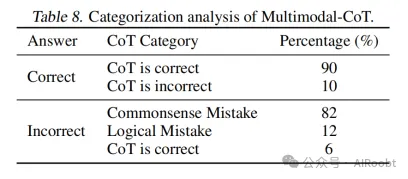

為了更好地理解多模態CoT的行為并促進未來的研究,我們手動調查了我們方法生成的隨機選擇的示例。表8總結了由多模態CoT生成的分類結果。我們隨機挑選了50個答案正確的樣本和50個答案不正確的樣本。每個類別的相應示例在附錄C中介紹。

我們發現正確的樣本(即答案正確的樣本)包含一定數量的錯誤思維鏈(10%)。結果表明,CoT可能并不總是有助于答案推斷,而且模型在一定程度上是健壯的——它可以通過忽略錯誤的推理來預測正確的答案。對于錯誤的樣本(即答案錯誤的樣本),思維鏈中的常識性錯誤是最常見的錯誤類型(88%)。當回答這些問題需要常識知識時,模型經常犯常識性錯誤,例如,理解地圖和計算圖像中的數字(圖9),以及使用字母表(圖10)。另一種錯誤類型是邏輯錯誤(12%),推理鏈中存在矛盾(圖11)。此外,還有一些情況是答案不正確,但它們的CoT是正確的(6%),但可能不一定與答案選項相關(圖12)。

分析表明,未來的研究有前景方向。通過(i)整合更多信息的視覺特征和改進語言-視覺交互以能夠理解地圖和計數;(ii)注入常識知識;(iii)應用過濾機制,例如,只使用有效的CoT來推斷答案并擺脫無關的CoT,可以改進多模態CoT。

7. 結論

我們正式研究了多模態CoT問題。我們提出了多模態CoT,它將語言和視覺模態結合到一個雙階段框架中,該框架將理由生成和答案推斷分開,使答案推斷能夠利用從多模態信息中更好地生成的理由。通過多模態CoT,我們展示了我們的方法在ScienceQA基準測試中的準確率超過了GPT-3.5的16個百分點。我們的錯誤分析表明,利用更有效的視覺特征、注入常識知識以及應用過濾機制來改進未來研究中的CoT推理是有潛力的。

Zhang Z, Zhang A, Li M, et al. Multimodal chain-of-thought reasoning in language models[J]. arXiv preprint arXiv:2302.00923, 2023.

?

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/wA6Zn8VvYNkbBi4usidWNw??