一種利用用戶搜索日志進行多任務學習的商品標題壓縮方法

原創摘要

在淘寶、天貓等電商平臺,商家為了搜索引擎優化(SEO),撰寫的商品標題通常比較冗余,尤其是在APP端等展示空間有限的場景下,過長的商品標題往往不能完全顯示,只能進行截斷處理,嚴重影響用戶體驗。如何將原始商品標題壓縮到限定長度內,而不影響整體成交是一個***挑戰的任務。以往的標題摘要方法往往需要大量的人工預處理,成本較高,并且未考慮電商場景下對點擊率、轉化率等指標的特殊需求。

基于此,我們提出一種利用用戶搜索日志進行多任務學習的商品標題壓縮方法。該方法同時進行兩個Sequence-to-Sequence學習任務:主任務基于Pointer Network模型實現從原始標題到短標題的抽取式摘要生成,輔任務基于帶有注意力機制的encoder-decoder模型實現從原始標題生成對應商品的用戶搜索query。

兩個任務之間共享編碼網絡參數,并對兩者的對原始標題的注意力分布進行聯合優化,使得兩個任務對于原始標題中重要信息的關注盡可能一致。離線人工評測和在線實驗證明通過多任務學習方法生成的商品短標題既保留了原始商品標題中的核心信息又能透出用戶搜索query信息,保證成交轉化不受影響。

研究背景

商品標題是賣家和買家在電商平臺溝通的重要媒介,用戶在搜索入口輸入Query檢索,在搜索結果頁(SRP)瀏覽商品列表,選擇目標商品,最終完成購買。在整條購物成交鏈路中,商品標題、商品描述、商品圖片等各種信息共同影響著用戶的購買決策,信息量豐富而不冗長的標題能大大提升終端用戶體驗。

根據第 40 次《中國互聯網絡發展狀況統計報告》顯示,截止2017年6月,我國手機網民規模已經達到 7.24 億,網民使用手機上網的比例由 2016 年底的 95.1% 提升至 96.3%。越來越多的在線購買行為已經從PC端轉移到無線端 (APP),并且兩者之間的差距還在進一步擴大,因此各大電商平臺的資源也在往各自APP端傾斜。PC和APP最明顯的區別在于顯示屏幕尺寸,通常智能手機顯示屏在 4.5 到 5.5 寸之間,遠小于PC的屏幕尺寸,對算法和產品設計都有新的要求。

當前淘系商品標題主要由商家負責撰寫,為了提高搜索召回和促進成交,商家往往會在標題中堆砌大量冗余詞,當用戶在手機端進行瀏覽的時候,過長的商品標題由于屏幕尺寸限制顯示不全,只能做截斷處理,嚴重影響用戶體驗。

如圖1所示,在SRP頁,商品原始標題顯示不完整,只能顯示14個字左右的短標題,用戶如果想獲取完整標題,還需要進一步點擊進入商品詳情頁,商品原始標題包含近30個字。此外,在個性化推送和推薦場景中,商品短標題作為信息主體,對長度也有一定限制,如何使用盡可能短的文本體現商品的核心屬性,引起用戶的點擊和瀏覽興趣,提高轉化率,是值得深入研究的問題。

圖1. 用戶搜索「碎花裙長袖女」,搜索結果頁商品原始標題過長無法完整顯示,只有點擊進入詳情頁才能看到完整標題。

已有方法介紹

文本摘要(壓縮)是自然語言處理中重要研究方向之一。按摘要的生成方式,可以分為抽取式和生成式兩種。顧名思義,抽取式方法生成的摘要句子和詞均從原文中抽取,而生成式方法更為靈活,摘要中的句子和詞并不要求一定從原文中抽取。傳統的抽取式摘要方法大致可以分為貪心方法、基于圖的方法和基于約束的優化方法等。

近年來神經網絡的方法也被應用到文本摘要領域并取得顯著進步,尤其是生成式摘要方法。業界已有方法都是以壓縮文章長度為優化目標實現文本的摘要,電商場景下除了文本壓縮率還有其他考量,如何在商品標題長度精簡的同時又不影響整體的成交轉化率成為一個業界難題。

方法介紹

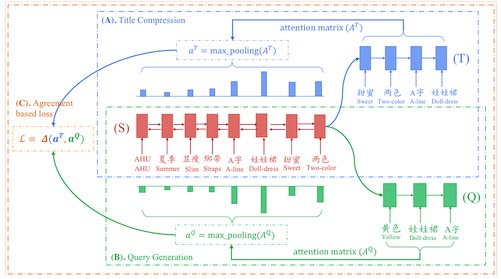

如圖2所示,本文提出的多任務學習方法包含兩個Sequence to Sequence任務,主任務是商品標題壓縮,由商品原始標題生成短標題,采用Pointer Network模型,通過attention機制選取原始標題的關鍵字輸出;輔助任務是搜索query生成,由商品原始標題生成搜索query,采用帶attention機制的encoder-decoder模型。兩個任務共享編碼網絡參數,并對兩者的對原始標題的注意力分布進行聯合優化,使得兩個任務對于原始標題中重要信息的關注盡可能一致。

輔助任務的引入可以幫助主任務更好地從原始標題中保留更有信息量、更容易吸引用戶點擊的詞。相應地,我們為兩個任務構建訓練數據,主任務使用的數據為女裝類目下的商品原始標題和手淘推薦頻道達人改寫的商品短標題,輔助任務使用的數據為女裝類目下的商品原始標題和對應的引導成交的用戶搜索query。

圖2. 多任務學習框架, 兩個Seq2Seq任務共享同一個encoder

主要貢獻

- 本文的多任務學習方法進行商品標題壓縮,生成的商品短標題在離線自動評測、人工評測以及在線評測中均超過傳統抽取式摘要方法。

- 端到端的訓練方式避免了傳統方法的大量人工預處理以及特征工程。

- 多任務學習中的Attention分布一致性設置使得最終生成的商品短標題中能透出原始標題中重要的詞,尤其是能引導成交的核心詞,對于其他電商場景也有重要意義。

實驗結果

我們使用了淘寶女裝類目下的商品標題數據進行了實驗,對比了五種不同的文本摘要方法。

***種是baseline方法,根據目標長度直接截斷方法(Trunc.);

第二種是經典的整數線性規劃方法(ILP),需要對標題進行分詞、NER、Term Weighting等預處理;

第三種是基于Pointer Network實驗的encoder-decoder抽取式方法(Ptr-Net);

第四種是多任務學習方法,直接將兩個子任務的損失函數相加作為整體損失函數進行優化(Vanilla-MTL);

第五種是本文提出的考慮Attention分布一致性的多任務學習方法(Agree-MTL)。

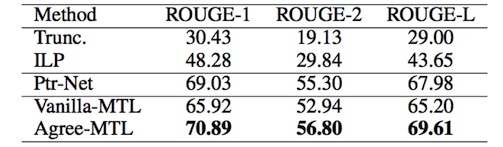

不同方法的自動評價對比

表1. 不同文本摘要方法產生的商品短標題自動評測結果

通過計算生成的短標題和參考短標題之間的三種ROUGE分作為自動評測結果,表1對比了不同的文本摘要方法。本文提出的多任務學習方法顯著超過了其他幾種方法。

不同方法的人工評價對比

表2. 不同方法產生的商品短標題的人工評測結果

表2展示了不同方法產生的商品短標題人工評測對比。由于電商場景下商品的核心產品詞比較敏感,所以在常見的可讀性(Readability)和信息完整性(Informativeness)指標以外,我們還比較了不同方法產生的短標題中核心產品詞是否準確(Accuracy)。從表2結果看,本文提出的方法在三個指標上均超過其他方法。

除了離線的自動評測和人工評測,我們還在真實線上環境中進行了AB測試,相比線上原來的ILP壓縮方法,本文提出的多任務學習方法在CTR和CVR兩個指標上分別有2.58%和1.32%的提升。

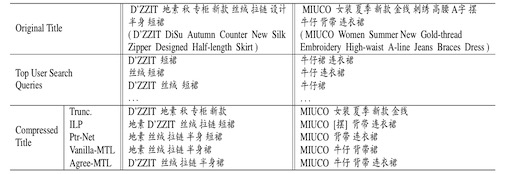

圖3給出了不同方法產生的商品短標題示例。受預處理結果影響,直接截斷和ILP兩種baseline方法生成的短標題流暢度和可讀性較差,而Ptr-Net和多任務學習屬于Sequence-to-Sequence 方法,生成的短標題在可讀性上優于兩種baseline。

圖3左側例子說明,本文方法生成的短標題會透出用戶高頻搜索query中出現過的詞(用戶搜索query中多使用英文品牌名而非中文品牌名),更容易促進成交。

圖3. 不同方法產生的短標題示例

總結

由于商家SEO過度,C2C電商平臺的商品標題通常長度過長且比較冗余且,無法在APP端完整展示。為了解決這個問題,本文使用抽取式摘要方法對過長的商品標題進行壓縮。(前面這句在前面好像沒有提)傳統的摘要方法僅在保持原標題語義的情況下實現標題的壓縮,未考慮電商場景下對壓縮后商品點擊率和成交轉化率的影響。

電商平臺累積了大量用戶搜索query和商品成交信息,利用這部分數據我們可以更有針對性地對原始長標題進行壓縮。因此,我們提出一種多任務學習的標題壓縮方法,包含兩個序列學習子任務: 其中主任務是基于Pointer Network模型實現的從原始標題到短標題的抽取式摘要生成,輔任務是基于帶有Attention機制的encoder-decoder模型實現的從原始標題生成對應商品的用戶搜索query。

兩個任務之間共享編碼參數,使得兩個子任務在原始標題上的Attention分布盡可能一致,對兩者的注意力分布進行聯合優化,進行聯合優化,最終使得主任務生成的短標題在保留原始商品標題中的核心信息的同時,更傾向于透出能促進成交轉化的關鍵詞。

離線人工評測和在線實驗證明使用本文方法在保證不影響成交轉化率的前提下,生成的短標題在可讀性、信息完整度、核心產品詞準確率上都超過了傳統摘要方法。

團隊:iDST-NLP

作者:王金剛,田俊峰(華東師大),裘龍(Onehome),李生,郎君,司羅,蘭曼(華東師大)