2840頁的計算機畢業論文,德州奧斯汀華人博士究竟寫了啥

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

單是目錄就有31頁,以及論文共有2840頁。

你沒看錯,這就是來自德克薩斯大學奧斯汀分校的一篇計算機科學系博士畢業論文。

說實話,計算機系的教材都沒有編寫得這么厚……

那么,這篇畢業論文到底都寫了啥?

3個角度,研究矩陣理論

這篇論文,主要從三個角度,對機器學習、理論計算科學中的矩陣理論進行了研究。

其中,包括矩陣在優化算法中的作用、隨機矩陣中的集中不等式(Concentration inequality)、以及針對矩陣開發的新算法。

首先,是針對優化算法的研究。作者介紹了自己在線性規劃中,對現有矩陣乘法理論進行研究后,提出的一種新算法。

這種算法突破了停滯三十年的研究,可以被應用于經驗風險最小化等優化問題上。

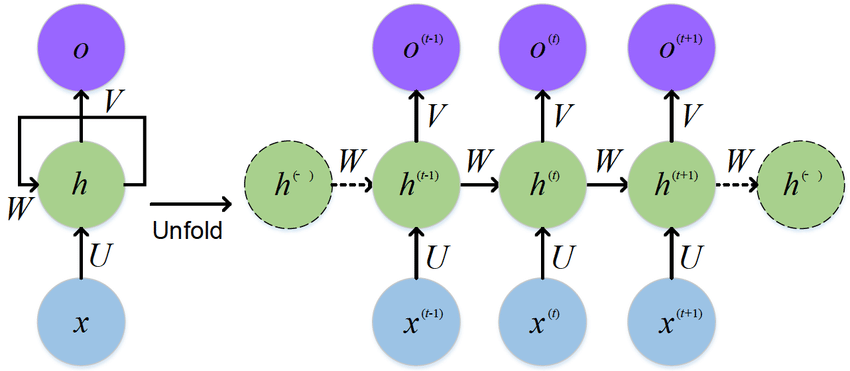

算法以外,作者還對深度神經網絡中的優化算法進行了研究,證明了為什么隨機梯度下降(SGD)可以在多項式時間內神經網絡的訓練目標上找到全局最小值。

而這項理論研究的成果,同樣適用于遞歸神經網絡(RNN)。

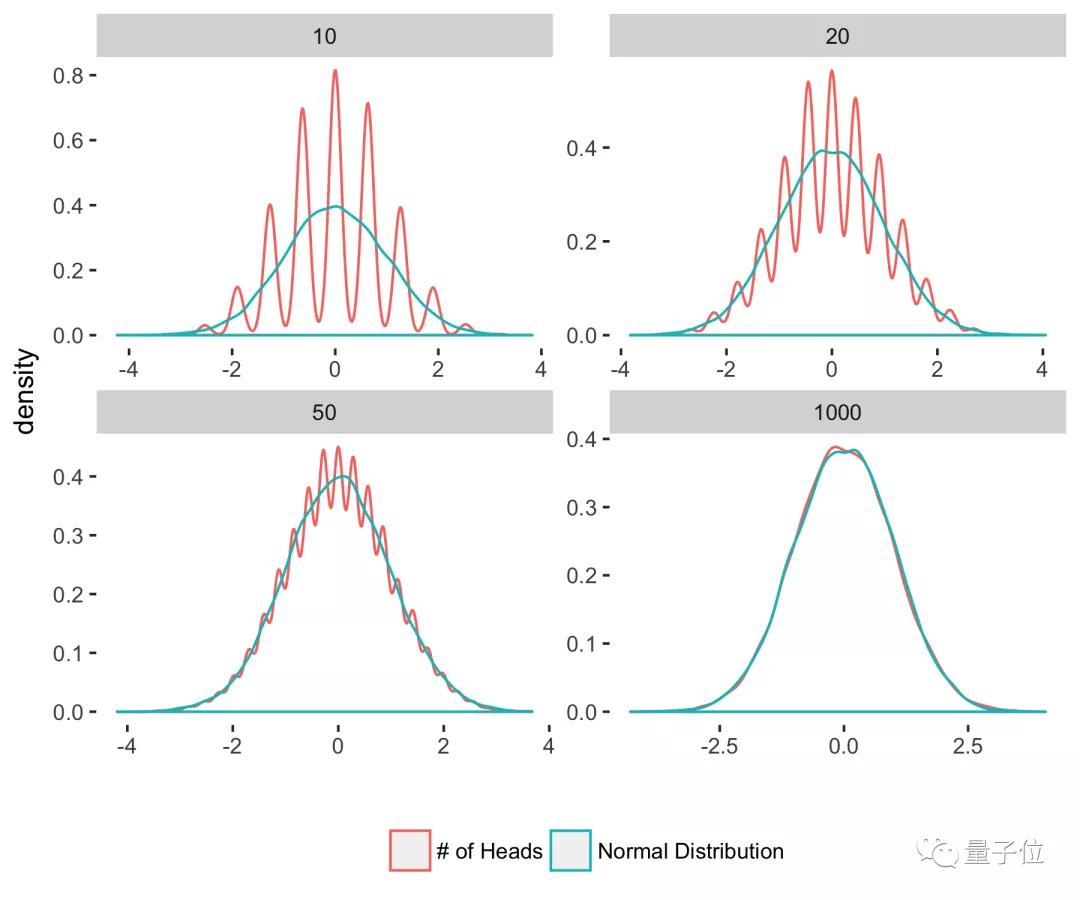

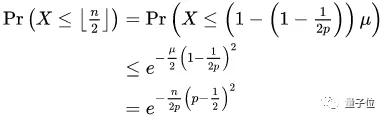

其次,是針對隨機矩陣中的集中不等式的研究。

事實上,隨機矩陣也是陶哲軒當年做出代表性研究的領域之一,在壓縮感知上有著重要應用。

作者主要研究了隨機矩陣中的切爾諾夫邊界,進一步給出了許多關于它的新應用。

此外,作者還研究了差異定理(Discrepancy theory)中的斯賓塞理論(Spencer’s theorem),并將研究成果推廣到了卡迪森-辛格問題中。

最后,作者針對矩陣問題提出了一些新的算法。

這些問題,大致可以分成矩陣分解問題、和結構重建問題兩類。第一類算法,主要是關于低秩矩陣分解的問題;第二類算法,則主要針對結構化矩陣提出的一些重構問題。

例如,作者針對壓縮感知算法設計了相應的矩陣、算法,并給出了針對傅里葉變換的快速算法。

“有輸入才會有輸出”

理論研究之外,作者還騰出了1頁附錄,給剛開始讀博的小伙伴寫了一點話。

他表示,自己曾經多次想退出讀博生涯,但最后還是堅持下來了,積累了一些經驗。

例如,每次開會時,他都習慣用LaTeX記下各種觀點、理論,進行復盤。

復盤時如果發現錯誤,就找出錯誤的原因,并記錄細節。他認為,記錄探索中遇到的問題,能為做出真正的成果提供靈感。

此外,作者還表示,自己一開始曾經抱著“解決某個問題”的心態去寫論文,結果三個月后,不但問題沒解決,心態還崩了。

他的朋友建議他選修一些課程,在里面找論文靈感。果然,在上完課后,他的第一篇博士論文也出來了,心態也恢復了平靜。

因此,他現在仍然保持著多看論文、持續輸入的狀態。如果有頂會論文放出,他會將每篇都快速過一遍,篩選有用的論文仔細閱讀。

最后,作者表示,不要放棄和任何領域的人交流的機會。對于協作者想要研究的領域,他也愿意一同進行探索。

關于這篇博士論文

論文作者Zhao Song,博士畢業于德克薩斯大學奧斯汀分校計算機科學系,本科畢業于西蒙菲沙大學。此前,他曾經是哈佛大學的訪問學者,也在IBM研究中心實習過。

在讀博期間,他的研究方向是機器學習、理論計算科學和數學,感興趣的方向包括深度學習理論、對抗樣本、傅里葉變換等。

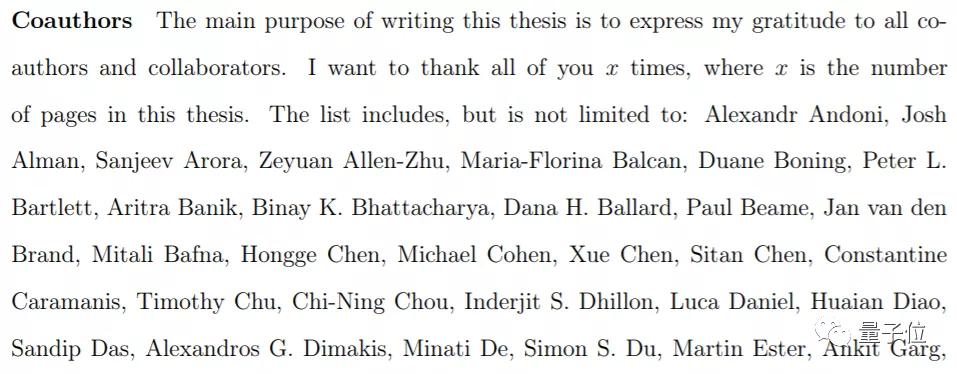

當然,之所以這些研究成果,能寫成2840頁的論文,也離不開在Zhao Song在讀博期間一起進行研究的合作者。

這里面,加上與他討論觀點、交流理論的學者,名字列表就幾乎有5頁:

而且這里面,還不完全包括那些,在他讀博生涯中幫助過他的人。

例如,在他寫畢業論文期間,曾經受到過好些朋友的幫助。不過,這些朋友不愿意加入作者名單,他便一同寫進了致謝。

網友:就當編教材了

論文出來后,有網友調侃,如果想將論文寫長點,還可以試試拆詞。例如“Don’t”,就可以拆分為“Do not”……

也有網友表示,這篇論文的長度,已經快趕上編教材了。(說不定整理一下,真能出書)

不過,既然論文這么長,肯定也寫了不少時間。估計校對一遍都不容易……

也有網友表示,想看看這篇2840頁的論文,就當讀書了。

(需要論文的同學,可以通過下方地址直接下載)

論文地址:

https://repositories.lib.utexas.edu/bitstream/handle/2152/80715/SONG-DISSERTATION-2019.pdf