裝在手機(jī)里的3D姿態(tài)估計(jì),模型尺寸僅同類1/7,誤差卻只有5厘米

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

長(zhǎng)久以來,三維姿態(tài)估計(jì)都在追求準(zhǔn)確性上一路狂奔。

但精度提高的同時(shí),也帶來了計(jì)算成本的上升。

而剛剛被CPVR 2021接受的論文中所提出的模型,MobileHumanPose卻可以同時(shí)做到又小又好。

還是放在手機(jī)上都能hold得住的那種。來感受一下這個(gè)feel:

這種動(dòng)作的健身操也沒問題:

據(jù)了解,這個(gè)模型的尺寸,只有基于ResNet-50的模型的1/7,算力達(dá)到了3.92GFLOPS。

而且平均每關(guān)節(jié)位置誤差(MPJPE),也只有大約5厘米。

那么這一模型到底是如何在有限的算力下產(chǎn)生極佳性能的呢?

基于編碼器-解碼器結(jié)構(gòu)的改進(jìn)

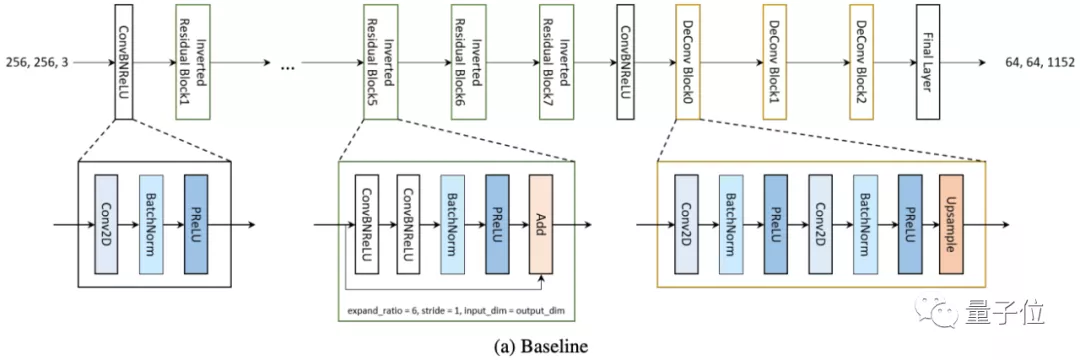

這是一個(gè)從基本的編碼器-解碼器結(jié)構(gòu)改良得來的模型。

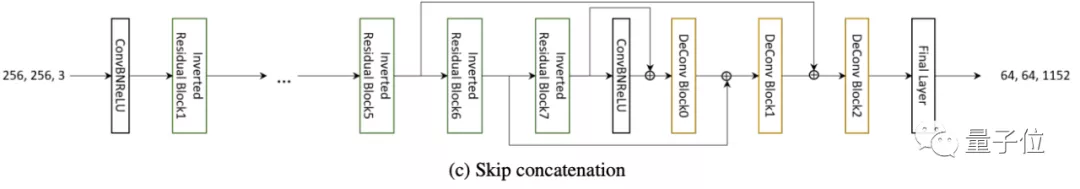

在編碼器用于全局特征提取,而解碼器進(jìn)行姿態(tài)估計(jì)的基礎(chǔ)架構(gòu)上,研究團(tuán)隊(duì)對(duì)其主干網(wǎng)絡(luò)、激活函數(shù),以及Skip concatenation功能都進(jìn)行了修改。

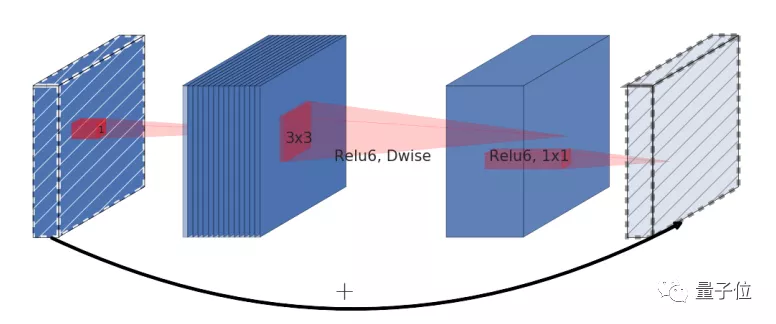

先來看研究團(tuán)隊(duì)選擇的主干網(wǎng)絡(luò),MobileNetV2。

他們?cè)贛obileNetV2的前四個(gè)倒置殘差塊(Residual Block)處修改了通道大小,獲得了性能提升。

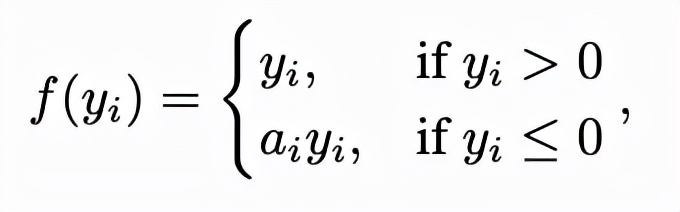

接下來,將PReLU函數(shù)用于實(shí)現(xiàn)激活功能,其中ai為學(xué)習(xí)參數(shù) yi是輸入信號(hào)。

這一函數(shù)中的可學(xué)習(xí)參數(shù)能夠在每一層網(wǎng)絡(luò)都獲得額外的信息,因此在人體姿勢(shì)估計(jì)任務(wù)中使用參數(shù)化PReLU時(shí)可提升性能。

△修改了激活函數(shù)后的baseline

現(xiàn)在,模型的效率已經(jīng)不低了,但考慮到推理速度,團(tuán)隊(duì)使用Skip concatenation結(jié)構(gòu)。這一結(jié)構(gòu)能從編碼器到解碼器中導(dǎo)出低級(jí)別特征信號(hào)(Lowlevel feature signal),不會(huì)降低性能。

參數(shù)量減少5倍,計(jì)算成本降到1/3

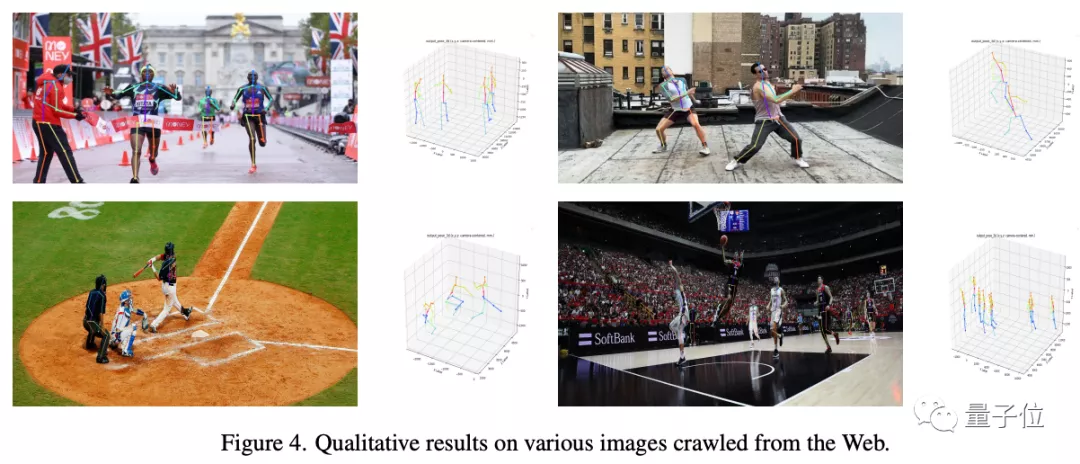

團(tuán)隊(duì)使用Human3.6M和MuCo-3DHP作為三維人體姿勢(shì)數(shù)據(jù)集,他們提出了MobileNetV2的大小兩個(gè)模型。

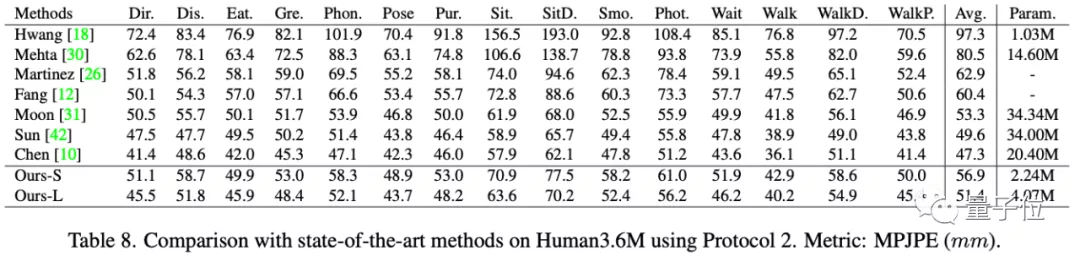

在Human3.6M上,MobileNetV2大模型實(shí)現(xiàn)了51.44毫米的平均每關(guān)節(jié)位置誤差。

且其參數(shù)量為4.07M,對(duì)比同類模型的20.4M(chen)減少了5倍,計(jì)算成本為5.49GFLOPS,是同類模型的1/3不到(14.1G)。

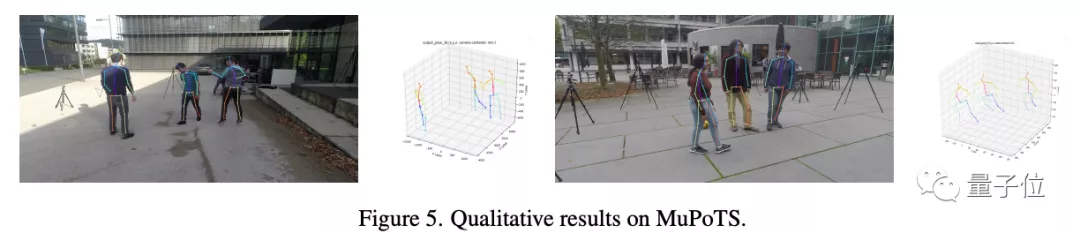

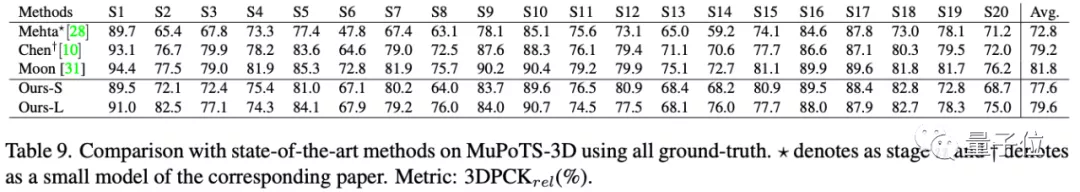

對(duì)于多人三維姿勢(shì)估計(jì)任務(wù),研究者使用RootNet來估計(jì)每個(gè)人的絕對(duì)坐標(biāo),在MuPoTS的20個(gè)場(chǎng)景中進(jìn)行了實(shí)驗(yàn):

實(shí)驗(yàn)結(jié)果證明,對(duì)比Zerui Chen等研究者提出的獲ECCV 2020的三維人體姿態(tài)估計(jì)方法,MobileNetV2在一般場(chǎng)景中的性能都更好,且在少數(shù)場(chǎng)景中取得了最佳性能:

在模型效率上,MobileNetV2的大模型效率為2.24M/3.92GFLOPS,遠(yuǎn)超同類模型的13.0M/10.7GFLOPS(Zerui Chen)。

而小模型也能實(shí)現(xiàn)56.94毫米的平均每關(guān)節(jié)位置誤差,有224萬(wàn)個(gè)參數(shù),計(jì)算成本為3.92GFLOPS。

作者介紹

論文的三位作者皆畢業(yè)于韓國(guó)高等技術(shù)研究院,一作Sangbum Choi為該校的電機(jī)及電子工程專業(yè)碩士。

論文:

https://openaccess.thecvf.com/content/CVPR2021W/MAI/html/Choi_MobileHumanPose_Toward_Real-Time_3D_Human_Pose_Estimation_in_Mobile_Devices_CVPRW_2021_paper.html

開源地址:

[1]https://github.com/SangbumChoi/MobileHumanPose

[2]https://github.com/ibaiGorordo/ONNX-Mobile-Human-Pose-3D