谷歌開源 3D 舞蹈生成模型 FACT

谷歌開源了其基于 AIST++ 的 3D 舞蹈生成模型 FACT。該模型不僅可以學習音樂-運動對應關系,還可以生成以音樂為基礎的 3D 運動序列。

此前,谷歌層發布了大規模的多模態 3D 舞蹈動作數據集 AIST++,它包含了 1408 個序列中 5.2 小時的 3D 舞蹈動作,涵蓋了 10 種舞蹈流派,每個序列都包括已知相機姿勢的多視角視頻。而 FACT 模型則可以使用使用這些數據從音樂生成 3D 舞蹈,甚至可以幫助增強一個人的編舞能力。

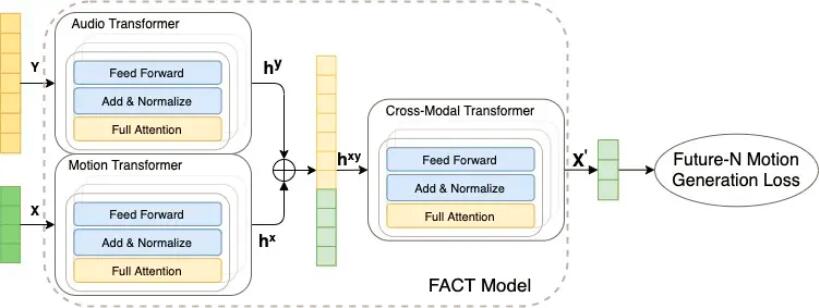

根據谷歌描述,該模型首先使用單獨的運動和音頻轉換器對種子運動和音頻輸入進行編碼,然后將嵌入連接起來并發送到跨模態轉換器,該轉換器學習兩種模態之間的對應關系并生成 N 個未來的運動序列,然后使用這些序列以自我監督的方式訓練模型。在測試時,將此模型應用于自回歸框架,其中預測的運動作為下一代步驟的輸入,從而使 FACT 模型能夠逐幀生成長距離舞蹈動作。

此外,谷歌還解釋了 FACT 涉及的三個關鍵設計選擇,這些選擇對于從音樂中產生逼真的 3D 舞蹈動作至關重要,包括所有轉換器都使用全注意掩碼、訓練模型會預測當前輸入之外的 N 個未來而不僅僅是下一個動作以及采用了一個深度的12層跨模式轉換模塊。最終,FACT 表現出了較好的運動質量、生成多樣性、以及節拍對齊分數。

目前,用于訓練的數據 AIST++、FACT 模型代碼以及一個經過訓練的模型均已發布。

本文轉自OSCHINA

本文標題:谷歌開源 3D 舞蹈生成模型 FACT

本文地址:https://www.oschina.net/news/160132/google-publish-fact