量子計算是人工智能的未來嗎?

由于量子計算能夠在“量子態”中容納許多不同的可能結果,它有可能為機器學習和人工智能問題提供一個巨大的計算升級。然而,圍繞量子計算仍有許多未解之謎,而且尚不清楚這些設備是否有助于企業人工智能投資的建設浪潮。

在20世紀50年代首次出現的二進制計算機發展成到今天已經成為價值數萬億美元的IT(信息技術)行業的基礎。僅僅用兩個比特位(bit)和三個布爾代數運算符,我們就創造了巨大的數據處理機器,使許多手工任務自動化,并對我們周圍的世界產生了巨大的影響。從基本的會計和電子商務到飛行控制計算機和了解基因組,計算機對我們現代生活的影響巨大。

但是,當我們接近經典二進制計算機的極限時,量子計算機出現了,帶來(尚未實現的)計算能力的巨大提升。量子計算不再局限于1和0上的布爾線性代數函數,而是允許我們在量子或量子位上使用線性代數,這些量子位由數字、向量和矩陣組成,在量子態中相互作用,包括疊加、糾纏和干涉。

量子計算打開了一扇門,潛在地解決了傳統計算機無法解決的非常龐大和復雜的計算問題。比如使用“蠻力”方法猜測由256位算法加密一段數據的密碼。使用AES-256加密的數據被認為非常安全的,因為它不能被暴力破解。但隨著量子計算機計算多種可能狀態的能力,解決這類問題將觸手可及。

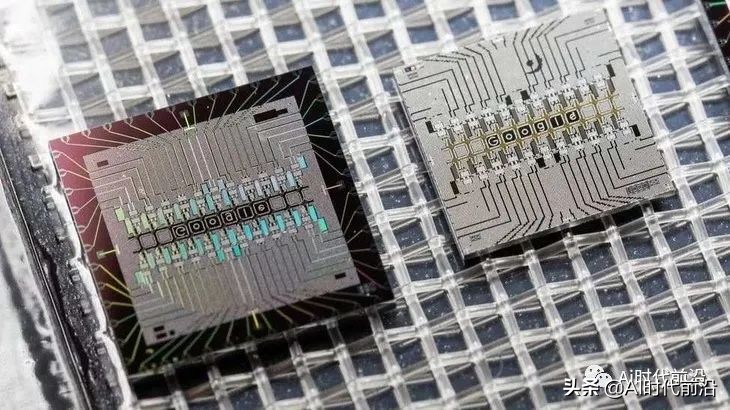

——谷歌Sycamore量子處理器

另一個例子是旅行推銷員問題。給定一些地理位置,找出其中最有效的路徑實際上是一個經典的計算密集型問題。花費數十億美元為貨運卡車加油的聯合包裹公司(UPS)甚至限制了司機左轉的次數,試圖最大限度地縮短送貨時間,減少燃料消耗。

這讓我們想到了機器學習和人工智能。機器學習(ML)的最新形式——深度學習(DL)正在挑戰傳統計算機的能力極限。大型Transformer模型,如OpenAI的GPT-3,它有1750億個參數,需要幾個月的時間在傳統計算機上訓練。隨著未來的模型成長為數以萬億計的參數,它們將需要更長的時間來訓練。這就是為什么用戶采用新型微處理器架構的原因之一(延展閱讀:超大芯片吸引2.5億美元新資金),這種架構提供了比傳統CPU甚至GPU更好的性能。

但是所有這些,包括CPU和GPU是與經典的二進制計算機捆綁在一起的,有先天限制。量子計算機為一系列用例的性能和能力提供了量子飛躍的可能性,人工智能肯定是其中之一。

量子人工智能定義為使用量子計算運行機器學習算法。多虧了量子計算的計算優勢,量子人工智能可以幫助實現傳統計算機無法實現的結果。

谷歌是最早涉足這一領域的量子計算機制造商之一。2020年3月,谷歌推出了TensorFlow Quantum,將TensorFlow機器學習開發庫帶入量子計算機的世界。通過TensorFlow Quantum,開發者將能夠開發在量子計算機上運行的量子神經網絡模型。

谷歌 TensorFlow Quantum

雖然在量子計算機上運行人工智能應用程序仍處于非常早期的階段,但有許多組織正在努力開發它。比如NASA與谷歌合作已經有一段時間了。

而且研究人員看好量子人工智能算法在計算能力方面提供下一個突破的潛力。這種方法將產生處理大量數據的新方法。

今年早些時候,IBM研究院宣布發現了量子機器學習的量子優勢的“數學證據”。證明以分類算法的形式出現,該算法提供了對“經典數據”的訪問,提供了比經典ML方法“可證明的指數級加速”。讓我們看到了量子人工智能可能實現的一個潛在未來。

可以肯定的是,每當人工智能和量子計算這兩項被高度炒作的技術走到一起時,總會有很多疑問。IBM在2021年7月曾表示:“在計算機科學中,很少有概念像量子機器學習那樣令人興奮,也可能像量子機器學習那樣引發炒作和錯誤信息。”

雖然量子人工智能似乎有潛力,但這種潛力尚未實現。樂觀的一面是,我們至少有理由樂觀地認為,未來可能會有真正的突破。

但懷疑者是正確的,量子計算仍然是一個研究領域,距離應用于神經網絡還有很長的路要走。然而,在10年內,由于計算能力不足,人工智能可能會進入另一個平臺期,量子計算崛起,會幫助人工智能的繼續高速發展。

現在判斷量子計算領域是否會對人工智能的發展產生重大影響還為時過早。有許多有希望的進展,但仍有許多未解之謎。