一日一技:輕松排雷,爬蟲讓 Gzip 炸彈變啞炮

在昨天的文章《??一日一技:反爬蟲的極致手段,幾行代碼直接炸了爬蟲服務器??》中,我講到了后端如何使用gzip返回極高壓縮率的文件,從而瞬間卡死爬蟲。

大家都知道我的公眾號風格,兩頭得罪討好人 。昨天我幫了后端,今天我就幫幫爬蟲。作為爬蟲,如何避免踩中gzip炸彈?

最直接的方法,就是把你的爬蟲隱藏起來,因為gzip炸彈只能在發現了爬蟲以后使用,否則就會影響到正常用戶。只要你的爬蟲讓網站無法發現,那么自然就不會踩中炸彈。

如果你沒有把握隱藏爬蟲,那么,請繼續往下看。

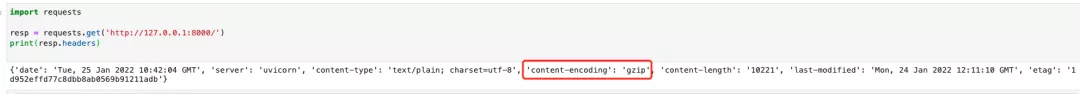

查看gzip炸彈的URL返回的Headers,你會發現如下圖所示的字段:

你只需要判斷resp.headers中,是否有一個名為content-encoding,值包含gzip或deflate的字段。如果沒有這個字段,或者值不含gzip、deflate那么你就可以放心,它大概率不是炸彈。

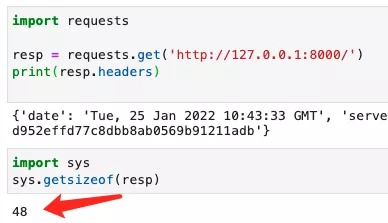

值得一提的是,當你不讀取resp.content、resp.text的時候,Requests是不會擅自給你解壓縮的,如下圖所示。因此你可以放心查看Headers。:

那么,如果你發現網站返回的內容確實是gzip壓縮后的內容了怎么辦呢?這個時候,我們如何做到既不解壓縮,又能獲取到解壓以后的大小?

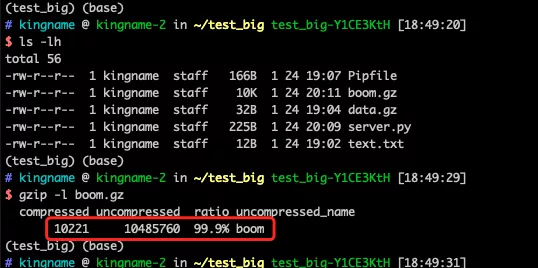

如果你本地檢查一個.gz文件,那么你可以使用命令gzip -l xxx.gz來查看它的頭信息:

打印出來的數據中,第一個數字是壓縮后的大小,第二個數字是解壓以后的大小,第三個百分比是壓縮率。這些信息是儲存在壓縮文件的頭部信息中的,不用解壓就能獲取到。

那么當我使用Requests的時候,如何獲得壓縮后的二進制數據,防止它擅自解壓縮?方法其實非常簡單:

import requests

resp = requests.get(url, stream=True)

print(resp.raw.read())

運行效果如下圖所示:

此時可以看到,這個大小是壓縮后的二進制數據的大小。現在,我們可以使用如下代碼,在不解壓的情況下,查詢到解壓縮后的文件大小:

import gzip

import io

import requests

resp = requests.get(url, stream=True)

decompressed = resp.raw.read()

with gzip.open(io.BytesIO(decompressed), 'rb') as g:

g.seek(0, 2)

origin_size = g.tell()

print(origin_size)

運行效果如下圖所示:

打印出來的數字轉成MB就是10MB,也就是我們昨天測試的解壓后的文件大小。

使用這個方法,我們就可以在不解壓的情況下,知道網站返回的gzip壓縮數據的實際大小。如果發現實際尺寸大得離譜,那就可以確定是gzip炸彈了,趕緊把它丟掉。