寫一個爬取板塊資金流的Python程序

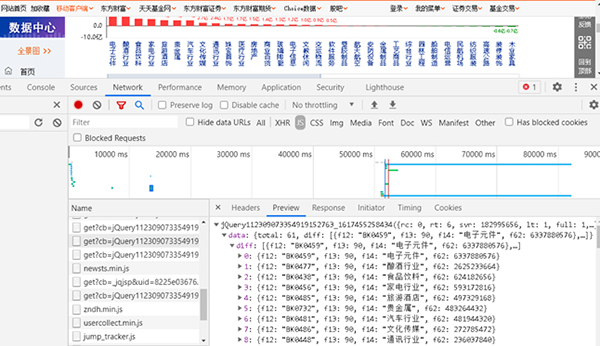

通過上面爬取股票個股資金流的例子,大家應該已經能夠學會自己編寫爬取代碼。現在鞏固一下,做個相似的小練習題。要動手自己編寫Python程序,爬取網上板塊的資金流。爬取網址為http://data.eastmoney.com/bkzj/hy.html,顯示界面如圖1所示。

圖1 板塊資金流網址界面

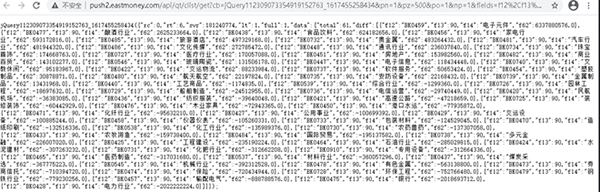

1,查找JS

直接按F12鍵,打開開發調試工具并查找數據所對應的網頁,如圖2所示。

圖2 查找JS所對應的網頁

然后把網址輸入瀏覽器中,網址比較長。

http://push2.eastmoney.com/api/qt/clist/get?cb=jQuery112309073354919152763_1617455258434&pn=1&pz=500&po=1&np=1&fields=f12%2Cf13%2Cf14%2Cf62&fid=f62&fs=m%3A90%2Bt%3A2&ut=b2884a393a59ad64002292a3e90d46a5&_=1617455258435

此時,會得到網站的反饋,如圖3所示。

圖3 從網站獲得板塊及資金流

該網址對應的內容即是我們想要爬取的內容。

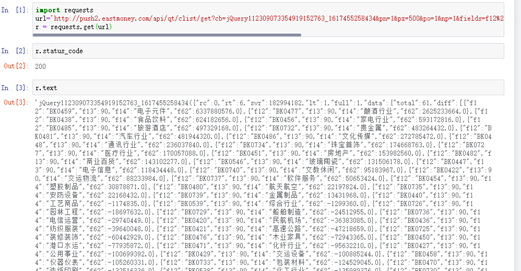

2,request請求及response響應狀態

編寫爬蟲代碼,詳見如下代碼:

# coding=utf-8

import requests

url=" http://push2.eastmoney.com/api/qt/clist/get?cb=jQuery112309073354919152763_

1617455258436&fid=f62&po=1&pz=50&pn=1&np=1&fltt=2&invt=2&ut=b2884a393a59ad64002292a3

e90d46a5&fs=m%3A90+t%3A2&fields=f12%2Cf14%2Cf2%2Cf3%2Cf62%2Cf184%2Cf66%2Cf69%2Cf72%2

Cf75%2Cf78%2Cf81%2Cf84%2Cf87%2Cf204%2Cf205%2Cf124"

r = requests.get(url)

r.status_code顯示200,表示響應狀態正常。r.text也有數據,說明爬取資金流數據是成功的,如圖4所示。

圖4 response響應狀態

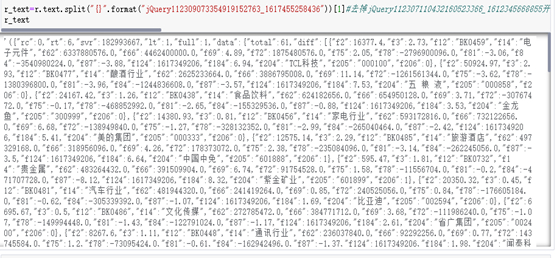

3,清洗str變成JSON標準格式

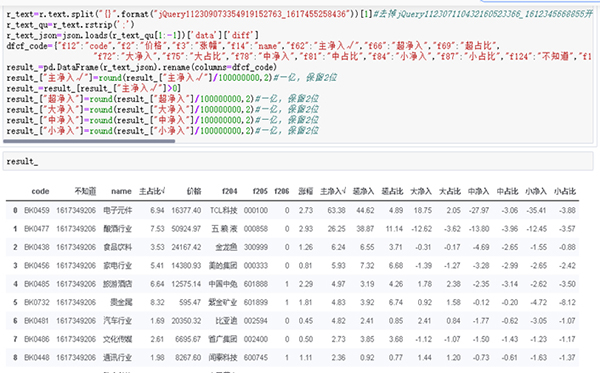

(1)分析r.text數據。其內部是標準的JSON格式,只是前面多了一些前綴。將jQ前綴去掉,使用split()函數就能完成這個操作。詳見如下代碼:

r_text=r.text.split("{}".format("jQuery112309073354919152763_1617455258436"))[1]

r_text

運行結果如圖5所示。

圖5 去掉前綴的運行結果

(2)整理JSON數據。詳見如下代碼:

r_text_qu=r_text.rstrip(';')

r_text_json=json.loads(r_text_qu[1:-1])['data']['diff']

dfcf_code={"f12":"code","f2":"價格","f3":"漲幅","f14":"name","f62":"主凈入√","f66":"超凈入","f69":"超占比", "f72":"大凈入","f75":"大占比","f78":"中凈入","f81":"中占比","f84":"小凈入","f87":"小占比","f124":"不知道","f184":"主占比√"}

result_=pd.DataFrame(r_text_json).rename(columns=dfcf_code)

result_["主凈入√"]=round(result_["主凈入√"]/100000000,2)#一億,保留2位

result_=result_[result_["主凈入√"]>0]

result_["超凈入"]=round(result_["超凈入"]/100000000,2)#一億,保留2位

result_["大凈入"]=round(result_["大凈入"]/100000000,2)#一億,保留2位

result_["中凈入"]=round(result_["中凈入"]/100000000,2)#一億,保留2位

result_["小凈入"]=round(result_["小凈入"]/100000000,2)#一億,保留2位

result_

運行結果如圖6所示。

圖6 整理后的運行結果

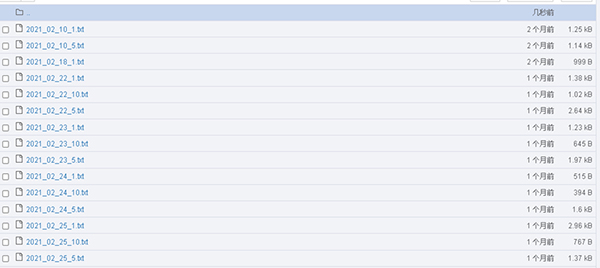

4,保存資金流數據

將清洗好的數據使用to_csv()函數保存到本地,如圖7所示。

通過以上兩種資金爬取的例子,想必大家已經了解了爬蟲的一部分使用方法。其核心思路是:

(1)選取股票個股資金流的優勢;

(2)獲得網址并加以分析;

(3)使用爬蟲進行數據獲取并保存數據。

圖6 數據保存

總結

JSON格式的數據是諸多網站使用的標準化數據格式之一,是一種輕量級的數據交換格式,十分易于閱讀和編寫,可以有效地提升網絡傳輸效率。首先爬取到的是str格式的字符串,通過數據加工與處理,將其變成標準的JSON格式,繼而變成Pandas格式。

通過案例分析與實戰,我們要學會自己編寫代碼爬取金融數據并具備轉化為JSON標準格式的能力。完成每日數據爬取工作與數據保存工作,為日后對數據進行歷史測試與歷史分析提供有效的數據支撐。

當然,有能力的讀者可以將結果保存到MySQL、MongoDB等數據庫中,甚至云端數據庫Mongo Atlas中,這里作者不作重點講解。我們將重點完全放在量化學習與策略的研究上面。使用txt格式保存數據,完全可以解決前期數據存儲問題,數據也是完整有效的。