??想了解更多關于開源的內容,請訪問:??

??51CTO 開源基礎軟件社區??

??https://ost.51cto.com??

一、虛擬機環境準備

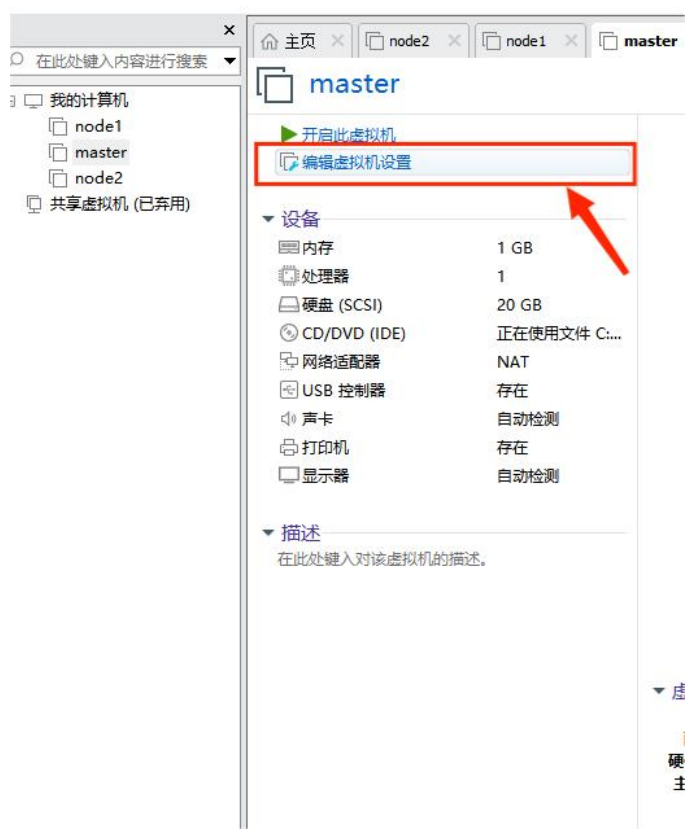

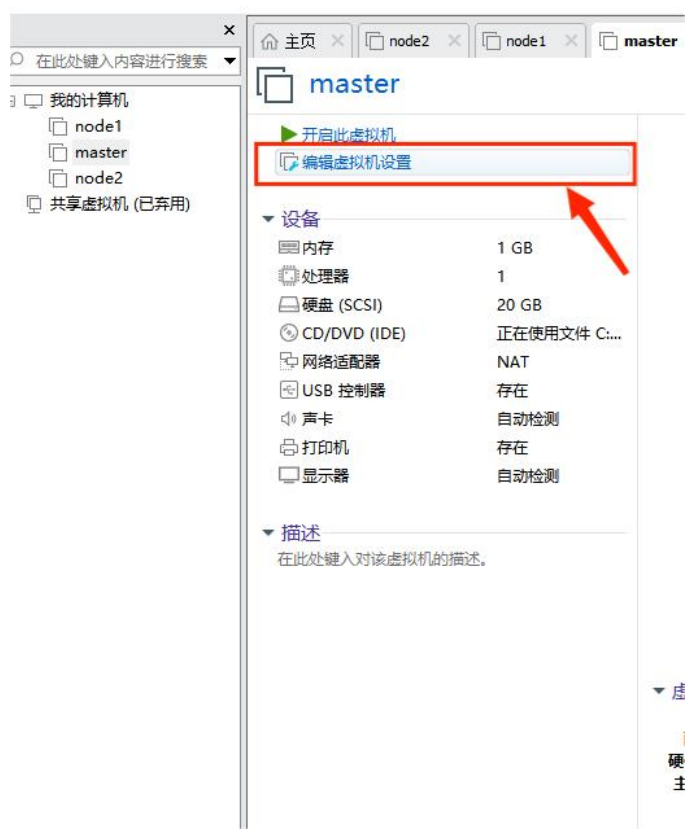

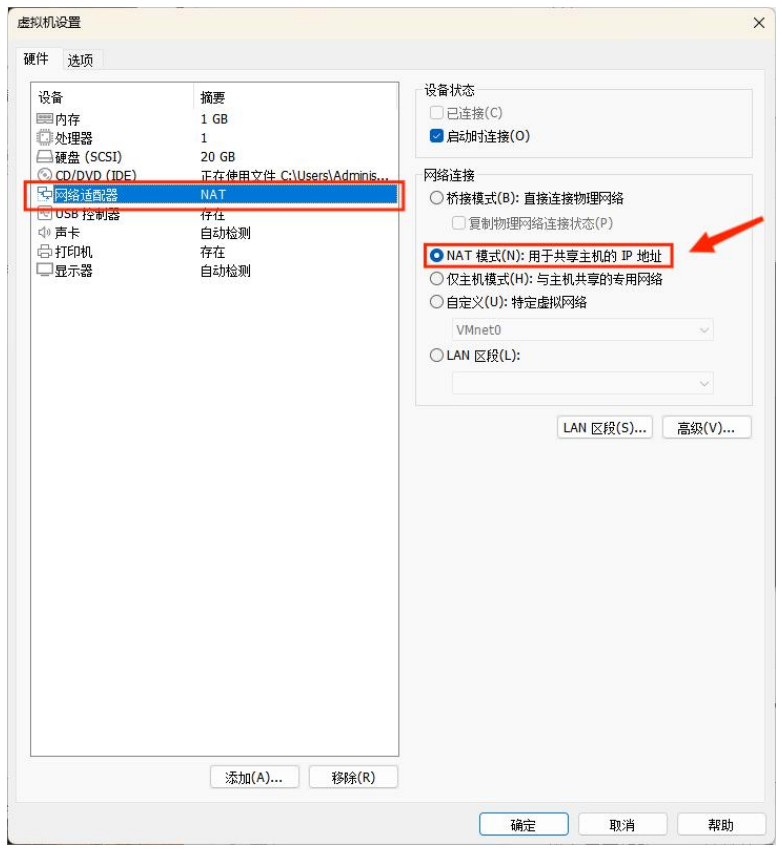

1、虛擬機網絡模式設置為 NAT

點擊 “編輯虛擬機設置”。

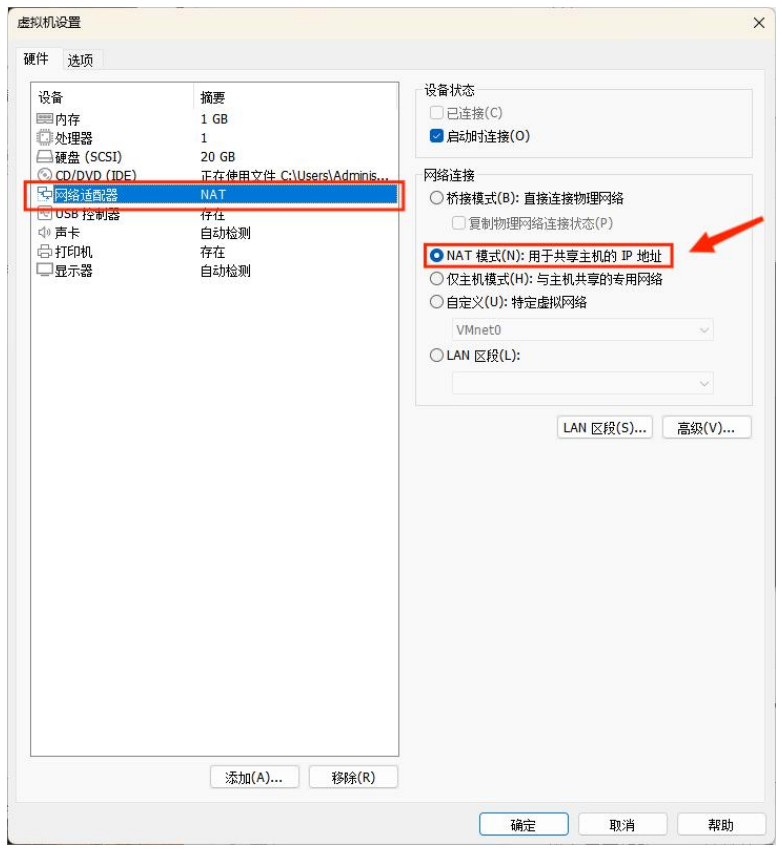

點擊 “網絡適配器” → “NAT模式” 即可。

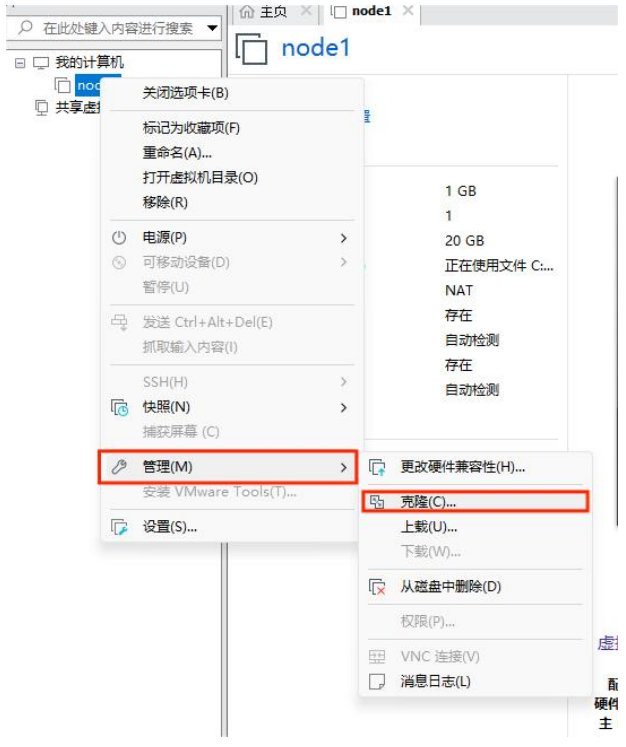

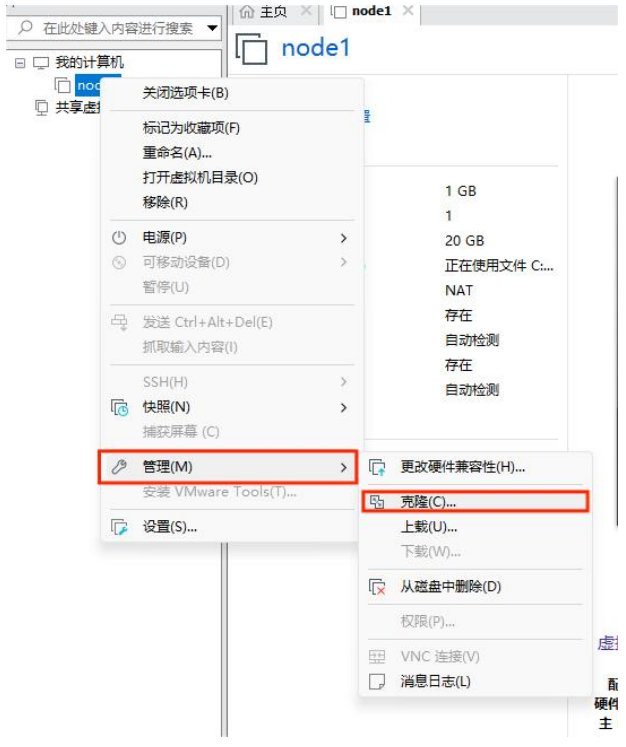

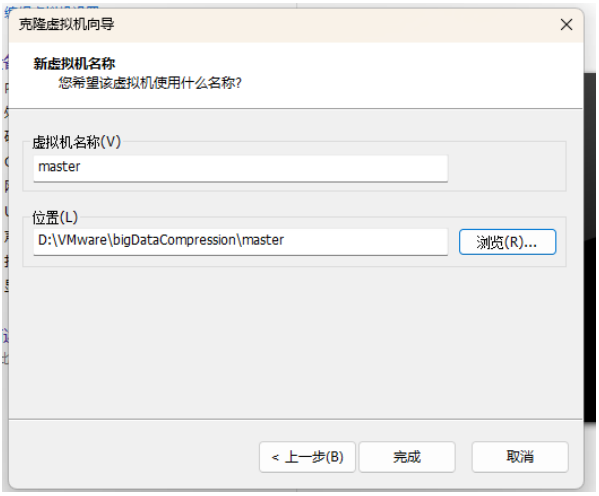

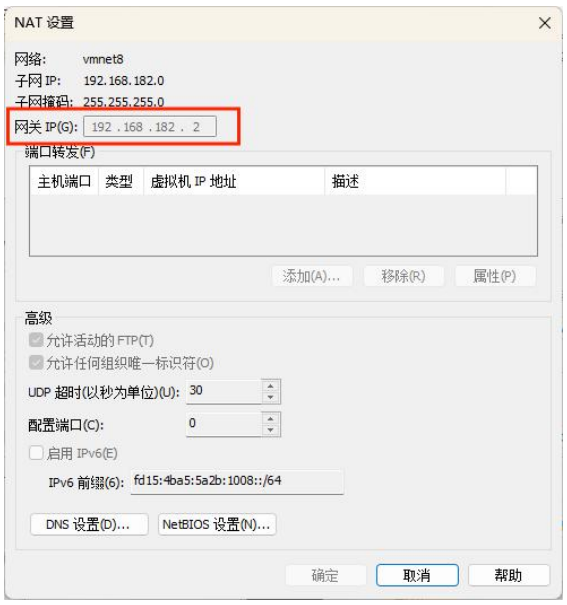

2、克隆虛擬機

右鍵需要克隆的虛擬機 → 管理 → 克隆。

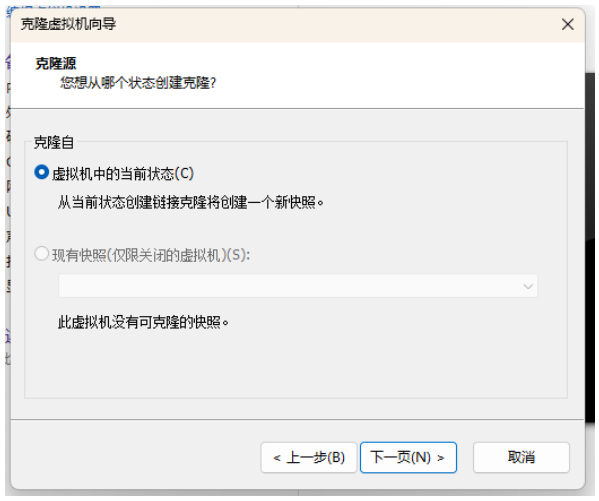

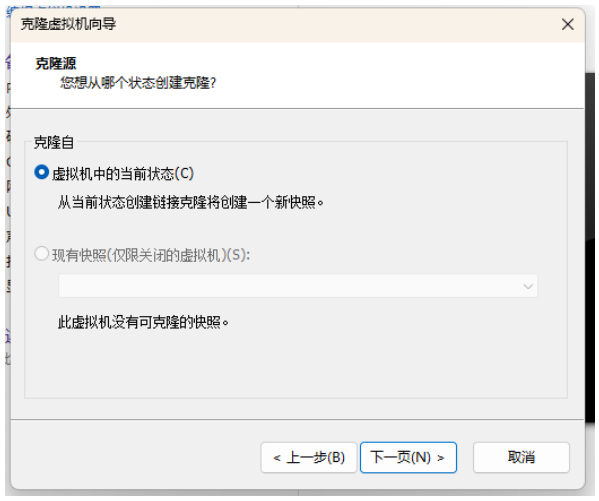

選擇“虛擬機中的當前狀態”,點擊下一步。

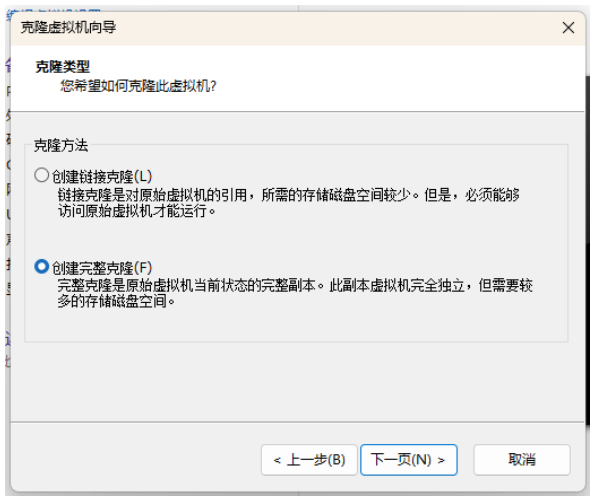

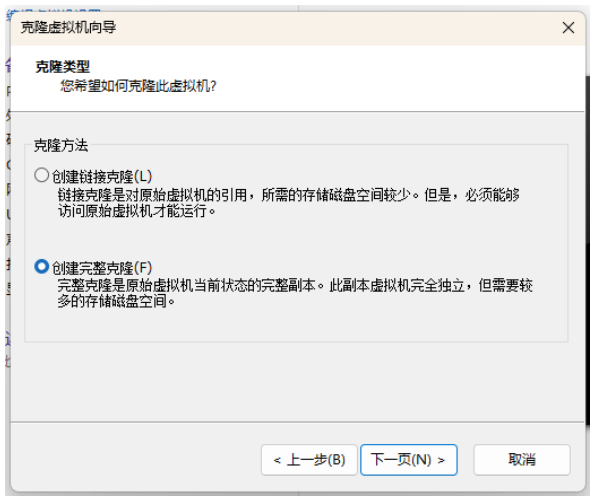

選擇“創建完整克隆”,點擊下一步。

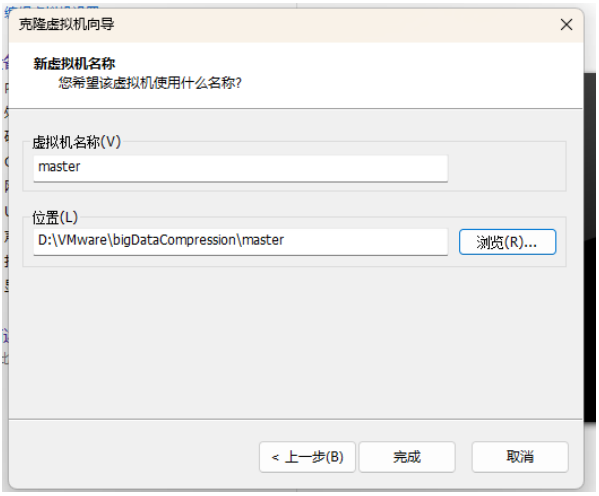

更改虛擬機名稱以及位置,點擊下一步。

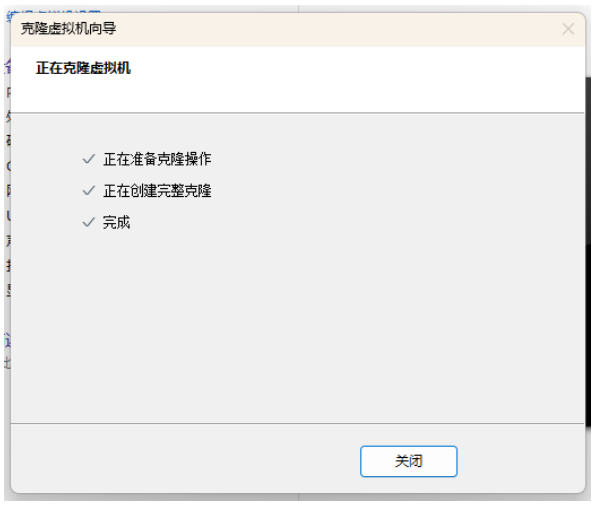

創建完成后關閉即可。

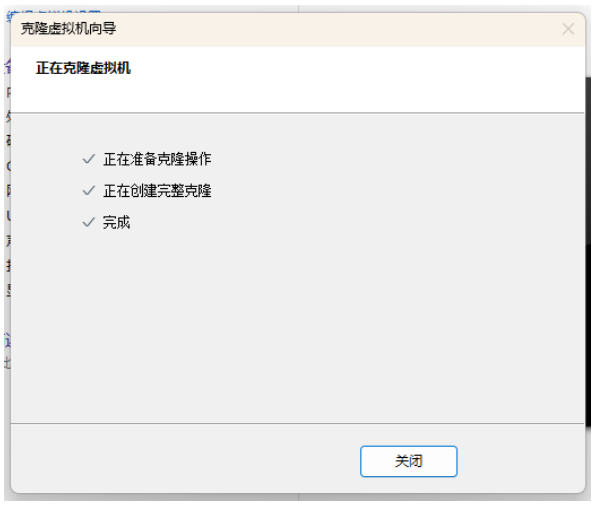

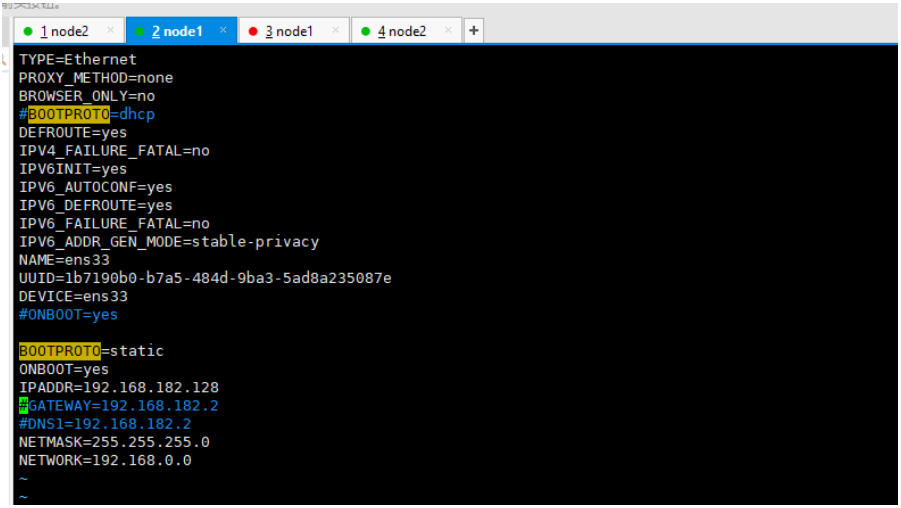

3、修改虛擬機為靜態 IP

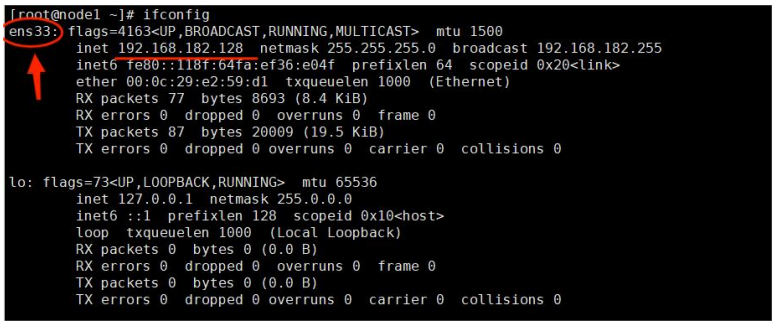

查看虛擬網卡信息。

輸入 ifconfig ,看到可以正常使用的網卡以及相關信息。

可以看到我們這里的網卡是 ens33。

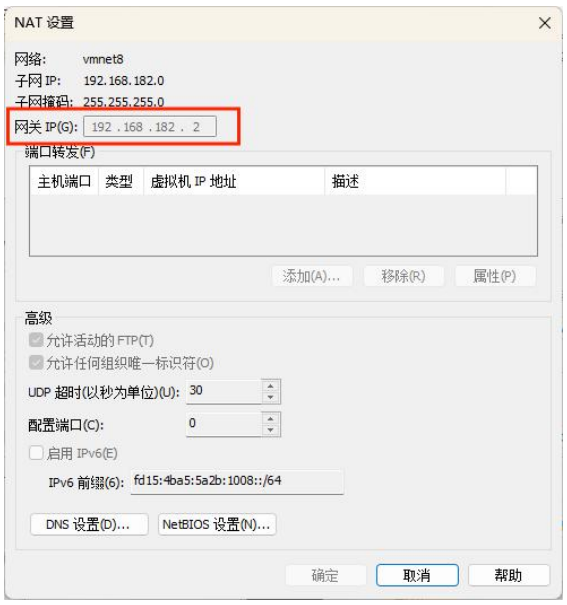

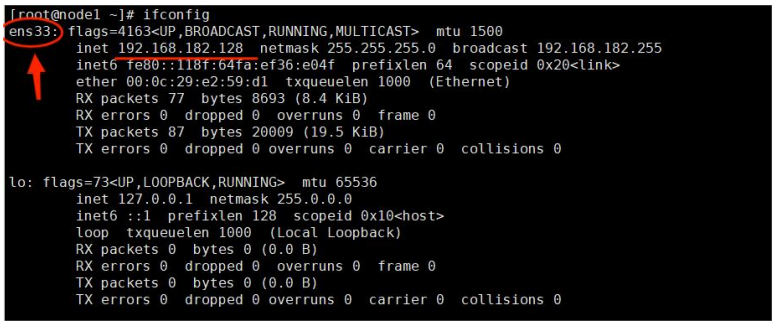

查看網關。

在 VMware 中的虛擬網絡編輯器中可以看到。

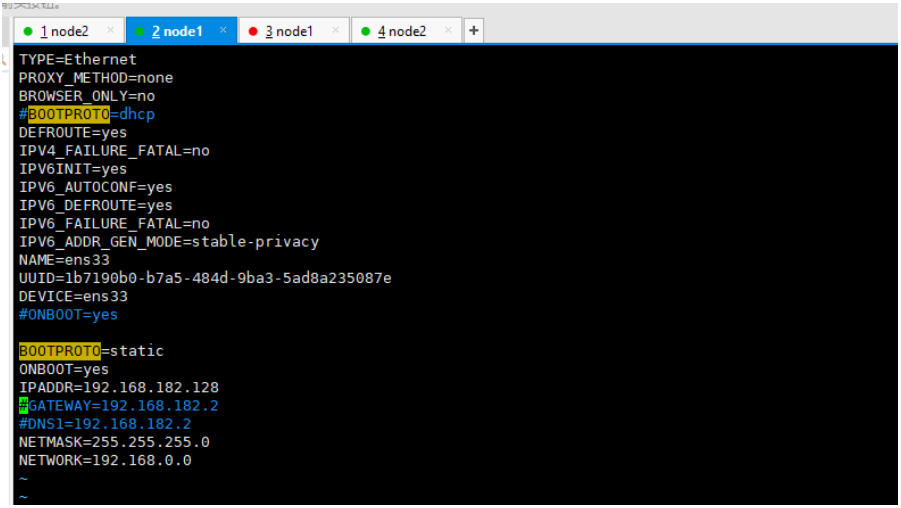

修改網卡配置。

輸入以下命令,即可編寫網卡配置。

vim /etc/sysconfig/network-scripts/ifcfg-網卡名

我這里的網卡名是 ens33,則命令如下:

vim /etc/sysconfig/network-scripts/ifcfg-ens33

把有的部分注釋掉,沒有的部分在最后加上。

# 要配制的部分

BOOTPROTO=static

ONBOOT=yes

IPADDR=192.168.182.128 #IP地址

NETMASK=255.255.255.0 #子網掩碼

NETWORK=192.168.0.0

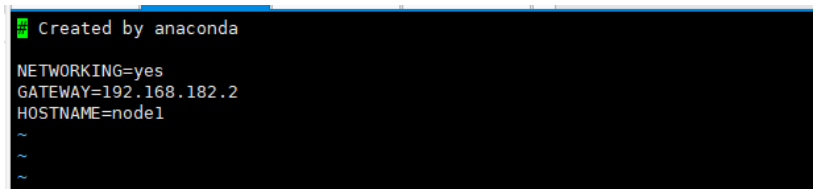

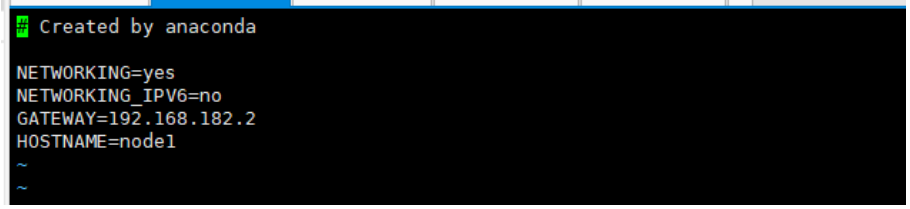

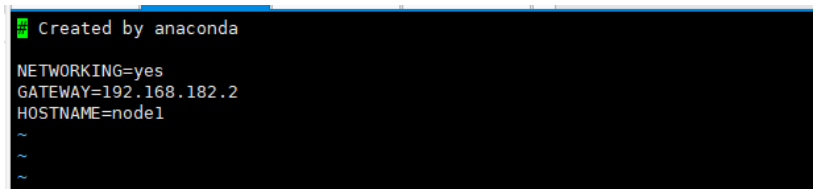

修改網關配置。

輸入以下命令,編寫網關配置。

vim /etc/sysconfig/network

編寫以下內容。

NETWORKING=yes

GATEWAY=192.168.182.2 #網關

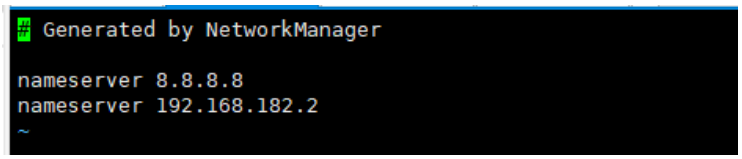

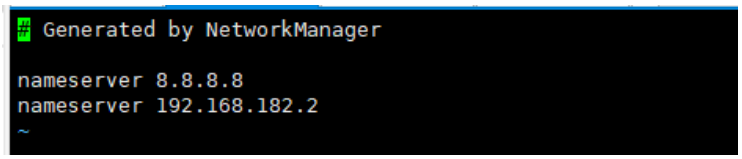

修改 DNS 配置。

輸入以下內容,編寫 DNS 配置。

編寫以下內容。

search localdomain

nameserver 8.8.8.8

nameserver 192.168.182.2

重啟網絡服務。

4、修改主機名

查看本機主機名

查看本機主機名使用 hostname 即可。

修改主機名(CentOS 7)。

使用下面的命令修改主機名。

hostnamectl set-hostname 主機名

示例:

hostnamectl set-hostname node1

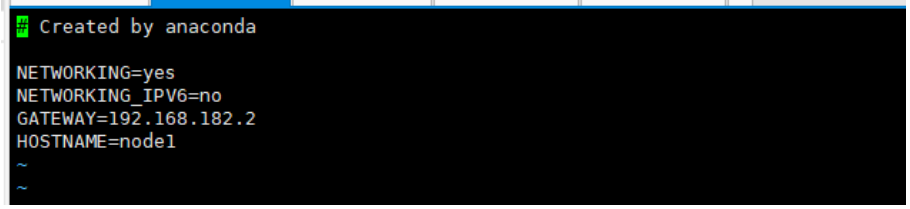

修改主機名(通用,CentOS7 與 非 CentOS7)。

NETWORKING=yes

NETWORKING_IPV6=no

GATEWAY=192.168.182.2 #網關

HOSTNAME=node1 #主機名

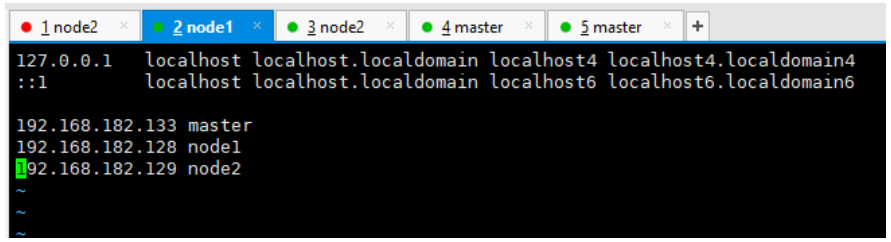

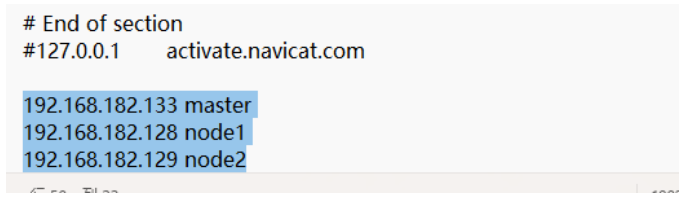

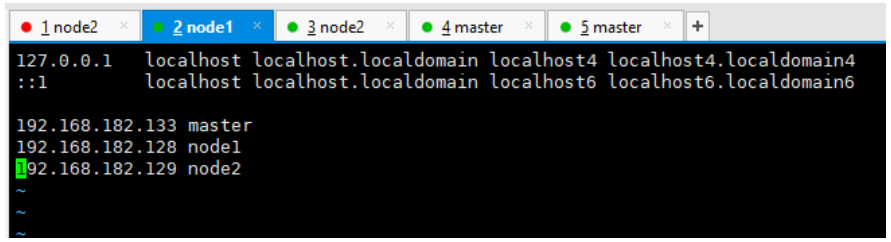

修改 CentOS 的 hosts。

使用下面的命令編輯 hosts。

在每個虛擬機的 hosts 文件后面增加自己所安裝的虛擬機的 IP 地址以及主機名。

192.168.182.133 master

192.168.182.128 node1

192.168.182.129 node2

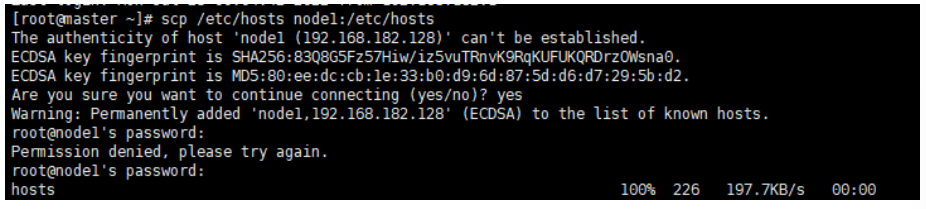

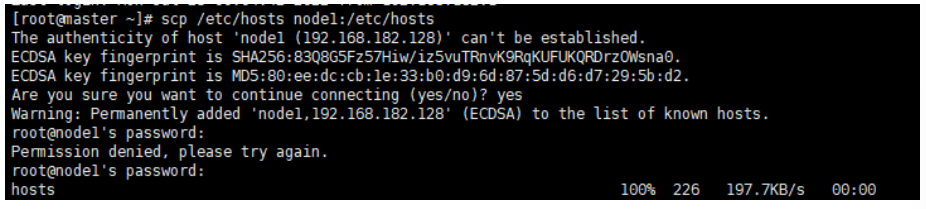

將 hosts 文件拷貝到 node1 和 node2 節點命令:

scp /etc/hosts node1:/etc/hosts # 拷貝到 node1

scp /etc/hosts node2:/etc/hosts # 拷貝到 node2

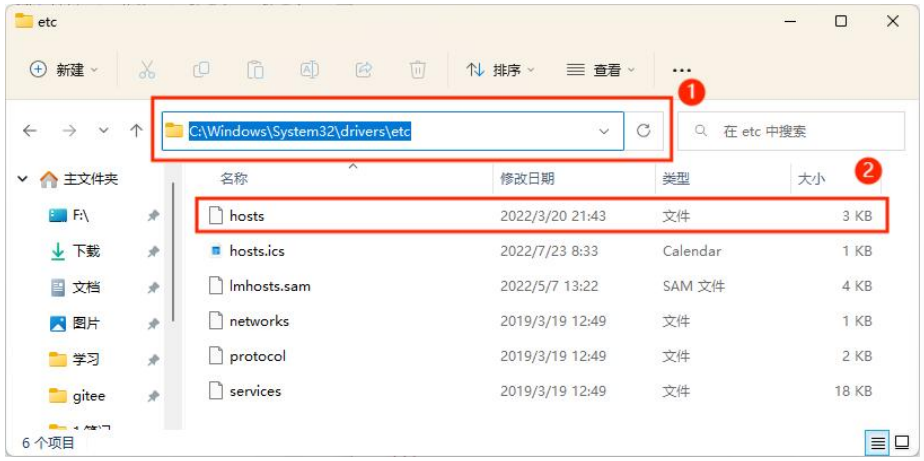

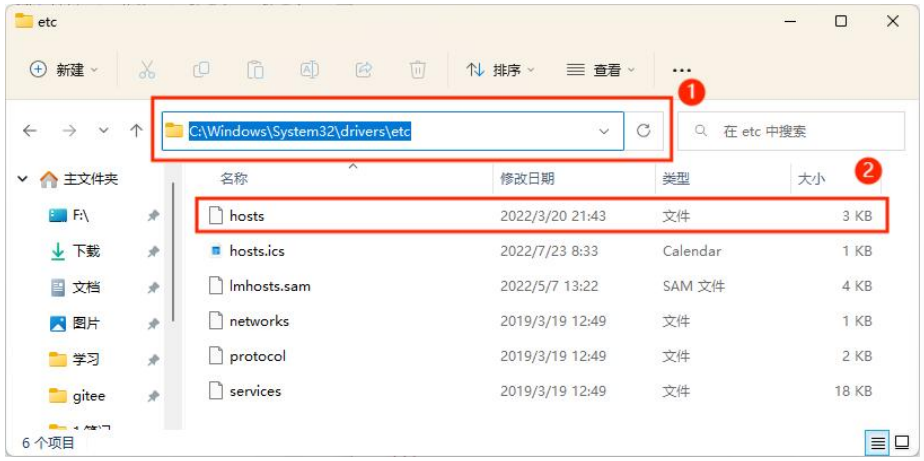

修改 Windows 的 hosts。

進入 C:\Windows\System32\drivers\etc 路徑。

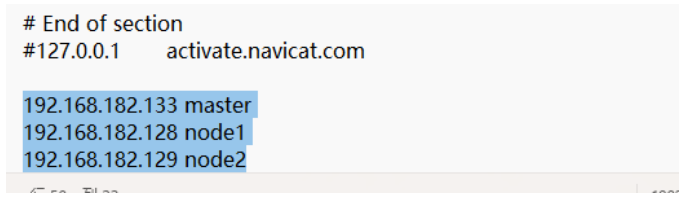

打開 hosts 文件,填寫如下內容:

192.168.182.133 master

192.168.182.128 node1

192.168.182.129 node2

保存文件,如果不行的話可以先移出來,再移回去。

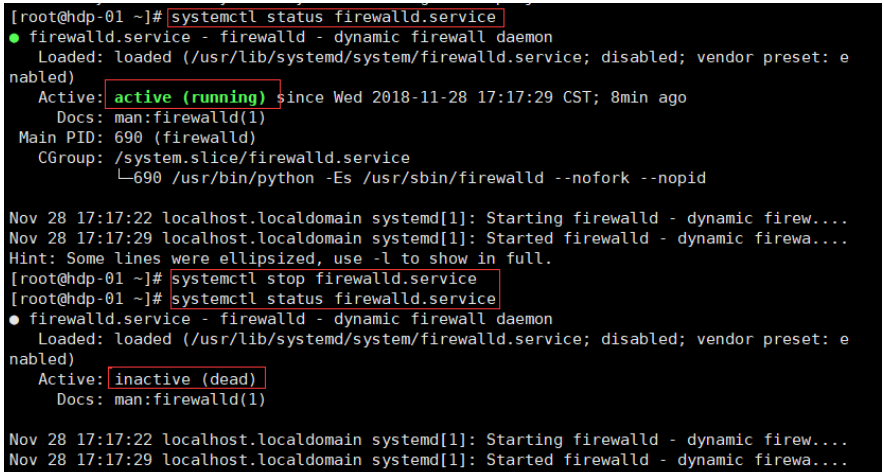

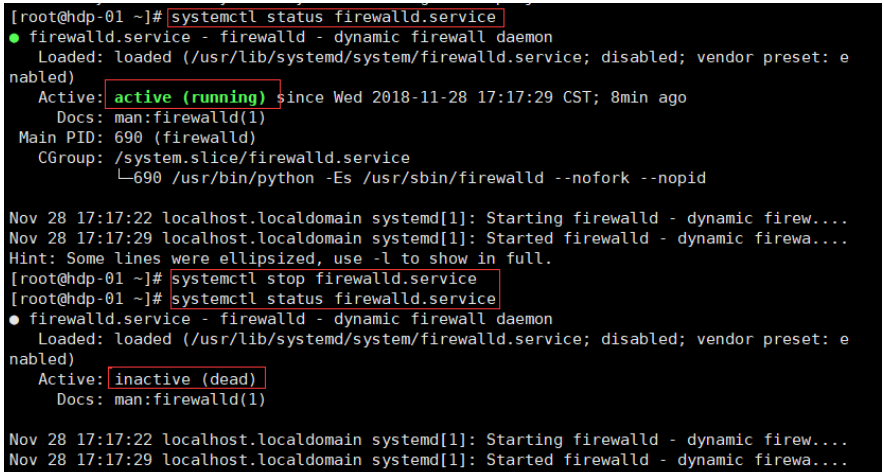

5、關閉防火墻

查看防火墻狀態。

systemctl status firewalld.service

綠的running表示防火墻開啟。

關閉防火墻。

systemctl stop firewalld.service

或:

開機禁用防火墻自啟。

systemctl disable firewalld.service

或:

啟動防火墻。

systemctl start firewalld.service

防火墻隨系統開啟啟動。

systemctl enable firewalld.service

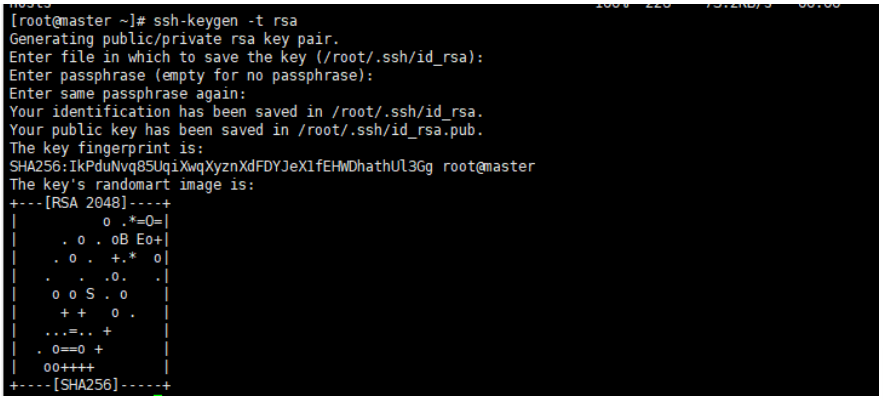

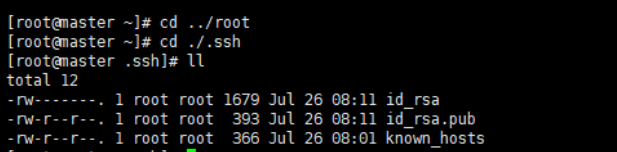

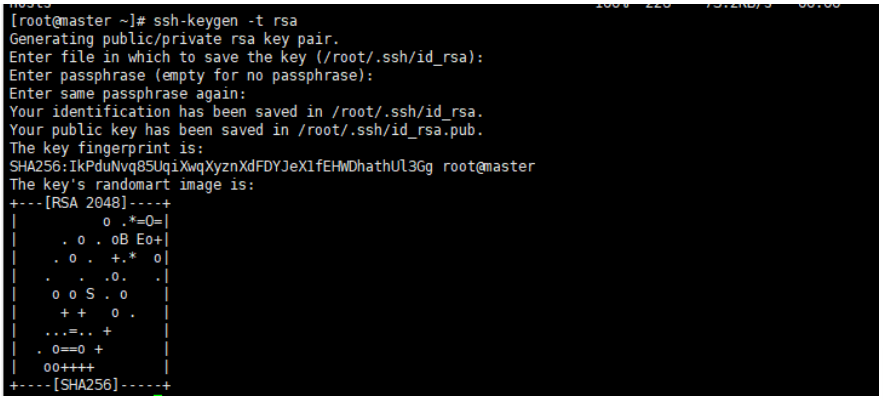

6、設置 ssh 免密??碼登錄(只在 Master 這臺主機操作)

生成密鑰并拷貝到子節點。

主節點執行命令 ssh-keygen -t rsa 產生密鑰,一直回車執行命令。

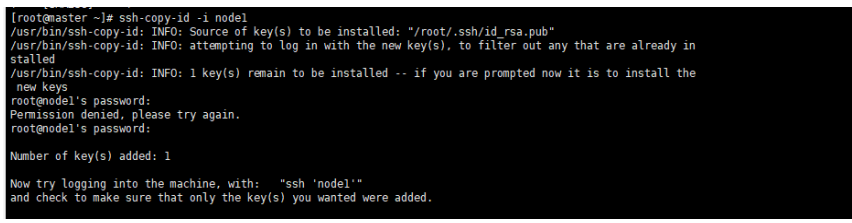

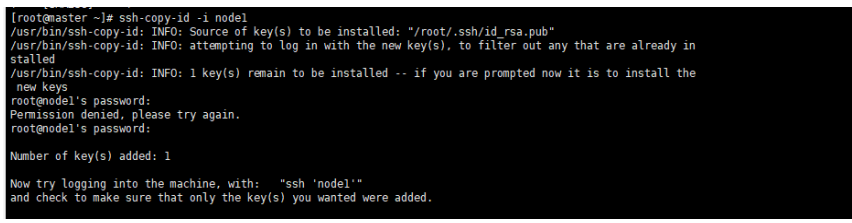

將密鑰拷貝到其他兩個子節點,命令如下:

ssh-copy-id -i node1

ssh-copy-id -i node2

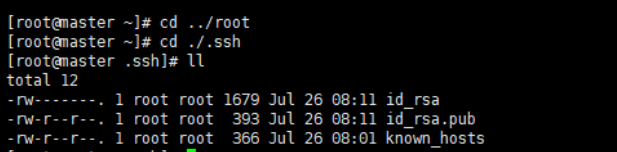

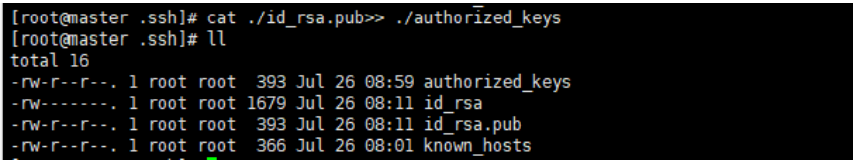

實現主節點 master 本地免密??碼登錄。

首先進入到 /root 命令:

在進入到 ./.ssh 目錄下:

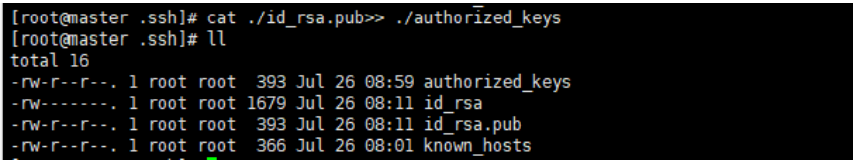

將公鑰寫入本地執行命令:

cat ./id_rsa.pub>> ./authorized_keys

二、用戶及文件權限配置

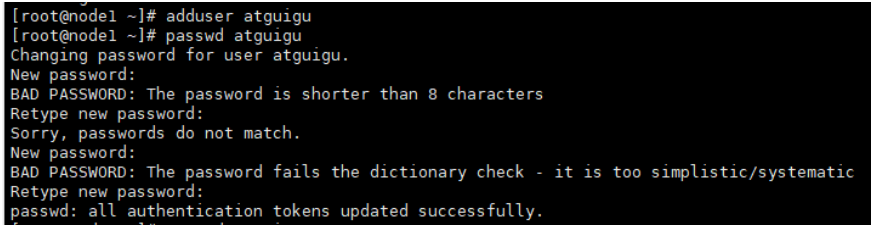

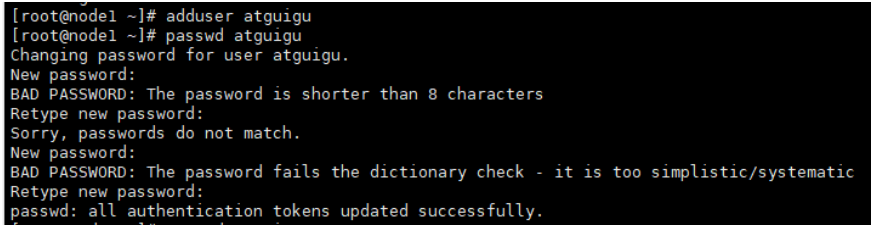

1、創建用戶

adduser atguigu #添加用戶

passwd atguigu #修改密??碼

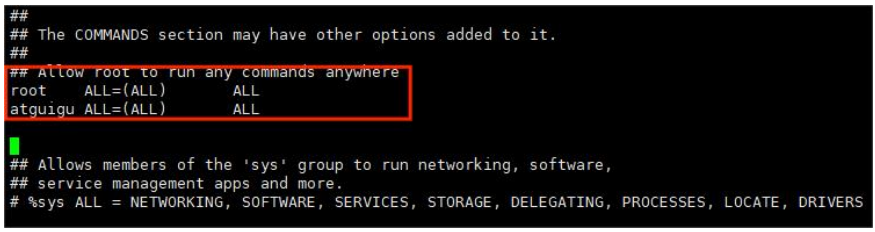

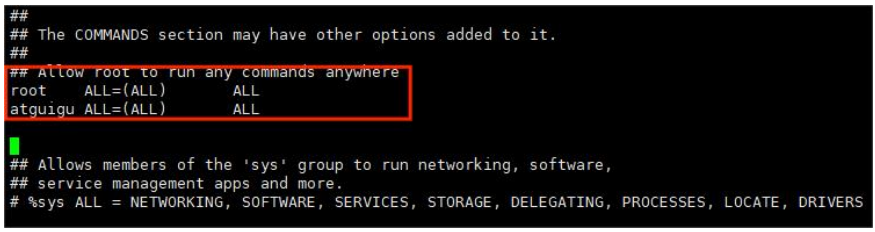

2、配置用戶具有 root 權限

輸入以下命令進行配置:

配置 atguigu 用戶的信息:

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

atguigu ALL=(ALL) ALL

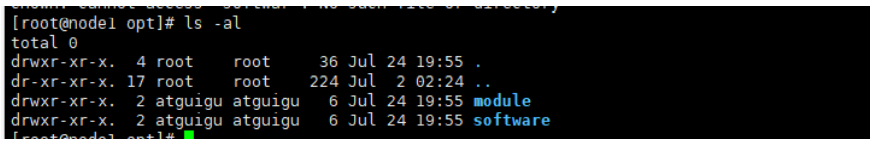

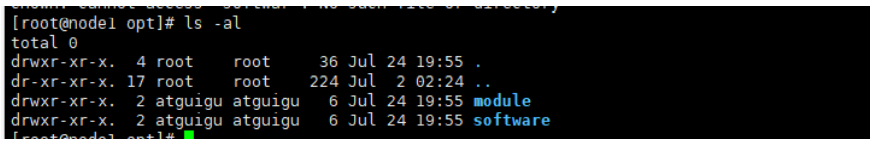

3、在 /opt 目錄下創建文件夾

在 /opt 目錄下創建 module、software 文件夾。

mkdir module # 創建 module 文件夾

mkdir software # 創建 software 文件夾

修改 module、software 文件夾的所有者 cd。

chown atguigu:atguigu module

chown atguigu:atguigu software

查看文件歸屬。

三、JDK 安裝

1、卸載現有 jdk

查詢是否安裝 Java。

如果安裝的版本低于 1.7,則卸載該 jdk。

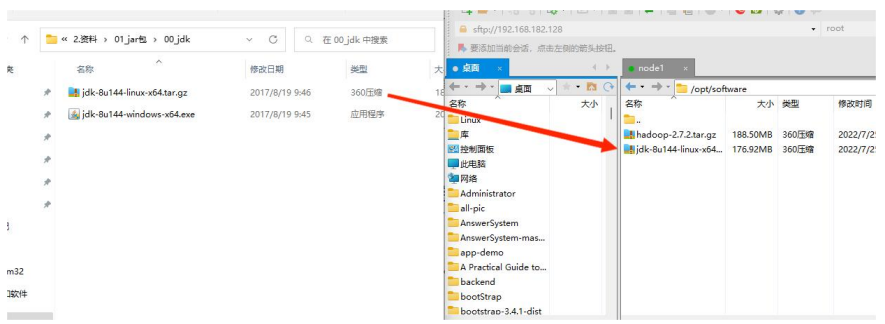

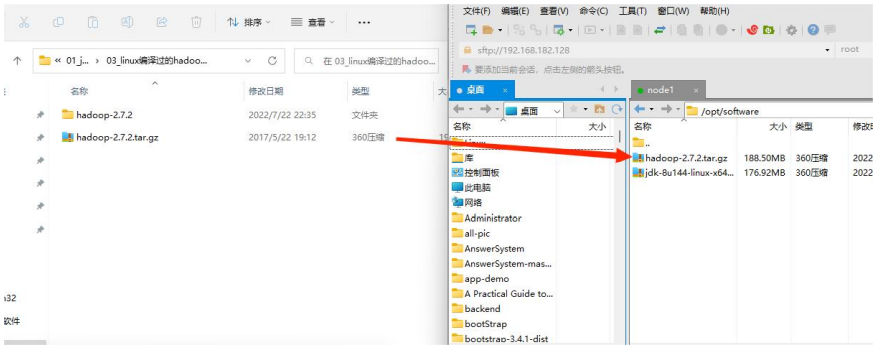

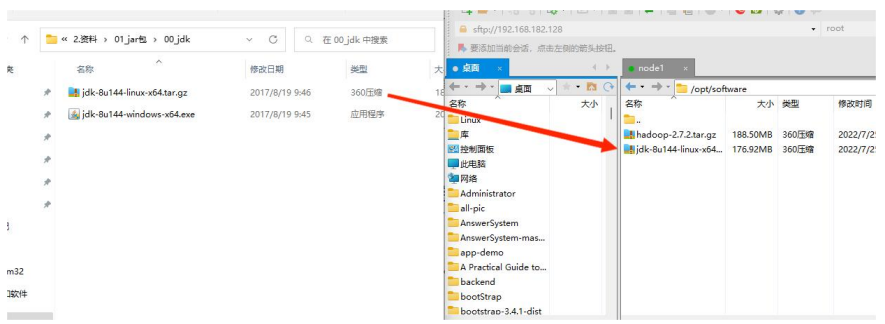

2、將 jdk、Hadoop 導入到 opt 目錄的 software 文件夾下

導入 jdk 安裝包。

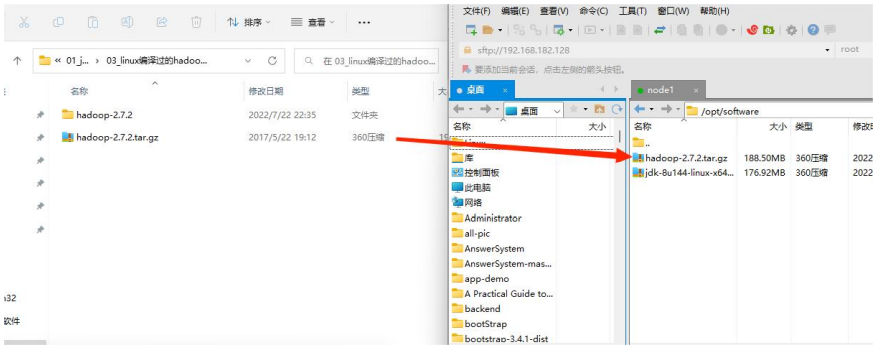

導入 Hadoop 安裝包。

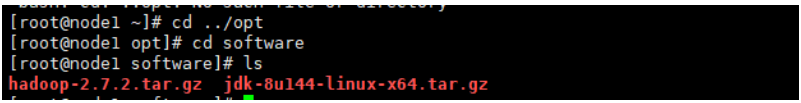

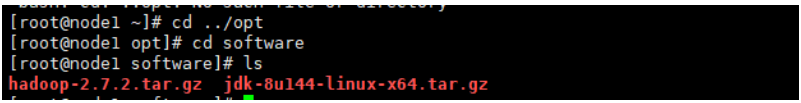

3、查看軟件包是否導入成功

4、解壓 jdk 到 /opt/module 目錄下

tar -zxvf jdk-8u144-linux-x64.tar.gz -C /opt/module/

5、配置 jdk 環境變量

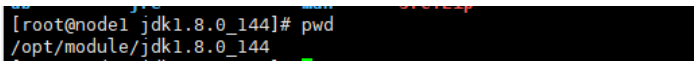

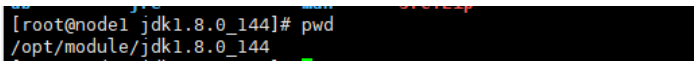

獲取 jdk 路徑。

進入 jdk 的解壓路徑,輸入以下命令即可查看 jdk 路徑:

打開 /etc/profile 文件:

輸入以下命令打開 profile 文件。

輸入以下命令配置 Java 環境變量。

export JAVA_HOME=/opt/module/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

保存退出。

配置 jdk 環境生效。

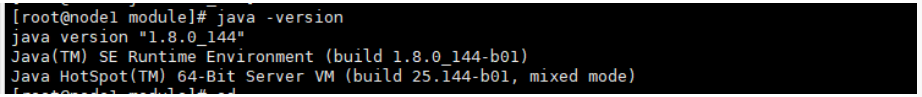

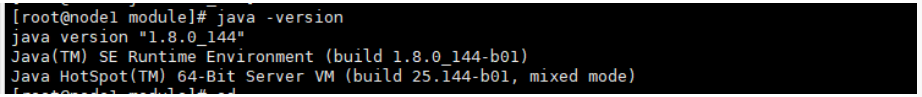

測試 jdk 是否安裝成功。

重啟(如果 java -version 可以用就不用重啟)。

四、Hadoop 安裝(master 主機)

1、進入 Hadoop 安裝包路徑下

2、解壓安裝文件到 /opt/module 目錄下

tar -zxf hadoop-2.7.2.tar.gz -C /opt/module/

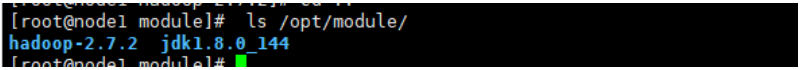

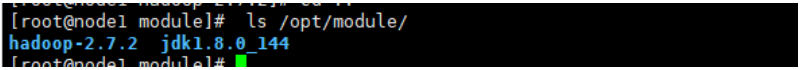

3、查看是否解壓成功

4、將 Hadoop 添加到環境變量下

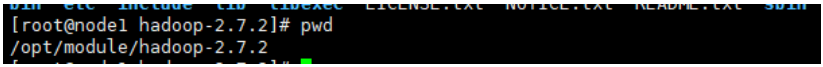

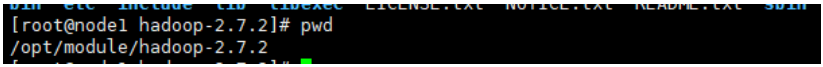

獲取 Hadoop 安裝路徑。

進入 Hadoop 路徑,輸入以下命令查看 Hadoop 安裝路徑。

打開 /etc/profile 文件。

使用 vim 打開 profile 文件。

編輯 Hadoop 環境。

##HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

保存退出。

Hadoop 環境生效。

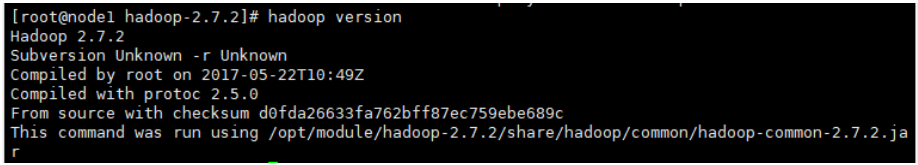

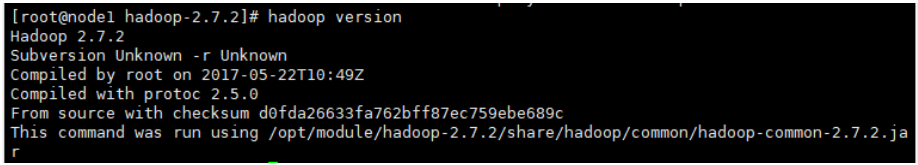

測試 Hadoop 是否安裝成功。

重啟(如果 hadoop version 可以用就不用重啟)。

5、修改 Hadoop 相關配置文件

(1) 修改 Hadoop 的 slaves 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

修改該目錄下的 slaves 文件。

使用 vim 編輯 slaves 文件。

刪除原來的內容,修改為如下內容。

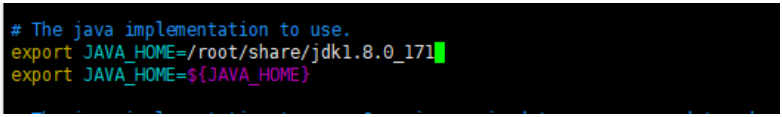

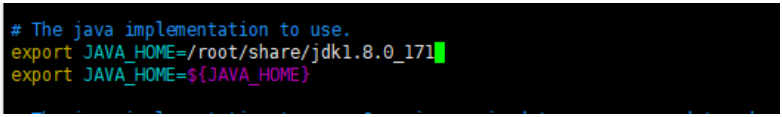

(2) 修改 Hadoop 的 hadoop-env.sh 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

修改該目錄下的 hadoop-env.sh 文件。

添加 JAVA_HOME 路徑:

export JAVA_HOME=/opt/module/jdk1.8.0_144

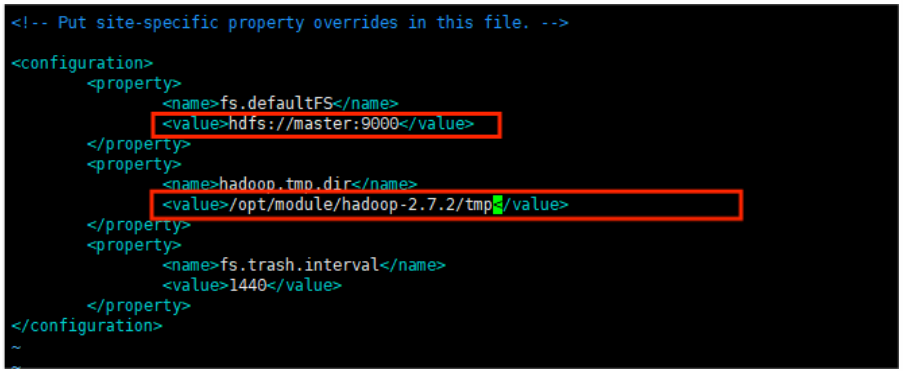

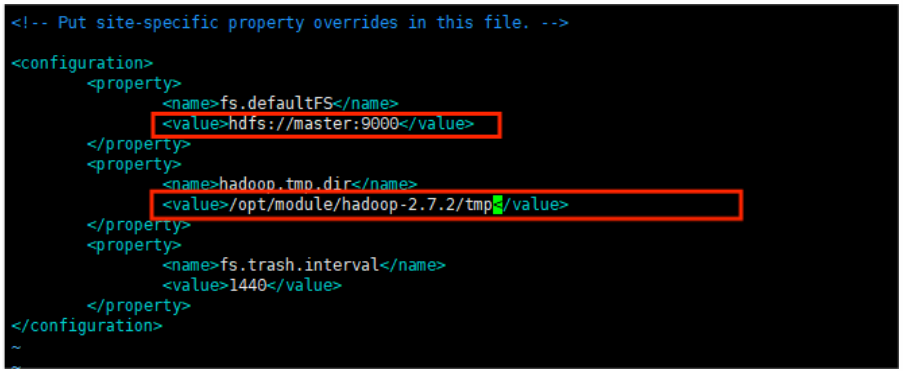

(3) 修改 Hadoop 的 core-site.xml 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

修改該目錄下的 core-site.xml 文件。

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-2.7.2/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

</configuration>

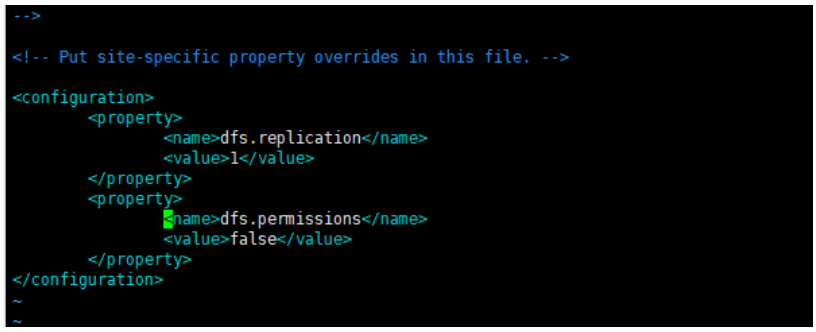

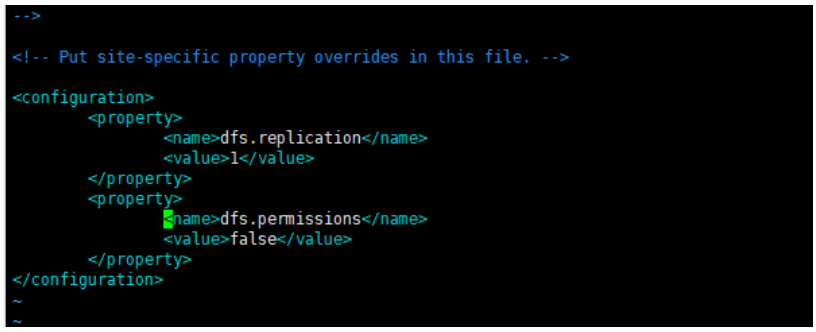

(4) 修改 Hadoop 的 hdfs-site.xml 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

修改該目錄下的 hdfs-site.xml 文件。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

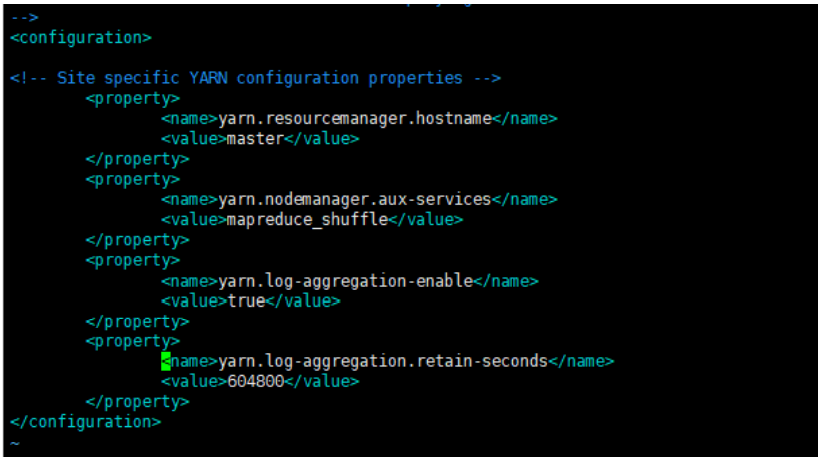

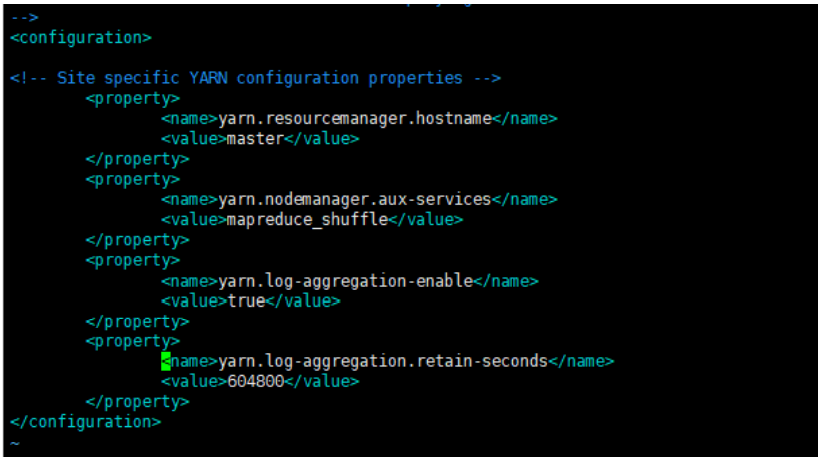

(5) 修改 Hadoop 的 yarn-site.xml 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

修改該目錄下的 yarn-site.xml 文件。

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

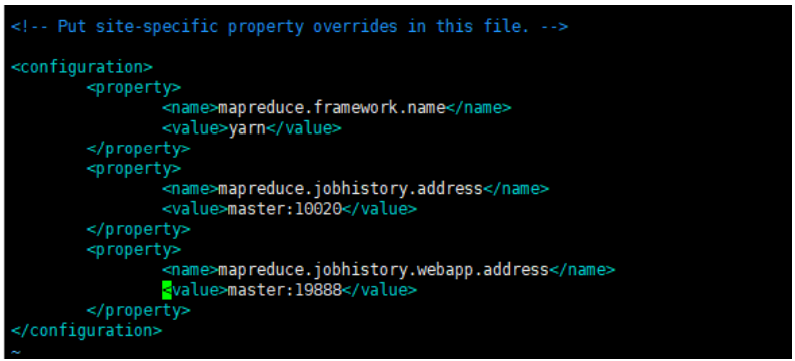

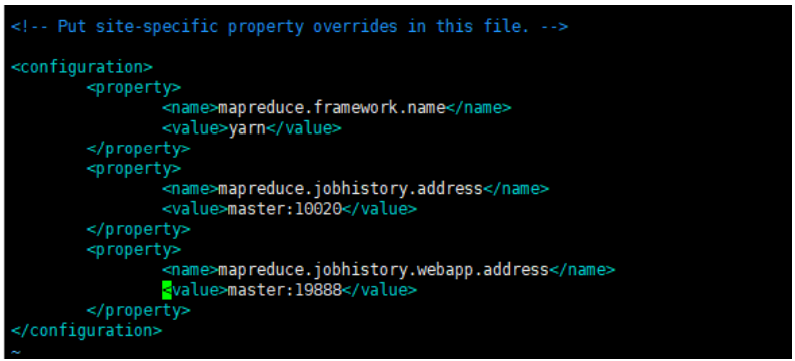

(6) 修改 Hadoop 的 mapred-site.xml 文件

進入 /opt/module/hadoop-2.7.2/etc/hadoop 目錄。

cd /opt/module/hadoop-2.7.2/etc/hadoop

復制 mapred-site.xml.template 為 mapred-site.xml。

cp mapred-site.xml.template mapred-site.xml

修改該目錄下的 mapred-site.xml 文件。

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

(7) 復制 Hadoop 的安裝目錄到其它子節點

scp -r /opt/module/hadoop-2.7.2 node1:/opt/module/hadoop-2.7.2

scp -r /opt/module/hadoop-2.7.2 node2:/opt/module/hadoop-2.7.2

6、驗證(啟動 Hadoop)

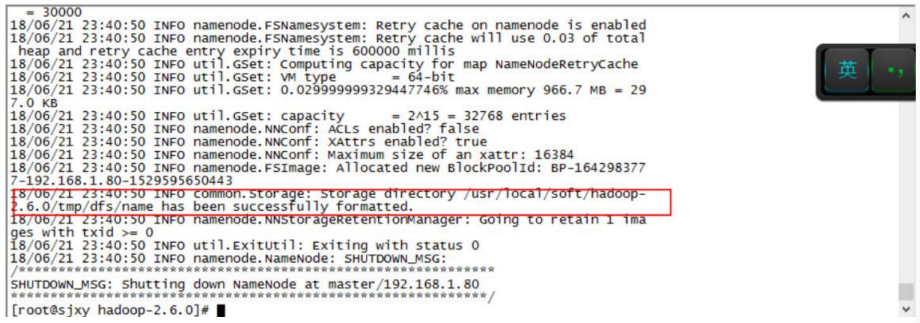

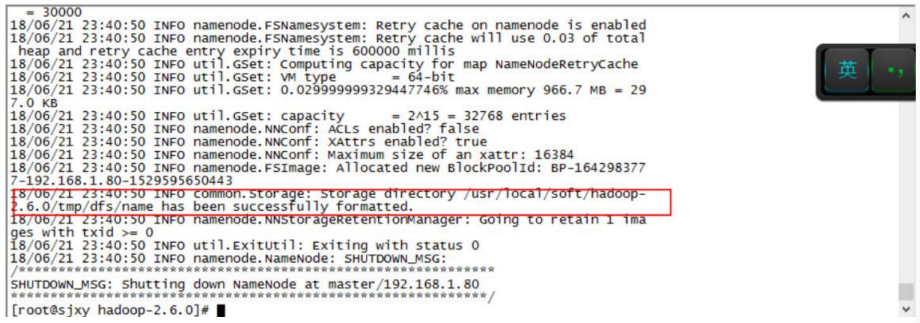

首先看下 hadoop-2.7.2 目錄下有沒有 tmp 文件夾。 如果沒有執行一次格式化命令:

cd /opt/module/hadoop-2.7.2 #進入 hadoop 安裝目錄

./bin/hdfs namenode -format # 格式化命令

執行完格式化命令會生成 tmp 文件。

啟動 Hadoop。

輸入以下命令啟動 Hadoop。

cd /opt/module/hadoop-2.7.2 #進入 hadoop 安裝目錄

./sbin/start-all.sh #啟動程序

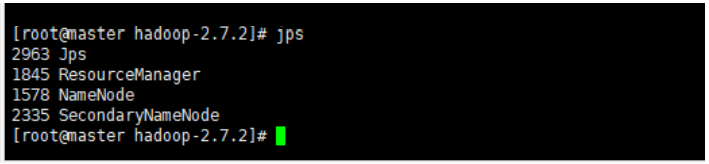

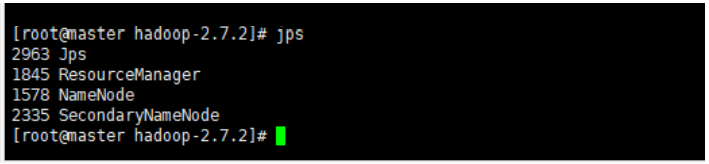

驗證主節點進程。

輸入以下命令查看進程:

主節點進程:

- ResourceManager

- NameNode

- SecondaryNameNode

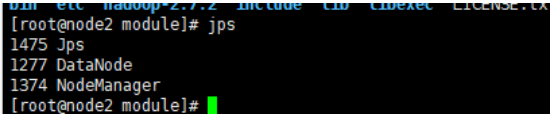

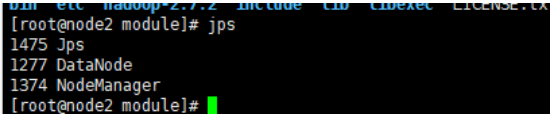

子節點進程

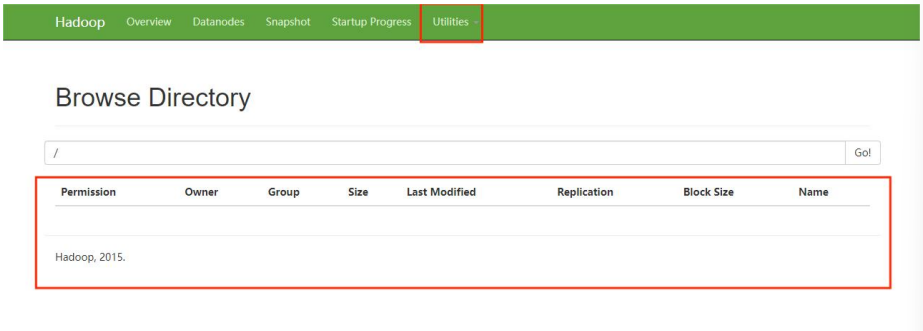

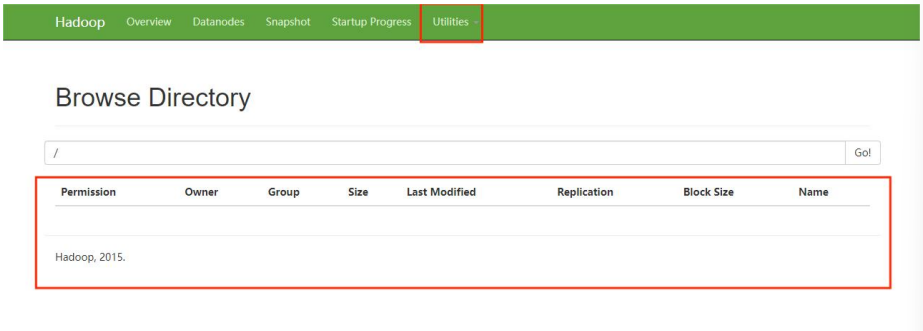

④ 驗證 HDFS:

瀏覽器登錄地址:192.168.182.133:50070(ip 地址是 master 節點的地址)。

出現以下界面則證明 HDFS 安裝成功:

剛搭建完成,什么都沒有。

PS:

如果第一次啟動失敗了,請重新檢查配置文件或者哪里步驟少了。 再次重啟的時候 需要手動將每個節點的 tmp 目錄刪除:

rm -rf /opt/module/hadoop-2.7.2/tmp

然后在<font color=“red”>主節點</font>執行以下命令格式化 namenode。

./bin/hdfs namenode -format

文章相關附件可以點擊下面的原文鏈接前往下載:

https://ost.51cto.com/resource/2334。

??想了解更多關于開源的內容,請訪問:??

??51CTO 開源基礎軟件社區??

??https://ost.51cto.com??。