北大河圖發(fā)布分布式訓(xùn)練神器Galvatron, 一鍵實(shí)現(xiàn)大模型高效自動(dòng)并行

最近一段時(shí)間,「大模型」在 AI 領(lǐng)域的各種應(yīng)用場(chǎng)景都大放異彩,其中基于 Transformer 的大規(guī)模預(yù)訓(xùn)練模型是最典型的大模型之一,已經(jīng)成為了當(dāng)前基礎(chǔ)模型(Foundation Model)的核心架構(gòu)。例如 NLP 領(lǐng)域的 BERT、GPT 系列,CV 領(lǐng)域的 ViT、Swin Transformer 系列,以及最近非常火熱的多專家混合模型 MoE 以及多模態(tài)模型 CLIP 等等,都是以 Transformer 作為核心的基礎(chǔ)架構(gòu)。與之相應(yīng)的,這類稠密大模型擁有著動(dòng)輒數(shù)十億、百億甚至萬(wàn)億規(guī)模的參數(shù)量,面臨高昂的計(jì)算、存儲(chǔ)、以及通信開銷,也為 AI 基礎(chǔ)設(shè)施帶來了巨大的挑戰(zhàn)。

為了支持大模型的訓(xùn)練,人們研發(fā)了很多工具(如 NVIDIA 提出的「威震天」Megatron,Microsoft 提出的 DeepSpeed,Meta 提出的 FairSeq 等等)來實(shí)現(xiàn)各種各樣的并行方式,數(shù)據(jù)并行、張量模型并行、流水并行、分片數(shù)據(jù)并行等等。這些系統(tǒng)對(duì)上述并行方式提供了良好的封裝,對(duì)外屏蔽相應(yīng)的實(shí)現(xiàn)細(xì)節(jié),使得用戶能夠通過添加配置的方式來實(shí)現(xiàn)混合并行策略。

基于上述思想,已經(jīng)有很多工作圍繞如何在張量或者算子層面表達(dá)各種并行方式進(jìn)行探究,這類工作的 “自動(dòng)化” 主要體現(xiàn)在并行 API 到執(zhí)行層的轉(zhuǎn)化過程。但是如果只是局限在設(shè)計(jì)并行 API 或者中間表達(dá)上,這種工程上的封裝并沒有從根本上解決分布式訓(xùn)練的問題。最直觀的結(jié)果就是,用戶仍然無(wú)法從分布式部署的難題中解放出來。實(shí)際上,大模型的分布式部署是一個(gè)非常復(fù)雜的問題,目前的絕大多數(shù)的分布式訓(xùn)練系統(tǒng),都依賴用戶人工反復(fù)嘗試以及系統(tǒng)專家經(jīng)驗(yàn)來進(jìn)行部署,造成嚴(yán)重的資源利用效率低下的問題,與真正的 “自動(dòng)并行” 存在相當(dāng)大的差距。

基于此,北大河圖團(tuán)隊(duì)提出了一款分布式訓(xùn)練神器 Galvatron,以實(shí)現(xiàn)大模型的高效自動(dòng)并行,研究論文入選國(guó)際頂會(huì) VLDB 2023。

- 論文地址:https://arxiv.org/abs/2211.13878

- 項(xiàng)目代碼鏈接:https://github.com/PKU-DAIR/Hetu/tree/main/tools/Galvatron

大模型自動(dòng)并行到底難在哪里

研究者認(rèn)為,大模型的自動(dòng)并行之難主要體現(xiàn)在以下三個(gè)方面:

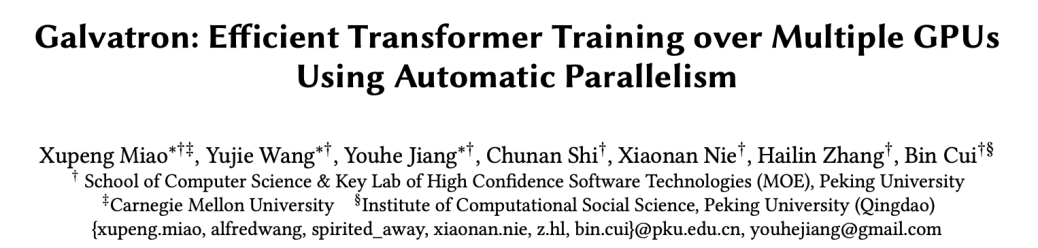

(1)多樣性:首先,在并行方式方面,目前大模型的并行方式呈現(xiàn)出百花齊放的態(tài)勢(shì),即使是對(duì)于同一個(gè)算子,不考慮混合并行方式,不同的基礎(chǔ)并行方式也會(huì)存在顯著的差異,從而導(dǎo)致不同的內(nèi)存開銷、通信代價(jià)以及計(jì)算效率。下圖展示了四種最主要的基礎(chǔ)并行方式,即數(shù)據(jù)并行(Data Parallelism)、張量模型并行(Tensor Parallelism)、流水模型并行(Pipeline Parallelism)、分片數(shù)據(jù)并行 (Sharded Data Parallelism),在兩張 GPU 上對(duì)于簡(jiǎn)單的矩陣乘法算子分布式執(zhí)行的過程。

?

?

并行方法對(duì)比示意圖

其次,在模型方面,各種各樣的模型架構(gòu)最近也是層出不窮,這往往也伴隨著不同的模型配置(例如不同輸入序列長(zhǎng)度,模型層數(shù),模型隱層寬度等),從而造成計(jì)算負(fù)載上的差異。另外,在硬件方面,用戶往往面臨著非常差異化的集群環(huán)境,可能會(huì)面臨不同的內(nèi)存容量、通信帶寬、計(jì)算能力等等。總體上來看,由于上述多樣性的存在,沒有哪種并行技術(shù)總是能夠獲得最佳訓(xùn)練效率,“自動(dòng)并行” 也就成為了分布式訓(xùn)練的核心挑戰(zhàn)。

(2)復(fù)雜性:上述分析還相對(duì)比較單一,實(shí)際上哪怕是對(duì)于同一個(gè)算子也可以同時(shí)應(yīng)用多種不同的基礎(chǔ)并行方式,如果考慮到由這些基礎(chǔ)并行方式復(fù)合所構(gòu)成的混合并行方式,則會(huì)導(dǎo)致問題變得非常復(fù)雜。更重要的是,大模型的計(jì)算圖往往結(jié)構(gòu)非常龐大,對(duì)應(yīng)的也需要更大規(guī)模的集群,如果對(duì)每個(gè)算子都進(jìn)行探索(包括選取集群中合適的計(jì)算資源以及設(shè)計(jì)相應(yīng)的混合并行方式),會(huì)帶來組合空間爆炸的問題,尋找整個(gè)模型的最優(yōu)分布式執(zhí)行方案變得難以求解。

(3)實(shí)用性:除此之外,實(shí)用性也是非常重要的問題。一方面,在進(jìn)行自動(dòng)并行搜索的過程中,對(duì)于各種分布式執(zhí)行方案,必須提供比較精確的內(nèi)存、通信、計(jì)算開銷,否則會(huì)導(dǎo)致結(jié)果與實(shí)際執(zhí)行偏差過大,產(chǎn)生次優(yōu)解或者根本無(wú)法使用。為此,就需要非常精準(zhǔn)的代價(jià)模型,對(duì)不同的模型結(jié)構(gòu)和硬件條件進(jìn)行建模。另一方面,系統(tǒng)提供自動(dòng)并行能力所帶來的額外時(shí)間開銷必須在一個(gè)可以接受的范圍內(nèi),過于高昂的搜索代價(jià)同樣也無(wú)法接受。

分布式訓(xùn)練神器 Galvatron,一鍵實(shí)現(xiàn)大模型高效自動(dòng)并行

系統(tǒng)特性:

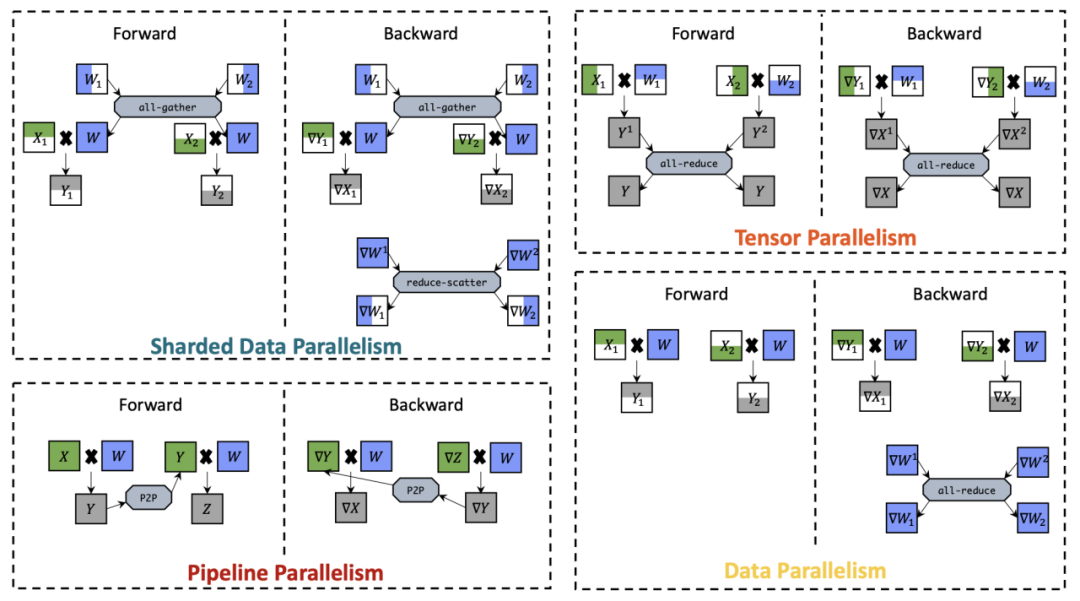

為了解決上述問題,研究者們提出了一些系列工作來探索混合并行的自動(dòng)搜索:一類工作主要討論了同時(shí)考慮數(shù)據(jù)并行和模型并行的搜索空間,代表性工作包括 FlexFlow,Tofu,另一類工作則產(chǎn)生于流水并行場(chǎng)景,將其與數(shù)據(jù)并行相結(jié)合,代表性工作包括 PipeDream,DAPPLE。在此基礎(chǔ)上還有一些衍生工作,如 Unity、Alpa,進(jìn)一步擴(kuò)展了自動(dòng)并行的探索范圍。北大河圖團(tuán)隊(duì)提出的系統(tǒng)「驚破天」Galvatron 同樣屬于自動(dòng)并行搜索的研究領(lǐng)域,但相比于現(xiàn)有工作,該系統(tǒng)主要擁有以下三方面優(yōu)勢(shì):

(1)在多樣性方面,現(xiàn)有工作能夠支持的并行維度仍然比較有限,而 Galvatron 不僅可以支持更多的并行維度,并且面對(duì)更加差異化的 Transformer 模型結(jié)構(gòu)也能夠精準(zhǔn)建模,以及在不同的集群硬件條件下驗(yàn)證了其自適應(yīng)調(diào)優(yōu)的能力。

大模型分布式訓(xùn)練系統(tǒng)對(duì)比示意圖?

(2)在復(fù)雜性方面,由于具備在多樣性上的優(yōu)勢(shì),Galvatron 面臨了前所未有的龐大搜索空間,為此,研究者探究了幾條目前大規(guī)模分布式訓(xùn)練過程中的一些經(jīng)過實(shí)驗(yàn)性或理論性驗(yàn)證的重要觀察,作為搜索空間的剪枝準(zhǔn)則,從而實(shí)現(xiàn)高效的分布式執(zhí)行計(jì)劃優(yōu)化。

(3)在實(shí)用性方面,該研究結(jié)合了理論建模和實(shí)驗(yàn)測(cè)量?jī)烧叩膬?yōu)勢(shì),實(shí)現(xiàn)對(duì)內(nèi)存、通信、計(jì)算開銷的精確估計(jì),甚至考慮到了計(jì)算與通信重疊所導(dǎo)致的 GPU 執(zhí)行效率下降問題,從而保證能夠得到足夠準(zhǔn)確的自動(dòng)并行優(yōu)化結(jié)果。

另外,Galvatron 底層選擇 PyTorch 作為執(zhí)行引擎,兼容 Huggingface 等常見的主流 Transformer 模型實(shí)現(xiàn),所以完全不會(huì)對(duì) PyTorch 用戶帶來額外的使用負(fù)擔(dān);同時(shí)也不需要用戶付出額外的系統(tǒng)安裝或者調(diào)試代價(jià),使用時(shí)只需要添加幾行代碼,就可以輕松完成自動(dòng)并行的整個(gè)流程。

Galvatron 工作流程及用戶使用接口展示?

關(guān)鍵技術(shù)

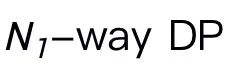

1. 基于決策樹的搜索空間分解

Galvatron 的設(shè)計(jì)目標(biāo)是高效地在復(fù)雜而龐大的并行策略空間內(nèi)自動(dòng)搜索,并為給定的 Transformer 模型和分布式環(huán)境生成最佳的并行執(zhí)行計(jì)劃。在搜索空間上,Galvatron 是業(yè)界首個(gè)考慮 4 種主流并行方法的自動(dòng)并行訓(xùn)練系統(tǒng),包括包括數(shù)據(jù)并行(data parallelism, DP)、分片數(shù)據(jù)并行(sharded data parallelism, SDP)、張量并行(tensor parallelism, TP)和流水并行(pipeline parallelism, PP)。由于混合并行策略會(huì)包含以上四種并行算法的任意組合,在多 GPU 的場(chǎng)景下這種組合帶來的搜索空間十分龐大。例如,對(duì)于雙機(jī)四卡場(chǎng)景,一種可行的策略是在機(jī)內(nèi)使用 2-way TP,機(jī)間使用 2-way PP,另一種可行的策略是在機(jī)內(nèi)使用 2-way PP,機(jī)間使用 2-way DP。當(dāng)節(jié)點(diǎn)內(nèi) GPU 數(shù)量擴(kuò)展到 8 卡時(shí),模型每一層的候選策略都多達(dá)上百種。隨著模型層數(shù)的增加,其搜索空間規(guī)模指數(shù)增長(zhǎng),難以有效探索。

為了高效地搜索如此龐大的搜索空間,該研究首先提出了以下觀察作為指導(dǎo):

- Takeway#1:PP 傾向于被跨設(shè)備島放置。此處 “設(shè)備島” 指具有高內(nèi)部帶寬的一組設(shè)備,在絕大多數(shù) Transformer 模型中,PP 的通信量相比于其它并行方式,顯著更少。因此,人們通常優(yōu)先對(duì)模型進(jìn)行 PP 切分并放置于設(shè)備島之間。

- Takeway#2:在同構(gòu)設(shè)備的前提下,并行策略傾向于將設(shè)備均勻切分。例如,對(duì)于 4 卡 GPU 的 2-way DP 傾向于將設(shè)備切分兩組 2 卡的設(shè)備,而不是一組 1 卡和一組 3 卡的設(shè)備。在這種情況下,一個(gè)設(shè)備組內(nèi)的最優(yōu)混合并行策略與其他組內(nèi)的最優(yōu)策略保持一致。

- Takeway#3:一般來說,在能夠混合使用 DP 和 SDP 的情況下,只使用 SDP 在理論上性能更優(yōu)。根據(jù)分析結(jié)果,N-way SDP 的通信開銷和內(nèi)存開銷均優(yōu)于

和

和 的組合,其中

的組合,其中 。

。

基于以上重要觀察,該研究提出了一種基于決策樹的搜索空間構(gòu)建方法:

(1)給定一個(gè) Transformer 模型,基于 Takeway#1 和 Takeway#2,Galvatron 首先用 PP 將模型切分成多個(gè)階段,同時(shí)將設(shè)備均勻且連續(xù)地切分為多個(gè)設(shè)備組。例如 8 卡場(chǎng)景下,模型被切分為 1/2/4/8-way PP,分別對(duì)應(yīng)設(shè)備組大小為 8/4/2/1。

(2)每種 PP 切分對(duì)應(yīng)著一棵決策樹及一個(gè)子搜索空間,決策樹葉結(jié)點(diǎn)總數(shù)為設(shè)備組大小,決策樹高度為可用的并行方法數(shù)量,即決策樹每一層可應(yīng)用一種并行策略。

(3)并行策略在決策樹不同層間不可重復(fù)使用。

(4)非葉結(jié)點(diǎn)的度數(shù)默認(rèn)在 2 的指數(shù)次冪 {2,4,8,…} 中選擇。

基于以上決策樹構(gòu)建規(guī)則,Galvatron 構(gòu)建的決策樹能表示以上并行的任意組合。Takeway#1 和 Takeway#2 幫助 Galvatron 規(guī)避了低效的并行組合,縮小了搜索空間。對(duì)于 8 卡 GPU 訓(xùn)練一層模型的場(chǎng)景,以上規(guī)則將產(chǎn)出 34 種候選的混合并行策略。進(jìn)一步,使用 Takeway#3 將 DP 和 SDP 同時(shí)出現(xiàn)在一棵決策樹的情形剪枝后,8 卡候選策略數(shù)降至 22 種。

下圖給出了 8 卡 GPU 場(chǎng)景不同 PP 并行度(8/4/2/1)下的決策樹示意圖。

8 卡 GPU 場(chǎng)景不同 PP 并行度(8/4/2/1)下的決策樹示意圖

2. 基于動(dòng)態(tài)規(guī)劃的并行優(yōu)化算法

現(xiàn)有系統(tǒng)如 Megatron 或者 DeepSpeed 通常由用戶指定全局并行方案及其對(duì)應(yīng)的并行度,嚴(yán)重限制了對(duì)分布式執(zhí)行計(jì)劃的表達(dá)能力。Galvatron 的優(yōu)化目標(biāo)是在用戶給定模型定義和分布式環(huán)境的情況下,無(wú)需用戶指定任何并行配置,自動(dòng)生成最優(yōu)的分布式執(zhí)行計(jì)劃。具體來說,給定一個(gè) L 層的模型 M 和內(nèi)存容量為 E 的 N 個(gè) GPU 設(shè)備,Galvatron 的優(yōu)化目標(biāo)是搜索得到最高的系統(tǒng)吞吐 T_pt 并返回對(duì)應(yīng)的并行方案,這里的并行方案指以層(或算子)為基礎(chǔ)單位的細(xì)粒度混合并行策略。

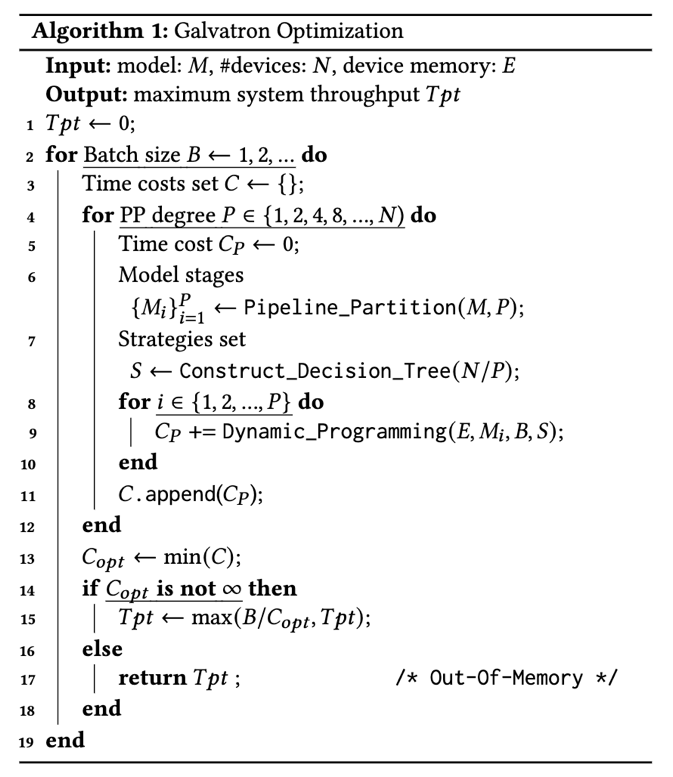

?

?

算法 1: Galvatron 優(yōu)化過程

優(yōu)化過程:Galvatron 的優(yōu)化過程如算法 1 所示。Galvatron 最外層循環(huán)逐步增加搜索的 batch size 直到超出設(shè)備內(nèi)存;給定每個(gè)候選 batch size B,Galvatron 首先根據(jù) Takeaway#1 對(duì)模型進(jìn)行 PP 切分并搜索不同的并行度 P(第 4 行),選定 P- way PP 后模型被切分為 P 個(gè)階段(第 6 行),與之對(duì)應(yīng)的所有設(shè)備被切分為 P 組,每組含有 N/P 個(gè)設(shè)備;接著 Galvatron 構(gòu)建對(duì)應(yīng)的決策樹,其能不重不漏地表示出 DP、SDP、TP 的任意組合,從而獲得策略集合 S;然后對(duì)于每個(gè)模型階段 M_i,在設(shè)備內(nèi)存限制 E 下,Galvatron 使用動(dòng)態(tài)規(guī)劃搜索得到其中每一層的最優(yōu)混合并行策略并返回最小時(shí)間開銷(第 9 行);最后,Galvatron 在所有可能的 PP 并行度和 batch size 中選擇吞吐率最高的策略并返回(第 15 行)。

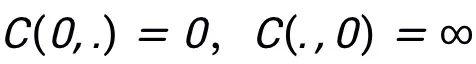

動(dòng)態(tài)規(guī)劃搜索:下面介紹 Galvatron 并行優(yōu)化工作流中的動(dòng)態(tài)規(guī)劃搜索算法。對(duì)于一個(gè)給定的包含 L 層的模型階段,用開銷函數(shù) C(L,E) 表示 L 層模型在設(shè)備內(nèi)存限制 E 下的總執(zhí)行時(shí)間,表示第 L 層使用策略 S_j 的執(zhí)行時(shí)間,其中策略 S_j 是并行策略候選集合 S 中的策略。設(shè)定初始值

,Galvatron 的動(dòng)態(tài)規(guī)劃搜索遵循以下狀態(tài)轉(zhuǎn)移方程(公式 1):

其中,?是第 L 層使用策略 S_j 的內(nèi)存開銷,?是第 L 層使用策略 S_j、其前一層使用策略 S_i 帶來的轉(zhuǎn)換開銷。在狀態(tài)轉(zhuǎn)移過程中,當(dāng)內(nèi)存開銷超過設(shè)備內(nèi)存限制設(shè)備內(nèi)存限制 E,開銷函數(shù) C 返回?zé)o窮大。

復(fù)雜度分析:Galvatron 使用的動(dòng)態(tài)規(guī)劃搜索(公式 1)計(jì)算復(fù)雜度為 O(LE|S|)。可見,每一層的搜索空間 S 的大小對(duì)于整體搜索復(fù)雜度非常重要,Galvatron 提出的基于決策樹的搜索空間分解能夠顯著減小搜索空間,控制搜索開銷在合理范圍內(nèi)。

3. 基于混合建模的執(zhí)行代價(jià)估計(jì)方法

Galvatron 使用一個(gè)策略開銷估計(jì)模塊來對(duì)混合并行策略的計(jì)算、通信、內(nèi)存開銷進(jìn)行估計(jì)。現(xiàn)有的開銷估計(jì)方法主要包括測(cè)量(profiling)和模擬(simulating)兩種,Galvatron 吸取了兩者的長(zhǎng)處并設(shè)計(jì)了一種代價(jià)低廉、高效且準(zhǔn)確的開銷估計(jì)方法。具體來說,對(duì)于內(nèi)存開銷,Galvatron 使用張量的形狀和數(shù)據(jù)類型來完成估計(jì);對(duì)于計(jì)算時(shí)間,Galvatron 通過在單設(shè)備上通過 profiling 測(cè)量逐樣本計(jì)算時(shí)間,結(jié)合 batch size 和擬合函數(shù)從而估計(jì)總體計(jì)算時(shí)間;對(duì)于通信時(shí)間,Galvatron 通過通信量除以設(shè)備通信帶寬得到預(yù)估的通信時(shí)間,其中通信量由理論計(jì)算得到,通信帶寬由 profiling 測(cè)量得到。

基于以上估計(jì)結(jié)果,Galvatron 通過 simulating 執(zhí)行過程來計(jì)算給定層使用給定策略的開銷 c(l,s)。和現(xiàn)有分布式訓(xùn)練系統(tǒng)的代價(jià)模型不同,Galvatron 在建模中首次考慮了計(jì)算和通信的重疊對(duì) GPU 性能下降帶來的影響。該研究通過實(shí)驗(yàn)發(fā)現(xiàn),由于重疊導(dǎo)致的 GPU 性能下降會(huì)顯著影響系統(tǒng)的執(zhí)行效率,而這在以往的工作中都是被忽視的。因此,Galvatron 的開銷估計(jì)更加準(zhǔn)確,并行優(yōu)化效果更佳。

實(shí)驗(yàn)結(jié)果

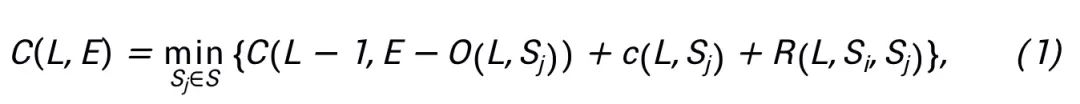

實(shí)驗(yàn)設(shè)置:在實(shí)驗(yàn)中,研究者將 Galvatron 和四種使用單一并行策略的基線系統(tǒng)(DP、SDP、TP、PP)以及專家設(shè)置的 DeepSpeed 3D Parallelism 進(jìn)行對(duì)比,同時(shí)額外設(shè)置了兩個(gè)弱化版本的 Galvatron 作為輔助基線,在有限的并行策略組合空間(即 TP+DP,PP+DP),展開自動(dòng)并行搜索。該研究選用了 NLP Transformer 模型 BERT 和 T5,CV Transformer 模型 ViT 和 Swin Transformer 作為實(shí)驗(yàn)對(duì)象。

Galvatron 和基線系統(tǒng)在 8 GPUs 20G 顯存下的吞吐對(duì)比情況

實(shí)驗(yàn)對(duì)比效果:該研究首先在八卡 Nvidia RTX TITAN 24GB 環(huán)境下進(jìn)行了實(shí)驗(yàn)。實(shí)驗(yàn)表明,在不同模型規(guī)模和不同內(nèi)存限制下,Galvatron 相比于總是取得最優(yōu)的吞吐率,與現(xiàn)有的最先進(jìn)的單一并行方法和混合并行方法相比,訓(xùn)練吞吐量均有顯著提升。具體而言,在 ViT 模型上,Galvatron 相比于單一策略的吞吐率加速比最高可達(dá) 338%,相比于其他混合并行策略的吞吐量從加速比最高可達(dá) 55%;在其他三個(gè)模型上,Galvatron 相比于單一策略和現(xiàn)存的混合策略加速比最高可達(dá) 200%-334% 和 28%-52%。

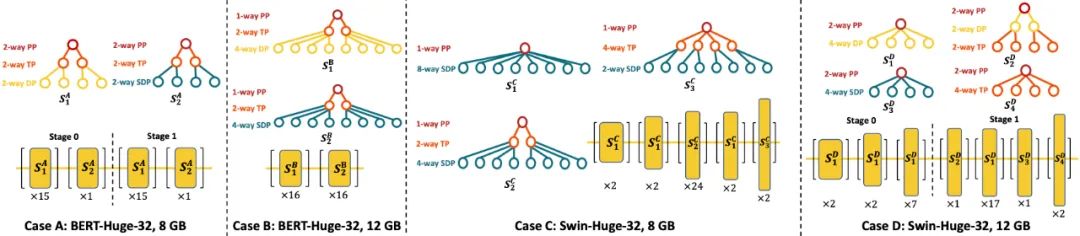

Galvatron 搜索得到的部分最優(yōu)并行策略示意圖

可解釋性實(shí)驗(yàn):該研究選取了一些由 Galvatron 搜索得到的最優(yōu)并行策略進(jìn)行展示。對(duì)于 BERT 模型在 8GB 情況下(Case A),Galvatron 選擇了兩種混合并行策略 PP-TP-DP 以及 PP-TP-SDP,而當(dāng)可用顯存增大到 12GB 時(shí),Galvatron 放棄了 PP,選擇使用更多的 DP,同時(shí)引入 SDP 來節(jié)省顯存空間。在 Swin Transformer 上情況則稍有不同,該模型的不同層呈現(xiàn)出明顯的異質(zhì)性,當(dāng)顯存比較緊缺時(shí)(Case C),淺層 SDP 的并行度較高,隨著層數(shù)加深,每層的激活變小,參數(shù)變多,所以 TP 逐漸取代 SDP。當(dāng)顯存增多時(shí)(Case D), 不僅重新啟用了 PP 替代了一部分低效的 SDP,而且淺層傾向于使用 DP 的趨勢(shì)更為明顯。

可擴(kuò)展性實(shí)驗(yàn):該研究進(jìn)一步在更大的集群上測(cè)試了 Galvatron,包括 16 卡 Nvidia RTX TITAN GPUs 的環(huán)境和 64 卡 Nvidia A100 GPUs 的環(huán)境。在 16 卡環(huán)境下,Galvatron 相比于其他策略依然擁有最高吞吐率,與相同內(nèi)存限制的 8 卡實(shí)驗(yàn)結(jié)果相比,由于更加多樣化的混合并行策略,Galvatron 在 16 卡上能獲得超過 2 倍的加速比。在 64 卡實(shí)驗(yàn)中,Galvatron 的吞吐率同樣是其他策略中最高的。這說明了 Galvatron 具有良好的可擴(kuò)展性,詳細(xì)結(jié)果可以參見論文原文。

北大河圖團(tuán)隊(duì)簡(jiǎn)介

河圖(Hetu)開發(fā)團(tuán)隊(duì)來自于北京大學(xué)數(shù)據(jù)與智能實(shí)驗(yàn)室(Data and Intelligence Research Lab at Peking Univeristy,以下簡(jiǎn)稱:實(shí)驗(yàn)室),實(shí)驗(yàn)室由北京大學(xué)計(jì)算機(jī)學(xué)院崔斌教授帶領(lǐng),多年來主要在人工智能、大數(shù)據(jù)等領(lǐng)域進(jìn)行前沿研究,在理論和技術(shù)創(chuàng)新以及系統(tǒng)研發(fā)上取得多項(xiàng)成果,已在國(guó)際頂級(jí)學(xué)術(shù)會(huì)議和期刊發(fā)表學(xué)術(shù)論文 100 余篇。

河圖系統(tǒng)是一個(gè)面向超大模型的分布式深度學(xué)習(xí)系統(tǒng),相比現(xiàn)有的老牌分布式深度學(xué)習(xí)框架,在系統(tǒng)功能性、系統(tǒng)復(fù)雜性和系統(tǒng)易用性上有諸多創(chuàng)新貢獻(xiàn),如自動(dòng)分布式并行策略、一致性協(xié)議和通信架構(gòu)、GPU 算子優(yōu)化等方面。Hetu 團(tuán)隊(duì)目前已在多種分布式機(jī)器學(xué)習(xí)或深度學(xué)習(xí)場(chǎng)景下進(jìn)行了學(xué)術(shù)創(chuàng)新,相關(guān)成果被 SIGMOD、VLDB、ICML、KDD 等國(guó)際頂級(jí)會(huì)議收錄,其中稀疏大模型分布式訓(xùn)練系統(tǒng) HET 榮獲 VLDB 2022 最佳可擴(kuò)展數(shù)據(jù)科學(xué)論文獎(jiǎng)。本次被 VLDB 2023 錄用的論文 Galvatron 則是河圖團(tuán)隊(duì)在稠密大模型分布式訓(xùn)練場(chǎng)景上的又一突破成果,已經(jīng)集成到 Hetu 系統(tǒng)并對(duì)外開源。目前,Hetu 團(tuán)隊(duì)已經(jīng)與騰訊、阿里巴巴、快手、字節(jié)跳動(dòng)等多家知名企業(yè)展開科研合作和應(yīng)用落地。